如要訓練模型,我們需要合適的方法來減少模型的損失。疊代方法是減少損失的其中一種方法,與向下步行的方式一樣簡單且有效率。

減少損失

如何減少損失?

- 「超參數」是一種設定,可用來調整模型訓練方式。

- 比較權重和偏誤的導數 (y - y')2,代表特定範例的損失變化

- 易於運算和凸顯

- 因此我們不斷朝目標邁進,盡可能減少損失

- 我們稱之為「梯度步數」 (但它們其實是負值的漸層步驟)

- 這項策略稱為「梯度下降法」

區塊圖

- 嘗試漸層下降運動

- 完成運動後,請按下播放 ▶ 繼續

權重初始化

- 對於表面問題,權重可以從任意位置開始 (例如,0 皆為 0 秒)

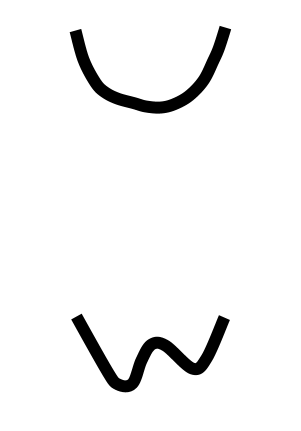

- Convex:想一個碗

- 最少一個

權重初始化

- 對於表面問題,權重可以從任意位置開始 (例如,0 皆為 0 秒)

- Convex:想一個碗

- 最少一個

- 影子覆蓋:如果類神經網路不是真相

- 無凸面:想一顆卵子

- 超過一個下限

- 對初始值有強烈的依賴性

新加坡幣和小批梯度下降法

- 可以計算每個步驟的整個資料集的梯度,但這並不是非必要的

- 對小資料樣本的計算梯度成效良好

- 在每個步驟中取得新的隨機樣本

- 隨機梯度下降法:一次一個範例

- 最小批次梯度下降法:10-1000 批次

- 計算該批次的損失和梯度平均值