พจนานุกรมคำศัพท์นี้จะให้คำนิยามของคำศัพท์เกี่ยวกับปัญญาประดิษฐ์

A

การจี้

เทคนิคในการประเมินความสำคัญของฟีเจอร์ หรือคอมโพเนนต์โดยนำออกชั่วคราวจากโมเดล จากนั้นให้ ฝึกโมเดลอีกครั้งโดยไม่มีฟีเจอร์หรือคอมโพเนนต์นั้น และหากโมเดลที่ฝึกอีกครั้ง มีประสิทธิภาพแย่ลงอย่างมาก แสดงว่าฟีเจอร์หรือคอมโพเนนต์ที่นำออก อาจมีความสำคัญ

ตัวอย่างเช่น สมมติว่าคุณฝึกโมเดลการแยกประเภท ในฟีเจอร์ 10 รายการและได้ความแม่นยำ 88% ในชุดทดสอบ หากต้องการตรวจสอบความสำคัญ ของฟีเจอร์แรก คุณสามารถฝึกโมเดลอีกครั้งโดยใช้เฉพาะฟีเจอร์อื่นๆ อีก 9 รายการ หากโมเดลที่ฝึกใหม่มีประสิทธิภาพแย่ลงอย่างมาก (เช่น ความแม่นยำ 55%) แสดงว่าฟีเจอร์ที่นำออกอาจมีความสำคัญ ในทางกลับกัน หากโมเดลที่ฝึกใหม่ทำงานได้ดีเท่ากัน แสดงว่าฟีเจอร์นั้นอาจ ไม่สำคัญมากนัก

นอกจากนี้ การตัดออกยังช่วยระบุความสำคัญของสิ่งต่อไปนี้ได้ด้วย

- คอมโพเนนต์ขนาดใหญ่ เช่น ทั้งระบบย่อยของระบบ ML ขนาดใหญ่

- กระบวนการหรือเทคนิค เช่น ขั้นตอนการประมวลผลข้อมูลเบื้องต้น

ในทั้ง 2 กรณี คุณจะสังเกตเห็นว่าประสิทธิภาพของระบบเปลี่ยนแปลง (หรือไม่เปลี่ยนแปลง) หลังจากนำคอมโพเนนต์ออก

การทดสอบ A/B

วิธีทางสถิติในการเปรียบเทียบเทคนิค 2 อย่าง (หรือมากกว่า) ซึ่งก็คือ A และ B โดยปกติแล้ว A คือเทคนิคที่มีอยู่ และ B คือเทคนิคใหม่ การทดสอบ A/B ไม่เพียงแต่ระบุว่าเทคนิคใดทำงานได้ดีกว่า แต่ยังระบุว่าความแตกต่างนั้นมีนัยสำคัญทางสถิติหรือไม่ด้วย

โดยปกติแล้วการทดสอบ A/B จะเปรียบเทียบเมตริกเดียวใน 2 เทคนิค เช่น ความแม่นยำของโมเดลเป็นอย่างไรเมื่อเปรียบเทียบกับ 2 เทคนิค อย่างไรก็ตาม การทดสอบ A/B ยังสามารถเปรียบเทียบเมตริกจำนวนจำกัดได้ด้วย

ชิปตัวเร่ง

หมวดหมู่ของคอมโพเนนต์ฮาร์ดแวร์เฉพาะทางที่ออกแบบมาเพื่อทำการคำนวณที่สำคัญ ซึ่งจำเป็นสำหรับอัลกอริทึมการเรียนรู้เชิงลึก

ชิปตัวเร่ง (หรือเรียกสั้นๆ ว่าตัวเร่ง) สามารถเพิ่มความเร็วและประสิทธิภาพของงานการฝึกและอนุมานได้อย่างมาก เมื่อเทียบกับ CPU แบบอเนกประสงค์ ซึ่งเหมาะอย่างยิ่งสำหรับการฝึก โครงข่ายประสาทเทียมและงานที่ต้องใช้การคำนวณสูงที่คล้ายกัน

ตัวอย่างชิปเร่งความเร็ว ได้แก่

- Tensor Processing Unit (TPU) ของ Google ที่มีฮาร์ดแวร์เฉพาะ สำหรับการเรียนรู้เชิงลึก

- GPU ของ NVIDIA ซึ่งแม้จะออกแบบมาเพื่อการประมวลผลกราฟิกในตอนแรก แต่ก็ออกแบบมาเพื่อเปิดใช้การประมวลผลแบบคู่ขนาน ซึ่งจะช่วยเพิ่มความเร็วในการประมวลผลได้อย่างมาก

ความแม่นยำ

จำนวนการคาดการณ์การจัดประเภทที่ถูกต้องหารด้วยจำนวนการคาดการณ์ทั้งหมด โดยการ

เช่น โมเดลที่คาดการณ์ถูกต้อง 40 รายการและคาดการณ์ไม่ถูกต้อง 10 รายการ จะมีความแม่นยำดังนี้

การจัดประเภทแบบไบนารีจะระบุชื่อที่เฉพาะเจาะจง สำหรับหมวดหมู่ต่างๆ ของการคาดการณ์ที่ถูกต้องและ การคาดการณ์ที่ไม่ถูกต้อง ดังนั้น สูตรความแม่นยำสำหรับการจัดประเภทแบบไบนารี จึงเป็นดังนี้

โดย

- TP คือจำนวนผลบวกจริง (การคาดการณ์ที่ถูกต้อง)

- TN คือจำนวนผลลบจริง (การคาดการณ์ที่ถูกต้อง)

- FP คือจำนวนผลบวกลวง (การคาดการณ์ที่ไม่ถูกต้อง)

- FN คือจำนวนผลลบลวง (การคาดการณ์ที่ไม่ถูกต้อง)

เปรียบเทียบความแม่นยำกับความเที่ยงตรงและความอ่อนไหว

ดูข้อมูลเพิ่มเติมได้ที่การจัดประเภท: ความแม่นยำ การเรียกคืน ความเที่ยงตรง และเมตริกที่เกี่ยวข้อง ในหลักสูตรเร่งรัดแมชชีนเลิร์นนิง

การดำเนินการ

ในการเรียนรู้แบบเสริมกำลัง กลไกที่เอเจนต์ เปลี่ยนผ่านระหว่างสถานะของ สภาพแวดล้อม เอเจนต์จะเลือกการดำเนินการโดยใช้นโยบาย

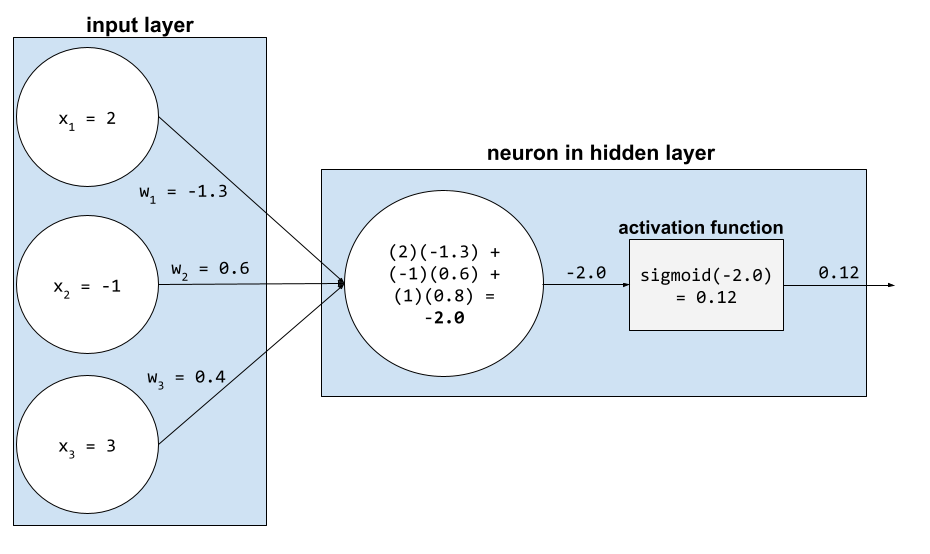

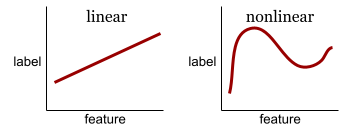

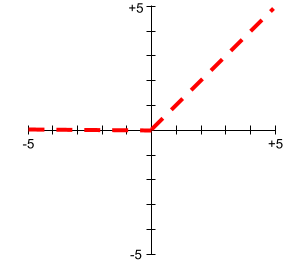

ฟังก์ชันการเปิดใช้งาน

ฟังก์ชันที่ช่วยให้โครงข่ายประสาทเทียมเรียนรู้ความสัมพันธ์ที่ไม่ใช่เชิงเส้น (ซับซ้อน) ระหว่างฟีเจอร์กับป้ายกำกับ

ฟังก์ชันการเปิดใช้งานที่ได้รับความนิยมมีดังนี้

กราฟของฟังก์ชันการเปิดใช้งานจะไม่ใช่เส้นตรงเส้นเดียว ตัวอย่างเช่น พล็อตของฟังก์ชันกระตุ้น ReLU ประกอบด้วยเส้นตรง 2 เส้น ดังนี้

กราฟของฟังก์ชันการเปิดใช้งานแบบซิคมอยด์มีลักษณะดังนี้

ดูข้อมูลเพิ่มเติมได้ที่โครงข่ายประสาทเทียม: ฟังก์ชันการเปิดใช้งาน ในหลักสูตรเร่งรัดแมชชีนเลิร์นนิง

การเรียนรู้แบบลงมือปฏิบัติ

แนวทางการฝึกที่อัลกอริทึมเลือกข้อมูลบางส่วนที่เรียนรู้ การเรียนรู้แบบแอ็กทีฟ มีประโยชน์อย่างยิ่งเมื่อตัวอย่างที่ติดป้ายกำกับ มีอยู่น้อยหรือมีต้นทุนสูง อัลกอริทึมการเรียนรู้แบบลงมือปฏิบัติจะเลือกค้นหาตัวอย่างในช่วงที่ต้องการสำหรับการเรียนรู้ แทนที่จะค้นหาตัวอย่างที่ติดป้ายกำกับหลากหลายโดยไม่เลือก

AdaGrad

อัลกอริทึมการไล่ระดับขั้นสูงที่ปรับขนาดใหม่ การไล่ระดับของพารามิเตอร์แต่ละรายการ ซึ่งทำให้พารามิเตอร์แต่ละรายการมีอัตราการเรียนรู้ที่เป็นอิสระ ดูคำอธิบายแบบเต็มได้ที่ วิธีการย่อยแบบปรับได้สำหรับการเรียนรู้ออนไลน์และการเพิ่มประสิทธิภาพแบบสุ่ม

การดัดแปลง

คำพ้องความหมายของการปรับแต่งหรือการปรับแต่งอย่างละเอียด

ตัวแทน

ซอฟต์แวร์ที่สามารถให้เหตุผลเกี่ยวกับอินพุตของผู้ใช้แบบมัลติโมดัลเพื่อวางแผนและ ดำเนินการในนามของผู้ใช้

ในการเรียนรู้แบบเสริมกำลัง เอเจนต์คือเอนทิตีที่ใช้นโยบายเพื่อเพิ่มผลตอบแทนที่คาดไว้ให้ได้มากที่สุด จากการเปลี่ยนสถานะของสภาพแวดล้อม

เป็น Agent

รูปแบบคำคุณศัพท์ของagent Agentic หมายถึงคุณสมบัติ ที่เอเจนต์มี (เช่น ความเป็นอิสระ)

เวิร์กโฟลว์ที่ใช้ AI Agent

กระบวนการแบบไดนามิกที่เอเจนต์วางแผนและ ดำเนินการโดยอัตโนมัติเพื่อบรรลุเป้าหมาย กระบวนการนี้อาจเกี่ยวข้องกับการให้เหตุผล การเรียกใช้เครื่องมือภายนอก และการแก้ไขแผนด้วยตนเอง

การจัดกลุ่มแบบรวมกลุ่ม

AI Slop

เอาต์พุตจากระบบ Generative AI ที่เน้นปริมาณมากกว่าคุณภาพ เช่น หน้าเว็บที่มีเนื้อหาที่ AI สร้างขึ้นอย่างลวกๆ จะเต็มไปด้วยเนื้อหาคุณภาพต่ำที่ AI สร้างขึ้นอย่างถูกๆ

การตรวจจับความผิดปกติ

กระบวนการระบุค่าผิดปกติ ตัวอย่างเช่น หากค่าเฉลี่ย ของฟีเจอร์หนึ่งๆ คือ 100 โดยมีค่าเบี่ยงเบนมาตรฐานเป็น 10 การตรวจหาความผิดปกติควรแจ้งค่า 200 ว่าน่าสงสัย

AR

ตัวย่อของ Augmented Reality

พื้นที่ใต้กราฟ PR

พื้นที่ใต้กราฟ ROC

ปัญญาประดิษฐ์ทั่วไป

กลไกที่ไม่ใช่มนุษย์ซึ่งแสดงให้เห็นถึงความหลากหลายในการแก้ปัญหา ความคิดสร้างสรรค์ และความสามารถในการปรับตัว เช่น โปรแกรมที่แสดงให้เห็นถึงปัญญาประดิษฐ์ อเนกประสงค์สามารถแปลข้อความ แต่งซิมโฟนี และเล่นเกมที่ยังไม่มีใครเคยประดิษฐ์ได้เก่งกาจ

ปัญญาประดิษฐ์ (AI)

โปรแกรมหรือโมเดลที่ไม่ใช่มนุษย์ซึ่งสามารถแก้โจทย์ที่ซับซ้อนได้ ตัวอย่างเช่น โปรแกรมหรือโมเดลที่แปลข้อความ หรือโปรแกรมหรือโมเดลที่ ระบุโรคจากภาพรังสีวิทยา ทั้ง 2 อย่างนี้แสดงให้เห็นถึงปัญญาประดิษฐ์

ในทางเทคนิคแล้ว แมชชีนเลิร์นนิงเป็นสาขาย่อยของปัญญาประดิษฐ์ (AI) อย่างไรก็ตาม ในช่วงไม่กี่ปีที่ผ่านมา องค์กรบางแห่งเริ่มใช้คำว่าปัญญาประดิษฐ์และแมชชีนเลิร์นนิงสลับกัน

โปรดทราบ

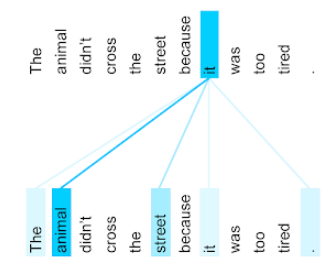

กลไกที่ใช้ในโครงข่ายประสาทเทียมซึ่งบ่งบอกถึงความสำคัญของคำหรือส่วนของคำ Attention จะบีบอัด ปริมาณข้อมูลที่โมเดลต้องใช้ในการคาดการณ์โทเค็น/คำถัดไป กลไกความสนใจทั่วไปอาจประกอบด้วยผลรวมถ่วงน้ำหนักของชุดอินพุต โดยน้ำหนักสำหรับอินพุตแต่ละรายการจะคำนวณโดยส่วนอื่นของโครงข่ายประสาทเทียม

ดูการทำ Self-Attention และ การทำ Self-Attention แบบหลายหัว ซึ่งเป็น องค์ประกอบพื้นฐานของ Transformer

ดูข้อมูลเพิ่มเติมเกี่ยวกับ Self-Attention ได้ที่ LLM: โมเดลภาษาขนาดใหญ่คืออะไร ในหลักสูตรเร่งรัดแมชชีนเลิร์นนิง

แอตทริบิวต์

คำพ้องความหมายของฟีเจอร์

ในความเท่าเทียมของแมชชีนเลิร์นนิง แอตทริบิวต์มักหมายถึง ลักษณะที่เกี่ยวข้องกับบุคคล

การสุ่มตัวอย่างแอตทริบิวต์

กลยุทธ์สำหรับการฝึกDecision Forest ซึ่งDecision Tree แต่ละรายการจะพิจารณาเฉพาะกลุ่มย่อยแบบสุ่มของฟีเจอร์ที่เป็นไปได้เมื่อเรียนรู้เงื่อนไข โดยทั่วไป ระบบจะสุ่มตัวอย่างชุดฟีเจอร์ย่อยที่แตกต่างกันสำหรับแต่ละโหนด ในทางตรงกันข้าม เมื่อฝึกต้นไม้ตัดสินใจโดยไม่ใช้การสุ่มตัวอย่างแอตทริบิวต์ ระบบจะพิจารณาฟีเจอร์ที่เป็นไปได้ทั้งหมดสำหรับแต่ละโหนด

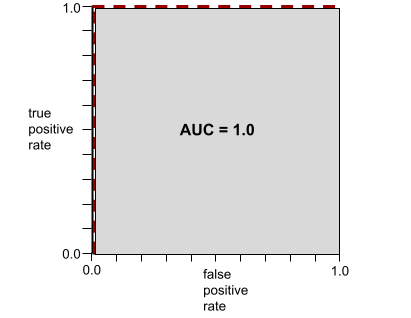

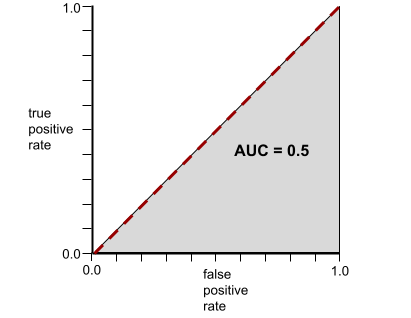

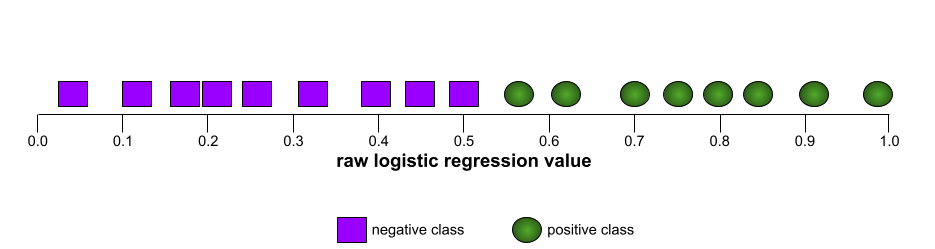

AUC (พื้นที่ใต้กราฟ ROC)

ตัวเลขระหว่าง 0.0 ถึง 1.0 ซึ่งแสดงถึงความสามารถของโมเดลการจัดประเภทแบบไบนารี ในการแยกคลาสที่เป็นบวกออกจากคลาสที่เป็นลบ ยิ่ง AUC ใกล้ 1.0 มากเท่าใด ความสามารถของโมเดลในการแยก คลาสออกจากกันก็จะยิ่งดีขึ้นเท่านั้น

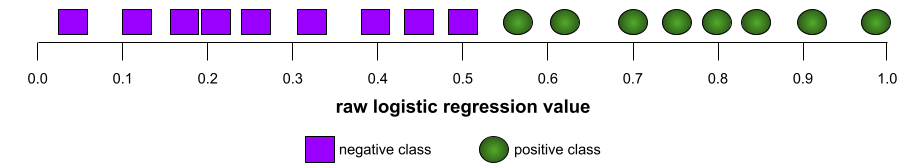

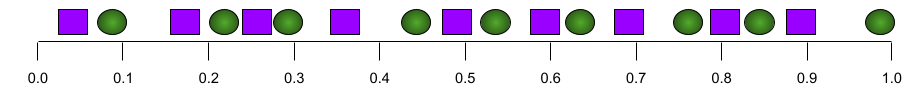

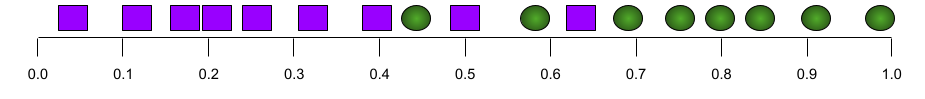

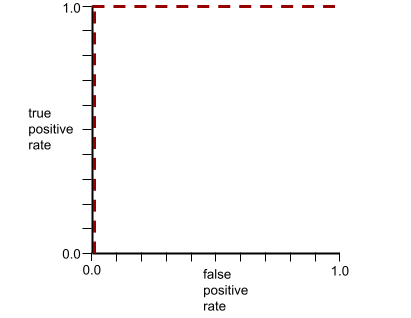

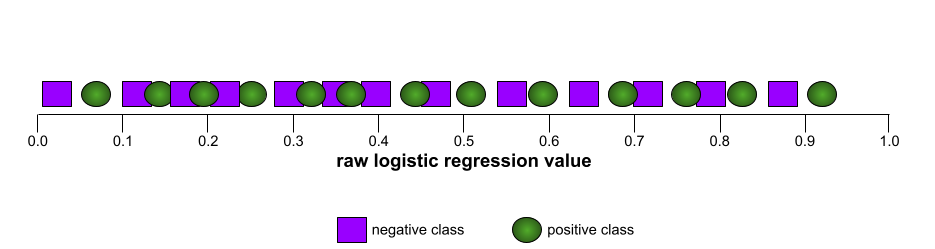

ตัวอย่างเช่น ภาพต่อไปนี้แสดงโมเดลการจัดประเภทที่แยกคลาสเชิงบวก (วงรีสีเขียว) ออกจากคลาสเชิงลบ (สี่เหลี่ยมผืนผ้าสีม่วง) ได้อย่างสมบูรณ์ โมเดลที่สมบูรณ์แบบอย่างไม่สมจริงนี้มี AUC เท่ากับ 1.0

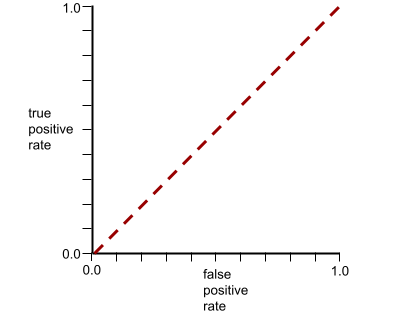

ในทางกลับกัน ภาพต่อไปนี้แสดงผลลัพธ์ของโมเดลการจัดประเภทที่สร้างผลลัพธ์แบบสุ่ม โมเดลนี้มี AUC เท่ากับ 0.5

ใช่ โมเดลก่อนหน้ามี AUC เท่ากับ 0.5 ไม่ใช่ 0.0

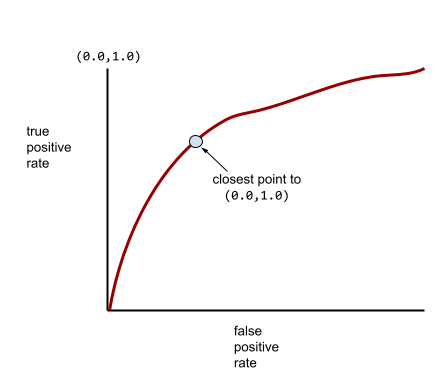

โมเดลส่วนใหญ่จะอยู่ระหว่าง 2 สุดขั้วนี้ ตัวอย่างเช่น โมเดลต่อไปนี้จะแยกผลลัพธ์เชิงบวกออกจากเชิงลบได้ในระดับหนึ่ง ดังนั้นจึงมี AUC อยู่ระหว่าง 0.5 ถึง 1.0

AUC จะไม่สนใจค่าที่คุณตั้งไว้สำหรับ เกณฑ์การแยกประเภท แต่ AUC จะพิจารณาเกณฑ์การแยกประเภทที่เป็นไปได้ทั้งหมด

ดูข้อมูลเพิ่มเติมได้ที่การแยกประเภท: ROC และ AUC ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

เสมือนจริงจำลอง

เทคโนโลยีที่ซ้อนภาพที่คอมพิวเตอร์สร้างขึ้นบนมุมมองโลกแห่งความเป็นจริงของผู้ใช้ จึงทำให้เกิดมุมมองแบบผสม

ออโต้เอนโค้ดเดอร์

ระบบที่เรียนรู้ที่จะดึงข้อมูลที่สำคัญที่สุดจากอินพุต Autoencoder เป็นการรวมกันของEncoder และ Decoder Autoencoder ใช้กระบวนการ 2 ขั้นตอนต่อไปนี้

- ตัวเข้ารหัสจะแมปอินพุตกับรูปแบบที่มีการสูญเสียข้อมูลและมีมิติที่ต่ำกว่า (โดยทั่วไป) (ระดับกลาง)

- ดีโคดเดอร์จะสร้างอินพุตต้นฉบับเวอร์ชันที่มีการสูญเสียโดยการแมปรูปแบบที่มีมิติต่ำกว่ากับรูปแบบอินพุตต้นฉบับที่มีมิติสูงกว่า

Autoencoder ได้รับการฝึกแบบ End-to-End โดยให้ตัวถอดรหัสพยายาม สร้างอินพุตต้นฉบับจากรูปแบบกลางของตัวเข้ารหัส ให้ใกล้เคียงที่สุด เนื่องจากรูปแบบกลางมีขนาดเล็กกว่า (มีมิติข้อมูลต่ำกว่า) รูปแบบเดิม ตัวเข้ารหัสอัตโนมัติจึงต้องเรียนรู้ว่าข้อมูลใดในอินพุตที่จำเป็น และเอาต์พุตจะไม่เหมือนกับอินพุตทุกประการ

เช่น

- หากข้อมูลอินพุตเป็นกราฟิก สำเนาที่ไม่ตรงกันจะคล้ายกับกราฟิกต้นฉบับ แต่มีการแก้ไขเล็กน้อย อาจเป็นเพราะสำเนาที่ไม่ตรงกันจะนำสัญญาณรบกวนออกจากกราฟิกต้นฉบับหรือเติมพิกเซลที่ขาดหายไป

- หากข้อมูลอินพุตเป็นข้อความ ออโต้เอนโค้ดเดอร์จะสร้างข้อความใหม่ที่ เลียนแบบ (แต่ไม่เหมือนกับ) ข้อความต้นฉบับ

ดูVariational Autoencoders ด้วย

การประเมินอัตโนมัติ

การใช้ซอฟต์แวร์เพื่อตัดสินคุณภาพของเอาต์พุตของโมเดล

เมื่อเอาต์พุตของโมเดลค่อนข้างตรงไปตรงมา สคริปต์หรือโปรแกรมจะ เปรียบเทียบเอาต์พุตของโมเดลกับคำตอบที่ถูกต้องได้ บางครั้งเราเรียกการประเมินอัตโนมัติประเภทนี้ว่าการประเมินแบบเป็นโปรแกรม เมตริก เช่น ROUGE หรือ BLEU มักมีประโยชน์สำหรับการประเมินแบบเป็นโปรแกรม

เมื่อเอาต์พุตของโมเดลมีความซับซ้อนหรือไม่มีคำตอบที่ถูกต้องเพียงคำตอบเดียว บางครั้งโปรแกรม ML แยกต่างหากที่เรียกว่าเครื่องมือให้คะแนนอัตโนมัติจะทำการประเมินอัตโนมัติ

เปรียบเทียบกับการประเมินโดยเจ้าหน้าที่

อคติในการทำงานอัตโนมัติ

เมื่อผู้มีอำนาจตัดสินใจที่เป็นมนุษย์เลือกใช้คำแนะนำที่ระบบการตัดสินใจอัตโนมัติสร้างขึ้นมากกว่าข้อมูลที่สร้างขึ้นโดยไม่มีการทำงานอัตโนมัติ แม้ว่าระบบการตัดสินใจอัตโนมัติจะเกิดข้อผิดพลาดก็ตาม

ดูข้อมูลเพิ่มเติมได้ที่ความเป็นธรรม: ประเภทของอคติ ในหลักสูตรเร่งรัดแมชชีนเลิร์นนิง

AutoML

กระบวนการอัตโนมัติใดๆ สำหรับการสร้างแมชชีนเลิร์นนิง โมเดล AutoML สามารถทำงานต่างๆ โดยอัตโนมัติได้ เช่น

- ค้นหาโมเดลที่เหมาะสมที่สุด

- ปรับแต่งไฮเปอร์พารามิเตอร์

- เตรียมข้อมูล (รวมถึงการทำการออกแบบฟีเจอร์)

- ทำให้โมเดลที่ได้ใช้งานได้

AutoML มีประโยชน์สำหรับนักวิทยาศาสตร์ข้อมูลเนื่องจากช่วยประหยัดเวลาและ ความพยายามในการพัฒนาไปป์ไลน์แมชชีนเลิร์นนิง รวมถึงปรับปรุงความแม่นยำในการคาดการณ์ นอกจากนี้ยังเป็นประโยชน์ต่อผู้ที่ไม่เชี่ยวชาญด้วยการทำให้งานแมชชีนเลิร์นนิงที่ซับซ้อนเข้าถึงได้ง่ายขึ้น

ดูข้อมูลเพิ่มเติมได้ที่แมชชีนเลิร์นนิงอัตโนมัติ (AutoML) ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

การประเมิน Autorater

กลไกแบบผสมสำหรับการตัดสินคุณภาพของเอาต์พุตของโมเดลGenerative AI ที่ผสานรวมการประเมินโดยเจ้าหน้าที่เข้ากับการประเมินอัตโนมัติ โปรแกรมให้คะแนนอัตโนมัติคือโมเดล ML ที่ฝึกโดยใช้ข้อมูลที่สร้างขึ้นจากการประเมินโดยเจ้าหน้าที่ ในอุดมคติแล้ว โปรแกรมให้คะแนนอัตโนมัติ จะเรียนรู้ที่จะเลียนแบบผู้ประเมินที่เป็นมนุษย์มีเครื่องมือให้คะแนนอัตโนมัติที่สร้างไว้ล่วงหน้า แต่เครื่องมือให้คะแนนอัตโนมัติที่ดีที่สุดคือเครื่องมือที่ ได้รับการปรับแต่งมาโดยเฉพาะสำหรับงานที่คุณกำลังประเมิน

โมเดลอัตถดถอย

โมเดลที่อนุมานการคาดการณ์ตามการคาดการณ์ก่อนหน้าของตัวเอง เช่น โมเดลภาษาแบบถดถอยอัตโนมัติจะคาดการณ์โทเค็นถัดไปโดยอิงตามโทเค็นที่คาดการณ์ไว้ก่อนหน้านี้ โมเดลภาษาขนาดใหญ่ที่อิงตาม Transformer ทั้งหมดเป็นแบบ Auto-Regressive

ในทางตรงกันข้าม โมเดลรูปภาพที่อิงตาม GAN มักจะไม่ใช่แบบถดถอยอัตโนมัติ เนื่องจากสร้างรูปภาพในการส่งต่อครั้งเดียว ไม่ใช่แบบวนซ้ำใน ขั้นตอนต่างๆ อย่างไรก็ตาม โมเดลการสร้างรูปภาพบางโมเดลเป็นแบบถดถอยอัตโนมัติเนื่องจาก สร้างรูปภาพเป็นขั้นตอน

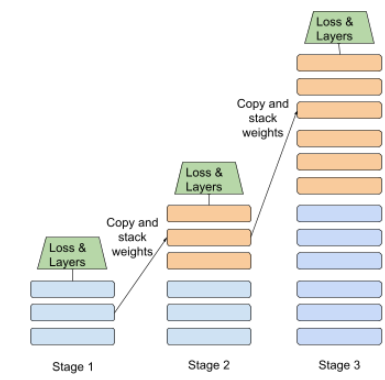

การสูญเสียเสริม

Loss Function ซึ่งใช้ร่วมกับ Loss Function หลักของโมเดลโครงข่ายประสาทเทียมที่ช่วยเร่งการฝึกในระหว่างการทำซ้ำช่วงแรกๆ เมื่อมีการเริ่มต้นน้ำหนักแบบสุ่ม

ฟังก์ชันการสูญเสียเสริมจะส่งการไล่ระดับสีที่มีประสิทธิภาพ ไปยังเลเยอร์ก่อนหน้า ซึ่งช่วยให้การบรรจบกันเป็นไปได้ง่ายขึ้นในระหว่างการฝึก ด้วยการแก้ปัญหาการไล่ระดับสีที่หายไป

ความแม่นยำเฉลี่ยที่ k

เมตริกสำหรับสรุปประสิทธิภาพของโมเดลในพรอมต์เดียวที่สร้างผลลัพธ์ที่จัดอันดับ เช่น รายการคำแนะนำหนังสือที่มีหมายเลข ความแม่นยำเฉลี่ยที่ k คือค่าเฉลี่ยของค่า ความแม่นยำที่ k สำหรับผลลัพธ์ที่เกี่ยวข้องแต่ละรายการ ดังนั้น สูตรสำหรับความแม่นยำเฉลี่ยที่ k คือ

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

โดย

- \(n\) คือจำนวนรายการที่เกี่ยวข้องในรายการ

เปรียบเทียบกับการเรียกคืนที่ k

เงื่อนไขที่สอดคล้องกับแกน

ในแผนผังการตัดสินใจ เงื่อนไข

ที่มีฟีเจอร์เดียวเท่านั้น ตัวอย่างเช่น หาก area

เป็นฟีเจอร์ เงื่อนไขที่สอดคล้องกับแกนจะเป็นดังนี้

area > 200

แตกต่างจากเงื่อนไขที่เอียง

B

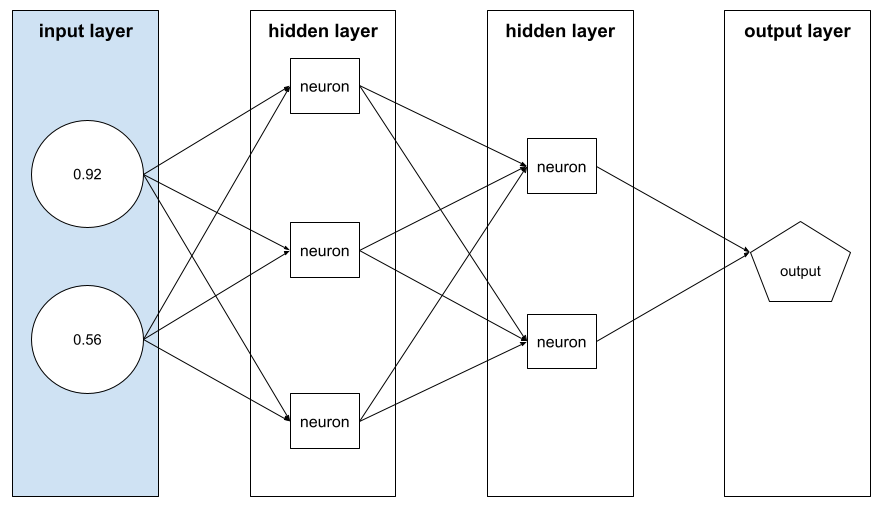

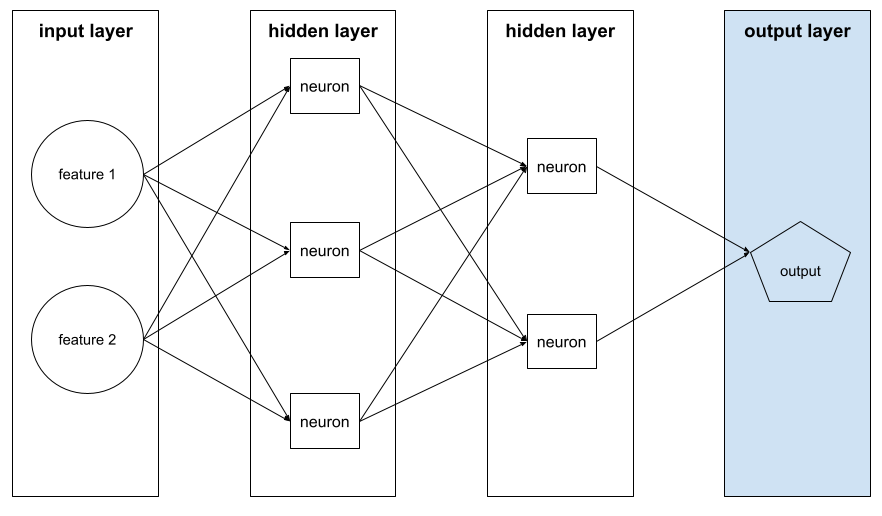

การแพร่ย้อนกลับ

อัลกอริทึมที่ใช้ การไล่ระดับความชันใน โครงข่ายประสาทเทียม

การฝึกโครงข่ายประสาทเทียมต้องทำการทำซ้ำหลายครั้ง ในวงจร 2 รอบต่อไปนี้

- ในระหว่างการส่งต่อ ระบบจะประมวลผลกลุ่มของ ตัวอย่างเพื่อให้ได้การคาดการณ์ ระบบจะเปรียบเทียบค่าการคาดการณ์แต่ละค่ากับค่าป้ายกำกับแต่ละค่า ความแตกต่างระหว่างค่าการคาดการณ์และค่าป้ายกำกับคือการสูญเสียสำหรับตัวอย่างนั้น ระบบจะรวมการสูญเสียสำหรับตัวอย่างทั้งหมดเพื่อคำนวณการสูญเสียทั้งหมดสำหรับกลุ่มปัจจุบัน

- ในการส่งผ่านย้อนกลับ (การแพร่ย้อนกลับ) ระบบจะลดการสูญเสียโดยการ ปรับน้ำหนักของนิวรอนทั้งหมดในเลเยอร์ที่ซ่อนอยู่ทั้งหมด

โดยมักจะมีนิวรอนจำนวนมากในเลเยอร์ที่ซ่อนอยู่หลายเลเยอร์ นิวรอนแต่ละตัวมีส่วนทำให้เกิดการสูญเสียโดยรวมในรูปแบบต่างๆ การแพร่ย้อนกลับจะพิจารณาว่าจะเพิ่มหรือลดน้ำหนัก ที่ใช้กับนิวรอนเฉพาะหรือไม่

อัตราการเรียนรู้คือตัวคูณที่ควบคุม ระดับที่แต่ละการส่งผ่านย้อนกลับจะเพิ่มหรือลดน้ำหนักแต่ละรายการ อัตราการเรียนรู้ที่สูงจะเพิ่มหรือลดน้ำหนักแต่ละรายการมากกว่าอัตราการเรียนรู้ที่ต่ำ

ในแง่ของแคลคูลัส การแพร่ย้อนกลับจะใช้กฎลูกโซ่ จากแคลคูลัส กล่าวคือ การแพร่ย้อนกลับจะคำนวณอนุพันธ์ย่อยของข้อผิดพลาดที่ เกี่ยวข้องกับแต่ละพารามิเตอร์

เมื่อหลายปีก่อน ผู้ปฏิบัติงานด้าน ML ต้องเขียนโค้ดเพื่อใช้การแพร่ย้อนกลับ API ของ ML รุ่นใหม่ เช่น Keras จะใช้การแพร่ย้อนกลับให้คุณ ในที่สุด

ดูข้อมูลเพิ่มเติมได้ที่โครงข่ายประสาทเทียม ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

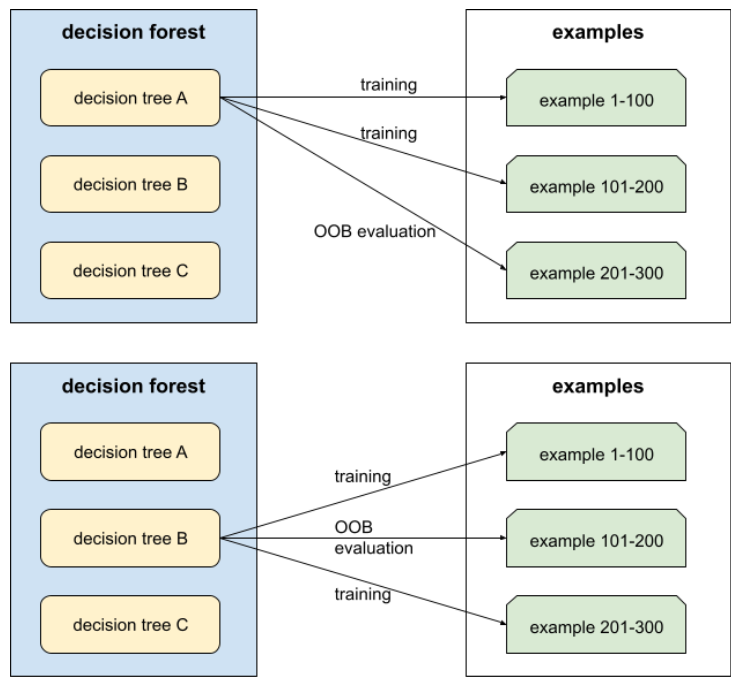

การใส่ถุง

วิธีการฝึกกลุ่ม โดยที่โมเดลแต่ละรายการจะฝึกในชุดย่อยแบบสุ่มของตัวอย่างการฝึกที่สุ่มโดยมีการแทนที่ ตัวอย่างเช่น Random Forest คือชุดของDecision Tree ที่ฝึกด้วยการ Bagging

คำว่า Bagging ย่อมาจาก Bootstrap Aggregating

ดูข้อมูลเพิ่มเติมได้ที่ป่าสุ่ม ในหลักสูตร Decision Forests

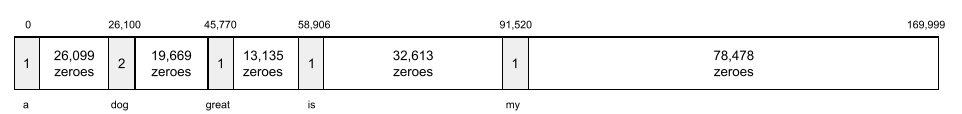

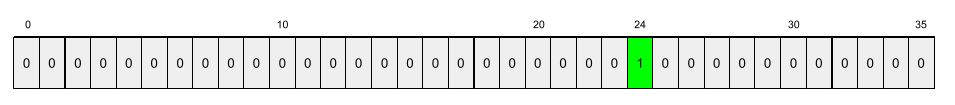

Bag of Words

การแสดงคำในวลีหรือข้อความ โดยไม่คำนึงถึงลำดับ ตัวอย่างเช่น ถุงคำจะแสดงวลี 3 วลีต่อไปนี้เหมือนกัน

- สุนัขกระโดด

- กระโดดข้ามสุนัข

- สุนัขกระโดด

ระบบจะแมปแต่ละคำกับดัชนีในเวกเตอร์แบบกระจัดกระจาย โดยเวกเตอร์จะมีดัชนีสำหรับทุกคำในคำศัพท์ เช่น วลี the dog jumps จะได้รับการแมปเป็นเวกเตอร์ฟีเจอร์ที่มีค่าที่ไม่ใช่ 0 ที่ดัชนี 3 รายการซึ่งสอดคล้องกับคำว่า the, dog และ jumps ค่าที่ไม่ใช่ 0 อาจเป็นค่าใดค่าหนึ่งต่อไปนี้

- 1 เพื่อระบุว่ามีคำนั้นอยู่

- จำนวนครั้งที่คำปรากฏในถุง เช่น หากวลีคือ หมาสีน้ำตาลแดงเป็นหมาที่มีขนสีน้ำตาลแดง ทั้งคำว่าน้ำตาลแดงและหมาจะแสดงเป็น 2 ส่วนคำอื่นๆ จะแสดงเป็น 1

- ค่าอื่นๆ เช่น ลอการิทึมของจำนวนครั้งที่คำปรากฏใน Bag

พื้นฐาน

โมเดลที่ใช้เป็นจุดอ้างอิงในการเปรียบเทียบประสิทธิภาพของโมเดลอื่น (โดยปกติจะเป็นโมเดลที่ซับซ้อนกว่า) ตัวอย่างเช่น โมเดลการถดถอยโลจิสติกอาจเป็นพื้นฐานที่ดีสำหรับโมเดลแบบลึก

สำหรับปัญหาหนึ่งๆ เกณฑ์พื้นฐานจะช่วยให้นักพัฒนาโมเดลสามารถวัดปริมาณ ประสิทธิภาพขั้นต่ำที่คาดหวังซึ่งโมเดลใหม่ต้องทำให้ได้เพื่อให้โมเดลใหม่ มีประโยชน์

โมเดลพื้นฐาน

โมเดลที่ผ่านการฝึกมาก่อนซึ่งใช้เป็นจุดเริ่มต้นสำหรับการปรับแต่งเพื่อจัดการกับงานหรือแอปพลิเคชันที่เฉพาะเจาะจง

ดูโมเดลก่อนการฝึก และโมเดลพื้นฐานด้วย

กลุ่ม

ชุดตัวอย่างที่ใช้ในการฝึกซ้ำ 1 ครั้ง ขนาดกลุ่มจะกำหนดจำนวนตัวอย่างในกลุ่ม

ดูคำอธิบายว่ากลุ่มข้อมูลเกี่ยวข้องกับ Epoch อย่างไรได้ที่Epoch

ดูข้อมูลเพิ่มเติมได้ที่การถดถอยเชิงเส้น: ไฮเปอร์พารามิเตอร์ ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

การอนุมานแบบกลุ่ม

กระบวนการอนุมานการคาดการณ์ในตัวอย่างที่ไม่มีป้ายกำกับหลายรายการซึ่งแบ่งออกเป็นชุดข้อมูลย่อย ("กลุ่ม") ที่เล็กลง

การอนุมานแบบกลุ่มสามารถใช้ประโยชน์จากฟีเจอร์การประมวลผลแบบคู่ขนานของชิปตัวเร่ง กล่าวคือ ตัวเร่งหลายตัว สามารถอนุมานการคาดการณ์ในกลุ่มตัวอย่างที่ไม่มีป้ายกำกับ ที่แตกต่างกันได้พร้อมกัน ซึ่งจะเพิ่มจำนวนการอนุมานต่อวินาทีอย่างมาก

ดูข้อมูลเพิ่มเติมได้ที่ระบบ ML ในการใช้งานจริง: การอนุมานแบบคงที่เทียบกับการอนุมานแบบไดนามิก ในหลักสูตรเร่งรัดแมชชีนเลิร์นนิง

การแปลงข้อมูลเป็นรูปแบบมาตรฐานแบบกลุ่ม

การปรับอินพุตหรือเอาต์พุตของฟังก์ชันการเปิดใช้งานในเลเยอร์ที่ซ่อนอยู่ การทําให้เป็นมาตรฐานแบบกลุ่มมีประโยชน์ดังนี้

- ทำให้โครงข่ายประสาทเทียมมีเสถียรภาพมากขึ้นด้วยการป้องกัน ค่าผิดปกติ

- เปิดใช้อัตราการเรียนรู้ที่สูงขึ้น ซึ่งจะช่วย เร่งการฝึก

- ลดการปรับมากเกินไป

ขนาดกลุ่ม

จำนวนตัวอย่างในกลุ่ม เช่น หากขนาดกลุ่มคือ 100 โมเดลจะประมวลผลตัวอย่าง 100 รายการต่อการทำซ้ำ

กลยุทธ์ขนาดกลุ่มยอดนิยมมีดังนี้

- การไล่ระดับสีแบบสุ่ม (SGD) ซึ่งมีขนาดกลุ่มเท่ากับ 1

- การประมวลผลแบบกลุ่มเต็ม ซึ่งขนาดกลุ่มคือจํานวนตัวอย่างในชุดการฝึกทั้งหมด เช่น หากชุดการฝึกมีตัวอย่าง 1 ล้านรายการ ขนาดกลุ่มจะเท่ากับตัวอย่าง 1 ล้านรายการ โดยปกติแล้ว การประมวลผลแบบกลุ่มทั้งหมดมักเป็นกลยุทธ์ที่ไม่มีประสิทธิภาพ

- มินิแบตช์ ซึ่งโดยปกติแล้วขนาดแบตช์จะอยู่ระหว่าง 10 ถึง 1,000 โดยปกติแล้ว มินิแบทช์เป็นกลยุทธ์ที่มีประสิทธิภาพมากที่สุด

โปรดดูข้อมูลเพิ่มเติมที่ด้านล่าง

- ระบบ ML ที่ใช้งานจริง: การอนุมานแบบคงที่เทียบกับการอนุมานแบบไดนามิก ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

- Playbook การปรับแต่ง Deep Learning

โครงข่ายประสาทเทียมแบบ Bayesian

โครงข่ายประสาทเทียมเชิงความน่าจะเป็นที่พิจารณา ความไม่แน่นอนในน้ำหนักและเอาต์พุต โดยปกติแล้วโมเดลการถดถอยของโครงข่ายประสาทเทียมมาตรฐานจะคาดการณ์ค่าสเกลาร์ เช่น โมเดลมาตรฐานคาดการณ์ราคาบ้าน ที่ 853,000 ในทางตรงกันข้าม เครือข่ายประสาทแบบเบย์จะคาดการณ์การกระจายค่า ตัวอย่างเช่น โมเดลแบบเบย์คาดการณ์ราคาบ้านที่ 853,000 โดยมี ส่วนเบี่ยงเบนมาตรฐานที่ 67,200

โครงข่ายประสาทแบบเบย์ใช้ ทฤษฎีบทของเบย์ เพื่อคำนวณความไม่แน่นอนในน้ำหนักและการคาดการณ์ โครงข่ายประสาทเทียมแบบเบย์มีประโยชน์เมื่อต้องการวัดความไม่แน่นอน เช่น ในโมเดลที่เกี่ยวข้องกับยา นอกจากนี้ เครือข่ายประสาทแบบเบย์ยังช่วย ป้องกันการปรับมากเกินไปได้ด้วย

การเพิ่มประสิทธิภาพ Bayesian

เทคนิคโมเดลการถดถอยเชิงความน่าจะเป็น ในการเพิ่มประสิทธิภาพฟังก์ชันเป้าหมายที่ใช้การคำนวณสูง โดยการเพิ่มประสิทธิภาพตัวแทนแทน ซึ่งจะวัดปริมาณความไม่แน่นอนโดยใช้เทคนิคการเรียนรู้แบบเบส์ เนื่องจากการเพิ่มประสิทธิภาพแบบเบย์เองก็มีค่าใช้จ่ายสูงมาก จึงมักใช้เพื่อเพิ่มประสิทธิภาพงานที่มีค่าใช้จ่ายสูงในการประเมินซึ่งมีพารามิเตอร์จำนวนน้อย เช่น การเลือกไฮเปอร์พารามิเตอร์

สมการเบลแมน

ในการเรียนรู้แบบเสริมกำลัง ฟังก์ชัน Q ที่ดีที่สุดจะตรงกับเอกลักษณ์ต่อไปนี้

\[Q(s, a) = r(s, a) + \gamma \mathbb{E}_{s'|s,a} \max_{a'} Q(s', a')\]

อัลกอริทึมการเรียนรู้แบบเสริมกำลังใช้ข้อมูลประจำตัวนี้ เพื่อสร้างการเรียนรู้แบบ Q โดยใช้กฎการอัปเดตต่อไปนี้

\[Q(s,a) \gets Q(s,a) + \alpha \left[r(s,a) + \gamma \displaystyle\max_{\substack{a_1}} Q(s',a') - Q(s,a) \right] \]

นอกจากเรื่องการเรียนรู้แบบเสริมกำลังแล้ว สมการเบลแมนยังนำไปใช้กับ การเขียนโปรแกรมแบบไดนามิกได้ด้วย ดู รายการใน Wikipedia สำหรับสมการเบลแมน

BERT (Bidirectional Encoder Representations from Transformers)

สถาปัตยกรรมโมเดลสำหรับการแสดงข้อความ โมเดล BERT ที่ฝึกแล้วสามารถทำหน้าที่เป็นส่วนหนึ่งของโมเดลขนาดใหญ่สำหรับการจัดประเภทข้อความหรืองาน ML อื่นๆ ได้

BERT มีลักษณะดังนี้

- ใช้สถาปัตยกรรม Transformer จึงต้องอาศัยการใส่ใจตนเอง

- ใช้ส่วนEncoder ของ Transformer หน้าที่ของตัวเข้ารหัส คือการสร้างการแสดงข้อความที่ดี ไม่ใช่การทำงานเฉพาะ อย่าง เช่น การจัดประเภท

- แบบ 2 ทิศทาง

- ใช้การมาสก์สำหรับ การฝึกที่ไม่มีการควบคุมดูแล

รูปแบบต่างๆ ของ BERT มีดังนี้

ดูภาพรวมของ BERT ได้ที่การเปิดซอร์ส BERT: การฝึกแบบล่วงหน้าที่มีประสิทธิภาพสูงสุดสำหรับการประมวลผลภาษาธรรมชาติ

อคติ (จริยธรรม/ความยุติธรรม)

1. การเหมารวม อคติ หรือการเข้าข้างสิ่งต่างๆ บุคคล หรือกลุ่มบางกลุ่มมากกว่ากลุ่มอื่นๆ อคติเหล่านี้อาจส่งผลต่อการเก็บรวบรวมและการตีความข้อมูล การออกแบบระบบ และวิธีที่ผู้ใช้โต้ตอบกับระบบ รูปแบบของอคติประเภทนี้ ได้แก่

- อคติในการทำงานอัตโนมัติ

- อคติยืนยันความคิดตัวเอง

- อคติของผู้ทดลอง

- อคติในการระบุแหล่งที่มาของกลุ่ม

- อคติโดยไม่รู้ตัว

- อคติในกลุ่ม

- อคติเกี่ยวกับความเหมือนกันของกลุ่มนอก

2. ข้อผิดพลาดของระบบที่เกิดจากขั้นตอนการสุ่มตัวอย่างหรือการรายงาน รูปแบบของอคติประเภทนี้ ได้แก่

- อคติในการครอบคลุม

- ความลำเอียงจากการไม่ตอบ

- อคติในการเข้าร่วม

- อคติในการรายงาน

- อคติในการสุ่มตัวอย่าง

- อคติในการเลือก

อย่าสับสนกับคำว่าอคติในโมเดลแมชชีนเลิร์นนิง หรืออคติในการคาดการณ์

ดูข้อมูลเพิ่มเติมได้ที่ความเป็นธรรม: ประเภทของอคติใน หลักสูตรเร่งรัดแมชชีนเลิร์นนิง

อคติ (คณิตศาสตร์) หรือเทอมอคติ

จุดตัดหรือออฟเซ็ตจากต้นทาง อคติเป็นพารามิเตอร์ในโมเดลแมชชีนเลิร์นนิง ซึ่งแสดงด้วยสัญลักษณ์ต่อไปนี้

- b

- w0

ตัวอย่างเช่น อคติคือ b ในสูตรต่อไปนี้

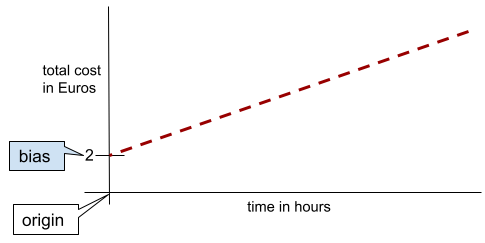

ในเส้น 2 มิติแบบง่ายๆ อคติหมายถึง "จุดตัดแกน y" ตัวอย่างเช่น อคติของเส้นในภาพต่อไปนี้คือ 2

ความเอนเอียงเกิดขึ้นเนื่องจากโมเดลบางรายการไม่ได้เริ่มต้นจากจุดกำเนิด (0,0) ตัวอย่างเช่น สมมติว่าค่าเข้าสวนสนุกคือ 20 บาท และมีค่าใช้จ่ายเพิ่มเติม 5 บาทต่อชั่วโมงที่ลูกค้าอยู่ในสวนสนุก ดังนั้น โมเดลที่แมปต้นทุนทั้งหมดจึงมีอคติเป็น 2 เนื่องจากต้นทุนต่ำสุดคือ 2 ยูโร

อย่าสับสนระหว่างอคติกับอคติในด้านจริยธรรมและความเป็นธรรม หรืออคติในการคาดการณ์

ดูข้อมูลเพิ่มเติมได้ที่การถดถอยเชิงเส้น ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

แบบ 2 ทิศทาง

คำที่ใช้เพื่ออธิบายระบบที่ประเมินข้อความที่อยู่ก่อนหน้า และต่อจากส่วนข้อความเป้าหมาย ในทางตรงกันข้าม ระบบแบบทิศทางเดียวจะประเมินเฉพาะข้อความที่อยู่ก่อนข้อความเป้าหมาย

ตัวอย่างเช่น ลองพิจารณาโมเดลภาษาที่มาสก์ซึ่ง ต้องกำหนดความน่าจะเป็นของคำหรือคำที่แสดงถึงขีดเส้นใต้ใน คำถามต่อไปนี้

คุณเป็นอะไร

โมเดลภาษาแบบทิศทางเดียวจะต้องอิงความน่าจะเป็นจากบริบทที่คำว่า "What", "is" และ "the" เท่านั้น ในทางตรงกันข้าม โมเดลภาษาแบบสองทิศทางยังสามารถรับบริบทจากคำว่า "กับ" และ "คุณ" ได้ด้วย ซึ่งอาจช่วยให้โมเดลคาดการณ์ได้ดียิ่งขึ้น

โมเดลภาษาแบบ 2 ทิศทาง

โมเดลภาษาที่กำหนดความน่าจะเป็นที่โทเค็นที่กำหนดจะอยู่ในตำแหน่งที่กำหนดในข้อความที่ตัดตอนโดยอิงตามข้อความก่อนหน้าและถัดไป

ไบแกรม

N-gram ที่ N=2

การจัดประเภทแบบไบนารี

งานการจัดประเภทประเภทหนึ่งที่ คาดการณ์คลาสใดคลาสหนึ่งใน 2 คลาสที่แยกกันโดยสิ้นเชิง

ตัวอย่างเช่น โมเดลแมชชีนเลิร์นนิง 2 รายการต่อไปนี้แต่ละรายการจะทำการ การจัดประเภทแบบไบนารี

- โมเดลที่พิจารณาว่าข้อความอีเมลเป็นจดหมายขยะ (คลาสเชิงบวก) หรือไม่ใช่จดหมายขยะ (คลาสเชิงลบ)

- โมเดลที่ประเมินอาการทางการแพทย์เพื่อพิจารณาว่าบุคคล เป็นโรคใดโรคหนึ่ง (คลาสบวก) หรือไม่เป็นโรคดังกล่าว (คลาสลบ)

เปรียบเทียบกับการจัดประเภทแบบหลายคลาส

ดูเพิ่มเติมที่การถดถอยโลจิสติกและ เกณฑ์การจัดประเภท

ดูข้อมูลเพิ่มเติมได้ที่การจัดประเภท ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

เงื่อนไขไบนารี

ในแผนผังการตัดสินใจ เงื่อนไข ที่มีผลลัพธ์ที่เป็นไปได้เพียง 2 อย่าง โดยปกติคือใช่หรือไม่ใช่ ตัวอย่างเช่น เงื่อนไขต่อไปนี้เป็นเงื่อนไขแบบไบนารี

temperature >= 100

เปรียบเทียบกับเงื่อนไขที่ไม่ใช่แบบไบนารี

ดูข้อมูลเพิ่มเติมได้ที่ประเภทของเงื่อนไข ในหลักสูตร Decision Forests

การจัดกลุ่ม

คำพ้องความหมายของการจัดกลุ่ม

โมเดลกล่องดำ

โมเดลที่มนุษย์ไม่สามารถเข้าใจ "การให้เหตุผล" ได้หรือเข้าใจได้ยาก กล่าวคือ แม้ว่ามนุษย์จะเห็นว่าพรอมต์ ส่งผลต่อคำตอบอย่างไร แต่ก็ไม่สามารถระบุได้อย่างแน่ชัดว่าโมเดลกล่องดำกำหนดคำตอบอย่างไร กล่าวคือ โมเดลกล่องดำไม่มีความสามารถในการตีความ

โมเดลเชิงลึกและ โมเดลภาษาขนาดใหญ่ส่วนใหญ่เป็นกล่องดำ

BLEU (Bilingual Evaluation Understudy)

เมตริกระหว่าง 0.0 ถึง 1.0 สำหรับการประเมินการแปลด้วยเครื่อง เช่น จากภาษาสเปนเป็นภาษาญี่ปุ่น

โดยปกติแล้ว BLEU จะเปรียบเทียบการแปลของโมเดล ML (ข้อความที่สร้างขึ้น) กับการแปลของมนุษย์ผู้เชี่ยวชาญ (ข้อความอ้างอิง) เพื่อคำนวณคะแนน ระดับที่ N-gram ในข้อความที่สร้างขึ้นและ ข้อความอ้างอิงตรงกันจะเป็นตัวกำหนดคะแนน BLEU

เอกสารต้นฉบับเกี่ยวกับเมตริกนี้คือ BLEU: a Method for Automatic Evaluation of Machine Translation

ดู BLEURT เพิ่มเติม

BLEURT (Bilingual Evaluation Understudy from Transformers)

เมตริกสําหรับการประเมินการแปลด้วยเครื่อง จากภาษาหนึ่งเป็นอีกภาษาหนึ่ง โดยเฉพาะอย่างยิ่งจากและเป็นภาษาอังกฤษ

สำหรับการแปลเป็นและจากภาษาอังกฤษ BLEURT จะสอดคล้องกับการให้คะแนนของมนุษย์มากกว่า BLEU BLEURT เน้นความคล้ายคลึงกันทางความหมาย (ความหมาย) และรองรับการถอดความ ซึ่งแตกต่างจาก BLEU

BLEURT ใช้โมเดลภาษาขนาดใหญ่ที่ฝึกล่วงหน้า (BERT อย่างแม่นยำ) ซึ่งจะปรับแต่ง ในข้อความจากนักแปลที่เป็นมนุษย์

เอกสารต้นฉบับเกี่ยวกับเมตริกนี้คือ BLEURT: Learning Robust Metrics for Text Generation

คำถามบูลีน (BoolQ)

ชุดข้อมูลสำหรับประเมินความสามารถของ LLM ในการตอบคำถามแบบใช่หรือไม่ ความท้าทายแต่ละอย่างในชุดข้อมูลมีองค์ประกอบ 3 อย่าง ดังนี้

- คำค้นหา

- ข้อความที่สื่อถึงคำตอบของคำค้นหา

- คำตอบที่ถูกต้อง ซึ่งอาจเป็นใช่หรือไม่ใช่

เช่น

- คำถาม: รัฐมิชิแกนมีโรงไฟฟ้านิวเคลียร์ไหม

- ข้อความ: ...โรงไฟฟ้านิวเคลียร์ 3 แห่งจ่ายไฟฟ้าให้มิชิแกน ประมาณ 30%

- คำตอบที่ถูกต้อง: ใช่

นักวิจัยรวบรวมคำถามจากคำค้นหาใน Google Search ที่รวบรวมและลบข้อมูลระบุตัวบุคคลแล้ว จากนั้นใช้หน้า Wikipedia เพื่ออ้างอิงข้อมูล

ดูข้อมูลเพิ่มเติมได้ที่ BoolQ: Exploring the Surprising Difficulty of Natural Yes/No Questions

BoolQ เป็นองค์ประกอบของกลุ่ม SuperGLUE

BoolQ

ตัวย่อของคำถามบูลีน

การเพิ่ม

เทคนิคแมชชีนเลิร์นนิงที่รวมชุดโมเดลการแยกประเภทอย่างง่ายที่ไม่แม่นยำนัก (เรียกว่า "ตัวแยกประเภทแบบอ่อน") เข้ากับโมเดลการแยกประเภทที่มีความแม่นยำสูง ("ตัวแยกประเภทแบบเข้ม") โดยการเพิ่มน้ำหนักให้กับตัวอย่างที่โมเดลแยกประเภทผิดในปัจจุบัน

ดูข้อมูลเพิ่มเติมได้ที่Gradient Boosted Decision Trees? ในหลักสูตร Decision Forests

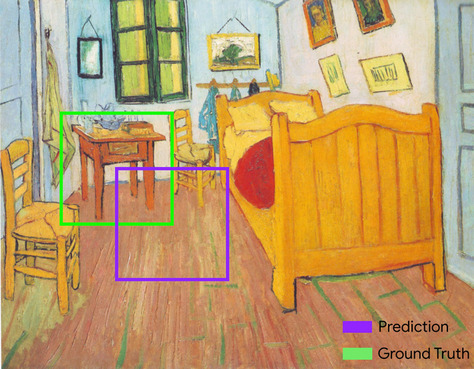

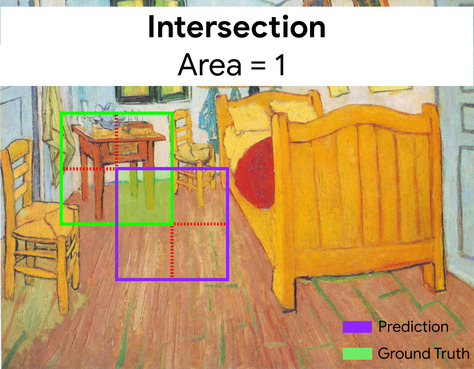

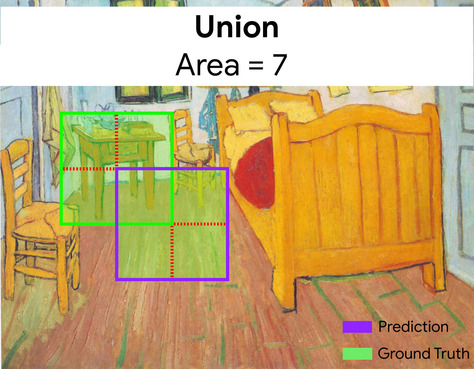

กรอบล้อมรอบ

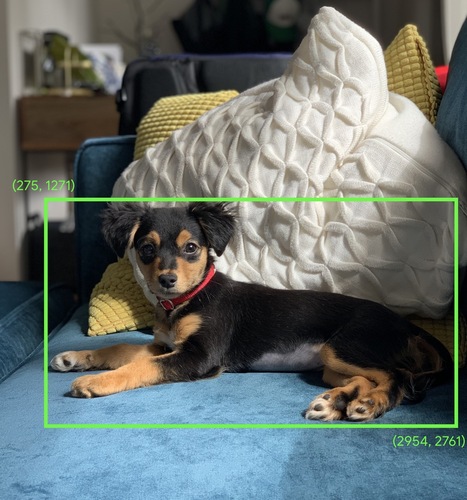

ในรูปภาพ พิกัด (x, y) ของสี่เหลี่ยมผืนผ้ารอบพื้นที่ที่น่าสนใจ เช่น สุนัขในรูปภาพด้านล่าง

การออกอากาศ

การขยายรูปร่างของตัวถูกดำเนินการในการดำเนินการทางคณิตศาสตร์ของเมทริกซ์ให้เป็นมิติข้อมูลที่เข้ากันได้กับการดำเนินการนั้น ตัวอย่างเช่น พีชคณิตเชิงเส้นกำหนดว่าตัวถูกดำเนินการทั้ง 2 ตัวในการดำเนินการบวกเมทริกซ์ ต้องมีมิติข้อมูลเดียวกัน ดังนั้น คุณจึงเพิ่มเมทริกซ์ที่มีรูปร่าง (m, n) ให้กับเวกเตอร์ที่มีความยาว n ไม่ได้ การออกอากาศช่วยให้ดำเนินการนี้ได้โดย ขยายเวกเตอร์ที่มีความยาว n เป็นเมทริกซ์ที่มีรูปร่าง (m, n) โดย ทำซ้ำค่าเดียวกันในแต่ละคอลัมน์

ดูรายละเอียดเพิ่มเติมได้ที่คำอธิบายต่อไปนี้ของ การออกอากาศใน NumPy

การจัดกลุ่ม

การแปลงฟีเจอร์เดียวเป็นฟีเจอร์ไบนารีหลายรายการ ที่เรียกว่ากลุ่มหรือถัง โดยปกติจะอิงตามช่วงค่า โดยปกติแล้ว ฟีเจอร์ที่ถูกตัดจะเป็นฟีเจอร์ต่อเนื่อง

ตัวอย่างเช่น แทนที่จะแสดงอุณหภูมิเป็นฟีเจอร์ทศนิยมต่อเนื่องเดียว คุณสามารถแบ่งช่วงอุณหภูมิ ออกเป็นกลุ่มที่ไม่ต่อเนื่อง เช่น

- <= 10 องศาเซลเซียสจะอยู่ในกลุ่ม "เย็น"

- 11-24 องศาเซลเซียสจะอยู่ในกลุ่ม "ปานกลาง"

- >= 25 องศาเซลเซียสจะเป็นกลุ่ม "อุ่น"

โมเดลจะถือว่าค่าทุกค่าในกลุ่มเดียวกันเหมือนกัน ตัวอย่างเช่น ค่า 13 และ 22 อยู่ในกลุ่มอุณหภูมิปานกลางทั้งคู่ ดังนั้นโมเดลจึงถือว่าค่าทั้ง 2 เหมือนกัน

ดูข้อมูลเพิ่มเติมได้ที่ข้อมูลเชิงตัวเลข: การจัดกลุ่ม ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

C

เลเยอร์การปรับเทียบ

การปรับหลังการคาดการณ์ ซึ่งโดยปกติจะใช้เพื่ออธิบายอคติในการคาดการณ์ การคาดการณ์และความน่าจะเป็นที่ปรับแล้วควรตรงกับการกระจายของชุดป้ายกำกับที่สังเกตได้

การสร้างผู้สมัคร

ชุดคำแนะนำเริ่มต้นที่ระบบการแนะนำเลือก ตัวอย่างเช่น ลองพิจารณาร้านหนังสือที่มีหนังสือ 100,000 ชื่อ ระยะการสร้างรายการตัวเลือกจะสร้างรายการหนังสือที่เหมาะสมสำหรับผู้ใช้รายหนึ่งๆ ซึ่งมีขนาดเล็กลงมาก เช่น 500 รายการ แต่หนังสือ 500 เล่มก็ยังมากเกินไปที่จะแนะนำให้ผู้ใช้ ระยะต่อๆ ไปของระบบการแนะนำซึ่งมีราคาแพงกว่า (เช่น การให้คะแนนและ การจัดอันดับใหม่) จะลดจำนวนคำแนะนำ 500 รายการดังกล่าวให้เหลือชุดคำแนะนำที่เล็กลงมาก และมีประโยชน์มากขึ้น

ดูข้อมูลเพิ่มเติมได้ที่ภาพรวมการสร้างแคนดิเดต ในหลักสูตรระบบการแนะนำ

การสุ่มตัวอย่างผู้สมัคร

การเพิ่มประสิทธิภาพในเวลาฝึกที่คำนวณความน่าจะเป็นสำหรับป้ายกำกับเชิงบวกทั้งหมด โดยใช้เช่น softmax แต่ใช้เฉพาะกับตัวอย่างป้ายกำกับเชิงลบแบบสุ่ม เช่น หากมีตัวอย่างที่ติดป้ายกำกับว่า บีเกิลและสุนัข การสุ่มตัวอย่างผู้สมัครจะคำนวณความน่าจะเป็นที่คาดการณ์ และข้อกำหนดการสูญเสียที่เกี่ยวข้องสำหรับ

- บีเกิล

- สุนัข

- ชุดย่อยแบบสุ่มของคลาสเชิงลบที่เหลือ (เช่น cat lollipop fence)

แนวคิดคือคลาสเชิงลบสามารถเรียนรู้จากการเสริมแรงเชิงลบที่เกิดขึ้นไม่บ่อยนักได้ ตราบใดที่คลาสเชิงบวกได้รับการเสริมแรงเชิงบวกที่เหมาะสมอยู่เสมอ และเราก็สังเกตเห็นสิ่งนี้ได้จากการทดลอง

การสุ่มตัวอย่างผู้สมัครมีประสิทธิภาพด้านการคำนวณมากกว่าอัลกอริทึมการฝึกที่คำนวณการคาดการณ์สำหรับคลาสเชิงลบทั้งหมด โดยเฉพาะอย่างยิ่งเมื่อจำนวนคลาสเชิงลบมีจำนวนมาก

ข้อมูลเชิงหมวดหมู่

ฟีเจอร์ที่มีชุดค่าที่เป็นไปได้ที่เฉพาะเจาะจง ตัวอย่างเช่น

พิจารณาฟีเจอร์เชิงหมวดหมู่ชื่อ traffic-light-state ซึ่งมีค่าได้เพียงค่าใดค่าหนึ่งจาก 3 ค่าต่อไปนี้

redyellowgreen

การแสดง traffic-light-state เป็นฟีเจอร์เชิงหมวดหมู่

จะช่วยให้โมเดลเรียนรู้

ผลกระทบที่แตกต่างกันของ red, green และ yellow ต่อพฤติกรรมของผู้ขับได้

บางครั้งฟีเจอร์เชิงหมวดหมู่เรียกว่าฟีเจอร์ที่ไม่ต่อเนื่อง

แตกต่างจากข้อมูลเชิงตัวเลข

ดูข้อมูลเพิ่มเติมได้ที่การทำงานกับข้อมูลเชิงหมวดหมู่ในหลักสูตรเร่งรัดแมชชีนเลิร์นนิง

โมเดลภาษาแบบเป็นเหตุเป็นผล

คำพ้องความหมายของโมเดลภาษาแบบทิศทางเดียว

ดูโมเดลภาษาแบบสองทิศทางเพื่อเปรียบเทียบแนวทางแบบทิศทางต่างๆ ในการสร้างโมเดลภาษา

CB

ตัวย่อของ CommitmentBank

เซนทรอยด์

จุดศูนย์กลางของคลัสเตอร์ตามที่กำหนดโดยอัลกอริทึม k-means หรือ k-median เช่น หาก k คือ 3 อัลกอริทึม k-means หรือ k-median จะพบจุดศูนย์กลาง 3 จุด

ดูข้อมูลเพิ่มเติมได้ที่อัลกอริทึมการจัดกลุ่ม ในหลักสูตรการจัดกลุ่ม

การจัดกลุ่มตามเซนทรอยด์

หมวดหมู่อัลกอริทึมการจัดกลุ่มที่จัดระเบียบข้อมูล เป็นคลัสเตอร์แบบไม่เป็นลำดับชั้น k-means เป็นอัลกอริทึมการจัดกลุ่มตามจุดศูนย์กลางที่ใช้กันอย่างแพร่หลายมากที่สุด

เปรียบเทียบกับอัลกอริทึมการจัดกลุ่มแบบลำดับชั้น

ดูข้อมูลเพิ่มเติมได้ที่อัลกอริทึมการจัดกลุ่ม ในหลักสูตรการจัดกลุ่ม

การเขียนพรอมต์แบบ Chain-of-Thought

เทคนิคการออกแบบพรอมต์ที่กระตุ้นให้โมเดลภาษาขนาดใหญ่ (LLM) อธิบายการให้เหตุผลทีละขั้นตอน ตัวอย่างเช่น ลองพิจารณาพรอมต์ต่อไปนี้ โดยให้ความสนใจเป็นพิเศษกับประโยคที่ 2

ผู้ขับขี่จะได้รับแรงโน้มถ่วงกี่ G ในรถยนต์ที่วิ่งจาก 0 ถึง 60 ไมล์ต่อชั่วโมงใน 7 วินาที แสดงการคำนวณที่เกี่ยวข้องทั้งหมดในคำตอบ

คำตอบของ LLM น่าจะมีลักษณะดังนี้

- แสดงลำดับสูตรฟิสิกส์ โดยเสียบค่า 0, 60 และ 7 ในตำแหน่งที่เหมาะสม

- อธิบายเหตุผลที่เลือกใช้สูตรเหล่านั้นและความหมายของตัวแปรต่างๆ

การแจ้งแบบลูกโซ่ความคิดจะบังคับให้ LLM ทำการคำนวณทั้งหมด ซึ่งอาจนำไปสู่คำตอบที่ถูกต้องมากขึ้น นอกจากนี้ การแจ้งแบบลูกโซ่ความคิด ยังช่วยให้ผู้ใช้ตรวจสอบขั้นตอนของ LLM เพื่อพิจารณาว่าคำตอบสมเหตุสมผลหรือไม่

คะแนน F ของ N-gram อักขระ (ChrF)

เมตริกสำหรับประเมินโมเดลการแปลด้วยเครื่อง คะแนน F ของ N-gram อักขระจะกำหนดระดับที่ N-gram ในข้อความอ้างอิงซ้อนทับกับ N-gram ในข้อความที่สร้างขึ้นของโมเดล ML

คะแนน F ของ N-gram อักขระคล้ายกับเมตริกในกลุ่ม ROUGE และ BLEU ยกเว้นว่า

- คะแนน F ของ N-gram อักขระจะทำงานกับ N-gram อักขระ

- ROUGE และ BLEU ทำงานกับ N-gram ของคำหรือโทเค็น

แชท

เนื้อหาของบทสนทนาไปมากับระบบ ML ซึ่งโดยทั่วไปคือโมเดลภาษาขนาดใหญ่ การโต้ตอบก่อนหน้าในแชท (สิ่งที่คุณพิมพ์และวิธีที่โมเดลภาษาขนาดใหญ่ตอบกลับ) จะกลายเป็น บริบทสำหรับส่วนต่อๆ ไปของแชท

แชทบ็อตคือแอปพลิเคชันของโมเดลภาษาขนาดใหญ่

จุดตรวจ

ข้อมูลที่บันทึกสถานะของพารามิเตอร์ของโมเดล ไม่ว่าจะ ระหว่างการฝึกหรือหลังจากฝึกเสร็จแล้ว ตัวอย่างเช่น ในระหว่างการฝึก คุณจะทำสิ่งต่อไปนี้ได้

- หยุดการฝึก อาจโดยตั้งใจหรือเป็นผลจาก ข้อผิดพลาดบางอย่าง

- บันทึกจุดตรวจสอบ

- จากนั้นให้โหลดจุดตรวจสอบซ้ำ ซึ่งอาจทำในฮาร์ดแวร์อื่น

- เริ่มการฝึกอีกครั้ง

ทางเลือกของทางเลือกที่เป็นไปได้ (COPA)

ชุดข้อมูลสำหรับประเมินความสามารถของ LLM ในการระบุคำตอบที่ดีกว่าใน 2 คำตอบ ที่เป็นไปได้สำหรับสมมติฐาน ความท้าทายแต่ละอย่างในชุดข้อมูล ประกอบด้วย 3 องค์ประกอบ ดังนี้

- สมมติฐาน ซึ่งโดยปกติจะเป็นคำกล่าวตามด้วยคำถาม

- คำตอบที่เป็นไปได้ 2 คำตอบสำหรับคำถามที่ระบุไว้ในสมมติฐาน โดยคำตอบหนึ่ง ถูกต้องและอีกคำตอบไม่ถูกต้อง

- คำตอบที่ถูกต้อง

เช่น

- สมมติฐาน: ชายคนนี้ทำนิ้วเท้าหัก สาเหตุของปัญหานี้คืออะไร

- คำตอบที่เป็นไปได้

- ถุงเท้าของเขามีรู

- เขาทำค้อนหล่นใส่เท้า

- คำตอบที่ถูกต้อง: 2

COPA เป็นส่วนประกอบของกลุ่ม SuperGLUE

คลาส

หมวดหมู่ที่ป้ายกำกับสามารถเป็นของได้ เช่น

- ในโมเดลการจัดประเภทแบบไบนารีที่ตรวจหาสแปม คลาสทั้ง 2 อาจเป็นสแปมและไม่ใช่สแปม

- ในโมเดลการจัดประเภทแบบหลายคลาส ที่ระบุสายพันธุ์สุนัข คลาสอาจเป็นพุดเดิล บีเกิล ปั๊ก และอื่นๆ

โมเดลการจัดประเภทจะคาดการณ์คลาส ในทางตรงกันข้าม โมเดลการถดถอยจะคาดการณ์ตัวเลข แทนที่จะเป็นคลาส

ดูข้อมูลเพิ่มเติมได้ที่การจัดประเภท ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

ชุดข้อมูลที่สมดุลของคลาส

ชุดข้อมูลที่มีป้ายกำกับ เชิงหมวดหมู่ ซึ่งมีจำนวนอินสแตนซ์ของแต่ละหมวดหมู่เท่ากันโดยประมาณ ตัวอย่างเช่น พิจารณาชุดข้อมูลพฤกษศาสตร์ที่มีป้ายกำกับไบนารีเป็นพืชพื้นเมืองหรือพืชที่ไม่ใช่พื้นเมือง

- ชุดข้อมูลที่มีพืชพื้นเมือง 515 ชนิดและพืชที่ไม่ใช่พืชพื้นเมือง 485 ชนิดคือชุดข้อมูลที่สมดุลของคลาส

- ชุดข้อมูลที่มีพืชพื้นเมือง 875 ชนิดและพืชที่ไม่ใช่พืชพื้นเมือง 125 ชนิดคือชุดข้อมูลที่มีความไม่สมดุลของคลาส

ไม่มีเส้นแบ่งอย่างเป็นทางการระหว่างชุดข้อมูลที่สมดุลของคลาสกับชุดข้อมูลที่ไม่สมดุลของคลาส ความแตกต่างนี้จะมีความสําคัญก็ต่อเมื่อโมเดลที่ฝึกในชุดข้อมูลที่มีความไม่สมดุลของคลาสสูงไม่สามารถบรรจบกันได้ ดูรายละเอียดได้ที่ ชุดข้อมูล: ชุดข้อมูลที่ไม่สมดุล ในหลักสูตรเร่งรัดแมชชีนเลิร์นนิง

โมเดลการแยกประเภท

โมเดลที่มีการคาดการณ์เป็นคลาส ตัวอย่างเช่น โมเดลต่อไปนี้เป็นโมเดลการแยกประเภททั้งหมด

- โมเดลที่คาดการณ์ภาษาของประโยคอินพุต (ฝรั่งเศส สเปน อิตาลี)

- โมเดลที่คาดการณ์สายพันธุ์ของต้นไม้ (เมเปิล Oak เบาบับ)

- โมเดลที่คาดการณ์คลาสที่เป็นบวกหรือลบสำหรับ ภาวะทางการแพทย์ที่เฉพาะเจาะจง

ในทางตรงกันข้าม โมเดลการเกิดปัญหาซ้ำจะคาดการณ์ตัวเลข แทนที่จะเป็นคลาส

โมเดลการจัดประเภทที่ใช้กันทั่วไปมี 2 ประเภท ได้แก่

เกณฑ์การจัดประเภท

ในการจัดประเภทแบบไบนารี ค่า ระหว่าง 0 ถึง 1 ที่แปลงเอาต์พุตดิบของโมเดลการถดถอยโลจิสติก เป็นการคาดการณ์ของคลาสที่เป็นบวก หรือคลาสที่เป็นลบ โปรดทราบว่าเกณฑ์การแยกประเภทคือค่าที่มนุษย์เลือก ไม่ใช่ค่าที่ได้จากการฝึกโมเดล

โมเดลการถดถอยโลจิสติกจะแสดงผลค่าดิบระหว่าง 0 ถึง 1 จากนั้นให้ทำดังนี้

- หากค่าดิบนี้มากกว่าเกณฑ์การจัดประเภท ระบบจะคาดการณ์ คลาสที่เป็นบวก

- หากค่าดิบนี้น้อยกว่าเกณฑ์การจัดประเภท ระบบจะคาดการณ์คลาสเชิงลบ

ตัวอย่างเช่น สมมติว่าเกณฑ์การแยกประเภทคือ 0.8 หากค่าดิบ เป็น 0.9 โมเดลจะคาดการณ์คลาสเชิงบวก หากค่าดิบเป็น 0.7 โมเดลจะคาดการณ์คลาสเชิงลบ

การเลือกเกณฑ์การแยกประเภทมีผลอย่างมากต่อจำนวนผลบวกลวงและผลลบลวง

ดูข้อมูลเพิ่มเติมได้ที่เกณฑ์และเมทริกซ์ความสับสน ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

ตัวแยกประเภท

คำที่ใช้กันทั่วไปสำหรับโมเดลการจัดประเภท

ชุดข้อมูลที่มีความไม่สมดุลของคลาส

ชุดข้อมูลสำหรับการแยกประเภท ซึ่งมีจำนวนป้ายกำกับทั้งหมดของคลาสแต่ละคลาส แตกต่างกันอย่างมาก ตัวอย่างเช่น พิจารณาชุดข้อมูลการจัดประเภทแบบไบนารีที่มีป้ายกำกับ 2 รายการ ซึ่งแบ่งออกเป็นดังนี้

- ป้ายกำกับค่าลบ 1,000,000 รายการ

- ป้ายกำกับเชิงบวก 10 รายการ

อัตราส่วนของป้ายกำกับเชิงลบต่อป้ายกำกับเชิงบวกคือ 100,000 ต่อ 1 ดังนั้นชุดข้อมูลนี้จึงเป็นชุดข้อมูลที่มีความไม่สมดุลของคลาส

ในทางตรงกันข้าม ชุดข้อมูลต่อไปนี้เป็นคลาสที่สมดุลเนื่องจากอัตราส่วนของป้ายกำกับเชิงลบต่อป้ายกำกับเชิงบวกค่อนข้างใกล้เคียงกับ 1

- ป้ายกำกับเชิงลบ 517 รายการ

- ป้ายกำกับค่าบวก 483 รายการ

ชุดข้อมูลแบบหลายคลาสอาจเป็นแบบคลาสไม่สมดุลได้เช่นกัน ตัวอย่างเช่น ชุดข้อมูลการจัดประเภทแบบหลายคลาสต่อไปนี้ยังเป็นชุดข้อมูลที่มีความไม่สมดุลของคลาสด้วย เนื่องจากป้ายกำกับหนึ่งมีตัวอย่างมากกว่าอีก 2 ป้ายกำกับมาก

- ป้ายกำกับ 1,000,000 รายการที่มีคลาส "สีเขียว"

- ป้ายกำกับ 200 รายการที่มีคลาส "สีม่วง"

- ป้ายกำกับ 350 รายการที่มีคลาส "ส้ม"

การฝึกโมเดลด้วยชุดข้อมูลที่มีความไม่สมดุลของคลาสอาจเป็นเรื่องยาก ดูรายละเอียดได้ที่ ชุดข้อมูลที่ไม่สมดุล ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

ดูเอนโทรปี คลาสส่วนใหญ่ และคลาสส่วนน้อยด้วย

การตัด

เทคนิคในการจัดการค่าผิดปกติโดยทำอย่างใดอย่างหนึ่งหรือทั้ง 2 อย่างต่อไปนี้

- การลดค่าฟีเจอร์ที่มากกว่าเกณฑ์สูงสุด ลงมาที่เกณฑ์สูงสุดนั้น

- การเพิ่มค่าฟีเจอร์ที่ต่ำกว่าเกณฑ์ขั้นต่ำให้เป็นเกณฑ์ขั้นต่ำนั้น

ตัวอย่างเช่น สมมติว่าค่าสำหรับฟีเจอร์หนึ่งๆ น้อยกว่า 0.5% อยู่ นอกช่วง 40–60 ในกรณีนี้ คุณสามารถดำเนินการต่อไปนี้ได้

- ตัดค่าทั้งหมดที่มากกว่า 60 (เกณฑ์สูงสุด) ให้เป็น 60

- คลิปค่าทั้งหมดที่ต่ำกว่า 40 (เกณฑ์ขั้นต่ำ) ให้เป็น 40

ค่าผิดปกติอาจทำให้โมเดลเสียหาย และบางครั้งอาจทำให้น้ำหนัก ล้นระหว่างการฝึก ค่าผิดปกติบางค่าอาจทำให้เมตริกต่างๆ เช่น ความแม่นยำ ลดลงอย่างมาก การตัดเสียงเป็นเทคนิคที่ใช้กันทั่วไปเพื่อจำกัด ความเสียหาย

การจำกัดค่าความชันจะบังคับให้ค่าความชันอยู่ในช่วงที่กำหนดระหว่างการฝึก

ดูข้อมูลเพิ่มเติมได้ที่ข้อมูลตัวเลข: การปรับค่า ในหลักสูตรเร่งรัดแมชชีนเลิร์นนิง

Cloud TPU

ตัวเร่งฮาร์ดแวร์เฉพาะทางที่ออกแบบมาเพื่อเพิ่มความเร็วของภาระงานแมชชีนเลิร์นนิงใน Google Cloud

การจัดกลุ่ม

การจัดกลุ่มตัวอย่างที่เกี่ยวข้อง โดยเฉพาะในช่วงการเรียนรู้แบบไม่มีการกำกับดูแล เมื่อจัดกลุ่มตัวอย่างทั้งหมดแล้ว เจ้าหน้าที่สามารถเลือกให้ความหมายแก่แต่ละคลัสเตอร์ได้

อัลกอริทึมการจัดกลุ่มมีอยู่หลายแบบ ตัวอย่างเช่น อัลกอริทึม k-means จะจัดกลุ่มตัวอย่างตามระยะใกล้กับจุดศูนย์กลาง ดังในแผนภาพต่อไปนี้

จากนั้นนักวิจัยจะตรวจสอบคลัสเตอร์และติดป้ายกำกับคลัสเตอร์ 1 เป็น "ต้นไม้แคระ" และคลัสเตอร์ 2 เป็น "ต้นไม้ขนาดเต็ม" ได้ เป็นต้น

อีกตัวอย่างหนึ่งคือพิจารณาอัลกอริทึมการจัดกลุ่มตามระยะห่างของตัวอย่างจากจุดศูนย์กลาง ดังภาพต่อไปนี้

ดูข้อมูลเพิ่มเติมได้ที่หลักสูตรการจัดกลุ่ม

การปรับตัวร่วมกัน

ลักษณะการทำงานที่ไม่พึงประสงค์ซึ่งนิวรอนคาดการณ์รูปแบบใน ข้อมูลการฝึกโดยอาศัยเอาต์พุตของนิวรอนอื่นๆ ที่เฉพาะเจาะจงเกือบทั้งหมด แทนที่จะอาศัยลักษณะการทำงานของเครือข่ายโดยรวม เมื่อรูปแบบที่ทำให้เกิดการปรับร่วมไม่มีอยู่ในข้อมูลการตรวจสอบ การปรับร่วมจะทำให้เกิดการปรับมากเกินไป การทำให้เป็นปกติแบบ Dropout ช่วยลดการปรับตัวร่วมกัน เนื่องจาก Dropout ทำให้มั่นใจได้ว่านิวรอนจะไม่พึ่งพานิวรอนอื่นๆ ที่เฉพาะเจาะจงเพียงอย่างเดียว

การกรองร่วมกัน

การคาดการณ์ความสนใจของผู้ใช้รายหนึ่ง โดยอิงตามความสนใจของผู้ใช้คนอื่นๆ จำนวนมาก การกรองร่วม มักใช้ในระบบแนะนำ

ดูข้อมูลเพิ่มเติมได้ที่การกรองร่วมในหลักสูตรระบบการแนะนำ

CommitmentBank (CB)

ชุดข้อมูลสําหรับประเมินความเชี่ยวชาญของ LLM ในการพิจารณาว่าผู้เขียนข้อความเชื่อในอนุประโยคเป้าหมายภายในข้อความนั้นหรือไม่ แต่ละรายการในชุดข้อมูลประกอบด้วยข้อมูลต่อไปนี้

- ข้อความ

- อนุประโยคเป้าหมายภายในข้อความนั้น

- ค่าบูลีนที่ระบุว่าผู้เขียนข้อความเชื่อว่ามาตราเป้าหมาย

เช่น

- ข้อความ: ฟังอาร์เทมิสหัวเราะช่างสนุกเสียนี่กระไร เธอเป็นเด็กที่จริงจังมาก ฉันไม่รู้ว่าเธอมีอารมณ์ขัน

- อนุประโยคเป้าหมาย: เธอมีอารมณ์ขัน

- บูลีน: จริง ซึ่งหมายความว่าผู้เขียนเชื่อว่าข้อความเป้าหมาย

CommitmentBank เป็นส่วนประกอบของกลุ่ม SuperGLUE

โมเดลแบบกะทัดรัด

โมเดลขนาดเล็กที่ออกแบบมาเพื่อทำงานในอุปกรณ์ขนาดเล็กที่มีทรัพยากรการคำนวณจำกัด เช่น โมเดลขนาดเล็กสามารถทำงานบนโทรศัพท์มือถือ แท็บเล็ต หรือ ระบบฝังตัวได้

คำนวณ

(คำนาม) ทรัพยากรการคำนวณที่โมเดลหรือระบบใช้ เช่น กำลังประมวลผล หน่วยความจำ และพื้นที่เก็บข้อมูล

การดริฟต์ของแนวคิด

การเปลี่ยนแปลงความสัมพันธ์ระหว่างฟีเจอร์กับค่ายเพลง เมื่อเวลาผ่านไป แนวคิดดริฟต์จะลดคุณภาพของโมเดล

ในระหว่างการฝึก โมเดลจะเรียนรู้ความสัมพันธ์ระหว่างฟีเจอร์กับ ป้ายกำกับในชุดการฝึก หากป้ายกำกับในชุดการฝึกเป็น ตัวแทนที่ดีสำหรับโลกแห่งความเป็นจริง โมเดลควรทำการคาดการณ์ในโลกแห่งความเป็นจริงได้ดี อย่างไรก็ตาม เนื่องจากแนวคิดที่เปลี่ยนแปลงไป การคาดการณ์ของโมเดลจึงมีแนวโน้มที่จะเสื่อมถอยลงเมื่อเวลาผ่านไป

เช่น พิจารณาโมเดลการจัดประเภทแบบไบนารี ที่คาดการณ์ว่ารถยนต์รุ่นหนึ่งๆ "ประหยัดน้ำมัน" หรือไม่ กล่าวคือ ฟีเจอร์อาจเป็นสิ่งต่อไปนี้

- น้ำหนักรถ

- การบีบอัดเครื่องยนต์

- ประเภทเกียร์

ขณะที่ป้ายกำกับมีสถานะอย่างใดอย่างหนึ่งต่อไปนี้

- ประหยัดเชื้อเพลิง

- ไม่ประหยัดเชื้อเพลิง

อย่างไรก็ตาม แนวคิดเรื่อง "รถยนต์ประหยัดน้ำมัน" มีการเปลี่ยนแปลงอยู่เสมอ รถยนต์รุ่นที่ติดป้ายกำกับว่าประหยัดน้ำมันในปี 1994 จะติดป้ายกำกับว่าไม่ประหยัดน้ำมันในปี 2024 อย่างแน่นอน โมเดลที่ได้รับผลกระทบจากแนวคิดที่เปลี่ยนแปลงไป มักจะทำการคาดการณ์ที่มีประโยชน์น้อยลงเรื่อยๆ เมื่อเวลาผ่านไป

เปรียบเทียบกับความไม่คงที่

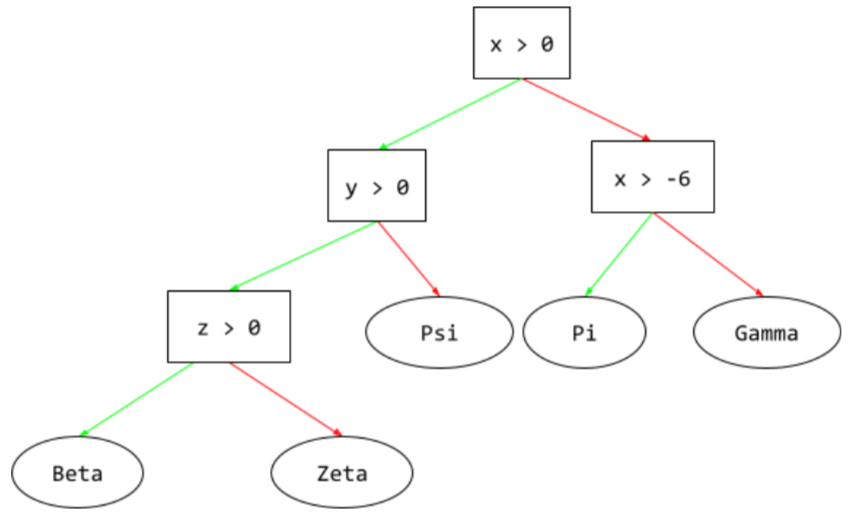

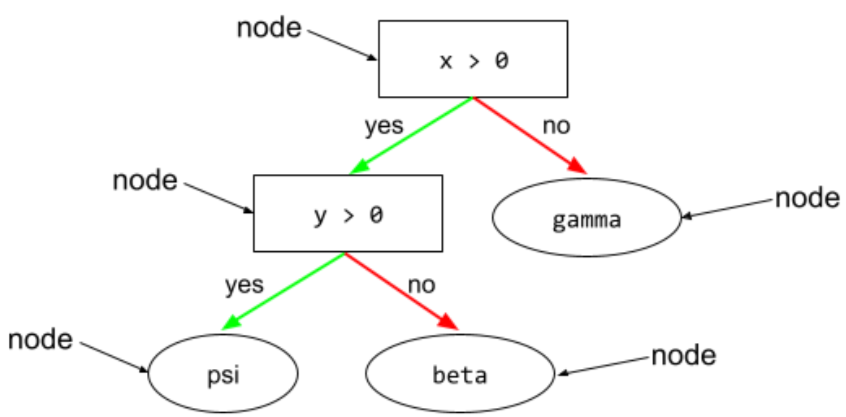

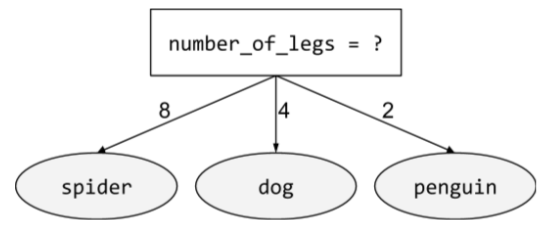

เงื่อนไข

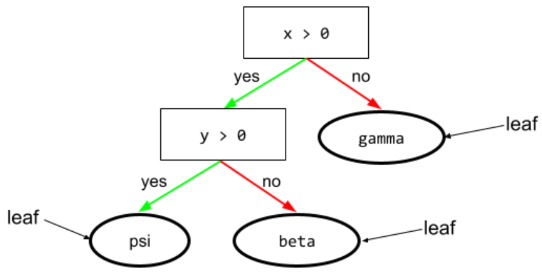

ในแผนผังการตัดสินใจ โหนดใดก็ตามที่ ทำการทดสอบ ตัวอย่างเช่น แผนผังการตัดสินใจต่อไปนี้มี เงื่อนไข 2 ข้อ

เงื่อนไขเรียกอีกอย่างว่าการแยกหรือการทดสอบ

สภาพคอนทราสต์ที่มีใบไม้

และดู:

ดูข้อมูลเพิ่มเติมได้ที่ประเภทของเงื่อนไข ในหลักสูตร Decision Forests

การแต่งเรื่อง

คำพ้องความหมายของอาการหลอน

การแต่งเรื่องอาจเป็นคำที่ถูกต้องในเชิงเทคนิคมากกว่าคำว่าหลอน อย่างไรก็ตาม การหลอนได้รับความนิยมก่อน

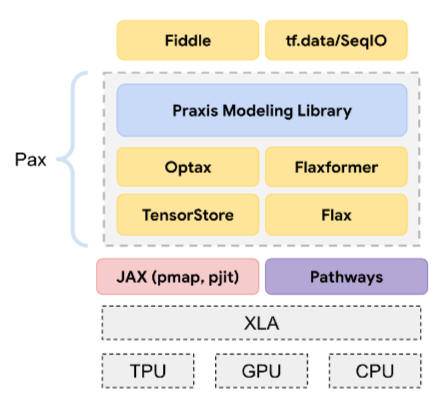

การกำหนดค่า

กระบวนการกำหนดค่าพร็อพเพอร์ตี้เริ่มต้นที่ใช้ฝึกโมเดล ซึ่งรวมถึง

- เลเยอร์การแต่งเพลงของโมเดล

- ตำแหน่งของข้อมูล

- ไฮเปอร์พารามิเตอร์ เช่น

ในโปรเจ็กต์แมชชีนเลิร์นนิง คุณสามารถกำหนดค่าผ่านไฟล์การกำหนดค่าพิเศษ หรือใช้ไลบรารีการกำหนดค่า เช่น รายการต่อไปนี้

อคติยืนยันความคิดตัวเอง

แนวโน้มที่จะค้นหา ตีความ ชื่นชอบ และจดจำข้อมูลในลักษณะที่ยืนยันความเชื่อหรือสมมติฐานที่มีอยู่ก่อนแล้ว นักพัฒนาแมชชีนเลิร์นนิงอาจเก็บรวบรวมหรือติดป้ายกำกับ ข้อมูลโดยไม่ตั้งใจในลักษณะที่ส่งผลต่อผลลัพธ์ที่สนับสนุนความเชื่อที่มีอยู่ อคติยืนยันความคิดตัวเองเป็นรูปแบบหนึ่งของอคติแฝง

อคติของผู้ทดลองเป็นรูปแบบหนึ่งของอคติในการยืนยัน ซึ่งผู้ทดลองจะฝึกโมเดลต่อไปจนกว่าจะมีการยืนยันสมมติฐานที่มีอยู่ก่อนแล้ว

เมตริกความสับสน

ตาราง NxN ที่สรุปจำนวนการคาดการณ์ที่ถูกต้องและไม่ถูกต้อง ที่โมเดลการจัดประเภทสร้างขึ้น ตัวอย่างเช่น ลองดูเมทริกซ์ความสับสนต่อไปนี้สําหรับโมเดลการจัดประเภทแบบไบนารี

| เนื้องอก (คาดการณ์) | ไม่ใช่เนื้องอก (คาดการณ์) | |

|---|---|---|

| เนื้องอก (ข้อมูลจากการสังเกตการณ์โดยตรง) | 18 (TP) | 1 (FN) |

| ไม่ใช่เนื้องอก (ข้อมูลจากการสังเกตการณ์โดยตรง) | 6 (FP) | 452 (TN) |

เมตริกความสับสนก่อนหน้าแสดงข้อมูลต่อไปนี้

- จากการคาดการณ์ 19 รายการที่ข้อมูลที่ระบุว่าถูกต้องโดยเจ้าหน้าที่เป็นเนื้องอก โมเดลจัดประเภทได้อย่างถูกต้อง 18 รายการและจัดประเภทไม่ถูกต้อง 1 รายการ

- จากการคาดการณ์ 458 รายการซึ่งมีข้อมูลที่ระบุว่าถูกต้องโดยเจ้าหน้าที่เป็น "ไม่ใช่เนื้องอก" โมเดล จัดประเภทได้อย่างถูกต้อง 452 รายการและจัดประเภทไม่ถูกต้อง 6 รายการ

เมทริกซ์ความสับสนสำหรับปัญหาการจัดประเภทแบบหลายคลาส ช่วยให้คุณระบุรูปแบบของข้อผิดพลาดได้ ตัวอย่างเช่น ลองพิจารณาเมทริกซ์ความสับสนต่อไปนี้สำหรับโมเดลการจัดประเภทแบบหลายคลาสที่มี 3 คลาส ซึ่งจัดประเภทไอริส 3 ประเภทที่แตกต่างกัน (Virginica, Versicolor และ Setosa) เมื่อข้อมูลที่ระบุว่าถูกต้องโดยเจ้าหน้าที่คือ Virginica เมทริกซ์ความสับสนแสดงให้เห็นว่าโมเดลมีแนวโน้มที่จะคาดการณ์ Versicolor มากกว่า Setosa อย่างมาก

| Setosa (คาดการณ์) | Versicolor (คาดการณ์) | เวอร์จิเนีย (คาดการณ์) | |

|---|---|---|---|

| Setosa (ข้อมูลจากการสังเกตการณ์โดยตรง) | 88 | 12 | 0 |

| Versicolor (ข้อมูลจากการสังเกตการณ์โดยตรง) | 6 | 141 | 7 |

| เวอร์จินิกา (ข้อมูลจากการสังเกตการณ์โดยตรง) | 2 | 27 | 109 |

อีกตัวอย่างหนึ่งคือเมทริกซ์ความสับสนอาจเผยให้เห็นว่าโมเดลที่ฝึกมา เพื่อจดจำตัวเลขที่เขียนด้วยลายมือมักจะทำนายผิดเป็น 9 แทนที่จะเป็น 4 หรือทำนายผิดเป็น 1 แทนที่จะเป็น 7

เมทริกซ์ความสับสนมีข้อมูลเพียงพอที่จะคํานวณเมตริกประสิทธิภาพที่หลากหลาย รวมถึงความแม่นยำ และการเรียกคืน

การแยกวิเคราะห์ส่วนประกอบ

การแบ่งประโยคออกเป็นโครงสร้างทางไวยากรณ์ที่เล็กลง ("ส่วนประกอบ") ส่วนท้ายของระบบ ML เช่น โมเดลความเข้าใจภาษาธรรมชาติ จะแยกวิเคราะห์องค์ประกอบได้ง่ายกว่าประโยคเดิม ตัวอย่างเช่น ลองพิจารณาประโยคต่อไปนี้

เพื่อนของฉันรับเลี้ยงแมว 2 ตัว

ตัวแยกวิเคราะห์แบบ Constituency สามารถแบ่งประโยคนี้ออกเป็นส่วนประกอบ 2 ส่วนต่อไปนี้

- My friend เป็นวลีนาม

- รับเลี้ยงแมว 2 ตัวเป็นวลีที่มีคำกริยา

โดยสามารถแบ่งย่อยองค์ประกอบเหล่านี้ออกเป็นองค์ประกอบที่เล็กลงได้อีก เช่น วลีที่มีคำกริยา

รับเลี้ยงแมว 2 ตัว

สามารถแบ่งย่อยออกเป็น

- ใช้เป็นกริยา

- แมว 2 ตัวเป็นวลีนามอีกวลีหนึ่ง

การฝังภาษาตามบริบท

การฝังที่ใกล้เคียงกับ "การทำความเข้าใจ" คำ และวลีในแบบที่ผู้พูดที่เป็นมนุษย์ซึ่งพูดภาษาได้อย่างคล่องแคล่วทำได้ การฝังภาษาตามบริบท สามารถเข้าใจไวยากรณ์ ความหมาย และบริบทที่ซับซ้อน

ตัวอย่างเช่น ลองพิจารณาการฝังคำภาษาอังกฤษว่า cow การฝังรุ่นเก่า เช่น word2vec สามารถแสดงคำภาษาอังกฤษ ในลักษณะที่ระยะทางในพื้นที่การฝัง จาก cow ถึง bull จะคล้ายกับระยะทางจาก ewe (แกะตัวเมีย) ถึง ram (แกะตัวผู้) หรือจาก female ถึง male การฝังภาษาตามบริบทสามารถก้าวไปอีกขั้นด้วยการรับรู้ว่าบางครั้งผู้พูดภาษาอังกฤษใช้คำว่าcow ในความหมายของทั้งวัวตัวเมียและวัวตัวผู้

หน้าต่างบริบท

จำนวนโทเค็นที่โมเดลประมวลผลได้ในพรอมต์ที่กำหนด ยิ่งหน้าต่างบริบทมีขนาดใหญ่เท่าใด โมเดลก็จะใช้ข้อมูลได้มากขึ้นเท่านั้น เพื่อสร้างคำตอบที่สอดคล้องและสมเหตุสมผล กับพรอมต์

ฟีเจอร์ต่อเนื่อง

ฟีเจอร์ทศนิยมที่มีค่าที่เป็นไปได้ไม่สิ้นสุด เช่น อุณหภูมิหรือน้ำหนัก

เปรียบเทียบกับฟีเจอร์ที่ไม่ต่อเนื่อง

การสุ่มตัวอย่างแบบตามสะดวก

การใช้ชุดข้อมูลที่ไม่ได้รวบรวมอย่างเป็นวิทยาศาสตร์เพื่อทำการทดสอบอย่างรวดเร็ว ในภายหลัง คุณจะต้องเปลี่ยนไปใช้ชุดข้อมูลที่รวบรวมมาอย่างเป็นวิทยาศาสตร์

การบรรจบกัน

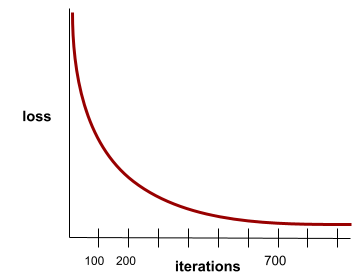

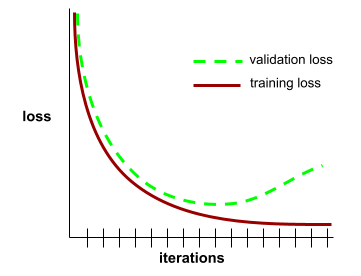

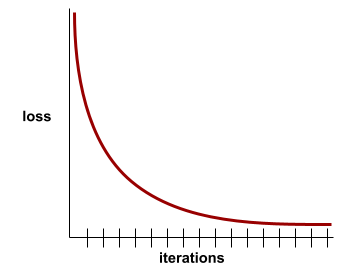

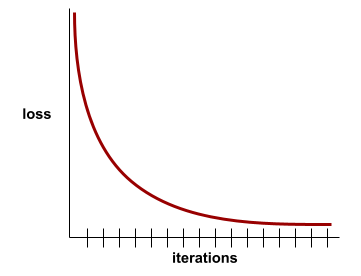

สถานะที่เกิดขึ้นเมื่อค่าการสูญเสียเปลี่ยนแปลงเล็กน้อยมากหรือ ไม่เปลี่ยนแปลงเลยในแต่ละการทำซ้ำ ตัวอย่างเช่น เส้นโค้งการสูญเสียต่อไปนี้แสดงให้เห็นว่าการบรรจบกันเกิดขึ้นที่การวนซ้ำประมาณ 700 ครั้ง

โมเดลจะบรรจบเมื่อการฝึกเพิ่มเติมไม่ ปรับปรุงโมเดล

ในดีปเลิร์นนิง บางครั้งค่าการสูญเสียจะคงที่หรือ เกือบคงที่สำหรับการวนซ้ำหลายครั้งก่อนที่จะลดลงในที่สุด ในช่วงระยะเวลานาน ที่ค่าการสูญเสียคงที่ คุณอาจรู้สึกว่ามีการบรรจบกันอย่างไม่ถูกต้องชั่วคราว

ดูการหยุดก่อนกำหนดด้วย

ดูข้อมูลเพิ่มเติมได้ที่เส้นโค้งการบรรจบกันของโมเดลและการสูญเสีย ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

การเขียนโค้ดแบบสนทนา

กล่องโต้ตอบแบบวนซ้ำระหว่างคุณกับโมเดล Generative AI เพื่อวัตถุประสงค์ ในการสร้างซอฟต์แวร์ คุณป้อนพรอมต์ที่อธิบายซอฟต์แวร์บางอย่าง จากนั้น โมเดลจะใช้คำอธิบายดังกล่าวเพื่อสร้างโค้ด จากนั้นคุณจะออกพรอมต์ใหม่ เพื่อแก้ไขข้อบกพร่องในพรอมต์ก่อนหน้าหรือในโค้ดที่สร้างขึ้น และโมเดลจะสร้างโค้ดที่อัปเดตแล้ว คุณทั้ง 2 คนจะสลับกันไปมาจนกว่าซอฟต์แวร์ที่สร้างขึ้นจะดีพอ

การเขียนโค้ดการสนทนาเป็นความหมายดั้งเดิมของการเขียนโค้ดไวบ์

เปรียบเทียบกับการเขียนโค้ดตามข้อกำหนด

ฟังก์ชันนูน

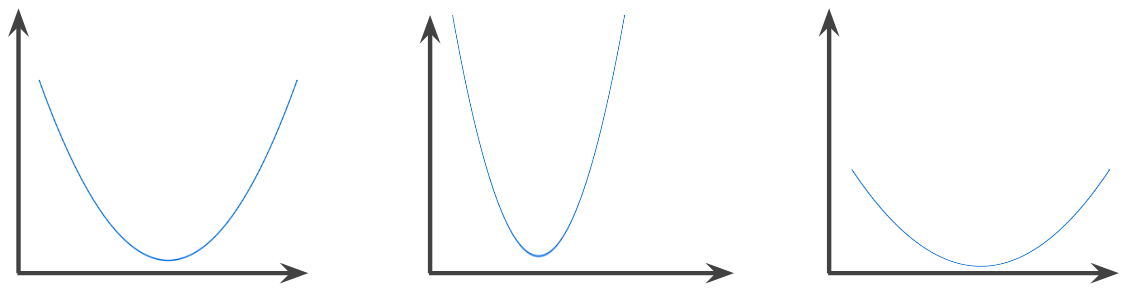

ฟังก์ชันที่ภูมิภาคเหนือกราฟของฟังก์ชันเป็นเซตแบบนูน ฟังก์ชันนูนต้นแบบมีลักษณะคล้ายตัวอักษร U ตัวอย่างเช่น ฟังก์ชันต่อไปนี้ เป็นฟังก์ชันนูนทั้งหมด

ในทางตรงกันข้าม ฟังก์ชันต่อไปนี้ไม่ใช่ฟังก์ชันนูน โปรดสังเกตว่า พื้นที่เหนือกราฟไม่ใช่เซตแบบนูน

ฟังก์ชันนูนอย่างแท้จริงมีจุดต่ำสุดเฉพาะที่เพียงจุดเดียว ซึ่งเป็นจุดต่ำสุดส่วนกลางด้วย ฟังก์ชันรูปตัว U แบบคลาสสิกคือฟังก์ชันนูนอย่างแท้จริง อย่างไรก็ตาม ฟังก์ชันนูนบางอย่าง (เช่น เส้นตรง) ไม่ได้มีรูปร่างเป็นตัว U

ดูข้อมูลเพิ่มเติมได้ที่ฟังก์ชันการบรรจบกันและฟังก์ชันนูนในหลักสูตรเร่งรัดแมชชีนเลิร์นนิง

การเพิ่มประสิทธิภาพแบบนูน

กระบวนการใช้เทคนิคทางคณิตศาสตร์ เช่น การไล่ระดับการไล่ระดับเพื่อค้นหาค่าต่ำสุดของฟังก์ชันนูน การวิจัยด้านแมชชีนเลิร์นนิงจำนวนมากมุ่งเน้นไปที่การกำหนดปัญหาต่างๆ เป็นปัญหาการเพิ่มประสิทธิภาพแบบนูน และการแก้ปัญหาเหล่านั้นอย่างมีประสิทธิภาพมากขึ้น

ดูรายละเอียดทั้งหมดได้ที่ Boyd และ Vandenberghe การเพิ่มประสิทธิภาพ แบบนูน

เซตนูน

เซตย่อยของปริภูมิแบบยุคลิดซึ่งเส้นที่ลากระหว่างจุด 2 จุดใดๆ ในเซตย่อย จะยังคงอยู่ภายในเซตย่อยนั้นอย่างสมบูรณ์ ตัวอย่างเช่น รูปร่าง 2 รูปต่อไปนี้ เป็นเซตแบบนูน

ในทางตรงกันข้าม รูปร่าง 2 แบบต่อไปนี้ไม่ใช่เซตคอนเวกซ์

การสังวัตนาการ

ในทางคณิตศาสตร์ ฟังก์ชันผสมคือการรวมฟังก์ชัน 2 ฟังก์ชันเข้าด้วยกัน ในแมชชีนเลิร์นนิง คอนโวลูชันจะผสมฟิลเตอร์คอนโวลูชันและเมทริกซ์อินพุต เพื่อฝึกน้ำหนัก

คำว่า "การสังวัตนาการ" ในแมชชีนเลิร์นนิงมักเป็นวิธีเรียกแบบย่อ เพื่ออ้างอิงถึงการดำเนินการสังวัตนาการ หรือเลเยอร์สังวัตนาการ

หากไม่มี Convolution อัลกอริทึมแมชชีนเลิร์นนิงจะต้องเรียนรู้ น้ำหนักแยกต่างหากสำหรับทุกเซลล์ในเทนเซอร์ขนาดใหญ่ ตัวอย่างเช่น อัลกอริทึมแมชชีนเลิร์นนิงที่ฝึกกับรูปภาพขนาด 2K x 2K จะต้อง ค้นหาน้ำหนักแยกกัน 4 ล้านรายการ อัลกอริทึมแมชชีนเลิร์นนิง ต้องค้นหาน้ำหนักสำหรับแต่ละเซลล์ในฟิลเตอร์ Convolutional เท่านั้น ซึ่งช่วยลด หน่วยความจำที่จำเป็นในการฝึกโมเดลได้อย่างมาก เมื่อใช้ฟิลเตอร์แบบ Convolutional ระบบจะทำซ้ำฟิลเตอร์ในเซลล์ต่างๆ เพื่อให้แต่ละเซลล์คูณด้วยฟิลเตอร์

ฟิลเตอร์ Convolutional

หนึ่งใน 2 องค์ประกอบในการดำเนินการแบบ Convolution (ตัวดำเนินการอีกตัว คือส่วนของเมทริกซ์อินพุต) ฟิลเตอร์ Convolutional คือเมทริกซ์ที่มีอันดับเดียวกันกับเมทริกซ์อินพุต แต่มีรูปร่างเล็กกว่า เช่น เมื่อกำหนดเมทริกซ์อินพุต 28x28 ตัวกรองอาจเป็นเมทริกซ์ 2 มิติใดก็ได้ ที่มีขนาดเล็กกว่า 28x28

ในการดัดแปลงภาพถ่าย โดยทั่วไปแล้วเซลล์ทั้งหมดในฟิลเตอร์ Convolutional จะ ตั้งค่าเป็นรูปแบบคงที่ของ 1 และ 0 ในแมชชีนเลิร์นนิง โดยทั่วไปแล้วฟิลเตอร์ Convolutional จะเริ่มต้นด้วยตัวเลขสุ่ม จากนั้น เครือข่ายจะฝึกค่าที่เหมาะสม

เลเยอร์ Convolutional

เลเยอร์ของโครงข่ายประสาทแบบลึกซึ่งฟิลเตอร์ Convolutional จะส่งต่อเมทริกซ์อินพุต ตัวอย่างเช่น ลองพิจารณาฟิลเตอร์ Convolutional ขนาด 3x3 ต่อไปนี้

![เมทริกซ์ 3x3 ที่มีค่าต่อไปนี้ [[0,1,0], [1,0,1], [0,1,0]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalFilter33.svg?authuser=4&hl=th)

ภาพเคลื่อนไหวต่อไปนี้แสดงเลเยอร์ Convolutional ซึ่งประกอบด้วยการดำเนินการ Convolutional 9 รายการที่เกี่ยวข้องกับเมทริกซ์อินพุตขนาด 5x5 โปรดสังเกตว่าการดำเนินการแบบ Convolution แต่ละครั้งจะทำงานกับส่วน 3x3 ที่แตกต่างกันของเมทริกซ์อินพุต เมทริกซ์ 3x3 ที่ได้ (ทางด้านขวา) ประกอบด้วยผลลัพธ์ของการดำเนินการ Convolutional 9 รายการ ดังนี้

![ภาพเคลื่อนไหวแสดงเมทริกซ์ 2 รายการ เมทริกซ์แรกคือเมทริกซ์ 5x5

[[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]]

เมทริกซ์ที่ 2 คือเมทริกซ์ 3x3 ดังนี้

[[181,303,618], [115,338,605], [169,351,560]]

เมทริกซ์ที่ 2 คํานวณโดยใช้ตัวกรองแบบ Convolutional

[[0, 1, 0], [1, 0, 1], [0, 1, 0]] กับ

เซตย่อย 3x3 ที่แตกต่างกันของเมทริกซ์ 5x5](https://developers.google.cn/static/machine-learning/glossary/images/AnimatedConvolution.gif?authuser=4&hl=th)

โครงข่ายประสาทแบบคอนโวลูชัน

โครงข่ายประสาทเทียมที่มีเลเยอร์อย่างน้อย 1 เลเยอร์เป็นเลเยอร์ Convolutional โดยทั่วไปแล้ว โครงข่ายประสาทเทียมแบบ Convolutional จะประกอบด้วยเลเยอร์ต่อไปนี้

โครงข่ายประสาทเทียมแบบคอนโวลูชันประสบความสำเร็จอย่างมากในปัญหาบางประเภท เช่น การจดจำรูปภาพ

การดำเนินการแบบ Convolution

การดำเนินการทางคณิตศาสตร์ 2 ขั้นตอนต่อไปนี้

- การคูณแบบทีละองค์ประกอบของฟิลเตอร์ Convolutional และชิ้นส่วนของเมทริกซ์อินพุต (ชิ้นส่วนของเมทริกซ์อินพุตมีอันดับและขนาดเท่ากับฟิลเตอร์ Convolutional)

- ผลรวมของค่าทั้งหมดในเมทริกซ์ผลิตภัณฑ์ที่ได้

ตัวอย่างเช่น ลองพิจารณาเมทริกซ์อินพุต 5x5 ต่อไปนี้

![เมทริกซ์ 5x5: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerInputMatrix.svg?authuser=4&hl=th)

ตอนนี้ลองนึกถึงฟิลเตอร์การแปลงแบบ Convolution ขนาด 2x2 ต่อไปนี้

![เมทริกซ์ 2x2: [[1, 0], [0, 1]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerFilter.svg?authuser=4&hl=th)

การดำเนินการแบบ Convolution แต่ละครั้งจะเกี่ยวข้องกับสไลซ์ขนาด 2x2 เดียวของเมทริกซ์อินพุต เช่น สมมติว่าเราใช้ชิ้นส่วนขนาด 2x2 ที่ ด้านซ้ายบนของเมทริกซ์อินพุต ดังนั้น การดำเนินการ Convolution ใน Slice นี้จึงมีลักษณะดังนี้

![ใช้ฟิลเตอร์ Convolutional [[1, 0], [0, 1]] กับส่วน 2x2 ด้านซ้ายบนของเมทริกซ์อินพุต ซึ่งคือ [[128,97], [35,22]]

ฟิลเตอร์ Convolutional จะคงค่า 128 และ 22 ไว้ แต่จะตั้งค่า 97 และ 35 เป็น 0 ดังนั้น การดำเนินการ Convolution จึงให้ค่า 150 (128+22)](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerOperation.svg?authuser=4&hl=th)

เลเยอร์ Convolutional ประกอบด้วย ชุดการดำเนินการ Convolutional ซึ่งแต่ละรายการจะทำงานกับส่วนที่แตกต่างกัน ของเมทริกซ์อินพุต

COPA

ตัวย่อของ Choice of Plausible Alternatives

ต้นทุน

คำพ้องความหมายของการสูญเสีย

การฝึกร่วม

แนวทางการเรียนรู้แบบกึ่งกำกับดูแล มีประโยชน์อย่างยิ่งเมื่อเงื่อนไขต่อไปนี้ทั้งหมดเป็นจริง

- อัตราส่วนของตัวอย่างที่ไม่มีป้ายกำกับต่อ ตัวอย่างที่มีป้ายกำกับในชุดข้อมูลสูง

- นี่คือปัญหาการจัดประเภท (ไบนารีหรือ หลายคลาส)

- ชุดข้อมูลมีฟีเจอร์เชิงคาดการณ์ 2 ชุดที่แตกต่างกัน ซึ่งเป็นอิสระต่อกันและเสริมซึ่งกันและกัน

การฝึกร่วมกันจะขยายสัญญาณอิสระให้เป็นสัญญาณที่แรงขึ้น ตัวอย่างเช่น พิจารณาโมเดลการแยกประเภทที่ จัดหมวดหมู่รถมือสองแต่ละคันเป็นดีหรือไม่ดี ฟีเจอร์การคาดการณ์ชุดหนึ่งอาจมุ่งเน้นลักษณะโดยรวม เช่น ปี ยี่ห้อ และรุ่นของรถยนต์ ส่วนฟีเจอร์การคาดการณ์อีกชุดหนึ่งอาจมุ่งเน้นบันทึกการขับขี่ของเจ้าของคนก่อนและประวัติการบำรุงรักษารถยนต์

เอกสารสำคัญเกี่ยวกับการฝึกร่วมคือ Combining Labeled and Unlabeled Data with Co-Training โดย Blum และ Mitchell

ความเป็นธรรมแบบข้อเท็จจริง

เมตริกความเป็นธรรมที่ตรวจสอบว่าโมเดลการจัดประเภทให้ผลลัพธ์เดียวกันสำหรับบุคคลหนึ่งกับอีกบุคคลหนึ่งที่เหมือนกับบุคคลแรกหรือไม่ ยกเว้นในส่วนของแอตทริบิวต์ที่ละเอียดอ่อนอย่างน้อย 1 รายการ การประเมินโมเดลการจัดประเภทเพื่อความเป็นธรรมแบบข้อเท็จจริง เป็นวิธีหนึ่งในการระบุแหล่งที่มาของความเอนเอียงที่อาจเกิดขึ้นในโมเดล

โปรดดูข้อมูลเพิ่มเติมในแหล่งข้อมูลต่อไปนี้

- ความเป็นธรรม: ความเป็นธรรมแบบข้อเท็จจริงที่ขัดแย้ง ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

- เมื่อโลกมาบรรจบกัน: การผสานรวมสมมติฐานแบบ Counterfactual ที่แตกต่างกัน ในความเท่าเทียม

อคติในการครอบคลุม

การขยายตัวของข่าว

ประโยคหรือวลีที่มีความหมายกำกวม การทำความเข้าใจภาษาธรรมชาติมีปัญหาสำคัญที่เรียกว่า "การแตกกิ่ง" ตัวอย่างเช่น พาดหัวข่าว Red Tape Holds Up Skyscraper เป็น การใช้คำที่ทำให้เกิดความสับสนเนื่องจากโมเดล NLU อาจตีความพาดหัวข่าวตามตัวอักษรหรือ ในเชิงเปรียบเทียบ

นักวิจารณ์

คำพ้องความหมายของ Deep Q-Network

ครอสเอนโทรปี

การสรุปการสูญเสียบันทึกเป็น ปัญหาการจัดประเภทแบบหลายคลาส Cross-entropy จะวัดความแตกต่างระหว่างการแจกแจงความน่าจะเป็น 2 แบบ ดูเพิ่มเติม perplexity

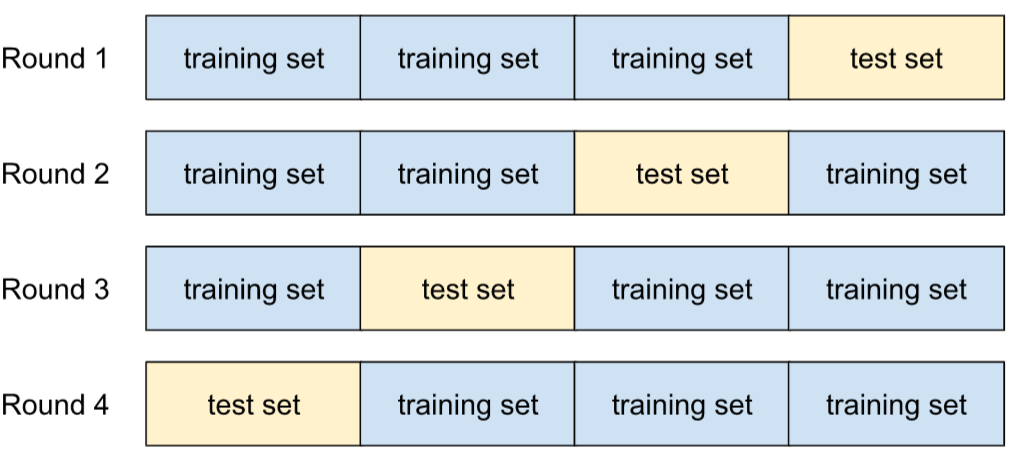

การตรวจสอบแบบไขว้

กลไกในการประมาณว่าโมเดลจะทำงานได้ดีเพียงใดกับข้อมูลใหม่โดยการทดสอบโมเดลกับชุดข้อมูลย่อยที่ไม่ทับซ้อนกันอย่างน้อย 1 ชุด ซึ่งได้มาจากชุดการฝึก

ฟังก์ชันการกระจายสะสม (CDF)

ฟังก์ชันที่กำหนดความถี่ของตัวอย่างที่น้อยกว่าหรือเท่ากับค่าเป้าหมาย ตัวอย่างเช่น พิจารณาการแจกแจงปกติของค่าต่อเนื่อง CDF บอกคุณว่าตัวอย่างประมาณ 50% ควรน้อยกว่าหรือเท่ากับค่าเฉลี่ย และตัวอย่างประมาณ 84% ควรน้อยกว่าหรือเท่ากับค่าเบี่ยงเบนมาตรฐาน 1 ค่าเหนือค่าเฉลี่ย

D

การวิเคราะห์ข้อมูล

ทำความเข้าใจข้อมูลโดยพิจารณาตัวอย่าง การวัด และการแสดงข้อมูลเป็นภาพ การวิเคราะห์ข้อมูลมีประโยชน์อย่างยิ่งเมื่อได้รับชุดข้อมูลเป็นครั้งแรก ก่อนที่จะสร้างโมเดลแรก นอกจากนี้ยังมีความสำคัญอย่างยิ่งในการทำความเข้าใจการทดสอบและการแก้ไขข้อบกพร่องของระบบ

การเพิ่มข้อมูล

การเพิ่มช่วงและจำนวนตัวอย่างการฝึกโดยการแปลงตัวอย่างที่มีอยู่เพื่อสร้างตัวอย่างเพิ่มเติม ตัวอย่างเช่น สมมติว่ารูปภาพเป็นหนึ่งในฟีเจอร์ของคุณ แต่ชุดข้อมูลไม่มีตัวอย่างรูปภาพเพียงพอให้โมเดลเรียนรู้ความสัมพันธ์ที่เป็นประโยชน์ คุณควรเพิ่มรูปภาพที่ติดป้ายกำกับให้เพียงพอลงในชุดข้อมูลเพื่อช่วยให้โมเดลฝึกได้อย่างถูกต้อง หากทำไม่ได้ การเพิ่มข้อมูล จะหมุน ยืด และพลิกแต่ละรูปภาพเพื่อสร้างรูปภาพต้นฉบับ ในรูปแบบต่างๆ ซึ่งอาจให้ข้อมูลที่ติดป้ายกำกับเพียงพอที่จะช่วยให้การฝึกโมเดลมีประสิทธิภาพยอดเยี่ยม

DataFrame

ประเภทข้อมูล pandas ยอดนิยมสำหรับแสดงชุดข้อมูลในหน่วยความจำ

DataFrame มีลักษณะคล้ายกับตารางหรือสเปรดชีต แต่ละคอลัมน์ของ DataFrame มีชื่อ (ส่วนหัว) และแต่ละแถวจะระบุด้วยหมายเลขที่ไม่ซ้ำกัน

แต่ละคอลัมน์ใน DataFrame มีโครงสร้างเหมือนอาร์เรย์ 2 มิติ ยกเว้นว่า แต่ละคอลัมน์สามารถกำหนดประเภทข้อมูลของตัวเองได้

นอกจากนี้ โปรดดูหน้าข้อมูลอ้างอิง pandas.DataFrame อย่างเป็นทางการด้วย

การประมวลผลแบบขนาน

วิธีปรับขนาดการฝึกหรือการอนุมาน ที่จำลองโมเดลทั้งหมดไปยัง อุปกรณ์หลายเครื่อง แล้วส่งชุดข้อมูลย่อยของข้อมูลอินพุตไปยังแต่ละอุปกรณ์ การขนานข้อมูลช่วยให้ฝึกและอนุมานได้ในขนาดกลุ่มที่ใหญ่มาก แต่การขนานข้อมูลกำหนดให้โมเดลต้องมีขนาดเล็กพอที่จะพอดีกับอุปกรณ์ทั้งหมด

โดยปกติแล้วการประมวลผลแบบคู่ขนานของข้อมูลจะช่วยเร่งการฝึกและการอนุมาน

ดูการทำงานแบบขนานของโมเดลด้วย

Dataset API (tf.data)

API TensorFlow ระดับสูงสําหรับการอ่านข้อมูลและ

แปลงข้อมูลให้อยู่ในรูปแบบที่อัลกอริทึมแมชชีนเลิร์นนิงต้องการ

ออบเจ็กต์ tf.data.Dataset แสดงลำดับขององค์ประกอบ ซึ่งแต่ละองค์ประกอบมี Tensor อย่างน้อย 1 รายการ ออบเจ็กต์ tf.data.Iterator

ให้สิทธิ์เข้าถึงองค์ประกอบของ Dataset

ชุดข้อมูล

ชุดข้อมูลดิบที่มักจะ (แต่ไม่เสมอไป) จัดระเบียบในรูปแบบใดรูปแบบหนึ่งต่อไปนี้

- สเปรดชีต

- ไฟล์ในรูปแบบ CSV (ค่าที่คั่นด้วยคอมมา)

ขอบเขตการตัดสินใจ

ตัวคั่นระหว่างคลาสที่โมเดลเรียนรู้ในคลาสแบบไบนารีหรือปัญหาการจัดประเภทแบบหลายคลาส ตัวอย่างเช่น ในรูปภาพต่อไปนี้ซึ่งแสดงถึงปัญหาการแยกประเภทแบบไบนารี ขอบเขตการตัดสินใจคือขอบเขตระหว่างคลาสสีส้มกับ คลาสสีน้ำเงิน

Decision Forest

โมเดลที่สร้างจากต้นไม้ตัดสินใจหลายต้น Decision Forest จะทำการคาดการณ์โดยการรวบรวมการคาดการณ์ของ Decision Tree ประเภทของป่าการตัดสินใจที่ได้รับความนิยม ได้แก่ ป่าสุ่มและต้นไม้ที่ได้รับการเพิ่มประสิทธิภาพแบบไล่ระดับ

ดูข้อมูลเพิ่มเติมได้ที่ส่วนDecision Forests ในหลักสูตร Decision Forests

เกณฑ์การตัดสินใจ

คำพ้องความหมายของเกณฑ์การจัดประเภท

แผนผังการตัดสินใจ

โมเดลการเรียนรู้ภายใต้การควบคุมดูแลซึ่งประกอบด้วยชุดเงื่อนไขและลีฟที่จัดระเบียบตามลำดับชั้น ตัวอย่างเช่น แผนผังการตัดสินใจมีลักษณะดังนี้

เครื่องมือถอดรหัส

โดยทั่วไปแล้ว ระบบ ML ใดๆ ที่แปลงจากรูปแบบที่ประมวลผลแล้ว หนาแน่น หรือภายในเป็นรูปแบบที่ดิบกว่า กระจัดกระจาย หรือภายนอก

ดีโคดเดอร์มักเป็นส่วนประกอบของโมเดลขนาดใหญ่ ซึ่งมักจะ จับคู่กับเอนโคดเดอร์

ในงานแบบลำดับต่อลำดับ ดีโคดเดอร์ จะเริ่มต้นด้วยสถานะภายในที่เอนโคดเดอร์สร้างขึ้นเพื่อคาดการณ์ลำดับ ถัดไป

ดูคำจำกัดความของตัวถอดรหัสภายในสถาปัตยกรรม Transformer ได้ที่Transformer

ดูข้อมูลเพิ่มเติมได้ที่โมเดลภาษาขนาดใหญ่ ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

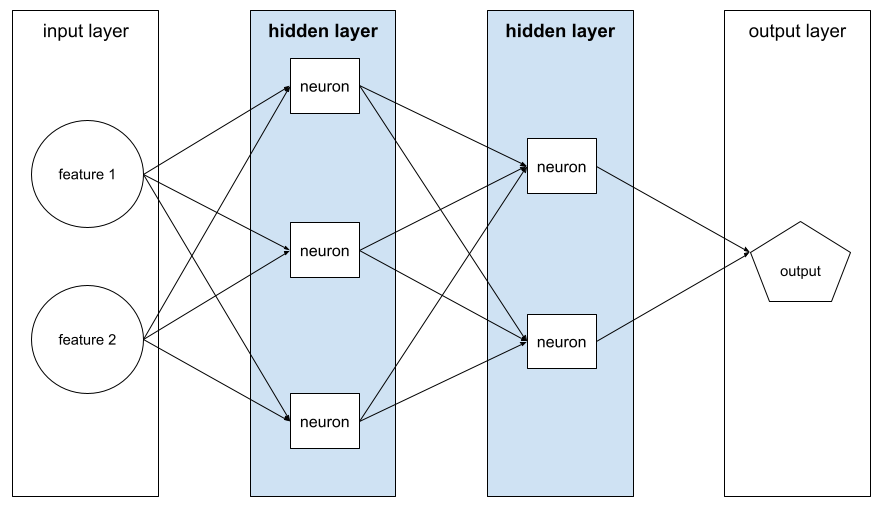

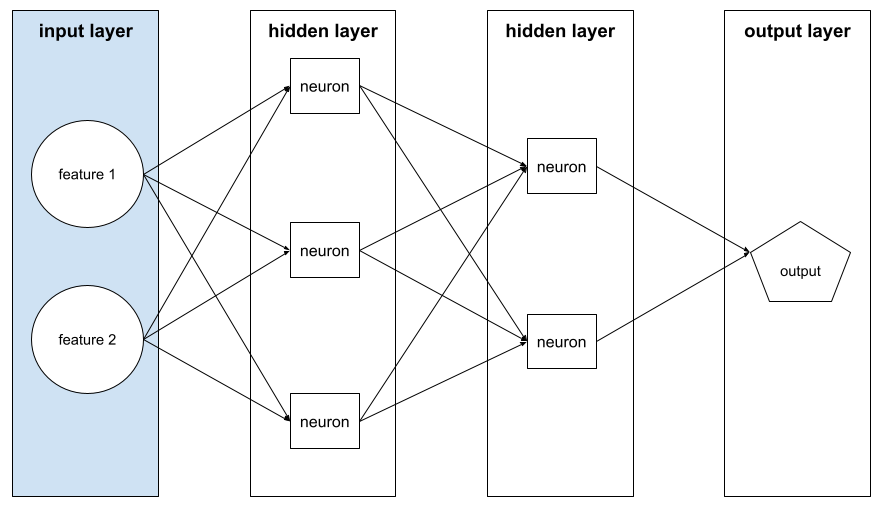

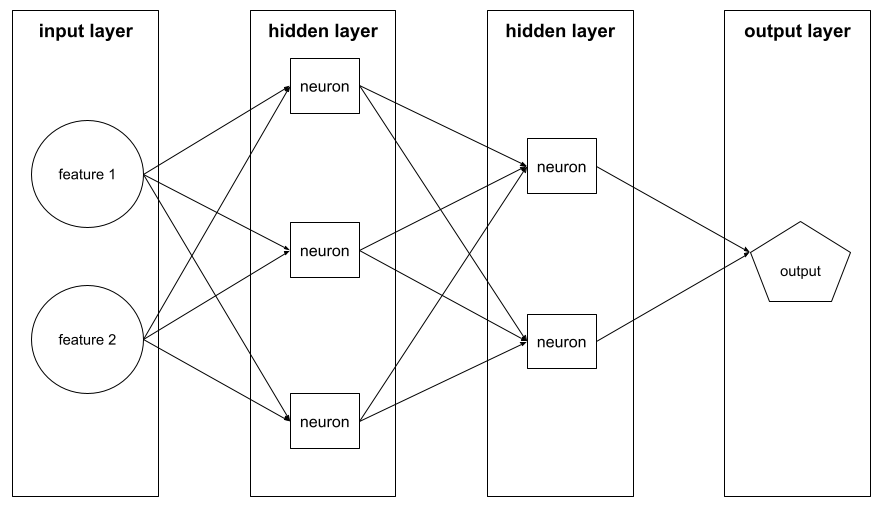

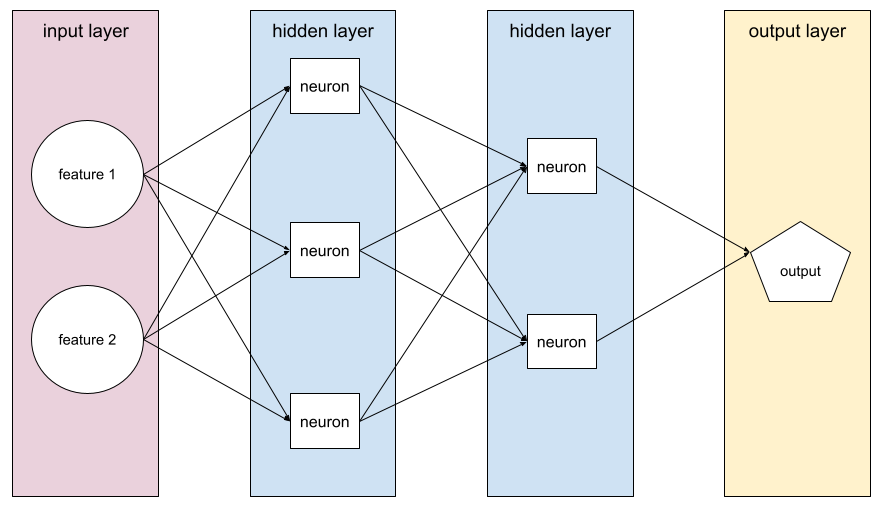

โมเดลเชิงลึก

โครงข่ายประสาทเทียมที่มีเลเยอร์ที่ซ่อนอยู่มากกว่า 1 เลเยอร์

โมเดลแบบลึกเรียกอีกอย่างว่าโครงข่ายประสาทแบบลึก

เปรียบเทียบกับโมเดลแบบกว้าง

โครงข่ายประสาทแบบลึก

คำพ้องความหมายของโมเดลเชิงลึก

เครือข่าย Deep Q (DQN)

ในการเรียนรู้แบบ Q โครงข่ายประสาทแบบลึก ที่คาดการณ์ฟังก์ชัน Q

Critic เป็นคำพ้องความหมายของ Deep Q-Network

ความเท่าเทียมทางประชากร

เมตริกความเป็นธรรมที่ตรงตามเงื่อนไขต่อไปนี้ ผลลัพธ์ของการจัดประเภทของโมเดลไม่ขึ้นอยู่กับแอตทริบิวต์ที่ละเอียดอ่อนที่กำหนด

ตัวอย่างเช่น หากทั้งชาวลิลิพุตและชาวโบรบดิงแนกสมัครเข้าเรียนที่มหาวิทยาลัยกลับบ์ดับดริบ ความเท่าเทียมกันทางประชากรจะเกิดขึ้นหากเปอร์เซ็นต์ของชาวลิลิพุตที่ได้รับการตอบรับเท่ากับเปอร์เซ็นต์ของชาวโบรบดิงแนกที่ได้รับการตอบรับ ไม่ว่ากลุ่มใดกลุ่มหนึ่งจะมีคุณสมบัติมากกว่าอีกกลุ่มหนึ่งโดยเฉลี่ยหรือไม่ก็ตาม

แตกต่างจากอัตราต่อรองที่เท่ากันและความเท่าเทียมกันของโอกาส ซึ่งอนุญาตให้ผลการจัดประเภทโดยรวมขึ้นอยู่กับแอตทริบิวต์ที่ละเอียดอ่อน แต่ไม่อนุญาตให้ผลการจัดประเภทสำหรับป้ายกำกับความจริงพื้นฐานที่ระบุบางอย่างขึ้นอยู่กับแอตทริบิวต์ที่ละเอียดอ่อน ดู "การต่อต้านการเลือกปฏิบัติด้วยแมชชีนเลิร์นนิงที่ชาญฉลาดยิ่งขึ้น" เพื่อดูภาพ ที่อธิบายถึงการแลกเปลี่ยนเมื่อเพิ่มประสิทธิภาพเพื่อความเท่าเทียมกันทางประชากร

ดูข้อมูลเพิ่มเติมได้ที่ความเป็นธรรม: ความเท่าเทียมกันทางประชากร ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

การลดสัญญาณรบกวน

แนวทางทั่วไปสำหรับการเรียนรู้แบบกำกับดูแลตนเอง ซึ่งมีลักษณะดังนี้

- สัญญาณรบกวนจะได้รับการเพิ่มลงในชุดข้อมูลโดยอัตโนมัติ

- โมเดลจะพยายามตัดเสียงรบกวน

การลดสัญญาณรบกวนช่วยให้เรียนรู้จากตัวอย่างที่ไม่มีป้ายกำกับได้ ชุดข้อมูลเดิมทำหน้าที่เป็นเป้าหมายหรือป้ายกำกับ และข้อมูลที่มีสัญญาณรบกวนทำหน้าที่เป็นอินพุต

โมเดลภาษาที่มาสก์บางรายการใช้การลดสัญญาณรบกวน ดังนี้

- ระบบจะเพิ่มสัญญาณรบกวนลงในประโยคที่ไม่มีป้ายกำกับโดยการมาสก์โทเค็นบางส่วน

- โมเดลจะพยายามคาดการณ์โทเค็นต้นฉบับ

ฟีเจอร์หนาแน่น

ฟีเจอร์ที่ค่าส่วนใหญ่หรือทั้งหมดไม่ใช่ศูนย์ โดยปกติจะเป็นเทนเซอร์ของค่าทศนิยม ตัวอย่างเช่น เทนเซอร์ 10 องค์ประกอบต่อไปนี้เป็นแบบหนาแน่นเนื่องจากค่า 9 ค่าเป็นค่าที่ไม่ใช่ 0

| 8 | 3 | 7 | 5 | 2 | 4 | 0 | 4 | 9 | 6 |

แตกต่างจากฟีเจอร์แบบกระจัดกระจาย

เลเยอร์หนาแน่น

คำพ้องความหมายของเลเยอร์ที่เชื่อมต่ออย่างเต็มรูปแบบ

ความลึก

ผลรวมของรายการต่อไปนี้ในโครงข่ายประสาทเทียม

- จำนวนเลเยอร์ที่ซ่อนอยู่

- จำนวนเลเยอร์เอาต์พุต ซึ่งโดยปกติคือ 1

- จำนวนเลเยอร์การฝัง

เช่น โครงข่ายประสาทที่มีเลเยอร์ที่ซ่อนอยู่ 5 เลเยอร์และเลเยอร์เอาต์พุต 1 เลเยอร์ มีความลึกเท่ากับ 6

โปรดสังเกตว่าเลเยอร์อินพุตไม่มีผลต่อความลึก

โครงข่ายประสาทแบบคอนโวลูชันที่แยกความลึกได้ (sepCNN)

สถาปัตยกรรมโครงข่ายประสาทเทียมแบบคอนโวลูชัน ที่อิงตาม Inception แต่จะแทนที่โมดูล Inception ด้วยคอนโวลูชันแบบแยกตามความลึก หรือที่เรียกว่า Xception

การ Convolution ที่แยกความลึกได้ (เรียกอีกอย่างว่า Convolution ที่แยกได้) จะแยก Convolution 3 มิติมาตรฐานออกเป็น 2 การดำเนินการ Convolution แยกกัน ซึ่งมีประสิทธิภาพในการคำนวณมากกว่า โดยขั้นแรกคือ Convolution ที่แยกความลึกได้ ที่มีความลึกเป็น 1 (n ✕ n ✕ 1) และขั้นที่ 2 คือ Convolution แบบ Pointwise ที่มีความยาวและความกว้างเป็น 1 (1 ✕ 1 ✕ n)

ดูข้อมูลเพิ่มเติมได้ที่ Xception: Deep Learning with Depthwise Separable Convolutions

ป้ายกำกับที่ได้มา

คำพ้องความหมายของป้ายกำกับพร็อกซี

อุปกรณ์

คำที่มีความหมายหลายอย่างซึ่งมีคำจำกัดความที่เป็นไปได้ 2 อย่างต่อไปนี้

- หมวดหมู่ฮาร์ดแวร์ที่เรียกใช้เซสชัน TensorFlow ได้ ซึ่งรวมถึง CPU, GPU และ TPU

- เมื่อฝึกโมเดล ML ในชิปตัวเร่ง (GPU หรือ TPU) ส่วนของระบบที่จัดการเทนเซอร์และการฝังจริง อุปกรณ์ทำงานบนชิปตัวเร่ง ในทางตรงกันข้าม โฮสต์ มักจะทำงานบน CPU

Differential Privacy

ในแมชชีนเลิร์นนิง แนวทางในการปกปิดข้อมูลระบุตัวบุคคลเพื่อปกป้องข้อมูลที่ละเอียดอ่อน (เช่น ข้อมูลส่วนบุคคลของบุคคล) ที่รวมอยู่ในชุดข้อมูลการฝึกของโมเดลไม่ให้มีการเปิดเผย วิธีนี้ช่วยให้มั่นใจได้ว่าโมเดลจะไม่เรียนรู้หรือจดจำข้อมูลเกี่ยวกับบุคคลใดบุคคลหนึ่งมากนัก ซึ่งทำได้โดยการสุ่มตัวอย่างและเพิ่มสัญญาณรบกวนระหว่างการฝึกโมเดล เพื่อปกปิดจุดข้อมูลแต่ละจุด ซึ่งจะช่วยลดความเสี่ยงในการเปิดเผย ข้อมูลการฝึกที่ละเอียดอ่อน

นอกจากนี้ Differential Privacy ยังใช้ภายนอกแมชชีนเลิร์นนิงด้วย ตัวอย่างเช่น นักวิทยาศาสตร์ด้านข้อมูลบางครั้งใช้ Differential Privacy เพื่อปกป้องความเป็นส่วนตัวของแต่ละบุคคล เมื่อคำนวณสถิติการใช้งานผลิตภัณฑ์สำหรับกลุ่มประชากรต่างๆ

การลดมิติ

การลดจำนวนมิติข้อมูลที่ใช้เพื่อแสดงฟีเจอร์หนึ่งๆ ในเวกเตอร์ฟีเจอร์ โดยปกติจะทำโดย การแปลงเป็นเวกเตอร์การฝัง

ขนาด

คำที่มีการใช้งานมากเกินไปซึ่งมีคำจำกัดความต่อไปนี้

จำนวนระดับของพิกัดในTensor เช่น

- สเกลาร์มี 0 มิติ เช่น

["Hello"] - เวกเตอร์มี 1 มิติ เช่น

[3, 5, 7, 11] - เมทริกซ์มี 2 มิติ เช่น

[[2, 4, 18], [5, 7, 14]]คุณระบุเซลล์หนึ่งๆ ในเวกเตอร์แบบ 1 มิติได้อย่างไม่ซ้ำกัน ด้วยพิกัด 1 ตำแหน่ง แต่ต้องใช้พิกัด 2 ตำแหน่งเพื่อระบุเซลล์หนึ่งๆ ในเมทริกซ์แบบ 2 มิติได้อย่างไม่ซ้ำกัน

- สเกลาร์มี 0 มิติ เช่น

จำนวนรายการในเวกเตอร์ฟีเจอร์

จำนวนองค์ประกอบในเลเยอร์การฝัง

การเขียนพรอมต์โดยตรง

คำพ้องความหมายของการเขียนพรอมต์แบบ Zero-Shot Prompting

ฟีเจอร์ที่ไม่ต่อเนื่อง

ฟีเจอร์ที่มีชุดค่าที่เป็นไปได้แบบจำกัด ตัวอย่างเช่น ฟีเจอร์ที่มีค่าเป็นได้เพียง animal, vegetable หรือ mineral คือฟีเจอร์ ไม่ต่อเนื่อง (หรือเชิงหมวดหมู่)

เปรียบเทียบกับฟีเจอร์ต่อเนื่อง

โมเดลแยกแยะ

โมเดลที่คาดการณ์ป้ายกำกับจากชุดฟีเจอร์อย่างน้อย 1 รายการ กล่าวอย่างเป็นทางการมากขึ้นคือ โมเดลแบบแยกแยะจะกำหนด ความน่าจะเป็นแบบมีเงื่อนไขของเอาต์พุตที่กำหนดฟีเจอร์และ น้ำหนัก นั่นคือ

p(output | features, weights)

เช่น โมเดลที่คาดการณ์ว่าอีเมลเป็นสแปมหรือไม่จากฟีเจอร์ และน้ำหนักคือโมเดลจำแนก

โมเดลการเรียนรู้ภายใต้การดูแลส่วนใหญ่ รวมถึงโมเดลการจัดประเภท และโมเดลการถดถอย เป็นโมเดลที่แยกแยะ

แตกต่างจากโมเดล Generative

ตัวแบ่ง

ระบบที่พิจารณาว่าตัวอย่างเป็นของจริงหรือปลอม

หรืออาจเป็นระบบย่อยภายในเครือข่าย ปฏิปักษ์แบบกำเนิดที่กำหนดว่าตัวอย่างที่สร้างโดยเครื่องกำเนิดเป็นของจริงหรือของปลอม

ดูข้อมูลเพิ่มเติมได้ที่ตัวแยกแยะ ในหลักสูตร GAN

ผลกระทบที่แตกต่าง

การตัดสินใจเกี่ยวกับผู้คนซึ่งส่งผลกระทบต่อกลุ่มย่อยของประชากรที่แตกต่างกันอย่างไม่สมส่วน โดยปกติแล้วจะหมายถึงสถานการณ์ ที่กระบวนการตัดสินใจแบบอัลกอริทึมส่งผลเสียหรือส่งผลดี ต่อกลุ่มย่อยบางกลุ่มมากกว่ากลุ่มอื่นๆ

ตัวอย่างเช่น สมมติว่าอัลกอริทึมที่พิจารณาการมีสิทธิ์ของชาวลิลิพุต ในการขอสินเชื่อบ้านขนาดเล็กมีแนวโน้มที่จะจัดประเภท ชาวลิลิพุตเป็น "ไม่มีสิทธิ์" หากที่อยู่จัดส่งมีรหัสไปรษณีย์ที่เฉพาะเจาะจง หากชาวลิลิพุตแบบ Big-Endian มีแนวโน้มที่จะมี ที่อยู่จัดส่งที่มีรหัสไปรษณีย์นี้มากกว่าชาวลิลิพุตแบบ Little-Endian อัลกอริทึมนี้อาจส่งผลให้เกิดผลกระทบที่ไม่เท่าเทียมกัน

แตกต่างจากการเลือกปฏิบัติ ซึ่งมุ่งเน้นความแตกต่างที่เกิดขึ้นเมื่อลักษณะของกลุ่มย่อย เป็นอินพุตที่ชัดเจนในกระบวนการตัดสินใจของอัลกอริทึม

การเลือกปฏิบัติ

การนำแอตทริบิวต์ที่ละเอียดอ่อนของกลุ่มตัวอย่าง มาพิจารณาในกระบวนการตัดสินใจแบบอัลกอริทึมเพื่อให้ กลุ่มย่อยต่างๆ ได้รับการปฏิบัติที่แตกต่างกัน

ตัวอย่างเช่น ลองพิจารณาอัลกอริทึมที่ กำหนดสิทธิ์ของชาวลิลิพุตในการขอสินเชื่อบ้านขนาดเล็กตาม ข้อมูลที่ระบุในใบสมัครขอสินเชื่อ หากอัลกอริทึมใช้ความสัมพันธ์ของ ลิลิพิวเทียนเป็น Big-Endian หรือ Little-Endian เป็นอินพุต อัลกอริทึม จะใช้การปฏิบัติที่แตกต่างกันตามมิตินั้น

แตกต่างจากผลกระทบที่ไม่เท่าเทียมกัน ซึ่งมุ่งเน้น ความแตกต่างในผลกระทบทางสังคมของการตัดสินใจตามอัลกอริทึมที่มีต่อกลุ่มย่อย โดยไม่คำนึงว่ากลุ่มย่อยเหล่านั้นจะเป็นอินพุตของโมเดลหรือไม่

การกลั่น

กระบวนการลดขนาดโมเดลหนึ่ง (เรียกว่าโมเดลครู) ให้เป็นโมเดลที่เล็กลง (เรียกว่าโมเดลนักเรียน) ซึ่งเลียนแบบ การคาดการณ์ของโมเดลเดิมให้ได้มากที่สุด การกลั่น มีประโยชน์เนื่องจากโมเดลขนาดเล็กมีข้อดี 2 ประการที่สำคัญกว่าโมเดลขนาดใหญ่ (โมเดลครู) ดังนี้

- เวลาอนุมานที่เร็วขึ้น

- ลดการใช้หน่วยความจำและพลังงาน

อย่างไรก็ตาม โดยทั่วไปแล้วการคาดการณ์ของนักเรียนมักจะไม่ดีเท่ากับการคาดการณ์ของครู

การกลั่นจะฝึกโมเดลนักเรียนเพื่อลดฟังก์ชันการสูญเสียตามความแตกต่างระหว่างเอาต์พุต ของการคาดการณ์ของโมเดลนักเรียนและโมเดลครู

เปรียบเทียบการกลั่นกับคำต่อไปนี้

ดูข้อมูลเพิ่มเติมได้ที่ LLM: การปรับแต่ง การกลั่น และการออกแบบพรอมต์ ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

การเผยแพร่

ความถี่และช่วงของค่าต่างๆ สำหรับฟีเจอร์หรือป้ายกำกับที่กำหนด การกระจายจะบันทึกความน่าจะเป็นของค่าหนึ่งๆ

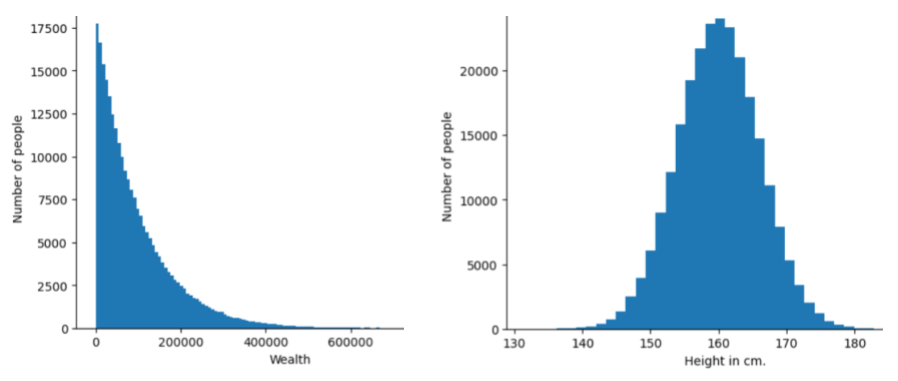

รูปภาพต่อไปนี้แสดงฮิสโทแกรมของการกระจาย 2 แบบที่แตกต่างกัน

- ทางด้านซ้ายคือการกระจายความมั่งคั่งตามกฎของพาเรโตเทียบกับจำนวนผู้ ที่มีความมั่งคั่งนั้น

- ทางด้านขวาคือการกระจายความสูงตามปกติเทียบกับจำนวนคน ที่มีความสูงนั้น

การทำความเข้าใจการกระจายของฟีเจอร์และป้ายกำกับแต่ละรายการจะช่วยให้คุณทราบวิธีปรับค่าให้เป็นมาตรฐานและตรวจหาค่าผิดปกติ

วลีไม่อยู่ในการกระจายหมายถึงค่าที่ไม่ปรากฏในชุดข้อมูลหรือพบได้น้อยมาก ตัวอย่างเช่น รูปภาพของดาวเสาร์จะถือว่าอยู่นอกการกระจายสำหรับชุดข้อมูลที่ประกอบด้วยรูปภาพแมว

การจัดกลุ่มแบบแบ่งแยก

การลดความละเอียด

คำที่ใช้กันอย่างแพร่หลายซึ่งอาจหมายถึงสิ่งต่อไปนี้

- การลดปริมาณข้อมูลในฟีเจอร์เพื่อฝึกโมเดลให้มีประสิทธิภาพมากขึ้น เช่น ก่อนฝึกโมเดลการจดจำรูปภาพ ให้ลดความละเอียดของรูปภาพที่มีความละเอียดสูง ลงเป็นรูปแบบที่มีความละเอียดต่ำกว่า

- การฝึกโดยใช้ตัวอย่างคลาสที่มีการแสดงมากเกินไปในเปอร์เซ็นต์ที่ต่ำอย่างไม่สมส่วน เพื่อปรับปรุงการฝึกโมเดลในคลาสที่มีการแสดงน้อย เช่น ในชุดข้อมูล ที่ไม่สมดุลของคลาส โมเดลมักจะเรียนรู้เกี่ยวกับ คลาสส่วนใหญ่เป็นจำนวนมาก และเรียนรู้เกี่ยวกับ คลาสส่วนน้อยไม่เพียงพอ การดาวน์แซมปลิงช่วย ปรับสมดุลปริมาณการฝึกในคลาสส่วนใหญ่และส่วนน้อย

ดูข้อมูลเพิ่มเติมได้ที่ชุดข้อมูล: ชุดข้อมูลที่ไม่สมดุล ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

DQN

ตัวย่อของ Deep Q-Network

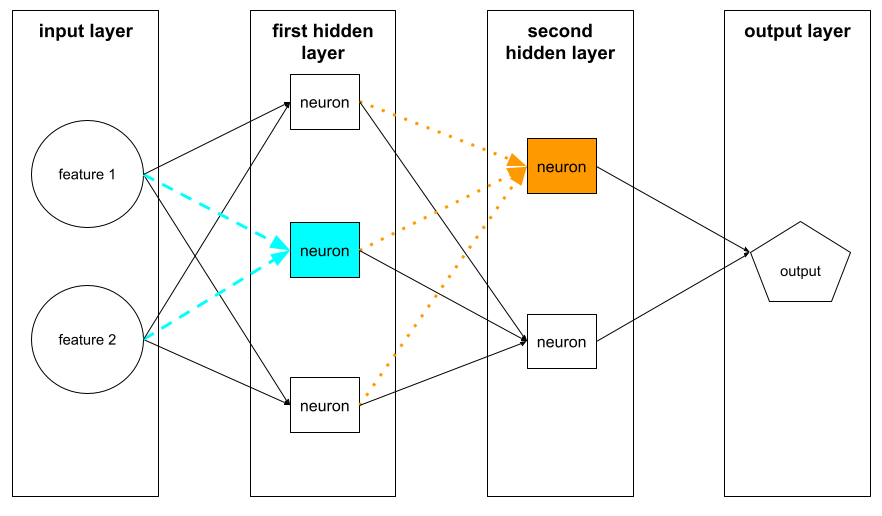

การทำให้เป็นปกติแบบ Dropout

รูปแบบของการทำให้เป็นปกติที่มีประโยชน์ในการฝึกโครงข่ายประสาทเทียม การทําให้เป็นปกติแบบ Dropout จะนําหน่วยที่เลือกแบบสุ่มจํานวนหนึ่งในเลเยอร์ เครือข่ายออกสําหรับขั้นตอนการไล่ระดับสีเดียว ยิ่งมีหน่วยหลุดออกไปมากเท่าใด การทำให้เป็นปกติก็จะยิ่งเข้มงวดมากขึ้นเท่านั้น ซึ่งคล้ายกับการฝึกโครงข่ายให้เลียนแบบกลุ่มโครงข่ายขนาดเล็กจำนวนมาก ดูรายละเอียดทั้งหมดได้ที่ Dropout: A Simple Way to Prevent Neural Networks from Overfitting

ไดนามิก

สิ่งที่ทำบ่อยๆ หรืออย่างต่อเนื่อง คำว่าไดนามิกและออนไลน์มีความหมายเหมือนกันในแมชชีนเลิร์นนิง การใช้งาน dynamic และ online ที่พบบ่อยในแมชชีนเลิร์นนิงมีดังนี้

- โมเดลแบบไดนามิก (หรือโมเดลออนไลน์) คือโมเดล ที่ได้รับการฝึกซ้ำบ่อยครั้งหรืออย่างต่อเนื่อง

- การฝึกแบบไดนามิก (หรือการฝึกออนไลน์) คือกระบวนการฝึก อย่างต่อเนื่องหรือบ่อยครั้ง

- การอนุมานแบบไดนามิก (หรือการอนุมานออนไลน์) คือกระบวนการ สร้างการคาดการณ์ตามต้องการ

โมเดลแบบไดนามิก

โมเดลที่ได้รับการฝึกซ้ำบ่อยครั้ง (อาจจะอย่างต่อเนื่องด้วย) โมเดลแบบไดนามิกคือ "ผู้เรียนรู้ตลอดชีวิต" ที่ ปรับตัวให้เข้ากับข้อมูลที่เปลี่ยนแปลงอยู่เสมอ โมเดลแบบไดนามิกเรียกอีกอย่างว่าโมเดลออนไลน์

แตกต่างจากโมเดลคงที่

E

Eager Execution

สภาพแวดล้อมการเขียนโปรแกรม TensorFlow ซึ่งการดำเนินการ จะทำงานทันที ในทางตรงกันข้าม การดำเนินการที่เรียกใช้ในการดำเนินการกราฟจะไม่ทำงานจนกว่าจะมีการประเมินอย่างชัดเจน การดำเนินการแบบกระตือรือร้นคืออินเทอร์เฟซแบบคำสั่ง ซึ่งคล้ายกับโค้ดในภาษาโปรแกรมส่วนใหญ่ โดยทั่วไปแล้ว โปรแกรมการดำเนินการแบบกระตือรือร้นจะแก้ไขข้อบกพร่องได้ง่ายกว่าโปรแกรมการดำเนินการแบบกราฟมาก

การหยุดก่อนกำหนด

วิธีการสำหรับการทำให้เป็นปกติที่เกี่ยวข้องกับการสิ้นสุดการฝึก ก่อนที่การลดลงของการฝึกจะสิ้นสุด การหยุดก่อนเวลาคือการหยุดฝึกโมเดลโดยตั้งใจ เมื่อการสูญเสียในชุดข้อมูลการตรวจสอบเริ่ม เพิ่มขึ้น นั่นคือเมื่อประสิทธิภาพการสรุปทั่วไปแย่ลง

แตกต่างจากการออกก่อนเวลา

ระยะทางของเครื่องเคลื่อนย้ายดิน (EMD)

การวัดความคล้ายคลึงกันของการกระจาย 2 รายการ ยิ่งระยะทางของ Earth Mover ต่ำเท่าใด การกระจายก็จะยิ่งคล้ายกันมากขึ้นเท่านั้น

ระยะทางแก้ไข

การวัดว่าสตริงข้อความ 2 รายการมีความคล้ายกันมากน้อยเพียงใด ในแมชชีนเลิร์นนิง ระยะทางในการแก้ไขมีประโยชน์ด้วยเหตุผลต่อไปนี้

- การคำนวณระยะทางในการแก้ไขทำได้ง่าย

- ระยะทางเอดิทสามารถเปรียบเทียบสตริง 2 รายการที่ทราบว่าคล้ายกัน

- ระยะทางในการแก้ไขจะกำหนดระดับที่สตริงต่างๆ คล้ายกับสตริงที่กำหนด

มีคำจำกัดความหลายอย่างของระยะทางในการแก้ไข โดยแต่ละคำจำกัดความจะใช้การดำเนินการกับสตริงที่แตกต่างกัน ดูตัวอย่างได้ที่ระยะทางเลเวนชไตน์

สัญกรณ์ Einsum

สัญกรณ์ที่มีประสิทธิภาพสำหรับอธิบายวิธีรวมเทนเซอร์ 2 รายการ ระบบจะรวมเทนเซอร์โดยการคูณองค์ประกอบของเทนเซอร์หนึ่ง กับองค์ประกอบของเทนเซอร์อีกอัน แล้วจึงนำผลคูณมาบวกกัน สัญกรณ์ Einsum ใช้สัญลักษณ์เพื่อระบุแกนของแต่ละเทนเซอร์ และจะจัดเรียงสัญลักษณ์เดียวกันเหล่านั้นใหม่เพื่อระบุรูปร่างของเทนเซอร์ใหม่ที่ได้

NumPy มีการติดตั้งใช้งาน Einsum ทั่วไป

เลเยอร์การฝัง

เลเยอร์ที่ซ่อนอยู่พิเศษที่ฝึกในฟีเจอร์เชิงหมวดหมู่ที่มีมิติสูงเพื่อค่อยๆ เรียนรู้เวกเตอร์การฝังที่มีมิติต่ำกว่า เลเยอร์การฝังช่วยให้โครงข่ายประสาทเทียมฝึกได้อย่างมีประสิทธิภาพมากกว่าการฝึกเฉพาะฟีเจอร์เชิงหมวดหมู่ที่มีมิติสูง

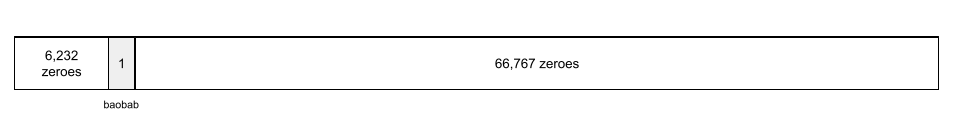

ตัวอย่างเช่น ปัจจุบัน Earth รองรับต้นไม้ประมาณ 73,000 สายพันธุ์ สมมติว่า

สายพันธุ์ต้นไม้เป็นฟีเจอร์ในโมเดลของคุณ ดังนั้นเลเยอร์

อินพุตของโมเดลจึงมีเวกเตอร์แบบ One-Hot ที่มีความยาว 73,000

องค์ประกอบ

เช่น baobab อาจแสดงเป็น

อาร์เรย์ที่มีองค์ประกอบ 73,000 รายการถือว่ายาวมาก หากคุณไม่เพิ่มเลเยอร์การฝัง ลงในโมเดล การฝึกจะใช้เวลานานมากเนื่องจาก การคูณด้วย 0 จำนวน 72,999 ตัว สมมติว่าคุณเลือกเลเยอร์การฝังที่มีมิติข้อมูล 12 รายการ ดังนั้น เลเยอร์การฝังจะค่อยๆ เรียนรู้ เวกเตอร์การฝังใหม่สำหรับต้นไม้แต่ละสายพันธุ์

ในบางสถานการณ์ การแฮชเป็นทางเลือกที่สมเหตุสมผล แทนเลเยอร์การฝัง

ดูข้อมูลเพิ่มเติมได้ที่การฝัง ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

พื้นที่การฝัง

ปริภูมิเวกเตอร์ d มิติที่ฟีเจอร์จากปริภูมิเวกเตอร์ที่มีมิติสูงกว่า จะได้รับการแมป ระบบจะฝึกพื้นที่การฝังเพื่อจับโครงสร้าง ที่มีความหมายสําหรับแอปพลิเคชันที่ต้องการ

ดอทโปรดักต์ ของการฝัง 2 รายการคือการวัดความคล้ายคลึงกัน

เวกเตอร์การฝัง

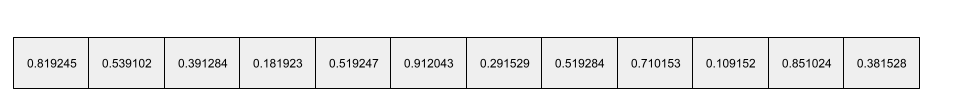

กล่าวโดยกว้างๆ คือ อาร์เรย์ของจำนวนจุดลอยที่นำมาจากเลเยอร์ที่ซ่อน ใดก็ได้ซึ่งอธิบายอินพุตไปยังเลเยอร์ที่ซ่อนนั้น เวกเตอร์การฝังมักจะเป็นอาร์เรย์ของจำนวนจุดลอยที่ได้รับการฝึกในเลเยอร์การฝัง เช่น สมมติว่าเลเยอร์การฝังต้องเรียนรู้เวกเตอร์การฝังสําหรับต้นไม้แต่ละสายพันธุ์จากทั้งหมด 73,000 สายพันธุ์บนโลก เวกเตอร์การฝังสำหรับต้นบาวบับอาจเป็นอาร์เรย์ต่อไปนี้

เวกเตอร์การฝังไม่ใช่กลุ่มตัวเลขแบบสุ่ม เลเยอร์การฝัง จะกำหนดค่าเหล่านี้ผ่านการฝึกคล้ายกับวิธีที่ โครงข่ายประสาทเทียมเรียนรู้น้ำหนักอื่นๆ ระหว่างการฝึก องค์ประกอบแต่ละรายการของอาร์เรย์คือการจัดประเภทตามลักษณะบางอย่างของสายพันธุ์ต้นไม้ องค์ประกอบใดแสดงลักษณะของต้นไม้สายพันธุ์ใด ซึ่งเป็นสิ่งที่มนุษย์ ระบุได้ยากมาก

ส่วนที่น่าทึ่งในทางคณิตศาสตร์ของเวกเตอร์การฝังคือรายการที่คล้ายกันจะมีชุดตัวเลขทศนิยมที่คล้ายกัน เช่น ต้นไม้สายพันธุ์ที่คล้ายกันจะมีชุดตัวเลขทศนิยมที่คล้ายกันมากกว่าต้นไม้สายพันธุ์ที่แตกต่างกัน ต้นเรดวูดและต้นซีคัวญ่าเป็นต้นไม้ที่เกี่ยวข้อง จึงมีชุดตัวเลขทศนิยมแบบลอยตัวที่คล้ายกันมากกว่า ต้นเรดวูดและต้นมะพร้าว ตัวเลขในเวกเตอร์การฝังจะ เปลี่ยนทุกครั้งที่คุณฝึกโมเดลใหม่ แม้ว่าคุณจะฝึกโมเดลใหม่ ด้วยอินพุตที่เหมือนกันก็ตาม

ฟังก์ชันการกระจายสะสมเชิงประจักษ์ (eCDF หรือ EDF)

ฟังก์ชันการกระจายสะสม โดยอิงตามการวัดเชิงประจักษ์จากชุดข้อมูลจริง ค่าของฟังก์ชันที่จุดใดก็ตามตามแกน x คือเศษส่วนของการสังเกตในชุดข้อมูลที่น้อยกว่าหรือเท่ากับค่าที่ระบุ

การลดความเสี่ยงเชิงประจักษ์ (ERM)

การเลือกฟังก์ชันที่ลดการสูญเสียในชุดการฝึกให้เหลือน้อยที่สุด เปรียบเทียบกับการลดความเสี่ยงเชิงโครงสร้าง

โปรแกรมเปลี่ยนไฟล์

โดยทั่วไปแล้ว ระบบ ML ใดๆ ที่แปลงจากรูปแบบดิบ แบบกระจัดกระจาย หรือภายนอก เป็นรูปแบบที่ประมวลผลแล้ว หนาแน่นขึ้น หรือภายในมากขึ้น

โดยมักเป็นส่วนประกอบของโมเดลขนาดใหญ่ ซึ่งมักจะ ทำงานร่วมกับดีโคดเดอร์ Transformer บางตัวจะจับคู่ตัวเข้ารหัสกับตัวถอดรหัส แต่ Transformer ตัวอื่นๆ จะใช้เฉพาะตัวเข้ารหัส หรือเฉพาะตัวถอดรหัส

บางระบบใช้เอาต์พุตของตัวเข้ารหัสเป็นอินพุตไปยังเครือข่ายการจัดประเภทหรือการถดถอย

ในงานแบบลำดับต่อลำดับ ตัวเข้ารหัส จะรับลำดับอินพุตและส่งคืนสถานะภายใน (เวกเตอร์) จากนั้นดีโคดเดอร์จะใช้สถานะภายในนั้นเพื่อคาดการณ์ลำดับถัดไป

ดูคำจำกัดความของตัวเข้ารหัสในสถาปัตยกรรม Transformer ได้ที่Transformer

ดูข้อมูลเพิ่มเติมได้ที่LLM: โมเดลภาษาขนาดใหญ่คืออะไรในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

อุปกรณ์ปลายทาง

ตำแหน่งที่เข้าถึงได้ในเครือข่าย (โดยปกติคือ URL) ซึ่งใช้เข้าถึงบริการได้

วงดนตรี

ชุดโมเดลที่ฝึกแยกกันซึ่งมีการหาค่าเฉลี่ยหรือรวบรวมการคาดการณ์ ในหลายกรณี การรวมโมเดลจะให้การคาดการณ์ที่ดีกว่าโมเดลเดียว เช่น Random Forest เป็นการรวมกันที่สร้างจากDecision Tree หลายรายการ โปรดทราบว่าDecision Forest บางรายการไม่ใช่กลุ่ม

ดูข้อมูลเพิ่มเติมได้ที่Random Forest ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

เอนโทรปี

ใน ทฤษฎีข้อมูล คำอธิบายเกี่ยวกับความไม่แน่นอนของการกระจายความน่าจะเป็น หรืออาจกล่าวได้ว่าเอนโทรปีคือปริมาณข้อมูลที่ตัวอย่างแต่ละรายการมี การกระจายจะมี เอนโทรปีสูงสุดที่เป็นไปได้เมื่อค่าทั้งหมดของตัวแปรสุ่มมี โอกาสเท่ากัน

เอนโทรปีของชุดที่มีค่าที่เป็นไปได้ 2 ค่าคือ "0" และ "1" (เช่น ป้ายกำกับในปัญหาการแยกประเภทแบบไบนารี) มีสูตรดังนี้

H = -p log p - q log q = -p log p - (1-p) * log (1-p)

โดย

- H คือเอนโทรปี

- p คือเศษส่วนของตัวอย่าง "1"

- q คือเศษส่วนของตัวอย่าง "0" โปรดทราบว่า q = (1 - p)

- log โดยทั่วไปคือ log2 ในกรณีนี้ หน่วยเอนโทรปี คือบิต

ตัวอย่างเช่น สมมติว่า

- ตัวอย่าง 100 รายการมีค่า "1"

- ตัวอย่าง 300 รายการมีค่า "0"

ดังนั้นค่าเอนโทรปีจึงเป็นดังนี้

- p = 0.25

- q = 0.75

- H = (-0.25)log2(0.25) - (0.75)log2(0.75) = 0.81 บิตต่อตัวอย่าง

ชุดข้อมูลที่สมดุลอย่างสมบูรณ์ (เช่น "0" 200 รายการและ "1" 200 รายการ) จะมีเอนโทรปี 1.0 บิตต่อตัวอย่าง เมื่อชุดข้อมูลไม่สมดุลมากขึ้น เอนโทรปีจะเข้าใกล้ 0.0

ในแผนผังการตัดสินใจ เอนโทรปีช่วยสร้างการได้ข้อมูลเพื่อช่วยให้ตัวแยกเลือกเงื่อนไข ในระหว่างการเติบโตของแผนผังการตัดสินใจในการจัดประเภท

เปรียบเทียบเอนโทรปีกับ

- ความไม่บริสุทธิ์ของ Gini

- ฟังก์ชันการสูญเสียเอนโทรปีครอส

โดยมักเรียกเอนโทรปีว่าเอนโทรปีของแชนนอน

ดูข้อมูลเพิ่มเติมได้ที่ตัวแยกที่แน่นอนสำหรับการแยกประเภทแบบไบนารีที่มีฟีเจอร์เชิงตัวเลข ในหลักสูตร Decision Forests

สภาพแวดล้อม

ในการเรียนรู้แบบเสริมกำลัง โลกที่มีเอเจนต์ และอนุญาตให้เอเจนต์สังเกตสถานะของโลกนั้น เช่น โลกที่แสดงอาจเป็นเกมอย่างหมากรุก หรือโลกทางกายภาพอย่างเขาวงกต เมื่อเอเจนต์ใช้การดำเนินการกับสภาพแวดล้อม สภาพแวดล้อมจะเปลี่ยนสถานะ

ตอน

ในการเรียนรู้แบบเสริมกำลัง การพยายามซ้ำแต่ละครั้งของเอเจนต์เพื่อเรียนรู้สภาพแวดล้อม

Epoch

การส่งผ่านการฝึกแบบเต็มทั้งชุดการฝึก เพื่อให้ระบบประมวลผลตัวอย่างแต่ละรายการ 1 ครั้ง

Epoch แสดงถึงN/ขนาดกลุ่ม

การวนซ้ำในการฝึก โดย N คือ

จํานวนตัวอย่างทั้งหมด

เช่น สมมติว่ามีข้อมูลต่อไปนี้

- ชุดข้อมูลประกอบด้วยตัวอย่าง 1,000 รายการ

- ขนาดกลุ่มคือ 50 ตัวอย่าง

ดังนั้น 1 Epoch จึงต้องมีการวนซ้ำ 20 ครั้ง

1 epoch = (N/batch size) = (1,000 / 50) = 20 iterations

ดูข้อมูลเพิ่มเติมได้ที่การถดถอยเชิงเส้น: ไฮเปอร์พารามิเตอร์ ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

นโยบายแบบเอปซิลอนกรีด

ในการเรียนรู้แบบเสริมกำลัง นโยบายที่ทำตาม นโยบายแบบสุ่มที่มีความน่าจะเป็นเป็นเอปซิลอนหรือ นโยบายแบบตะกละในกรณีอื่นๆ ตัวอย่างเช่น หากเอปซิลอนเป็น 0.9 นโยบายจะทำตามนโยบายแบบสุ่ม 90% ของเวลา และนโยบายแบบตะกละ 10% ของเวลา

ในตอนต่อๆ ไป อัลกอริทึมจะลดค่าของเอปซิลอนเพื่อเปลี่ยนจากการปฏิบัติตามนโยบายแบบสุ่มเป็นการปฏิบัติตามนโยบายแบบตะกละ การเปลี่ยนนโยบายทำให้เอเจนต์สำรวจสภาพแวดล้อมแบบสุ่มก่อน แล้วจึงใช้ประโยชน์จากผลลัพธ์ของการสำรวจแบบสุ่มอย่างตะกละตะกลาม

ความเท่าเทียมของโอกาส

เมตริกความเป็นธรรมเพื่อประเมินว่าโมเดลคาดการณ์ผลลัพธ์ที่ต้องการได้ดีเท่าๆ กันสำหรับค่าทั้งหมดของแอตทริบิวต์ที่ละเอียดอ่อนหรือไม่ กล่าวอีกนัยหนึ่งคือ หากคลาสที่เป็นบวกเป็นผลลัพธ์ที่ต้องการสำหรับโมเดล เป้าหมายคือการทำให้อัตราผลบวกจริงเท่ากันสำหรับทุกกลุ่ม

ความเท่าเทียมกันของโอกาสเกี่ยวข้องกับโอกาสที่เท่าเทียมกัน ซึ่งกำหนดให้ทั้งอัตราผลบวกจริงและ อัตราผลบวกลวงต้องเหมือนกันสำหรับทุกกลุ่ม

สมมติว่ามหาวิทยาลัยกลับดับดริบรับทั้งชาวลิลิปุตและชาวบร็อบดิงแนก เข้าโปรแกรมคณิตศาสตร์ที่เข้มงวด โรงเรียนมัธยมศึกษาของชาวลิลิพุตมี หลักสูตรที่แข็งแกร่งสำหรับชั้นเรียนคณิตศาสตร์ และนักเรียนส่วนใหญ่ มีคุณสมบัติเหมาะสมสำหรับโปรแกรมมหาวิทยาลัย โรงเรียนมัธยมของชาวบร็อบดิงแนกไม่มี ชั้นเรียนคณิตศาสตร์เลย และด้วยเหตุนี้ นักเรียนที่ มีคุณสมบัติจึงมีจำนวนน้อยกว่ามาก โอกาสที่เท่าเทียมกันจะเกิดขึ้นสำหรับป้ายกำกับที่ต้องการของ "ได้รับการยอมรับ" ในส่วนที่เกี่ยวข้องกับสัญชาติ (ลิลิพุตหรือบร็อบดิงแนก) หากนักเรียน/นักศึกษาที่มีคุณสมบัติเหมาะสมมีโอกาสได้รับการยอมรับเท่ากัน ไม่ว่าจะเป็นชาวลิลิพุตหรือชาวบร็อบดิงแนก

ตัวอย่างเช่น สมมติว่ามีชาวลิลิพุต 100 คนและชาวโบรบดิงแนก 100 คนสมัครเข้าเรียนที่ มหาวิทยาลัยกลับบ์ดับดริบ และการตัดสินใจรับเข้าเรียนมีดังนี้

ตารางที่ 1 ผู้สมัครจากลิลิพุต (90% มีคุณสมบัติ)

| เข้าเกณฑ์ | คุณสมบัติไม่ครบ | |

|---|---|---|

| ยอมรับ | 45 | 3 |

| ถูกปฏิเสธ | 45 | 7 |

| รวม | 90 | 10 |

|

เปอร์เซ็นต์ของนักเรียนที่มีคุณสมบัติเหมาะสมที่ได้รับการตอบรับ: 45/90 = 50% เปอร์เซ็นต์ของนักเรียนที่ไม่มีคุณสมบัติเหมาะสมที่ถูกปฏิเสธ: 7/10 = 70% เปอร์เซ็นต์รวมของนักเรียนชาวลิลิพุตที่ได้รับการตอบรับ: (45+3)/100 = 48% |

||

ตารางที่ 2 ผู้สมัครจาก Brobdingnag (10% มีคุณสมบัติ):

| เข้าเกณฑ์ | คุณสมบัติไม่ครบ | |

|---|---|---|

| ยอมรับ | 5 | 9 |

| ถูกปฏิเสธ | 5 | 81 |

| รวม | 10 | 90 |

|

เปอร์เซ็นต์ของนักเรียนที่มีคุณสมบัติเหมาะสมที่ได้รับการตอบรับ: 5/10 = 50% เปอร์เซ็นต์ของนักเรียนที่ไม่มีคุณสมบัติเหมาะสมที่ถูกปฏิเสธ: 81/90 = 90% เปอร์เซ็นต์รวมของนักเรียน Brobdingnagian ที่ได้รับการตอบรับ: (5+9)/100 = 14% |

||

ตัวอย่างข้างต้นเป็นไปตามความเท่าเทียมกันในโอกาสที่จะได้รับการยอมรับ ของนักเรียนที่มีคุณสมบัติเหมาะสม เนื่องจากทั้งชาวลิลิพุตและชาวบร็อบดิงแนก มีโอกาส 50% ที่จะได้รับการตอบรับ

แม้ว่าโอกาสที่เท่าเทียมจะได้รับการตอบสนอง แต่เมตริกความเป็นธรรม 2 รายการต่อไปนี้ ยังไม่ได้รับการตอบสนอง

- ความเท่าเทียมกันทางประชากรศาสตร์: ชาวลิลิพุตและชาวบร็อบดิงแนกจะได้รับการตอบรับเข้ามหาวิทยาลัยในอัตราที่แตกต่างกัน โดยนักเรียนชาวลิลิพุตได้รับการตอบรับ 48% แต่นักเรียนชาวบร็อบดิงแนกได้รับการตอบรับเพียง 14%

- โอกาสที่เท่าเทียมกัน: แม้ว่านักเรียน/นักศึกษาชาวลิลิพุต และชาวบร็อบดิงแนกที่มีคุณสมบัติเหมาะสมจะมีโอกาสได้รับการตอบรับเท่ากัน แต่ข้อจำกัดเพิ่มเติมที่ว่านักเรียน/นักศึกษาชาวลิลิพุตและ ชาวบร็อบดิงแนกที่ไม่มีคุณสมบัติเหมาะสมจะมีโอกาสถูกปฏิเสธเท่ากันนั้นไม่เป็นจริง ชาวลิลิปุตที่ไม่ผ่านเกณฑ์มีอัตราการปฏิเสธ 70% ส่วนชาวบร็อบดิงแน็กที่ไม่ผ่านเกณฑ์มีอัตราการปฏิเสธ 90%

ดูข้อมูลเพิ่มเติมได้ที่ความเป็นธรรม: ความเท่าเทียมกันของโอกาส ในหลักสูตรเร่งรัดเกี่ยวกับแมชชีนเลิร์นนิง

โอกาสที่เท่ากัน

เมตริกความเป็นธรรมเพื่อประเมินว่าโมเดลคาดการณ์ผลลัพธ์ได้ดีเท่ากันสำหรับค่าทั้งหมดของแอตทริบิวต์ที่ละเอียดอ่อนหรือไม่ โดยคำนึงถึงทั้งคลาสบวกและคลาสลบ ไม่ใช่แค่คลาสใดคลาสหนึ่งเท่านั้น กล่าวคือ อัตราผลบวกจริง และอัตราผลลบลวงควรเท่ากันสำหรับ ทุกกลุ่ม