Bu sayfada Karar Ormanları sözlüğündeki terimler yer almaktadır. Tüm sözlük terimleri için burayı tıklayın.

A

özellik örnekleme

Her bir karar ağacının, koşulu öğrenirken olası özelliklerin yalnızca rastgele bir alt kümesini dikkate aldığı bir karar ormanı eğitme taktiği. Genellikle her düğüm için farklı bir özellik alt kümesi örneklenir. Buna karşılık, bir karar ağacı eğitilirken özellik örneklemesi yapılmadığında her düğüm için olası tüm özellikler dikkate alınır.

eksenle hizalı koşul

Karar ağacında yalnızca tek bir özelliği içeren bir koşul. Örneğin, area

bir özellikse aşağıdaki koşul eksenle hizalanmış bir koşuldur:

area > 200

Eğik koşul ile çakışıyor.

B

torbalama

Her bir bileşen modelinin, eğitim örneklerinin yerine koyma ile örneklenmiş rastgele bir alt kümesi üzerinde eğitildiği bir topluluk eğitme yöntemi. Örneğin, rastgele orman, torbalama ile eğitilmiş bir karar ağaçları koleksiyonudur.

Bagging terimi, bootstrap aggregating'in kısaltmasıdır.

Daha fazla bilgi için Karar Ormanları kursundaki Rastgele ormanlar bölümüne bakın.

ikili koşul

Karar ağacında, genellikle evet veya hayır olmak üzere yalnızca iki olası sonucu olan bir koşul. Örneğin, aşağıdakiler ikili koşuldur:

temperature >= 100

Non-binary durumu ile karşılaştırın.

Daha fazla bilgi için Karar Ormanları kursundaki Koşul türleri bölümünü inceleyin.

C

koşul

Karar ağacında test gerçekleştiren tüm düğümler. Örneğin, aşağıdaki karar ağacı iki koşul içerir:

Koşul, bölünme veya test olarak da adlandırılır.

Yaprak ile kontrast durumu.

Şuna da bakabilirsiniz:

Daha fazla bilgi için Karar Ormanları kursundaki Koşul türleri bölümünü inceleyin.

D

karar ormanı

Birden fazla karar ağacından oluşturulan bir model. Karar ormanı, karar ağaçlarının tahminlerini toplayarak tahmin yapar. Popüler karar ormanı türleri arasında rastgele ormanlar ve gradyan artırılmış ağaçlar yer alır.

Daha fazla bilgi için Karar Ormanları kursundaki Karar Ormanları bölümüne bakın.

karar ağacı

Hiyerarşik olarak düzenlenmiş bir dizi koşul ve yapraklardan oluşan bir denetimli öğrenme modeli. Örneğin, aşağıda bir karar ağacı verilmiştir:

E

entropi

Bilgi teorisinde, bir olasılık dağılımının ne kadar tahmin edilemez olduğunun açıklamasıdır. Alternatif olarak entropi, her bir örneğin ne kadar bilgi içerdiği şeklinde de tanımlanır. Bir dağılım, rastgele değişkenin tüm değerleri eşit olasılıklı olduğunda mümkün olan en yüksek entropiye sahiptir.

"0" ve "1" olmak üzere iki olası değere sahip bir kümenin entropisi (örneğin, ikili sınıflandırma problemindeki etiketler) aşağıdaki formüle sahiptir:

H = -p log p - q log q = -p log p - (1-p) * log (1-p)

Bu örnekte:

- H, entropidir.

- p, "1" örneklerinin kesridir.

- q, "0" örneklerinin kesridir. q = (1 - p) olduğunu unutmayın.

- log genellikle log2'dir. Bu durumda, entropi birimi bit'tir.

Örneğin, aşağıdakileri varsayalım:

- 100 örnekte "1" değeri var

- 300 örnekte "0" değeri var

Bu nedenle, entropi değeri şöyledir:

- p = 0,25

- q = 0,75

- H = (-0,25)log2(0,25) - (0,75)log2(0,75) = örnek başına 0,81 bit

Mükemmel dengelenmiş bir küme (örneğin, 200 "0" ve 200 "1") örneği başına 1,0 bit entropiye sahip olur. Bir küme dengesizleştiğinde entropisi 0, 0'a doğru hareket eder.

Karar ağaçlarında entropi, bölücünün sınıflandırma karar ağacının büyümesi sırasında koşulları seçmesine yardımcı olmak için bilgi kazancını formüle etmeye yardımcı olur.

Entropiyi şunlarla karşılaştırın:

- gini impurity

- Çapraz entropi kayıp fonksiyonu

Entropiye genellikle Shannon entropisi denir.

Daha fazla bilgi için Karar Ormanları kursundaki Sayısal özelliklerle ikili sınıflandırma için tam ayırıcı başlıklı makaleyi inceleyin.

C

özellik önem düzeyleri

Değişken önemleri ile eş anlamlıdır.

G

Gini kirliliği

Entropiye benzer bir metrik. Ayırıcılar, sınıflandırma karar ağaçları için koşullar oluşturmak üzere gini kirliliğinden veya entropiden elde edilen değerleri kullanır. Bilgi kazancı, entropiden elde edilir. Gini kirliliğinden elde edilen metrik için evrensel olarak kabul edilen eşdeğer bir terim yoktur. Ancak bu adsız metrik, bilgi kazancı kadar önemlidir.

Gini kirliliğine Gini endeksi veya kısaca Gini de denir.

gradyan artırılmış (karar) ağaçları (GBT)

Aşağıdaki özelliklere sahip bir karar ormanı türü:

- Eğitim, gradyan artırma yöntemini kullanır.

- Zayıf model bir karar ağacıdır.

Daha fazla bilgi için Karar Ormanları kursundaki Gradyan Artırılmış Karar Ağaçları bölümüne bakın.

gradyan artırma

Zayıf modellerin, güçlü bir modelin kalitesini (kaybı azaltmak) yinelemeli olarak iyileştirmek için eğitildiği bir eğitim algoritması. Örneğin, zayıf bir model doğrusal veya küçük bir karar ağacı modeli olabilir. Güçlü model, daha önce eğitilmiş tüm zayıf modellerin toplamı haline gelir.

En basit biçimiyle gradyan artırmada, her yinelemede güçlü modelin kayıp gradyanını tahmin etmek için zayıf bir model eğitilir. Ardından, güçlü modelin çıkışı, gradyan inişine benzer şekilde, tahmin edilen gradyan çıkarılarak güncellenir.

Bu örnekte:

- $F_{0}$ başlangıçtaki güçlü modeldir.

- $F_{i+1}$ ise bir sonraki güçlü modeldir.

- $F_{i}$ mevcut güçlü modeldir.

- $\xi$, 0,0 ile 1,0 arasında bir değerdir ve küçültme olarak adlandırılır. Bu değer, gradyan inişindeki öğrenme hızına benzer.

- $f_{i}$, $F_{i}$'nin kayıp gradyanını tahmin etmek için eğitilmiş zayıf modeldir.

Gradyan artırmanın modern varyasyonları, hesaplamalarına kaybın ikinci türevini (Hessian) de dahil eder.

Karar ağaçları, genellikle gradyan artırmada zayıf modeller olarak kullanılır. Gradyan artırılmış (karar) ağaçları başlıklı makaleyi inceleyin.

I

çıkarım yolu

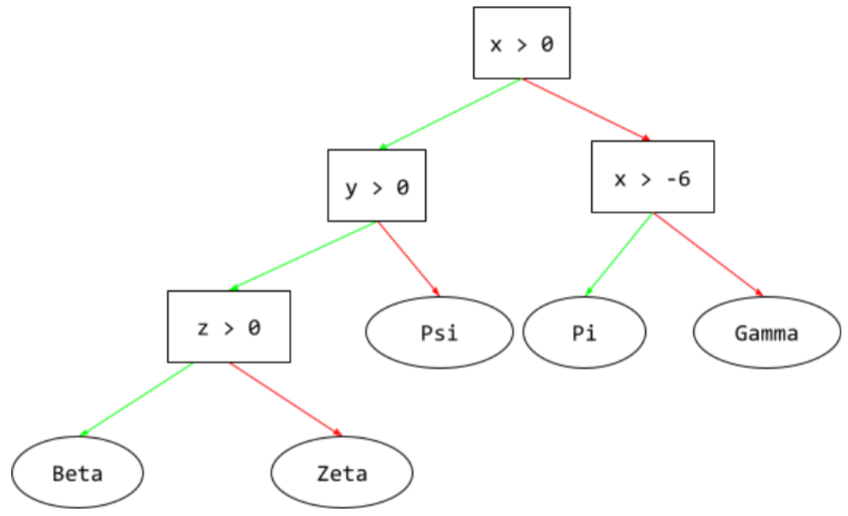

Karar ağacında, çıkarım sırasında belirli bir örneğin kökten diğer koşullara doğru izlediği yol, yaprakla sonlanır. Örneğin, aşağıdaki karar ağacında daha kalın oklar, aşağıdaki özellik değerlerine sahip bir örnek için çıkarım yolunu gösterir:

- x = 7

- y = 12

- z = -3

Aşağıdaki resimde çıkarım yolu, yaprağa (Zeta) ulaşmadan önce üç koşuldan geçer.

Üç kalın ok, çıkarım yolunu gösterir.

Daha fazla bilgi için Karar Ormanları kursundaki Karar ağaçları bölümüne bakın.

bilgi kazancı

Karar ağaçlarında, bir düğümün entropisi ile alt düğümlerinin entropisinin örnek sayısına göre ağırlıklı toplamı arasındaki fark. Bir düğümün entropisi, o düğümdeki örneklerin entropisidir.

Örneğin, aşağıdaki entropi değerlerini ele alalım:

- üst düğümün entropisi = 0,6

- 16 alakalı örneğe sahip bir alt düğümün entropisi = 0,2

- 24 alakalı örneği olan başka bir alt düğümün entropisi = 0,1

Bu nedenle, örneklerin% 40'ı bir alt düğümde, %60'ı ise diğer alt düğümdedir. Bu nedenle:

- alt düğümlerin ağırlıklı entropi toplamı = (0,4 * 0,2) + (0,6 * 0,1) = 0,14

Bu nedenle, bilgi kazancı şöyledir:

- bilgi kazancı = üst düğümün entropisi - alt düğümlerin ağırlıklı entropi toplamı

- bilgi kazancı = 0,6 - 0,14 = 0,46

Çoğu bölücü, bilgi kazanımını en üst düzeye çıkaran koşullar oluşturmayı amaçlar.

küme içi koşul

Karar ağacında, bir öğe grubunda bir öğenin varlığını test eden koşul. Örneğin, aşağıdakiler bir küme içi koşuldur:

house-style in [tudor, colonial, cape]

Çıkarım sırasında, ev stili özelliğinin değeri tudor, colonial veya cape ise bu koşul Evet olarak değerlendirilir. Eğer

ev stili özelliğinin değeri başka bir şeyse (örneğin, ranch),

bu koşul Hayır olarak değerlendirilir.

Küme içi koşullar genellikle one-hot kodlu özellikleri test eden koşullara kıyasla daha verimli karar ağaçları oluşturur.

L

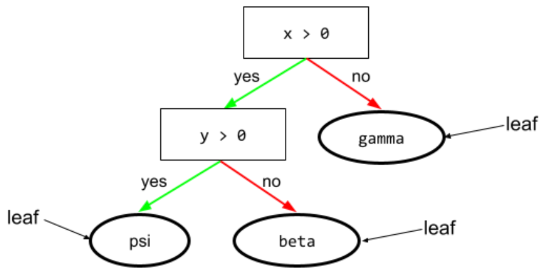

yaprak

Karar ağacındaki herhangi bir uç nokta. Bir koşulun aksine, yaprak test yapmaz. Daha doğrusu, yaprak olası bir tahmindir. Yaprak, çıkarım yolunun son düğümüdür.

Örneğin, aşağıdaki karar ağacında üç yaprak bulunur:

Daha fazla bilgi için Karar Ormanları kursundaki Karar ağaçları bölümüne bakın.

H

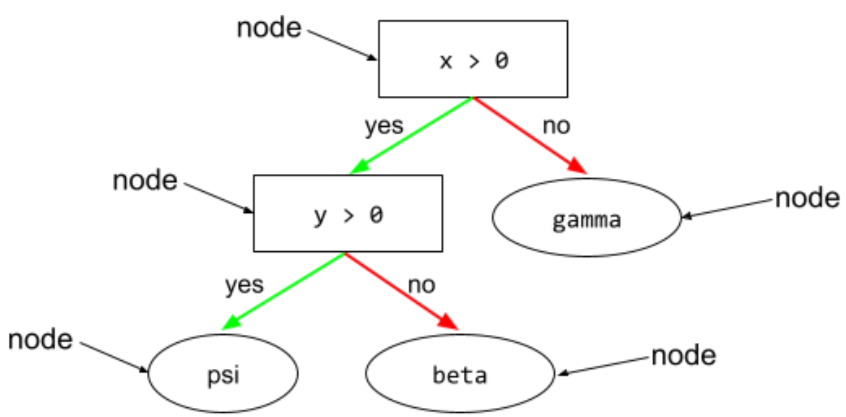

düğüm (karar ağacı)

Karar ağacında herhangi bir koşul veya yaprak.

Daha fazla bilgi için Karar Ormanları kursundaki Karar Ağaçları bölümüne bakın.

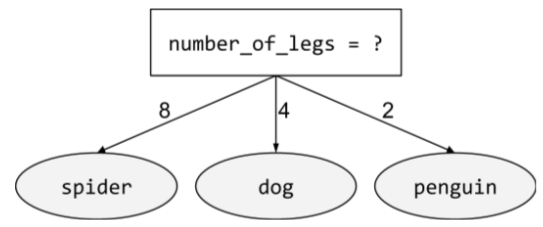

ikili olmayan koşul

İkiden fazla olası sonuç içeren bir koşul. Örneğin, aşağıdaki ikili olmayan koşul üç olası sonuç içerir:

Daha fazla bilgi için Karar Ormanları kursundaki Koşul türleri bölümünü inceleyin.

O

eğik koşul

Karar ağacında birden fazla özelliği içeren bir koşul. Örneğin, yükseklik ve genişlik özellikse aşağıdaki koşul eğik koşuldur:

height > width

Eksenle hizalanmış koşul ile karşılaştırın.

Daha fazla bilgi için Karar Ormanları kursundaki Koşul türleri bölümünü inceleyin.

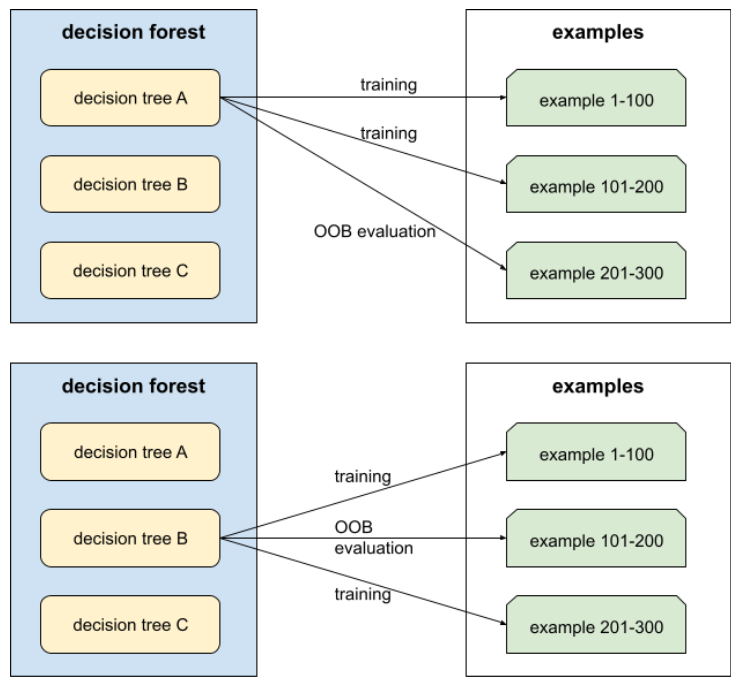

out-of-bag evaluation (OOB evaluation)

Her bir karar ağacını, bu karar ağacının eğitimi sırasında kullanılmayan örneklerle karşılaştırarak karar ormanının kalitesini değerlendirme mekanizması. Örneğin, aşağıdaki şemada sistemin her karar ağacını örneklerin yaklaşık üçte ikisi üzerinde eğittiğini ve ardından örneklerin kalan üçte biri üzerinde değerlendirdiğini görebilirsiniz.

Torba dışı değerlendirme, çapraz doğrulama mekanizmasının hesaplama açısından verimli ve tutarlı bir yaklaşımıdır. Çapraz doğrulama işleminde, her çapraz doğrulama turu için bir model eğitilir (örneğin, 10 katlı çapraz doğrulama işleminde 10 model eğitilir). Bant dışı değerlendirmede tek bir model eğitilir. Torbalama, eğitim sırasında her ağaçtan bazı verileri sakladığı için OOB değerlendirmesi, çapraz doğrulamayı yaklaşık olarak hesaplamak için bu verileri kullanabilir.

Daha fazla bilgi için Karar Ormanları kursundaki Torba dışı değerlendirme bölümüne bakın.

P

permütasyon değişkeni önemleri

Özellik değerleri permütasyonundan sonra bir modelin tahmin hatasındaki artışı değerlendiren bir değişken önem derecesi türü. Permütasyonlu değişken önemi, modelden bağımsız bir metriktir.

R

rastgele orman

Her karar ağacının, torbalama gibi belirli bir rastgele gürültüyle eğitildiği karar ağaçlarından oluşan bir topluluktur.

Rastgele ormanlar, bir karar ormanı türüdür.

Daha fazla bilgi için Karar Ormanları kursundaki Rastgele Orman bölümüne bakın.

kök

Karar ağacındaki başlangıç düğümü (ilk koşul). Geleneksel olarak, diyagramlarda kök, karar ağacının en üstünde yer alır. Örneğin:

G

yerine koyarak örnekleme

Aynı öğenin birden çok kez seçilebildiği, bir dizi aday öğe arasından öğe seçme yöntemi. "Değiştirme ile" ifadesi, her seçimden sonra seçilen öğenin aday öğeler havuzuna geri döndürüldüğü anlamına gelir. Ters yöntem olan yerine koymadan örnekleme, aday öğenin yalnızca bir kez seçilebileceği anlamına gelir.

Örneğin, aşağıdaki meyve setini ele alalım:

fruit = {kiwi, apple, pear, fig, cherry, lime, mango}Sistemin ilk öğe olarak rastgele fig öğesini seçtiğini varsayalım.

Değiştirme ile örnekleme kullanılıyorsa sistem, aşağıdaki gruptan ikinci öğeyi seçer:

fruit = {kiwi, apple, pear, fig, cherry, lime, mango}Evet, bu öncekiyle aynı set olduğundan sistem fig öğesini tekrar seçebilir.

Yerine koymadan örnekleme kullanılıyorsa seçilen bir örnek tekrar seçilemez. Örneğin, sistem ilk örnek olarak rastgele fig öğesini seçerse fig tekrar seçilemez. Bu nedenle, sistem aşağıdaki (küçültülmüş) kümeden ikinci örneği seçer:

fruit = {kiwi, apple, pear, cherry, lime, mango}küçülme

Gradyan artırmada aşırı uyumu kontrol eden bir hiperparametredir. Gradyan artırmada küçültme, gradyan inişindeki öğrenme hızına benzer. Küçülme, 0,0 ile 1,0 arasında bir ondalık değerdir. Daha düşük bir daralma değeri, daha yüksek bir daralma değerine kıyasla aşırı uyumu daha fazla azaltır.

Split

Karar ağacında, koşulun diğer adı.

ayırıcı

Karar ağacı eğitilirken her düğümde en iyi koşulu bulmaktan sorumlu rutin (ve algoritma).

T

test

Karar ağacında, koşulun diğer adı.

eşik (karar ağaçları için)

Eksene göre hizalanmış koşulda, özelliğin karşılaştırıldığı değer. Örneğin, aşağıdaki koşulda 75 eşik değerdir:

grade >= 75

Daha fazla bilgi için Karar Ormanları kursundaki Sayısal özelliklerle ikili sınıflandırma için tam ayırıcı başlıklı makaleyi inceleyin.

V

değişken önemleri

Her bir özelliğin model için göreli önemini gösteren bir puan grubu.

Örneğin, ev fiyatlarını tahmin eden bir karar ağacını ele alalım. Bu karar ağacının üç özellik kullandığını varsayalım: boyut, yaş ve stil. Üç özellik için değişken önem düzeyleri kümesi {size=5.8, age=2.5, style=4.7} olarak hesaplanırsa boyut, karar ağacı için yaş veya stilden daha önemlidir.

Farklı değişken önem metrikleri vardır. Bu metrikler, makine öğrenimi uzmanlarını modellerin farklı yönleri hakkında bilgilendirebilir.

W

kitlelerin bilgeliği

Büyük bir insan grubunun ("kalabalık") görüşlerinin veya tahminlerinin ortalamasını almanın genellikle şaşırtıcı derecede iyi sonuçlar verdiği fikri. Örneğin, büyük bir kavanoza doldurulmuş sakızlı şeker sayısını tahmin etmeye dayalı bir oyunu ele alalım. Tahminlerin çoğu yanlış olsa da tüm tahminlerin ortalamasının, kavanozdaki gerçek sakız sayısı ile şaşırtıcı derecede yakın olduğu deneysel olarak gösterilmiştir.

Topluluklar, topluluğun bilgeliğinin yazılımdaki karşılığıdır. Tek tek modeller çok yanlış tahminler yapsa bile birçok modelin tahminlerinin ortalaması genellikle şaşırtıcı derecede iyi tahminler üretir. Örneğin, tek bir karar ağacı kötü tahminler yapsa da karar ormanı genellikle çok iyi tahminler yapar.