Bu sayfa, Karar Ormanları sözlük terimlerini içerir. Tüm sözlük terimleri için burayı tıklayın.

CEVAP

özellik örnekleme

Her karar ağacının durumu öğrenirken yalnızca olası özelliklerin rastgele bir alt kümesini dikkate aldığı bir karar ormanı eğitme taktiği. Genellikle her düğüm için farklı bir özellik alt kümesi örneklenir. Öte yandan, özellik örnekleme olmadan bir karar ağacını eğitirken her düğüm için olası tüm özellikler dikkate alınır.

eksene ayarlı koşul

Karar ağacında yalnızca tek bir özellik içeren koşul. Örneğin, alan bir özellikse eksene hizalı bir koşul aşağıdaki gibidir:

area > 200

Eğik koşulla kontrast oluşturun.

B

bagaj hazırlama

Her bir bileşen modelin değiştirilerek örneklenmiş rastgele bir eğitim örneği alt kümesi üzerinde eğitildiği bir topluluğu eğitme yöntemi. Örneğin, rastgele orman, çuvallama ile eğitilmiş bir karar ağacı koleksiyonudur.

bagaj terimi, bootstrap aggregating kelimesinin kısaltmasıdır.

ikili koşul

Karar ağacında genellikle yes veya no olmak üzere yalnızca iki olası sonucu olan bir koşul. Örneğin, aşağıdaki ikili bir koşuldur:

temperature >= 100

İkili olmayan koşullarla zıtlık.

C

koşul

Karar ağacında, bir ifadeyi değerlendiren herhangi bir düğüm. Örneğin, karar ağacının aşağıdaki kısmı iki koşul içerir:

Koşula, bölünme veya test de denir.

Yaprak ile kontrast durumu.

Şuna da bakabilirsiniz:

- ikili koşul

- olmayan koşul olarak tanımlayabilirsiniz.

- eksen-hizalı-durumu

- eğik-durum

D

karar ormanı

Birden fazla karar ağacından oluşturulan bir model. Bir karar ormanı, karar ağaçlarından gelen tahminleri birleştirerek bir tahminde bulunur. Popüler karar ormanı türleri arasında rastgele ormanlar ve gradyan güçlendirilmiş ağaçlar bulunur.

karar ağacı

Bir dizi conditions ve conditions hiyerarşik olarak düzenlenmiş, gözetimli bir öğrenme modeli. Örneğin, aşağıda bir karar ağacı verilmiştir:

E

entropi

Bilgi teorisinde, olasılık dağılımının ne kadar öngörülemez olduğuna dair bir açıklamadır. Alternatif olarak entropi, her bir örneğin ne kadar bilgi içerdiği olarak da tanımlanır. Rastgele bir değişkenin tüm değerlerinin eşit olasılığa sahip olduğu durumlarda dağılım mümkün olan en yüksek entropiye sahip olur.

İki olası değere ("0" ve "1") sahip bir kümenin entropisi (örneğin, ikili sınıflandırma problemindeki etiketler) aşağıdaki formüle sahiptir:

H = -p log p - q log q = -p log p - (1-p) * log (1-p)

Bu örnekte:

- H, entropidir.

- p, "1" örneklerin oranıdır.

- q, "0" örneklerinin oranıdır. q = (1 - p) değerine dikkat edin.

- log, genellikle log2'dir. Bu örnekte entropi birimi biraz olsun.

Örneğin, aşağıdaki durumu varsayalım:

- "1" değerini içeren 100 örnek

- "0" değerini içeren 300 örnek

Bu durumda entropi değeri şöyle olur:

- k = 0,25

- q = 0,75

- H = (-0,25)log2(0,25) - (0,75)log2(0,75) = Örnek başına 0,81 bit

Tam dengeli bir kümenin (örneğin, 200 "0" ve 200 "1") entropisi örnek başına 1,0 bit olur. Bir küme daha dengesizleştiğinde entropi 0, 0'a doğru ilerler.

Karar ağaçlarında entropi, bilgi kazanımı oluşturarak sınıflandırma karar ağacının gelişimi sırasında bölen kişinin koşulları seçmesine yardımcı olur.

Entropiyi şununla karşılaştır:

- cinsiyetini bozulması

- entropiler arası kayıp fonksiyonu

Entropi genellikle Shannon entropisi olarak adlandırılır.

F

özelliğin önem düzeyi

Değişken önemler ile eş anlamlı.

G

cinsi saflık

Entropi'ye benzer bir metrik. Ayırıcılar, karar ağaçları için koşulları oluşturmak amacıyla gini bozulmasından veya entropiden türetilen değerleri kullanır. Bilgi edinme entropiden türetilir. Gini saflığından türetilen metrik için dünya genelinde kabul gören bir eşdeğer terim yoktur; ancak bu adsız metrik, en az bilgi kazancı kadar önemlidir.

Gini bozulması, gini endeksi veya kısaca gini olarak da adlandırılır.

gradyan artırılmış (karar) ağaçları (GBT)

Aşağıdakilerin içinde bulunduğu bir karar ormanı türü:

- Eğitim, gradyan artırmayı temel alır.

- Zayıf model karar ağacıdır.

gradyan artırma

Zayıf modellerin, güçlü bir modelin kalitesini yinelemeli olarak iyileştirmek (kaybı azaltmak) için eğitildiği bir eğitim algoritması. Örneğin, zayıf bir model, doğrusal veya küçük bir karar ağacı modeli olabilir. Güçlü model, önceden eğitilmiş tüm zayıf modellerin toplamı haline gelir.

En basit gradyan artırma biçiminde, her iterasyonda güçlü modelin kayıp gradyanını tahmin etmek için zayıf bir model eğitilir. Daha sonra, güçlü modelin çıkışı, gradyan azalmaya benzer şekilde tahmin edilen gradyan çıkarılarak güncellenir.

Bu örnekte:

- $F_{0}$ başlangıç için güçlü modeldir.

- $F_{i+1}$ bir sonraki güçlü model.

- $F_{i}$ şu anki güçlü modeldir.

- $\xi$, 0,0 ile 1,0 arasında bir değerdir ve daraltma olarak adlandırılır. Bu, gradyan inişteki öğrenme hızına benzer.

- $f_{i}$, $F_{i}$ tutarındaki kayıp gradyanını tahmin etmek için eğitilmiş zayıf modeldir.

Gradyan güçlendirmenin modern varyasyonları, hesaplamalarında kaybın ikinci türevini (Hessian) da içerir.

Karar ağaçları, gradyan artırma işleminde genellikle zayıf modeller olarak kullanılır. Renk geçişi artırılmış (karar) ağaçları konusuna bakın.

İ

çıkarım yolu

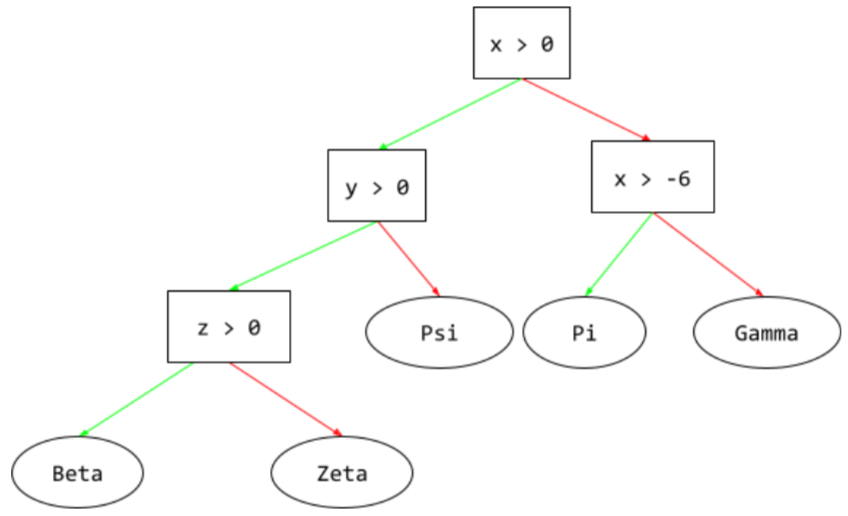

Bir karar ağacında, çıkarım sırasında belirli bir örneğin kökten diğer koşullara giden ve bir yaprak ile sonlandırılan rota. Örneğin, aşağıdaki karar ağacındaki daha kalın oklar, aşağıdaki özellik değerlerine sahip bir örnek için çıkarım yolunu gösterir:

- x = 7

- y = 12

- z = -3

Aşağıdaki çizimde gösterilen çıkarım yolu, yaprağa (Zeta) ulaşmadan önce üç koşuldan geçer.

Çıkarım yolunu gösteren üç kalın ok.

bilgi kazancı

Karar ormanlarında, bir düğümün entropisi ile alt düğümlerinin entropisinin ağırlıklı (örnek sayısına göre) toplamı arasındaki fark. Bir düğümün entropisi, o düğümdeki örneklerin entropisidir.

Örneğin, aşağıdaki entropi değerlerini dikkate alın:

- üst düğümün entropisi = 0,6

- 16 ilgili örnekle birlikte bir alt düğümün entropisi = 0,2

- 24 ilgili örnekle birlikte başka bir alt düğümün entropisi = 0,1

Dolayısıyla, örneklerin% 40'ı bir alt düğümde, %60'ı ise diğer bir alt düğümdedir. Bu nedenle:

- alt düğümlerin ağırlıklı entropi toplamı = (0,4 * 0,2) + (0,6 * 0,1) = 0,14

Bu durumda, elde edilecek bilgi şudur:

- bilgi kazancı = üst düğümün entropisi - alt düğümlerin ağırlıklı entropi toplamı

- bilgi kazancı = 0,6 - 0,14 = 0,46

Çoğu bölücü, bilgi kazancını en üst düzeye çıkaran koşullar oluşturmaya çalışır.

belirlenen koşul

Karar ağacında, bir öğe grubundaki bir öğenin varlığını test eden bir koşul. Örneğin, aşağıda belirtilmiş bir koşul gösterilmektedir:

house-style in [tudor, colonial, cape]

Çıkarım sırasında ev stili özellik değeri tudor, colonial veya cape olursa bu koşul Evet olarak değerlendirilir. Ev tarzı özelliğin değeri başka bir şeyse (örneğin, ranch) bu koşul Hayır olarak değerlendirilir.

Ayarlanmış koşullar, genellikle tek sıcak kodlanmış özellikleri test eden koşullardan daha verimli karar ağaçları sağlar.

L

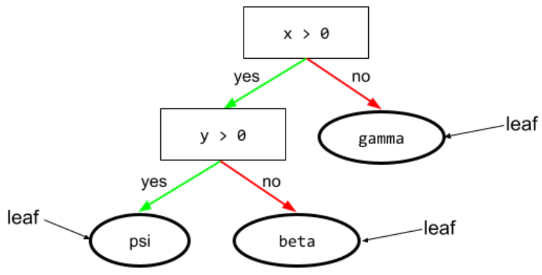

yaprak

Karar ağacındaki herhangi bir uç nokta. Koşul'un aksine, yaprak test yapmaz. Daha ziyade, yaprak olası bir tahmindir. Yaprak aynı zamanda çıkarım yolunun terminal düğümüdür.

Örneğin, aşağıdaki karar ağacı üç yaprak içerir:

N

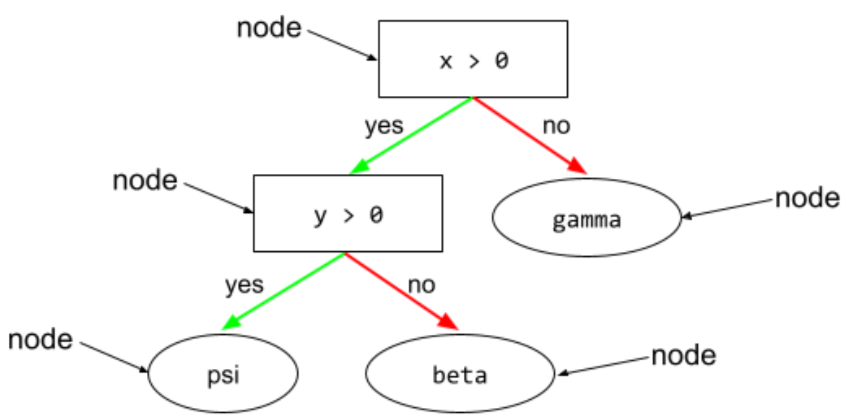

düğüm (karar ağacı)

Karar ağacında herhangi bir durum veya yaprak.

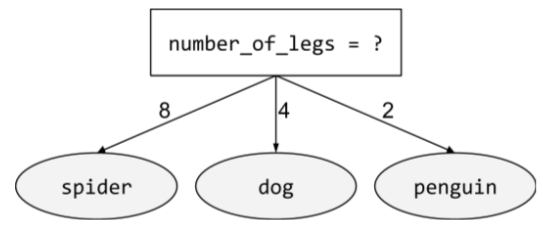

ikilik olmayan koşul

İkiden fazla olası sonuç içeren koşul. Örneğin, aşağıdaki "binary" olmayan koşul üç olası sonuç içerir:

O

eğik durum

Karar ağacında birden fazla özellik içeren bir koşul. Örneğin, yükseklik ve genişliğin her ikisi de özellik ise eğik bir koşuldur:

height > width

Eksene hizalı koşul ile kontrast oluşturun.

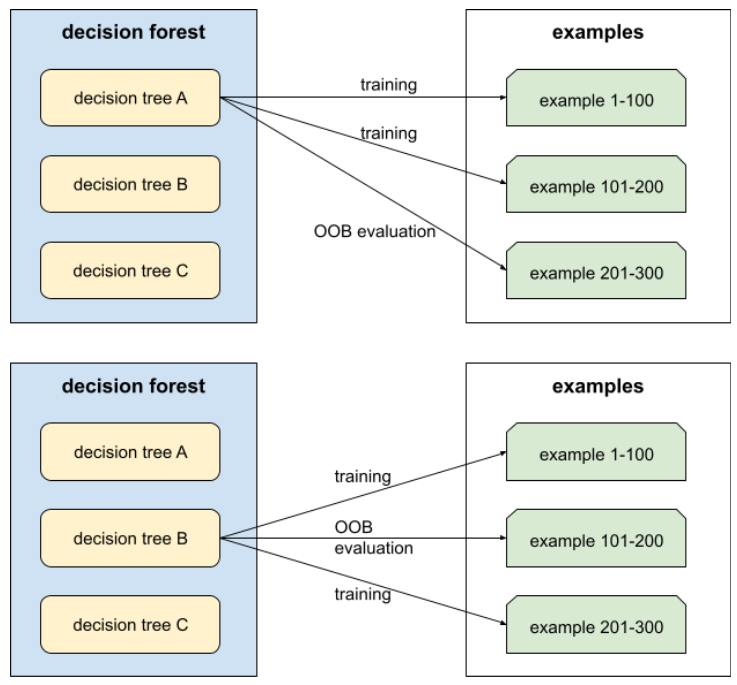

paket dışı değerlendirmesi (OOB değerlendirmesi)

Her bir karar ağacının kalitesini, söz konusu karar ağacının eğitimi sırasında kullanılmayan örneklere göre test ederek karar ormanının kalitesini değerlendirmek için kullanılan mekanizma. Örneğin, aşağıdaki şemada, sistemin her bir karar ağacını örneklerin yaklaşık üçte ikisi üzerinde eğittiğine ve daha sonra kalan örneklerin üçte birine göre değerlendirme yaptığına dikkat edin.

Paket dışı değerlendirmesi, çapraz doğrulama mekanizmasının işlem açısından verimli ve konservatif bir tahminidir. Çapraz doğrulamada, her çapraz doğrulama turu için bir model eğitilir (örneğin, 10 model 10 katlı çapraz doğrulama için eğitilir). OOB değerlendirmesiyle tek bir model eğitilir. bagaj, eğitim sırasında her ağaçtan bazı verileri sakladığından OOB değerlendirmesi, çapraz doğrulamayı yaklaşık olarak belirlemek için bu verileri kullanabilir.

P

permütasyon değişkeni önemleri

Özelliğin değerlerini permüt ettikten sonra bir modelin tahmin hatasındaki artışı değerlendiren bir değişken önem türü. Permütasyon değişkeninin önem düzeyi, modelden bağımsız bir metriktir.

R

Rastgele Orman

Her bir karar ağacının çuvallama gibi belirli bir rastgele gürültüyle eğitildiği bir karar ağaçları grubu.

Rastgele ormanlar bir karar ormanı türüdür.

kök

Bir karar ağacındaki başlangıç düğümü (ilk koşul). Geleneksel olarak, diyagramlarda kökü karar ağacının en tepesine yerleştirilir. Örneğin:

S

değiştirilerek örnekleme

Aynı öğenin birden çok kez seçilebildiği bir aday öğe grubundan öğe seçme yöntemi. "Değiştirilmiş" ifadesi, her seçimden sonra, seçilen öğenin aday öğeler havuzuna döndürüleceği anlamına gelir. Ters yöntem olan değiştirmeden örnekleme, bir aday öğenin yalnızca bir kez seçilebileceği anlamına gelir.

Örneğin, aşağıdaki meyve kümesini ele alalım:

fruit = {kiwi, apple, pear, fig, cherry, lime, mango}

Sistemin fig öğesini ilk öğe olarak rastgele seçtiğini varsayalım.

Yerine örnekleme yöntemiyle örnekleme kullanılıyorsa sistem, aşağıdaki kümeden ikinci öğeyi seçer:

fruit = {kiwi, apple, pear, fig, cherry, lime, mango}

Evet, bu önceki kümeyle aynıdır. Bu nedenle sistem, potansiyel olarak fig öğesini tekrar seçebilir.

Değiştirmeden örnekleme kullanılıyorsa bir numune tekrar seçilemez. Örneğin, sistem ilk örnek olarak rastgele fig seçerse fig tekrar seçilemez. Bu nedenle, sistem aşağıdaki (azaltılmış) kümeden ikinci örneği seçer:

fruit = {kiwi, apple, pear, cherry, lime, mango}

küçülme

Aşırı uyumu kontrol eden, gradyan artırma özelliğinde bir hiperparametre. Gradyan artırmadaki küçülme, gradyan inişindeki öğrenme hızına benzer. Daraltma, 0,0 ile 1,0 arasında ondalık bir değerdir. Daha düşük bir çekme değeri, fazla eşleşmeyi daha büyük bir daraltma değerinden daha fazla azaltır.

split

Karar ağacında, koşul için başka bir addır.

ayırıcı

Bir karar ağacı eğitilirken her bir düğümde en iyi koşulu bulmaktan sorumlu rutin (ve algoritma).

T

test

Karar ağacında, koşul için başka bir addır.

eşik (karar ağaçları için)

Eksene hizalı koşulda, bir özelliğin karşılaştırılmakta olduğu değerdir. Örneğin, aşağıdaki koşulda 75 eşik değeridir:

grade >= 75

V

değişken önemler

Her özelliğin model için göreceli önemini belirten puanlar.

Örneğin, ev fiyatlarını tahmin eden bir karar ağacını ele alalım. Bu karar ağacının üç özellik kullandığını varsayalım: boyut, yaş ve stil. Üç özellik için bir dizi değişkenin önem derecesi {size=5.8, age=2.5, style=4.7} şeklinde hesaplanırsa, karar ağacında yaş veya stilden ziyade boyut önemlidir.

Makine öğrenimi uzmanlarına modellerin farklı yönleri hakkında bilgi verebilecek farklı değişken önem metrikleri vardır.

W

kalabalığın bilgeliği

Büyük bir insan grubunun ("kalabalık") fikirlerinin veya tahminlerinin ortalamasını almanın şaşırtıcı derecede iyi sonuçlar sağladığı fikri. Örneğin, insanların büyük bir kavanozdaki jelibon sayısını tahmin ettiği bir oyun düşünün. Çoğu bireysel tahmin yanlış olsa da, tüm tahminlerin ortalamasının kavanozdaki gerçek jelibon sayısına şaşırtıcı bir şekilde yakın olduğu gözlemlenmiştir.

Ensembles kalabalıkların bilgeliğinin yazılım analogudur. Bağımsız modeller son derece yanlış tahminler yapsa bile birçok modelin tahminlerinin ortalaması genellikle şaşırtıcı derecede iyi tahminler oluşturur. Örneğin, tek bir karar ağacı kötü tahminlerde bulunsa da bir karar ormanı genellikle çok iyi tahminlerde bulunur.