En esta página, se incluyen términos del glosario de la IA generativa. Para consultar todos los términos del glosario, haz clic aquí.

A

adaptación

Sinónimo de ajuste o ajuste fino.

agente

Software que puede razonar sobre las entradas multimodales del usuario para planificar y ejecutar acciones en nombre del usuario.

En el aprendizaje por refuerzo, un agente es la entidad que usa una política para maximizar el retorno esperado que se obtiene de la transición entre los estados del entorno.

agéntico/agéntica

Forma adjetiva de agente. El término "agéntico" se refiere a las cualidades que poseen los agentes (como la autonomía).

flujo de trabajo de agentes

Es un proceso dinámico en el que un agente planifica y ejecuta acciones de forma autónoma para lograr un objetivo. El proceso puede implicar razonamiento, invocar herramientas externas y corregir su plan por sí mismo.

Margen de error de la IA

Es el resultado de un sistema de IA generativa que prioriza la cantidad por sobre la calidad. Por ejemplo, una página web con pendiente de IA está repleta de contenido de baja calidad, generado por IA y producido de forma económica.

evaluación automática

Usar software para juzgar la calidad del resultado de un modelo

Cuando el resultado del modelo es relativamente sencillo, una secuencia de comandos o un programa pueden comparar el resultado del modelo con una respuesta ideal. A veces, este tipo de evaluación automática se denomina evaluación programática. Las métricas como ROUGE o BLEU suelen ser útiles para la evaluación programática.

Cuando el resultado del modelo es complejo o no tiene una respuesta correcta, a veces, un programa de AA independiente llamado calificador automático realiza la evaluación automática.

Compara esto con la evaluación humana.

Evaluación del evaluador automático

Es un mecanismo híbrido para juzgar la calidad del resultado de un modelo de IA generativa que combina la evaluación humana con la evaluación automática. Un evaluador automático es un modelo de AA entrenado con datos creados por la evaluación humana. Lo ideal es que un autor aprenda a imitar a un evaluador humano.Hay autorraters prediseñados disponibles, pero los mejores se ajustan específicamente para la tarea que evalúas.

Modelo autorregresivo

Un modelo que infiere una predicción en función de sus propias predicciones anteriores. Por ejemplo, los modelos de lenguaje autorregresivos predicen el siguiente token en función de los tokens predichos anteriormente. Todos los modelos de lenguaje grandes basados en Transformer son de regresión automática.

En cambio, los modelos de imágenes basados en GAN no suelen ser autorregresivos, ya que generan una imagen en un solo pase hacia adelante y no de forma iterativa en pasos. Sin embargo, ciertos modelos de generación de imágenes son autorregresivos porque generan una imagen en pasos.

B

modelo base

Un modelo previamente entrenado que puede servir como punto de partida para el ajuste para abordar tareas o aplicaciones específicas

Consulta también modelo previamente entrenado y modelo fundamental.

C

Cadena de pensamientos

Una técnica de ingeniería de instrucciones que alienta a un modelo de lenguaje grande (LLM) a explicar su razonamiento paso a paso. Por ejemplo, considera la siguiente instrucción, y presta especial atención a la segunda oración:

¿Cuántas fuerzas G experimentaría un conductor en un automóvil que va de 0 a 60 millas por hora en 7 segundos? En la respuesta, muestra todos los cálculos pertinentes.

Es probable que la respuesta del LLM haga lo siguiente:

- Muestra una secuencia de fórmulas físicas, reemplazando los valores 0, 60 y 7 en los lugares correspondientes.

- Explica por qué eligió esas fórmulas y qué significan las distintas variables.

La instrucción de cadena de pensamientos obliga al LLM a realizar todos los cálculos, lo que podría generar una respuesta más correcta. Además, las instrucciones de encadenamiento de pensamiento permiten que el usuario examine los pasos del LLM para determinar si la respuesta tiene sentido.

chat

Contenido de un diálogo bidireccional con un sistema de AA, por lo general, un modelo de lenguaje grande. La interacción anterior en un chat (lo que escribiste y cómo respondió el modelo de lenguaje grande) se convierte en el contexto para las partes posteriores del chat.

Un chatbot es una aplicación de un modelo de lenguaje grande.

embedding de lenguaje contextualizado

Un embedding que se acerca a "comprender" palabras y frases de formas en que pueden hacerlo los hablantes humanos fluidos. Las incorporaciones de lenguaje contextualizadas pueden comprender la sintaxis, la semántica y el contexto complejos.

Por ejemplo, considera las incorporaciones de la palabra en inglés cow (vaca). Las incorporaciones más antiguas, como word2vec, pueden representar palabras en inglés de modo que la distancia en el espacio de incorporación de vaca a toro sea similar a la distancia de oveja (oveja hembra) a carnero (oveja macho) o de mujer a hombre. Las incorporaciones de lenguaje contextualizadas pueden ir un paso más allá y reconocer que los angloparlantes a veces usan la palabra cow de manera informal para referirse a una vaca o a un toro.

ventana de contexto

Es la cantidad de tokens que un modelo puede procesar en una instrucción determinada. Cuanto más grande sea la ventana de contexto, más información podrá usar el modelo para proporcionar respuestas coherentes y uniformes a la instrucción.

Programación conversacional

Es un diálogo iterativo entre tú y un modelo de IA generativa con el propósito de crear software. Emite una instrucción que describe algún software. Luego, el modelo usa esa descripción para generar código. Luego, emites una nueva instrucción para abordar las fallas de la instrucción anterior o del código generado, y el modelo genera código actualizado. Ambos siguen intercambiando ideas hasta que el software generado es lo suficientemente bueno.

El codificado de conversaciones es, en esencia, el significado original de vibe coding.

Compara esto con la codificación especificacional.

D

Instrucción directa

Sinónimo de instrucción sin ejemplos.

destilación

Proceso de reducir el tamaño de un modelo (conocido como profesor) en un modelo más pequeño (conocido como estudiante) que emula las predicciones del modelo original con la mayor fidelidad posible. La destilación es útil porque el modelo más pequeño tiene dos beneficios clave en comparación con el modelo más grande (el profesor):

- Tiempo de inferencia más rápido

- Menor uso de memoria y energía

Sin embargo, las predicciones del estudiante no suelen ser tan buenas como las del profesor.

La destilación entrena al modelo estudiante para minimizar una función de pérdida basada en la diferencia entre los resultados de las predicciones de los modelos estudiante y profesor.

Compara y contrasta la destilación con los siguientes términos:

Consulta LLMs: Ajuste, destilación y diseño de instrucciones en el Curso intensivo de aprendizaje automático para obtener más información.

E

evals

Se usa principalmente como abreviatura de evaluaciones de LLM. En términos más generales, evals es la abreviatura de cualquier forma de evaluación.

sin conexión

Proceso para medir la calidad de un modelo o comparar diferentes modelos entre sí.

Para evaluar un modelo de aprendizaje automático supervisado, por lo general, lo comparas con un conjunto de validación y un conjunto de prueba. Evaluar un LLM suele implicar evaluaciones más amplias de calidad y seguridad.

F

Facticidad

En el mundo del AA, una propiedad que describe un modelo cuya salida se basa en la realidad. La facticidad es un concepto, no una métrica. Por ejemplo, supongamos que envías la siguiente instrucción a un modelo de lenguaje grande:

¿Cuál es la fórmula química de la sal de mesa?

Un modelo que optimice la facticidad respondería de la siguiente manera:

NaCl

Es tentador suponer que todos los modelos deben basarse en la facticidad. Sin embargo, algunas instrucciones, como las siguientes, deberían hacer que un modelo de IA generativa optimice la creatividad en lugar de la factualidad.

Cuéntame un limerick sobre un astronauta y una oruga.

Es poco probable que la limerick resultante se base en la realidad.

Compara esto con la fundamentación.

Decaimiento rápido

Técnica de entrenamiento para mejorar el rendimiento de los LLM La disminución rápida implica reducir rápidamente la tasa de aprendizaje durante el entrenamiento. Esta estrategia ayuda a evitar que el modelo se sobreajuste a los datos de entrenamiento y mejora la generalización.

Instrucción con varios ejemplos

Un prompt que contiene más de un ejemplo (algunos) que demuestran cómo debe responder el modelo de lenguaje extenso. Por ejemplo, la siguiente instrucción extensa contiene dos ejemplos que muestran a un modelo de lenguaje grande cómo responder una búsqueda.

| Partes de una instrucción | Notas |

|---|---|

| ¿Cuál es la moneda oficial del país especificado? | La pregunta que quieres que responda el LLM. |

| Francia: EUR | Veamos un ejemplo. |

| Reino Unido: GBP | Otro ejemplo. |

| India: | Es la búsqueda real. |

En general, las instrucciones con pocos ejemplos producen resultados más deseables que las instrucciones sin ejemplos y las instrucciones con un solo ejemplo. Sin embargo, las instrucciones con varios ejemplos requieren una instrucción más extensa.

La instrucción con ejemplos limitados es una forma de aprendizaje en pocos intentos que se aplica al aprendizaje basado en instrucciones.

Consulta Ingeniería de instrucciones en el Curso intensivo de aprendizaje automático para obtener más información.

Ajuste

Es un segundo paso de entrenamiento específico para la tarea que se realiza en un modelo previamente entrenado para ajustar sus parámetros para un caso de uso específico. Por ejemplo, la secuencia de entrenamiento completa para algunos modelos de lenguaje grandes es la siguiente:

- Preentrenamiento: Entrena un modelo de lenguaje grande con un vasto conjunto de datos generales, como todas las páginas de Wikipedia en inglés.

- Ajuste: Entrena el modelo previamente entrenado para realizar una tarea específica, como responder preguntas médicas. Por lo general, el ajuste implica cientos o miles de ejemplos enfocados en la tarea específica.

Como otro ejemplo, la secuencia de entrenamiento completa para un modelo de imágenes grande es la siguiente:

- Entrenamiento previo: Entrena un modelo de imágenes grande en un vasto conjunto de datos de imágenes generales, como todas las imágenes de Wikimedia Commons.

- Ajuste: Entrena el modelo previamente entrenado para realizar una tarea específica, como generar imágenes de orcas.

El ajuste puede implicar cualquier combinación de las siguientes estrategias:

- Modifica todos los parámetros existentes del modelo entrenado previamente. A veces, esto se denomina ajuste fino completo.

- Modificar solo algunos de los parámetros existentes del modelo entrenado previamente (por lo general, las capas más cercanas a la capa de salida), mientras se mantienen sin cambios otros parámetros existentes (por lo general, las capas más cercanas a la capa de entrada). Consulta ajuste eficiente de parámetros.

- Se agregan más capas, por lo general, sobre las capas existentes más cercanas a la capa de salida.

El ajuste es una forma de aprendizaje por transferencia. Por lo tanto, el ajuste puede usar una función de pérdida o un tipo de modelo diferente de los que se usan para entrenar el modelo previamente entrenado. Por ejemplo, podrías ajustar un modelo de imágenes grandes previamente entrenado para producir un modelo de regresión que devuelva la cantidad de aves en una imagen de entrada.

Compara y contrasta el ajuste fino con los siguientes términos:

Consulta Ajuste fino en el Curso intensivo de aprendizaje automático para obtener más información.

Modelo de flash

Una familia de modelos Gemini relativamente pequeños y optimizados para la velocidad y la baja latencia. Los modelos Flash están diseñados para una amplia variedad de aplicaciones en las que las respuestas rápidas y la alta capacidad de procesamiento son fundamentales.

modelo de base

Un modelo previamente entrenado muy grande entrenado con un conjunto de entrenamiento enorme y diverso. Un modelo de base puede hacer lo siguiente:

- Responder bien a una amplia variedad de solicitudes

- Sirven como modelo base para ajustes adicionales o cualquier otra personalización.

En otras palabras, un modelo de base ya es muy capaz en un sentido general, pero se puede personalizar aún más para que sea más útil para una tarea específica.

fracción de éxitos

Es una métrica para evaluar el texto generado de un modelo de AA. La fracción de éxitos es la cantidad de resultados de texto generados "correctos" dividida por la cantidad total de resultados de texto generados. Por ejemplo, si un modelo de lenguaje grande generó 10 bloques de código, de los cuales cinco fueron exitosos, la fracción de éxitos sería del 50%.

Si bien la fracción de éxitos es útil en general en todas las estadísticas, en el AA, esta métrica es principalmente útil para medir tareas verificables, como la generación de código o los problemas matemáticos.

G

Gemini

El ecosistema que comprende la IA más avanzada de Google. Los elementos de este ecosistema incluyen lo siguiente:

- Varios modelos de Gemini

- Es la interfaz conversacional interactiva para un modelo de Gemini. Los usuarios escriben instrucciones y Gemini responde a ellas.

- Varias APIs de Gemini

- Varios productos empresariales basados en modelos de Gemini, por ejemplo, Gemini para Google Cloud.

Modelos de Gemini

Modelos multimodales de última generación basados en Transformer de Google. Los modelos de Gemini están diseñados específicamente para integrarse con agentes.

Los usuarios pueden interactuar con los modelos de Gemini de diversas maneras, como a través de una interfaz de diálogo interactiva y de SDKs.

Gemma

Una familia de modelos abiertos y ligeros creados a partir de la misma investigación y tecnología que se utilizaron para crear los modelos de Gemini. Hay varios modelos de Gemma disponibles, cada uno con diferentes funciones, como visión, código y seguimiento de instrucciones. Consulta Gemma para obtener más información.

IA generativa o IAgenerativa

Abreviatura de IA generativa.

Texto generado

En general, es el texto que genera un modelo de AA. Cuando se evalúan modelos de lenguaje grandes, algunas métricas comparan el texto generado con el texto de referencia. Por ejemplo, supongamos que intentas determinar la eficacia con la que un modelo de AA traduce del francés al neerlandés. En este caso, ocurre lo siguiente:

- El texto generado es la traducción al neerlandés que genera el modelo de AA.

- El texto de referencia es la traducción al neerlandés que crea un traductor humano (o un software).

Ten en cuenta que algunas estrategias de evaluación no incluyen texto de referencia.

IA generativa

Es un campo transformador emergente sin una definición formal. Dicho esto, la mayoría de los expertos coinciden en que los modelos de IA generativa pueden crear ("generar") contenido que cumpla con todos los siguientes requisitos:

- emergencia compleja,

- coherente

- original

Estos son algunos ejemplos de IA generativa:

- Modelos de lenguaje grandes, que pueden generar texto original sofisticado y responder preguntas

- Modelo de generación de imágenes, que puede producir imágenes únicas.

- Modelos de generación de audio y música, que pueden componer música original o generar voz realista.

- Modelos de generación de video, que pueden generar videos originales.

Algunas tecnologías anteriores, como las LSTM y las RNN, también pueden generar contenido original y coherente. Algunos expertos consideran que estas tecnologías anteriores son IA generativa, mientras que otros creen que la verdadera IA generativa requiere resultados más complejos de los que pueden producir esas tecnologías anteriores.

Compara esto con el AA predictivo.

Respuesta dorada

Una respuesta que se sabe que es buena. Por ejemplo, dada la siguiente instrucción:

2 + 2

La respuesta ideal es la siguiente:

4

GPT (transformador generativo previamente entrenado)

Una familia de modelos de lenguaje grandes basados en Transformer desarrollados por OpenAI.

Las variantes de GPT se pueden aplicar a múltiples modalidades, incluidas las siguientes:

- Generación de imágenes (por ejemplo, ImageGPT)

- Generación de texto a imagen (por ejemplo, DALL-E)

H

alucinación

Producción de resultados que parecen plausibles, pero que son incorrectos desde el punto de vista fáctico por parte de un modelo de IA generativa que pretende hacer una afirmación sobre el mundo real. Por ejemplo, un modelo de IA generativa que afirma que Barack Obama murió en 1865 está alucinando.

evaluación humana

Proceso en el que personas juzgan la calidad del resultado de un modelo de AA; por ejemplo, personas bilingües que juzgan la calidad de un modelo de traducción de AA. La evaluación humana es especialmente útil para juzgar modelos que no tienen una respuesta correcta.

Compara esto con la evaluación automática y la evaluación del autorrater.

con interacción humana (HITL)

Es una expresión idiomática definida de forma vaga que podría significar cualquiera de las siguientes opciones:

- Una política de visualización del resultado de la IA generativa de forma crítica o escéptica

- Es una estrategia o un sistema para garantizar que las personas ayuden a dar forma, evaluar y perfeccionar el comportamiento de un modelo. Mantener a un humano en el circuito permite que la IA se beneficie tanto de la inteligencia artificial como de la humana. Por ejemplo, un sistema en el que una IA genera código que luego revisan los ingenieros de software es un sistema con participación humana.

I

aprendizaje en contexto

Sinónimo de instrucciones con ejemplos limitados.

Inferencia

En el aprendizaje automático tradicional, el proceso de realizar predicciones aplicando un modelo entrenado a ejemplos sin etiqueta. Consulta Aprendizaje supervisado en el curso Introducción al AA para obtener más información.

En los modelos de lenguaje grandes, la inferencia es el proceso de usar un modelo entrenado para generar una respuesta a una instrucción de entrada.

En estadística, la inferencia tiene un significado algo diferente. Consulta el artículo de Wikipedia sobre inferencia estadística para obtener más detalles.

Ajuste de instrucciones

Es una forma de ajuste que mejora la capacidad de un modelo de IA generativa para seguir instrucciones. El ajuste de instrucciones implica entrenar un modelo en una serie de instrucciones, que suelen abarcar una amplia variedad de tareas. Luego, el modelo ajustado con instrucciones tiende a generar respuestas útiles a instrucciones sin ejemplos en una variedad de tareas.

Comparar y contrastar con lo siguiente:

L

modelo de lenguaje grande

Como mínimo, un modelo de lenguaje que tenga una gran cantidad de parámetros. De manera más informal, cualquier modelo de lenguaje basado en Transformer, como Gemini o GPT.

Consulta Modelos de lenguaje grandes (LLM) en el Curso intensivo de aprendizaje automático para obtener más información.

latencia

Es el tiempo que tarda un modelo en procesar la entrada y generar una respuesta. Una respuesta de latencia alta tarda más en generarse que una respuesta de latencia baja.

Entre los factores que influyen en la latencia de los modelos de lenguaje grandes, se incluyen los siguientes:

- Longitudes de los tokens de entrada y salida

- Complejidad del modelo

- La infraestructura en la que se ejecuta el modelo

La optimización de la latencia es fundamental para crear aplicaciones responsivas y fáciles de usar.

LLM

Abreviatura de modelo de lenguaje grande.

Evaluaciones de LLM

Es un conjunto de métricas y comparativas para evaluar el rendimiento de los modelos de lenguaje grandes (LLM). A un alto nivel, las evaluaciones de LLM hacen lo siguiente:

- Ayudar a los investigadores a identificar áreas en las que los LLM necesitan mejorar

- Son útiles para comparar diferentes LLM y determinar cuál es el mejor para una tarea en particular.

- Ayudar a garantizar que los LLMs sean seguros y éticos para su uso

Consulta Modelos de lenguaje extenso (LLM) en el Curso intensivo de aprendizaje automático para obtener más información.

Laura

Abreviatura de Low-Rank Adaptability.

Adaptación de clasificación baja (LoRA)

Es una técnica eficiente en cuanto a parámetros para el ajuste que "congela" los pesos entrenados previamente del modelo (de modo que ya no se puedan modificar) y, luego, inserta un pequeño conjunto de pesos entrenables en el modelo. Este conjunto de pesos entrenables (también conocido como "matrices de actualización") es considerablemente más pequeño que el modelo base y, por lo tanto, se entrena mucho más rápido.

LoRA proporciona los siguientes beneficios:

- Mejora la calidad de las predicciones de un modelo para el dominio en el que se aplica el ajuste.

- Se ajusta con mayor rapidez que las técnicas que requieren el ajuste de todos los parámetros de un modelo.

- Reduce el costo de procesamiento de la inferencia, ya que permite la entrega simultánea de varios modelos especializados que comparten el mismo modelo base.

M

traducción automática

Uso de software (por lo general, un modelo de aprendizaje automático) para convertir texto de un idioma humano a otro, por ejemplo, de inglés a japonés.

Precisión media en k (mAP@k)

Es la media estadística de todas las puntuaciones de precisión promedio en k en un conjunto de datos de validación. Un uso de la precisión media promedio en k es evaluar la calidad de las recomendaciones que genera un sistema de recomendación.

Aunque la frase "promedio medio" suena redundante, el nombre de la métrica es apropiado. Después de todo, esta métrica encuentra la media de varios valores de precisión promedio en k.

Mezcla de expertos

Es un esquema para aumentar la eficiencia de la red neuronal usando solo un subconjunto de sus parámetros (conocido como experto) para procesar un token o un ejemplo determinados. Una red de selección dirige cada token o ejemplo de entrada a los expertos adecuados.

Para obtener más detalles, consulta cualquiera de los siguientes documentos:

- Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer (Redes neuronales increíblemente grandes: la capa de mezcla de expertos con puerta dispersa)

- Mixture-of-Experts with Expert Choice Routing

MMIT

Abreviatura de ajuste de instrucciones multimodal.

Cascada de modelos

Es un sistema que elige el modelo ideal para una consulta de inferencia específica.

Imagina un grupo de modelos, desde muy grandes (con muchos parámetros) hasta mucho más pequeños (con muchos menos parámetros). Los modelos muy grandes consumen más recursos de procesamiento en el momento de la inferencia que los modelos más pequeños. Sin embargo, los modelos muy grandes suelen poder inferir solicitudes más complejas que los modelos más pequeños. El encadenamiento de modelos determina la complejidad de la consulta de inferencia y, luego, elige el modelo adecuado para realizar la inferencia. La principal motivación para la cascada de modelos es reducir los costos de inferencia seleccionando, en general, modelos más pequeños y solo seleccionando un modelo más grande para las búsquedas más complejas.

Imagina que un modelo pequeño se ejecuta en un teléfono y una versión más grande de ese modelo se ejecuta en un servidor remoto. La buena cascada de modelos reduce el costo y la latencia, ya que permite que el modelo más pequeño controle las solicitudes simples y solo llame al modelo remoto para controlar las solicitudes complejas.

Consulta también enrutador de modelos.

router de modelo

Es el algoritmo que determina el modelo ideal para la inferencia en la cascada de modelos. Un router de modelos suele ser un modelo de aprendizaje automático que aprende de forma gradual a elegir el mejor modelo para una entrada determinada. Sin embargo, un router de modelos a veces podría ser un algoritmo más simple que no utilice aprendizaje automático.

MOE

Abreviatura de mezcla de expertos.

MT

Abreviatura de traducción automática.

N

Nano

Un modelo de Gemini relativamente pequeño diseñado para usarse en el dispositivo. Consulta Gemini Nano para obtener más detalles.

Sin una respuesta correcta (NORA)

Una instrucción que tiene varias respuestas correctas Por ejemplo, la siguiente instrucción no tiene una respuesta correcta:

Cuéntame un chiste divertido sobre elefantes.

Evaluar las respuestas a las instrucciones que no tienen una respuesta correcta suele ser mucho más subjetivo que evaluar las instrucciones con una respuesta correcta. Por ejemplo, evaluar un chiste sobre elefantes requiere una forma sistemática de determinar qué tan gracioso es.

NORA

Abreviatura de no hay una sola respuesta correcta.

NotebookLM

Es una herramienta basada en Gemini que permite a los usuarios subir documentos y, luego, usar instrucciones para hacer preguntas sobre esos documentos, resumirlos u organizarlos. Por ejemplo, un autor podría subir varios cuentos y pedirle a NotebookLM que encuentre los temas comunes o que identifique cuál sería la mejor película.

O

Una respuesta correcta (ORA)

Una instrucción que tiene una sola respuesta correcta. Por ejemplo, considera la siguiente instrucción:

Verdadero o falso: Saturno es más grande que Marte.

La única respuesta correcta es verdadero.

Contrasta con no hay una respuesta correcta.

Instrucción con un solo ejemplo

Una instrucción que contiene un ejemplo que demuestra cómo debería responder el modelo de lenguaje grande. Por ejemplo, la siguiente instrucción contiene un ejemplo que muestra a un modelo de lenguaje grande cómo debe responder una búsqueda.

| Partes de una instrucción | Notas |

|---|---|

| ¿Cuál es la moneda oficial del país especificado? | La pregunta que quieres que responda el LLM. |

| Francia: EUR | Veamos un ejemplo. |

| India: | Es la búsqueda real. |

Compara y contrasta el one-shot prompting con los siguientes términos:

ORA

Abreviatura de una respuesta correcta.

P

Ajuste eficiente de parámetros

Es un conjunto de técnicas para ajustar un modelo de lenguaje entrenado previamente (PLM) grande de manera más eficiente que el ajuste completo. Por lo general, el ajuste eficiente de parámetros ajusta muchos menos parámetros que el ajuste completo, pero, aun así, produce un modelo de lenguaje extenso que funciona tan bien (o casi tan bien) como un modelo de lenguaje extenso creado a partir del ajuste completo.

Compara y contrasta el ajuste eficiente de parámetros con lo siguiente:

El ajuste eficiente de parámetros también se conoce como ajuste eficiente de parámetros.

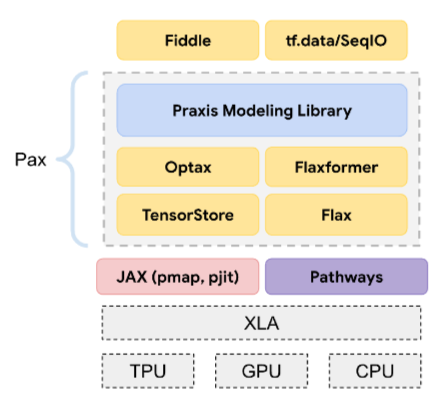

Pax

Es un framework de programación diseñado para entrenar modelos de redes neuronales a gran escala, tan grandes que abarcan varias porciones o pods de chips aceleradores de TPU.

Pax se basa en Flax, que se basa en JAX.

PLM

Abreviatura de modelo de lenguaje previamente entrenado.

modelo entrenado posteriormente

Término definido de forma imprecisa que suele hacer referencia a un modelo previamente entrenado que se sometió a algún procesamiento posterior, como uno o más de los siguientes:

modelo previamente entrenado

Si bien este término podría referirse a cualquier modelo o vector de embedding entrenado, ahora se suele referir a un modelo de lenguaje grande entrenado o a otro tipo de modelo de IA generativa entrenado.

Consulta también modelo base y modelo de base.

autosupervisado

El entrenamiento inicial de un modelo en un conjunto de datos grande Algunos modelos entrenados previamente son gigantes torpes y, por lo general, deben perfeccionarse con entrenamiento adicional. Por ejemplo, los expertos en AA podrían entrenar previamente un modelo de lenguaje grande con un vasto conjunto de datos de texto, como todas las páginas en inglés de Wikipedia. Después del entrenamiento previo, el modelo resultante se puede refinar aún más con cualquiera de las siguientes técnicas:

Pro

Un modelo de Gemini con menos parámetros que Ultra, pero más que Nano. Consulta Gemini Pro para obtener más información.

instrucción

Cualquier texto que se ingresa como entrada en un modelo de lenguaje grande para condicionar el modelo y que se comporte de una manera determinada. Las instrucciones pueden ser tan cortas como una frase o tan largas como se desee (por ejemplo, el texto completo de una novela). Las instrucciones se clasifican en varias categorías, incluidas las que se muestran en la siguiente tabla:

| Categoría de instrucción | Ejemplo | Notas |

|---|---|---|

| Pregunta | ¿Qué tan rápido puede volar una paloma? | |

| Instrucción | Escribe un poema divertido sobre el arbitraje. | Es una instrucción que le pide al modelo de lenguaje grande que haga algo. |

| Ejemplo | Traduce el código de Markdown a HTML. Por ejemplo:

Markdown: * list item HTML: <ul> <li>list item</li> </ul> |

La primera oración de esta instrucción de ejemplo es una instrucción. El resto de la instrucción es el ejemplo. |

| Rol | Explicar por qué se usa el descenso de gradientes en el entrenamiento del aprendizaje automático a un doctor en Física | La primera parte de la oración es una instrucción; la frase "para obtener un doctorado en Física" es la parte del rol. |

| Entrada parcial para que el modelo la complete | El primer ministro del Reino Unido vive en | Una instrucción de entrada parcial puede terminar de forma abrupta (como en este ejemplo) o con un guion bajo. |

Un modelo de IA generativa puede responder a una instrucción con texto, código, imágenes, incorporaciones, videos… casi cualquier cosa.

aprendizaje basado en instrucciones

Es una capacidad de ciertos modelos que les permite adaptar su comportamiento en respuesta a entradas de texto arbitrarias (instrucciones). En un paradigma de aprendizaje basado en instrucciones típico, un modelo de lenguaje grande responde a una instrucción generando texto. Por ejemplo, supongamos que un usuario ingresa la siguiente instrucción:

Resume la tercera ley del movimiento de Newton.

Un modelo capaz de aprender a partir de instrucciones no se entrena específicamente para responder la instrucción anterior. En cambio, el modelo "conoce" muchos datos sobre física, muchas reglas generales del lenguaje y mucha información sobre lo que constituye respuestas generalmente útiles. Ese conocimiento es suficiente para proporcionar una respuesta (con suerte) útil. La retroalimentación humana adicional ("Esa respuesta fue demasiado complicada" o "¿Qué es una reacción?") permite que algunos sistemas de aprendizaje basados en instrucciones mejoren gradualmente la utilidad de sus respuestas.

Diseño de instrucciones

Sinónimo de ingeniería de instrucciones.

Ingeniería de instrucciones

El arte de crear instrucciones que produzcan las respuestas deseadas de un modelo de lenguaje grande Los humanos realizan la ingeniería de instrucciones. Escribir instrucciones bien estructuradas es una parte esencial para garantizar respuestas útiles de un modelo de lenguaje grande. La ingeniería de instrucciones depende de muchos factores, incluidos los siguientes:

- Es el conjunto de datos que se usa para entrenar previamente y, posiblemente, ajustar el modelo de lenguaje grande.

- Son el parámetro temperature y otros parámetros de decodificación que el modelo usa para generar respuestas.

Diseño de instrucciones es sinónimo de ingeniería de instrucciones.

Consulta Introducción al diseño de instrucciones para obtener más detalles sobre cómo escribir instrucciones útiles.

conjunto de instrucciones

Es un grupo de instrucciones para evaluar un modelo de lenguaje grande. Por ejemplo, la siguiente ilustración muestra un conjunto de instrucciones que consta de tres instrucciones:

Los buenos conjuntos de instrucciones constan de una colección de instrucciones lo suficientemente "amplia" para evaluar a fondo la seguridad y la utilidad de un modelo de lenguaje grande.

Consulta también conjunto de respuestas.

Ajuste de instrucciones

Un mecanismo de ajuste eficiente de parámetros que aprende un "prefijo" que el sistema antepone a la instrucción real.

Una variación del ajuste de instrucciones, a veces denominado ajuste de prefijo, consiste en anteponer el prefijo en cada capa. En cambio, la mayoría de los ajustes de instrucciones solo agregan un prefijo a la capa de entrada.

R

texto de referencia

Respuesta de un experto a una instrucción. Por ejemplo, dada la siguiente instrucción:

Traduce la pregunta "¿Cómo te llamas?" del inglés al francés.

La respuesta de un experto podría ser la siguiente:

Comment vous appelez-vous?

Varias métricas (como ROUGE) miden el grado en que el texto de referencia coincide con el texto generado de un modelo de AA.

reflexión

Estrategia para mejorar la calidad de un flujo de trabajo basado en agentes examinando (reflexionando sobre) el resultado de un paso antes de pasarlo al siguiente.

A menudo, el examinador es el mismo LLM que generó la respuesta (aunque podría ser un LLM diferente). ¿Cómo podría el mismo LLM que generó una respuesta ser un juez imparcial de su propia respuesta? El "truco" consiste en poner al LLM en un estado mental crítico (reflexivo). Este proceso es análogo al de un escritor que usa una mentalidad creativa para escribir un primer borrador y, luego, cambia a una mentalidad crítica para editarlo.

Por ejemplo, imagina un flujo de trabajo de agente cuyo primer paso es crear texto para tazas de café. La instrucción para este paso podría ser la siguiente:

Eres creativo. Genera un texto original y humorístico de menos de 50 caracteres adecuado para una taza de café.

Ahora, imagina la siguiente instrucción reflexiva:

Eres bebedor de café. ¿Considerarías humorística la respuesta anterior?

Luego, el flujo de trabajo podría pasar solo el texto que recibe una puntuación de reflexión alta a la siguiente etapa.

Aprendizaje por refuerzo con retroalimentación humana (RLHF)

Usar la retroalimentación de evaluadores humanos para mejorar la calidad de las respuestas de un modelo Por ejemplo, un mecanismo de RLHF puede pedirles a los usuarios que califiquen la calidad de la respuesta de un modelo con un emoji 👍 o 👎. Luego, el sistema puede ajustar sus respuestas futuras en función de esos comentarios.

respuesta

El texto, las imágenes, el audio o el video que infiere un modelo de IA generativa. En otras palabras, una instrucción es la entrada para un modelo de IA generativa, y la respuesta es la salida.

conjunto de respuestas

Es la colección de respuestas que un modelo de lenguaje grande devuelve a un conjunto de instrucciones de entrada.

Instrucciones con roles

Una instrucción, que suele comenzar con el pronombre tú, que le indica a un modelo de IA generativa que finja ser una persona o un rol determinado cuando genere la respuesta. Las instrucciones de rol pueden ayudar a un modelo de IA generativa a adoptar la "mentalidad" adecuada para generar una respuesta más útil. Por ejemplo, cualquiera de las siguientes instrucciones de rol podría ser adecuada según el tipo de respuesta que busques:

Tienes un doctorado en informática.

Eres ingeniero de software y te gusta dar explicaciones pacientes sobre Python a los estudiantes de programación nuevos.

Eres un héroe de acción con un conjunto muy particular de habilidades de programación. Asegúrame que encontrarás un elemento específico en una lista de Python.

S

Ajuste de instrucciones secundarias

Es una técnica para ajustar un modelo de lenguaje grande para una tarea en particular, sin necesidad de un ajuste que requiera muchos recursos. En lugar de volver a entrenar todos los pesos del modelo, el ajuste de instrucciones flexible ajusta automáticamente una instrucción para lograr el mismo objetivo.

Dado un texto de instrucción, el ajuste de instrucciones con texto adicional suele agregar incorporaciones de tokens adicionales a la instrucción y usa la retropropagación para optimizar la entrada.

Una instrucción "fuerte" contiene tokens reales en lugar de incorporaciones de tokens.

codificación especificacional

Proceso de escribir y mantener un archivo en un lenguaje humano (por ejemplo, inglés) que describe software. Luego, puedes pedirle a un modelo de IA generativa o a otro ingeniero de software que cree el software que cumpla con esa descripción.

El código generado automáticamente suele requerir iteraciones. En la codificación de especificaciones, iteras en el archivo de descripción. En cambio, en la programación conversacional, iteras dentro del cuadro de instrucciones. En la práctica, la generación automática de código a veces implica una combinación de ambos tipos de codificación: la específica y la conversacional.

T

temperatura

Es un hiperparámetro que controla el grado de aleatoriedad del resultado de un modelo. Las temperaturas más altas generan resultados más aleatorios, mientras que las temperaturas más bajas generan resultados menos aleatorios.

Elegir la mejor temperatura depende de la aplicación específica o de los valores de cadena.

U

Ultra

El modelo de Gemini con la mayor cantidad de parámetros. Consulta Gemini Ultra para obtener más detalles.

V

Vertex

Plataforma de Google Cloud para la IA y el aprendizaje automático. Vertex proporciona herramientas e infraestructura para compilar, implementar y administrar aplicaciones basadas en IA, incluido el acceso a los modelos de Gemini.vibe coding

Dar instrucciones a un modelo de IA generativa para crear software Es decir, tus instrucciones describen el propósito y las funciones del software, que un modelo de IA generativa traduce en código fuente. El código generado no siempre coincide con tus intenciones, por lo que la programación por intuición suele requerir iteraciones.

Andrej Karpathy acuñó el término "vibe coding" en esta publicación de X. En la publicación de X, Karpathy lo describe como "un nuevo tipo de programación… en el que te dejas llevar por el ambiente…". Por lo tanto, el término originalmente implicaba un enfoque intencionalmente flexible para crear software en el que tal vez ni siquiera se examinaba el código generado. Sin embargo, el término evolucionó rápidamente en muchos círculos para significar ahora cualquier forma de codificación generada por IA.

Para obtener una descripción más detallada de la codificación de ambiente, consulta ¿Qué es el vibe coding?.

Además, compara y contrasta el vibe coding con lo siguiente:

Z

instrucción sin ejemplos

Una instrucción que no proporciona un ejemplo de cómo quieres que responda el modelo de lenguaje grande Por ejemplo:

| Partes de una instrucción | Notas |

|---|---|

| ¿Cuál es la moneda oficial del país especificado? | La pregunta que quieres que responda el LLM. |

| India: | Es la búsqueda real. |

El modelo de lenguaje grande podría responder con cualquiera de las siguientes opciones:

- Rupia

- INR

- ₹

- Rupia hindú

- La rupia

- La rupia india

Todas las respuestas son correctas, aunque es posible que prefieras un formato en particular.

Compara y contrasta el zero-shot prompting con los siguientes términos: