Halaman ini berisi istilah glosarium AI Generatif. Untuk semua istilah glosarium, klik di sini.

A

adaptasi

Sinonim untuk penyesuaian atau penyesuaian.

agen

Software yang dapat memproses input pengguna multimodal untuk merencanakan dan mengeksekusi tindakan atas nama pengguna.

Dalam reinforcement learning, agen adalah entitas yang menggunakan kebijakan untuk memaksimalkan hasil yang diharapkan dari transisi antara status lingkungan.

agentik

Bentuk adjektif dari agen. Agentik mengacu pada kualitas yang dimiliki agen (seperti otonomi).

alur kerja agentic

Proses dinamis di mana agen secara otonom merencanakan dan mengeksekusi tindakan untuk mencapai sasaran. Prosesnya dapat melibatkan penalaran, pemanggilan alat eksternal, dan mengoreksi sendiri rencananya.

Kemiringan AI

Output dari sistem AI generatif yang lebih mengutamakan kuantitas daripada kualitas. Misalnya, halaman web dengan konten buatan AI yang tidak bermutu diisi dengan konten berkualitas rendah buatan AI yang diproduksi dengan murah.

evaluasi otomatis

Menggunakan software untuk menilai kualitas output model.

Jika output model relatif sederhana, skrip atau program dapat membandingkan output model dengan respons ideal. Jenis evaluasi otomatis ini terkadang disebut evaluasi terprogram. Metrik seperti ROUGE atau BLEU sering kali berguna untuk evaluasi terprogram.

Jika output model kompleks atau tidak ada satu jawaban yang benar, program ML terpisah yang disebut penilai otomatis terkadang melakukan evaluasi otomatis.

Berbeda dengan evaluasi manual.

evaluasi pemberi rating otomatis

Mekanisme hibrida untuk menilai kualitas output model AI generatif yang menggabungkan evaluasi manual dengan evaluasi otomatis. Autorater adalah model ML yang dilatih pada data yang dibuat oleh evaluasi manusia. Idealnya, autorater belajar meniru evaluator manusia.Autorater bawaan tersedia, tetapi autorater terbaik adalah yang di-fine-tune secara khusus untuk tugas yang Anda evaluasi.

model autoregresif

Model yang menyimpulkan prediksi berdasarkan prediksi sebelumnya. Misalnya, model bahasa autoregresif memprediksi token berikutnya berdasarkan token yang diprediksi sebelumnya. Semua model bahasa besar berbasis Transformer bersifat autoregresif.

Sebaliknya, model gambar berbasis GAN biasanya tidak autoregresif karena menghasilkan gambar dalam satu penerusan ke depan dan tidak secara iteratif dalam langkah-langkah. Namun, model pembuatan gambar tertentu bersifat autoregresif karena model tersebut menghasilkan gambar secara bertahap.

B

model dasar

Model terlatih yang dapat berfungsi sebagai titik awal untuk penyesuaian guna menangani tugas atau aplikasi tertentu.

Lihat juga model terlatih dan model dasar.

C

prompting chain-of-thought

Teknik rekayasa perintah yang mendorong model bahasa besar (LLM) untuk menjelaskan penalarannya, langkah demi langkah. Misalnya, perhatikan perintah berikut, dengan memberikan perhatian khusus pada kalimat kedua:

Berapa gaya gravitasi yang akan dialami pengemudi dalam mobil yang melaju dari 0 hingga 60 mil per jam dalam 7 detik? Dalam jawaban, tunjukkan semua perhitungan yang relevan.

Respons LLM kemungkinan akan:

- Tampilkan urutan rumus fisika, dengan memasukkan nilai 0, 60, dan 7 di tempat yang sesuai.

- Jelaskan alasan pemilihan formula tersebut dan arti berbagai variabelnya.

Prompting chain-of-thought memaksa LLM untuk melakukan semua perhitungan, yang dapat menghasilkan jawaban yang lebih benar. Selain itu, perintah rantai pemikiran memungkinkan pengguna memeriksa langkah-langkah LLM untuk menentukan apakah jawaban yang diberikan masuk akal atau tidak.

chat

Isi dialog dua arah dengan sistem ML, biasanya model bahasa besar. Interaksi sebelumnya dalam chat (apa yang Anda ketik dan cara model bahasa besar merespons) menjadi konteks untuk bagian chat berikutnya.

Chatbot adalah aplikasi model bahasa besar.

embedding bahasa yang dikontekstualisasi

Embedding yang mendekati "pemahaman" kata dan frasa seperti yang dilakukan penutur manusia yang fasih. Penyematan bahasa yang dikontekstualisasi dapat memahami sintaksis, semantik, dan konteks yang kompleks.

Misalnya, pertimbangkan embedding kata cow dalam bahasa Inggris. Embedding lama seperti word2vec dapat merepresentasikan kata-kata bahasa Inggris sehingga jarak dalam ruang embedding dari cow ke bull mirip dengan jarak dari ewe (domba betina) ke ram (domba jantan) atau dari female ke male. Penyematan bahasa yang dikontekstualisasikan dapat melangkah lebih jauh dengan mengenali bahwa penutur bahasa Inggris terkadang menggunakan kata cow secara kasual untuk merujuk pada sapi betina atau sapi jantan.

jendela konteks

Jumlah token yang dapat diproses model dalam perintah tertentu. Makin besar jendela konteks, makin banyak informasi yang dapat digunakan model untuk memberikan respons yang koheren dan konsisten terhadap perintah.

pengodean percakapan

Dialog berulang antara Anda dan model AI generatif untuk tujuan pembuatan software. Anda memberikan perintah yang mendeskripsikan beberapa software. Kemudian, model menggunakan deskripsi tersebut untuk membuat kode. Kemudian, Anda mengeluarkan perintah baru untuk mengatasi kekurangan dalam perintah sebelumnya atau dalam kode yang dihasilkan, dan model akan menghasilkan kode yang diperbarui. Anda berdua terus berdiskusi hingga software yang dihasilkan cukup baik.

Pengodean percakapan pada dasarnya adalah makna asli dari pengodean suasana.

Berbeda dengan pengodean spesifikasi.

D

perintah langsung

Sinonim untuk zero-shot prompting.

distilasi

Proses mengurangi ukuran satu model (dikenal sebagai pengajar) menjadi model yang lebih kecil (dikenal sebagai siswa) yang meniru prediksi model asli seakurat mungkin. Distilasi berguna karena model yang lebih kecil memiliki dua manfaat utama dibandingkan model yang lebih besar (pengajar):

- Waktu inferensi yang lebih cepat

- Mengurangi penggunaan memori dan energi

Namun, prediksi siswa biasanya tidak sebaik prediksi pengajar.

Distilasi melatih model siswa untuk meminimalkan fungsi loss berdasarkan perbedaan antara output prediksi model siswa dan model pengajar.

Bandingkan dan bedakan distilasi dengan istilah berikut:

Lihat LLM: Penyesuaian, distilasi, dan rekayasa prompt di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

E

evaluasi

Terutama digunakan sebagai singkatan untuk evaluasi LLM. Secara umum, evaluasi adalah singkatan dari bentuk evaluasi apa pun.

evaluasi

Proses mengukur kualitas model atau membandingkan berbagai model satu sama lain.

Untuk mengevaluasi model machine learning terawasi, Anda biasanya menilainya berdasarkan set validasi dan set pengujian. Mengevaluasi LLM biasanya melibatkan penilaian kualitas dan keamanan yang lebih luas.

F

faktualitas

Dalam dunia ML, properti yang menjelaskan model yang outputnya didasarkan pada kenyataan. Faktualitas adalah konsep, bukan metrik. Misalnya, Anda mengirimkan perintah berikut ke model bahasa besar:

Apa rumus kimia untuk garam dapur?

Model yang mengoptimalkan faktualitas akan merespons:

NaCl

Kita cenderung mengasumsikan bahwa semua model harus didasarkan pada faktualitas. Namun, beberapa perintah, seperti berikut, akan menyebabkan model AI generatif mengoptimalkan kreativitas, bukan faktualitas.

Buatkan saya sajak lucu tentang astronot dan ulat.

Limerick yang dihasilkan kemungkinan tidak akan didasarkan pada kenyataan.

Berbeda dengan keterikatan dengan data.

peluruhan cepat

Teknik pelatihan untuk meningkatkan performa LLM. Peluruhan cepat melibatkan penurunan kecepatan pembelajaran dengan cepat selama pelatihan. Strategi ini membantu mencegah model melakukan overfitting pada data pelatihan, dan meningkatkan generalisasi.

few-shot prompting

Perintah yang berisi lebih dari satu contoh (beberapa contoh) yang menunjukkan cara model bahasa yang besar harus merespons. Misalnya, perintah panjang berikut berisi dua contoh yang menunjukkan cara model bahasa yang besar menjawab kueri.

| Bagian dari satu perintah | Catatan |

|---|---|

| Apa mata uang resmi negara yang ditentukan? | Pertanyaan yang ingin Anda minta jawabannya dari LLM. |

| Prancis: EUR | Satu contoh. |

| Inggris Raya: GBP | Contoh lain. |

| India: | Kueri sebenarnya. |

Few-shot prompting umumnya menghasilkan hasil yang lebih diinginkan daripada zero-shot prompting dan one-shot prompting. Namun, perintah few-shot memerlukan perintah yang lebih panjang.

Few-shot prompting adalah bentuk few-shot learning yang diterapkan pada pembelajaran berbasis perintah.

Lihat Rekayasa perintah di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

penyesuaian

Proses pelatihan khusus tugas kedua dilakukan pada model terlatih untuk menyempurnakan parameternya untuk kasus penggunaan tertentu. Misalnya, urutan pelatihan lengkap untuk beberapa model bahasa besar adalah sebagai berikut:

- Prapelatihan: Melatih model bahasa besar pada set data umum yang besar, seperti semua halaman Wikipedia berbahasa Inggris.

- Penyesuaian: Melatih model terlatih untuk melakukan tugas tertentu, seperti merespons kueri medis. Penyesuaian biasanya melibatkan ratusan atau ribuan contoh yang berfokus pada tugas tertentu.

Sebagai contoh lain, urutan pelatihan lengkap untuk model gambar besar adalah sebagai berikut:

- Prapelatihan: Melatih model gambar besar pada set data gambar umum yang luas, seperti semua gambar di Wikimedia Commons.

- Penyesuaian: Melatih model terlatih untuk melakukan tugas tertentu, seperti membuat gambar orca.

Penyesuaian dapat mencakup kombinasi strategi berikut:

- Mengubah semua parameter model terlatih yang ada. Hal ini terkadang disebut penyesuaian penuh.

- Mengubah hanya beberapa parameter yang ada pada model terlatih (biasanya, lapisan yang paling dekat dengan lapisan output), sambil mempertahankan parameter yang ada lainnya (biasanya, lapisan yang paling dekat dengan lapisan input). Lihat parameter-efficient tuning.

- Menambahkan lebih banyak lapisan, biasanya di atas lapisan yang ada yang paling dekat dengan lapisan output.

Penyesuaian adalah bentuk transfer learning. Oleh karena itu, penyesuaian mungkin menggunakan fungsi kerugian yang berbeda atau jenis model yang berbeda dengan yang digunakan untuk melatih model terlatih. Misalnya, Anda dapat melakukan penyesuaian pada model gambar besar terlatih untuk menghasilkan model regresi yang menampilkan jumlah burung dalam gambar input.

Bandingkan dan bedakan penyesuaian dengan istilah berikut:

Lihat Penyesuaian di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

Model flash

Rangkaian model Gemini yang relatif kecil dan dioptimalkan untuk kecepatan dan latensi rendah. Model Flash dirancang untuk berbagai aplikasi yang memerlukan respons cepat dan throughput tinggi.

model dasar

Model terlatih yang sangat besar dan dilatih pada set pelatihan yang sangat besar dan beragam. Model dasar dapat melakukan kedua hal berikut:

- Merespons dengan baik berbagai permintaan.

- Berfungsi sebagai model dasar untuk penyesuaian tambahan atau penyesuaian lainnya.

Dengan kata lain, model dasar sudah sangat mumpuni secara umum, tetapi dapat disesuaikan lebih lanjut agar lebih berguna untuk tugas tertentu.

fraksi keberhasilan

Metrik untuk mengevaluasi teks yang dihasilkan model ML. Pecahan keberhasilan adalah jumlah output teks yang dihasilkan "berhasil" dibagi dengan total jumlah output teks yang dihasilkan. Misalnya, jika model bahasa besar menghasilkan 10 blok kode, lima di antaranya berhasil, maka rasio keberhasilannya adalah 50%.

Meskipun fraksi keberhasilan sangat berguna dalam statistik, dalam ML, metrik ini terutama berguna untuk mengukur tugas yang dapat diverifikasi seperti pembuatan kode atau masalah matematika.

G

Gemini

Ekosistem yang terdiri dari AI tercanggih Google. Elemen ekosistem ini mencakup:

- Berbagai model Gemini.

- Antarmuka percakapan interaktif ke model Gemini. Pengguna mengetik perintah dan Gemini merespons perintah tersebut.

- Berbagai Gemini API.

- Berbagai produk bisnis berdasarkan model Gemini; misalnya, Gemini untuk Google Cloud.

Model Gemini

Model multimodal berbasis Transformer mutakhir Google. Model Gemini secara khusus dirancang untuk terintegrasi dengan agen.

Pengguna dapat berinteraksi dengan model Gemini dalam berbagai cara, termasuk melalui antarmuka dialog interaktif dan melalui SDK.

Gemma

Sekumpulan model terbuka yang ringan, dibangun dari riset dan teknologi yang sama dengan yang digunakan untuk membuat model Gemini. Beberapa model Gemma yang berbeda tersedia, yang masing-masing menyediakan fitur yang berbeda, seperti kemampuan melihat, membuat kode, dan mengikuti perintah. Lihat Gemma untuk mengetahui detailnya.

GenAI atau genAI

Singkatan untuk AI generatif.

teks yang dihasilkan

Secara umum, teks yang dihasilkan oleh model ML. Saat mengevaluasi model bahasa besar, beberapa metrik membandingkan teks yang dihasilkan dengan teks referensi. Misalnya, Anda sedang mencoba menentukan seberapa efektif model ML menerjemahkan dari bahasa Prancis ke bahasa Belanda. Dalam hal ini:

- Teks yang dihasilkan adalah terjemahan Belanda yang dihasilkan oleh model ML.

- Teks rujukan adalah terjemahan dalam bahasa Belanda yang dibuat oleh penerjemah manusia (atau software).

Perhatikan bahwa beberapa strategi evaluasi tidak melibatkan teks rujukan.

AI generatif

Bidang transformatif yang baru muncul tanpa definisi formal. Namun, sebagian besar pakar setuju bahwa model AI generatif dapat membuat ("menghasilkan") konten yang memenuhi semua kriteria berikut:

- kompleks

- koheren

- asli

Contoh AI generatif meliputi:

- Model bahasa besar, yang dapat menghasilkan teks asli yang canggih dan menjawab pertanyaan.

- Model pembuatan gambar, yang dapat menghasilkan gambar unik.

- Model pembuatan audio dan musik, yang dapat menyusun musik asli atau menghasilkan ucapan yang realistis.

- Model pembuatan video, yang dapat membuat video asli.

Beberapa teknologi sebelumnya, termasuk LSTM dan RNN, juga dapat menghasilkan konten orisinal dan koheren. Beberapa pakar menganggap teknologi sebelumnya ini sebagai AI generatif, sementara yang lain merasa bahwa AI generatif yang sebenarnya memerlukan output yang lebih kompleks daripada yang dapat dihasilkan oleh teknologi sebelumnya tersebut.

Berbeda dengan ML prediktif.

respons emas

Respons yang diketahui baik. Misalnya, dengan prompt berikut:

2 + 2

Respons terbaik yang diharapkan adalah:

4

GPT (Generative Pre-trained Transformer)

Serangkaian model bahasa besar berbasis Transformer yang dikembangkan oleh OpenAI.

Varian GPT dapat berlaku untuk beberapa modalitas, termasuk:

- pembuatan gambar (misalnya, ImageGPT)

- pembuatan gambar dari teks (misalnya, DALL-E).

H

halusinasi

Produksi output yang tampak masuk akal, tetapi salah secara faktual oleh model AI generatif yang menyatakan membuat pernyataan tentang dunia nyata. Misalnya, model AI generatif yang mengklaim bahwa Barack Obama meninggal pada tahun 1865 sedang berhalusinasi.

evaluasi manual

Proses saat orang menilai kualitas output model ML; misalnya, meminta orang bilingual menilai kualitas model terjemahan ML. Evaluasi manusia sangat berguna untuk menilai model yang tidak memiliki satu jawaban yang benar.

Berbeda dengan evaluasi otomatis dan evaluasi autorater.

Human in the loop (HITL)

Idiom yang tidak jelas yang dapat berarti salah satu dari berikut ini:

- Kebijakan untuk melihat output AI generatif secara kritis atau skeptis.

- Strategi atau sistem untuk memastikan bahwa orang-orang membantu membentuk, mengevaluasi, dan menyempurnakan perilaku model. Dengan mempertahankan keterlibatan manusia, AI dapat memanfaatkan kecerdasan mesin dan kecerdasan manusia. Misalnya, sistem yang menggunakan AI untuk membuat kode yang kemudian ditinjau oleh software engineer adalah sistem human-in-the-loop.

I

pembelajaran dalam konteks

Sinonim untuk few-shot prompting.

inferensi

Dalam machine learning tradisional, proses pembuatan prediksi dengan menerapkan model terlatih ke contoh tak berlabel. Lihat Supervised Learning dalam kursus Intro to ML untuk mempelajari lebih lanjut.

Dalam model bahasa besar, inferensi adalah proses penggunaan model terlatih untuk menghasilkan respons terhadap perintah input.

Inferensi memiliki arti yang agak berbeda dalam statistik. Lihat artikel Wikipedia tentang inferensi statistik untuk mengetahui detailnya.

penyesuaian instruksi

Bentuk penyesuaian yang meningkatkan kemampuan model AI generatif dalam mengikuti petunjuk. Penyesuaian perintah melibatkan pelatihan model pada serangkaian perintah instruksi, yang biasanya mencakup berbagai tugas. Model yang disesuaikan dengan petunjuk ini kemudian cenderung menghasilkan respons yang berguna terhadap perintah zero-shot di berbagai tugas.

Bandingkan dan bedakan dengan:

L

model bahasa besar

Setidaknya, model bahasa yang memiliki parameter dalam jumlah sangat besar. Secara lebih informal, model bahasa berbasis Transformer, seperti Gemini atau GPT.

Lihat Model bahasa besar (LLM) di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

latensi

Waktu yang dibutuhkan model untuk memproses input dan menghasilkan respons. Respons latensi tinggi memerlukan waktu lebih lama untuk dihasilkan daripada respons latensi rendah.

Faktor-faktor yang memengaruhi latensi model bahasa besar meliputi:

- Panjang token input dan output

- Kompleksitas model

- Infrastruktur tempat model berjalan

Mengoptimalkan latensi sangat penting untuk membuat aplikasi yang responsif dan mudah digunakan.

LLM

Singkatan dari model bahasa besar.

Evaluasi LLM (evaluasi)

Serangkaian metrik dan tolok ukur untuk menilai performa model bahasa besar (LLM). Secara umum, evaluasi LLM:

- Membantu peneliti mengidentifikasi area yang perlu ditingkatkan pada LLM.

- Berguna dalam membandingkan berbagai LLM dan mengidentifikasi LLM terbaik untuk tugas tertentu.

- Membantu memastikan bahwa LLM aman dan etis untuk digunakan.

Lihat Model bahasa besar (LLM) di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

LoRA

Singkatan dari Low-Rank Adaptability.

Low-Rank Adaptability (LoRA)

Teknik parameter-efisien untuk penyesuaian yang "membekukan" bobot model yang telah dilatih sebelumnya (sehingga tidak dapat lagi diubah) lalu menyisipkan sekumpulan kecil bobot yang dapat dilatih ke dalam model. Kumpulan bobot yang dapat dilatih ini (juga dikenal sebagai "matriks update") jauh lebih kecil daripada model dasar dan oleh karena itu, pelatihan jauh lebih cepat.

LoRA memberikan manfaat berikut:

- Meningkatkan kualitas prediksi model untuk domain tempat penyesuaian diterapkan.

- Menyesuaikan lebih cepat daripada teknik yang memerlukan penyesuaian semua parameter model.

- Mengurangi biaya komputasi inferensi dengan memungkinkan penyajian serentak beberapa model khusus yang berbagi model dasar yang sama.

M

terjemahan mesin

Menggunakan software (biasanya, model machine learning) untuk mengonversi teks dari satu bahasa manusia ke bahasa manusia lain, misalnya, dari bahasa Inggris ke bahasa Jepang.

presisi rata-rata pada k (mAP@k)

Rata-rata statistik dari semua skor presisi rata-rata pada k di seluruh set data validasi. Salah satu penggunaan presisi rata-rata mean pada k adalah untuk menilai kualitas rekomendasi yang dihasilkan oleh sistem rekomendasi.

Meskipun frasa "rata-rata" terdengar berlebihan, nama metrik ini sudah tepat. Bagaimanapun, metrik ini menemukan rata-rata dari beberapa nilai presisi rata-rata pada k.

campuran pakar

Skema untuk meningkatkan efisiensi jaringan neural dengan hanya menggunakan subset parameternya (dikenal sebagai pakar) untuk memproses token atau contoh input tertentu. Jaringan gating mengarahkan setiap token atau contoh input ke pakar yang tepat.

Untuk mengetahui detailnya, lihat salah satu makalah berikut:

- Jaringan Neural yang Sangat Besar: Lapisan Mixture-of-Experts dengan Gerbang yang Jarang

- Mixture-of-Experts dengan Perutean Pilihan Pakar

MMIT

Singkatan dari multimodal instruction-tuned.

penggabungan model

Sistem yang memilih model yang ideal untuk kueri inferensi tertentu.

Bayangkan sekelompok model, mulai dari yang sangat besar (banyak parameter) hingga yang jauh lebih kecil (lebih sedikit parameter). Model yang sangat besar menggunakan lebih banyak resource komputasi pada waktu inferensi daripada model yang lebih kecil. Namun, model yang sangat besar biasanya dapat menyimpulkan permintaan yang lebih kompleks daripada model yang lebih kecil. Cascading model menentukan kompleksitas kueri inferensi, lalu memilih model yang sesuai untuk melakukan inferensi. Motivasi utama untuk pengelompokan model adalah mengurangi biaya inferensi dengan umumnya memilih model yang lebih kecil, dan hanya memilih model yang lebih besar untuk kueri yang lebih kompleks.

Bayangkan model kecil berjalan di ponsel dan versi model yang lebih besar berjalan di server jarak jauh. Cascading model yang baik mengurangi biaya dan latensi dengan memungkinkan model yang lebih kecil menangani permintaan sederhana dan hanya memanggil model jarak jauh untuk menangani permintaan yang kompleks.

Lihat juga model router.

router model

Algoritma yang menentukan model ideal untuk inferensi dalam penggabungan model. Router model itu sendiri biasanya merupakan model machine learning yang secara bertahap mempelajari cara memilih model terbaik untuk input tertentu. Namun, perute model terkadang bisa menjadi algoritma yang lebih sederhana dan non-machine learning.

MOE

Singkatan dari mixture of experts.

MT

Singkatan dari machine translation.

T

Nano

Model Gemini yang relatif kecil dan dirancang untuk penggunaan di perangkat. Lihat Gemini Nano untuk mengetahui detailnya.

tidak ada satu jawaban yang benar (NORA)

Perintah yang memiliki beberapa respons yang benar. Misalnya, perintah berikut tidak memiliki satu jawaban yang benar:

Ceritakan lelucon lucu tentang gajah.

Mengevaluasi respons terhadap perintah tanpa satu jawaban yang benar biasanya jauh lebih subjektif daripada mengevaluasi perintah dengan satu jawaban yang benar. Misalnya, mengevaluasi lelucon tentang gajah memerlukan cara sistematis untuk menentukan seberapa lucu lelucon tersebut.

NORA

Singkatan untuk tidak ada satu jawaban yang benar.

Notebook LM

Alat berbasis Gemini yang memungkinkan pengguna mengupload dokumen, lalu menggunakan perintah untuk mengajukan pertanyaan tentang, meringkas, atau mengatur dokumen tersebut. Misalnya, seorang penulis dapat mengupload beberapa cerita pendek dan meminta NotebookLM untuk menemukan tema umumnya atau mengidentifikasi mana yang akan menjadi film terbaik.

O

satu jawaban benar (ORA)

Perintah yang memiliki satu respons yang benar. Misalnya, pertimbangkan perintah berikut:

Benar atau salah: Saturnus lebih besar dari Mars.

Satu-satunya respons yang benar adalah benar.

Berbeda dengan tidak ada satu jawaban yang benar.

one-shot prompting

Perintah yang berisi satu contoh yang menunjukkan cara model bahasa besar harus merespons. Misalnya, perintah berikut berisi satu contoh yang menunjukkan kepada model bahasa besar cara menjawab kueri.

| Bagian dari satu perintah | Catatan |

|---|---|

| Apa mata uang resmi negara yang ditentukan? | Pertanyaan yang ingin Anda minta jawabannya dari LLM. |

| Prancis: EUR | Satu contoh. |

| India: | Kueri sebenarnya. |

Bandingkan dan bedakan prompting sekali tembak dengan istilah berikut:

ORA

Singkatan dari satu jawaban yang benar.

P

parameter-efficient tuning

Serangkaian teknik untuk menyesuaikan model bahasa besar (LLM) terlatih (PLM) secara lebih efisien daripada penyesuaian penuh. Penyesuaian yang efisien parameter biasanya menyesuaikan jauh lebih sedikit parameter daripada penyesuaian penuh, tetapi umumnya menghasilkan model bahasa besar yang berperforma sama baiknya (atau hampir sama baiknya) dengan model bahasa besar yang dibuat dari penyesuaian penuh.

Membandingkan dan membedakan parameter-efficient tuning dengan:

Parameter-efficient tuning juga dikenal sebagai parameter-efficient fine-tuning.

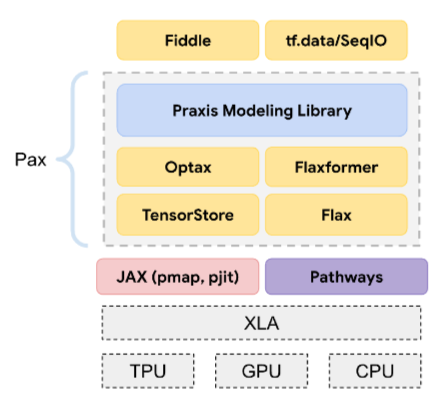

Pax

Framework pemrograman yang dirancang untuk melatih jaringan neural model berskala besar sehingga model tersebut mencakup beberapa TPU slice chip akselerator atau pod .

Pax dibangun di atas Flax, yang dibangun di atas JAX.

PLM

Singkatan dari pre-trained language model.

model yang dilatih ulang

Istilah yang didefinisikan secara longgar yang biasanya merujuk pada model terlatih yang telah melalui beberapa pascapemrosesan, seperti satu atau beberapa hal berikut:

model terlatih

Meskipun istilah ini dapat merujuk ke model terlatih atau vektor sematan terlatih, model terlatih kini biasanya merujuk ke model bahasa besar terlatih atau bentuk model AI generatif terlatih lainnya.

Lihat juga model dasar dan model dasar.

pra-pelatihan

Pelatihan awal model pada set data yang besar. Beberapa model terlatih adalah raksasa yang canggung dan biasanya harus disempurnakan melalui pelatihan tambahan. Misalnya, pakar ML dapat melatih model bahasa besar terlebih dahulu pada set data teks yang sangat besar, seperti semua halaman berbahasa Inggris di Wikipedia. Setelah pra-pelatihan, model yang dihasilkan dapat disempurnakan lebih lanjut melalui salah satu teknik berikut:

- distilasi

- penyesuaian (fine-tuning)

- penyesuaian petunjuk

- parameter-efficient tuning

- penyesuaian perintah

Pro

Model Gemini dengan parameter yang lebih sedikit daripada Ultra, tetapi lebih banyak parameter daripada Nano. Lihat Gemini Pro untuk mengetahui detailnya.

perintah

Teks apa pun yang dimasukkan sebagai input ke model bahasa besar untuk mengondisikan model agar berperilaku dengan cara tertentu. Perintah bisa sesingkat frasa atau sepanjang yang Anda inginkan (misalnya, seluruh teks novel). Perintah terbagi dalam beberapa kategori, termasuk yang ditampilkan dalam tabel berikut:

| Kategori perintah | Contoh | Catatan |

|---|---|---|

| Pertanyaan | Seberapa cepat merpati dapat terbang? | |

| Petunjuk | Tulis puisi lucu tentang arbitrase. | Perintah yang meminta model bahasa besar untuk melakukan sesuatu. |

| Contoh | Terjemahkan kode Markdown ke HTML. Misalnya:

Markdown: * item daftar HTML: <ul> <li>item daftar</li> </ul> |

Kalimat pertama dalam perintah contoh ini adalah petunjuk. Bagian perintah lainnya adalah contoh. |

| Peran | Jelaskan alasan penurunan gradien digunakan dalam pelatihan machine learning untuk PhD di bidang Fisika. | Bagian pertama kalimat adalah petunjuk; frasa "to a PhD in Physics" adalah bagian peran. |

| Input parsial yang harus diselesaikan oleh model | Perdana Menteri Inggris Raya tinggal di | Perintah input parsial dapat berakhir tiba-tiba (seperti contoh ini) atau berakhir dengan garis bawah. |

Model AI generatif dapat merespons perintah dengan teks, kode, gambar, embedding, video…hampir semua hal.

pembelajaran berbasis perintah

Kemampuan model tertentu yang memungkinkannya menyesuaikan perilakunya sebagai respons terhadap input teks arbitrer (perintah). Dalam paradigma pembelajaran berbasis perintah yang umum, model bahasa besar merespons perintah dengan menghasilkan teks. Misalnya, pengguna memasukkan perintah berikut:

Ringkas Hukum Ketiga Gerak Newton.

Model yang mampu melakukan pembelajaran berbasis perintah tidak dilatih secara khusus untuk menjawab perintah sebelumnya. Sebaliknya, model "mengetahui" banyak fakta tentang fisika, banyak tentang aturan bahasa umum, dan banyak tentang apa yang merupakan jawaban yang umumnya berguna. Pengetahuan tersebut sudah cukup untuk memberikan jawaban yang (semoga) bermanfaat. Masukan tambahan dari petugas ("Jawaban itu terlalu rumit" atau "Apa itu reaksi?") memungkinkan beberapa sistem pembelajaran berbasis perintah secara bertahap meningkatkan kegunaan jawabannya.

desain perintah

Sinonim untuk rekayasa perintah.

rekayasa perintah

Seni membuat perintah yang mendapatkan respons yang diinginkan dari model bahasa besar. Manusia melakukan rekayasa perintah. Menulis perintah yang terstruktur dengan baik adalah bagian penting untuk memastikan respons yang berguna dari model bahasa besar. Rekayasa perintah bergantung pada banyak faktor, termasuk:

- Set data yang digunakan untuk melakukan pra-pelatihan dan mungkin menyesuaikan model bahasa besar.

- Suhu dan parameter decoding lainnya yang digunakan model untuk membuat respons.

Desain perintah adalah sinonim untuk rekayasa perintah.

Lihat Pengantar desain perintah untuk mengetahui detail selengkapnya tentang cara menulis perintah yang bermanfaat.

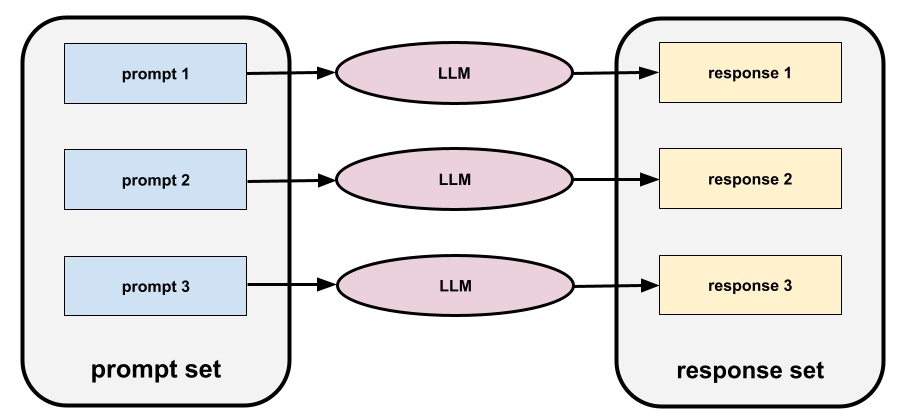

set perintah

Sekelompok perintah untuk mengevaluasi model bahasa besar. Misalnya, ilustrasi berikut menunjukkan kumpulan perintah yang terdiri dari tiga perintah:

Set perintah yang baik terdiri dari kumpulan perintah yang cukup "luas" untuk mengevaluasi secara menyeluruh keamanan dan kegunaan model bahasa besar.

Lihat juga set respons.

penyesuaian perintah

Mekanisme parameter efficient tuning yang mempelajari "awalan" yang ditambahkan sistem ke perintah yang sebenarnya.

Salah satu variasi penyesuaian perintah—terkadang disebut penyesuaian awalan—adalah menambahkan awalan di setiap lapisan. Sebaliknya, sebagian besar penyesuaian perintah hanya menambahkan awalan ke lapisan input.

R

teks referensi

Respons pakar terhadap prompt . Misalnya, dengan perintah berikut:

Terjemahkan pertanyaan "Siapa namamu?" dari bahasa Inggris ke bahasa Prancis.

Respons pakar mungkin:

Comment vous appelez-vous?

Berbagai metrik (seperti ROUGE) mengukur tingkat kecocokan teks referensi dengan teks yang dihasilkan model ML.

refleksi diri

Strategi untuk meningkatkan kualitas alur kerja berbasis agen dengan memeriksa (merefleksikan) output langkah sebelum meneruskan output tersebut ke langkah berikutnya.

Pemeriksa sering kali adalah LLM yang sama yang menghasilkan respons (meskipun bisa berupa LLM yang berbeda). Bagaimana bisa LLM yang sama yang menghasilkan respons menjadi penilai yang adil atas responsnya sendiri? "Triknya" adalah membuat LLM berpikir kritis (reflektif). Proses ini serupa dengan penulis yang menggunakan pola pikir kreatif untuk menulis draf pertama, lalu beralih ke pola pikir kritis untuk mengeditnya.

Misalnya, bayangkan alur kerja agentik yang langkah pertamanya adalah membuat teks untuk cangkir kopi. Perintah untuk langkah ini mungkin:

Anda adalah seorang kreator. Buat teks orisinal yang lucu dengan panjang kurang dari 50 karakter yang cocok untuk cangkir kopi.

Sekarang, bayangkan perintah refleksi berikut:

Anda adalah seorang peminum kopi. Apakah Anda menganggap respons sebelumnya lucu?

Alur kerja kemudian hanya akan meneruskan teks yang menerima skor refleksi tinggi ke tahap berikutnya.

Reinforcement Learning from Human Feedback (RLHF)

Menggunakan masukan dari pemberi rating manual untuk meningkatkan kualitas respons model. Misalnya, mekanisme RLHF dapat meminta pengguna untuk menilai kualitas respons model dengan emoji 👍 atau 👎. Sistem kemudian dapat menyesuaikan responsnya di masa mendatang berdasarkan masukan tersebut.

respons

Teks, gambar, audio, atau video yang disimpulkan oleh model AI generatif. Dengan kata lain, perintah adalah input ke model AI generatif dan responsnya adalah output.

kumpulan respons

Kumpulan respons yang model bahasa besar berikan untuk input set perintah.

perintah peran

Perintah, biasanya dimulai dengan kata ganti Anda, yang memberi tahu model AI generatif untuk berpura-pura menjadi orang tertentu atau peran tertentu saat membuat respons. Perintah peran dapat membantu model AI generatif mendapatkan "pola pikir" yang tepat untuk menghasilkan respons yang lebih berguna. Misalnya, salah satu perintah peran berikut mungkin sesuai, bergantung pada jenis respons yang Anda inginkan:

Anda memiliki gelar PhD di bidang ilmu komputer.

Anda adalah seorang software engineer yang senang memberikan penjelasan sabar tentang Python kepada siswa pemrograman baru.

Anda adalah pahlawan aksi dengan serangkaian keterampilan pemrograman yang sangat khusus. Yakinkan saya bahwa Anda akan menemukan item tertentu dalam daftar Python.

S

penyesuaian perintah ringan

Teknik untuk menyesuaikan model bahasa besar untuk tugas tertentu, tanpa penyesuaian yang memerlukan banyak resource. Daripada melatih ulang semua bobot dalam model, penyesuaian perintah ringan secara otomatis menyesuaikan perintah untuk mencapai sasaran yang sama.

Dengan perintah tekstual, penyesuaian perintah lembut biasanya menambahkan embedding token tambahan ke perintah dan menggunakan backpropagation untuk mengoptimalkan input.

Perintah "keras" berisi token aktual, bukan penyematan token.

pengodean spesifikasi

Proses penulisan dan pengelolaan file dalam bahasa manusia (misalnya, Inggris) yang menjelaskan software. Kemudian, Anda dapat meminta model AI generatif atau engineer software lain untuk membuat software yang memenuhi deskripsi tersebut.

Kode yang dibuat secara otomatis umumnya memerlukan iterasi. Dalam pengodean spesifikasi, Anda melakukan iterasi pada file deskripsi. Sebaliknya, dalam pengodean percakapan, Anda melakukan iterasi dalam kotak perintah. Dalam praktiknya, pembuatan kode otomatis terkadang melibatkan kombinasi kedua pengodean spesifikasi dan pengodean percakapan.

T

suhu

Hyperparameter yang mengontrol tingkat keacakan output model. Temperatur yang lebih tinggi menghasilkan output yang lebih acak, sedangkan temperatur yang lebih rendah menghasilkan output yang kurang acak.

Memilih suhu terbaik bergantung pada aplikasi dan/atau nilai string tertentu.

U

Ultra

Model Gemini dengan parameter terbanyak. Lihat Gemini Ultra untuk mengetahui detailnya.

V

Vertex

Platform Google Cloud untuk AI dan machine learning. Vertex menyediakan alat dan infrastruktur untuk membangun, men-deploy, dan mengelola aplikasi AI, termasuk akses ke model Gemini.vibe coding

Memberi perintah pada model AI generatif untuk membuat software. Artinya, perintah Anda mendeskripsikan tujuan dan fitur software, yang diterjemahkan oleh model AI generatif menjadi kode sumber. Kode yang dihasilkan tidak selalu sesuai dengan maksud Anda, sehingga coding suasana biasanya memerlukan iterasi.

Andrej Karpathy menciptakan istilah vibe coding dalam postingan X ini. Dalam postingan X, Karpathy mendeskripsikannya sebagai "jenis coding baru...tempat Anda sepenuhnya menyerah pada getaran..." Jadi, istilah ini awalnya menyiratkan pendekatan yang sengaja longgar untuk membuat software yang bahkan mungkin tidak memeriksa kode yang dihasilkan. Namun, istilah ini telah berkembang pesat di banyak kalangan hingga kini berarti semua bentuk coding yang dihasilkan AI.

Untuk mengetahui deskripsi yang lebih mendetail tentang pengodean nuansa, lihat What is vibe coding?.

Selain itu, bandingkan dan bedakan vibe coding dengan:

Z

zero-shot prompting

Perintah yang tidak memberikan contoh cara Anda ingin model bahasa besar merespons. Contoh:

| Bagian dari satu perintah | Catatan |

|---|---|

| Apa mata uang resmi negara yang ditentukan? | Pertanyaan yang ingin Anda minta jawabannya dari LLM. |

| India: | Kueri sebenarnya. |

Model bahasa besar dapat merespons dengan salah satu dari berikut ini:

- Rupee

- INR

- Rs

- Rupee India

- Rupee

- Rupee India

Semua jawaban benar, meskipun Anda mungkin lebih menyukai format tertentu.

Bandingkan dan bedakan prompting zero-shot dengan istilah berikut: