इस पेज पर, इमेज मॉडल की ग्लॉसरी के शब्द दिए गए हैं. ग्लॉसरी में मौजूद सभी शब्दों के लिए, यहां क्लिक करें.

A

संवर्धित वास्तविकता

यह एक ऐसी टेक्नोलॉजी है जो कंप्यूटर से जनरेट की गई इमेज को, उपयोगकर्ता के आस-पास मौजूद असली दुनिया के व्यू पर सुपरइंपोज़ करती है. इससे, उपयोगकर्ता को कंपोज़िट व्यू मिलता है.

ऑटोएन्कोडर

यह ऐसा सिस्टम है जो इनपुट से सबसे ज़रूरी जानकारी निकालना सीखता है. ऑटोएन्कोडर, एन्कोडर और डिकोडर का कॉम्बिनेशन होते हैं. ऑटोएन्कोडर, दो चरणों वाली इस प्रोसेस पर निर्भर करते हैं:

- एन्कोडर, इनपुट को आम तौर पर कम डाइमेंशन वाले (इंटरमीडिएट) और लॉस वाले फ़ॉर्मैट में मैप करता है.

- डिकोडर, कम डाइमेंशन वाले फ़ॉर्मैट को ओरिजनल ज़्यादा डाइमेंशन वाले इनपुट फ़ॉर्मैट में मैप करके, ओरिजनल इनपुट का लॉस वाला वर्शन बनाता है.

ऑटोएन्कोडर को एंड-टू-एंड ट्रेनिंग दी जाती है. इसके लिए, डिकोडर, एन्कोडर के इंटरमीडिएट फ़ॉर्मैट से ओरिजनल इनपुट को फिर से बनाने की कोशिश करता है. इंटरमीडिएट फ़ॉर्मैट, ओरिजनल फ़ॉर्मैट से छोटा (कम डाइमेंशन वाला) होता है. इसलिए, ऑटोएन्कोडर को यह सीखना पड़ता है कि इनपुट में कौनसी जानकारी ज़रूरी है. साथ ही, आउटपुट, इनपुट से पूरी तरह मेल नहीं खाएगा.

उदाहरण के लिए:

- अगर इनपुट डेटा कोई ग्राफ़िक है, तो नॉन-एग्ज़ैक्ट कॉपी, ओरिजनल ग्राफ़िक से मिलती-जुलती होगी, लेकिन उसमें कुछ बदलाव किया गया होगा. ऐसा हो सकता है कि एआई की मदद से बनाई गई कॉपी, ओरिजनल ग्राफ़िक से ग़ैर-ज़रूरी चीज़ों को हटा दे या कुछ पिक्सल जोड़ दे.

- अगर इनपुट डेटा टेक्स्ट है, तो ऑटोएन्कोडर नया टेक्स्ट जनरेट करेगा. यह टेक्स्ट, ओरिजनल टेक्स्ट से मिलता-जुलता होगा, लेकिन एक जैसा नहीं होगा.

वैरिएशनल ऑटोएन्कोडर भी देखें.

ऑटो-रिग्रेसिव मॉडल

ऐसा मॉडल जो अपने पिछले अनुमानों के आधार पर अनुमान लगाता है. उदाहरण के लिए, अपने-आप कम होने वाले भाषा मॉडल, पहले से अनुमानित टोकन के आधार पर अगले टोकन का अनुमान लगाते हैं. ट्रांसफ़ॉर्मर पर आधारित सभी लार्ज लैंग्वेज मॉडल, अपने-आप रिग्रेसिव होते हैं.

इसके उलट, GAN पर आधारित इमेज मॉडल आम तौर पर अपने-आप रिग्रेसिव नहीं होते, क्योंकि ये एक फ़ॉरवर्ड-पास में इमेज जनरेट करते हैं, न कि चरणों में बार-बार. हालांकि, इमेज जनरेट करने के कुछ मॉडल अपने-आप रिग्रेसिव होते हैं, क्योंकि ये चरणों में इमेज जनरेट करते हैं.

B

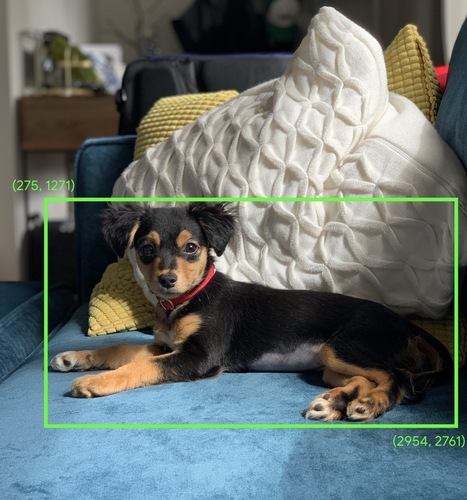

बाउंडिंग बॉक्स

किसी इमेज में, दिलचस्पी के किसी हिस्से के आस-पास मौजूद रेक्टैंगल के (x, y) निर्देशांक. जैसे, नीचे दी गई इमेज में कुत्ता.

C

कॉन्वोल्यूशन

गणित में, दो फ़ंक्शन को मिलाकर बनाया गया फ़ंक्शन. मशीन लर्निंग में, वेट को ट्रेन करने के लिए, कॉन्वोल्यूशन, कॉन्वोल्यूशनल फ़िल्टर और इनपुट मैट्रिक को मिक्स करता है.

मशीन लर्निंग में "कंवोल्यूशन" शब्द का इस्तेमाल, अक्सर कंवोल्यूशन ऑपरेशन या कंवोल्यूशन लेयर के लिए किया जाता है.

कॉन्वोल्यूशन के बिना, मशीन लर्निंग एल्गोरिदम को बड़े टेंसर में हर सेल के लिए अलग वेट सीखना होगा. उदाहरण के लिए, 2K x 2K इमेज पर ट्रेनिंग करने वाले मशीन लर्निंग एल्गोरिदम को 40 लाख अलग-अलग वेट ढूंढने होंगे. कॉन्वोल्यूशन की मदद से, मशीन लर्निंग एल्गोरिदम को सिर्फ़ कॉन्वोल्यूशनल फ़िल्टर में हर सेल के लिए वेट ढूंढना होता है. इससे, मॉडल को ट्रेन करने के लिए ज़रूरी मेमोरी काफ़ी कम हो जाती है. जब कॉन्वोल्यूशनल फ़िल्टर लागू किया जाता है, तो उसे सभी सेल में दोहराया जाता है, ताकि हर सेल में फ़िल्टर का इस्तेमाल किया जा सके.

ज़्यादा जानकारी के लिए, इमेज क्लासिफ़िकेशन कोर्स में कन्वोल्यूशनल नेटवर्क के बारे में जानकारी देखें.

कॉन्वोल्यूशनल फ़िल्टर

कन्वोल्यूशनल ऑपरेशन में मौजूद दो ऐक्टर में से एक. (दूसरा ऐक्टर, इनपुट मैट्रिक्स का एक स्लाइस है.) कॉन्वोल्यूशनल फ़िल्टर एक मैट्रिक होती है, जिसका रैंक, इनपुट मैट्रिक के रैंक जैसा होता है, लेकिन इसका साइज़ छोटा होता है. उदाहरण के लिए, 28x28 इनपुट मैट्रिक के लिए, फ़िल्टर 28x28 से छोटा कोई भी 2D मैट्रिक हो सकता है.

फ़ोटो में बदलाव करने के लिए, आम तौर पर कॉन्वोल्यूशनल फ़िल्टर की सभी सेल को एक और शून्य के एक तय पैटर्न पर सेट किया जाता है. मशीन लर्निंग में, आम तौर पर कॉन्वोल्यूशनल फ़िल्टर को रैंडम नंबर से शुरू किया जाता है. इसके बाद, नेटवर्क सही वैल्यू ट्रेन करता है.

ज़्यादा जानकारी के लिए, इमेज क्लासिफ़िकेशन कोर्स में कंवोल्यूशन देखें.

कॉन्वोल्यूशनल लेयर

डीप न्यूरल नेटवर्क की एक लेयर, जिसमें कन्वोल्यूशनल फ़िल्टर, इनपुट मैट्रिक के साथ पास होता है. उदाहरण के लिए, यहां दिया गया 3x3 कन्वोल्यूशनल फ़िल्टर देखें:

![3x3 मैट्रिक्स, जिसमें ये वैल्यू हैं: [[0,1,0], [1,0,1], [0,1,0]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalFilter33.svg?authuser=00&hl=hi)

नीचे दिया गया ऐनिमेशन, एक कॉन्वोल्यूशनल लेयर दिखाता है. इसमें 5x5 इनपुट मैट्रिक्स वाले नौ कॉन्वोल्यूशनल ऑपरेशन शामिल हैं. ध्यान दें कि हर कॉन्वोल्यूशनल ऑपरेशन, इनपुट मैट्रिक्स के अलग-अलग 3x3 स्लाइस पर काम करता है. दाईं ओर मौजूद 3x3 मैट्रिक में, नौ कॉन्वोल्यूशनल ऑपरेशन के नतीजे शामिल होते हैं:

![दो मैट्रिक दिखाने वाला ऐनिमेशन. पहला मैट्रिक्स 5x5 वाला मैट्रिक्स है: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].

दूसरा मैट्रिक्स 3x3 मैट्रिक्स है:

[[181,303,618], [115,338,605], [169,351,560]].

दूसरी मैट्रिक का हिसाब लगाने के लिए, 5x5 मैट्रिक के अलग-अलग 3x3 सबसेट पर, [[0, 1, 0], [1, 0, 1], [0, 1, 0]] कॉन्वोल्यूशनल फ़िल्टर लागू किया जाता है.](https://developers.google.cn/static/machine-learning/glossary/images/AnimatedConvolution.gif?authuser=00&hl=hi)

ज़्यादा जानकारी के लिए, इमेज क्लासिफ़िकेशन कोर्स में पूरी तरह से कनेक्ट की गई लेयर देखें.

कॉन्वोल्यूशनल न्यूरल नेटवर्क

ऐसा न्यूरल नेटवर्क जिसमें कम से कम एक लेयर, कन्वोल्यूशनल लेयर हो. आम तौर पर, कॉन्वोल्यूशनल नेटवर्क में इन लेयर का कोई कॉम्बिनेशन होता है:

कॉन्वोल्यूशनल न्यूरल नेटवर्क, कुछ तरह की समस्याओं को हल करने में काफ़ी कारगर साबित हुए हैं. जैसे, इमेज की पहचान करना.

कॉन्वोल्यूशनल ऑपरेशन

गणित का यह दो चरणों वाला ऑपरेशन:

- कन्वोल्यूशनल फ़िल्टर और इनपुट मैट्रिक्स के स्लाइस के एलिमेंट के हिसाब से गुणा करना. (इनपुट मैट्रिक्स के स्लाइस की रैंक और साइज़, कॉन्वोल्यूशनल फ़िल्टर जैसा ही होता है.)

- नतीजे के तौर पर मिलने वाले प्रॉडक्ट मैट्रिक्स में मौजूद सभी वैल्यू का योग.

उदाहरण के लिए, यहां दिया गया 5x5 इनपुट मैट्रिक देखें:

![5x5 मैट्रिक्स: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerInputMatrix.svg?authuser=00&hl=hi)

अब इस 2x2 कॉन्वोल्यूशनल फ़िल्टर की कल्पना करें:

![2x2 मैट्रिक्स: [[1, 0], [0, 1]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerFilter.svg?authuser=00&hl=hi)

हर कॉन्वोल्यूशनल ऑपरेशन में, इनपुट मैट्रिक का एक 2x2 स्लाइस शामिल होता है. उदाहरण के लिए, मान लें कि हम इनपुट मैट्रिक्स के सबसे ऊपर बाईं ओर मौजूद 2x2 स्लाइस का इस्तेमाल करते हैं. इसलिए, इस स्लाइस पर कॉन्वोल्यूशन ऑपरेशन इस तरह दिखता है:

![इनपुट मैट्रिक के सबसे ऊपर बाईं ओर मौजूद 2x2 सेक्शन, [[128,97], [35, 22]] पर कॉन्वोल्यूशनल फ़िल्टर [[1,0], [0,1]] लागू करना.

कॉन्वोल्यूशनल फ़िल्टर, 128 और 22 को पहले जैसा ही रखता है, लेकिन 97 और 35 को शून्य कर देता है. इसलिए, कॉन्वोल्यूशन ऑपरेशन से 150 (128+22) वैल्यू मिलती है.](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerOperation.svg?authuser=00&hl=hi)

कन्वोल्यूशन लेयर में, कन्वोल्यूशन ऑपरेशन की एक सीरीज़ होती है. हर ऑपरेशन, इनपुट मैट्रिक्स के अलग-अलग स्लाइस पर काम करता है.

D

डेटा बढ़ाना

ट्रेनिंग के उदाहरणों की रेंज और संख्या को कृत्रिम तरीके से बढ़ाना. इसके लिए, मौजूदा उदाहरणों को बदलकर, और उदाहरण बनाए जाते हैं. उदाहरण के लिए, मान लें कि इमेज आपकी सुविधाओं में से एक है, लेकिन आपके डेटासेट में इमेज के ज़रूरत के मुताबिक उदाहरण नहीं हैं, ताकि मॉडल काम के असोसिएशन सीख सके. आम तौर पर, अपने डेटासेट में ज़रूरत के मुताबिक लेबल की गई इमेज जोड़ी जाती हैं, ताकि आपके मॉडल को सही तरीके से ट्रेन किया जा सके. अगर ऐसा नहीं किया जा सकता, तो डेटा बढ़ाने की सुविधा, हर इमेज को घुमाकर, स्ट्रेच करके, और उसमें बदलाव करके, ओरिजनल इमेज के कई वैरिएंट बना सकती है. इससे, बेहतर ट्रेनिंग के लिए ज़रूरत के मुताबिक लेबल किया गया डेटा मिल सकता है.

डेप्थ-वाइज़ सेपरेबल कॉन्वोल्यूशनल न्यूरल नेटवर्क (sepCNN)

कन्वोल्यूशनल न्यूरल नेटवर्क का एक ऐसा आर्किटेक्चर जो Inception पर आधारित है. हालांकि, इसमें Inception मॉड्यूल को डेप्थवाइज़ सेपरेबल कन्वोल्यूशन से बदल दिया गया है. इसे Xception भी कहा जाता है.

डेप्थवाइज़ सेपरेबल कन्वोल्यूशन (जिसे सेपरेबल कन्वोल्यूशन भी कहा जाता है) एक स्टैंडर्ड 3D कन्वोल्यूशन को दो अलग-अलग कन्वोल्यूशन ऑपरेशन में फ़ैक्टर करता है. ये ऑपरेशन, कैलकुलेशन के लिहाज़ से ज़्यादा असरदार होते हैं: पहला, डेप्थवाइज़ कन्वोल्यूशन, जिसकी डेप्थ 1 (n ✕ n ✕ 1) होती है. दूसरा, पॉइंटवाइज़ कन्वोल्यूशन, जिसकी लंबाई और चौड़ाई 1 (1 ✕ 1 ✕ n) होती है.

ज़्यादा जानने के लिए, Xception: डेप्थवाइज़ सेपरेबल कॉन्वोल्यूशन के साथ डीप लर्निंग लेख पढ़ें.

डाउनसैंपलिंग

ओवरलोड किया गया शब्द, जिसका मतलब इनमें से कोई एक हो सकता है:

- किसी मॉडल को ज़्यादा बेहतर तरीके से ट्रेन करने के लिए, सुविधा में मौजूद जानकारी को कम करना. उदाहरण के लिए, इमेज पहचानने वाले मॉडल को ट्रेनिंग देने से पहले, ज़्यादा रिज़ॉल्यूशन वाली इमेज को कम रिज़ॉल्यूशन वाले फ़ॉर्मैट में बदलना.

- ज़्यादा संख्या में मौजूद क्लास के उदाहरणों के मुकाबले, कम संख्या में मौजूद उदाहरणों पर ट्रेनिंग देना. इससे, कम संख्या में मौजूद क्लास के लिए मॉडल की ट्रेनिंग को बेहतर बनाया जा सकता है. उदाहरण के लिए, क्लास के हिसाब से असंतुलित डेटासेट में, मॉडल बड़ी संख्या में मौजूद क्लास के बारे में ज़्यादा सीखते हैं और कम संख्या में मौजूद क्लास के बारे में ज़रूरत के मुताबिक नहीं सीखते. डाउनसैंपलिंग की मदद से, ज़्यादा और कम संख्या वाली क्लास के लिए ट्रेनिंग की संख्या को संतुलित किया जा सकता है.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में डेटासेट: असंतुलित डेटासेट देखें.

F

फ़ाइन-ट्यूनिंग

पहले से ट्रेन किए गए मॉडल पर, टास्क के हिसाब से दूसरा ट्रेनिंग पास किया जाता है. इससे, किसी खास इस्तेमाल के उदाहरण के लिए, मॉडल के पैरामीटर को बेहतर बनाया जा सकता है. उदाहरण के लिए, कुछ बड़े लैंग्वेज मॉडल के लिए, ट्रेनिंग का पूरा क्रम इस तरह है:

- पहले से ट्रेनिंग: किसी बड़े लैंग्वेज मॉडल को बड़े सामान्य डेटासेट पर ट्रेन करें. जैसे, अंग्रेज़ी भाषा के सभी Wikipedia पेज.

- बेहतर बनाना: पहले से ट्रेन किए गए मॉडल को खास टास्क पूरा करने के लिए ट्रेन करना. जैसे, मेडिकल क्वेरी का जवाब देना. आम तौर पर, बेहतर बनाने की प्रोसेस में किसी खास टास्क पर फ़ोकस करने वाले सैकड़ों या हज़ारों उदाहरण शामिल होते हैं.

एक और उदाहरण के तौर पर, बड़ी इमेज वाले मॉडल के लिए ट्रेनिंग का पूरा क्रम इस तरह है:

- पहले से ट्रेनिंग: बड़े इमेज मॉडल को सामान्य इमेज डेटासेट पर ट्रेन करें. जैसे, Wikimedia Commons में मौजूद सभी इमेज.

- बेहतर बनाना: पहले से ट्रेन किए गए मॉडल को खास टास्क पूरा करने के लिए ट्रेन करें. जैसे, ऑर्का की इमेज जनरेट करना.

रणनीतियों को बेहतर बनाने के लिए, इनमें से किसी भी कॉम्बिनेशन का इस्तेमाल किया जा सकता है:

- पहले से ट्रेन किए गए मॉडल के मौजूदा पैरामीटर में सभी बदलाव करना. इसे कभी-कभी पूरी तरह से फ़ाइन-ट्यून करना भी कहा जाता है.

- पहले से ट्रेन किए गए मॉडल के मौजूदा पैरामीटर में से सिर्फ़ कुछ पैरामीटर में बदलाव करना (आम तौर पर, आउटपुट लेयर के सबसे करीब वाली लेयर), जबकि अन्य मौजूदा पैरामीटर में कोई बदलाव न करना (आम तौर पर, इनपुट लेयर के सबसे करीब वाली लेयर). पैरामीटर-बेहतर ट्यूनिंग देखें.

- ज़्यादा लेयर जोड़ना. आम तौर पर, ये लेयर आउटपुट लेयर के सबसे करीब मौजूद मौजूदा लेयर के ऊपर जोड़ी जाती हैं.

फ़ाइन-ट्यूनिंग, ट्रांसफ़र लर्निंग का एक तरीका है. इसलिए, फ़ाइन-ट्यूनिंग में, पहले से ट्रेन किए गए मॉडल को ट्रेन करने के लिए इस्तेमाल किए गए लॉस फ़ंक्शन या मॉडल टाइप के बजाय, किसी दूसरे लॉस फ़ंक्शन या मॉडल टाइप का इस्तेमाल किया जा सकता है. उदाहरण के लिए, पहले से ट्रेन किए गए बड़े इमेज मॉडल को बेहतर बनाकर, ऐसा रिग्रेशन मॉडल बनाया जा सकता है जो किसी इनपुट इमेज में पक्षियों की संख्या बताता है.

यहां दिए गए शब्दों के साथ, फ़ाइन-ट्यूनिंग की तुलना करें:

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में बेहतर बनाना देखें.

G

Gemini

यह नेटवर्क, Google के सबसे बेहतर एआई से बना है. इस नेटवर्क में ये चीज़ें शामिल हैं:

- Gemini के अलग-अलग मॉडल.

- Gemini मॉडल के लिए, इंटरैक्टिव बातचीत वाला इंटरफ़ेस. उपयोगकर्ता प्रॉम्प्ट टाइप करते हैं और Gemini उन प्रॉम्प्ट का जवाब देता है.

- Gemini के अलग-अलग एपीआई.

- Gemini मॉडल पर आधारित कारोबार के लिए अलग-अलग प्रॉडक्ट. उदाहरण के लिए, Google Cloud के लिए Gemini.

Gemini मॉडल

Google के सबसे आधुनिक ट्रांसफ़ॉर्मर-आधारित मल्टीमोडल मॉडल. Gemini मॉडल को खास तौर पर, एजेंट के साथ इंटिग्रेट करने के लिए डिज़ाइन किया गया है.

उपयोगकर्ता, Gemini मॉडल के साथ कई तरीकों से इंटरैक्ट कर सकते हैं. जैसे, इंटरैक्टिव डायलॉग इंटरफ़ेस और SDKs की मदद से.

जनरेटिव एआई

यह एक ऐसा फ़ील्ड है जो बदलावों को बढ़ावा देता है. हालांकि, इसकी कोई आधिकारिक परिभाषा नहीं है. हालांकि, ज़्यादातर विशेषज्ञ इस बात से सहमत हैं कि जनरेटिव एआई मॉडल, ऐसा कॉन्टेंट बना सकते हैं ("जनरेट" कर सकते हैं) जो इन सभी चीज़ों के मुताबिक हो:

- जटिल

- एक-दूसरे से जुड़े हुए

- मूल

उदाहरण के लिए, जनरेटिव एआई मॉडल बेहतरीन तरह के लेख या इमेज बना सकता है.

LSTMs और RNNs जैसी कुछ पुरानी टेक्नोलॉजी से भी ओरिजनल और एक जैसा कॉन्टेंट जनरेट किया जा सकता है. कुछ विशेषज्ञ इन पुरानी टेक्नोलॉजी को जनरेटिव एआई मानते हैं, जबकि कुछ का मानना है कि असल जनरेटिव एआई के लिए, ज़्यादा जटिल आउटपुट की ज़रूरत होती है, जो इन पुरानी टेक्नोलॉजी से नहीं मिल सकता.

अनुमानित एमएल के साथ तुलना करें.

I

इमेज पहचानने की सुविधा

ऐसी प्रोसेस जो किसी इमेज में मौजूद ऑब्जेक्ट, पैटर्न या कॉन्सेप्ट को अलग-अलग कैटगरी में बांटती है. इमेज की पहचान करने की सुविधा को इमेज का क्लासिफ़िकेशन भी कहा जाता है.

ज़्यादा जानकारी के लिए, एमएल प्रैक्टिकम: इमेज को अलग-अलग कैटगरी में बांटना देखें.

ज़्यादा जानकारी के लिए, एमएल प्रैक्टिकम: इमेज का क्लासिफ़िकेशन करने वाला कोर्स देखें.

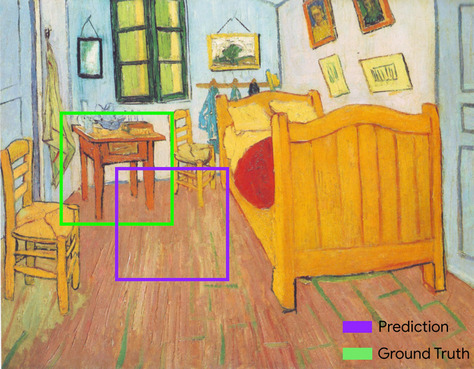

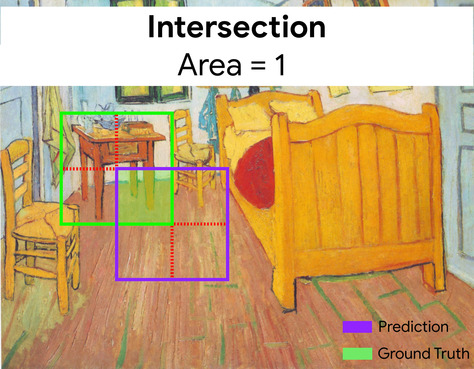

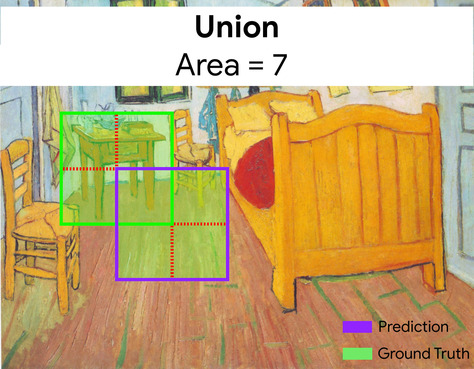

इंटरसेक्शन ओवर यूनियन (IoU)

दो सेट के इंटरसेक्शन को उनके यूनियन से भाग दिया जाता है. मशीन लर्निंग की मदद से इमेज की पहचान करने वाले टास्क में, IoU का इस्तेमाल करके यह मेज़र किया जाता है कि मॉडल के अनुमानित बाउंडिंग बॉक्स की तुलना में, ग्राउंड-ट्रूथ बाउंडिंग बॉक्स कितना सटीक है. इस मामले में, दोनों बॉक्स के लिए IoU, ओवरलैप होने वाले हिस्से और पूरे हिस्से के बीच का अनुपात होता है. इसकी वैल्यू 0 से 1 के बीच होती है. 0 का मतलब है कि अनुमानित बॉउंडिंग बॉक्स और ग्राउंड-ट्रूथ बॉउंडिंग बॉक्स ओवरलैप नहीं होते. वहीं, 1 का मतलब है कि अनुमानित बॉउंडिंग बॉक्स और ग्राउंड-ट्रूथ बॉउंडिंग बॉक्स के कोऑर्डिनेट एक जैसे होते हैं.

उदाहरण के लिए, नीचे दी गई इमेज में:

- अनुमानित बाउंडिंग बॉक्स (पेंटिंग में मॉडल के अनुमानित नाइट टेबल के कोऑर्डिनेट) को बैंगनी रंग में दिखाया गया है.

- ग्राउंड-ट्रूथ बाउंडिंग बॉक्स (पेंटिंग में नाइट टेबल की असल जगह की जानकारी देने वाले निर्देशांक) को हरे रंग में दिखाया गया है.

यहां, अनुमान और ज़मीनी सच्चाई (नीचे बाईं ओर) के बाउंडिंग बॉक्स का इंटरसेक्शन 1 है और अनुमान और ज़मीनी सच्चाई (नीचे दाईं ओर) के बाउंडिंग बॉक्स का यूनियन 7 है. इसलिए, IoU \(\frac{1}{7}\)है.

K

keypoints

किसी इमेज में मौजूद खास चीज़ों के निर्देशांक. उदाहरण के लिए, इमेज की पहचान करने वाले ऐसे मॉडल के लिए, जिसमें फूल की प्रजातियों में अंतर किया जाता है, मुख्य पॉइंट हर पंखुड़ी का बीच, डंठल, और स्टैमन वगैरह हो सकते हैं.

L

लैंडमार्क

खास जानकारी के लिए इस्तेमाल होने वाला समानार्थी शब्द.

M

MMIT

मल्टीमोडल निर्देश-ट्यून के लिए छोटा नाम.

MNIST

यह एक सार्वजनिक डोमेन डेटासेट है, जिसे LeCun, Cortes,और Burges ने इकट्ठा किया है. इसमें 60, 000 इमेज हैं. हर इमेज में यह दिखाया गया है कि किसी व्यक्ति ने 0 से 9 के बीच के किसी अंक को मैन्युअल तरीके से कैसे लिखा है. हर इमेज को 28x28 इंटिजर के ऐरे के तौर पर सेव किया जाता है. इसमें हर इंटिजर, ग्रेस्केल वैल्यू होती है, जो 0 से 255 के बीच होती है.

MNIST, मशीन लर्निंग के लिए एक कैननिकल डेटासेट है. इसका इस्तेमाल, अक्सर मशीन लर्निंग के नए तरीकों की जांच करने के लिए किया जाता है. ज़्यादा जानकारी के लिए, हाथ से लिखे गए अंकों का MNIST डेटाबेस देखें.

MOE

विशेषज्ञों के मिश्रण का छोटा नाम.

P

पूल करना

किसी मैट्रिक (या मैट्रिक) को छोटा करना, जिसे पहले बनाई गई कन्वोल्यूशनल लेयर ने बनाया है. आम तौर पर, पूल किए गए एरिया में ज़्यादा से ज़्यादा या औसत वैल्यू ली जाती है. उदाहरण के लिए, मान लें कि हमारे पास यह 3x3 मैट्रिक्स है:

![3x3 मैट्रिक्स [[5,3,1], [8,2,5], [9,4,3]].](https://developers.google.cn/static/machine-learning/glossary/images/PoolingStart.svg?authuser=00&hl=hi)

पूलिंग ऑपरेशन, कॉन्वोल्यूशनल ऑपरेशन की तरह ही, उस मैट्रिक्स को स्लाइस में बांटता है. इसके बाद, उस कॉन्वोल्यूशनल ऑपरेशन को स्ट्राइड के हिसाब से स्लाइड करता है. उदाहरण के लिए, मान लें कि पूल करने की प्रोसेस, कॉन्वोल्यूशनल मैट्रिक्स को 1x1 स्ट्राइड के साथ 2x2 स्लाइस में बांटती है. नीचे दिए गए डायग्राम में दिखाया गया है कि पूल करने के चार तरीके हैं. मान लें कि पूल करने की हर कार्रवाई, उस स्लाइस में चार में से सबसे बड़ी वैल्यू चुनती है:

![इनपुट मैट्रिक्स 3x3 है और इसमें ये वैल्यू हैं: [[5,3,1], [8,2,5], [9,4,3]].

इनपुट मैट्रिक की सबसे ऊपर बाईं ओर मौजूद 2x2 सबमैट्रिक [[5,3], [8,2]] है. इसलिए, सबसे ऊपर बाईं ओर पूल करने पर वैल्यू 8 मिलती है. यह वैल्यू, 5, 3, 8, और 2 में से सबसे ज़्यादा है. इनपुट मैट्रिक की सबसे ऊपर दाईं ओर मौजूद 2x2 सबमैट्रिक [[3,1], [2,5]] है. इसलिए, सबसे ऊपर दाईं ओर पूल करने पर वैल्यू 5 मिलती है. इनपुट मैट्रिक की सबसे नीचे बाईं ओर मौजूद 2x2 सबमैट्रिक,

[[8,2], [9,4]] है. इसलिए, सबसे नीचे बाईं ओर पूल करने पर वैल्यू

9 मिलती है. इनपुट मैट्रिक की सबसे नीचे दाईं ओर मौजूद 2x2 सबमैट्रिक,

[[2,5], [4,3]] है. इसलिए, सबसे नीचे दाईं ओर पूल करने पर वैल्यू

5 मिलती है. खास जानकारी के तौर पर, पूल करने की प्रोसेस से 2x2 मैट्रिक्स मिलती है

[[8,5], [9,5]].](https://developers.google.cn/static/machine-learning/glossary/images/PoolingConvolution.svg?authuser=00&hl=hi)

पूल करने से, इनपुट मैट्रिक में ट्रांसलेशन इनवैरिएंस लागू करने में मदद मिलती है.

विज़न ऐप्लिकेशन के लिए पूल करने की प्रोसेस को स्पेशल पूलिंग कहा जाता है. टाइम सीरीज़ वाले ऐप्लिकेशन में, आम तौर पर पूल करने की प्रोसेस को समय के हिसाब से पूल करना कहा जाता है. आम तौर पर, पूल करने की प्रोसेस को सबसैंपलिंग या डाउनसैंपलिंग कहा जाता है.

ट्रेनिंग के बाद का मॉडल

यह एक ऐसा शब्द है जिसे अलग-अलग तरीके से परिभाषित किया जा सकता है. आम तौर पर, इसका मतलब पहले से ट्रेन किए गए मॉडल से होता है, जिसे पोस्ट-प्रोसेसिंग के कुछ चरणों से गुज़रना पड़ा है. जैसे, इनमें से एक या एक से ज़्यादा चरण:

पहले से ट्रेन किया गया मॉडल

आम तौर पर, ऐसा मॉडल जिसे पहले ही ट्रेन किया जा चुका है. इस शब्द का मतलब, पहले से ट्रेन किए गए एम्बेडिंग वेक्टर से भी हो सकता है.

पहले से ट्रेन किए गए लैंग्वेज मॉडल का मतलब आम तौर पर, पहले से ट्रेन किए गए बड़े लैंग्वेज मॉडल से होता है.

प्री-ट्रेनिंग

बड़े डेटासेट पर मॉडल की शुरुआती ट्रेनिंग. पहले से ट्रेन किए गए कुछ मॉडल, बड़े और जटिल होते हैं. आम तौर पर, उन्हें अतिरिक्त ट्रेनिंग देकर बेहतर बनाया जाता है. उदाहरण के लिए, एमएल विशेषज्ञ किसी बड़े टेक्स्ट डेटासेट पर, बड़े लैंग्वेज मॉडल को पहले से ट्रेन कर सकते हैं. जैसे, विकिपीडिया के सभी अंग्रेज़ी पेज. प्री-ट्रेनिंग के बाद, इनमें से किसी भी तकनीक का इस्तेमाल करके, मॉडल को और बेहतर बनाया जा सकता है:

R

रोटेशन इनवैरिएंस

इमेज को अलग-अलग कैटगरी में बांटने की समस्या में, एल्गोरिदम की यह क्षमता कि वह इमेज के ओरिएंटेशन में बदलाव होने पर भी, इमेज को अलग-अलग कैटगरी में बांट सके. उदाहरण के लिए, एल्गोरिदम अब भी टेनिस रैकेट की पहचान कर सकता है, भले ही वह ऊपर, बगल में या नीचे की ओर हो. ध्यान दें कि रोटेशन इनवैरिएंस हमेशा काम का नहीं होता; उदाहरण के लिए, उलटे 9 को 9 के तौर पर नहीं माना जाना चाहिए.

ट्रांसलेशनल इनवैरिएंस और साइज़ इनवैरिएंस भी देखें.

S

साइज़ में बदलाव न होना

इमेज को अलग-अलग कैटगरी में बांटने से जुड़ी समस्या में, एल्गोरिदम की यह क्षमता कि वह इमेज के साइज़ में बदलाव होने के बावजूद, इमेज को अलग-अलग कैटगरी में बांट सके. उदाहरण के लिए, एल्गोरिदम अब भी बिल्ली की पहचान कर सकता है, भले ही उसमें 20 लाख पिक्सल या 2 लाख पिक्सल का इस्तेमाल किया गया हो. ध्यान दें कि इमेज को अलग-अलग कैटगरी में बांटने वाले सबसे अच्छे एल्गोरिदम के लिए भी, साइज़ में बदलाव होने पर इमेज की पहचान करने की सुविधा काम नहीं करती. उदाहरण के लिए, किसी ऐल्गोरिदम (या इंसान) के लिए, सिर्फ़ 20 पिक्सल वाली बिल्ली की इमेज को सही तरीके से कैटगरी में बांटना मुश्किल है.

ट्रांसलेशनल इनवैरिएंस और रोटेशनल इनवैरिएंस भी देखें.

स्पेसिएल पूलिंग

पूलिंग देखें.

स्ट्राइड

कॉन्वोल्यूशनल ऑपरेशन या पूलिंग में, इनपुट स्लाइस की अगली सीरीज़ के हर डाइमेंशन में डेल्टा. उदाहरण के लिए, यहां दिया गया ऐनिमेशन, कॉन्वोल्यूशनल ऑपरेशन के दौरान (1,1) स्ट्राइड दिखाता है. इसलिए, अगला इनपुट स्लाइस, पिछले इनपुट स्लाइस की दाईं ओर से शुरू होता है. जब ऑपरेशन दाएं किनारे तक पहुंच जाता है, तो अगला स्लाइस पूरी तरह से बाईं ओर होता है, लेकिन एक पोज़िशन नीचे होता है.

पिछले उदाहरण में, दो डाइमेंशन वाली स्ट्राइड दिखाई गई है. अगर इनपुट मैट्रिक तीन डाइमेंशन वाली है, तो स्ट्राइड भी तीन डाइमेंशन वाली होगी.

सब-सैंपलिंग

पूलिंग देखें.

T

तापमान

हाइपरपैरामीटर, जो मॉडल के आउटपुट के लिए, यादृच्छिकता की डिग्री को कंट्रोल करता है. ज़्यादा तापमान पर, रैंडम आउटपुट ज़्यादा मिलता है, जबकि कम तापमान पर रैंडम आउटपुट कम मिलता है.

सबसे सही तापमान चुनना, खास ऐप्लिकेशन और मॉडल के आउटपुट की पसंदीदा प्रॉपर्टी पर निर्भर करता है. उदाहरण के लिए, क्रिएटिव आउटपुट जनरेट करने वाला ऐप्लिकेशन बनाते समय, शायद आप टेंपरेचर बढ़ाना चाहें. इसके उलट, इमेज या टेक्स्ट को अलग-अलग कैटगरी में बांटने वाले मॉडल को बनाते समय, शायद आप तापमान को कम कर दें. इससे मॉडल की सटीकता और एक जैसी परफ़ॉर्मेंस को बेहतर बनाया जा सकता है.

तापमान का इस्तेमाल अक्सर softmax के साथ किया जाता है.

ट्रांसलेशनल इनवैरिएंस

इमेज को अलग-अलग कैटगरी में बांटने की समस्या में, एल्गोरिदम की यह क्षमता कि वह इमेज में ऑब्जेक्ट की पोज़िशन बदलने पर भी, इमेज को अलग-अलग कैटगरी में बांट सके. उदाहरण के लिए, एल्गोरिदम अब भी कुत्ते की पहचान कर सकता है, भले ही वह फ़्रेम के बीच में हो या फ़्रेम के बाईं ओर.

साइज़ में बदलाव न होना और रोटेशन में बदलाव न होना भी देखें.