Diese Seite enthält Glossarbegriffe für Image-Modelle. Alle Glossarbegriffe finden Sie hier.

A

augmented reality

Eine Technologie, die ein computergeneriertes Bild der Sicht eines Nutzers der realen Welt überlagert und so eine zusammengesetzte Ansicht bietet.

Autoencoder

Ein System, das lernt, die wichtigsten Informationen aus der Eingabe zu extrahieren. Autoencoder sind eine Kombination aus einem Encoder und Decoder. Autoencoder nutzen den folgenden zweistufigen Prozess:

- Der Encoder ordnet die Eingabe einem (üblicherweise) verlustbehafteten Format mit niedrigeren Dimensionen zu.

- Der Decoder erstellt eine verlustbehaftete Version der ursprünglichen Eingabe, indem er das niedrigerdimensionale Format dem ursprünglichen höherdimensionalen Eingabeformat zuordnet.

Autoencoder werden durchgängig trainiert. Dabei versucht der Decoder, die ursprüngliche Eingabe möglichst genau aus dem Zwischenformat des Encoders zu rekonstruieren. Da das Zwischenformat kleiner (niedrigerdimensional) als das Originalformat ist, muss der Autoencoder lernen, welche Informationen in der Eingabe wichtig sind, und die Ausgabe ist nicht perfekt mit der Eingabe identisch.

Beispiel:

- Wenn es sich bei den Eingabedaten um eine Grafik handelt, würde die nicht exakte Kopie der Originalgrafik ähnlich, aber etwas abgeändert sein. Vielleicht entfernt die nicht exakte Kopie das Rauschen aus der Originalgrafik oder füllt einige fehlende Pixel auf.

- Wenn die Eingabedaten Text sind, generiert ein Autoencoder neuen Text, der den Originaltext imitiert (aber nicht damit identisch ist).

Siehe auch Verschiedene Autoencoder.

automatisch-regressives Modell

Ein model, das eine Vorhersage anhand seiner eigenen vorherigen Vorhersagen ableitet. Autoregressive Sprachmodelle sagen beispielsweise das nächste Token anhand der zuvor vorhergesagten Tokens voraus. Alle Large Language Models, die auf Transformer basieren, sind automatisch regressiv.

Im Gegensatz dazu sind GAN-basierte Bildmodelle normalerweise nicht automatisch regressiv, da sie ein Bild in einem einzigen Vorwärtsdurchlauf und nicht iterativ in Schritten generieren. Bestimmte Bildgenerierungsmodelle sind jedoch automatisch regressiv, da sie ein Bild schrittweise generieren.

B

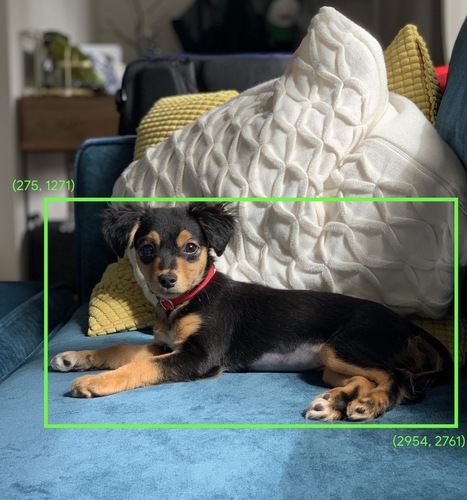

Begrenzungsrahmen

In einem Bild die Koordinaten (x, y) eines Rechtecks um einen Interessenbereich, z. B. den Hund im Bild unten.

C

Faltung

In der Mathematik, beiläufig gesagt, eine Mischung aus zwei Funktionen. Beim maschinellen Lernen werden bei einer Faltung der Convolutional-Filter und die Eingabematrix vermischt, um Gewichtungen zu trainieren.

Der Begriff „Faltung“ im maschinellen Lernen ist oft eine Abkürzung für Faltungsvorgang oder Faltungsschicht.

Ohne Faltungen müsste ein Algorithmus für maschinelles Lernen eine separate Gewichtung für jede Zelle in einem großen Tensor lernen. Beispielsweise müsste bei einem Training eines Algorithmus für maschinelles Lernen mit Bildern mit 2.000 × 2.000 Bildern 4 Millionen separate Gewichtungen ermittelt werden. Dank Faltungen muss ein Algorithmus für maschinelles Lernen nur die Gewichtung für jede Zelle im Faltungsfilter ermitteln. Dadurch wird der zum Trainieren des Modells erforderliche Arbeitsspeicher drastisch reduziert. Wenn der Faltungsfilter angewendet wird, wird er einfach über die Zellen hinweg repliziert, sodass jede Zelle mit dem Filter multipliziert wird.

Faltungsfilter

Einer der beiden Akteure bei einem Faltungsvorgang. (Der andere Akteur ist ein Slice einer Eingabematrix.) Ein Faltungsfilter ist eine Matrix, die denselben Rang wie die Eingabematrix, aber eine kleinere Form hat. Bei einer 28 x 28-Eingabematrix kann der Filter beispielsweise eine beliebige 2D-Matrix sein, die kleiner als 28 x 28 ist.

Bei der fotografischen Bearbeitung sind alle Zellen in einem Faltungsfilter in der Regel auf ein konstantes Muster von Einsen und Nullen eingestellt. Beim maschinellen Lernen werden Faltungsfilter in der Regel mit Zufallszahlen gesetzt. Anschließend trainiert das Netzwerk die idealen Werte.

Convolutional Layer

Eine Ebene eines neuronalen Deep-Learning-Netzwerks, in der ein Convolutionalfilter eine Eingabematrix durchläuft. Betrachten Sie beispielsweise den folgenden Convolutional-Filter (3 x 3):

![Eine 3x3-Matrix mit den folgenden Werten: [[0,1,0], [1,0,1], [0,1,0]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalFilter33.svg?authuser=2&hl=de)

Die folgende Animation zeigt eine Faltungsschicht, die aus neun Faltungsvorgängen besteht, die die 5x5-Eingabematrix einbeziehen. Beachten Sie, dass jeder Faltungsvorgang mit einem anderen 3x3-Slice der Eingabematrix funktioniert. Die resultierende 3x3-Matrix (rechts) besteht aus den Ergebnissen der 9 Faltungsoperationen:

![Eine Animation mit zwei Matrizen. Die erste Matrix ist die 5x5-Matrix: [[128,97,53,201,198], [35,22,25,200,195], [37,24,28,197,182], [33,28,92,195,179],101740

Die zweite Matrix ist die 3x3-Matrix: [[181,303,618], [115,338,605], [169,351,560]].

Die zweite Matrix wird berechnet, indem der Faltungsfilter [[0, 1, 0], [1, 0, 1], [0, 1, 0]] auf verschiedene 3x3-Teilmengen der 5x5-Matrix angewendet wird.](https://developers.google.cn/static/machine-learning/glossary/images/AnimatedConvolution.gif?authuser=2&hl=de)

Convolutional Neural Network

Ein neuronales Netzwerk, in dem mindestens eine Schicht eine Faltungsschicht ist. Ein typisches neuronales Faltungsnetzwerk besteht aus einer Kombination der folgenden Schichten:

Convolutional Neural Networks waren bei bestimmten Problemen wie der Bilderkennung sehr erfolgreich.

Faltungsvorgang

Die folgende zweistufige mathematische Operation:

- Elementweise Multiplikation des Faltungsfilters und eines Slice einer Eingabematrix. (Das Slice der Eingabematrix hat denselben Rang und dieselbe Größe wie der Faltungsfilter.)

- Summe aller Werte in der resultierenden Produktmatrix.

Betrachten Sie zum Beispiel die folgende 5x5-Eingabematrix:

![Die 5x5-Matrix: [[128,97,53,201,198], [35,22,25,200,195], [37,24,28,197,182], [33,28,92,195,179], [31,40]2,17,1](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerInputMatrix.svg?authuser=2&hl=de)

Stellen Sie sich nun den folgenden 2x2-Faltungsfilter vor:

![Die 2x2-Matrix: [[1, 0], [0, 1]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerFilter.svg?authuser=2&hl=de)

Jeder Faltungsvorgang umfasst ein einzelnes 2x2-Slice der Eingabematrix. Angenommen, wir verwenden das 2x2-Slice oben links in der Eingabematrix. Der Faltungsvorgang für dieses Slice sieht also so aus:

![Anwenden des Faltungsfilters [[1, 0], [0, 1]] auf den oberen linken 2x2-Abschnitt der Eingabematrix, also [[128,97], [35,22]],

Der Faltungsfilter lässt die Werte 128 und 22 intakt, aber 97 und 35 werden auf Null gesetzt. Folglich ergibt der Faltungsvorgang den Wert 150 (128 + 22).](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerOperation.svg?authuser=2&hl=de)

Eine Faltungsschicht besteht aus einer Reihe von Faltungsvorgängen, die jeweils auf einen anderen Abschnitt der Eingabematrix wirken.

D

Datenerweiterung

Die Reichweite und Anzahl der Trainingsbeispiele werden durch Umwandlung vorhandener Beispiele in zusätzliche Beispiele künstlich erhöht. Angenommen, Bilder gehören zu Ihren Features, aber Ihr Dataset enthält nicht genügend Bildbeispiele für das Modell, um nützliche Verknüpfungen zu lernen. Idealerweise fügen Sie dem Dataset genügend Bilder mit Labels hinzu, damit das Modell ordnungsgemäß trainieren kann. Wenn dies nicht möglich ist, kann die Datenerweiterung jedes Bild rotieren, strecken und reflektieren, um viele Varianten des Originalbilds zu generieren. Möglicherweise werden genügend Daten mit Labels geliefert, um ein hervorragendes Training zu ermöglichen.

Deeplink-separable Convolutional Neural Network (sepCNN)

Eine Architektur des Convolutional Neural Network, die auf Inception basiert, in der Inception-Module jedoch durch tief trennbare Faltungen ersetzt werden. Auch als Xception bezeichnet.

Eine tief trennbare Faltung (auch als trennbare Faltung abgekürzt) umfasst eine Standardfaltung in 3D in zwei separate Faltungsvorgänge, die recheneffizienter sind: zuerst eine tiefenweise Faltung mit einer Tiefe von 1 (n × n × 1) und dann eine punktweise Faltung mit einer Länge und Breite von 1 (1 × n).

Weitere Informationen finden Sie unter Xception: Deep Learning with Depthwise Separable Convolutions.

Downsampling

Überlastete Begriffe, die Folgendes bedeuten können:

- Die Informationsmenge in einem Feature reduzieren, um ein Modell effizienter zu trainieren. Bevor Sie beispielsweise ein Bilderkennungsmodell trainieren, reduzieren Sie Bilder mit hoher Auflösung auf ein Format mit geringerer Auflösung.

- Training mit einem unverhältnismäßig niedrigen Prozentsatz der überrepräsentierten Klassenbeispiele, um das Modelltraining für unterrepräsentierte Klassen zu verbessern. In einem Dataset ohne Klassenausgleich lernen Modelle beispielsweise viel über die Mehrheitsklasse und nicht genug über die Minderheitenklasse. Downsampling hilft dabei, ein ausgewogenes Verhältnis des Trainingsumfangs auf die Mehrheits- und Minderheitenklassen zu finden.

F

Abstimmung

Ein zweiter, aufgabenspezifischer Trainingspass, der mit einem vortrainierten Modell ausgeführt wird, um seine Parameter für einen bestimmten Anwendungsfall zu optimieren. Für einige Large Language Models sieht der vollständige Trainingsablauf beispielsweise so aus:

- Vortraining: Trainieren Sie ein Large Language Model mit einem riesigen allgemeinen Dataset, z. B. allen englischsprachigen Wikipedia-Seiten.

- Feinabstimmung:Trainieren Sie das vortrainierte Modell für die Ausführung einer bestimmten Aufgabe, z. B. zum Antworten auf medizinische Anfragen. Die Feinabstimmung umfasst in der Regel Hunderte oder Tausende von Beispielen, die auf die jeweilige Aufgabe ausgerichtet sind.

Als weiteres Beispiel sieht die vollständige Trainingssequenz für ein Modell mit großen Bildern so aus:

- Vortraining:Trainieren Sie ein Modell mit großen Bildern anhand eines umfangreichen allgemeinen Bild-Datasets, z. B. mit allen Bildern in Wikimedia Commons.

- Feinabstimmung:Trainieren Sie das vortrainierte Modell für die Ausführung einer bestimmten Aufgabe, z. B. zum Generieren von Bildern von Orcas.

Die Optimierung kann eine beliebige Kombination der folgenden Strategien umfassen:

- Alle vorhandenen Parameter des vortrainierten Modells ändern. Dies wird auch als vollständige Feinabstimmung bezeichnet.

- Nur einige der vorhandenen Parameter des vortrainierten Modells ändern (in der Regel die Ebenen, die der Ausgabeschicht am nächsten sind) und andere vorhandene Parameter unverändert lassen (in der Regel die Ebenen, die der Eingabeebene am nächsten sind). Siehe parametersparende Abstimmung.

- Weitere Ebenen hinzufügen, in der Regel auf den vorhandenen Ebenen, die der Ausgabeschicht am nächsten sind

Abstimmung ist eine Form des Lerntransfers. Daher kann bei der Feinabstimmung eine andere Verlustfunktion oder ein anderer Modelltyp als der zum Trainieren des vortrainierten Modells verwendet werden. Sie könnten beispielsweise ein vortrainiertes großes Bildmodell optimieren, um ein Regressionsmodell zu erstellen, das die Anzahl der Vögel in einem Eingabebild zurückgibt.

Die Feinabstimmung mit den folgenden Begriffen vergleichen und gegenüberstellen:

G

Generative AI

Ein aufstrebendes transformatives Feld ohne formale Definition. Dennoch sind sich die meisten Experten einig, dass Generative-AI-Modelle folgende Inhalte erstellen („generieren“) können:

- Komplex

- kohärent

- ursprünglich

Ein generatives KI-Modell kann beispielsweise anspruchsvolle Aufsätze oder Bilder erstellen.

Einige ältere Technologien, einschließlich LSTMs und RNNs, können auch eigene und kohärente Inhalte generieren. Einige Experten betrachten diese früheren Technologien als Generative AI, während andere der Meinung sind, dass echte Generative AI komplexere Ausgaben erfordert, als diese früheren Technologien liefern können.

Kontrast mit Prognose-ML

I

bilderkennung

Ein Prozess zum Klassifizieren von Objekten, Mustern oder Konzepten in einem Bild. Die Bilderkennung wird auch als Bildklassifizierung bezeichnet.

Weitere Informationen finden Sie unter ML-Praxis: Bildklassifizierung.

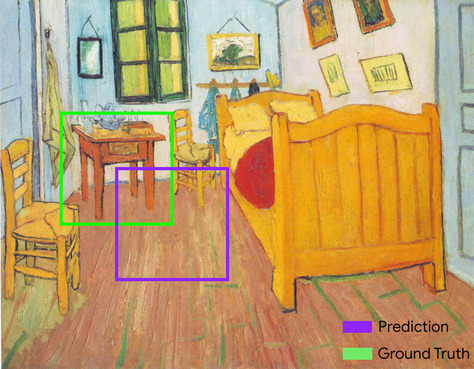

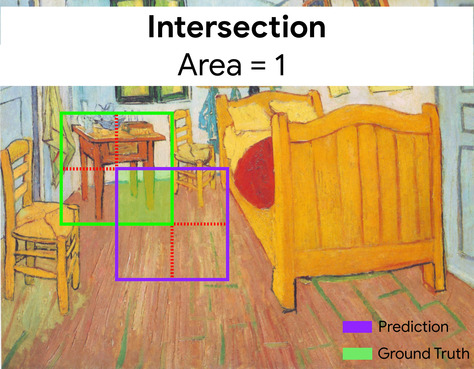

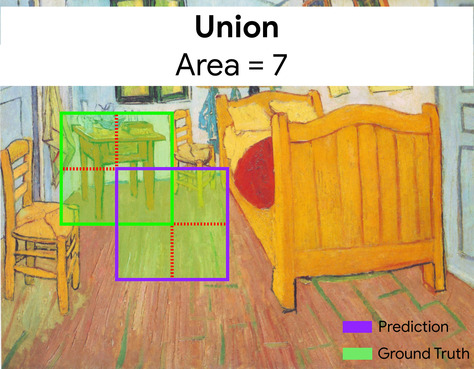

Schnittmenge über Union (IoU)

Die Schnittmenge zweier Mengen geteilt durch ihre Vereinigung. Bei der Bilderkennung durch maschinelles Lernen wird IoU verwendet, um die Genauigkeit des vorhergesagten Begrenzungsrahmens des Modells in Bezug auf den Ground-Truth-Begrenzungsrahmen zu messen. In diesem Fall ist die IoU für die beiden Rahmen das Verhältnis zwischen dem überlappenden Bereich und der Gesamtfläche. Ihr Wert reicht von 0 (keine Überschneidung des vorhergesagten Begrenzungsrahmens und Ground-Truth-Begrenzungsrahmens) bis 1 (der vorhergesagte Begrenzungsrahmen und der Ground-Truth-Begrenzungsrahmen haben exakt dieselben Koordinaten).

Hier ein Beispiel:

- Der vorhergesagte Begrenzungsrahmen (die Koordinaten, durch die sich der Ort der Nachttabelle im Gemälde vom Modell begrenzt) wird lila dargestellt.

- Der Ground-Truth-Begrenzungsrahmen (die Koordinaten, die den tatsächlichen Standort der Nachttabelle im Gemälde begrenzen) ist grün umrandet.

Hier beträgt die Schnittmenge der Begrenzungsrahmen für Vorhersage und Ground Truth (unten links) 1 und die Union der Begrenzungsrahmen für Vorhersage und Ground Truth (unten rechts) ist 7, sodass der IoU \(\frac{1}{7}\)ist.

K

Keypoints

Die Koordinaten bestimmter Elemente in einem Bild. Bei einem Bilderkennungsmodell, das Blumenarten unterscheidet, können beispielsweise Schlüsselpunkte der Mittelpunkt der einzelnen Blütenblätter, der Stamm, der Stapel usw. sein.

L

landmarks

Synonym für Schlüsselpunkte.

M

MNIST

Ein von LeCun, Cortes und Burges zusammengestelltes öffentliches Dataset mit 60.000 Bildern, auf denen jeweils zu sehen ist, wie ein Mensch eine bestimmte Ziffer von 0 bis 9 manuell geschrieben hat. Jedes Bild wird als 28 × 28-Array aus Ganzzahlen gespeichert, wobei jede Ganzzahl ein Graustufenwert zwischen 0 und 255 ist.

MNIST ist ein kanonisches Dataset für maschinelles Lernen, das häufig zum Testen neuer Ansätze für maschinelles Lernen verwendet wird. Weitere Informationen finden Sie in der MNIST-Datenbank für handschriftliche Ziffern.

P

Pooling

Die Matrix (oder Matrix), die von einer früheren Faltungsschicht erstellt wurde, werden auf eine kleinere Matrix reduziert. Beim Pooling wird in der Regel entweder der Maximal- oder der Durchschnittswert über den Poolbereich hinweg ermittelt. Angenommen, wir haben die folgende 3x3-Matrix:

![Die 3x3-Matrix [[5,3,1], [8,2,5], [9,4,3]].](https://developers.google.cn/static/machine-learning/glossary/images/PoolingStart.svg?authuser=2&hl=de)

Bei einem Pooling-Vorgang wird die Matrix genau wie bei einer Faltung in Segmente aufgeteilt und diese Faltungsfunktion wird dann in Schritte gleitet. Angenommen, die Pooling-Operation teilt die Faltungsmatrix in 2x2-Slices mit einem 1x1-Schritt auf. Wie das folgende Diagramm zeigt, finden vier Pooling-Vorgänge statt. Angenommen, jeder Pooling-Vorgang wählt den Maximalwert der vier in diesem Slice aus:

![Die Eingabematrix ist 3x3 mit den Werten: [[5,3,1], [8,2,5], [9,4,3]].

Die 2x2-Submatrix oben links der Eingabematrix ist [[5,3], [8,2]], sodass der Pooling-Vorgang oben links den Wert 8 ergibt (das Maximum von 5, 3, 8 und 2). Die 2x2-Submatrix oben rechts der Eingabematrix ist [[3,1], [2,5]], sodass der Pooling-Vorgang oben rechts den Wert 5 liefert. Die 2x2-Submatrix unten links der Eingabematrix ist [[8,2], [9,4]], sodass der Pooling-Vorgang unten links den Wert 9 liefert. Die 2x2-Submatrix unten rechts der Eingabematrix ist [[2,5], [4,3]], sodass der Pooling-Vorgang unten rechts den Wert 5 liefert. Zusammenfassend lässt sich sagen, dass der Pooling-Vorgang die 2x2-Matrix [[8,5], [9,5]] liefert.](https://developers.google.cn/static/machine-learning/glossary/images/PoolingConvolution.svg?authuser=2&hl=de)

Pooling hilft bei der Durchsetzung einer Übersetzungsinvarianz in der Eingabematrix.

Pooling für Vision-Anwendungen wird formeller als räumliches Pooling bezeichnet. Bei Zeitreihenanwendungen wird Pooling in der Regel als temporales Pooling bezeichnet. Weniger formell wird das Pooling häufig als Subsampling oder Downsampling bezeichnet.

vortrainiertes Modell

Modelle oder Modellkomponenten (z. B. ein Einbettungsvektor), die bereits trainiert wurden. Manchmal geben Sie vortrainierte Einbettungsvektoren in ein neuronales Netzwerk ein. In anderen Fällen trainiert Ihr Modell die Einbettungsvektoren selbst, anstatt sich auf die vortrainierten Einbettungen zu verlassen.

Der Begriff vortrainiertes Language Model bezieht sich auf ein Large Language Model, das Vortraining durchlaufen hat.

Vortraining

Erstes Training eines Modells mit einem großen Dataset. Einige vortrainierte Modelle sind ungeschickt und müssen in der Regel durch ein zusätzliches Training verfeinert werden. Beispielsweise können ML-Experten ein Large Language Model für ein umfangreiches Text-Dataset wie alle englischen Seiten in Wikipedia vorab trainieren. Nach dem Vorabtraining kann das resultierende Modell durch eine der folgenden Techniken weiter verfeinert werden:

- Destillation

- Feinabstimmung

- Anpassung von Anleitungen

- parametersparende Abstimmung

- Einstellung von Aufforderungen

R

Rotationsinvarianz

Bei einem Problem zur Bildklassifizierung die Fähigkeit eines Algorithmus, Bilder auch dann erfolgreich zu klassifizieren, wenn sich die Ausrichtung des Bildes ändert. Der Algorithmus kann beispielsweise einen Tennisschläger erkennen, ob er nach oben, seitlich oder nach unten zeigt. Eine Rotationsinvarianz ist nicht immer erwünscht. So sollte beispielsweise eine verkehrte 9 nicht als 9 klassifiziert werden.

Siehe auch Translationale Invarianz und Größeninvarianz.

S

Größeninvarianz

Bei einem Problem zur Bildklassifizierung die Fähigkeit eines Algorithmus, Bilder auch dann erfolgreich zu klassifizieren, wenn sich die Größe des Bildes ändert. Beispielsweise kann der Algorithmus eine Katze trotzdem identifizieren, ob sie 2 Millionen oder 200.000 Pixel verbraucht. Beachten Sie, dass selbst die besten Algorithmen zur Bildklassifizierung dennoch praktische Grenzen in Bezug auf Größenabweichungen haben. Beispielsweise ist es unwahrscheinlich, dass ein Algorithmus (oder eine Person) ein Katzenbild, das nur 20 Pixel hat, korrekt klassifiziert.

Siehe auch Übersetzungsinvarianz und Rotationsinvarianz.

räumliches Pooling

Siehe Pooling.

Stride

Bei einem Faltungsvorgang oder Pooling das Delta in jeder Dimension der nächsten Reihe von Eingabesegmenten. Die folgende Animation zeigt beispielsweise einen Schritt (1,1) während eines Faltvorgangs. Daher beginnt das nächste Eingabesegment eine Position rechts vom vorherigen Eingabesegment. Wenn der Vorgang den rechten Rand erreicht, ist das nächste Kreissegment ganz links, nur eine Position weiter unten.

Das vorherige Beispiel zeigt einen zweidimensionalen Schritt. Wenn die Eingabematrix dreidimensional ist, wäre der Schritt ebenfalls dreidimensional.

Subsampling

Siehe Pooling.

T

Temperatur

Ein Hyperparameter, der den Grad der Zufälligkeit einer Modellausgabe steuert. Bei höheren Temperaturen ist die Ausgabe zufälliger, bei niedrigeren Temperaturen ist die Ausgabe weniger zufällig.

Die Auswahl der besten Temperatur hängt von der spezifischen Anwendung und den bevorzugten Attributen der Modellausgabe ab. Beispielsweise würden Sie die Temperatur wahrscheinlich erhöhen, wenn Sie eine Anwendung erstellen, mit der Creatives generiert werden. Umgekehrt würden Sie wahrscheinlich die Temperatur senken, wenn Sie ein Modell erstellen, das Bilder oder Text klassifiziert, um die Genauigkeit und Konsistenz des Modells zu verbessern.

Die Temperatur wird häufig mit Softmax verwendet.

Translation Invarianz

Bei einem Problem zur Bildklassifizierung die Fähigkeit eines Algorithmus, Bilder auch dann erfolgreich zu klassifizieren, wenn sich die Position von Objekten innerhalb des Bildes ändert. Der Algorithmus kann beispielsweise weiterhin einen Hund identifizieren, unabhängig davon, ob er sich in der Mitte oder am linken Ende des Frames befindet.

Siehe auch Größeninvarianz und Rotationsinvarianz.