Bảng chú giải này định nghĩa các thuật ngữ về trí tuệ nhân tạo.

A

loại bỏ

Một kỹ thuật để đánh giá tầm quan trọng của một đặc điểm hoặc thành phần bằng cách tạm thời xoá đặc điểm hoặc thành phần đó khỏi một mô hình. Sau đó, bạn sẽ huấn luyện lại mô hình mà không có tính năng hoặc thành phần đó. Nếu mô hình được huấn luyện lại hoạt động kém hơn đáng kể, thì tính năng hoặc thành phần đã xoá có thể là quan trọng.

Ví dụ: giả sử bạn huấn luyện một mô hình phân loại trên 10 đối tượng và đạt được độ chính xác 88% trên tập hợp kiểm thử. Để kiểm tra tầm quan trọng của tính năng đầu tiên, bạn có thể huấn luyện lại mô hình chỉ bằng 9 tính năng khác. Nếu mô hình được huấn luyện lại hoạt động kém hơn đáng kể (ví dụ: độ chính xác 55%), thì có thể tính năng bị xoá là một tính năng quan trọng. Ngược lại, nếu mô hình được huấn luyện lại hoạt động tốt như nhau, thì có thể tính năng đó không quan trọng.

Việc loại bỏ cũng có thể giúp xác định tầm quan trọng của:

- Các thành phần lớn hơn, chẳng hạn như toàn bộ hệ thống con của một hệ thống học máy lớn hơn

- Các quy trình hoặc kỹ thuật, chẳng hạn như bước tiền xử lý dữ liệu

Trong cả hai trường hợp, bạn sẽ quan sát thấy hiệu suất của hệ thống thay đổi (hoặc không thay đổi) sau khi bạn xoá thành phần.

Thử nghiệm A/B

Một phương pháp thống kê để so sánh hai (hoặc nhiều) kỹ thuật – A và B. Thông thường, A là một kỹ thuật hiện có và B là một kỹ thuật mới. Thử nghiệm A/B không chỉ xác định kỹ thuật nào hoạt động hiệu quả hơn mà còn xác định xem sự khác biệt đó có ý nghĩa thống kê hay không.

Thử nghiệm A/B thường so sánh một chỉ số duy nhất trên hai kỹ thuật; ví dụ: độ chính xác của mô hình so với hai kỹ thuật như thế nào? Tuy nhiên, thử nghiệm A/B cũng có thể so sánh bất kỳ số lượng chỉ số hữu hạn nào.

chip tăng tốc

Một danh mục các thành phần phần cứng chuyên dụng được thiết kế để thực hiện các phép tính chính cần thiết cho các thuật toán học sâu.

Các chip tăng tốc (hoặc chỉ bộ tăng tốc) có thể tăng đáng kể tốc độ và hiệu quả của các tác vụ huấn luyện và suy luận so với CPU đa năng. Chúng lý tưởng cho việc huấn luyện mạng nơ-ron và các tác vụ tương tự cần nhiều phép tính toán.

Sau đây là một số ví dụ về chip tăng tốc:

- Tensor Processing Unit (TPU) của Google với phần cứng chuyên dụng cho hoạt động học sâu.

- GPU của NVIDIA, mặc dù ban đầu được thiết kế để xử lý đồ hoạ, nhưng được thiết kế để cho phép xử lý song song, có thể tăng đáng kể tốc độ xử lý.

độ chính xác

Số lượng dự đoán phân loại chính xác chia cho tổng số dự đoán. Đó là:

Ví dụ: một mô hình đưa ra 40 dự đoán chính xác và 10 dự đoán không chính xác sẽ có độ chính xác là:

Phân loại nhị phân cung cấp tên cụ thể cho các danh mục khác nhau của dự đoán chính xác và dự đoán không chính xác. Vì vậy, công thức tính độ chính xác cho phân loại nhị phân như sau:

trong đó:

- TP là số lượng dương tính thật (dự đoán chính xác).

- TN là số lượng âm tính thật (dự đoán chính xác).

- FP là số lượng kết quả dương tính giả (dự đoán không chính xác).

- FN là số lượng âm tính giả (dự đoán không chính xác).

So sánh và đối chiếu độ chính xác với độ đo chính xác và khả năng thu hồi.

Hãy xem bài viết Phân loại: Độ chính xác, khả năng thu hồi, độ đo và các chỉ số liên quan trong Khoá học cấp tốc về học máy để biết thêm thông tin.

hành động

Trong học tăng cường, cơ chế mà tác nhân chuyển đổi giữa các trạng thái của môi trường. Nhân viên hỗ trợ chọn hành động bằng cách sử dụng một chính sách.

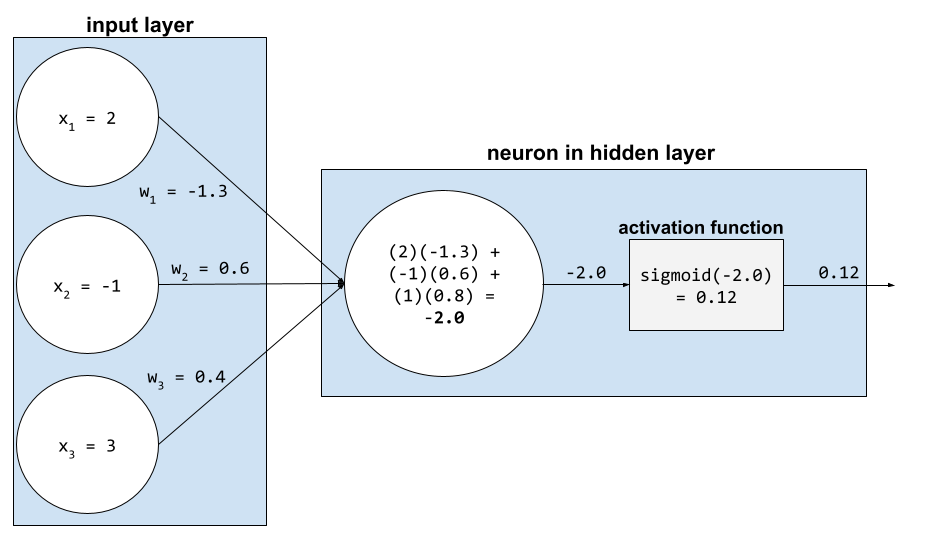

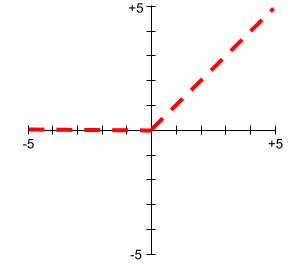

hàm kích hoạt

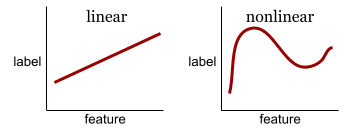

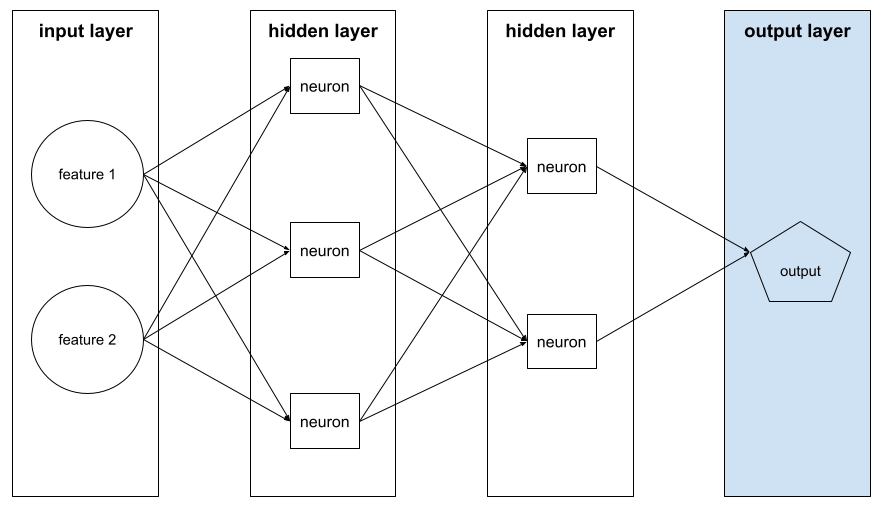

Một hàm cho phép mạng nơ-ron tìm hiểu các mối quan hệ phi tuyến tính (phức tạp) giữa các đặc điểm và nhãn.

Các hàm kích hoạt phổ biến bao gồm:

Đồ thị của các hàm kích hoạt không bao giờ là đường thẳng đơn lẻ. Ví dụ: biểu đồ của hàm kích hoạt ReLU bao gồm 2 đường thẳng:

Biểu đồ của hàm kích hoạt sigmoid có dạng như sau:

Hãy xem Mạng nơ-ron: Hàm kích hoạt trong Khoá học cấp tốc về học máy để biết thêm thông tin.

học tập chủ động

Một phương pháp huấn luyện trong đó thuật toán chọn một số dữ liệu mà thuật toán học được. Học tập chủ động đặc biệt có giá trị khi các ví dụ được gắn nhãn khan hiếm hoặc tốn kém để thu thập. Thay vì mù quáng tìm kiếm nhiều ví dụ được gắn nhãn, thuật toán học tập chủ động sẽ chọn lọc phạm vi ví dụ cụ thể mà thuật toán cần để học.

AdaGrad

Một thuật toán hạ độ dốc tinh vi giúp điều chỉnh lại độ dốc của từng tham số, nhờ đó, mỗi tham số sẽ có một tốc độ học tập độc lập. Để biết nội dung giải thích đầy đủ, hãy xem Phương pháp hạ gradient thích ứng cho học tập trực tuyến và tối ưu hoá ngẫu nhiên.

thích ứng

Từ đồng nghĩa với việc điều chỉnh hoặc tinh chỉnh.

nhân viên hỗ trợ

Phần mềm có thể suy luận về thông tin đầu vào đa phương thức của người dùng để lập kế hoạch và thực hiện các hành động thay cho người dùng.

Trong học tăng cường, tác nhân là thực thể sử dụng một chính sách để tối đa hoá lợi nhuận dự kiến thu được từ việc chuyển đổi giữa các trạng thái của môi trường.

tác nhân

Dạng tính từ của agent (tác nhân). Agentic đề cập đến những phẩm chất mà các tác nhân sở hữu (chẳng hạn như tính tự chủ).

quy trình làm việc dựa trên tác nhân

Một quy trình linh hoạt trong đó tác nhân tự động lập kế hoạch và thực hiện các hành động để đạt được mục tiêu. Quy trình này có thể bao gồm suy luận, gọi các công cụ bên ngoài và tự sửa kế hoạch.

phân cụm kết hợp

Xem phần phân cụm theo hệ thống phân cấp.

AI slop

Kết quả của hệ thống AI tạo sinh ưu tiên số lượng hơn chất lượng. Ví dụ: một trang web có nội dung do AI tạo ra một cách cẩu thả sẽ chứa đầy nội dung chất lượng thấp, do AI tạo ra một cách rẻ tiền.

phát hiện điểm bất thường

Quá trình xác định giá trị ngoại lệ. Ví dụ: nếu giá trị trung bình cho một tính năng nhất định là 100 với độ lệch chuẩn là 10, thì tính năng phát hiện điểm bất thường sẽ gắn cờ giá trị 200 là đáng ngờ.

Thực tế tăng cường (AR)

Viết tắt của thực tế tăng cường.

diện tích dưới đường cong PR

Xem PR AUC (Diện tích dưới đường cong PR).

diện tích dưới đường cong ROC

Xem AUC (Diện tích dưới đường cong ROC).

trí tuệ nhân tạo tổng quát

Một cơ chế không phải do con người tạo ra, thể hiện nhiều khả năng giải quyết vấn đề, sáng tạo và thích ứng. Ví dụ: một chương trình minh hoạ trí tuệ nhân tạo đa năng có thể dịch văn bản, sáng tác bản giao hưởng và chơi giỏi những trò chơi chưa được phát minh.

trí tuệ nhân tạo

Một chương trình hoặc mô hình không phải do con người tạo ra, có thể giải quyết các nhiệm vụ phức tạp. Ví dụ: một chương trình hoặc mô hình dịch văn bản hoặc một chương trình hoặc mô hình xác định bệnh từ hình ảnh chụp X-quang đều thể hiện trí tuệ nhân tạo.

Về mặt chính thức, học máy là một lĩnh vực con của trí tuệ nhân tạo. Tuy nhiên, trong những năm gần đây, một số tổ chức đã bắt đầu sử dụng các thuật ngữ trí tuệ nhân tạo và học máy thay thế cho nhau.

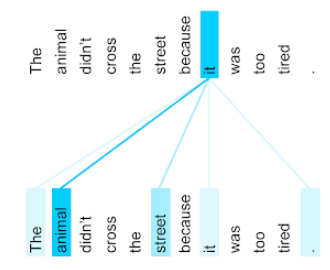

chú ý

Một cơ chế được dùng trong mạng nơ-ron cho biết tầm quan trọng của một từ cụ thể hoặc một phần của từ. Cơ chế chú ý nén lượng thông tin mà một mô hình cần để dự đoán mã thông báo/từ tiếp theo. Cơ chế chú ý thông thường có thể bao gồm một tổng có trọng số trên một tập hợp các đầu vào, trong đó trọng số cho mỗi đầu vào được tính toán bởi một phần khác của mạng nơ-ron.

Bạn cũng có thể tham khảo cơ chế tự chú ý và cơ chế tự chú ý nhiều đầu. Đây là các khối xây dựng của Mô hình Transformer.

Hãy xem bài viết LLM: Mô hình ngôn ngữ lớn là gì? trong Khoá học cấp tốc về học máy để biết thêm thông tin về cơ chế tự chú ý.

thuộc tính

Từ đồng nghĩa với tính năng.

Trong tính công bằng của học máy, các thuộc tính thường đề cập đến những đặc điểm liên quan đến cá nhân.

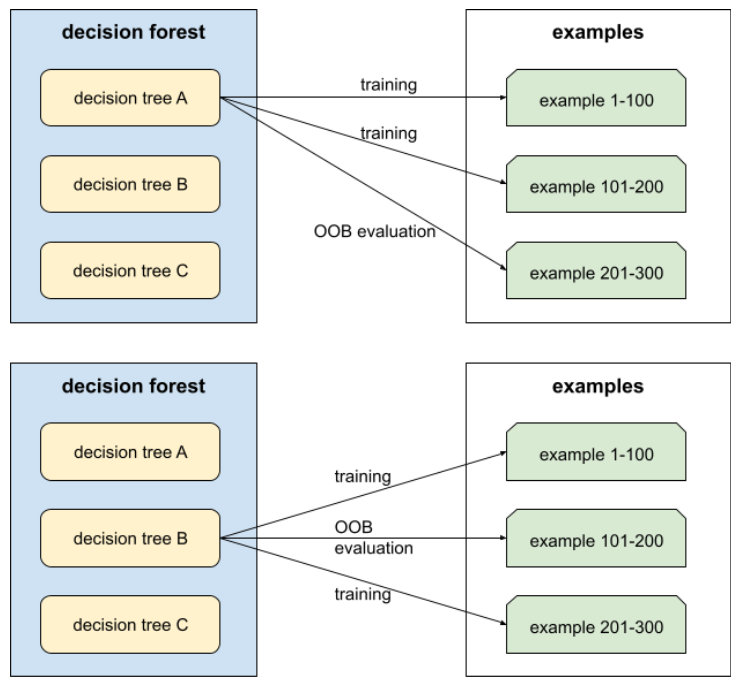

lấy mẫu thuộc tính

Một chiến thuật để huấn luyện rừng quyết định trong đó mỗi cây quyết định chỉ xem xét một tập hợp con ngẫu nhiên gồm các đặc điểm có thể có khi tìm hiểu điều kiện. Nhìn chung, một tập hợp con khác của các đối tượng được lấy mẫu cho mỗi nút. Ngược lại, khi huấn luyện cây quyết định mà không lấy mẫu thuộc tính, tất cả các đặc điểm có thể có đều được xem xét cho từng nút.

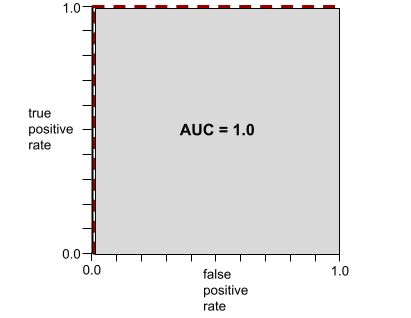

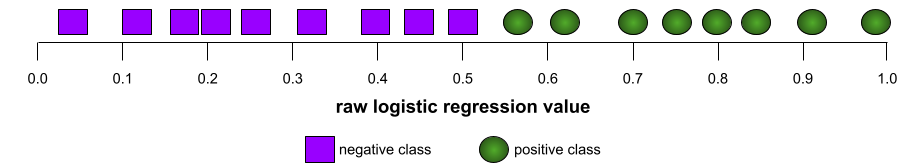

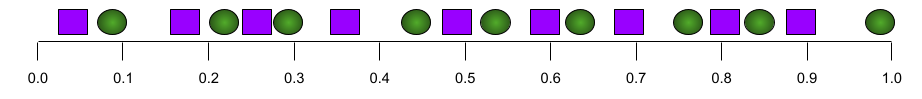

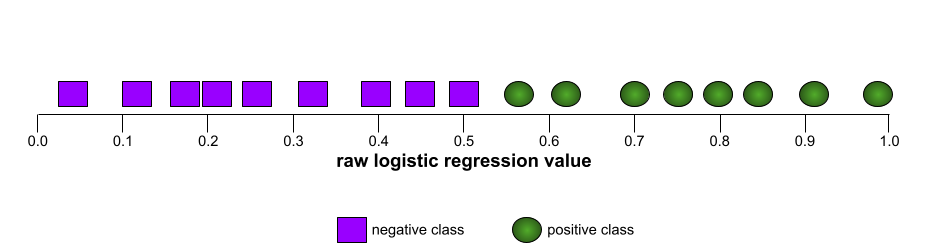

AUC (Diện tích dưới đường cong ROC)

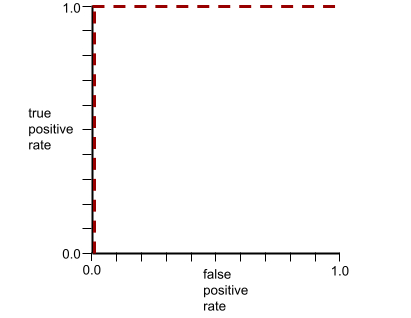

Một số từ 0,0 đến 1,0 biểu thị khả năng của mô hình phân loại nhị phân trong việc tách các lớp dương khỏi các lớp âm. AUC càng gần 1.0 thì khả năng tách các lớp của mô hình càng tốt.

Ví dụ: hình minh hoạ sau đây cho thấy một mô hình phân loại tách biệt hoàn toàn các lớp dương (hình bầu dục màu xanh lục) với các lớp âm (hình chữ nhật màu tím). Mô hình hoàn hảo một cách phi thực tế này có AUC là 1.0:

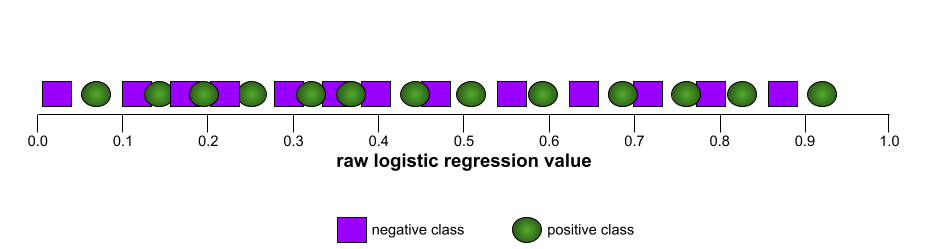

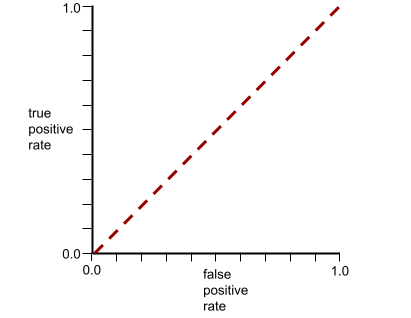

Ngược lại, hình minh hoạ sau đây cho thấy kết quả của một mô hình phân loại đã tạo ra kết quả ngẫu nhiên. Mô hình này có AUC là 0,5:

Có, mô hình trước đó có AUC là 0, 5 chứ không phải 0.

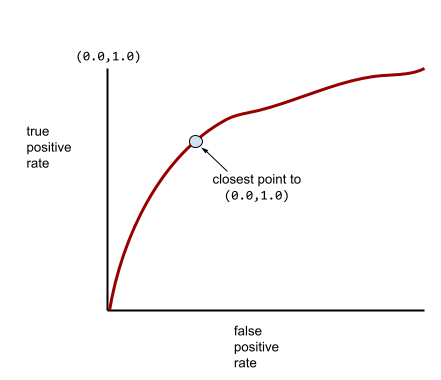

Hầu hết các mô hình đều nằm ở khoảng giữa hai thái cực này. Ví dụ: mô hình sau đây tách biệt phần nào các giá trị dương với giá trị âm, do đó có AUC nằm trong khoảng từ 0,5 đến 1,0:

AUC bỏ qua mọi giá trị mà bạn đặt cho ngưỡng phân loại. Thay vào đó, AUC sẽ xem xét tất cả các ngưỡng phân loại có thể có.

Hãy xem phần Phân loại: ROC và AUC trong Khoá học học máy ứng dụng để biết thêm thông tin.

thực tế tăng cường

Một công nghệ giúp chồng hình ảnh do máy tính tạo lên khung cảnh thực tế mà người dùng nhìn thấy, từ đó mang đến một khung cảnh kết hợp.

autoencoder

Một hệ thống học cách trích xuất thông tin quan trọng nhất từ dữ liệu đầu vào. Bộ mã hoá tự động là sự kết hợp giữa bộ mã hoá và bộ giải mã. Trình mã hoá tự động dựa vào quy trình gồm 2 bước sau:

- Bộ mã hoá ánh xạ đầu vào sang định dạng (thường là) có tổn thất ở chiều thấp hơn (trung gian).

- Bộ giải mã tạo một phiên bản có tổn hao của dữ liệu đầu vào ban đầu bằng cách ánh xạ định dạng ít chiều hơn sang định dạng đầu vào ban đầu có nhiều chiều hơn.

Autoencoder được huấn luyện từ đầu đến cuối bằng cách yêu cầu bộ giải mã cố gắng tái tạo đầu vào ban đầu từ định dạng trung gian của bộ mã hoá một cách chính xác nhất có thể. Vì định dạng trung gian nhỏ hơn (ít chiều hơn) so với định dạng ban đầu, nên bộ mã hoá tự động buộc phải tìm hiểu thông tin nào trong dữ liệu đầu vào là cần thiết và đầu ra sẽ không hoàn toàn giống với đầu vào.

Ví dụ:

- Nếu dữ liệu đầu vào là một hình ảnh, thì bản sao không hoàn toàn giống sẽ tương tự như hình ảnh gốc, nhưng có phần sửa đổi. Có thể bản sao không hoàn toàn giống sẽ loại bỏ nhiễu khỏi hình ảnh gốc hoặc điền vào một số pixel bị thiếu.

- Nếu dữ liệu đầu vào là văn bản, thì một bộ mã hoá tự động sẽ tạo ra văn bản mới mô phỏng (nhưng không giống hệt) văn bản gốc.

Xem thêm mô hình tự mã hoá biến phân.

đánh giá tự động

Sử dụng phần mềm để đánh giá chất lượng đầu ra của một mô hình.

Khi đầu ra của mô hình tương đối đơn giản, một tập lệnh hoặc chương trình có thể so sánh đầu ra của mô hình với một phản hồi mẫu. Loại đánh giá tự động này đôi khi được gọi là đánh giá theo chương trình. Các chỉ số như ROUGE hoặc BLEU thường hữu ích cho việc đánh giá theo chương trình.

Khi đầu ra của mô hình phức tạp hoặc không có câu trả lời đúng duy nhất, một chương trình học máy riêng biệt có tên là trình đánh giá tự động đôi khi sẽ thực hiện quy trình đánh giá tự động.

Tương phản với đánh giá của con người.

thiên kiến tự động hoá

Khi người đưa ra quyết định là con người ưu tiên các đề xuất do hệ thống tự động đưa ra quyết định so với thông tin không có sự can thiệp của hệ thống tự động, ngay cả khi hệ thống tự động đưa ra quyết định mắc lỗi.

Hãy xem phần Tính công bằng: Các loại thiên kiến trong Khoá học cấp tốc về học máy để biết thêm thông tin.

AutoML

Mọi quy trình tự động để xây dựng mô hình học máy . AutoML có thể tự động thực hiện các tác vụ như sau:

- Tìm kiếm mô hình phù hợp nhất.

- Điều chỉnh siêu tham số.

- Chuẩn bị dữ liệu (bao gồm cả việc thực hiện thiết kế đặc trưng).

- Triển khai mô hình thu được.

AutoML rất hữu ích cho các nhà khoa học dữ liệu vì có thể giúp họ tiết kiệm thời gian và công sức trong việc phát triển các quy trình học máy, đồng thời cải thiện độ chính xác của dự đoán. Công cụ này cũng hữu ích cho những người không phải là chuyên gia, bằng cách giúp họ dễ dàng thực hiện các tác vụ học máy phức tạp hơn.

Hãy xem phần Học máy tự động (AutoML) trong Khoá học học máy ứng dụng để biết thêm thông tin.

đánh giá autorater

Một cơ chế kết hợp để đánh giá chất lượng đầu ra của mô hình AI tạo sinh, kết hợp quy trình đánh giá thủ công với quy trình đánh giá tự động. Autorater là một mô hình học máy được huấn luyện dựa trên dữ liệu do hoạt động đánh giá của con người tạo ra. Lý tưởng nhất là một hệ thống chấm điểm tự động học cách mô phỏng một người đánh giá.Có sẵn các trình đánh giá tự động được tạo sẵn, nhưng trình đánh giá tự động tốt nhất là trình được tinh chỉnh cụ thể cho nhiệm vụ mà bạn đang đánh giá.

mô hình tự hồi quy

Một mô hình suy luận một dự đoán dựa trên các dự đoán trước đó của chính nó. Ví dụ: mô hình ngôn ngữ tự hồi quy dự đoán mã thông báo tiếp theo dựa trên các mã thông báo đã dự đoán trước đó. Tất cả mô hình ngôn ngữ lớn dựa trên Transformer đều tự hồi quy.

Ngược lại, các mô hình hình ảnh dựa trên GAN thường không tự hồi quy vì chúng tạo ra hình ảnh trong một lần truyền thẳng và không lặp lại theo các bước. Tuy nhiên, một số mô hình tạo hình ảnh là mô hình hồi quy tự động vì chúng tạo hình ảnh theo từng bước.

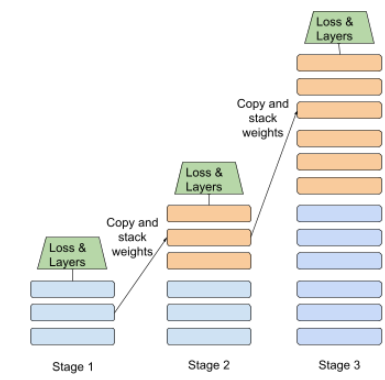

tổn thất phụ trợ

Hàm tổn thất – được dùng cùng với hàm tổn thất chính của mô hình mạng nơron. Hàm này giúp tăng tốc quá trình huấn luyện trong các lần lặp lại ban đầu khi trọng số được khởi tạo ngẫu nhiên.

Các hàm mất mát phụ đẩy độ dốc hiệu quả đến các lớp trước đó. Điều này tạo điều kiện cho sự hội tụ trong quá trình huấn luyện bằng cách giải quyết vấn đề về độ dốc biến mất.

độ chính xác trung bình tại k

Một chỉ số để tóm tắt hiệu suất của mô hình trên một câu lệnh duy nhất tạo ra kết quả được xếp hạng, chẳng hạn như danh sách đề xuất sách có đánh số. Độ chính xác trung bình tại k là giá trị trung bình của các giá trị độ chính xác tại k cho mỗi kết quả phù hợp. Do đó, công thức tính độ chính xác trung bình tại k là:

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

trong đó:

- \(n\) là số lượng mặt hàng có liên quan trong danh sách.

Tương phản với khả năng nhớ lại ở k.

điều kiện căn chỉnh theo trục

Trong cây quyết định, điều kiện chỉ liên quan đến một đặc điểm. Ví dụ: nếu area là một đối tượng, thì sau đây là điều kiện căn chỉnh theo trục:

area > 200

Tương phản với điều kiện gián tiếp.

TỶ

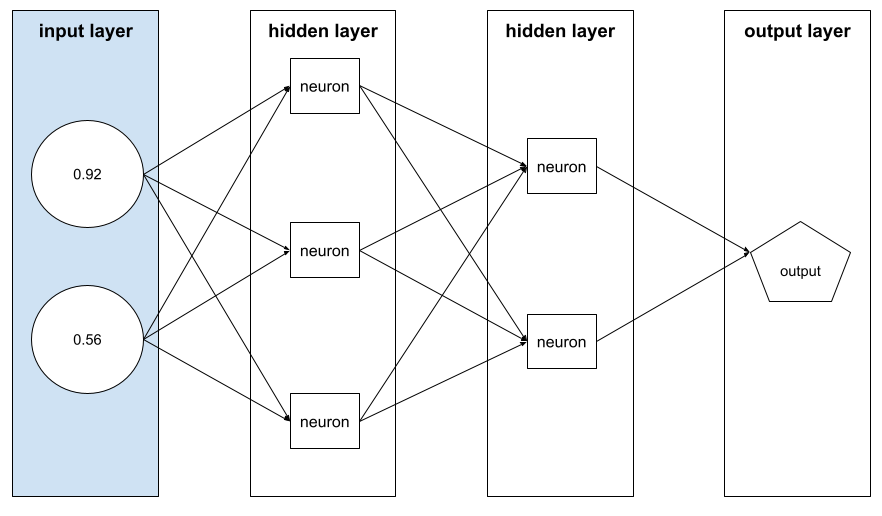

lan truyền ngược

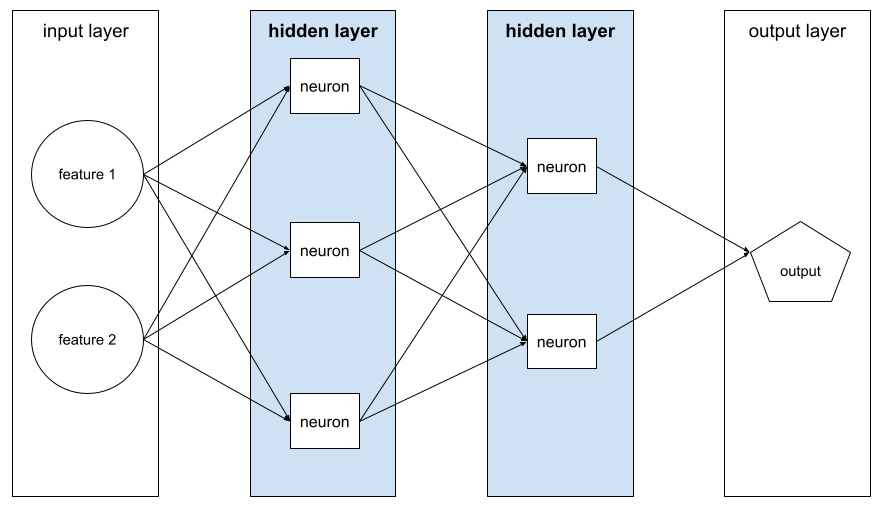

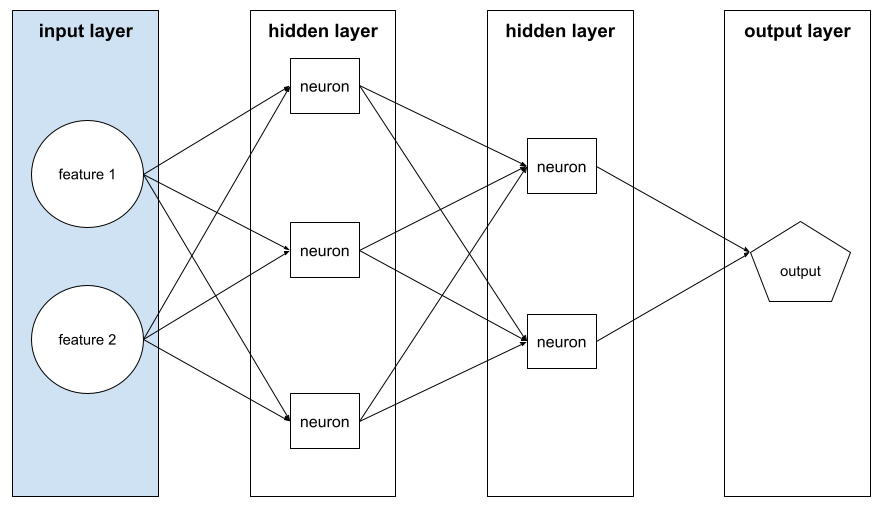

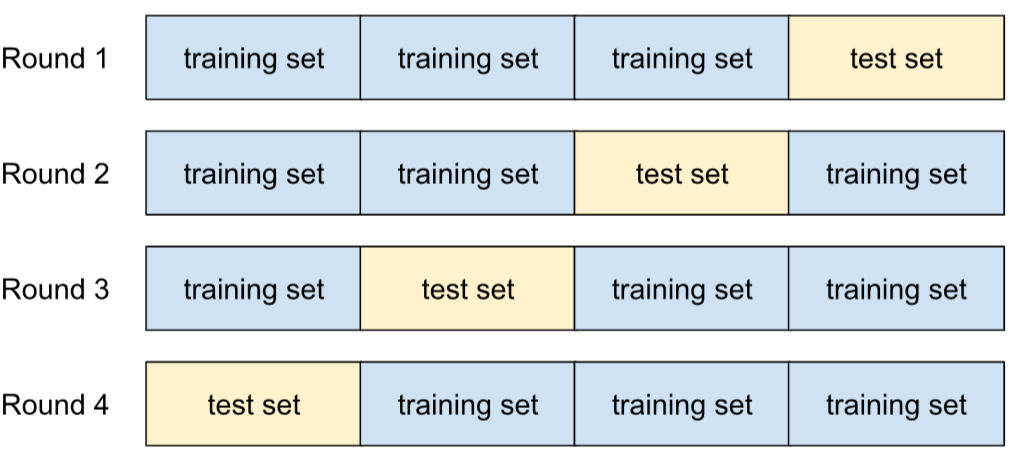

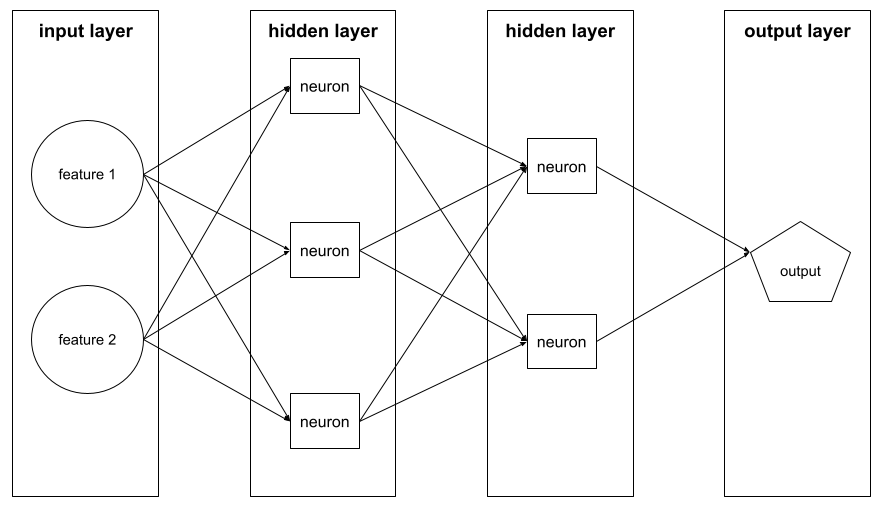

Thuật toán triển khai phương pháp giảm độ dốc trong mạng nơron.

Việc huấn luyện mạng nơ-ron bao gồm nhiều lần lặp lại của chu kỳ hai lượt sau đây:

- Trong quá trình truyền xuôi, hệ thống sẽ xử lý một lô gồm ví dụ để đưa ra(các) dự đoán. Hệ thống so sánh từng dự đoán với từng giá trị nhãn. Khoảng chênh lệch giữa giá trị dự đoán và giá trị nhãn là mức tổn thất cho ví dụ đó. Hệ thống tổng hợp các tổn thất cho tất cả các ví dụ để tính tổng tổn thất cho lô hiện tại.

- Trong lượt truyền ngược (truyền ngược), hệ thống sẽ giảm tổn thất bằng cách điều chỉnh trọng số của tất cả nơ-ron trong tất cả (các) lớp ẩn.

Mạng nơ-ron thường chứa nhiều nơ-ron trên nhiều lớp ẩn. Mỗi nơ-ron trong số đó đóng góp vào tổn thất tổng thể theo những cách khác nhau. Thuật toán lan truyền ngược xác định xem có nên tăng hay giảm trọng số được áp dụng cho các nơ-ron cụ thể hay không.

Tốc độ học là hệ số nhân kiểm soát mức độ mà mỗi lượt truyền ngược tăng hoặc giảm mỗi trọng số. Tốc độ học tập lớn sẽ tăng hoặc giảm mỗi trọng số nhiều hơn tốc độ học tập nhỏ.

Theo thuật ngữ giải tích, phương pháp lan truyền ngược triển khai quy tắc chuỗi từ giải tích. Tức là quá trình truyền ngược sẽ tính toán đạo hàm riêng phần của sai số đối với từng tham số.

Nhiều năm trước, các chuyên gia về học máy phải viết mã để triển khai quá trình truyền ngược. Các API ML hiện đại như Keras hiện triển khai phương pháp lan truyền ngược cho bạn. Chà!

Hãy xem phần Mạng nơ-ron trong Khoá học học máy ứng dụng để biết thêm thông tin.

bagging

Một phương pháp để huấn luyện một tập hợp trong đó mỗi mô hình thành phần huấn luyện trên một tập hợp con ngẫu nhiên của các ví dụ huấn luyện được lấy mẫu có thay thế. Ví dụ: rừng ngẫu nhiên là một tập hợp các cây quyết định được huấn luyện bằng phương pháp lấy mẫu lại.

Thuật ngữ bagging là viết tắt của bootstrap aggregating (tập hợp khởi động).

Hãy xem phần Rừng ngẫu nhiên trong khoá học Rừng quyết định để biết thêm thông tin.

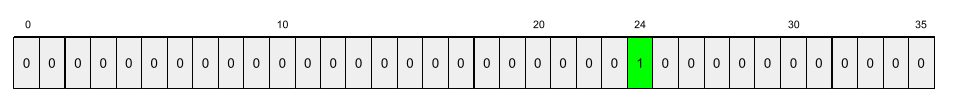

túi từ

Một biểu diễn của các từ trong một cụm từ hoặc đoạn văn, bất kể thứ tự. Ví dụ: túi từ biểu thị 3 cụm từ sau đây một cách giống hệt nhau:

- con chó nhảy lên

- nhảy lên con chó

- chó nhảy qua

Mỗi từ được liên kết với một chỉ mục trong vectơ thưa, trong đó vectơ có một chỉ mục cho mỗi từ trong từ vựng. Ví dụ: cụm từ the dog jumps (con chó nhảy) được ánh xạ thành một vectơ đặc trưng có giá trị khác 0 tại 3 chỉ mục tương ứng với các từ the (con), dog (chó) và jumps (nhảy). Giá trị khác 0 có thể là bất kỳ giá trị nào sau đây:

- Số 1 cho biết sự hiện diện của một từ.

- Số lần một từ xuất hiện trong túi. Ví dụ: nếu cụm từ là the maroon dog is a dog with maroon fur (con chó màu hạt dẻ là một con chó có bộ lông màu hạt dẻ), thì cả maroon (màu hạt dẻ) và dog (chó) sẽ được biểu thị là 2, trong khi các từ khác sẽ được biểu thị là 1.

- Một số giá trị khác, chẳng hạn như logarit của số lần một từ xuất hiện trong túi.

đường cơ sở

Một mô hình được dùng làm điểm tham chiếu để so sánh hiệu suất của một mô hình khác (thường là mô hình phức tạp hơn). Ví dụ: mô hình hồi quy logistic có thể đóng vai trò là đường cơ sở tốt cho một mô hình sâu.

Đối với một vấn đề cụ thể, đường cơ sở giúp các nhà phát triển mô hình định lượng hiệu suất tối thiểu dự kiến mà một mô hình mới phải đạt được để mô hình mới đó hữu ích.

mô hình cơ sở

Một mô hình được huấn luyện trước có thể đóng vai trò là điểm bắt đầu cho quá trình điều chỉnh để giải quyết các tác vụ hoặc ứng dụng cụ thể.

Xem thêm mô hình được huấn luyện trước và mô hình nền tảng.

lô

Tập hợp ví dụ được dùng trong một lần lặp lại của quá trình huấn luyện. Kích thước lô xác định số lượng ví dụ trong một lô.

Hãy xem epoch để biết nội dung giải thích về mối quan hệ giữa một lô và một epoch.

Hãy xem phần Hồi quy tuyến tính: Siêu tham số trong Khoá học cấp tốc về học máy để biết thêm thông tin.

suy luận theo lô

Quy trình suy luận dự đoán trên nhiều ví dụ chưa được gắn nhãn được chia thành các tập hợp con nhỏ hơn ("lô").

Suy luận theo lô có thể tận dụng các tính năng song song hoá của các chip tăng tốc. Tức là nhiều bộ tăng tốc có thể đồng thời suy luận dự đoán trên nhiều lô ví dụ chưa được gắn nhãn, giúp tăng đáng kể số lượng suy luận mỗi giây.

Hãy xem bài viết Hệ thống học máy trong sản xuất: Suy luận tĩnh so với suy luận động trong Khoá học cấp tốc về học máy để biết thêm thông tin.

chuẩn hoá theo lô

Chuẩn hoá đầu vào hoặc đầu ra của hàm kích hoạt trong lớp ẩn. Chuẩn hoá theo lô có thể mang lại những lợi ích sau:

- Giúp mạng nơ-ron ổn định hơn bằng cách bảo vệ trước các trọng số dị thường.

- Cho phép tốc độ học tập cao hơn, có thể giúp tăng tốc quá trình huấn luyện.

- Giảm hiện tượng khớp quá mức.

kích thước lô

Số lượng ví dụ trong một lô. Ví dụ: nếu kích thước lô là 100, thì mô hình sẽ xử lý 100 ví dụ cho mỗi lần lặp lại.

Sau đây là các chiến lược kích thước lô phổ biến:

- Phương pháp giảm độ dốc ngẫu nhiên (SGD), trong đó kích thước lô là 1.

- Toàn bộ lô, trong đó kích thước lô là số lượng ví dụ trong toàn bộ tập huấn luyện. Ví dụ: nếu tập huấn luyện chứa một triệu ví dụ, thì kích thước lô sẽ là một triệu ví dụ. Xử lý theo lô đầy đủ thường là một chiến lược không hiệu quả.

- Tiểu lô, trong đó kích thước lô thường nằm trong khoảng từ 10 đến 1000. Mini-batch thường là chiến lược hiệu quả nhất.

Hãy xem phần sau đây để biết thêm thông tin:

- Hệ thống học máy trong sản xuất: Suy luận tĩnh so với suy luận động trong Khoá học học máy ứng dụng.

- Cẩm nang điều chỉnh học sâu.

Mạng nơron Bayesian

Một mạng nơ-ron xác suất có tính đến sự không chắc chắn trong trọng số và đầu ra. Mô hình hồi quy mạng nơ-ron tiêu chuẩn thường dự đoán một giá trị vô hướng; ví dụ: một mô hình tiêu chuẩn dự đoán giá nhà là 853.000. Ngược lại, mạng nơ-ron Bayesian dự đoán một phân phối các giá trị; ví dụ: mô hình Bayesian dự đoán giá nhà là 853.000 với độ lệch chuẩn là 67.200.

Mạng nơ-ron Bayesian dựa vào Định lý Bayes để tính toán sự không chắc chắn về trọng số và dự đoán. Mạng nơ-ron Bayesian có thể hữu ích khi bạn cần định lượng mức độ không chắc chắn, chẳng hạn như trong các mô hình liên quan đến dược phẩm. Mạng nơ-ron Bayesian cũng có thể giúp ngăn chặn tình trạng khớp quá mức.

Tối ưu hoá theo phương pháp Bayes

Một kỹ thuật mô hình hồi quy xác suất để tối ưu hoá các hàm mục tiêu tốn nhiều tài nguyên tính toán bằng cách tối ưu hoá một đại diện giúp định lượng mức độ không chắc chắn bằng kỹ thuật học Bayesian. Vì bản thân quá trình tối ưu hoá theo phương pháp Bayesian rất tốn kém, nên phương pháp này thường được dùng để tối ưu hoá các tác vụ khó đánh giá có số lượng nhỏ tham số, chẳng hạn như chọn siêu tham số.

Phương trình Bellman

Trong học tăng cường, danh tính sau đây được đáp ứng bởi Q-function tối ưu:

\[Q(s, a) = r(s, a) + \gamma \mathbb{E}_{s'|s,a} \max_{a'} Q(s', a')\]

Thuật toán học tăng cường áp dụng danh tính này để tạo Q-learning bằng quy tắc cập nhật sau:

\[Q(s,a) \gets Q(s,a) + \alpha \left[r(s,a) + \gamma \displaystyle\max_{\substack{a_1}} Q(s',a') - Q(s,a) \right] \]

Ngoài việc học tăng cường, phương trình Bellman còn có các ứng dụng cho lập trình động. Xem mục nhập về phương trình Bellman trên Wikipedia.

BERT (Biểu diễn mã hoá hai chiều từ Transformer)

Một cấu trúc mô hình để biểu thị văn bản. Một mô hình BERT đã được huấn luyện có thể đóng vai trò là một phần của mô hình lớn hơn để phân loại văn bản hoặc các tác vụ học máy khác.

BERT có các đặc điểm sau:

- Sử dụng cấu trúc Transformer và do đó dựa vào cơ chế tự chú ý.

- Sử dụng phần encoder của Transformer. Công việc của bộ mã hoá là tạo ra các biểu diễn văn bản tốt, thay vì thực hiện một tác vụ cụ thể như phân loại.

- Có hai chiều.

- Sử dụng phương pháp che phủ cho huấn luyện không có giám sát.

Các biến thể của BERT bao gồm:

Hãy xem bài viết Nguồn mở BERT: Hoạt động huấn luyện trước hiện đại cho Xử lý ngôn ngữ tự nhiên để biết thông tin tổng quan về BERT.

thiên kiến (đạo đức/tính công bằng)

1. Định kiến, thiên kiến hoặc thiên vị đối với một số sự vật, người hoặc nhóm người so với những người khác. Những thiên kiến này có thể ảnh hưởng đến việc thu thập và diễn giải dữ liệu, thiết kế của một hệ thống và cách người dùng tương tác với hệ thống. Các hình thức thiên kiến thuộc loại này bao gồm:

- thiên kiến tự động hoá

- thiên kiến xác nhận

- sự thiên vị của người nghiên cứu

- thiên vị quy cho nhóm

- thiên kiến ngầm

- thiên vị cùng nhóm

- thiên vị khác nhóm

2. Lỗi hệ thống do quy trình lấy mẫu hoặc báo cáo gây ra. Các hình thức thiên kiến thuộc loại này bao gồm:

- thiên vị do thiếu bao quát

- thiên vị do thiếu hồi âm

- thiên kiến tham gia

- thiên vị dựa trên báo cáo

- thiên vị do không lấy mẫu

- thiên vị do cách chọn mẫu

Không nhầm lẫn với hệ số thiên vị trong các mô hình học máy hoặc độ thiên lệch dự đoán.

Hãy xem phần Tính công bằng: Các loại thành kiến trong Khoá học cấp tốc về học máy để biết thêm thông tin.

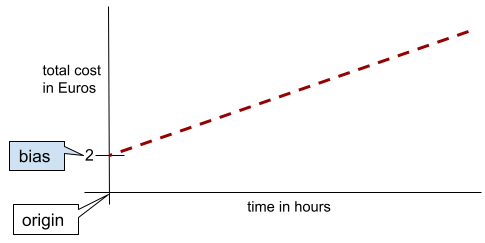

độ lệch (toán học) hoặc hệ số thiên kiến

Một điểm cắt hoặc độ lệch so với điểm gốc. Độ lệch là một tham số trong các mô hình học máy, được biểu thị bằng một trong những tham số sau:

- b

- w0

Ví dụ: độ lệch là b trong công thức sau:

Trong một đường thẳng hai chiều đơn giản, độ lệch chỉ có nghĩa là "giao điểm với trục y". Ví dụ: độ lệch của đường thẳng trong hình minh hoạ sau đây là 2.

Sai số tồn tại vì không phải tất cả các mô hình đều bắt đầu từ gốc (0,0). Ví dụ: giả sử một công viên giải trí có giá vé vào cửa là 2 EUR và khách hàng phải trả thêm 0,5 EUR cho mỗi giờ ở lại. Do đó, một mô hình ánh xạ tổng chi phí có độ lệch là 2 vì chi phí thấp nhất là 2 EUR.

Không được nhầm lẫn thiên kiến với thiên kiến về đạo đức và sự công bằng hoặc thiên kiến dự đoán.

Hãy xem phần Hồi quy tuyến tính trong Khoá học học máy ứng dụng để biết thêm thông tin.

hai chiều

Một thuật ngữ dùng để mô tả hệ thống đánh giá văn bản đứng trước và đứng sau một phần văn bản mục tiêu. Ngược lại, hệ thống một chiều chỉ đánh giá văn bản đứng trước một phần văn bản mục tiêu.

Ví dụ: hãy xem xét một mô hình ngôn ngữ được che giấu phải xác định xác suất cho (các) từ đại diện cho phần gạch chân trong câu hỏi sau:

Bạn bị _____ sao?

Một mô hình ngôn ngữ một chiều sẽ chỉ dựa vào xác suất của ngữ cảnh do các từ "What", "is" và "the" cung cấp. Ngược lại, mô hình ngôn ngữ hai chiều cũng có thể thu thập ngữ cảnh từ "với" và "bạn", điều này có thể giúp mô hình tạo ra những dự đoán chính xác hơn.

mô hình ngôn ngữ hai chiều

Một mô hình ngôn ngữ xác định xác suất mà một mã thông báo nhất định xuất hiện ở một vị trí nhất định trong một đoạn trích văn bản dựa trên văn bản trước và sau.

bigram

Một N-gram trong đó N=2.

phân loại nhị phân

Một loại tác vụ phân loại dự đoán một trong hai lớp loại trừ lẫn nhau:

Ví dụ: mỗi mô hình học máy sau đây đều thực hiện phân loại nhị phân:

- Một mô hình xác định xem thư điện tử có phải là thư rác (lớp dương tính) hay không phải thư rác (lớp âm tính).

- Một mô hình đánh giá các triệu chứng y tế để xác định xem một người có mắc một bệnh cụ thể (lớp dương tính) hay không mắc bệnh đó (lớp âm tính).

Tương phản với phân loại đa mục.

Xem thêm hồi quy logistic và ngưỡng phân loại.

Hãy xem phần Phân loại trong Khoá học học máy ứng dụng để biết thêm thông tin.

điều kiện nhị phân

Trong cây quyết định, điều kiện chỉ có 2 kết quả có thể xảy ra, thường là có hoặc không. Ví dụ: sau đây là một điều kiện nhị phân:

temperature >= 100

Tương phản với điều kiện không phải là nhị phân.

Hãy xem Các loại điều kiện trong khoá học Rừng quyết định để biết thêm thông tin.

phân thùng

Từ đồng nghĩa với phân nhóm.

mô hình hộp đen

Một mô hình có "lý do" mà con người không thể hiểu được hoặc khó hiểu. Tức là mặc dù con người có thể thấy câu lệnh ảnh hưởng đến câu trả lời như thế nào, nhưng con người không thể xác định chính xác cách một mô hình hộp đen xác định câu trả lời. Nói cách khác, mô hình hộp đen thiếu khả năng diễn giải.

Hầu hết các mô hình sâu và mô hình ngôn ngữ lớn đều là hộp đen.

BLEU (Bilingual Evaluation Understudy)

Một chỉ số từ 0 đến 1 để đánh giá bản dịch bằng máy, ví dụ: từ tiếng Tây Ban Nha sang tiếng Nhật.

Để tính điểm, BLEU thường so sánh bản dịch của một mô hình học máy (văn bản được tạo) với bản dịch của một chuyên gia là con người (văn bản tham chiếu). Mức độ trùng khớp giữa N-gram trong văn bản được tạo và văn bản tham chiếu sẽ xác định điểm BLEU.

Bài viết gốc về chỉ số này là BLEU: a Method for Automatic Evaluation of Machine Translation (BLEU: một phương pháp đánh giá tự động bản dịch của máy).

Xem thêm BLEURT.

BLEURT (Bilingual Evaluation Understudy from Transformers)

Một chỉ số để đánh giá bản dịch bằng máy từ ngôn ngữ này sang ngôn ngữ khác, đặc biệt là từ tiếng Anh và sang tiếng Anh.

Đối với bản dịch từ tiếng Anh sang tiếng Anh, BLEURT phù hợp với điểm đánh giá của con người hơn so với BLEU. Không giống như BLEU, BLEURT nhấn mạnh sự tương đồng về ngữ nghĩa (ý nghĩa) và có thể điều chỉnh việc diễn giải.

BLEURT dựa vào một mô hình ngôn ngữ lớn được huấn luyện trước (chính xác là BERT) rồi sau đó được điều chỉnh trên văn bản của người dịch.

Bài viết gốc về chỉ số này là BLEURT: Learning Robust Metrics for Text Generation (BLEURT: Học các chỉ số mạnh mẽ để tạo văn bản).

Câu hỏi Boolean (BoolQ)

Một tập dữ liệu để đánh giá mức độ thành thạo của LLM trong việc trả lời các câu hỏi có hoặc không. Mỗi thử thách trong tập dữ liệu đều có 3 thành phần:

- Một truy vấn

- Một đoạn văn ngụ ý câu trả lời cho câu hỏi.

- Câu trả lời đúng là có hoặc không.

Ví dụ:

- Câu hỏi: Có nhà máy điện hạt nhân nào ở Michigan không?

- Đoạn văn: ...3 nhà máy điện hạt nhân cung cấp khoảng 30% lượng điện cho Michigan.

- Câu trả lời đúng: Có

Các nhà nghiên cứu đã thu thập các câu hỏi từ những cụm từ tìm kiếm ẩn danh, tổng hợp trên Google Tìm kiếm, sau đó sử dụng các trang trên Wikipedia để xác minh thông tin.

Để biết thêm thông tin, hãy xem bài viết BoolQ: Khám phá độ khó đáng ngạc nhiên của các câu hỏi tự nhiên có/không.

BoolQ là một thành phần của tập hợp SuperGLUE.

BoolQ

Từ viết tắt của Câu hỏi Boolean.

tăng cường

Một kỹ thuật học máy kết hợp lặp đi lặp lại một tập hợp các mô hình phân loại đơn giản và không chính xác lắm (được gọi là "trình phân loại yếu") thành một mô hình phân loại có độ chính xác cao ("trình phân loại mạnh") bằng cách tăng trọng số cho các ví dụ mà mô hình hiện đang phân loại sai.

Hãy xem phần Cây quyết định được tăng cường độ dốc? trong khoá học Rừng quyết định để biết thêm thông tin.

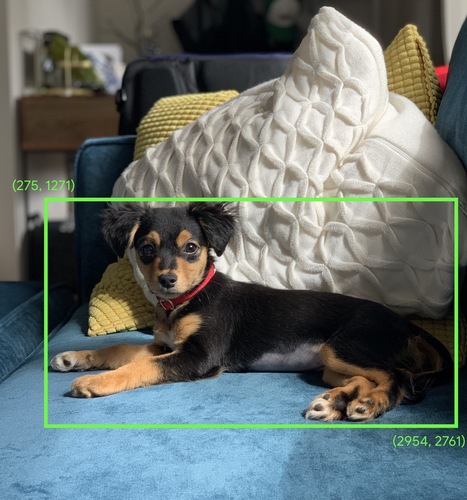

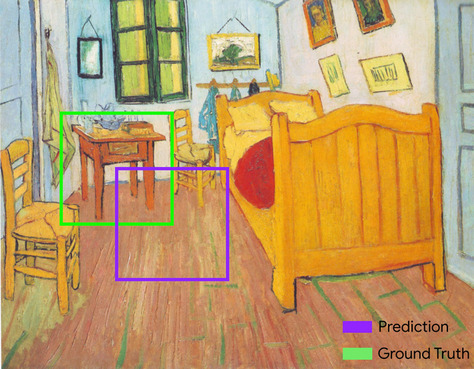

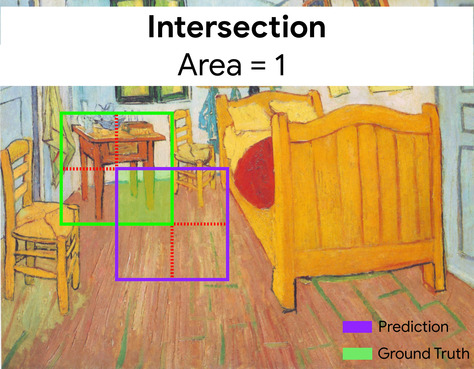

hộp giới hạn

Trong một hình ảnh, toạ độ (x, y) của một hình chữ nhật xung quanh một vùng quan tâm, chẳng hạn như chú chó trong hình ảnh bên dưới.

phát sóng

Mở rộng hình dạng của một toán hạng trong phép toán ma trận để kích thước tương thích cho phép toán đó. Ví dụ: đại số tuyến tính yêu cầu hai toán hạng trong một phép toán cộng ma trận phải có cùng kích thước. Do đó, bạn không thể thêm ma trận có hình dạng (m, n) vào một vectơ có độ dài n. Hoạt động truyền tin cho phép thao tác này bằng cách mở rộng vectơ có độ dài n thành ma trận có hình dạng (m, n) bằng cách sao chép các giá trị tương tự xuống từng cột.

Hãy xem nội dung mô tả sau đây về truyền tin trong NumPy để biết thêm thông tin chi tiết.

phân giỏ

Chuyển đổi một đối tượng duy nhất thành nhiều đối tượng nhị phân được gọi là nhóm hoặc thùng, thường dựa trên một dải giá trị. Tính năng bị cắt thường là một tính năng liên tục.

Ví dụ: thay vì biểu thị nhiệt độ dưới dạng một đặc điểm liên tục duy nhất có dấu phẩy động, bạn có thể chia các phạm vi nhiệt độ thành các nhóm rời rạc, chẳng hạn như:

- <= 10 độ C sẽ là nhóm "lạnh".

- 11 – 24 độ C sẽ là nhóm "ôn hoà".

- >= 25 độ C sẽ là nhóm "ấm".

Mô hình sẽ xử lý mọi giá trị trong cùng một nhóm theo cách giống nhau. Ví dụ: giá trị 13 và 22 đều nằm trong nhóm nhiệt độ vừa phải, nên mô hình sẽ xử lý hai giá trị này giống nhau.

Hãy xem phần Dữ liệu dạng số: Phân nhóm trong Khoá học cấp tốc về học máy để biết thêm thông tin.

C

lớp hiệu chỉnh

Giá trị điều chỉnh sau dự đoán, thường là để tính đến sai lệch dự đoán. Các dự đoán và xác suất được điều chỉnh phải khớp với phân phối của một tập hợp nhãn được quan sát.

tạo đề xuất

Nhóm đề xuất ban đầu do hệ thống đề xuất chọn. Ví dụ: hãy xem xét một hiệu sách cung cấp 100.000 đầu sách. Giai đoạn tạo đề xuất sẽ tạo ra một danh sách nhỏ hơn nhiều gồm những cuốn sách phù hợp cho một người dùng cụ thể, chẳng hạn như 500 cuốn. Nhưng ngay cả 500 cuốn sách cũng là quá nhiều để đề xuất cho một người dùng. Các giai đoạn tiếp theo, tốn kém hơn của hệ thống đề xuất (chẳng hạn như chấm điểm và sắp xếp lại) sẽ giảm 500 đề xuất đó xuống một tập hợp đề xuất nhỏ hơn và hữu ích hơn nhiều.

Hãy xem Tổng quan về việc tạo đề xuất trong khoá học Hệ thống đề xuất để biết thêm thông tin.

lấy mẫu ứng viên

Một quy trình tối ưu hoá trong thời gian huấn luyện sẽ tính toán xác suất cho tất cả các nhãn dương, chẳng hạn như sử dụng softmax, nhưng chỉ dành cho một mẫu nhãn âm ngẫu nhiên. Ví dụ: cho một ví dụ được gắn nhãn beagle và dog, hoạt động lấy mẫu ứng viên sẽ tính toán các xác suất dự đoán và các số hạng tổn thất tương ứng cho:

- chó săn thỏ

- dog

- một tập hợp con ngẫu nhiên của các lớp âm còn lại (ví dụ: mèo, kẹo mút, hàng rào).

Ý tưởng là các lớp âm tính có thể học hỏi từ việc củng cố âm tính ít thường xuyên hơn, miễn là các lớp dương tính luôn nhận được sự củng cố dương tính thích hợp. Điều này thực sự được quan sát một cách thực nghiệm.

Lấy mẫu ứng viên hiệu quả hơn về mặt tính toán so với các thuật toán huấn luyện tính toán dự đoán cho tất cả các lớp âm tính, đặc biệt là khi số lượng lớp âm tính rất lớn.

dữ liệu phân loại

Tính năng có một nhóm giá trị có thể có cụ thể. Ví dụ: hãy xem xét một đặc điểm phân loại có tên là traffic-light-state, chỉ có thể có một trong 3 giá trị có thể có sau đây:

redyellowgreen

Bằng cách biểu thị traffic-light-state dưới dạng một đặc điểm phân loại, mô hình có thể tìm hiểu những tác động khác nhau của red, green và yellow đối với hành vi của người lái xe.

Đôi khi, các đặc điểm phân loại được gọi là đặc điểm rời rạc.

Tương phản với dữ liệu dạng số.

Hãy xem bài viết Làm việc với dữ liệu phân loại trong Khoá học cấp tốc về học máy để biết thêm thông tin.

mô hình ngôn ngữ nhân quả

Từ đồng nghĩa với mô hình ngôn ngữ một chiều.

Hãy xem mô hình ngôn ngữ hai chiều để so sánh các phương pháp định hướng khác nhau trong mô hình ngôn ngữ.

CB

Từ viết tắt của CommitmentBank.

tâm

Tâm của một cụm do thuật toán k-means hoặc k-median xác định. Ví dụ: nếu k là 3, thì thuật toán k-means hoặc k-median sẽ tìm thấy 3 tâm cụm.

Hãy xem Thuật toán phân cụm trong khoá học Phân cụm để biết thêm thông tin.

phân cụm dựa trên tâm

Một danh mục thuật toán phân cụm sắp xếp dữ liệu thành các cụm không phân cấp. k-means là thuật toán phân cụm dựa trên tâm điểm được sử dụng rộng rãi nhất.

Tương phản với thuật toán phân cụm phân cấp.

Hãy xem Thuật toán phân cụm trong khoá học Phân cụm để biết thêm thông tin.

đặt câu lệnh theo chuỗi suy luận

Một kỹ thuật thiết kế câu lệnh khuyến khích mô hình ngôn ngữ lớn (LLM) giải thích quy trình suy luận của mình từng bước. Ví dụ: hãy xem xét câu lệnh sau, đặc biệt chú ý đến câu thứ hai:

Một người lái xe sẽ chịu bao nhiêu lực g trong một chiếc xe tăng tốc từ 0 đến 60 dặm/giờ trong 7 giây? Trong câu trả lời, hãy trình bày tất cả các phép tính liên quan.

Câu trả lời của LLM có thể sẽ:

- Cho thấy một chuỗi công thức vật lý, cắm các giá trị 0, 60 và 7 vào các vị trí thích hợp.

- Giải thích lý do chọn những công thức đó và ý nghĩa của các biến.

Câu lệnh chuỗi suy luận buộc LLM thực hiện tất cả các phép tính, điều này có thể dẫn đến câu trả lời chính xác hơn. Ngoài ra, tính năng gợi ý theo chuỗi suy luận cho phép người dùng xem xét các bước của LLM để xác định xem câu trả lời có hợp lý hay không.

Điểm F của N-gram ký tự (ChrF)

Một chỉ số để đánh giá các mô hình dịch máy. Điểm F của N-gram ký tự xác định mức độ mà N-gram trong văn bản tham chiếu trùng lặp với N-gram trong văn bản được tạo của mô hình học máy.

Điểm F của n-gram ký tự tương tự như các chỉ số trong nhóm ROUGE và BLEU, ngoại trừ:

- Điểm F của N-gram ký tự hoạt động trên N-gram ký tự.

- ROUGE và BLEU hoạt động trên N-gram từ hoặc mã thông báo.

trò chuyện

Nội dung của một cuộc đối thoại qua lại với hệ thống học máy, thường là một mô hình ngôn ngữ lớn. Tương tác trước đó trong cuộc trò chuyện (nội dung bạn đã nhập và cách mô hình ngôn ngữ lớn phản hồi) sẽ trở thành ngữ cảnh cho các phần tiếp theo của cuộc trò chuyện.

Trợ lý trò chuyện là một ứng dụng của mô hình ngôn ngữ lớn.

chốt kiểm tra

Dữ liệu ghi lại trạng thái của các tham số của mô hình trong quá trình huấn luyện hoặc sau khi hoàn tất quá trình huấn luyện. Ví dụ: trong quá trình huấn luyện, bạn có thể:

- Ngừng huấn luyện, có thể là do cố ý hoặc do một số lỗi nhất định.

- Ghi lại điểm kiểm tra.

- Sau đó, tải lại điểm kiểm tra, có thể trên phần cứng khác.

- Bắt đầu lại khoá đào tạo.

Lựa chọn thay thế hợp lý (COPA)

Một tập dữ liệu để đánh giá mức độ hiệu quả của một LLM trong việc xác định câu trả lời tốt hơn trong số hai câu trả lời thay thế cho một tiền đề. Mỗi thử thách trong tập dữ liệu bao gồm 3 thành phần:

- Một tiền đề, thường là một câu nói theo sau là một câu hỏi

- Hai câu trả lời có thể có cho câu hỏi được đặt ra trong tiền đề, trong đó có một câu trả lời đúng và một câu trả lời sai

- Câu trả lời đúng

Ví dụ:

- Tình huống: Người đàn ông bị gãy ngón chân. Đâu là NGUYÊN NHÂN gây ra vấn đề này?

- Các câu trả lời có thể có:

- Anh ấy bị thủng tất.

- Anh ấy làm rơi búa lên chân.

- Câu trả lời đúng: 2

COPA là một thành phần của nhóm mô hình SuperGLUE.

lớp

Một danh mục mà nhãn có thể thuộc về. Ví dụ:

- Trong mô hình phân loại nhị phân phát hiện thư rác, hai lớp có thể là thư rác và không phải thư rác.

- Trong mô hình phân loại nhiều lớp xác định giống chó, các lớp có thể là chó poodle, chó beagle, chó pug, v.v.

Mô hình phân loại dự đoán một lớp. Ngược lại, mô hình hồi quy dự đoán một số thay vì một lớp.

Hãy xem phần Phân loại trong Khoá học học máy ứng dụng để biết thêm thông tin.

tập dữ liệu cân bằng về loại

Một tập dữ liệu chứa nhãn phân loại trong đó số lượng thực thể của mỗi danh mục gần bằng nhau. Ví dụ: hãy xem xét một tập dữ liệu thực vật có nhãn nhị phân có thể là cây bản địa hoặc cây không phải bản địa:

- Một tập dữ liệu có 515 cây bản địa và 485 cây không phải bản địa là một tập dữ liệu cân bằng theo lớp.

- Một tập dữ liệu có 875 cây bản địa và 125 cây không phải bản địa là một tập dữ liệu bất cân đối về loại.

Không có ranh giới chính thức giữa các tập dữ liệu cân bằng theo lớp và các tập dữ liệu không cân bằng theo lớp. Sự khác biệt này chỉ trở nên quan trọng khi một mô hình được huấn luyện trên một tập dữ liệu có sự mất cân bằng lớn về lớp không thể hội tụ. Xem Tập dữ liệu: tập dữ liệu bất cân đối trong Khoá học học máy ứng dụng để biết thông tin chi tiết.

mô hình phân loại

Một mô hình có dự đoán là một lớp. Ví dụ: sau đây là tất cả các mô hình phân loại:

- Một mô hình dự đoán ngôn ngữ của câu đầu vào (tiếng Pháp? Tiếng Tây Ban Nha? Tiếng Ý).

- Một mô hình dự đoán loài cây (Cây phong? Oak? Bao báp?).

- Một mô hình dự đoán lớp dương tính hoặc âm tính cho một tình trạng bệnh cụ thể.

Ngược lại, mô hình hồi quy dự đoán các con số thay vì các lớp.

Hai loại mô hình phân loại phổ biến là:

ngưỡng phân loại

Trong phân loại nhị phân, một số nằm trong khoảng từ 0 đến 1 sẽ chuyển đổi đầu ra thô của mô hình hồi quy logistic thành dự đoán về lớp dương tính hoặc lớp âm tính. Xin lưu ý rằng ngưỡng phân loại là giá trị do con người chọn, chứ không phải giá trị do quá trình huấn luyện mô hình chọn.

Mô hình hồi quy logistic xuất ra một giá trị thô trong khoảng từ 0 đến 1. Sau đó:

- Nếu giá trị thô này lớn hơn ngưỡng phân loại, thì lớp dương sẽ được dự đoán.

- Nếu giá trị thô này nhỏ hơn ngưỡng phân loại, thì lớp âm tính sẽ được dự đoán.

Ví dụ: giả sử ngưỡng phân loại là 0, 8. Nếu giá trị thô là 0,9, thì mô hình sẽ dự đoán lớp dương. Nếu giá trị thô là 0,7, thì mô hình sẽ dự đoán lớp âm.

Lựa chọn ngưỡng phân loại ảnh hưởng lớn đến số lượng kết quả dương tính giả và kết quả âm tính giả.

Hãy xem phần Ngưỡng và ma trận nhầm lẫn trong Khoá học học máy ứng dụng để biết thêm thông tin.

thuật toán phân loại

Một thuật ngữ thông thường cho mô hình phân loại.

tập dữ liệu bất cân đối về loại

Một tập dữ liệu cho một phân loại trong đó tổng số nhãn của mỗi lớp khác biệt đáng kể. Ví dụ: hãy xem xét một tập dữ liệu phân loại nhị phân có 2 nhãn được chia như sau:

- 1.000.000 nhãn phủ định

- 10 nhãn tích cực

Tỷ lệ nhãn âm so với nhãn dương là 100.000:1, vì vậy đây là một tập dữ liệu bất cân đối về loại.

Ngược lại, tập dữ liệu sau đây là cân bằng theo lớp vì tỷ lệ nhãn tiêu cực so với nhãn tích cực tương đối gần với 1:

- 517 nhãn phủ định

- 483 nhãn tích cực

Tập dữ liệu nhiều lớp cũng có thể bị mất cân bằng về lớp. Ví dụ: tập dữ liệu phân loại nhiều lớp sau đây cũng bị mất cân bằng lớp vì một nhãn có nhiều ví dụ hơn hai nhãn còn lại:

- 1.000.000 nhãn có lớp "xanh lục"

- 200 nhãn có lớp "tím"

- 350 nhãn có lớp "orange"

Việc huấn luyện tập dữ liệu bất cân đối về loại có thể gây ra những thách thức đặc biệt. Hãy xem phần Tập dữ liệu không cân bằng trong Khoá học học máy ứng dụng để biết thông tin chi tiết.

Xem thêm entropy, majority class và minority class.

cắt

Một kỹ thuật xử lý giá trị ngoại lệ bằng cách thực hiện một hoặc cả hai thao tác sau:

- Giảm các giá trị tính năng lớn hơn ngưỡng tối đa xuống ngưỡng tối đa đó.

- Tăng các giá trị của đối tượng nhỏ hơn ngưỡng tối thiểu lên đến ngưỡng tối thiểu đó.

Ví dụ: giả sử <0, 5% giá trị của một tính năng cụ thể nằm ngoài phạm vi 40–60. Trong trường hợp này, bạn có thể làm như sau:

- Cắt tất cả các giá trị trên 60 (ngưỡng tối đa) thành chính xác 60.

- Cắt tất cả các giá trị dưới 40 (ngưỡng tối thiểu) thành chính xác 40.

Giá trị ngoại lệ có thể làm hỏng các mô hình, đôi khi khiến trọng số tràn trong quá trình huấn luyện. Một số giá trị ngoại lệ cũng có thể làm hỏng đáng kể các chỉ số như độ chính xác. Cắt bớt là một kỹ thuật phổ biến để hạn chế thiệt hại.

Giới hạn độ dốc buộc các giá trị độ dốc nằm trong một phạm vi được chỉ định trong quá trình huấn luyện.

Hãy xem phần Dữ liệu dạng số: Chuẩn hoá trong Khoá học cấp tốc về học máy để biết thêm thông tin.

Cloud TPU

Một bộ tăng tốc phần cứng chuyên dụng được thiết kế để tăng tốc các tải công việc học máy trên Google Cloud.

phân cụm

Nhóm các ví dụ có liên quan, đặc biệt là trong quá trình học không giám sát. Sau khi tất cả các ví dụ được nhóm lại, con người có thể tuỳ ý cung cấp ý nghĩa cho từng cụm.

Có nhiều thuật toán phân cụm. Ví dụ: thuật toán k-means sẽ phân cụm các ví dụ dựa trên khoảng cách của chúng đến một tâm cụm, như trong sơ đồ sau:

Sau đó, một nhà nghiên cứu có thể xem xét các cụm và gắn nhãn cho cụm 1 là "cây lùn" và cụm 2 là "cây có kích thước đầy đủ".

Một ví dụ khác là hãy xem xét thuật toán phân cụm dựa trên khoảng cách của một ví dụ từ một điểm trung tâm, minh hoạ như sau:

Hãy xem Khoá học về phân cụm để biết thêm thông tin.

cùng thích nghi

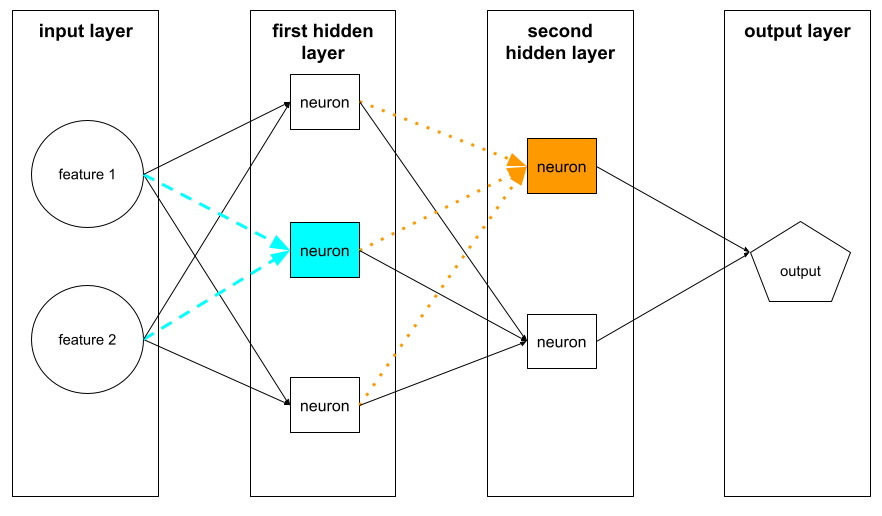

Một hành vi không mong muốn trong đó các nơ-ron dự đoán các mẫu trong dữ liệu huấn luyện bằng cách gần như chỉ dựa vào đầu ra của các nơ-ron cụ thể khác thay vì dựa vào hành vi của toàn bộ mạng. Khi các mẫu gây ra hiện tượng đồng thích ứng không có trong dữ liệu xác thực, thì hiện tượng đồng thích ứng sẽ gây ra tình trạng khớp quá mức. Điều chỉnh bằng cách loại bỏ giúp giảm sự thích ứng lẫn nhau vì việc loại bỏ đảm bảo các nơ-ron không chỉ dựa vào các nơ-ron cụ thể khác.

lọc cộng tác

Đưa ra dự đoán về mối quan tâm của một người dùng dựa trên mối quan tâm của nhiều người dùng khác. Lọc cộng tác thường được dùng trong hệ thống đề xuất.

Hãy xem phần Lọc cộng tác trong khoá học Hệ thống đề xuất để biết thêm thông tin.

CommitmentBank (CB)

Một tập dữ liệu để đánh giá mức độ thành thạo của LLM trong việc xác định xem tác giả của một đoạn văn có tin vào một mệnh đề mục tiêu trong đoạn văn đó hay không. Mỗi mục trong tập dữ liệu chứa:

- Đoạn văn

- Một mệnh đề mục tiêu trong đoạn văn đó

- Giá trị Boolean cho biết liệu tác giả của đoạn văn có tin rằng mệnh đề mục tiêu

Ví dụ:

- Đoạn trích: Thật vui khi nghe Artemis cười. Cô bé là một đứa trẻ rất nghiêm túc. Tôi không biết cô ấy có khiếu hài hước.

- Mệnh đề mục đích: cô ấy có khiếu hài hước

- Boolean: True, tức là tác giả tin rằng mệnh đề mục tiêu

CommitmentBank là một thành phần của nhóm mô hình SuperGLUE.

mô hình thu gọn

Mọi mô hình nhỏ được thiết kế để chạy trên các thiết bị nhỏ có tài nguyên tính toán hạn chế. Ví dụ: các mô hình nhỏ gọn có thể chạy trên điện thoại di động, máy tính bảng hoặc hệ thống nhúng.

tính toán

(Danh từ) Tài nguyên điện toán mà một mô hình hoặc hệ thống sử dụng, chẳng hạn như sức mạnh xử lý, bộ nhớ và bộ nhớ lưu trữ.

Xem chip tăng tốc.

sự sai lệch về khái niệm

Sự thay đổi trong mối quan hệ giữa các tính năng và nhãn. Theo thời gian, sự thay đổi về khái niệm sẽ làm giảm chất lượng của mô hình.

Trong quá trình huấn luyện, mô hình sẽ học mối quan hệ giữa các đặc điểm và nhãn của chúng trong tập huấn luyện. Nếu nhãn trong tập huấn luyện là các proxy tốt cho thế giới thực, thì mô hình sẽ đưa ra các dự đoán chính xác trong thế giới thực. Tuy nhiên, do sự thay đổi về khái niệm, các dự đoán của mô hình có xu hướng giảm theo thời gian.

Ví dụ: hãy xem xét một mô hình phân loại nhị phân dự đoán xem một mẫu xe nhất định có "tiết kiệm nhiên liệu" hay không. Tức là các tính năng có thể là:

- trọng lượng xe

- độ nén của động cơ

- loại truyền động

trong khi nhãn là:

- tiết kiệm nhiên liệu

- không tiết kiệm nhiên liệu

Tuy nhiên, khái niệm về "xe tiết kiệm nhiên liệu" vẫn không ngừng thay đổi. Một mẫu xe được gắn nhãn tiết kiệm nhiên liệu vào năm 1994 gần như chắc chắn sẽ được gắn nhãn không tiết kiệm nhiên liệu vào năm 2024. Một mô hình chịu ảnh hưởng của sự thay đổi khái niệm có xu hướng đưa ra những dự đoán ngày càng ít hữu ích theo thời gian.

So sánh và đối chiếu với tính không dừng.

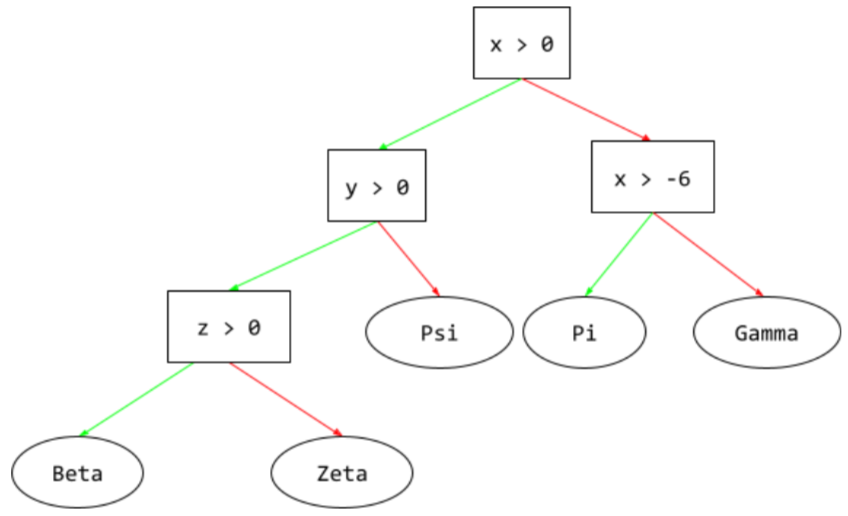

điều kiện

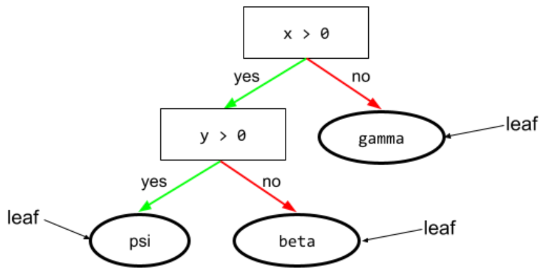

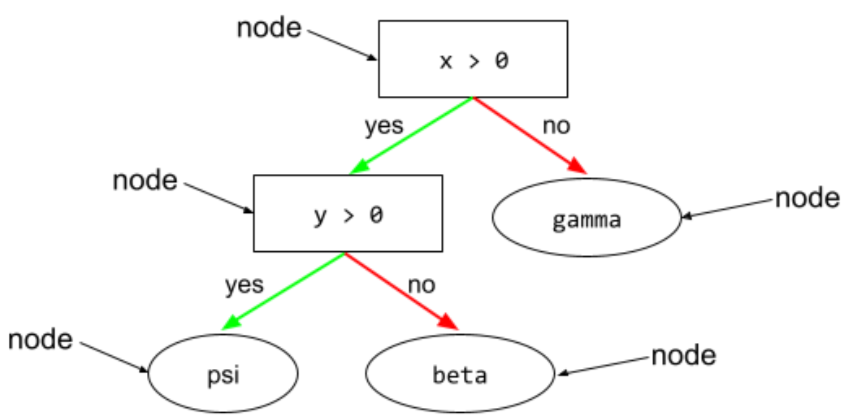

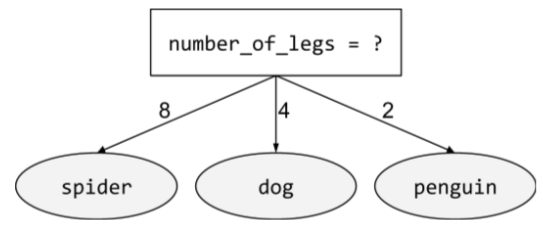

Trong cây quyết định, mọi nút thực hiện một kiểm thử. Ví dụ: cây quyết định sau đây có 2 điều kiện:

Điều kiện còn được gọi là phân tách hoặc kiểm thử.

Điều kiện tương phản với lá.

Xem thêm:

Hãy xem Các loại điều kiện trong khoá học Rừng quyết định để biết thêm thông tin.

chuyện bịa đặt

Từ đồng nghĩa với ảo tưởng.

Có lẽ, thuật ngữ bịa chuyện chính xác hơn về mặt kỹ thuật so với ảo giác. Tuy nhiên, ảo giác trở nên phổ biến trước.

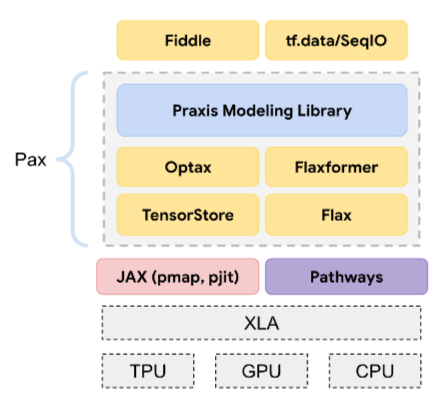

cấu hình

Quá trình chỉ định các giá trị thuộc tính ban đầu được dùng để huấn luyện một mô hình, bao gồm:

- các lớp tạo nên mô hình

- vị trí của dữ liệu

- siêu tham số, chẳng hạn như:

Trong các dự án học máy, bạn có thể định cấu hình thông qua một tệp cấu hình đặc biệt hoặc sử dụng các thư viện cấu hình như sau:

thiên kiến xác nhận

Xu hướng tìm kiếm, diễn giải, ủng hộ và nhớ lại thông tin theo cách xác nhận niềm tin hoặc giả thuyết có sẵn của một người. Các nhà phát triển học máy có thể vô tình thu thập hoặc gắn nhãn dữ liệu theo cách ảnh hưởng đến kết quả hỗ trợ niềm tin hiện tại của họ. Thiên kiến xác nhận là một dạng thiên kiến ngầm.

Thiên kiến của người thử nghiệm là một dạng thiên kiến xác nhận, trong đó người thử nghiệm tiếp tục huấn luyện các mô hình cho đến khi giả thuyết có sẵn được xác nhận.

ma trận nhầm lẫn

Một bảng NxN tóm tắt số lượng dự đoán chính xác và không chính xác mà mô hình phân loại đã thực hiện. Ví dụ: hãy xem xét ma trận nhầm lẫn sau đây cho mô hình phân loại nhị phân:

| Khối u (dự đoán) | Không phải khối u (dự đoán) | |

|---|---|---|

| Khối u (thông tin thực tế) | 18 (TP) | 1 (FN) |

| Không phải khối u (thông tin thực tế) | 6 (FP) | 452 (TN) |

Ma trận nhầm lẫn ở trên cho thấy những điều sau:

- Trong số 19 dự đoán mà cơ sở thực tế là Khối u, mô hình đã phân loại chính xác 18 và phân loại không chính xác 1.

- Trong số 458 dự đoán có dữ liệu thực tế là Không phải khối u, mô hình đã phân loại chính xác 452 và phân loại không chính xác 6.

Ma trận nhầm lẫn cho vấn đề phân loại nhiều lớp có thể giúp bạn xác định các mẫu lỗi. Ví dụ: hãy xem xét ma trận nhầm lẫn sau đây cho một mô hình phân loại nhiều lớp có 3 lớp, phân loại 3 loại hoa diên vĩ khác nhau (Virginica, Versicolor và Setosa). Khi thông tin thực tế là Virginica, ma trận nhầm lẫn cho thấy mô hình có nhiều khả năng dự đoán nhầm Versicolor hơn Setosa:

| Setosa (dự đoán) | Versicolor (dự đoán) | Virginica (dự đoán) | |

|---|---|---|---|

| Setosa (thông tin thực tế) | 88 | 12 | 0 |

| Versicolor (thông tin thực tế) | 6 | 141 | 7 |

| Virginica (thông tin thực tế) | 2 | 27 | 109 |

Một ví dụ khác là ma trận nhầm lẫn có thể cho thấy rằng một mô hình được huấn luyện để nhận dạng chữ số viết tay có xu hướng dự đoán nhầm 9 thay vì 4 hoặc dự đoán nhầm 1 thay vì 7.

Ma trận nhầm lẫn chứa đủ thông tin để tính toán nhiều chỉ số hiệu suất, bao gồm cả độ chính xác và khả năng thu hồi.

phân tích cú pháp thành phần

Chia một câu thành các cấu trúc ngữ pháp nhỏ hơn ("thành phần"). Một phần sau của hệ thống học máy (chẳng hạn như mô hình hiểu ngôn ngữ tự nhiên) có thể phân tích cú pháp các thành phần dễ dàng hơn so với câu gốc. Ví dụ: hãy xem xét câu sau:

Bạn tôi nhận nuôi hai chú mèo.

Một trình phân tích cú pháp thành phần có thể chia câu này thành 2 thành phần sau:

- My friend (Bạn của tôi) là một cụm danh từ.

- adopted two cats (nhận nuôi hai chú mèo) là một cụm động từ.

Các thành phần này có thể được chia thành các thành phần nhỏ hơn. Ví dụ: cụm động từ

nhận nuôi hai chú mèo

có thể được chia thành:

- adopted là một động từ.

- two cats (hai con mèo) là một cụm danh từ khác.

mô hình nhúng ngôn ngữ theo ngữ cảnh

Một mô hình nhúng gần như "hiểu" được các từ và cụm từ theo cách mà người nói thành thạo có thể hiểu. Các câu lệnh nhúng ngôn ngữ theo ngữ cảnh có thể hiểu được cú pháp, ngữ nghĩa và ngữ cảnh phức tạp.

Ví dụ: hãy xem xét các mục nhúng của từ tiếng Anh cow (bò). Các vectơ nhúng cũ hơn, chẳng hạn như word2vec, có thể biểu thị các từ tiếng Anh sao cho khoảng cách trong không gian vectơ nhúng từ cow (bò cái) đến bull (bò đực) tương tự như khoảng cách từ ewe (cừu cái) đến ram (cừu đực) hoặc từ female (nữ) đến male (nam). Các vectơ nhúng ngôn ngữ theo ngữ cảnh có thể tiến thêm một bước bằng cách nhận ra rằng đôi khi người nói tiếng Anh sử dụng từ cow (bò cái) một cách tuỳ ý để chỉ cả bò cái và bò đực.

cửa sổ ngữ cảnh

Số lượng mã thông báo mà một mô hình có thể xử lý trong một lời nhắc nhất định. Cửa sổ ngữ cảnh càng lớn, mô hình càng có thể sử dụng nhiều thông tin để đưa ra câu trả lời nhất quán và mạch lạc cho câu lệnh.

đối tượng liên tục

Một tính năng dấu phẩy động với vô số giá trị có thể có, chẳng hạn như nhiệt độ hoặc trọng lượng.

Tương phản với tính chất rời rạc.

lấy mẫu tiện lợi

Sử dụng một tập dữ liệu không được thu thập một cách khoa học để chạy các thử nghiệm nhanh. Sau đó, bạn cần chuyển sang một tập dữ liệu được thu thập một cách khoa học.

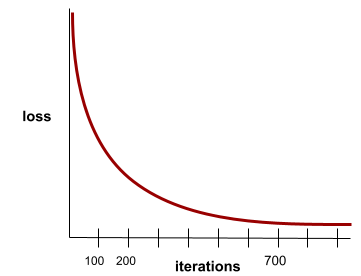

sự hội tụ

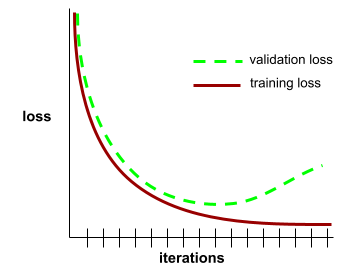

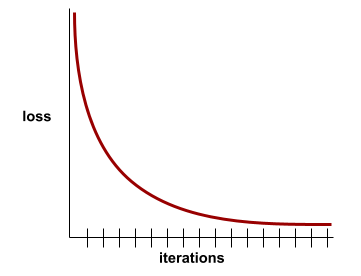

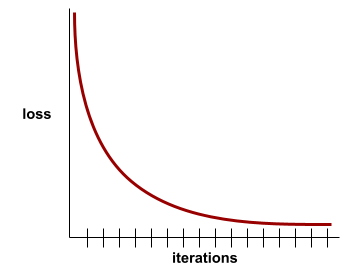

Một trạng thái đạt được khi các giá trị mất mát thay đổi rất ít hoặc không thay đổi chút nào trong mỗi lần lặp lại. Ví dụ: đường cong tổn thất sau đây cho thấy sự hội tụ ở khoảng 700 lần lặp:

Một mô hình hội tụ khi việc huấn luyện thêm sẽ không cải thiện mô hình.

Trong học sâu, các giá trị tổn thất đôi khi vẫn không đổi hoặc gần như không đổi trong nhiều lần lặp lại trước khi giảm xuống. Trong một khoảng thời gian dài có các giá trị tổn thất không đổi, bạn có thể tạm thời có cảm giác sai lầm về sự hội tụ.

Xem thêm dừng sớm.

Hãy xem phần Đường cong hội tụ mô hình và đường cong tổn thất trong Khoá học cấp tốc về học máy để biết thêm thông tin.

lập trình đàm thoại

Một cuộc đối thoại lặp đi lặp lại giữa bạn và một mô hình AI tạo sinh nhằm mục đích tạo ra phần mềm. Bạn đưa ra một câu lệnh mô tả một số phần mềm. Sau đó, mô hình sẽ dùng nội dung mô tả đó để tạo mã. Sau đó, bạn đưa ra một câu lệnh mới để giải quyết các điểm yếu trong câu lệnh trước đó hoặc trong mã đã tạo, rồi mô hình sẽ tạo mã mới. Hai bạn sẽ tiếp tục trao đổi cho đến khi phần mềm được tạo ra đủ tốt.

Lập trình theo cảm hứng về cơ bản là ý nghĩa ban đầu của lập trình theo cảm hứng.

Tương phản với mã hoá theo quy cách.

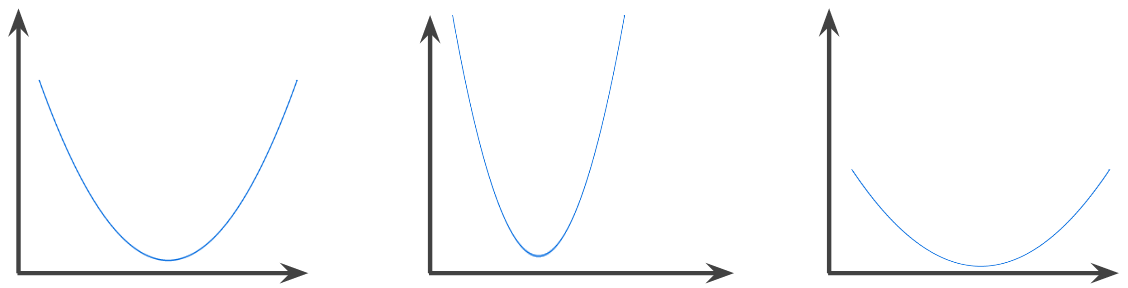

hàm lồi

Một hàm mà trong đó vùng phía trên đồ thị của hàm là một tập hợp lồi. Hàm lồi nguyên mẫu có dạng như chữ U. Ví dụ: tất cả hàm sau đều là hàm lồi:

Ngược lại, hàm sau đây không lồi. Lưu ý cách vùng phía trên biểu đồ không phải là một tập hợp lồi:

Hàm lồi hoàn toàn có đúng một điểm cực tiểu cục bộ, cũng là điểm cực tiểu toàn cục. Các hàm có dạng chữ U cổ điển là các hàm lồi hoàn toàn. Tuy nhiên, một số hàm lồi (ví dụ: đường thẳng) không có dạng chữ U.

Hãy xem phần Hàm hội tụ và hàm lồi trong Khoá học cấp tốc về học máy để biết thêm thông tin.

tối ưu hoá lồi

Quy trình sử dụng các kỹ thuật toán học như hạ độ dốc để tìm giá trị tối thiểu của một hàm lồi. Rất nhiều nghiên cứu về học máy tập trung vào việc xây dựng các vấn đề khác nhau dưới dạng các vấn đề tối ưu hoá lồi và giải quyết những vấn đề đó một cách hiệu quả hơn.

Để biết đầy đủ thông tin chi tiết, hãy xem Boyd và Vandenberghe, Tối ưu hoá lồi.

tập lồi

Một tập hợp con của không gian Euclide sao cho đường thẳng được vẽ giữa hai điểm bất kỳ trong tập hợp con vẫn hoàn toàn nằm trong tập hợp con. Ví dụ: 2 hình dạng sau đây là tập hợp lồi:

Ngược lại, 2 hình dạng sau đây không phải là tập hợp lồi:

tích chập

Trong toán học, nói một cách thông thường, một hỗn hợp của hai hàm. Trong học máy, phép tích chập kết hợp bộ lọc tích chập và ma trận đầu vào để huấn luyện trọng số.

Thuật ngữ "tích chập" trong học máy thường là cách gọi tắt của phép tích chập hoặc lớp tích chập.

Nếu không có các phép tích chập, thuật toán học máy sẽ phải học một trọng số riêng cho mọi ô trong một tensor lớn. Ví dụ: thuật toán học máy huấn luyện trên hình ảnh 2K x 2K sẽ buộc phải tìm 4M trọng số riêng biệt. Nhờ các phép tích chập, thuật toán học máy chỉ phải tìm trọng số cho từng ô trong bộ lọc tích chập, giúp giảm đáng kể bộ nhớ cần thiết để huấn luyện mô hình. Khi bộ lọc tích chập được áp dụng, bộ lọc này sẽ được sao chép trên các ô sao cho mỗi ô được nhân với bộ lọc.

bộ lọc tích chập

Một trong hai tác nhân trong phép tích chập. (Tác nhân còn lại là một phần của ma trận đầu vào.) Bộ lọc tích chập là một ma trận có cùng hạng với ma trận đầu vào, nhưng có hình dạng nhỏ hơn. Ví dụ: với ma trận đầu vào 28x28, bộ lọc có thể là bất kỳ ma trận 2D nào nhỏ hơn 28x28.

Trong việc chỉnh sửa ảnh, tất cả các ô trong bộ lọc tích chập thường được đặt thành một mẫu hằng số gồm các số 1 và 0. Trong quá trình máy học, các bộ lọc tích chập thường được gieo bằng các số ngẫu nhiên, sau đó mạng huấn luyện các giá trị lý tưởng.

lớp tích chập

Một lớp của mạng nơron sâu trong đó bộ lọc tích chập truyền dọc theo một ma trận đầu vào. Ví dụ: hãy xem xét bộ lọc tích chập 3x3 sau:

![Ma trận 3x3 có các giá trị sau: [[0,1,0], [1,0,1], [0,1,0]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalFilter33.svg?authuser=8&hl=vi)

Ảnh động sau đây cho thấy một lớp tích chập bao gồm 9 phép toán tích chập liên quan đến ma trận đầu vào 5x5. Lưu ý rằng mỗi phép toán tích chập hoạt động trên một lát cắt 3x3 khác nhau của ma trận đầu vào. Ma trận 3x3 thu được (ở bên phải) bao gồm kết quả của 9 phép toán tích chập:

![Ảnh động minh hoạ hai ma trận. Ma trận đầu tiên là ma trận 5x5: [[128,97,53,201,198], [35,22,25,200,195], [37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].

Ma trận thứ hai là ma trận 3x3: [[181,303,618], [115,338,605], [169,351,560]].

Ma trận thứ hai được tính bằng cách áp dụng bộ lọc tích chập [[0, 1, 0], [1, 0, 1], [0, 1, 0]] trên các tập hợp con 3x3 khác nhau của ma trận 5x5.](https://developers.google.cn/static/machine-learning/glossary/images/AnimatedConvolution.gif?authuser=8&hl=vi)

mạng nơron tích chập

Một mạng nơ-ron trong đó ít nhất một lớp là lớp tích chập. Một mạng nơ-ron tích chập điển hình bao gồm một số tổ hợp của các lớp sau:

Mạng nơ-ron tích chập đã đạt được thành công lớn trong một số loại vấn đề, chẳng hạn như nhận dạng hình ảnh.

phép tích chập

Phép toán gồm 2 bước sau:

- Phép nhân theo phần tử của bộ lọc tích chập và một lát cắt của ma trận đầu vào. (Lát của ma trận đầu vào có cùng thứ hạng và kích thước với bộ lọc tích chập.)

- Tổng của tất cả các giá trị trong ma trận sản phẩm thu được.

Ví dụ: hãy xem xét ma trận đầu vào 5x5 sau:

![Ma trận 5x5: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerInputMatrix.svg?authuser=8&hl=vi)

Bây giờ, hãy tưởng tượng bộ lọc tích chập 2x2 sau đây:

![Ma trận 2x2: [[1, 0], [0, 1]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerFilter.svg?authuser=8&hl=vi)

Mỗi phép toán tích chập liên quan đến một lát cắt 2x2 duy nhất của ma trận đầu vào. Ví dụ: giả sử chúng ta sử dụng lát cắt 2x2 ở trên cùng bên trái của ma trận đầu vào. Vì vậy, phép toán tích chập trên lát này có dạng như sau:

![Áp dụng bộ lọc tích chập [[1, 0], [0, 1]] cho phần 2x2 ở trên cùng bên trái của ma trận đầu vào, tức là [[128,97], [35,22]].

Bộ lọc tích chập giữ nguyên 128 và 22, nhưng đặt 97 và 35 thành 0. Do đó, phép toán tích chập sẽ cho ra giá trị 150 (128 + 22).](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerOperation.svg?authuser=8&hl=vi)

Lớp tích chập bao gồm một chuỗi các phép tích chập, mỗi phép tích chập hoạt động trên một lát cắt khác nhau của ma trận đầu vào.

COPA

Từ viết tắt của Lựa chọn thay thế hợp lý.

chi phí

Từ đồng nghĩa với thua.

cùng đào tạo

Phương pháp học bán giám sát đặc biệt hữu ích khi tất cả các điều kiện sau đây đều đúng:

- Tỷ lệ ví dụ chưa được gắn nhãn so với ví dụ đã được gắn nhãn trong tập dữ liệu là cao.

- Đây là một vấn đề phân loại (nhị phân hoặc đa mục).

- Tập dữ liệu chứa 2 tập hợp riêng biệt gồm các đặc điểm dự đoán độc lập với nhau và bổ sung cho nhau.

Về cơ bản, hoạt động đồng huấn luyện sẽ khuếch đại các tín hiệu độc lập thành một tín hiệu mạnh hơn. Ví dụ: hãy xem xét một mô hình phân loại phân loại từng chiếc xe đã qua sử dụng là Tốt hoặc Kém. Một nhóm các tính năng dự đoán có thể tập trung vào các đặc điểm tổng hợp như năm sản xuất, hãng sản xuất và mẫu xe; một nhóm các tính năng dự đoán khác có thể tập trung vào hồ sơ lái xe của chủ sở hữu trước và nhật ký bảo dưỡng của xe.

Bài viết mang tính đột phá về đồng huấn luyện là Kết hợp dữ liệu được gắn nhãn và dữ liệu chưa được gắn nhãn bằng phương pháp đồng huấn luyện của Blum và Mitchell.

tính công bằng phản thực tế

Chỉ số công bằng kiểm tra xem mô hình phân loại có đưa ra cùng một kết quả cho một cá nhân như kết quả của một cá nhân khác giống với cá nhân đầu tiên hay không, ngoại trừ một hoặc nhiều thuộc tính nhạy cảm. Đánh giá mô hình phân loại để đảm bảo tính công bằng phản thực tế là một phương pháp để tìm ra các nguồn thiên kiến tiềm ẩn trong một mô hình.

Hãy xem một trong hai phần sau để biết thêm thông tin:

- Tính công bằng: Tính công bằng phản thực tế trong Khoá học học máy ứng dụng.

- Khi các thế giới va chạm: Tích hợp các giả định phản thực tế khác nhau về tính công bằng

thiên kiến do thiếu bao quát

Xem phần thiên vị do cách chọn mẫu.

hiện tượng hoa nở đột ngột

Một câu hoặc cụm từ có nghĩa mơ hồ. Crash blossom (vấn đề về sự hiểu lầm) là một vấn đề đáng kể trong việc hiểu ngôn ngữ tự nhiên. Ví dụ: tiêu đề Red Tape Holds Up Skyscraper (Quan liêu cản trở việc xây dựng toà nhà chọc trời) là một tiêu đề gây hiểu lầm vì mô hình NLU có thể diễn giải tiêu đề theo nghĩa đen hoặc theo nghĩa bóng.

nhà phê bình

Từ đồng nghĩa với Mạng Q sâu.

cross-entropy

Một khái quát hoá của Log Loss thành vấn đề phân loại đa lớp. Cross-entropy định lượng sự khác biệt giữa hai hàm phân phối xác suất. Xem thêm độ phức tạp.

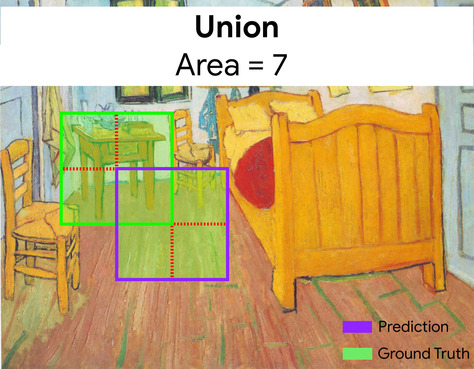

xác thực chéo

Một cơ chế để ước tính mức độ khái quát hoá của mô hình đối với dữ liệu mới bằng cách kiểm thử mô hình dựa trên một hoặc nhiều tập hợp con dữ liệu không chồng chéo được giữ lại từ tập huấn luyện.

hàm phân phối tích luỹ (CDF)

Một hàm xác định tần suất của các mẫu nhỏ hơn hoặc bằng một giá trị mục tiêu. Ví dụ: hãy xem xét hàm phân phối chuẩn của các giá trị liên tục. CDF cho biết khoảng 50% mẫu phải nhỏ hơn hoặc bằng giá trị trung bình và khoảng 84% mẫu phải nhỏ hơn hoặc bằng một độ lệch chuẩn so với giá trị trung bình.

D

phân tích dữ liệu

Hiểu rõ dữ liệu bằng cách xem xét các mẫu, phép đo và hình ảnh hoá. Phân tích dữ liệu có thể đặc biệt hữu ích khi bạn nhận được một tập dữ liệu lần đầu tiên, trước khi bạn tạo mô hình đầu tiên. Việc này cũng rất quan trọng trong việc tìm hiểu các thử nghiệm và gỡ lỗi các vấn đề với hệ thống.

tăng cường dữ liệu

Tăng cường phạm vi và số lượng ví dụ huấn luyện một cách giả tạo bằng cách chuyển đổi ví dụ hiện có để tạo thêm ví dụ. Ví dụ: giả sử hình ảnh là một trong những tính năng của bạn, nhưng tập dữ liệu của bạn không chứa đủ ví dụ về hình ảnh để mô hình học được các mối liên kết hữu ích. Tốt nhất là bạn nên thêm đủ hình ảnh được gắn nhãn vào tập dữ liệu để mô hình của bạn có thể huấn luyện đúng cách. Nếu không thể, việc tăng cường dữ liệu có thể xoay, kéo giãn và phản chiếu từng hình ảnh để tạo ra nhiều biến thể của bức ảnh gốc, có thể tạo ra đủ dữ liệu được gắn nhãn để cho phép quá trình huấn luyện diễn ra hiệu quả.

DataFrame

Một kiểu dữ liệu pandas phổ biến để biểu thị tập dữ liệu trong bộ nhớ.

DataFrame tương tự như một bảng hoặc bảng tính. Mỗi cột của DataFrame có một tên (tiêu đề) và mỗi hàng được xác định bằng một số duy nhất.

Mỗi cột trong DataFrame được cấu trúc như một mảng 2D, ngoại trừ việc mỗi cột có thể được chỉ định kiểu dữ liệu riêng.

Bạn cũng có thể xem trang tham chiếu pandas.DataFrame chính thức.

tính song song của dữ liệu

Một cách để mở rộng quy mô huấn luyện hoặc suy luận bằng cách sao chép toàn bộ mô hình sang nhiều thiết bị, sau đó truyền một tập hợp con của dữ liệu đầu vào đến từng thiết bị. Tính song song dữ liệu có thể cho phép huấn luyện và suy luận trên kích thước lô rất lớn; tuy nhiên, tính song song dữ liệu yêu cầu mô hình phải đủ nhỏ để phù hợp với mọi thiết bị.

Tính song song của dữ liệu thường giúp tăng tốc quá trình huấn luyện và suy luận.

Xem thêm song song hoá mô hình.

Dataset API (tf.data)

Một API TensorFlow cấp cao để đọc dữ liệu và chuyển đổi dữ liệu đó thành dạng mà thuật toán học máy yêu cầu.

Một đối tượng tf.data.Dataset biểu thị một chuỗi các phần tử, trong đó mỗi phần tử chứa một hoặc nhiều Tensor. Đối tượng tf.data.Iterator cung cấp quyền truy cập vào các phần tử của Dataset.

tập dữ liệu hoặc bộ dữ liệu

Một tập hợp dữ liệu thô, thường (nhưng không chỉ) được sắp xếp theo một trong các định dạng sau:

- bảng tính

- một tệp ở định dạng CSV (giá trị được phân tách bằng dấu phẩy)

ranh giới quyết định

Đường phân cách giữa các lớp mà mô hình học được trong vấn đề phân loại nhị phân hoặc phân loại nhiều lớp. Ví dụ: trong hình ảnh sau đây biểu thị một vấn đề phân loại nhị phân, ranh giới quyết định là ranh giới giữa lớp màu cam và lớp màu xanh dương:

rừng quyết định

Một mô hình được tạo từ nhiều cây quyết định. Rừng quyết định đưa ra dự đoán bằng cách tổng hợp các dự đoán của cây quyết định. Các loại rừng quyết định phổ biến bao gồm rừng ngẫu nhiên và cây tăng cường độ dốc.

Hãy xem phần Rừng quyết định trong khoá học Rừng quyết định để biết thêm thông tin.

ngưỡng quyết định

Từ đồng nghĩa với ngưỡng phân loại.

cây quyết định

Một mô hình học có giám sát bao gồm một tập hợp các điều kiện và các nút lá được sắp xếp theo thứ bậc. Ví dụ: sau đây là một cây quyết định:

bộ giải mã

Nói chung, mọi hệ thống học máy chuyển đổi từ một biểu diễn đã xử lý, dày đặc hoặc nội bộ sang một biểu diễn thô, thưa thớt hoặc bên ngoài hơn.

Bộ giải mã thường là một thành phần của mô hình lớn hơn, trong đó chúng thường được ghép nối với một bộ mã hoá.

Trong các tác vụ từ chuỗi đến chuỗi, bộ giải mã bắt đầu bằng trạng thái nội bộ do bộ mã hoá tạo ra để dự đoán chuỗi tiếp theo.

Tham khảo Transformer để biết định nghĩa về bộ giải mã trong kiến trúc Transformer.

Hãy xem phần Mô hình ngôn ngữ lớn trong Khoá học học máy ứng dụng để biết thêm thông tin.

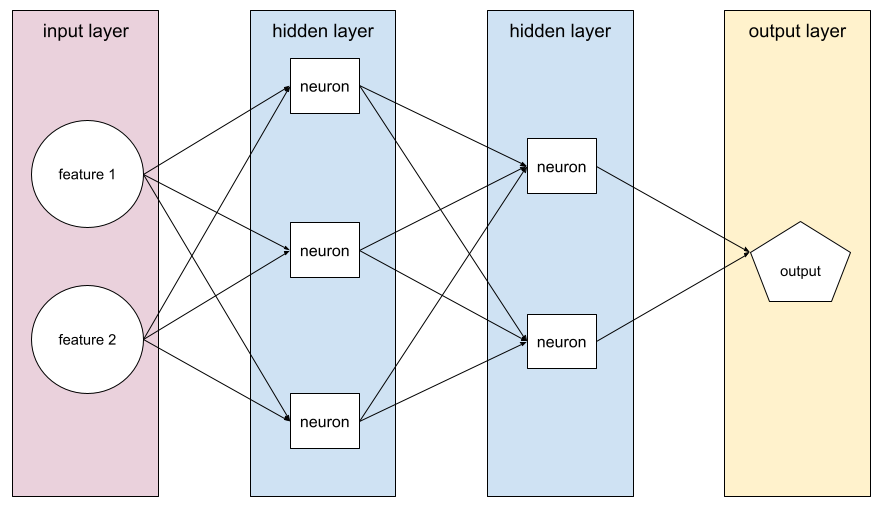

mô hình sâu

Một mạng nơ-ron chứa nhiều lớp ẩn.

Mô hình sâu còn được gọi là mạng nơron sâu.

Tương phản với mô hình rộng.

mạng nơron sâu

Từ đồng nghĩa với mô hình sâu.

Mạng Q sâu (DQN)

Trong Q-learning, một mạng nơron sâu dự đoán các hàm Q.

Critic là từ đồng nghĩa với Deep Q-Network.

tương đương về nhân khẩu học

Một chỉ số công bằng được đáp ứng nếu kết quả phân loại của một mô hình không phụ thuộc vào một thuộc tính nhạy cảm nhất định.

Ví dụ: nếu cả người Lilliput và người Brobdingnag đều đăng ký vào Đại học Glubbdubdrib, thì sự bình đẳng về nhân khẩu học sẽ đạt được nếu tỷ lệ phần trăm người Lilliput được nhận vào học bằng với tỷ lệ phần trăm người Brobdingnag được nhận vào học, bất kể một nhóm có trình độ chuyên môn cao hơn nhóm còn lại hay không.

Tương phản với tỷ lệ cược cân bằng và cơ hội bình đẳng, cho phép kết quả phân loại tổng hợp phụ thuộc vào các thuộc tính nhạy cảm, nhưng không cho phép kết quả phân loại cho một số nhãn dữ liệu thực tế được chỉ định phụ thuộc vào các thuộc tính nhạy cảm. Xem bài viết "Chống phân biệt đối xử bằng công nghệ học máy thông minh hơn" để xem hình ảnh minh hoạ về những điểm đánh đổi khi tối ưu hoá để đạt được sự bình đẳng về nhân khẩu học.

Hãy xem phần Tính công bằng: sự ngang bằng về nhân khẩu học trong Khoá học học máy ứng dụng để biết thêm thông tin.

khử nhiễu

Một phương pháp phổ biến để tự học có giám sát, trong đó:

Việc khử nhiễu giúp bạn học từ các ví dụ không được gắn nhãn. Tập dữ liệu ban đầu đóng vai trò là mục tiêu hoặc nhãn và dữ liệu nhiễu đóng vai trò là dữ liệu đầu vào.

Một số mô hình ngôn ngữ được che giấu sử dụng phương pháp khử nhiễu như sau:

- Nhiễu được thêm vào một câu chưa được gắn nhãn một cách nhân tạo bằng cách che một số mã thông báo.

- Mô hình này cố gắng dự đoán các mã thông báo ban đầu.

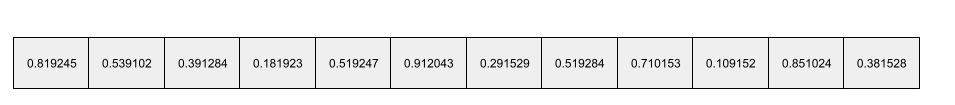

tính chất dày đặc

Một đặc điểm trong đó hầu hết hoặc tất cả các giá trị đều khác 0, thường là một Tensor gồm các giá trị dấu phẩy động. Ví dụ: Tensor gồm 10 phần tử sau đây là Tensor dày đặc vì 9 trong số các giá trị của Tensor này khác 0:

| 8 | 3 | 7 | 5 | 2 | 4 | 0 | 4 | 9 | 6 |

Tương phản với tính chất thưa.

lớp dày đặc

Từ đồng nghĩa với lớp liên thông đầy đủ.

độ sâu

Tổng của những nội dung sau trong một mạng nơron:

- số lượng lớp ẩn

- số lượng lớp đầu ra, thường là 1

- số lượng lớp nhúng bất kỳ

Ví dụ: một mạng nơ-ron có 5 lớp ẩn và 1 lớp đầu ra có độ sâu là 6.

Xin lưu ý rằng lớp đầu vào không ảnh hưởng đến độ sâu.

mạng nơron tích chập có thể phân tách theo chiều sâu (sepCNN)

Một cấu trúc mạng nơ-ron tích chập dựa trên Inception, nhưng trong đó các mô-đun Inception được thay thế bằng các phép tích chập có thể phân tách theo chiều sâu. Còn được gọi là Xception.

Phép tích chập có thể tách theo chiều sâu (còn được gọi là phép tích chập có thể tách) phân tích một phép tích chập 3D tiêu chuẩn thành 2 phép tích chập riêng biệt có hiệu quả tính toán cao hơn: thứ nhất, phép tích chập theo chiều sâu, với độ sâu là 1 (n ✕ n ✕ 1) và thứ hai, phép tích chập theo điểm, với chiều dài và chiều rộng là 1 (1 ✕ 1 ✕ n).

Để tìm hiểu thêm, hãy xem bài viết Xception: Học sâu với các phép tích chập có thể phân tách theo chiều sâu.

nhãn dẫn xuất

Từ đồng nghĩa với nhãn đại diện.

thiết bị

Một thuật ngữ được nạp chồng với 2 định nghĩa có thể có sau đây:

- Một danh mục phần cứng có thể chạy một phiên TensorFlow, bao gồm CPU, GPU và TPU.

- Khi huấn luyện một mô hình học máy trên các chip tăng tốc (GPU hoặc TPU), phần của hệ thống thực sự thao tác với các tensor và các mục nhúng. Thiết bị chạy trên các chip tăng tốc. Ngược lại, máy chủ thường chạy trên CPU.

sự riêng tư biệt lập

Trong học máy, một phương pháp ẩn danh để bảo vệ mọi dữ liệu nhạy cảm (ví dụ: thông tin cá nhân của một cá nhân) có trong tập huấn luyện của mô hình khỏi bị lộ. Phương pháp này đảm bảo rằng mô hình không học hoặc ghi nhớ nhiều thông tin về một cá nhân cụ thể. Điều này được thực hiện bằng cách lấy mẫu và thêm thành phần nhiễu trong quá trình huấn luyện mô hình để che giấu các điểm dữ liệu riêng lẻ, giảm thiểu nguy cơ để lộ dữ liệu huấn luyện nhạy cảm.

Sự riêng tư biệt lập cũng được sử dụng bên ngoài công nghệ học máy. Ví dụ: đôi khi các nhà khoa học dữ liệu sử dụng quyền riêng tư biệt lập để bảo vệ quyền riêng tư của từng cá nhân khi tính toán số liệu thống kê về mức sử dụng sản phẩm cho các nhóm nhân khẩu học khác nhau.

giảm chiều

Giảm số lượng phương diện được dùng để biểu thị một tính năng cụ thể trong vectơ tính năng, thường là bằng cách chuyển đổi sang một vectơ nhúng.

phương diện

Thuật ngữ bị nạp chồng có một trong các định nghĩa sau:

Số lượng cấp toạ độ trong một Tensor. Ví dụ:

- Một đại lượng vô hướng có 0 chiều; ví dụ:

["Hello"]. - Một vectơ có một chiều; ví dụ:

[3, 5, 7, 11]. - Ma trận có hai phương diện; ví dụ:

[[2, 4, 18], [5, 7, 14]]. Bạn có thể chỉ định một ô cụ thể trong một vectơ một chiều bằng một toạ độ; bạn cần hai toạ độ để chỉ định một ô cụ thể trong ma trận hai chiều.

- Một đại lượng vô hướng có 0 chiều; ví dụ:

Số mục trong một vectơ đối tượng.

Số lượng phần tử trong một lớp nhúng.

đặt câu lệnh trực tiếp

Từ đồng nghĩa với đặt câu lệnh không kèm ví dụ.

tính chất rời rạc

Một đặc điểm có một tập hợp hữu hạn các giá trị có thể có. Ví dụ: một đối tượng có các giá trị chỉ có thể là động vật, thực vật hoặc khoáng chất là một đối tượng rời rạc (hoặc phân loại).

Tương phản với tính năng liên tục.

mô hình phân biệt

Một mô hình dự đoán nhãn từ một tập hợp gồm một hoặc nhiều đặc điểm. Cụ thể hơn, các mô hình phân biệt xác định xác suất có điều kiện của một đầu ra nhất định dựa trên các đặc điểm và trọng số; tức là:

p(output | features, weights)

Ví dụ: một mô hình dự đoán xem email có phải là thư rác hay không dựa trên các đặc điểm và trọng số là một mô hình phân biệt.

Phần lớn các mô hình học có giám sát, bao gồm cả mô hình phân loại và mô hình hồi quy, đều là mô hình phân biệt.

Tương phản với mô hình tạo sinh.

thuộc tính phân biệt

Một hệ thống xác định xem ví dụ là thật hay giả.

Ngoài ra, đây còn là hệ thống con trong mạng đối nghịch tạo sinh, giúp xác định xem các ví dụ do trình tạo tạo ra là thật hay giả.

Hãy xem Phân biệt đối xử trong khoá học về GAN để biết thêm thông tin.

tác động không tương xứng

Đưa ra quyết định về những người có tác động không cân xứng đến các nhóm nhỏ dân số khác nhau. Điều này thường đề cập đến những tình huống mà quy trình ra quyết định dựa trên thuật toán gây hại hoặc mang lại lợi ích cho một số nhóm nhỏ nhiều hơn những nhóm khác.

Ví dụ: giả sử một thuật toán xác định xem người Lilliput có đủ điều kiện vay tiền mua nhà thu nhỏ hay không có nhiều khả năng phân loại họ là "không đủ điều kiện" nếu địa chỉ gửi thư của họ có một mã bưu chính nhất định. Nếu người Lilliput sử dụng hệ thống Big-Endian có nhiều khả năng có địa chỉ gửi thư với mã bưu chính này hơn người Lilliput sử dụng hệ thống Little-Endian, thì thuật toán này có thể dẫn đến tác động không tương xứng.

Tương phản với đối xử phân biệt, tập trung vào sự chênh lệch do đặc điểm của nhóm nhỏ là thông tin đầu vào rõ ràng cho quy trình đưa ra quyết định bằng thuật toán.

đối xử phân biệt

Đưa thuộc tính nhạy cảm của đối tượng vào quy trình ra quyết định dựa trên thuật toán sao cho các nhóm nhỏ khác nhau của mọi người được đối xử khác nhau.

Ví dụ: hãy xem xét một thuật toán xác định xem người Lilliput có đủ điều kiện để vay tiền mua nhà thu nhỏ hay không dựa trên dữ liệu mà họ cung cấp trong đơn đăng ký vay. Nếu thuật toán sử dụng mối quan hệ của người Lilliputian với Big-Endian hoặc Little-Endian làm dữ liệu đầu vào, thì thuật toán đó đang thực hiện việc đối xử phân biệt theo phương diện đó.

Tương phản với tác động không tương xứng, tập trung vào sự khác biệt trong tác động xã hội của các quyết định dựa trên thuật toán đối với các nhóm nhỏ, bất kể những nhóm nhỏ đó có phải là dữ liệu đầu vào cho mô hình hay không.

chưng cất

Quy trình giảm kích thước của một mô hình (được gọi là mô hình gốc) thành một mô hình nhỏ hơn (được gọi là mô hình đích) mô phỏng các dự đoán của mô hình gốc một cách trung thực nhất có thể. Chưng cất rất hữu ích vì mô hình nhỏ hơn có 2 lợi ích chính so với mô hình lớn hơn (mô hình gốc):

- Thời gian suy luận nhanh hơn

- Giảm mức sử dụng bộ nhớ và năng lượng

Tuy nhiên, các dự đoán của học viên thường không chính xác bằng dự đoán của giáo viên.

Chưng cất giúp huấn luyện mô hình học viên để giảm thiểu hàm tổn thất dựa trên sự khác biệt giữa các kết quả dự đoán của mô hình học viên và mô hình giáo viên.

So sánh và đối chiếu phương pháp chưng cất với các thuật ngữ sau:

Hãy xem phần Mô hình ngôn ngữ lớn: Tinh chỉnh, chưng cất và kỹ thuật tạo câu lệnh trong Khoá học cấp tốc về học máy để biết thêm thông tin.

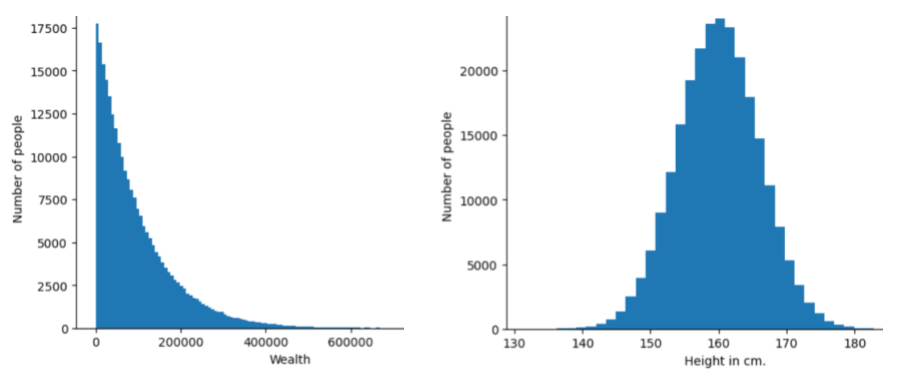

Phân phối

Tần suất và phạm vi của các giá trị khác nhau cho một tính năng hoặc nhãn nhất định. Phân phối cho biết khả năng xuất hiện của một giá trị cụ thể.

Hình ảnh sau đây cho thấy biểu đồ tần suất của 2 phân phối khác nhau:

- Ở bên trái, một quy luật lũy thừa về sự phân phối của cải so với số người sở hữu của cải đó.

- Ở bên phải, một phân phối chuẩn về chiều cao so với số người có chiều cao đó.

Việc tìm hiểu mức phân phối của từng đối tượng và nhãn có thể giúp bạn xác định cách chuẩn hoá các giá trị và phát hiện giá trị ngoại lệ.

Cụm từ ngoài phân phối đề cập đến một giá trị không xuất hiện trong tập dữ liệu hoặc rất hiếm khi xuất hiện. Ví dụ: hình ảnh về hành tinh Thổ Tinh sẽ được coi là nằm ngoài phân phối đối với một tập dữ liệu bao gồm hình ảnh mèo.

phân cụm phân chia

Xem phần phân cụm theo hệ thống phân cấp.

giảm tốc độ lấy mẫu

Thuật ngữ có nhiều nghĩa, có thể mang một trong những ý nghĩa sau:

- Giảm lượng thông tin trong một đối tượng để huấn luyện mô hình hiệu quả hơn. Ví dụ: trước khi huấn luyện mô hình nhận dạng hình ảnh, hãy giảm độ phân giải của hình ảnh có độ phân giải cao xuống định dạng có độ phân giải thấp hơn.

- Huấn luyện trên một tỷ lệ phần trăm thấp không cân xứng của các ví dụ về lớp được biểu thị quá mức để cải thiện việc huấn luyện mô hình trên các lớp được biểu thị dưới mức. Ví dụ: trong tập dữ liệu không cân bằng lớp, các mô hình có xu hướng tìm hiểu nhiều về lớp đa số và không đủ về lớp thiểu số. Giảm mẫu giúp cân bằng lượng dữ liệu huấn luyện cho các lớp đa số và thiểu số.

Hãy xem phần Tập dữ liệu: Tập dữ liệu bất cân đối trong Khoá học học máy ứng dụng để biết thêm thông tin.

DQN

Từ viết tắt của Mạng Q sâu.

điều hoà dropout

Một dạng điều chỉnh hữu ích trong việc huấn luyện mạng nơ-ron. Việc điều chỉnh bằng cách loại bỏ sẽ loại bỏ một lựa chọn ngẫu nhiên gồm một số lượng cố định các đơn vị trong một lớp mạng cho một bước gradient duy nhất. Càng nhiều đơn vị bị loại bỏ thì quá trình điều chỉnh càng mạnh. Điều này tương tự như việc huấn luyện mạng để mô phỏng một tập hợp lớn theo cấp số nhân gồm các mạng nhỏ hơn. Để biết thông tin chi tiết, hãy xem bài viết Dropout: A Simple Way to Prevent Neural Networks from Overfitting (Dropout: Một cách đơn giản để ngăn mạng nơ-ron bị khớp quá mức).

linh động

Một việc được thực hiện thường xuyên hoặc liên tục. Các thuật ngữ động và trực tuyến là từ đồng nghĩa trong học máy. Sau đây là những cách sử dụng phổ biến của động và trực tuyến trong học máy:

- Mô hình động (hoặc mô hình trực tuyến) là mô hình được đào tạo lại thường xuyên hoặc liên tục.

- Đào tạo linh hoạt (hoặc đào tạo trực tuyến) là quy trình đào tạo thường xuyên hoặc liên tục.

- Suy luận động (hoặc suy luận trực tuyến) là quy trình tạo ra các dự đoán theo yêu cầu.

mô hình động

Một mô hình thường xuyên (thậm chí là liên tục) được huấn luyện lại. Mô hình động là một "người học tập suốt đời" không ngừng thích ứng với dữ liệu đang phát triển. Mô hình động còn được gọi là mô hình trực tuyến.

Tương phản với mô hình tĩnh.

E

thực thi tức thì

Một môi trường lập trình TensorFlow mà trong đó các thao tác chạy ngay lập tức. Ngược lại, các thao tác được gọi trong thực thi đồ thị sẽ không chạy cho đến khi được đánh giá một cách rõ ràng. Thực thi tức thì là một giao diện bắt buộc, giống như mã trong hầu hết các ngôn ngữ lập trình. Các chương trình thực thi tức thì thường dễ gỡ lỗi hơn nhiều so với các chương trình thực thi đồ thị.

dừng sớm

Một phương pháp điều chỉnh liên quan đến việc kết thúc đào tạo trước khi quá trình giảm tổn thất đào tạo kết thúc. Trong tính năng dừng sớm, bạn cố ý dừng huấn luyện mô hình khi mức tổn thất trên tập dữ liệu xác thực bắt đầu tăng; tức là khi hiệu suất khái quát hoá trở nên kém hơn.

Tương phản với thoát sớm.

khoảng cách di chuyển của đất (EMD)

Thước đo mức độ tương đồng tương đối của hai phân phối. Khoảng cách của máy xúc càng thấp thì các bản phân phối càng giống nhau.

khoảng cách chỉnh sửa

Một chỉ số đo lường mức độ tương đồng giữa hai chuỗi văn bản. Trong học máy, khoảng cách chỉnh sửa rất hữu ích vì những lý do sau:

- Khoảng cách chỉnh sửa rất dễ tính toán.

- Khoảng cách chỉnh sửa có thể so sánh hai chuỗi được biết là tương tự nhau.

- Khoảng cách chỉnh sửa có thể xác định mức độ tương tự của các chuỗi khác nhau với một chuỗi nhất định.

Có một số định nghĩa về khoảng cách chỉnh sửa, mỗi định nghĩa sử dụng các thao tác khác nhau trên chuỗi. Hãy xem khoảng cách Levenshtein để biết ví dụ.

Ký hiệu Einsum

Một ký hiệu hiệu quả để mô tả cách kết hợp hai tensor. Các tensor được kết hợp bằng cách nhân các phần tử của một tensor với các phần tử của tensor kia, sau đó cộng các tích lại với nhau. Ký hiệu Einsum dùng các biểu tượng để xác định các trục của từng tenxơ và các biểu tượng đó được sắp xếp lại để chỉ định hình dạng của tenxơ kết quả mới.

NumPy cung cấp một cách triển khai Einsum phổ biến.

lớp nhúng

Một lớp ẩn đặc biệt huấn luyện trên một đặc điểm phân loại có nhiều chiều để dần dần tìm hiểu một vectơ nhúng có ít chiều hơn. Lớp nhúng cho phép mạng nơ-ron huấn luyện hiệu quả hơn nhiều so với chỉ huấn luyện trên đặc điểm phân loại nhiều chiều.

Ví dụ: Earth hiện hỗ trợ khoảng 73.000 loài cây. Giả sử loài cây là một đối tượng trong mô hình của bạn, vì vậy,lớp đầu vào của mô hình sẽ bao gồm một vectơ mã hoá một lần có độ dài 73.000 phần tử.

Ví dụ: có lẽ baobab sẽ được biểu thị như sau: