Halaman ini berisi istilah glosarium Evaluasi Bahasa. Untuk semua istilah glosarium, klik di sini.

A

Attention,

Mekanisme yang digunakan dalam jaringan neural yang menunjukkan pentingnya kata atau bagian kata tertentu. Perhatian mengompresi jumlah informasi yang diperlukan model untuk memprediksi token/kata berikutnya. Mekanisme perhatian standar mungkin terdiri dari jumlah berbobot pada sekumpulan input, dengan bobot untuk setiap input dihitung oleh bagian lain dari jaringan neural.

Lihat juga self-attention dan multi-head self-attention, yang merupakan elemen penyusun Transformer.

Lihat LLM: Apa itu model bahasa besar? di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya tentang perhatian mandiri.

autoencoder

Sistem yang mempelajari cara mengekstrak informasi yang paling penting dari input. Autoencoder adalah kombinasi dari encoder dan decoder. Autoencoder mengandalkan proses dua langkah berikut:

- Encoder memetakan input ke format (biasanya) dengan dimensi lebih rendah (perantara) yang mengalami derau.

- Dekoder membuat versi lossy dari input asli dengan memetakan format dimensi yang lebih rendah ke format input dimensi yang lebih tinggi.

Autoencoder dilatih secara menyeluruh dengan meminta decoder untuk merekonstruksi input asli dari format perantara encoder sesecara mungkin. Karena format perantara lebih kecil (dimensi lebih rendah) daripada format asli, autoencoder dipaksa untuk mempelajari informasi apa yang penting dalam input, dan output tidak akan sama persis dengan input.

Contoh:

- Jika data input adalah grafik, salinan yang tidak sama persis akan mirip dengan grafik asli, tetapi sedikit dimodifikasi. Mungkin salinan yang tidak sama menghapus derau dari gambar asli atau mengisi beberapa piksel yang hilang.

- Jika data input adalah teks, autoencoder akan menghasilkan teks baru yang meniru (tetapi tidak identik dengan) teks asli.

Lihat juga autoencoder variasional.

evaluasi otomatis

Menggunakan software untuk menilai kualitas output model.

Jika output model relatif sederhana, skrip atau program dapat membandingkan output model dengan respons emas. Jenis evaluasi otomatis ini terkadang disebut evaluasi terprogram. Metrik seperti ROUGE atau BLEU sering kali berguna untuk evaluasi terprogram.

Jika output model kompleks atau tidak memiliki satu jawaban yang benar, program ML terpisah yang disebut autorater terkadang melakukan evaluasi otomatis.

Berbeda dengan evaluasi manual.

evaluasi autorater

Mekanisme campuran untuk menilai kualitas output model AI generatif yang menggabungkan evaluasi manual dengan evaluasi otomatis. Autorater adalah model ML yang dilatih pada data yang dibuat oleh evaluasi manusia. Idealnya, pembuat otomatis akan belajar meniru evaluator manusia.Autorator bawaan tersedia, tetapi autorator terbaik dioptimalkan secara khusus untuk tugas yang Anda evaluasi.

model autoregresif

Model yang menyimpulkan prediksi berdasarkan prediksi sebelumnya. Misalnya, model bahasa autoregresif memprediksi token berikutnya berdasarkan token yang diprediksi sebelumnya. Semua model bahasa besar berbasis Transformer bersifat autoregresif.

Sebaliknya, model gambar berbasis GAN biasanya tidak bersifat autoregresif karena menghasilkan gambar dalam satu penerusan maju dan tidak secara iteratif dalam langkah-langkah. Namun, model pembuatan gambar tertentu adalah autoregresif karena membuat gambar secara bertahap.

presisi rata-rata pada k

Metrik untuk meringkas performa model pada satu perintah yang menghasilkan hasil yang diberi peringkat, seperti daftar rekomendasi buku yang diberi nomor. Presisi rata-rata pada k adalah rata-rata nilai presisi pada k untuk setiap hasil yang relevan. Oleh karena itu, formula untuk presisi rata-rata pada k adalah:

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

dalam hal ini:

- \(n\) adalah jumlah item yang relevan dalam daftar.

Berbeda dengan recall pada k.

B

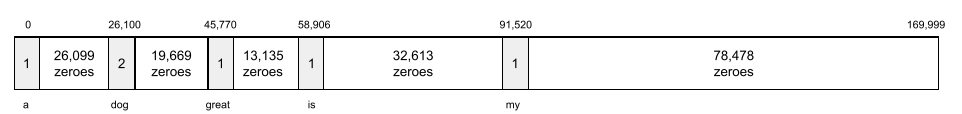

kantong data

Representasi kata dalam frasa atau bagian, terlepas dari urutannya. Misalnya, bag of words mewakili tiga frasa berikut secara identik:

- melompat

- melompat

- melompat

Setiap kata dipetakan ke indeks dalam vektor jarang, dengan vektor memiliki indeks untuk setiap kata dalam kosakata. Misalnya, frasa the dog jumps dipetakan ke dalam vektor fitur dengan nilai bukan nol pada tiga indeks yang sesuai dengan kata the, dog, dan jumps. Nilai non-nol dapat berupa salah satu dari hal berikut:

- 1 untuk menunjukkan keberadaan kata.

- Jumlah frekuensi kemunculan kata dalam bag. Misalnya, jika frasa tersebut adalah maroon adalah dengan bulu maroon, maka maroon dan akan direpresentasikan sebagai 2, sedangkan kata lainnya akan direpresentasikan sebagai 1.

- Beberapa nilai lainnya, seperti logaritma jumlah frekuensi kata muncul dalam bag.

BERT (Bidirectional Encoder Representations from Transformers)

Arsitektur model untuk representasi teks. Model BERT yang dilatih dapat bertindak sebagai bagian dari model yang lebih besar untuk klasifikasi teks atau tugas ML lainnya.

BERT memiliki karakteristik berikut:

- Menggunakan arsitektur Transformer, sehingga bergantung pada self-attention.

- Menggunakan bagian encoder dari Transformer. Tugas encoder adalah menghasilkan representasi teks yang baik, bukan untuk melakukan tugas tertentu seperti klasifikasi.

- Dua arah.

- Menggunakan masking untuk pelatihan tanpa pengawasan.

Varian BERT mencakup:

Lihat Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing untuk mengetahui ringkasan BERT.

dua arah

Istilah yang digunakan untuk menjelaskan sistem yang mengevaluasi teks yang mendahului dan mengikuti bagian teks target. Sebaliknya, sistem satu arah hanya mengevaluasi teks yang mendahului bagian teks target.

Misalnya, pertimbangkan model bahasa yang disamarkan yang harus menentukan probabilitas untuk kata atau kata yang mewakili garis bawah dalam pertanyaan berikut:

Apa _____ Anda?

Model bahasa satu arah harus mendasarkan probabilitasnya hanya pada konteks yang diberikan oleh kata "Apa", "adalah", dan "yang". Sebaliknya, model bahasa dua arah juga dapat memperoleh konteks dari "dengan" dan "Anda", yang dapat membantu model menghasilkan prediksi yang lebih baik.

model bahasa dua arah

Model bahasa yang menentukan probabilitas bahwa token tertentu ada di lokasi tertentu dalam cuplikan teks berdasarkan teks sebelumnya dan berikutnya.

bigram

N-gram yang mana N=2.

BLEU (Bilingual Evaluation Understudy)

Metrik antara 0,0 dan 1,0 untuk mengevaluasi terjemahan mesin, misalnya, dari bahasa Spanyol ke bahasa Jepang.

Untuk menghitung skor, BLEU biasanya membandingkan terjemahan model ML (teks yang dihasilkan) dengan terjemahan pakar manusia (teks referensi). Tingkat kecocokan N-gram dalam teks yang dihasilkan dan teks referensi menentukan skor BLEU.

Makalah asli tentang metrik ini adalah BLEU: a Method for Automatic Evaluation of Machine Translation.

Lihat juga BLEURT.

BLEURT (Bilingual Evaluation Understudy from Transformers)

Metrik untuk mengevaluasi terjemahan mesin dari satu bahasa ke bahasa lain, terutama ke dan dari bahasa Inggris.

Untuk terjemahan ke dan dari bahasa Inggris, BLEURT lebih selaras dengan rating manusia daripada BLEU. Tidak seperti BLEU, BLEURT menekankan kesamaan semantik (makna) dan dapat mengakomodasi parafrase.

BLEURT mengandalkan model bahasa besar terlatih (tepatnya BERT) yang kemudian dioptimalkan pada teks dari penerjemah manusia.

Makalah asli tentang metrik ini adalah BLEURT: Learning Robust Metrics for Text Generation.

C

model bahasa kausal

Sinonim dari model bahasa searah.

Lihat model bahasa dua arah untuk membandingkan berbagai pendekatan arah dalam pemodelan bahasa.

prompting chain-of-thought

Teknik prompt engineering yang mendorong model bahasa besar (LLM) untuk menjelaskan pemikirannya, langkah demi langkah. Misalnya, pertimbangkan perintah berikut, dengan memperhatikan kalimat kedua secara khusus:

Berapa gaya g yang akan dialami pengemudi dalam mobil yang melaju dari 0 hingga 60 mil per jam dalam 7 detik? Dalam jawaban, tampilkan semua penghitungan yang relevan.

Respons LLM kemungkinan akan:

- Tampilkan urutan formula fisika, dengan memasukkan nilai 0, 60, dan 7 di tempat yang sesuai.

- Jelaskan alasan formula tersebut dipilih dan arti berbagai variabel.

Perintah chain-of-thought memaksa LLM untuk melakukan semua penghitungan, yang mungkin menghasilkan jawaban yang lebih benar. Selain itu, perintah chain-of-thought memungkinkan pengguna memeriksa langkah-langkah LLM untuk menentukan apakah jawaban tersebut masuk akal atau tidak.

chat

Konten dialog dua arah dengan sistem ML, biasanya model bahasa besar. Interaksi sebelumnya dalam chat (apa yang Anda ketik dan bagaimana model bahasa besar merespons) menjadi konteks untuk bagian chat berikutnya.

Chatbot adalah aplikasi model bahasa besar.

konfabulasi

Sinonim dari halusinasi.

Konfabulasi mungkin merupakan istilah yang secara teknis lebih akurat daripada halusinasi. Namun, halusinasi menjadi populer terlebih dahulu.

penguraian konstituensi

Membagi kalimat menjadi struktur tata bahasa yang lebih kecil ("konstituen"). Bagian selanjutnya dari sistem ML, seperti model natural language understanding, dapat mengurai konstituen dengan lebih mudah daripada kalimat asli. Misalnya, pertimbangkan kalimat berikut:

Teman saya mengadopsi dua ekor kucing.

Parser konstituen dapat membagi kalimat ini menjadi dua konstituen berikut:

- Teman saya adalah frasa kata benda.

- mengadopsi dua kucing adalah frasa kata kerja.

Konstituen ini dapat dibagi lagi menjadi konstituen yang lebih kecil. Misalnya, frasa kata kerja

mengadopsi dua kucing

dapat dibagi lagi menjadi:

- adopted adalah kata kerja.

- dua kucing adalah frasa kata benda lainnya.

penyematan bahasa yang dikontekstualisasikan

Embedding yang mendekati "pemahaman" kata dan frasa dengan cara yang dapat dilakukan penutur asli manusia. Penyematan bahasa kontekstual dapat memahami sintaksis, semantik, dan konteks yang kompleks.

Misalnya, pertimbangkan penyematan kata bahasa Inggris cow. Penyematan lama seperti word2vec dapat merepresentasikan kata-kata bahasa Inggris sehingga jarak dalam ruang penyematan dari cow ke bull mirip dengan jarak dari ewe (domba betina) ke ram (domba jantan) atau dari female ke male. Penyematan bahasa yang dikontekstualisasikan dapat melangkah lebih jauh dengan mengenali bahwa penutur bahasa Inggris terkadang menggunakan kata cow secara santai untuk merujuk pada sapi atau banteng.

jendela konteks

Jumlah token yang dapat diproses model dalam perintah tertentu. Makin besar jendela konteks, makin banyak informasi yang dapat digunakan model untuk memberikan respons yang koheren dan konsisten kepada perintah.

frasa ambigu

Kalimat atau frasa dengan arti yang ambigu. Frasa ambigu menghadirkan masalah yang signifikan dalam natural language understanding. Misalnya, judul Red Tape Holds Up Skyscraper adalah frase ambigu karena model NLU dapat menafsirkan judul secara harfiah atau kiasan.

D

decoder

Secara umum, setiap sistem ML yang mengonversi dari representasi internal, padat, atau yang diproses menjadi representasi yang lebih mentah, jarang, atau eksternal.

Decoder sering kali merupakan komponen dari model yang lebih besar, yang sering kali dipasangkan dengan encoder.

Dalam tugas urutan ke urutan, decoder dimulai dengan status internal yang dihasilkan oleh encoder untuk memprediksi urutan berikutnya.

Lihat Transformer untuk mengetahui definisi decoder dalam arsitektur Transformer.

Lihat Model bahasa besar di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

denoising

Pendekatan umum untuk pembelajaran mandiri dengan:

Pembersihan derau memungkinkan pembelajaran dari contoh tanpa label. Set data asli berfungsi sebagai target atau label dan data berisi derau sebagai input.

Beberapa model bahasa yang disamarkan menggunakan pemrosesan derau sebagai berikut:

- Derau ditambahkan secara artifisial ke kalimat yang tidak berlabel dengan menyamarkan beberapa token.

- Model mencoba memprediksi token asli.

perintah langsung

Sinonim dari zero-shot prompting.

E

edit jarak

Pengukuran seberapa mirip dua string teks satu sama lain. Dalam machine learning, edit distance berguna karena alasan berikut:

- Jarak edit mudah dihitung.

- Jarak edit dapat membandingkan dua string yang diketahui mirip satu sama lain.

- Jarak edit dapat menentukan tingkat kemiripan string yang berbeda dengan string tertentu.

Ada beberapa definisi jarak edit, masing-masing menggunakan operasi string yang berbeda. Lihat Jarak Levenshtein untuk contoh.

lapisan penyematan

Lapisan tersembunyi khusus yang dilatih pada fitur kategoris berdimensi tinggi untuk mempelajari vektor penyematan dimensi yang lebih rendah secara bertahap. Lapisan penyematan memungkinkan jaringan neural dilatih jauh lebih efisien daripada hanya dilatih pada fitur kategoris berdimensi tinggi.

Misalnya, Bumi saat ini mendukung sekitar 73.000 spesies pohon. Misalkan

spesies pohon adalah fitur dalam model Anda, sehingga lapisan input

model Anda menyertakan vektor one-hot dengan panjang elemen

73.000.

Misalnya, mungkin baobab akan direpresentasikan seperti ini:

Array 73.000 elemen sangat panjang. Jika Anda tidak menambahkan lapisan penyematan ke model, pelatihan akan sangat memakan waktu karena menggandakan 72.999 nol. Mungkin Anda memilih lapisan penyematan yang terdiri dari 12 dimensi. Akibatnya, lapisan penyematan akan secara bertahap mempelajari vektor penyematan baru untuk setiap spesies pohon.

Dalam situasi tertentu, hashing adalah alternatif yang wajar untuk lapisan penyematan.

Lihat Penyematan di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

ruang sematan

Ruang vektor berdimensi d yang menjadi fitur dari ruang vektor berdimensi yang lebih tinggi. Idealnya, ruang sematan berisi struktur yang menghasilkan hasil matematika yang berarti; misalnya, dalam ruang sematan yang ideal, penjumlahan dan pengurangan embeddings dapat memecahkan tugas analogi kata.

Produk titik dari dua embeddings adalah ukuran kesamaan dari embedding tersebut.

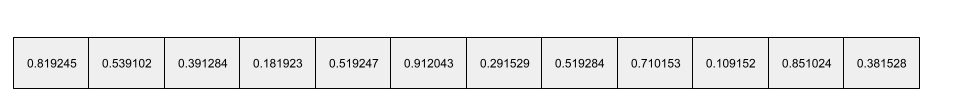

vektor penyematan

Secara garis besar, array bilangan floating point yang diambil dari setiap lapisan tersembunyi yang menjelaskan input ke lapisan tersembunyi tersebut. Sering kali, vektor penyematan adalah array bilangan floating point yang dilatih di lapisan penyematan. Misalnya, lapisan penyematan harus mempelajari vektor penyematan untuk setiap dari 73.000 spesies pohon di Bumi. Mungkin array berikut adalah vektor penyematan untuk pohon baobab:

Vektor penyematan bukanlah sekumpulan angka acak. Lapisan penyematan menentukan nilai ini melalui pelatihan, mirip dengan cara jaringan saraf mempelajari bobot lain selama pelatihan. Setiap elemen array adalah rating beserta beberapa karakteristik spesies pohon. Elemen mana yang mewakili karakteristik spesies pohon? Hal ini sangat sulit ditentukan oleh manusia.

Bagian yang luar biasa secara matematis dari vektor penyematan adalah item yang serupa memiliki kumpulan bilangan floating point yang serupa. Misalnya, jenis pohon yang serupa memiliki kumpulan bilangan floating point yang lebih mirip daripada jenis pohon yang tidak serupa. Pohon redwood dan sequoia adalah spesies pohon yang terkait, sehingga keduanya akan memiliki kumpulan bilangan floating point yang lebih mirip daripada pohon redwood dan pohon kelapa. Angka dalam vektor penyematan akan berubah setiap kali Anda melatih ulang model, meskipun Anda melatih ulang model dengan input yang identik.

pembuat enkode

Secara umum, sistem ML apa pun yang mengonversi dari representasi mentah, jarang, atau eksternal menjadi representasi yang lebih diproses, lebih padat, atau lebih internal.

Encoder sering kali merupakan komponen dari model yang lebih besar, yang sering kali dipasangkan dengan decoder. Beberapa Transformer mengaitkan encoder dengan decoder, meskipun Transformer lainnya hanya menggunakan encoder atau hanya decoder.

Beberapa sistem menggunakan output encoder sebagai input ke jaringan klasifikasi atau regresi.

Dalam tugas urutan ke urutan, encoder mengambil urutan input dan menampilkan status internal (vektor). Kemudian, decoder menggunakan status internal tersebut untuk memprediksi urutan berikutnya.

Lihat Transformer untuk mengetahui definisi encoder dalam arsitektur Transformer.

Lihat LLM: Apa itu model bahasa besar di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

evals

Utamanya digunakan sebagai singkatan untuk evaluasi LLM. Secara lebih luas, evals adalah singkatan dari bentuk evaluasi apa pun.

evaluasi

Proses mengukur kualitas model atau membandingkan berbagai model satu sama lain.

Untuk mengevaluasi model machine learning dengan pengawasan, Anda biasanya menilainya berdasarkan set validasi dan set pengujian. Mengevaluasi LLM biasanya melibatkan penilaian kualitas dan keamanan yang lebih luas.

F

perintah few-shot

Perintah yang berisi lebih dari satu ("beberapa") contoh yang menunjukkan bagaimana model bahasa besar harus merespons. Misalnya, perintah panjang berikut berisi dua contoh yang menunjukkan cara model bahasa besar menjawab kueri.

| Bagian dari satu perintah | Catatan |

|---|---|

| Apa mata uang resmi negara yang ditentukan? | Pertanyaan yang ingin Anda jawab dengan LLM. |

| Prancis: EUR | Satu contoh. |

| Inggris Raya: GBP | Contoh lainnya. |

| India: | Kueri yang sebenarnya. |

Perintah few-shot umumnya menghasilkan hasil yang lebih diinginkan daripada perintah zero-shot dan perintah one-shot. Namun, perintah few-shot memerlukan perintah yang lebih panjang.

Perintah few-shot adalah bentuk pemelajaran beberapa tahap yang diterapkan pada pembelajaran berbasis perintah.

Lihat Rekayasa perintah di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

Biola

Library konfigurasi yang mengutamakan Python dan menetapkan nilai fungsi dan class tanpa kode atau infrastruktur yang invasif. Dalam kasus Pax—dan codebase ML lainnya—fungsi dan class ini mewakili model dan pelatihan hyperparameter.

Fiddle menganggap bahwa codebase machine learning biasanya dibagi menjadi:

- Kode library, yang menentukan lapisan dan pengoptimal.

- Kode "lem" set data, yang memanggil library dan menghubungkan semuanya.

Fiddle menangkap struktur panggilan kode glue dalam bentuk yang tidak dievaluasi dan dapat diubah.

penyesuaian

Lulusan pelatihan kedua khusus tugas yang dilakukan pada model terlatih untuk meningkatkan parameternya untuk kasus penggunaan tertentu. Misalnya, urutan pelatihan lengkap untuk beberapa model bahasa besar adalah sebagai berikut:

- Prapelatihan: Melatih model bahasa besar pada set data umum yang luas, seperti semua halaman Wikipedia bahasa Inggris.

- Penyesuaian: Melatih model terlatih untuk melakukan tugas tertentu, seperti merespons kueri medis. Penyesuaian biasanya melibatkan ratusan atau ribuan contoh yang berfokus pada tugas tertentu.

Sebagai contoh lain, urutan pelatihan lengkap untuk model gambar besar adalah sebagai berikut:

- Prapelatihan: Melatih model gambar besar pada set data gambar umum yang luas, seperti semua gambar di Wikimedia commons.

- Penyesuaian: Melatih model terlatih untuk melakukan tugas tertentu, seperti membuat gambar paus orca.

Penyesuaian dapat mencakup kombinasi strategi berikut:

- Mengubah semua parameter yang ada pada model terlatih. Hal ini terkadang disebut penyesuaian penuh.

- Hanya mengubah beberapa parameter yang ada dari model terlatih (biasanya, lapisan yang paling dekat dengan lapisan output), sambil mempertahankan parameter lain yang ada agar tidak berubah (biasanya, lapisan yang paling dekat dengan lapisan input). Lihat parameter-efficient tuning.

- Menambahkan lebih banyak lapisan, biasanya di atas lapisan yang ada dan paling dekat dengan lapisan output.

Penyesuaian adalah bentuk pemelajaran transfer. Dengan demikian, penyesuaian mungkin menggunakan fungsi loss yang berbeda atau jenis model yang berbeda dari yang digunakan untuk melatih model terlatih. Misalnya, Anda dapat menyetel model gambar besar terlatih untuk menghasilkan model regresi yang menampilkan jumlah burung dalam gambar input.

Bandingkan dan bedakan penyesuaian halus dengan istilah berikut:

Lihat Penyesuaian di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

Flax

Library open source berperforma tinggi untuk deep learning yang dibuat di atas JAX. Flax menyediakan fungsi untuk melatih jaringan saraf, serta metode untuk mengevaluasi performanya.

Flaxformer

Library Transformer open source, yang dibuat di Flax, yang dirancang terutama untuk pemrosesan bahasa alami dan riset multimodal.

G

Gemini

Ekosistem yang terdiri dari AI tercanggih Google. Elemen ekosistem ini meliputi:

- Berbagai model Gemini.

- Antarmuka percakapan interaktif ke model Gemini. Pengguna mengetik perintah dan Gemini merespons perintah tersebut.

- Berbagai Gemini API.

- Berbagai produk bisnis berdasarkan model Gemini; misalnya, Gemini untuk Google Cloud.

Model Gemini

Model multimodal berbasis Transformer mutakhir dari Google. Model Gemini dirancang khusus untuk berintegrasi dengan agen.

Pengguna dapat berinteraksi dengan model Gemini dengan berbagai cara, termasuk melalui antarmuka dialog interaktif dan melalui SDK.

teks yang dihasilkan

Secara umum, teks yang dihasilkan model ML. Saat mengevaluasi model bahasa besar, beberapa metrik membandingkan teks yang dihasilkan dengan teks referensi. Misalnya, Anda mencoba menentukan seberapa efektif model ML menerjemahkan dari bahasa Prancis ke bahasa Belanda. Dalam hal ini:

- Teks yang dihasilkan adalah terjemahan Belanda yang dihasilkan model ML.

- Teks referensi adalah terjemahan Belanda yang dibuat oleh penerjemah manusia (atau software).

Perhatikan bahwa beberapa strategi evaluasi tidak melibatkan teks referensi.

AI generatif

Bidang transformatif yang baru muncul tanpa definisi formal. Meskipun demikian, sebagian besar pakar setuju bahwa model AI generatif dapat membuat ("menghasilkan") konten yang merupakan semua hal berikut:

- kompleks

- koheren

- asli

Misalnya, model AI generatif dapat membuat esai atau gambar yang canggih.

Beberapa teknologi sebelumnya, termasuk LSTM dan RNN, juga dapat menghasilkan konten yang orisinal dan koheren. Beberapa pakar memandang teknologi sebelumnya ini sebagai AI generatif, sementara yang lain merasa bahwa AI generatif sejati memerlukan output yang lebih kompleks daripada yang dapat dihasilkan teknologi sebelumnya.

Berbeda dengan ML prediktif.

respons emas

Jawaban yang diketahui bagus. Misalnya, dengan perintah berikut:

2 + 2

Respons yang diharapkan adalah:

4

GPT (Generative Pre-trained Transformer)

Serangkaian model bahasa besar berbasis Transformer yang dikembangkan oleh OpenAI.

Varian GPT dapat diterapkan ke beberapa modalitas, termasuk:

- pembuatan gambar (misalnya, ImageGPT)

- pembuatan teks ke gambar (misalnya, DALL-E).

H

halusinasi

Produksi output yang tampak masuk akal tetapi salah secara faktual oleh model AI generatif yang berpura-pura membuat pernyataan tentang dunia nyata. Misalnya, model AI generatif yang mengklaim bahwa Barack Obama meninggal pada tahun 1865 mengalami halusinasi.

evaluasi manusia

Proses saat orang menilai kualitas output model ML; misalnya, meminta orang bilingual menilai kualitas model terjemahan ML. Evaluasi manusia sangat berguna untuk menilai model yang tidak memiliki satu jawaban yang benar.

Berbeda dengan evaluasi otomatis dan evaluasi penilai otomatis.

I

pembelajaran dalam konteks

Sinonim dari perintah few-shot.

L

LaMDA (Language Model for Dialogue Applications/Model Bahasa untuk Aplikasi Dialog)

Model bahasa besar berbasis Transformer yang dikembangkan oleh Google dan dilatih pada set data dialog besar yang dapat menghasilkan respons percakapan yang realistis.

LaMDA: our breakthrough conversation technology memberikan ringkasan.

model bahasa

Model yang memperkirakan probabilitas token atau urutan token yang terjadi dalam urutan token yang lebih panjang.

model bahasa besar

Minimal, model bahasa memiliki jumlah parameter yang sangat tinggi. Secara tidak resmi, model bahasa apa pun berbasis Transformer, seperti Gemini atau GPT.

ruang laten

Sinonim dari ruang penyematan.

Jarak Levenshtein

Metrik jarak edit yang menghitung operasi penghapusan, penyisipan, dan penggantian paling sedikit yang diperlukan untuk mengubah satu kata menjadi kata lain. Misalnya, jarak Levenshtein antara kata "heart" dan "darts" adalah tiga karena tiga pengeditan berikut adalah perubahan paling sedikit untuk mengubah satu kata menjadi kata lain:

- heart → deart (ganti "h" dengan "d")

- deart → dart (hapus "e")

- dart → darts (masukkan "s")

Perhatikan bahwa urutan sebelumnya bukan satu-satunya jalur dari tiga pengeditan.

LLM

Singkatan dari large language model.

Evaluasi LLM (eval)

Serangkaian metrik dan tolok ukur untuk menilai performa model bahasa besar (LLM). Pada tingkat yang tinggi, evaluasi LLM:

- Membantu peneliti mengidentifikasi area yang perlu ditingkatkan pada LLM.

- Berguna dalam membandingkan berbagai LLM dan mengidentifikasi LLM terbaik untuk tugas tertentu.

- Membantu memastikan bahwa LLM aman dan etis untuk digunakan.

LoRA

Singkatan dari Low-Rank Adaptability.

Low-Rank Adaptability (LoRA)

Teknik parameter-efficient untuk penyesuaian halus yang "membekukan" bobot yang telah dilatih sebelumnya pada model (sehingga tidak dapat lagi diubah), lalu menyisipkan sekumpulan kecil bobot yang dapat dilatih ke dalam model. Kumpulan bobot yang dapat dilatih ini (juga dikenal sebagai "matriks pembaruan") jauh lebih kecil daripada model dasar sehingga jauh lebih cepat untuk dilatih.

LoRA memberikan manfaat berikut:

- Meningkatkan kualitas prediksi model untuk domain tempat penyesuaian lanjut diterapkan.

- Melakukan penyesuaian lebih cepat daripada teknik yang memerlukan penyesuaian semua parameter model.

- Mengurangi biaya komputasi inferensi dengan mengaktifkan penayangan serentak beberapa model khusus yang berbagi model dasar yang sama.

M

model bahasa yang disamarkan

Model bahasa yang memprediksi kemungkinan token kandidat untuk mengisi bagian yang kosong dalam urutan. Misalnya, model bahasa yang disamarkan dapat menghitung probabilitas untuk kata kandidat guna mengganti garis bawah dalam kalimat berikut:

____ di topi kembali.

Referensi biasanya menggunakan string "MASK", bukan garis bawah. Contoh:

"MASK" di topi muncul kembali.

Sebagian besar model bahasa masked modern bersifat dua arah.

presisi rata-rata pada k (mAP@k)

Rata-rata statistik dari semua skor presisi rata-rata pada k di seluruh set data validasi. Salah satu penggunaan presisi rata-rata mean pada k adalah untuk menilai kualitas rekomendasi yang dihasilkan oleh sistem rekomendasi.

Meskipun frasa "rata-rata mean" terdengar berlebihan, nama metrik ini sudah tepat. Bagaimanapun, metrik ini menemukan nilai tengah beberapa nilai presisi rata-rata pada k.

meta-pembelajaran

Subkumpulan machine learning yang menemukan atau meningkatkan algoritma pembelajaran. Sistem meta-pembelajaran juga dapat bertujuan untuk melatih model agar dapat dengan cepat mempelajari tugas baru dari sejumlah kecil data atau dari pengalaman yang diperoleh dalam tugas sebelumnya. Algoritma meta-pembelajaran umumnya mencoba mencapai hal berikut:

- Meningkatkan atau mempelajari fitur yang dibuat secara manual (seperti penginisialisasi atau pengoptimal).

- Lebih efisien dalam penggunaan data dan komputasi.

- Meningkatkan generalisasi.

Meta-pembelajaran terkait dengan pemelajaran beberapa tahap.

campuran pakar

Skema untuk meningkatkan efisiensi jaringan saraf dengan hanya menggunakan sebagian parameternya (dikenal sebagai ahli) untuk memproses token atau contoh input tertentu. Jaringan gating merutekan setiap token atau contoh input ke pakar yang sesuai.

Untuk mengetahui detailnya, lihat salah satu makalah berikut:

- Jaringan Neural yang Sangat Besar: Lapisan Mixture-of-Experts dengan Gate yang Jarang

- Mixture-of-Experts dengan Expert Choice Routing

MMIT

Singkatan dari multimodal instruction-tuned.

modalitas

Kategori data tingkat tinggi. Misalnya, angka, teks, gambar, video, dan audio adalah lima modalitas yang berbeda.

paralelisme model

Cara menskalakan pelatihan atau inferensi yang menempatkan berbagai bagian dari satu model di berbagai perangkat. Paralelisme model memungkinkan model yang terlalu besar untuk dimuat di satu perangkat.

Untuk menerapkan paralelisme model, sistem biasanya melakukan hal berikut:

- Shard (membagi) model menjadi bagian-bagian yang lebih kecil.

- Mendistribusikan pelatihan bagian-bagian yang lebih kecil tersebut ke beberapa prosesor. Setiap prosesor melatih bagian modelnya sendiri.

- Menggabungkan hasil untuk membuat satu model.

Paralelisme model memperlambat pelatihan.

Lihat juga paralelisme data.

MOE

Singkatan dari mixture of experts.

self-attention multi-head

Ekstensi self-attention yang menerapkan mekanisme self-attention beberapa kali untuk setiap posisi dalam urutan input.

Transformer memperkenalkan self-attention multi-head.

disesuaikan dengan petunjuk multimodal

Model yang disesuaikan dengan petunjuk yang dapat memproses input selain teks, seperti gambar, video, dan audio.

model multimodal

Model yang input dan/atau output-nya mencakup lebih dari satu modalitas. Misalnya, pertimbangkan model yang menggunakan gambar dan teks (dua modalitas) sebagai fitur, dan mengeluarkan skor yang menunjukkan seberapa sesuai teks untuk gambar. Jadi, input model ini bersifat multimodal dan output-nya bersifat unimodal.

T

natural language processing

Bidang yang mengajarkan komputer untuk memproses apa yang diucapkan atau diketik pengguna menggunakan aturan linguistik. Hampir semua natural language processing modern mengandalkan machine learning.natural language understanding

Subkumpulan natural language processing yang menentukan niat dari sesuatu yang diucapkan atau diketik. Pemahaman bahasa alam dapat melampaui natural language processing untuk mempertimbangkan aspek bahasa yang kompleks seperti konteks, sarkasme, dan sentimen.

N-gram

Urutan kata N yang teratur. Misalnya, truly madly adalah 2-gram. Karena urutan relevan, madly truly adalah 2-gram yang berbeda dengan truly madly.

| T | Nama untuk jenis N-gram ini | Contoh |

|---|---|---|

| 2 | bigram atau 2-gram | to go, go to, eat lunch, eat dinner |

| 3 | trigram atau 3-gram | ate too much, three blind mice, the bell tolls |

| 4 | 4-gram | walk in the park, dust in the wind, the boy ate lentils |

Banyak model natural language understanding bergantung pada N-gram untuk memprediksi kata berikutnya yang akan diketik atau diucapkan oleh pengguna. Misalnya, pengguna mengetik three blind. Model NLU berdasarkan trigram kemungkinan akan memprediksi bahwa pengguna selanjutnya akan mengetik tikus.

Bedakan N-gram dengan kantong data, yang merupakan kumpulan kata yang tidak berurutan.

NLP

Singkatan dari natural language processing.

NLU

Singkatan dari natural language understanding.

no one right answer (NORA)

Perintah yang memiliki beberapa respons yang sesuai. Misalnya, perintah berikut tidak memiliki satu jawaban yang benar:

Ceritakan lelucon tentang gajah.

Mengevaluasi perintah yang tidak memiliki jawaban yang benar bisa jadi sulit.

NORA

Singkatan dari tidak ada jawaban yang benar.

O

one-shot prompting

Perintah yang berisi satu contoh yang menunjukkan cara model bahasa besar harus merespons. Misalnya, perintah berikut berisi satu contoh yang menunjukkan model bahasa besar cara menjawab kueri.

| Bagian dari satu perintah | Catatan |

|---|---|

| Apa mata uang resmi negara yang ditentukan? | Pertanyaan yang ingin Anda jawab dengan LLM. |

| Prancis: EUR | Satu contoh. |

| India: | Kueri yang sebenarnya. |

Bandingkan dan bedakan perintah satu kali dengan istilah berikut:

P

parameter-efficient tuning

Serangkaian teknik untuk melakukan penyesuaian halus model bahasa terlatih (PLM) yang besar secara lebih efisien daripada penyesuaian halus penuh. Penyesuaian yang hemat parameter biasanya menyesuaikan jauh lebih sedikit parameter daripada penyesuaian lengkap, tetapi umumnya menghasilkan model bahasa besar yang berperforma setara (atau hampir sama) dengan model bahasa besar yang dibuat dari penyesuaian lengkap.

Membandingkan dan membedakan parameter-efficient tuning dengan:

Parameter-efficient tuning juga dikenal sebagai parameter-efficient fine-tuning.

pipeline

Bentuk paralelisme model yang memproses model dibagi menjadi beberapa tahap berturut-turut dan setiap tahap dijalankan di perangkat yang berbeda. Saat suatu tahap memproses satu batch, tahap sebelumnya dapat memproses batch berikutnya.

Lihat juga pelatihan bertahap.

PLM

Singkatan dari model bahasa terlatih.

encoding posisi

Teknik untuk menambahkan informasi tentang posisi token dalam urutan ke penyematan token. Model Transformer menggunakan encoding posisi untuk lebih memahami hubungan antara berbagai bagian urutan.

Implementasi umum encoding posisi menggunakan fungsi sinus. (Secara khusus, frekuensi dan amplitudo fungsi sinusoid ditentukan oleh posisi token dalam urutan.) Teknik ini memungkinkan model Transformer mempelajari cara memperhatikan berbagai bagian urutan berdasarkan posisinya.

model pasca-pelatihan

Istilah yang didefinisikan secara longgar yang biasanya mengacu pada model terlatih yang telah melalui beberapa pemrosesan pasca, seperti satu atau beberapa hal berikut:

presisi pada k (precision@k)

Metrik untuk mengevaluasi daftar item yang diurutkan. Presisi pada k mengidentifikasi fraksi item k pertama dalam daftar tersebut yang "relevan". Definisinya yaitu:

\[\text{precision at k} = \frac{\text{relevant items in first k items of the list}} {\text{k}}\]

Nilai k harus kurang dari atau sama dengan panjang daftar yang ditampilkan. Perhatikan bahwa panjang daftar yang ditampilkan bukan bagian dari penghitungan.

Relevansi sering kali bersifat subjektif; bahkan evaluator manusia pakar sering kali tidak setuju tentang item mana yang relevan.

Bandingkan dengan:

model terlatih

Biasanya, model yang telah dilatih. Istilah ini juga dapat berarti vektor penyematan yang telah dilatih sebelumnya.

Istilah model bahasa terlatih biasanya mengacu pada model bahasa besar yang telah dilatih.

pra-pelatihan

Pelatihan awal model pada set data besar. Beberapa model terlatih adalah model besar yang canggung dan biasanya harus ditingkatkan melalui pelatihan tambahan. Misalnya, pakar ML mungkin melakukan pra-pelatihan model bahasa besar pada set data teks yang luas, seperti semua halaman bahasa Inggris di Wikipedia. Setelah pra-pelatihan, model yang dihasilkan dapat lebih ditingkatkan lagi melalui salah satu teknik berikut:

perintah

Setiap teks yang dimasukkan sebagai input ke model bahasa besar untuk mengkondisikan model agar berperilaku dengan cara tertentu. Perintah dapat berupa frasa yang singkat atau panjang secara arbitrer (misalnya, seluruh teks novel). Perintah tercakup dalam beberapa kategori, termasuk yang ditampilkan dalam tabel berikut:

| Kategori perintah | Contoh | Catatan |

|---|---|---|

| Pertanyaan | Seberapa cepat merpati dapat terbang? | |

| Petunjuk | Tulis puisi lucu tentang arbitrase. | Perintah yang meminta model bahasa besar untuk melakukan sesuatu. |

| Contoh | Menerjemahkan kode Markdown ke HTML. Misalnya:

Markdown: * item daftar HTML: <ul> <li>item daftar</li> </ul> |

Kalimat pertama dalam contoh perintah ini adalah petunjuk. Sisa perintah adalah contohnya. |

| Peran | Jelaskan alasan penurunan gradien digunakan dalam pelatihan machine learning kepada seorang PhD dalam Fisika. | Bagian pertama kalimat adalah petunjuk; frasa "ke PhD dalam Fisika" adalah bagian peran. |

| Input parsial untuk diselesaikan model | Perdana Menteri Inggris Raya tinggal di | Perintah input parsial dapat berakhir secara tiba-tiba (seperti contoh ini) atau diakhiri dengan garis bawah. |

Model AI generatif dapat merespons perintah dengan teks, kode, gambar, embedding, video…hampir semuanya.

pembelajaran berbasis perintah

Kemampuan model tertentu yang memungkinkannya menyesuaikan perilakunya sebagai respons terhadap input teks arbitrer (perintah). Dalam paradigma pembelajaran berbasis perintah umum, model bahasa besar merespons perintah dengan menghasilkan teks. Misalnya, pengguna memasukkan perintah berikut:

Meringkas Hukum Ketiga Newton tentang Gerak.

Model yang mampu melakukan pembelajaran berbasis perintah tidak dilatih secara khusus untuk menjawab perintah sebelumnya. Sebaliknya, model "mengetahui" banyak fakta tentang fisika, banyak tentang aturan bahasa umum, dan banyak tentang apa yang membentuk jawaban yang umumnya berguna. Pengetahuan tersebut cukup untuk memberikan jawaban yang (semoga) berguna. Masukan tambahan dari manusia ("Jawaban itu terlalu rumit" atau "Apa reaksinya?") memungkinkan beberapa sistem pembelajaran berbasis perintah untuk secara bertahap meningkatkan kegunaan jawabannya.

desain perintah

Sinonim dari rekayasa perintah.

rekayasa perintah

Seni membuat perintah yang mendapatkan respons yang diinginkan dari model bahasa besar. Manusia melakukan prompt engineering. Menulis dialog yang terstruktur dengan baik adalah bagian penting untuk memastikan respons yang berguna dari model bahasa besar. Rekayasa perintah bergantung pada banyak faktor, termasuk:

- Set data yang digunakan untuk prapelatihan dan mungkin penyesuaian model bahasa besar.

- Suhu dan parameter decoding lainnya yang digunakan model untuk menghasilkan respons.

Lihat Pengantar desain perintah untuk mengetahui detail selengkapnya tentang cara menulis perintah yang bermanfaat.

Desain perintah adalah sinonim untuk rekayasa perintah.

penyesuaian perintah

Mekanisme parameter-efficient tuning yang mempelajari "awalan" yang ditambahkan sistem ke perintah yang sebenarnya.

Salah satu variasi penyesuaian perintah—terkadang disebut penyesuaian awalan—adalah menambahkan awalan di setiap lapisan. Sebaliknya, sebagian besar penyesuaian perintah hanya menambahkan awalan ke lapisan input.

R

recall pada k (recall@k)

Metrik untuk mengevaluasi sistem yang menghasilkan daftar item yang diberi peringkat (diurutkan). Recall pada k mengidentifikasi fraksi item yang relevan dalam item k pertama dalam daftar tersebut dari total jumlah item relevan yang ditampilkan.

\[\text{recall at k} = \frac{\text{relevant items in first k items of the list}} {\text{total number of relevant items in the list}}\]

Berbeda dengan presisi pada k.

teks referensi

Respons pakar terhadap perintah. Misalnya, dengan perintah berikut:

Terjemahkan pertanyaan "Siapa nama Anda?" dari bahasa Inggris ke bahasa Prancis.

Respons pakar mungkin:

Comment vous appelez-vous?

Berbagai metrik (seperti ROUGE) mengukur tingkat kecocokan teks referensi dengan teks yang dihasilkan model ML.

perintah peran

Bagian opsional dari perintah yang mengidentifikasi audiens target untuk respons model AI generatif. Tanpa perintah peran, model bahasa besar memberikan jawaban yang mungkin atau mungkin tidak berguna bagi orang yang mengajukan pertanyaan. Dengan perintah peran, model bahasa besar dapat menjawab dengan cara yang lebih sesuai dan lebih membantu untuk target audiens tertentu. Misalnya, bagian perintah peran dari perintah berikut dicetak tebal:

- Ringkas artikel ini untuk gelar PhD dalam ekonomi.

- Jelaskan cara kerja pasang surut untuk anak berusia sepuluh tahun.

- Jelaskan krisis keuangan tahun 2008. Bicaralah seperti yang Anda lakukan kepada anak kecil, atau golden retriever.

ROUGE (Recall-Oriented Understudy for Gisting Evaluation)

Kumpulan metrik yang mengevaluasi model ringkasan otomatis dan terjemahan mesin. Metrik ROUGE menentukan tingkat tumpang-tindih teks referensi dengan teks yang dihasilkan model ML. Setiap anggota keluarga ROUGE mengukur tumpang-tindih dengan cara yang berbeda. Skor ROUGE yang lebih tinggi menunjukkan kesamaan yang lebih besar antara teks referensi dan teks yang dihasilkan daripada skor ROUGE yang lebih rendah.

Setiap anggota keluarga ROUGE biasanya menghasilkan metrik berikut:

- Presisi

- Recall

- F1

Untuk mengetahui detail dan contohnya, lihat:

ROUGE-L

Anggota dari keluarga ROUGE berfokus pada panjang suburutan umum terpanjang dalam teks referensi dan teks yang dihasilkan. Rumus berikut menghitung recall dan presisi untuk ROUGE-L:

Kemudian, Anda dapat menggunakan F1 untuk menggabungkan recall ROUGE-L dan presisi ROUGE-L menjadi satu metrik:

ROUGE-L mengabaikan baris baru dalam teks referensi dan teks yang dihasilkan, sehingga suburutan umum terpanjang dapat melintasi beberapa kalimat. Jika teks referensi dan teks yang dihasilkan melibatkan beberapa kalimat, variasi ROUGE-L yang disebut ROUGE-Lsum umumnya merupakan metrik yang lebih baik. ROUGE-Lsum menentukan suburutan umum terpanjang untuk setiap kalimat dalam sebuah bagian, lalu menghitung rata-rata suburutan umum terpanjang tersebut.

ROUGE-N

Kumpulan metrik dalam keluarga ROUGE yang membandingkan N-gram bersama dengan ukuran tertentu dalam teks referensi dan teks yang dihasilkan. Contoh:

- ROUGE-1 mengukur jumlah token yang dibagikan dalam teks referensi dan teks yang dihasilkan.

- ROUGE-2 mengukur jumlah bigram (2-gram) bersama dalam teks referensi dan teks yang dihasilkan.

- ROUGE-3 mengukur jumlah trigram (3-gram) bersama dalam teks referensi dan teks yang dihasilkan.

Anda dapat menggunakan formula berikut untuk menghitung recall ROUGE-N dan presisi ROUGE-N untuk setiap anggota keluarga ROUGE-N:

Kemudian, Anda dapat menggunakan F1 untuk menggabungkan recall ROUGE-N dan presisi ROUGE-N menjadi satu metrik:

ROUGE-S

Bentuk ROUGE-N yang toleran yang memungkinkan pencocokan skip-gram. Artinya, ROUGE-N hanya menghitung N-gram yang cocok persis, tetapi ROUGE-S juga menghitung N-gram yang dipisahkan oleh satu atau beberapa kata. Misalnya, perhatikan kode berikut:

- reference text: Awan putih

- generated text: Awan putih yang membumbung

Saat menghitung ROUGE-N, 2-gram, Awan putih tidak cocok dengan Awan putih yang mengembang. Namun, saat menghitung ROUGE-S, Awan putih cocok dengan Awan putih yang membumbung.

S

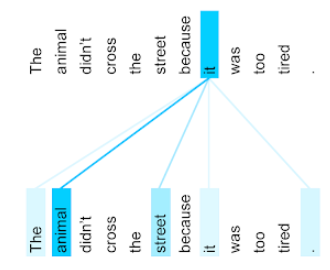

self-attention (juga disebut lapisan self-attention)

Lapisan jaringan neural yang mengubah urutan embedding (misalnya, embedding token) menjadi urutan embedding lainnya. Setiap penyematan dalam urutan output dibuat dengan mengintegrasikan informasi dari elemen urutan input melalui mekanisme perhatian.

Bagian self dari self-attention mengacu pada urutan yang memperhatikan dirinya sendiri, bukan konteks lainnya. Self-attention adalah salah satu blok utama untuk Transformer dan menggunakan terminologi pencarian kamus, seperti "kueri", "kunci", dan "nilai".

Lapisan self-attention dimulai dengan urutan representasi input, satu untuk setiap kata. Representasi input untuk kata dapat berupa penyematan sederhana. Untuk setiap kata dalam urutan input, jaringan akan menilai relevansi kata dengan setiap elemen dalam seluruh urutan kata. Skor relevansi menentukan seberapa banyak representasi akhir kata menggabungkan representasi kata lain.

Misalnya, pertimbangkan kalimat berikut:

Hewan itu tidak menyeberang jalan karena terlalu lelah.

Ilustrasi berikut (dari Transformer: A Novel Neural Network Architecture for Language Understanding) menunjukkan pola perhatian lapisan perhatian mandiri untuk kata ganti it, dengan keterangkasan setiap baris menunjukkan seberapa banyak setiap kata berkontribusi pada representasi:

Lapisan self-attention menandai kata-kata yang relevan dengan "it". Dalam hal ini, lapisan perhatian telah belajar untuk menandai kata yang mungkin dirujuk oleh lapisan perhatian, dengan menetapkan bobot tertinggi ke hewan.

Untuk urutan token n, perhatian mandiri mengubah urutan penyematan n secara terpisah, satu kali di setiap posisi dalam urutan.

Lihat juga perhatian dan perhatian mandiri multi-head.

analisis sentimen

Menggunakan algoritma statistik atau machine learning untuk menentukan sikap keseluruhan grup—positif atau negatif—terhadap layanan, produk, organisasi, atau topik. Misalnya, menggunakan natural language understanding, algoritma dapat melakukan analisis sentimen terkait masukan tekstual dari mata kuliah universitas untuk menentukan sejauh mana mahasiswa umumnya menyukai atau tidak menyukai mata kuliah tersebut.

tugas urutan ke urutan

Tugas yang mengonversi urutan input token menjadi urutan token output. Misalnya, dua jenis tugas urutan ke urutan yang populer adalah:

- Penerjemah:

- Contoh urutan input: "Aku cinta kamu".

- Contoh urutan output: "Je t'aime".

- Penjawaban pertanyaan:

- Contoh urutan input: "Apakah saya memerlukan mobil di New York City?"

- Contoh urutan output: "Tidak. Harap tinggalkan mobil Anda di rumah."

skip-gram

N-gram yang dapat menghilangkan (atau "melewati") kata dari konteks asli, yang berarti kata-kata N mungkin awalnya tidak berdekatan. Lebih tepatnya, "k-skip-n-gram" adalah n-gram yang mungkin telah mengabaikan hingga k kata.

Misalnya, "the quick brown fox" memiliki kemungkinan 2-gram berikut:

- "the quick"

- "quick brown"

- "brown fox"

"1-skip-2-gram" adalah sepasang kata yang memiliki maksimal 1 kata di antaranya. Oleh karena itu, "the quick brown fox" memiliki 2-gram 1-lewati berikut:

- "the brown"

- "quick fox"

Selain itu, semua 2-gram juga merupakan 1-skip-2-gram, karena kurang dari satu kata dapat dilewati.

Skip-gram berguna untuk lebih memahami konteks di sekitar kata. Dalam contoh, "fox" dikaitkan langsung dengan "quick" dalam kumpulan 1-skip-2-gram, tetapi tidak dalam kumpulan 2-gram.

Skip-gram membantu melatih model embedding kata.

penyesuaian perintah lunak

Teknik untuk menyesuaikan model bahasa besar untuk tugas tertentu, tanpa penyesuaian terperinci yang membutuhkan banyak resource. Daripada melatih ulang semua bobot dalam model, penyesuaian perintah lunak otomatis menyesuaikan perintah untuk mencapai sasaran yang sama.

Dengan perintah tekstual, penyesuaian perintah lunak biasanya menambahkan penyematan token tambahan ke perintah dan menggunakan backpropagation untuk mengoptimalkan input.

Perintah "hard" berisi token sebenarnya, bukan penyematan token.

fitur renggang

Fitur yang sebagian besar nilainya nol atau kosong. Misalnya, fitur yang berisi satu nilai 1 dan satu juta nilai 0 bersifat renggang. Sebaliknya, fitur rapat memiliki nilai yang sebagian besar bukan nol atau kosong.

Dalam machine learning, banyak fitur yang merupakan fitur jarang. Fitur kategoris biasanya merupakan fitur yang jarang. Misalnya, dari 300 kemungkinan spesies pohon di hutan, satu contoh mungkin hanya mengidentifikasi pohon maple. Atau, dari jutaan video yang mungkin ada di koleksi video, satu contoh mungkin hanya mengidentifikasi "Casablanca".

Dalam model, Anda biasanya merepresentasikan fitur jarang dengan enkode one-hot. Jika enkode one-hot berukuran besar, Anda dapat menempatkan lapisan penyematan di atas enkode one-hot untuk efisiensi yang lebih besar.

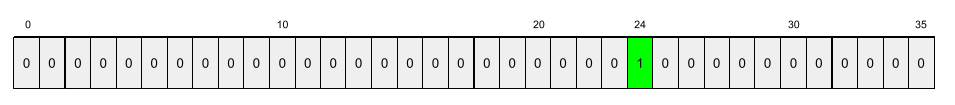

representasi renggang

Hanya menyimpan posisi elemen non-nol dalam fitur jarang.

Misalnya, fitur kategoris bernama species mengidentifikasi 36

spesies pohon di hutan tertentu. Selanjutnya, asumsikan bahwa setiap

contoh hanya mengidentifikasi satu spesies.

Anda dapat menggunakan vektor one-hot untuk merepresentasikan spesies pohon dalam setiap contoh.

Vektor one-hot akan berisi satu 1 (untuk mewakili

spesies pohon tertentu dalam contoh tersebut) dan 35 0 (untuk mewakili

35 spesies pohon yang tidak ada dalam contoh tersebut). Jadi, representasi one-hot

maple mungkin terlihat seperti berikut:

Atau, representasi jarang hanya akan mengidentifikasi posisi

spesies tertentu. Jika maple berada di posisi 24, representasi jarang

maple akan menjadi:

24

Perhatikan bahwa representasi jarang jauh lebih ringkas daripada representasi one-hot.

pelatihan bertahap

Taktik pelatihan model dalam urutan tahap terpisah. Sasarannya dapat mempercepat proses pelatihan, atau untuk mencapai kualitas model yang lebih baik.

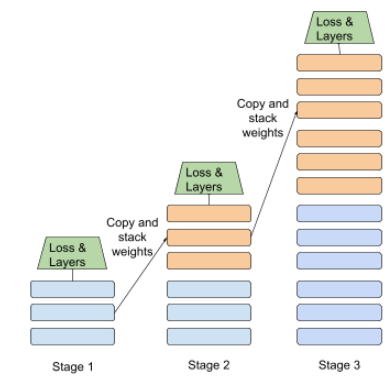

Ilustrasi pendekatan penumpukan progresif ditampilkan di bawah ini:

- Tahap 1 berisi 3 lapisan tersembunyi, tahap 2 berisi 6 lapisan tersembunyi, dan tahap 3 berisi 12 lapisan tersembunyi.

- Tahap 2 memulai pelatihan dengan bobot yang dipelajari di 3 lapisan tersembunyi Tahap 1. Tahap 3 memulai pelatihan dengan bobot yang dipelajari di 6 lapisan tersembunyi Tahap 2.

Lihat juga pipeline.

token subword

Dalam model bahasa, token adalah substring kata, yang mungkin merupakan seluruh kata.

Misalnya, kata seperti "itemize" dapat dibagi menjadi bagian-bagian "item" (kata akar) dan "ize" (akhiran), yang masing-masing diwakili oleh tokennya sendiri. Membagi kata yang tidak umum menjadi bagian-bagian tersebut, yang disebut subword, memungkinkan model bahasa beroperasi pada bagian penyusun kata yang lebih umum, seperti awalan dan akhiran.

Sebaliknya, kata umum seperti "going" mungkin tidak dipecah dan mungkin diwakili oleh satu token.

S

T5

Model pembelajaran transfer teks ke teks yang diperkenalkan oleh Google AI pada tahun 2020. T5 adalah model encoder-decoder, berdasarkan arsitektur Transformer, yang dilatih pada set data yang sangat besar. Model ini efektif dalam berbagai tugas natural language processing, seperti membuat teks, menerjemahkan bahasa, dan menjawab pertanyaan dengan cara percakapan.

T5 mendapatkan namanya dari lima huruf T dalam "Text-to-Text Transfer Transformer".

T5X

Framework machine learning open source yang dirancang untuk membuat dan melatih model natural language processing (NLP) skala besar. T5 diterapkan pada codebase T5X (yang di-build di JAX dan Flax).

suhu

Hyperparameter yang mengontrol tingkat keacakan output model. Suhu yang lebih tinggi menghasilkan output yang lebih acak, sedangkan suhu yang lebih rendah menghasilkan output yang lebih acak.

Memilih suhu terbaik bergantung pada aplikasi tertentu dan properti yang diinginkan dari output model. Misalnya, Anda mungkin akan menaikkan suhu saat membuat aplikasi yang menghasilkan output materi iklan. Sebaliknya, Anda mungkin akan menurunkan suhu saat membuat model yang mengklasifikasikan gambar atau teks untuk meningkatkan akurasi dan konsistensi model.

Suhu sering digunakan dengan softmax.

span teks

Rentang indeks array yang dikaitkan dengan subbagian string teks tertentu.

Misalnya, kata good dalam string Python s="Be good now" menempati

rentang teks dari 3 hingga 6.

token

Dalam model bahasa, unit atomik yang digunakan untuk melatih dan membuat prediksi model. Token biasanya berupa salah satu dari hal berikut:

- kata—misalnya, frasa " suka kucing" terdiri dari tiga token kata: "", "suka", dan "kucing".

- karakter—misalnya, frasa "ikan sepeda" terdiri dari sembilan token karakter. (Perhatikan bahwa spasi kosong dihitung sebagai salah satu token.)

- subkata—di mana satu kata dapat berupa satu token atau beberapa token. Subword terdiri dari kata akar, awalan, atau akhiran. Misalnya, model bahasa yang menggunakan subword sebagai token mungkin melihat kata "dogs" sebagai dua token (kata root "dog" dan akhiran jamak "s"). Model bahasa yang sama mungkin melihat satu kata "taller" sebagai dua subkata (kata akar "tall" dan akhiran "er").

Di domain di luar model bahasa, token dapat mewakili jenis unit atomik lainnya. Misalnya, dalam computer vision, token mungkin merupakan subset gambar.

akurasi top-k

Persentase frekuensi kemunculan "label target" dalam posisi k pertama dari daftar yang dihasilkan. Daftar tersebut dapat berupa rekomendasi yang dipersonalisasi atau daftar item yang diurutkan menurut softmax.

Akurasi top-k juga dikenal sebagai akurasi pada k.

perilaku negatif

Tingkat konten yang menyinggung, mengancam, atau kasar. Banyak model machine learning yang dapat mengidentifikasi dan mengukur toksisitas. Sebagian besar model ini mengidentifikasi toksisitas berdasarkan beberapa parameter, seperti tingkat bahasa kasar dan tingkat bahasa yang mengancam.

Transformator

Arsitektur jaringan saraf yang dikembangkan di Google yang mengandalkan mekanisme self-attention untuk mengubah urutan penyematan input menjadi urutan penyematan output tanpa mengandalkan konvolusi atau jaringan saraf berulang. Transformer dapat dilihat sebagai tumpukan lapisan self-attention.

Transformer dapat menyertakan salah satu dari hal berikut:

Encoder mengubah urutan penyematan menjadi urutan baru dengan panjang yang sama. Encoder menyertakan N lapisan identik, yang masing-masing berisi dua sub-lapisan. Kedua sublapisan ini diterapkan di setiap posisi urutan penyematan input, yang mengubah setiap elemen urutan menjadi penyematan baru. Sublapisan encoder pertama menggabungkan informasi dari seluruh urutan input. Sublapisan encoder kedua mengubah informasi agregat menjadi penyematan output.

Decoder mengubah urutan penyematan input menjadi urutan penyematan output, mungkin dengan panjang yang berbeda. Decoder juga menyertakan lapisan identik N dengan tiga sublapisan, dua di antaranya mirip dengan sublapisan encoder. Sublapisan decoder ketiga mengambil output encoder dan menerapkan mekanisme self-attention untuk mengumpulkan informasi darinya.

Postingan blog Transformer: A Novel Neural Network Architecture for Language Understanding memberikan pengantar yang baik tentang Transformer.

trigram

N-gram yang mana N=3.

U

searah

Sistem yang hanya mengevaluasi teks yang mendahului bagian teks target. Sebaliknya, sistem dua arah mengevaluasi teks yang mendahului dan mengikuti bagian teks target. Lihat dua arah untuk mengetahui detail selengkapnya.

model bahasa searah

Model bahasa yang mendasarkan probabilitasnya hanya pada token yang muncul sebelum, bukan setelah, token target. Berbeda dengan model bahasa dua arah.

V

autoencoder variasional (VAE)

Jenis autoencoder yang memanfaatkan perbedaan antara input dan output untuk menghasilkan versi input yang dimodifikasi. Autoencoder variasional berguna untuk AI generatif.

VAE didasarkan pada inferensi variasional: teknik untuk memperkirakan parameter model probabilitas.

W

embedding kata

Merepresentasikan setiap kata dalam kumpulan kata dalam vektor penyematan; yaitu, merepresentasikan setiap kata sebagai vektor nilai floating point antara 0,0 dan 1,0. Kata dengan makna yang serupa memiliki representasi yang lebih mirip daripada kata dengan makna yang berbeda. Misalnya, wortel, seledri, dan mentimun akan memiliki representasi yang relatif mirip, yang akan sangat berbeda dengan representasi pesawat, kacamata hitam, dan pasta gigi.

Z

zero-shot prompting

Perintah yang tidak memberikan contoh bagaimana Anda ingin model bahasa besar merespons. Contoh:

| Bagian dari satu perintah | Catatan |

|---|---|

| Apa mata uang resmi negara yang ditentukan? | Pertanyaan yang ingin Anda jawab dengan LLM. |

| India: | Kueri yang sebenarnya. |

Model bahasa besar mungkin merespons dengan salah satu dari hal berikut:

- Rupee

- INR

- Rs

- Rupee India

- Rupee

- Rupee India

Semua jawaban benar, meskipun Anda mungkin lebih menyukai format tertentu.

Bandingkan dan bedakan perintah zero-shot dengan istilah berikut: