Halaman ini berisi istilah glosarium Evaluasi Bahasa. Untuk semua istilah glosarium, klik di sini.

A

Attention,

Mekanisme yang digunakan dalam jaringan neural yang menunjukkan pentingnya suatu kata atau bagian dari sebuah kata. Kompresi atensi jumlah informasi yang dibutuhkan model untuk memprediksi token/kata berikutnya. Mekanisme atensi yang khas mungkin terdiri dari jumlah berbobot terhadap kumpulan input, dengan bobot untuk setiap input dihitung oleh bagian lain dari saraf alur maju.

Lihat juga perhatian mandiri dan multi-head self-attention, yang merupakan elemen penyusun Transformer.

autoencoder

Sebuah sistem yang belajar mengekstrak informasi terpenting dari input teks. Autoencoder adalah kombinasi dari encoder dan decoder. Autoencoder mengandalkan proses dua langkah berikut:

- Encoder memetakan input ke dimensi rendah lossy (biasanya) (menengah).

- Decoder membangun versi lossy dari input asli dengan memetakan format dimensi yang lebih rendah ke dimensi aslinya format input teks.

Autoencoder dilatih secara menyeluruh dengan meminta decoder mencoba merekonstruksi input asli dari format perantara encoder semirip mungkin. Karena format perantara lebih kecil (dimensi lebih rendah) daripada format aslinya, autoencoder dipaksa untuk mempelajari informasi apa yang penting dalam input, dan {i>output-<i}nya tidak identik dengan input lainnya.

Contoh:

- Jika data input berupa grafik, salinan yang tidak tepat akan mirip dengan grafis aslinya, tetapi agak dimodifikasi. Mungkin salinan yang tidak persis menghilangkan noise dari grafis asli atau mengisi beberapa piksel yang hilang.

- Jika data inputnya adalah teks, {i>autoencoder <i}akan menghasilkan teks baru yang meniru (tetapi tidak sama dengan) teks aslinya.

Lihat juga autoencoder variasi.

model autoregresif

Model yang menyimpulkan prediksi berdasarkan permintaan sebelumnya terhadap prediksi yang di-output oleh model. Misalnya, model bahasa autoregresif memprediksi token berdasarkan token yang diprediksi sebelumnya. Semua berbasis Transformer model bahasa besar bersifat autoregresif.

Sebaliknya, model gambar berbasis GAN biasanya tidak auto-regresif karena metode itu menghasilkan gambar dalam satu penerusan maju dan tidak iteratif dalam langkah. Namun, model pembuatan gambar tertentu bersifat autoregresif karena mereka membuat gambar secara bertahap.

B

kantong data

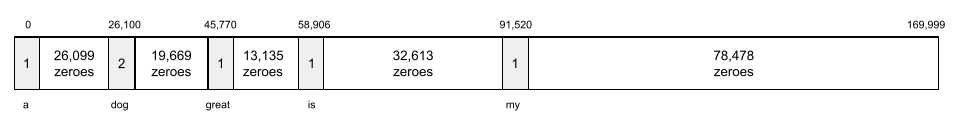

Representasi dari kata-kata dalam frasa atau bagian, terlepas dari urutannya. Misalnya, kumpulan kata-kata mewakili tiga frasa berikut secara identik:

- anjingnya melompat

- melompat pada anjingnya

- {i>dog walker<i}

Setiap kata dipetakan ke indeks dalam vektor renggang, dengan vektor memiliki indeks untuk setiap kata dalam kosakata. Misalnya, frasa the dog jumps dipetakan menjadi vektor fitur dengan nilai bukan nol pada ketiga indeks yang sesuai dengan kata the, dog, dan lompatan. Nilai bukan nol dapat berupa salah satu dari hal berikut:

- A 1 untuk menunjukkan kehadiran sebuah kata.

- Hitungan berapa kali sebuah kata muncul dalam tas. Misalnya, jika frasanya adalah the maroon dog is a dog with maroon fur, maka keduanya maroon dan dog akan direpresentasikan sebagai 2, sedangkan kata lainnya akan dinyatakan sebagai 1.

- Beberapa nilai lainnya, seperti logaritma jumlah berapa kali kata muncul di dalam tas.

BERT (Encoder Dua Arah Representasi dari Transformer)

Arsitektur model untuk representasi teks. Tim Model BERT dapat bertindak sebagai bagian dari model yang lebih besar untuk klasifikasi teks atau tugas ML lainnya.

BERT memiliki karakteristik berikut:

- Menggunakan arsitektur Transformer, sehingga mengandalkan pada perhatian mandiri.

- Menggunakan bagian encoder dari Transformer. Tugas encoder adalah untuk menghasilkan representasi teks yang baik, bukan untuk melakukan seperti klasifikasi.

- Bersifat dua arah.

- Menggunakan masking untuk pelatihan tanpa pengawasan.

Varian BERT meliputi:

Lihat Open Sourcing BERT: Pra-pelatihan Canggih untuk Natural Language Memproses untuk ringkasan BERT.

dua arah

Istilah yang digunakan untuk menggambarkan sistem yang mengevaluasi teks yang mendahului dan mengikuti bagian target teks. Sebaliknya, Khusus sistem searah mengevaluasi teks yang mendahului bagian target teks.

Misalnya, pertimbangkan model bahasa yang disamarkan yang harus menentukan probabilitas kata atau kata-kata yang mewakili garis bawah dalam pertanyaan berikut:

Ada apa _____ dengan Anda?

Model bahasa searah harus mendasarkan probabilitasnya hanya pada konteks yang diberikan oleh kata-kata "Apa", "adalah", dan "yang". Sebaliknya, model bahasa dua arah juga bisa mendapatkan konteks dari dan "Anda", yang dapat membantu model menghasilkan prediksi yang lebih baik.

model bahasa dua arah

Model bahasa yang menentukan probabilitas bahwa suatu token yang diberikan ada di lokasi tertentu dalam kutipan teks berdasarkan teks sebelumnya dan berikutnya.

Bigram

N-gram yang mana N=2.

BLEU (Pembelajaran Evaluasi Bilingual)

Skor antara 0,0 dan 1,0, inklusif, yang menunjukkan kualitas terjemahan antara dua bahasa manusia (misalnya, antara bahasa Inggris dan Rusia). BLEU skor 1,0 menunjukkan terjemahan yang sempurna; skor BLEU sebesar 0,0 menunjukkan terjemahan yang buruk.

C

model bahasa kausal

Sinonim dari model bahasa searah.

Lihat model bahasa dua arah untuk membedakan berbagai pendekatan terarah dalam pemodelan bahasa.

prompting chain-of-thinkt

Teknik rekayasa perintah yang mendorong model bahasa besar (LLM) untuk menjelaskan penalaran, langkah demi langkah. Misalnya, pertimbangkan petunjuk berikut, membayar perhatian khusus pada kalimat kedua:

Berapakah gaya g yang dialami pengemudi dalam sebuah mobil yang bergerak dari 0 hingga 60 mil per jam dalam 7 detik? Pada jawaban, tampilkan semua penghitungan yang relevan.

Respons LLM kemungkinan akan:

- Menunjukkan urutan rumus fisika, dengan memasukkan nilai 0, 60, dan 7 di tempat yang tepat.

- Menjelaskan mengapa ia memilih formula tersebut dan apa arti berbagai variabelnya.

Rantai pikiran yang mendorong LLM untuk melakukan semua perhitungan, yang mungkin mengarah pada jawaban yang lebih benar. Selain itu, rantai pemikiran memungkinkan pengguna memeriksa langkah-langkah LLM untuk menentukan apakah atau tidak, jawabannya masuk akal.

chat

Konten dialog dua arah dengan sistem ML, biasanya model bahasa besar (LLM). Interaksi sebelumnya dalam chat (apa yang Anda ketik dan bagaimana model bahasa besar merespons) menjadi konteks untuk bagian selanjutnya dari percakapan tersebut.

Chatbot adalah penerapan model bahasa besar.

konfabulasi

Sinonim dari halusinasi.

Konfabulasi mungkin merupakan istilah yang lebih akurat secara teknis daripada halusinasi. Namun, halusinasi menjadi populer terlebih dahulu.

penguraian konstituensi

Membagi kalimat menjadi struktur tata bahasa yang lebih kecil ("konstituen"). Bagian selanjutnya dari sistem ML, seperti natural language understanding, dapat mengurai konstituen dengan lebih mudah daripada kalimat aslinya. Misalnya, pertimbangkan kalimat berikut:

Teman saya mengadopsi dua ekor kucing.

Parser konstituensi dapat membagi kalimat ini menjadi beberapa dua konstituen:

- Teman saya adalah frasa nomina.

- adopted two cats adalah frasa kata kerja.

Konstituen ini dapat dibagi lagi menjadi beberapa konstituen yang lebih kecil. Misalnya, frasa kata kerja

mengadopsi dua kucing

dapat dibagi lebih lanjut menjadi:

- adopted adalah kata kerja.

- two cats adalah frasa nomina lainnya.

embedding bahasa kontekstual

Penyematan yang hampir sama dengan "memahami" kata dan frasa dengan cara yang dapat dilakukan oleh penutur asli manusia. Bahasa yang kontekstual embeddings dapat memahami sintaks yang kompleks, semantik, dan konteks.

Misalnya, pertimbangkan embedding kata bahasa Inggris cow. Embedding lama seperti word2vec dapat mewakili bahasa Inggris kata sedemikian rupa sehingga jarak di ruang penyematan dari sapi ke banteng mirip dengan jarak dari betina (domba betina) ke domba jantan (domba jantan) atau dari betina menjadi jantan. Bahasa yang kontekstual embedding dapat lebih jauh mengetahui menggunakan kata cow yang bisa berarti sapi atau banteng.

jendela konteks

Jumlah token yang dapat diproses model dalam perintah. Semakin besar jendela konteks, semakin banyak informasi dapat digunakan model untuk memberikan respons yang koheren dan konsisten prompt tersebut.

bunga tabrakan

Kalimat atau frasa dengan makna yang ambigu. Bunga sakura menghadirkan masalah yang signifikan dalam alam alami pemahaman bahasa. Misalnya, judul Pita Merah Menahan Pilar adalah {i>error blossom<i} karena model NLU dapat menafsirkan judul secara harfiah atau secara kiasan.

D

decoder

Secara umum, setiap sistem ML yang melakukan konversi dari representasi internal ke representasi yang lebih mentah, jarang, atau eksternal.

Decoder sering kali merupakan komponen dari model yang lebih besar, di mana mereka sering disambungkan dengan encoder.

Pada tugas urutan-ke-urutan, decoder dimulai dengan status internal yang dihasilkan encoder untuk memprediksi .

Lihat Transformer untuk definisi decoder di dalam arsitektur Transformer.

penghilang kebisingan

Pendekatan umum untuk self-supervised learning dalam hal ini:

Dengan penghilangan noise, Anda dapat mempelajari contoh tak berlabel. Set data asli berfungsi sebagai target atau label dan data yang bising sebagai input.

Beberapa model bahasa yang disamarkan menggunakan penghilang noise sebagai berikut:

- Kebisingan ditambahkan secara artifisial ke kalimat tak berlabel dengan menutupi beberapa token-nya.

- Model mencoba memprediksi token asli.

perintah langsung

Sinonim dari zero-shot prompting.

E

edit jarak

Pengukuran seberapa mirip dua {i>string<i} teks satu sama lain. Dalam machine learning, edit jarak berguna karena mudah untuk komputasi, dan cara efektif untuk membandingkan dua {i>string<i} yang dikenal serupa atau untuk menemukan {i>string<i} yang mirip dengan {i>string<i} tertentu.

Ada beberapa definisi jarak edit, masing-masing menggunakan string yang berbeda operasional bisnis. Misalnya, Jarak Levenshtein mempertimbangkan operasi penghapusan, penyisipan, dan penggantian yang paling sedikit.

Misalnya, jarak Levenshtein antara kata "hati" dan "dart" adalah 3 karena 3 edit berikut adalah perubahan paling sedikit untuk mengubah satu kata ke yang lain:

- hati → deart (ganti "h" dengan "d")

- deart → dart (hapus "e")

- dart → dart (masukkan "s")

lapisan embedding

Lapisan tersembunyi khusus yang dilatih pada fitur kategoris berdimensi tinggi untuk secara bertahap mempelajari vektor embedding dimensi yang lebih rendah. Channel memungkinkan jaringan neural untuk melatih jauh lebih lebih efisien dibandingkan melatih fitur kategorikal berdimensi tinggi.

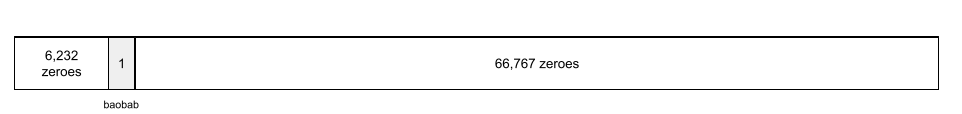

Misalnya, saat ini Bumi mendukung sekitar 73.000 spesies pohon. Misalkan

spesies pohon adalah fitur dalam model Anda, jadi model

lapisan input menyertakan vektor one-hot 73.000

elemen yang panjang.

Misalnya, mungkin baobab akan direpresentasikan seperti ini:

Array 73.000 elemen sangat panjang. Jika Anda tidak menambahkan lapisan embedding ke model, pelatihan akan sangat memakan waktu karena mengalikan 72.999 angka nol. Mungkin Anda memilih lapisan embedding dari 12 dimensi. Akibatnya, lapisan embedding akan secara bertahap mempelajari vektor embedding baru untuk setiap spesies pohon.

Dalam situasi tertentu, hashing adalah alternatif yang wajar ke lapisan embedding.

ruang embedding

Ruang vektor dimensi d yang ditampilkan dari dimensi yang lebih tinggi akan dipetakan ke ruang vektor. Idealnya, ruang embedding berisi struktur yang memberikan hasil matematis yang bermakna; misalnya, dalam ruang embedding yang ideal, penambahan dan pengurangan embedding dapat menyelesaikan tugas analogi kata.

Produk dot dari dua embedding adalah ukuran kesamaannya.

vektor embedding

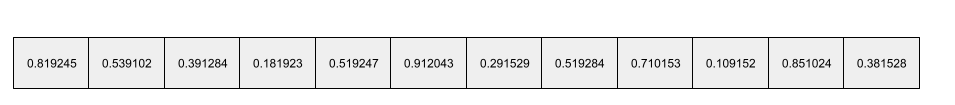

Secara umum, array bilangan floating point yang diambil dari apa pun lapisan tersembunyi yang mendeskripsikan input ke lapisan tersembunyi tersebut. Sering kali, vektor embedding adalah array angka floating point yang dilatih dalam lapisan embedding. Misalnya, lapisan embedding harus mempelajari vektor embedding untuk masing-masing dari 73.000 spesies pohon di Bumi. Mungkin array berikut adalah vektor embedding untuk pohon baobab:

Vektor embedding bukanlah sekumpulan angka acak. Lapisan embedding menentukan nilai-nilai ini melalui pelatihan, mirip dengan cara neural network mempelajari bobot lain selama pelatihan. Setiap elemen dari array adalah peringkat terhadap beberapa karakteristik dari spesies pohon. Yang mana mewakili spesies pohon karakteristik? Sangat sulit yang dapat ditentukan oleh manusia.

Bagian luar biasa secara matematis dari vektor embedding adalah bahwa item memiliki kumpulan angka floating point yang serupa. Misalnya, serupa spesies pohon memiliki kumpulan angka floating point yang lebih mirip daripada spesies pohon yang berbeda. Kayu merah dan sequoia adalah spesies pohon yang terkait, sehingga mereka akan memiliki kumpulan angka mengambang yang lebih mirip daripada redwood dan pohon kelapa. Angka-angka dalam vektor embedding akan berubah setiap kali Anda melatih ulang model, bahkan jika Anda melatih ulang model dengan input yang identik.

pembuat enkode

Secara umum, setiap sistem ML yang melakukan konversi dari resource mentah, sparse, atau eksternal representasi data menjadi representasi yang lebih terproses, lebih padat, atau lebih internal.

Encoder sering kali menjadi komponen dari model yang lebih besar, yang seringkali disambungkan dengan decoder. Beberapa Transformer menyambungkan encoder dengan decoder, meskipun Transformer lain hanya menggunakan encoder atau hanya decoder.

Beberapa sistem menggunakan output encoder sebagai input untuk klasifikasi atau jaringan regresif.

Dalam tugas urutan ke urutan, encoder mengambil urutan input dan menampilkan status internal (vektor). Lalu, decoder menggunakan status internal tersebut untuk memprediksi urutan berikutnya.

Lihat Transformer untuk mengetahui definisi encoder di arsitektur Transformer.

F

few-shot prompting

Perintah yang berisi lebih dari satu contoh ("beberapa") mendemonstrasikan bagaimana model bahasa besar (LLM) harus merespons. Misalnya, {i>prompt<i} panjang berikut berisi dua contoh yang menunjukkan model bahasa besar tentang cara menjawab kueri.

| Bagian dari satu perintah | Catatan |

|---|---|

| Apa mata uang resmi negara yang ditentukan? | Pertanyaan yang perlu dijawab oleh LLM. |

| Prancis: EUR | Satu contoh. |

| Inggris Raya: GBP | Contoh lain. |

| India: | Kueri sebenarnya. |

{i>Fed-shot prompting<i} umumnya memberikan hasil yang lebih diinginkan daripada zero-shot prompting dan one-shot prompting. Namun, few-shot prompting memerlukan prompt yang lebih panjang.

Few-shot prompting adalah bentuk pembelajaran beberapa tahap diterapkan ke pembelajaran berbasis perintah.

Biola

Library konfigurasi Python-first yang menetapkan fungsi dan kelas tanpa kode atau infrastruktur yang invasif. Untuk Pax—dan codebase ML lainnya—fungsi dan class merepresentasikan model dan pelatihan hyperparameter.

Bola mengasumsikan bahwa codebase machine learning biasanya dibagi menjadi:

- Kode pustaka, yang menetapkan layer dan pengoptimal.

- "Perekat" set data kode, yang memanggil {i>library<i} dan menghubungkan semuanya.

Fiddle menangkap struktur panggilan kode glue dalam model yang dapat berubah.

penyempurnaan

Tahap pelatihan kedua, khusus tugas yang dilakukan pada model terlatih guna menyaring parameternya untuk kasus penggunaan tertentu. Misalnya, urutan pelatihan lengkap untuk beberapa model bahasa besar (LLM) adalah sebagai berikut:

- Pra-pelatihan: Latih model bahasa besar dengan set data umum yang luas, seperti semua halaman Wikipedia bahasa Inggris.

- Fine-tuning: Latih model terlatih untuk melakukan tugas tertentu, seperti menanggapi pertanyaan medis. Fine-tuning biasanya melibatkan ratusan atau ribuan contoh yang fokus pada tugas tertentu.

Contoh lain, urutan pelatihan lengkap untuk model gambar besar adalah berikut ini:

- Pelatihan awal: Melatih model gambar besar pada gambar umum yang luas seperti semua gambar di Wikimedia commons.

- Fine-tuning: Latih model terlatih untuk melakukan tugas tertentu, seperti membuat gambar {i>orca<i}.

Fine-tuning dapat memerlukan kombinasi dari strategi berikut:

- Memodifikasi semua model terlatih yang ada parameter. Hal ini terkadang disebut perbaikan penuh.

- Hanya mengubah beberapa parameter model terlatih yang ada (biasanya, lapisan yang paling dekat dengan lapisan output), sembari mempertahankan parameter lain yang sudah ada (biasanya, lapisan terdekat dengan lapisan input). Lihat parameter-efficient tuning.

- Menambahkan lebih banyak lapisan, biasanya di atas lapisan yang ada yang paling dekat dengan lapisan output.

Fine-tuning adalah bentuk pembelajaran transfer. Dengan demikian, fine-tuning mungkin menggunakan fungsi kerugian yang berbeda atau model yang berbeda dibandingkan dengan yang digunakan untuk melatih model terlatih. Misalnya, Anda dapat menyesuaikan model gambar besar yang sudah dilatih sebelumnya untuk menghasilkan model regresi yang menampilkan jumlah burung pada gambar input.

Bandingkan dan buat perbedaan nyata penyempurnaan dengan istilah berikut:

Flax

Aplikasi open source berperforma tinggi library untuk deep learning yang dibangun di atas JAX. Flax menyediakan fungsi untuk pelatihan jaringan neural, serta sebagai metode untuk mengevaluasi kinerjanya.

Flaxformer

Transformer open source perpustakaan, dibangun di Flax, yang dirancang terutama untuk natural language processing dan penelitian multimodal.

G

AI generatif

Bidang transformatif yang terus berkembang tanpa definisi formal. Meskipun demikian, sebagian besar pakar setuju bahwa model AI generatif dapat membuat ("buat") konten yang merupakan semua hal berikut:

- kompleks

- koheren

- asli

Misalnya, model AI generatif dapat membuat model esai atau gambar.

Beberapa teknologi lama, termasuk LSTMs dan RNN, juga dapat menghasilkan respons asli dan konten yang koheren. Beberapa ahli melihat teknologi sebelumnya sebagai AI generatif, sementara yang lain merasa bahwa AI generatif sejati membutuhkan {i>output<i} daripada yang dapat dihasilkan oleh teknologi sebelumnya.

Berbeda dengan ML prediktif.

GPT (Transformer Terlatih Generatif)

Keluarga berbasis Transformer model bahasa besar (LLM) yang dikembangkan oleh OpenAI.

Varian GPT dapat berlaku untuk beberapa modalitas, termasuk:

- pembuatan gambar (misalnya, ImageGPT)

- pembuatan teks ke gambar (misalnya, DALL-E).

H

halusinasi

Produksi {i>output<i} yang tampak masuk akal tetapi faktual salah oleh AI generatif yang dimaksudkan untuk pernyataan tentang dunia nyata. Misalnya, model AI generatif yang mengklaim bahwa Barack Obama meninggal pada tahun 1865 sedang berhalusinasi.

I

pembelajaran dalam konteks

Sinonim dari few-shot prompting.

L

LaMDA (Language Model for Dialogue Applications/Model Bahasa untuk Aplikasi Dialog)

Berbasis Transformer model bahasa besar (LLM) yang dikembangkan oleh Google dan dilatih pada set data dialog besar yang dapat menghasilkan respons percakapan yang realistis.

LaMDA: percakapan terobosan kami teknologi memberikan ringkasan.

model bahasa

Model yang memperkirakan probabilitas token atau urutan token yang terjadi dalam urutan token yang lebih panjang.

model bahasa besar

Istilah informal tanpa definisi yang ketat yang biasanya berarti model bahasa yang memiliki parameter. Beberapa model bahasa besar berisi lebih dari 100 miliar parameter.

ruang laten

Sinonim dari ruang penyematan.

LLM

Singkatan dari model bahasa besar.

LoRA

Singkatan dari Adaptasi Peringkat Rendah.

Adaptasi Peringkat Rendah (LoRA)

Sebuah algoritma untuk melakukan parameter-efficient tuning yang fine-tune hanya subset dari parameter model bahasa besar. LoRA memberikan manfaat berikut:

- Menyesuaikan lebih cepat daripada teknik yang memerlukan fine-tuning semua model parameter.

- Mengurangi biaya komputasi inferensi dalam yang sudah di-fine-tune.

Model yang disesuaikan dengan LoRA mempertahankan atau meningkatkan kualitas prediksinya.

LoRA memungkinkan beberapa versi khusus dari suatu model.

M

model bahasa yang disamarkan

Model bahasa yang memprediksi probabilitas token kandidat untuk mengisi bagian yang kosong secara berurutan. Misalnya, model bahasa yang disamarkan dapat menghitung probabilitas kata kandidat untuk mengganti garis bawah dalam kalimat berikut:

____ di topi itu kembali.

Literatur biasanya menggunakan {i>string<i} "MASK" bukan garis bawah. Contoh:

"MASK" dalam topi itu kembali.

Sebagian besar model bahasa yang disamarkan dan modern bersifat dua arah.

pembelajaran meta

Bagian dari machine learning yang menemukan atau meningkatkan kualitas algoritma pembelajaran. Sistem pembelajaran meta juga dapat bertujuan melatih model untuk dengan cepat mempelajari tugas dari sejumlah kecil data atau dari pengalaman yang diperoleh dalam tugas sebelumnya. Algoritma pembelajaran meta umumnya mencoba untuk mencapai hal-hal berikut:

- Meningkatkan atau mempelajari fitur rekayasa tangan (seperti penginisialisasi atau pengoptimal).

- Meningkatkan efisiensi data dan komputasi.

- Meningkatkan generalisasi.

Meta-learning terkait dengan few-shot learning.

modalitas

Kategori data tingkat tinggi. Misalnya, angka, teks, gambar, video, dan audio adalah lima modalitas yang berbeda.

paralelisme model

Cara untuk menskalakan pelatihan atau inferensi yang menempatkan berbagai bagian dari satu bagian model di berbagai perangkat. Paralelisme model memungkinkan model yang terlalu besar untuk diletakkan di satu perangkat.

Untuk menerapkan paralelisme model, sistem biasanya melakukan hal berikut:

- Shard (membagi) model menjadi bagian-bagian yang lebih kecil.

- Mendistribusikan pelatihan bagian-bagian yang lebih kecil ke beberapa prosesor. Setiap prosesor melatih bagian modelnya sendiri.

- Menggabungkan hasil untuk membuat model tunggal.

Paralelisme model memperlambat pelatihan.

Lihat juga paralelisme data.

self-attention multi-kepala

Perluasan dari perhatian mandiri yang menerapkan mekanisme self-attention beberapa kali untuk setiap posisi dalam urutan input.

Transformers memperkenalkan fitur self-attention multi-head.

model multimodal

Model yang input dan/atau outputnya menyertakan lebih dari satu modalitas. Misalnya, pertimbangkan model yang mengambil gambar dan teks teks (dua modalitas) sebagai fitur, dan menghasilkan skor yang menunjukkan seberapa tepat teks keterangan untuk gambar tersebut. Jadi, input model ini multimodal dan output-nya unimodal.

T

natural language understanding

Menentukan niat pengguna berdasarkan apa yang diketik atau dikatakan pengguna. Misalnya, mesin telusur menggunakan natural language understanding untuk menentukan apa yang dicari pengguna berdasarkan apa yang diketik atau dikatakan pengguna.

N-gram

Rangkaian N kata yang diurutkan. Misalnya, truly madly bernilai 2 gram. Karena benar-benar berbeda 2 gram dengan benar-benar gila.

| T | Nama untuk jenis N-gram ini | Contoh |

|---|---|---|

| 2 | bigram atau 2 gram | untuk pergi, pergi, makan siang, makan malam |

| 3 | trigram atau 3 gram | makan terlalu banyak, tiga tikus tunanetra, bel berbunyi |

| 4 | 4 gram | berjalan di taman, terkena debu, dan anak itu makan miju-miju |

Banyak natural language understanding model bergantung pada N-gram untuk memprediksi kata berikutnya yang akan diketik pengguna atau katakan. Misalnya, anggaplah pengguna mengetik three blind. Model NLU berdasarkan trigram kemungkinan akan memprediksi bahwa selanjutnya pengguna akan mengetik mice.

Bedakan N-gram dengan kantong kata, yang kumpulan kata yang tidak diurutkan.

NLU

Singkatan dari bahasa natural pemahaman.

O

metode one-shot prompting

Perintah yang berisi satu contoh yang menunjukkan cara model bahasa besar akan merespons. Misalnya, prompt berikut berisi satu contoh yang menunjukkan model bahasa besar model ini harus menjawab kueri.

| Bagian dari satu perintah | Catatan |

|---|---|

| Apa mata uang resmi negara yang ditentukan? | Pertanyaan yang perlu dijawab oleh LLM. |

| Prancis: EUR | Satu contoh. |

| India: | Kueri sebenarnya. |

Bandingkan dan bedakan one-shot prompting dengan istilah berikut:

P

parameter-efficient tuning

Serangkaian teknik untuk mengoptimalkan berbagai model bahasa terlatih (PLM) lebih efisien daripada penyesuaian penuh. Parameter-efficient tuning biasanya melakukan penyesuaian yang jauh lebih sedikit parameter daripada menyetel fine-tuning, namun umumnya menghasilkan model bahasa besar yang berfungsi juga (atau hampir sama) model bahasa besar yang dibangun dari fine-tuning.

Bandingkan dan buat perbedaan nyata penyesuaian parameter yang efisien dengan:

Parameter-efficient tuning juga dikenal sebagai parameter-efficient tuning.

pipeline

Bentuk paralelisme model di mana model dibagi menjadi beberapa tahap yang berurutan dan setiap tahap dijalankan di perangkat yang berbeda. Saat sebuah tahap memproses satu batch, bisa berfungsi di batch berikutnya.

Lihat juga pelatihan bertahap.

PLM

Singkatan dari model bahasa terlatih.

encoding posisi

Teknik untuk menambahkan informasi tentang posisi token secara berurutan ke embedding token. Model transformer menggunakan posisi pengkodean untuk lebih memahami hubungan antara berbagai bagian dari .

Implementasi umum dari pengkodean posisi{i> <i}menggunakan fungsi sinusoidal. (Secara khusus, frekuensi dan amplitudo fungsi sinusoidal ditentukan oleh posisi token dalam urutan.) Teknik ini memungkinkan model Transformer untuk belajar menangani berbagai bagian berurutan berdasarkan posisinya.

model terlatih

Model atau komponen model (seperti vektor penyematan) yang telah dilatih. Terkadang, Anda akan memasukkan vektor embedding terlatih ke jaringan neural. Pada lain waktu, model Anda akan melatih embedding vektor itu sendiri, daripada mengandalkan embeddings terlatih.

Istilah model bahasa terlatih mengacu pada model bahasa besar yang telah melewati pra-pelatihan.

latihan awal

Pelatihan awal model pada set data besar. Beberapa model terlatih adalah raksasa yang ceroboh dan biasanya harus ditingkatkan melalui pelatihan tambahan. Misalnya, pakar ML mungkin melatih model bahasa besar (LLM) di set data teks yang luas, seperti semua halaman berbahasa Inggris di Wikipedia. Setelah pelatihan awal, model yang dihasilkan mungkin akan ditingkatkan kualitasnya melalui salah satu teknik:

perintah

Semua teks yang dimasukkan sebagai input pada model bahasa besar untuk mengondisikan model agar berperilaku dengan cara tertentu. Perintah bisa sesingkat frasa atau panjangnya bebas (misalnya, seluruh teks novel). Perintah dapat dikelompokkan ke dalam beberapa kategori, termasuk yang ditampilkan dalam tabel berikut:

| Kategori perintah | Contoh | Catatan |

|---|---|---|

| Pertanyaan | Seberapa cepat merpati bisa terbang? | |

| Petunjuk | Tulis puisi lucu tentang arbitrase. | Prompt yang meminta model bahasa besar untuk melakukan sesuatu. |

| Contoh | Terjemahkan kode Markdown ke HTML. Contoh:

{i>Markdown<i}: * item daftar HTML: <ul> <li>daftar item</li> </ul> |

Kalimat pertama dalam contoh perintah ini adalah instruksi. sisa perintah adalah contohnya. |

| Peran | Menjelaskan mengapa penurunan gradien digunakan dalam pelatihan machine learning untuk mendapatkan gelar PhD di bidang Fisika. | Bagian pertama dari kalimat itu adalah instruksi; frasa "mendapatkan gelar PhD di bidang Fisika" adalah bagian peran. |

| Input sebagian untuk diselesaikan model | Perdana Menteri Inggris Raya tinggal di | Perintah input parsial dapat berakhir secara tiba-tiba (seperti yang terjadi pada contoh ini) atau diakhiri dengan garis bawah. |

Model AI generatif dapat merespons perintah dengan teks, kode, gambar, sematan, video...hampir apa saja.

pembelajaran berbasis perintah

Kemampuan model tertentu yang memungkinkan mereka beradaptasi perilakunya sebagai respons terhadap input teks arbitrer (perintah). Dalam paradigma pembelajaran berbasis perintah yang umum, model bahasa besar (LLM) merespons perintah dengan menghasilkan teks. Misalnya, anggaplah pengguna memasukkan perintah berikut:

Ringkaslah Hukum Ketiga Gerak Newton.

Model yang mampu melakukan pembelajaran berbasis perintah tidak dilatih secara khusus untuk menjawab perintah sebelumnya. Sebaliknya, model “mengetahui” banyak fakta tentang fisika, banyak tentang aturan bahasa umum, dan banyak hal tentang apa yang jawaban yang bermanfaat. Pengetahuan tersebut cukup untuk memberikan (semoga) yang bermanfaat ke suatu jawaban tertentu. Masukan tambahan dari manusia ("Jawaban itu terlalu rumit." atau "Apa itu reaksi?") memungkinkan beberapa sistem pembelajaran berbasis perintah untuk secara bertahap meningkatkan kegunaan jawaban mereka.

desain prompt

Sinonim dari rekayasa perintah.

rekayasa perintah

Seni membuat perintah yang menghasilkan respons yang diinginkan dari model bahasa besar. Manusia menjalankan perintah teknik. Menulis perintah yang terstruktur dengan baik adalah bagian penting dalam memastikan respons yang berguna dari model bahasa besar. Prompt Engineering bergantung pada banyak faktor, termasuk:

- Set data yang digunakan untuk melatih sebelumnya dan mungkin Sempurnakan model bahasa besar.

- temperature dan parameter decoding lainnya yang untuk menghasilkan respons.

Lihat Pengantar desain prompt untuk mengetahui detail selengkapnya tentang cara menulis perintah yang bermanfaat.

Prompt Design adalah sinonim untuk Prompt Engineering.

prompt tuning

Mekanisme parameter-efficient tuning yang mempelajari "awalan" bahwa sistem menambahkan perintah sebenarnya.

Salah satu variasi prompt tuning—terkadang disebut tuning awalan—adalah untuk tambahkan awalan di setiap lapisan. Sebaliknya, sebagian besar prompt tuning menambahkan awalan ke lapisan input.

R

pemberian perintah peran

Bagian opsional dari perintah yang mengidentifikasi target audiens untuk respons model AI generatif. Tanpa peran , model bahasa besar memberikan jawaban yang mungkin berguna atau tidak orang yang mengajukan pertanyaan. Dengan prompt peran, model bahasa dapat menjawab dengan cara yang lebih tepat dan lebih membantu bagi audiens target yang spesifik. Misalnya, bagian prompt peran prompt dicetak tebal:

- Rangkum artikel ini untuk mendapatkan gelar PhD dalam bidang ekonomi.

- Menjelaskan cara kerja pasang surut untuk anak berusia sepuluh tahun.

- Menjelaskan krisis keuangan 2008. Bicaralah sebagaimana Anda mungkin kepada anak kecil, atau golden retriever.

S

self-attention (lapisan ini juga disebut lapisan self-attention)

Lapisan jaringan neural yang mengubah urutan embedding (misalnya, embedding token) menjadi urutan embedding lainnya. Setiap embedding di urutan output dibangun dengan mengintegrasikan informasi dari elemen urutan input melalui mekanisme perhatian.

Bagian self-attention dari self-attention mengacu pada urutan yang hadir untuk itu sendiri daripada beberapa konteks lain. Perhatian penuh adalah salah satu hal utama elemen penyusun untuk Transformers dan menggunakan pencarian kamus terminologi, seperti "query", "key", dan "value".

Lapisan self-attention dimulai dengan urutan representasi input, satu untuk setiap kata. Representasi input untuk kata bisa berupa penyematan. Untuk setiap kata dalam urutan input, jaringan menilai relevansi kata terhadap setiap elemen dalam seluruh urutan kata. Skor relevansi menentukan seberapa banyak representasi akhir kata menggabungkan representasi dari kata-kata lain.

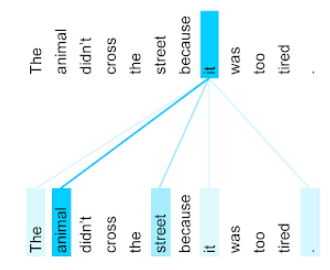

Misalnya, perhatikan kalimat berikut:

Hewan itu tidak menyeberang jalan karena terlalu lelah.

Ilustrasi berikut (dari Transformer: Arsitektur Jaringan Neural Baru untuk Bahasa Memahami) menunjukkan pola atensi lapisan self-attention untuk sebutan it, dengan kegelapan setiap baris yang menunjukkan seberapa besar kontribusi setiap kata terhadap representasi:

Lapisan self-attention menandai kata-kata yang relevan dengan "it". Di sini yang dipelajari lapisan attention untuk menyoroti kata-kata yang mungkin merujuk pada penetapan bobot tertinggi untuk hewan.

Untuk urutan n token, self-attention mengubah urutan embedding n kali terpisah, sekali di setiap posisi dalam urutan.

Lihat juga perhatian dan multi-head self-attention.

analisis sentimen

Menggunakan algoritma statistik atau machine learning untuk menentukan performa grup sikap keseluruhan—positif atau negatif—terhadap suatu layanan, produk, organisasi, atau topik. Misalnya, menggunakan natural language understanding, algoritma dapat melakukan analisis sentimen pada masukan tekstual dari kuliah perguruan tinggi untuk menentukan sejauh mana mahasiswa umumnya menyukai atau tidak menyukai materi tersebut.

tugas urutan ke urutan

Tugas yang mengonversi urutan input token menjadi output urutan token. Misalnya, dua jenis populer urutan-ke-urutan tugas adalah:

- Penerjemah:

- Contoh urutan input: "Saya cinta kamu".

- Contoh urutan output: "Je t'aime".

- Menjawab pertanyaan:

- Contoh urutan input: "Apakah saya perlu mobil saya di Jakarta?"

- Contoh urutan output: "No. Simpan mobil Anda di rumah."

skip-gram

n-gram yang dapat menghilangkan (atau "melewati") kata-kata dari aslinya konteks, yang berarti N kata mungkin awalnya tidak berdekatan. Selengkapnya “k-skip-n-gram” saja, adalah n-gram dengan hingga k kata yang mungkin memiliki dilewati.

Misalnya, "rubah cokelat cepat" memiliki kemungkinan 2 gram berikut:

- "cepat"

- "cokelat cepat"

- "rubah cokelat"

"1-lewati-2-gram" adalah pasangan kata yang memiliki paling banyak 1 kata di antara mereka. Oleh karena itu, "rubah cokelat" memiliki 1-skip 2-gram berikut:

- "cokelat"

- "rubah cepat"

Selain itu, semua 2 gram juga 1-skip-2-gram, karena lebih sedikit dari satu kata bisa dilewati.

Lewati gram berguna untuk memahami lebih lanjut konteks kata di sekitar. Dalam contoh, "{i>fox<i}" terkait langsung dengan kata "cepat" dalam kumpulan 1-lewati-2-gram, tetapi tidak dalam set 2-gram.

Bantuan untuk latihan lewati gram model penyematan kata.

prompt tuning lembut

Teknik untuk melakukan tuning model bahasa besar untuk tugas tertentu, tanpa perlu sumber daya fine-tuning. Alih-alih melatih ulang semua bobot dalam model, soft prompt tuning otomatis menyesuaikan perintah untuk mencapai sasaran yang sama.

Diberikan perintah tekstual, prompt tuning ringan biasanya menambahkan embedding token tambahan ke prompt propagasi mundur untuk mengoptimalkan input.

"Sulit" prompt berisi token aktual, bukan embedding token.

fitur renggang

Fitur yang sebagian besar nilainya nol atau kosong. Misalnya, fitur yang berisi satu nilai 1 dan satu juta nilai 0 adalah jarang. Sebaliknya, fitur padat memiliki nilai yang utamanya tidak bernilai nol atau kosong.

Dalam machine learning, jumlah fitur yang mengejutkan adalah fitur yang jarang. Fitur kategori biasanya berupa fitur renggang. Misalnya, dari 300 kemungkinan spesies pohon di hutan, satu contoh mungkin hanya mengidentifikasi pohon maple. Atau, dari jutaan tentang video yang mungkin ada dalam koleksi video, satu contoh mungkin mengidentifikasi hanya "Casablanca."

Dalam model, Anda biasanya merepresentasikan fitur renggang dengan enkode one-hot. Jika {i>one-hot encoding<i} berukuran besar, Anda dapat menempatkan lapisan embedding di atas lapisan encoding one-hot untuk efisiensi yang lebih besar.

representasi renggang

Hanya menyimpan posisi elemen bukan nol dalam fitur renggang.

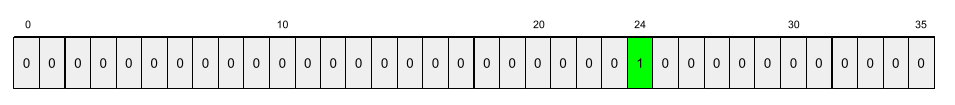

Misalnya, fitur kategori bernama species mengidentifikasi 36

spesies pohon

di hutan tertentu. Asumsikan lebih lanjut bahwa setiap

contoh hanya mengidentifikasi satu spesies.

Anda dapat menggunakan vektor one-hot untuk merepresentasikan spesies pohon pada setiap contoh.

Vektor one-hot akan berisi satu 1 (untuk mewakili

spesies pohon tertentu dalam contoh tersebut) dan 35 0 (untuk mewakili

35 spesies pohon yang tidak ada dalam contoh tersebut). Jadi, representasi one-hot

dari maple mungkin terlihat seperti berikut:

Atau, representasi sparse hanya

akan mengidentifikasi posisi

spesies tertentu. Jika maple berada di posisi 24, representasi sparse

dari maple akan menjadi:

24

Perhatikan bahwa representasi renggang jauh lebih ringkas daripada representasi one-hot merepresentasinya.

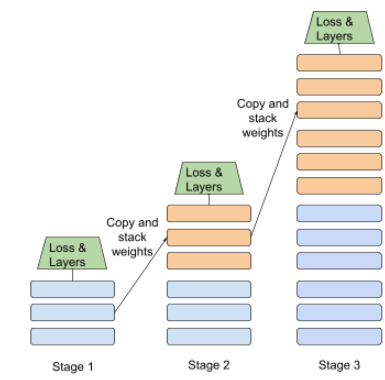

pelatihan bertahap

Taktik melatih model dalam urutan tahapan yang berbeda. Tujuannya bisa berupa untuk mempercepat proses pelatihan, atau untuk mencapai kualitas model yang lebih baik.

Ilustrasi pendekatan {i>progressive stacking<i} ditampilkan di bawah ini:

- Tahap 1 berisi 3 lapisan tersembunyi, tahap 2 berisi 6 lapisan tersembunyi, dan tahap 3 berisi 12 lapisan tersembunyi.

- Tahap 2 memulai pelatihan dengan bobot yang dipelajari di 3 lapisan tersembunyi dari Tahap 1. Tahap 3 memulai pelatihan dengan bobot yang dipelajari dalam 6 lapisan tersembunyi Tahap 2.

Lihat juga pipeline.

token subkata

Dalam model bahasa, token yang merupakan {i>substring<i} dari sebuah kata, yang mungkin merupakan seluruh kata.

Misalnya, kata seperti "itemisasi" mungkin dipecah menjadi bagian-bagian "item" (kata akar) dan "{i>ize<i}" (akhiran), yang masing-masing diwakili oleh elemen sebelumnya yang benar. Membagi kata-kata yang tidak umum menjadi potongan-potongan seperti itu, yang disebut subkata, memungkinkan model bahasa untuk beroperasi pada bagian konstituen kata yang lebih umum, seperti awalan dan akhiran.

Sebaliknya, kata-kata umum seperti "pergi" mungkin tidak dipecah dan mungkin diwakili oleh satu token.

S

T5

Model transfer teks ke teks diperkenalkan oleh AI Google pada tahun 2020. T5 adalah model encoder-decoder, berdasarkan Arsitektur Transformer, dilatih dengan arsitektur yang {i>dataset<i} aslinya. Alat ini efektif pada berbagai tugas natural language processing, seperti membuat teks, menerjemahkan bahasa, dan menjawab pertanyaan dalam percakapan.

T5 mendapatkan namanya dari lima huruf T dalam "Text-to-Text Transfer Transformer".

T5X

Framework machine learning open source yang dirancang untuk membangun dan melatih natural language processing berskala besar (NLP). T5 diimplementasikan pada codebase T5X (yang dibangun di JAX dan Flax).

suhu

Hyperparameter yang mengontrol tingkat keacakan output model. Suhu yang lebih tinggi menghasilkan lebih banyak {i>output<i} acak, sementara temperatur yang lebih rendah akan menghasilkan lebih sedikit {i>output<i} acak.

Memilih suhu terbaik tergantung pada aplikasi dan properti pilihan output model. Misalnya, Anda akan mungkin menaikkan suhu saat membuat aplikasi yang yang menghasilkan output materi iklan. Sebaliknya, Anda mungkin akan menurunkan suhu saat membangun model yang mengklasifikasikan gambar atau teks untuk meningkatkan akurasi dan konsistensi model.

Suhu sering digunakan dengan softmax.

rentang teks

Rentang indeks array yang terkait dengan subbagian tertentu dari string teks.

Misalnya, kata good di string Python s="Be good now" menempati

rentang teks dari 3

hingga 6.

token

Dalam model bahasa, unit atom yang digunakan model melatih dan membuat prediksi. Token biasanya merupakan salah satu berikut ini:

- sebuah kata—misalnya, frasa " seperti kucing" terdiri dari tiga kata token: "dogs", "like", dan "cats".

- karakter—misalnya, frasa "bike fish" terdiri dari sembilan token karakter. (Perhatikan bahwa spasi kosong dihitung sebagai salah satu token.)

- subkata—yang satu kata bisa berupa satu token atau beberapa token. Subkata terdiri dari kata akar, awalan, atau akhiran. Misalnya, model bahasa yang menggunakan subkata sebagai token mungkin melihat kata "dogs" sebagai dua token (akar kata "dog" dan akhiran jamak "s"). Hal yang sama model bahasa tertentu mungkin menampilkan satu kata "lebih tinggi" menjadi dua subkata (yang akar kata "tinggi" dengan akhiran "er").

Dalam domain di luar model bahasa, token dapat merepresentasikan jenis satuan atom. Misalnya, dalam computer vision, token mungkin merupakan subset gambar.

Transformator

Arsitektur jaringan neural yang dikembangkan di Google yang mengandalkan mekanisme perhatian mandiri untuk mengubah urutan embedding input ke dalam urutan output, embedding tanpa mengandalkan konvolusi atau jaringan saraf berulang. Transformator bisa menjadi dipandang sebagai tumpukan lapisan self-attention.

Transformator dapat mencakup salah satu dari berikut ini:

Encoder mengubah urutan embedding menjadi urutan baru panjangnya sama. Encoder berisi N lapisan identik, yang masing-masing berisi dua sub-lapisan. Kedua sub-lapisan ini diterapkan di setiap posisi input urutan embedding, mengubah setiap elemen urutan menjadi set data penyematan. Sub-lapisan encoder pertama menggabungkan informasi dari seluruh urutan input teks. Sub-lapisan encoder kedua mengubah lapisan informasi ke dalam embedding output.

Decoder mengubah urutan embedding input menjadi urutan embedding output, kemungkinan dengan panjang yang berbeda. Decoder juga menyertakan N lapisan identik dengan tiga sub-lapisan, dua di antaranya mirip dengan sub-lapisan encoder. Sub-lapisan decoder ketiga mengambil output encoder dan menerapkan mekanisme perhatian mandiri pada mengumpulkan informasi darinya.

Postingan blog Transformer: Arsitektur Jaringan Neural Baru untuk Bahasa Memahami memberikan pengantar yang baik tentang Transformer.

trigram

N-gram yang mana N=3.

U

searah

Sistem yang hanya mengevaluasi teks yang mendahului bagian target teks. Sebaliknya, sistem dua arah mengevaluasi teks yang mendahului dan mengikuti bagian target teks. Lihat dua arah untuk mengetahui detail selengkapnya.

model bahasa searah

Model bahasa yang mendasarkan probabilitasnya hanya pada token muncul sebelum, bukan setelah, token target. Berbeda dengan model bahasa dua arah.

V

autoencoder variasional (VAE)

Jenis autoencoder yang memanfaatkan perbedaan tersebut antara input dan output untuk menghasilkan versi input yang dimodifikasi. Autoencoder variasional berguna untuk AI generatif.

VAE didasarkan pada inferensi variasional: sebuah teknik untuk memperkirakan parameter dari model probabilitas.

W

embedding kata

Merepresentasikan setiap kata dalam himpunan kata dalam vektor yang disematkan; yaitu, mewakili setiap kata sebagai vektor nilai floating point antara 0,0 dan 1,0. Kata dengan kemiripan memiliki representasi yang lebih mirip daripada kata-kata dengan makna yang berbeda. Misalnya, wortel, seledri, dan mentimun memiliki jumlah relatif yang mirip, yang akan sangat berbeda dengan representasi pesawat, kacamata hitam, dan tempel gigi.

Z

metode zero-shot prompting

Perintah yang tidak memberikan contoh cara yang Anda inginkan model bahasa besar untuk merespons. Contoh:

| Bagian dari satu perintah | Catatan |

|---|---|

| Apa mata uang resmi negara yang ditentukan? | Pertanyaan yang perlu dijawab oleh LLM. |

| India: | Kueri sebenarnya. |

Model bahasa besar mungkin merespons dengan salah satu dari hal berikut:

- Rupee

- INR

- Rs

- Rupee India

- Rupee

- Rupee India

Semua jawaban benar, meskipun Anda mungkin lebih memilih format tertentu.

Bandingkan dan bandingkan zero-shot prompting dengan istilah berikut: