本页面包含语言评估术语表术语。对于所有术语库术语 点击此处。

A

注意力层、

一种用于神经网络的机制, 特定字词或字词中某一部分的重要性。注意力压缩 模型预测下一个词元/字词所需的信息量。 典型的注意力机制可能包含 一组输入的加权和,其中 每个输入的权重由 神经网络。

另请参阅自注意力和 多头自注意力 Transformer 的基础组件。

自编码器

一个学习从机器学习系统中提取最重要的信息的系统, 输入。自编码器是编码器和 解码器。自动编码器依赖于以下两个步骤:

- 编码器将输入映射到(通常)有损低维 (中级)格式。

- 解码器通过映射关系来构建原始输入的有损版本, 将低维格式转换为原始的高维格式 输入格式。

自编码器进行端到端训练,方法是让解码器尝试 根据编码器的中间格式重建原始输入。 尽可能接近由于中间格式较小 (低维度),则强制自动编码器 了解输入中的哪些信息是必要的, 与输入完全相同。

例如:

- 如果输入数据是图形,则非精确副本将类似于 原始图片,只是有所修改。或许, 不精确的文案会去除原始图片中的噪声或填充 缺少一些像素

- 如果输入数据是文本,自动编码器会生成新文本, 模仿(但不完全相同)原文。

另请参阅变体自动编码器。

自回归模型

一种模型,可根据自身的先前模型推断出预测结果 预测。例如,自动回归语言模型 token。 所有基于 Transformer 大语言模型具有自动回归性。

相比之下,基于 GAN 的图片模型通常不具有自动回归性 因为它们在单次正向传播中生成图像, 步骤。不过,某些图片生成模型是自动回归模型,这是因为 它们一步步生成图像。

B

词袋

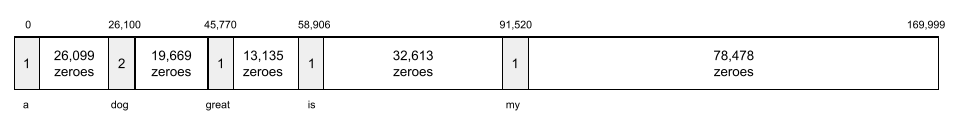

短语或段落中的字词的表示形式; 而与顺序无关。例如,词袋表示 以下三个短语:

- 狗跳跃

- 跳狗

- 小狗跳跃

每个字词都会映射到稀疏向量中的一个索引,其中 词汇表中的每个字词都有一个索引。例如: 短语“the dog jumps”会映射到一个非零特征向量 对应于字词 the、dog 和 jumps。非零值可以是以下任意值:

- 1 表示某个字词的存在。

- 某个字词在词袋中出现的次数。例如: 假设词组是“the maroon dog is a dog with maroon fur”,那么 maroon 和 dog 将表示为 2,而其他字词 表示为 1。

- 一些其他值,例如 词包中出现的次数。

BERT(双向编码器) 基于 Transformer 的表示法)

文本表示的模型架构。一个训练有素的 BERT 模型可以充当大型文本分类模型的一部分, 其他机器学习任务。

BERT 具有以下特征:

- 使用 Transformer 架构,因此依赖于 自注意力。

- 使用 Transformer 的编码器部分。编码器的工作 是生成良好的文本表示, 等任务。

- 为双向。

- 针对以下内容使用遮盖: 非监督式训练。

BERT 的变体包括:

。请参阅开源 BERT:先进的自然语言预训练 数据处理 简要了解 BERT。

双向

一个术语,用于描述系统评估前面的文本 跟随文本的目标部分。相比之下, 仅限单向系统 用于评估文本的目标部分之前的文本。

以一个掩码语言模型为例,该模型 必须判断字词中表示下划线的 以下问题:

和你一起的_____是什么?

单向语言模型只能基于其概率 根据“内容”“是”和“此”字词提供的上下文进行微调。相比之下, 双向语言模型也可以和“您” 这可能有助于模型生成更好的预测。

双向语言模型

一种语言模型,用于确定 给定词元是否出现在给定位置的文本摘录中, 前和后文本。

二元语法

一种 N 元语法,其中 N=2。

BLEU(双语评估研究)

介于 0.0 和 1.0(含)之间的分数,表示翻译的质量 两种人类语言之间的差异。BLEU 1.0 分表示完美的翻译;BLEU 得分为 0.0,表示 太糟糕了

C

因果语言模型

与单向语言模型的含义相同。

请参阅双向语言模型 比较语言建模中不同的方向性方法。

思维链提示

一种提示工程技术,鼓励 一个大语言模型 (LLM) 来解释 一步一步地进行推理。例如,请考虑以下提示: 特别要注意第二句话:

在 0 到 60 的范围内,驾驶员在汽车上体验到的重力是多少 能达到每小时多少英里?在答案中显示所有相关计算。

LLM 的回答可能是:

- 插入值 0、60 和 7,显示一系列物理公式 放置在适当的位置。

- 解释为什么选择这些公式以及各种变量的含义。

思维链提示迫使 LLM 执行所有计算, 这可能会得到更正确的答案。此外,思维链 让用户能够检查 LLM 的步骤,以确定 或者答案是否合理。

聊天

与机器学习系统(通常是 大语言模型。 上一次聊天互动 (您输入的内容以及大语言模型的响应方式)会变成 为聊天的后续部分提供上下文。

聊天机器人是大型语言模型的应用。

谈话

与光照的含义相同。

从技术上来说,“幻想”可能比“幻觉”更为准确。 然而,幻觉最初流行起来。

选区解析

将句子拆分为较小的语法结构(“组成部分”)。 机器学习系统的后期部分,例如 自然语言理解模型, 比原始句子更容易解析这些成分。例如: 请考虑以下句子:

我的朋友领养了两只猫。

合成器解析器可将这个句子分成以下语句 两个组成部分:

- 我的朋友是一个名词短语。

- adopted two cats 是一个动词短语。

这些组成部分还可以进一步细分为更小的组成部分。 例如,动词短语

领养了两只猫

可进一步细分为:

- adopted 是一个动词。

- two cats 是另一个名词短语。

上下文化语言嵌入

接近“理解”的嵌入字词 和短语。语境 嵌入可以理解复杂的语法、语义和上下文。

以英语单词 cow 为例,较早的嵌入 例如 word2vec 可以表示英语 使嵌入空间中的距离 从母羊到公牛的距离相当于从母羊到母羊到 ram(公羊)或从 female 到 male。语境 嵌入可以更进一步, 认识到讲英语的人 随意使用“cow”一词表示 cow 或 bull。

上下文窗口

一个模型可以在给定给定实例中处理的词元数量 提示。上下文窗口越大,信息越丰富 模型可用于提供连贯且一致的回答 。

崩溃花

含义不明确的句子或短语。 崩溃花是大自然界的重大问题 语言理解。 例如,标题“Red Tape Holds Up Skyscraper”是个 因为 NLU 模型可以逐字解读标题, 比喻。

D

解码器

一般来说,任何从经过处理的、密集的或 转换为更原始、稀疏或对外的表示法。

解码器通常是较大模型的一个组件, 与编码器配对。

在序列到序列任务中,解码器 从编码器生成的内部状态开始, 序列。

如需了解解码器位于何处,请参阅 Transformer Transformer 架构。

去噪

一种常见的自我监督式学习方法 其中:

通过去噪功能,可以从无标签样本中学习。 原始数据集用作目标或 label 和 将噪声数据作为输入。

一些遮盖语言模型会使用去噪功能 如下所示:

- 通过遮盖部分句子,人为地向无标签句子添加噪声。 词元。

- 模型会尝试预测原始词元。

直接提示

与零样本提示的含义相同。

E

修改距离

用于衡量两个文本字符串彼此相似度的指标。 在机器学习中,修改距离非常有用, 以及一种有效的方法,用于比较两个已知已知 或用于查找与给定字符串相似的字符串。

修改距离有多种定义,每个定义使用不同的字符串 操作。例如, <ph type="x-smartling-placeholder"></ph> 列文什泰因距离 表示使用最少的删除、插入和替换操作。

例如,字词“heart”之间的列文什泰因距离和“飞镖” 是 3,因为以下 3 次修改是将一个字词转换成的最少更改 复制到另一个对象中:

- 心形 → deart(将“h”替换为“d”)

- deart → dart(删除“e”)

- dart → darts(插入“s”)

嵌入层

一种特殊的隐藏层,用于基于 高维分类特征来 逐渐学习低维度嵌入向量。一个 嵌入层让神经网络能够训练更多 这比只使用高维分类特征进行训练更高效。

例如,Google 地球目前支持约 73,000 种树种。假设

树种是模型中的特征,所以模型的

输入层包含一个独热矢量,即 73000

元素。

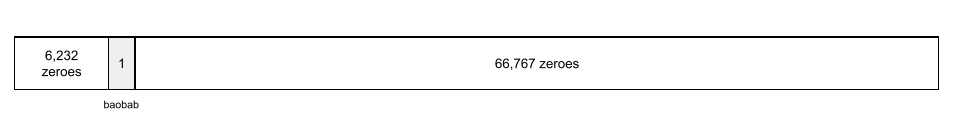

例如,baobab 的表示形式如下:

包含 73,000 个元素的数组非常长。如果没有添加嵌入层 训练将非常耗时, 72,999 个零相乘。也许您会选择嵌入层, 共 12 个维度因此,嵌入层会逐渐学习 每个树种的新嵌入向量。

在某些情况下,哈希处理是一种合理的替代方案 嵌入层。

嵌入空间

d 维向量空间,具有更高维的特征, 矢量空间的映射关系。理想情况下,嵌入空间包含一个 可得出有意义的数学结果的结构;例如 在理想的嵌入空间中, 可以解决文字类比任务。

点积 用于衡量两个嵌入之间的相似度。

嵌入向量

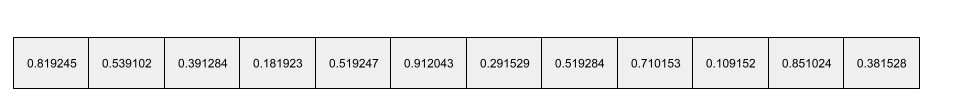

从广义上讲,取自任意变量的浮点数数组 隐藏层,用于描述该隐藏层的输入。 通常,嵌入矢量是 嵌入层。例如,假设嵌入层必须学习 嵌入向量。或许, 以下数组是猴面包树的嵌入向量:

嵌入矢量不是一堆随机数字。嵌入层 通过训练确定这些值,类似于 神经网络在训练过程中学习其他权重。每个 数组是有关树种某个特征的评分。哪个 代表哪种树种的特征?太难了

嵌入向量在数学上值得注意的部分是 项具有类似的浮点数集。例如,类似 与树种相比, 不同的树种。红杉和红杉是相关的树种 因此它们会有一组更相似的浮点数 红杉和椰子树。嵌入矢量中的数字 每次重新训练模型都会更改,即使重新训练模型也是如此 完全相同的输入。

编码器

一般来说,任何从原始、稀疏或外部 处理成经过处理、更密集或更内部的表示形式。

编码器通常是较大模型的一个组成部分, 与解码器配对。一些 Transformer 将编码器与解码器配对,尽管其他 Transformer 仅使用 也可以只训练解码器。

有些系统使用编码器的输出作为分类或 回归网络。

在序列到序列任务中,编码器 接受输入序列并返回内部状态(向量)。然后, 解码器使用该内部状态来预测下一个序列。

如需了解编码器的定义,请参阅 Transformer Transformer 架构。

F

少样本提示

包含多个(“几个”)示例的提示 演示了大语言模型 响应。例如,以下很长的提示包含两个 显示大型语言模型如何回答查询的示例。

| 一个提示的组成部分 | 备注 |

|---|---|

| 指定国家/地区的官方货币是什么? | 您希望 LLM 回答的问题。 |

| 法国:欧元 | 一个例子。 |

| 英国:英镑 | 再举一个例子。 |

| 印度: | 实际查询。 |

与少样本提示相比,少样本提示通常会 零样本提示和 单样本提示。然而,少样本提示 需要更长的提示。

小提琴

Python 优先的 configuration 库,用于设置 函数和类的值,而无需侵入性代码或基础架构。 对于 Pax 和其他机器学习代码库,这些函数和 类别代表模型和训练 超参数。

小提琴 假设机器学习代码库通常分为以下几类:

- 库代码,用于定义层和优化器。

- 数据集“粘合剂”这些代码会调用这些库,并将所有内容连接在一起。

Fiddle 会在未评估和 可变形式。

微调

对 BERT 模型进行第二次特定任务的训练, 预训练模型,用于针对 应用场景。例如,某些完整训练过程的 大语言模型如下所示:

- 预训练:利用庞大的常规数据集训练大语言模型。 例如所有英文版的维基百科网页。

- 微调:训练预训练模型以执行特定任务, 例如回复医疗查询微调通常涉及 成百上千个针对特定任务的示例。

再举一个例子,大型图片模型的完整训练序列是 如下:

- 预训练:使用大型一般图片训练大型图片模型 例如维基共享资源中的所有图像。

- 微调:训练预训练模型以执行特定任务, 例如生成虎鲸的图片。

微调可包含以下策略的任意组合:

- 修改所有预训练模型现有的 parameters。这有时称为“全面微调”。

- 仅修改预训练模型的部分现有参数 (通常是最接近输出层的层), 同时保持其他现有参数不变(通常情况下, 最接近输入层)。请参阅 参数高效微调。

- 添加更多图层,通常在最靠近 输出层。

微调是一种迁移学习形式。 因此,微调可能会使用不同的损失函数或不同的模型, 与用于训练预训练模型的 ID 相比。例如,你可以 微调预训练的大图像模型,以生成回归模型, 返回输入图片中的鸟类数量。

使用以下术语比较和对比微调:

亚麻

高性能开源 库 基于 JAX 构建的深度学习。Flax 提供各种功能 训练 神经网络 作为评估其效果的方法。

Flaxformer

开源 Transformer 库、 基于主要用于自然语言处理的 Flax 构建 和多模态研究。

G

生成式 AI

一个新兴的变革性领域,没有正式定义。 尽管如此,大多数专家也同意,生成式 AI 模型 创建(“生成”)内容:

- 复杂

- 连贯

- 原图

例如,生成式 AI 模型可以构建复杂的 论文或图片。

一些早期的技术,包括 LSTMs 和 RNN 也可以生成原始和 连贯的内容一些专家认为这些早期的技术 而其他人则认为真正的生成式 AI 需要更复杂的

与预测性机器学习相对。

GPT(生成式预训练 Transformer)

一系列基于 Transformer 的 大语言模型, OpenAI。

GPT 变体可适用于多种模态,包括:

- 图片生成(例如 ImageGPT)

- 生成文本到图像(例如, DALL-E)。

H

幻觉

由一个 AI 技术人员生成看似看似 但实际上不正确的输出 生成式 AI 模型, 与现实世界有关的断言。 例如,某个生成式 AI 模型声称贝拉克·奥巴马 (Barack Obama) 于 1865 年去世 具有幻觉性。

I

情境学习

相当于少样本提示。

L

LaMDA(对话应用语言模型)

基于 Transformer 由 Google 开发的大语言模型, 可生成真实对话回复的大型对话数据集。

LaMDA:我们的突破性对话 技术提供了概览。

语言模型

大语言模型

没有严格定义的非正式术语,通常是指 parameters。 某些大型语言模型包含超过 1000 亿个参数。

潜在空间

与嵌入空间的含义相同。

LLM

大语言模型的缩写。

LoRA

低排名自适应的缩写。

低排名自适应 (LoRA)

用于执行优化的算法 参数高效微调 微调中 大语言模型的参数。 LoRA 具有以下优势:

- 相较于需要微调模型的所有 参数。

- 降低模型中推理的计算成本, 经过微调的模型。

使用 LoRA 调优的模型可以维持或提升其预测质量。

LoRA 支持模型的多个专用版本。

M

遮盖语言模型

一个语言模型,用于预测 用于在序列中填空的候选词元。例如, 遮盖语言模型可以计算候选字词的概率 替换以下句子中的下划线:

帽子里的 ____ 回来了。

文献通常使用字符串“MASK”而不是下划线。 例如:

“面具”都归来了

大多数现代的遮盖语言模型都是双向模型。

元学习

机器学习的一部分,用于发现或改进学习算法。 元学习系统也可以用来训练模型,以便快速学习新的 少量数据或之前的任务中积累的经验来调整任务。 元学习算法通常会尝试实现以下目标:

- 改进或学习手动设计的功能(例如初始化程序或 优化器)。

- 提高数据效率和计算效率。

- 改进泛化。

元学习与少样本学习相关。

modality

高级数据类别。例如数字、文字、图片、视频和 有五种不同的模态。

模型并行处理

一种扩缩训练或推理的方法,将一个内容的不同部分 model 在不同的设备上运行。模型并行处理 可以让模型因太大而无法适应单一设备。

为了实现模型并行处理,系统通常会执行以下操作:

- 将模型分片(划分)为更小的部分。

- 将这些较小部分的训练分布到多个处理器。 每个处理器都会训练自己的模型部分。

- 组合结果以创建一个模型。

模型并行处理会减慢训练速度。

另请参阅数据并行处理。

多头自注意力

对自注意力的扩展,应用 输入序列中每个位置的自注意力机制。

Transformer 引入了多头自注意力机制。

多模态模型

其输入和/或输出包含多个的模型 模态。例如,假设一个模型同时接受 图片和文本说明(两种模态)作为特征,以及 会输出一个分数,以指示文本说明与图像的适宜程度。 因此,该模型的输入是多模态,而输出是单模态。

否

自然语言理解

根据用户输入或说出的内容确定用户的意图。 例如,搜索引擎使用自然语言理解来 根据用户输入或说出的内容确定用户正在搜索的内容。

N 元语法

N 个单词的有序序列。例如,“truly madly”属于二元语法。因为 顺序相关,“疯狂”是与“真正疯狂”不同的二元语法。

| 否 | 此类 N 元语法的名称 | 示例 |

|---|---|---|

| 2 | 二元语法 | 去、去、吃午餐、吃晚餐 |

| 3 | 三元语法 | ate too more、three blind mice、the bell tolls |

| 4 | 四元语法 | 公园漫步,风中的尘土,男孩吃扁豆 |

许多自然语言理解 模型依赖 N 元语法来预测用户将输入的下一个字词 或者说。例如,假设用户输入了“three blind”。 基于三元语法的 NLU 模型可能会预测出 接下来,用户将输入 mice。

将 N 元语法与词袋进行比较,词袋是 无序的字词集。

NLU

自然语言的缩写 理解。

O

单样本提示

一个提示,其中包含一个示例,演示了 大语言模型应做出响应。例如: 以下提示包含一个示例,该示例展示了大型语言模型 应该能够回答查询

| 一个提示的组成部分 | 备注 |

|---|---|

| 指定国家/地区的官方货币是什么? | 您希望 LLM 回答的问题。 |

| 法国:欧元 | 一个例子。 |

| 印度: | 实际查询。 |

将单样本提示与以下术语进行比较和对比:

P

参数高效微调

一组用于微调大型广告的技术 预训练语言模型 (PLM) 比完全微调的效率更高。参数高效 “微调”通常对参数进行微调要比完整参数少得多 微调,但通常会生成 大语言模型, 大型语言模型, 微调。

将参数高效调优与以下各项进行比较和对比:

参数高效微调也称为“参数高效微调”。

流水线

模型并行处理的一种形式,即模型的 处理过程分为连续的阶段, 在不同设备上当一个阶段处理一个批次时,上一个阶段会处理一个批次, 可以处理下一批次。

另请参阅分阶段训练。

PLM

预训练语言模型的缩写。

位置编码

一种将有关词元在序列中的位置的信息添加到 词元的嵌入。Transformer 模型使用位置 以便更好地了解数据中不同部分之间的关系, 序列。

位置编码的常见实现是使用正弦函数。 (具体而言,正弦函数的频率和振幅为 取决于词元在序列中的位置。)这种方法 Transformer 模型可以学习处理 序列。

预训练模型

模型或模型组件(例如 嵌入向量)。 有时,您需要将预训练嵌入向量馈送到 神经网络。其他时候,您的模型将训练 嵌入向量本身,而不是依赖于预训练嵌入。

“预训练的语言模型”一词是指 前面介绍的大语言模型 预训练。

预训练 (pre-training)

基于大型数据集进行模型的初始训练。一些预训练模型 都是笨拙的巨人,通常必须通过额外训练加以改善。 例如,机器学习专家可能会 基于大型文本数据集的大语言模型, 例如维基百科中的所有英文页面。在预训练之后, 我们可以通过以下任一方式进一步优化生成的模型 方法:

提示符

作为输入到大语言模型的任何文本 来调节模型以特定方式的行为。提示可短至 短语或任意长度的内容(例如,小说的整段文字)。提示 分为多个类别,包括下表中显示的类别:

| 提示类别 | 示例 | 备注 |

|---|---|---|

| 问题 | 鸽子能飞多快? | |

| 指令 | 写一首有关套利的趣味诗。 | 要求大语言模型执行某项操作的提示。 |

| 示例 | 将 Markdown 代码翻译为 HTML。例如:

Markdown:* 列表项 HTML:<ul><li>列表项</li></ul> |

此示例提示中的第一句话是一条指令。 提示的其余部分就是示例。 |

| 角色 | 解释为什么在机器学习训练中使用梯度下降法 拥有物理学博士学位。 | 句子的第一部分是指令;短语 “获得物理学博士学位”是角色部分 |

| 模型要完成的部分输入 | 英国首相住在 | 部分输入提示可能会出现突然结束的情况(本例就是这样) 或以下划线结尾。 |

生成式 AI 模型可以使用文本来回答提示, 代码、图片、嵌入、视频等几乎任何内容。

提示式学习

某些模型具备适应能力 对任意文本输入的响应行为(提示)。 在基于提示的典型学习范式中, 大语言模型会通过以下方式响应提示: 生成文本。例如,假设用户输入以下提示:

总结牛顿第三运动定律。

能够基于提示进行学习的模型并未经过专门训练, 上一个提示。相反,模型“知道”我们可以看到很多关于物理学的知识 一般语言规则,以及一般语言规则的构成要素, 有用的答案。这些知识足以提供(有希望)实用的帮助 回答。其他人工反馈(“那个答案太复杂了。”或 “什么是反应?”)可让一些基于提示的学习系统逐渐 提高答案的实用性。

提示设计

与提示工程的含义相同。

提示工程

创建可触发所需回答的提示的技巧 构建自大语言模型。人工执行提示 工程。撰写结构合理的提示是确保 生成有用的响应。提示工程依赖于 许多因素,包括:

- 用于预训练的数据集,可能 微调大语言模型。

- temperature(温度)和其他解码参数 来生成回答。

请参阅 提示设计简介 详细了解如何撰写实用提示。

提示设计是提示工程的同义词。

提示调优

提示调优(有时称为前缀调优)的一种变体是 请在每一层前添加该前缀。相比之下,大多数提示调优都只 向输入层添加前缀。

R

角色提示

提示的可选部分,用于标识目标对象群组 生成式 AI 模型的回答。没有角色 大型语言模型提供的答案不一定有用, 。使用角色提示、大型语言模型 模型能够以更合适、更有用的方式 特定目标受众群体。例如,下面的“角色提示”部分 以粗体显示的提示:

- 总结一下获得经济学博士学位这篇文章。

- 描述潮汐如何适用于 10 岁儿童。

- 解释 2008 年金融危机。像对待年幼的孩子一样, 或金毛寻回犬。

S

自注意力层(也称为自注意力层)

一个神经网络层, 嵌入(例如词元嵌入) 转换为另一个嵌入序列。输出序列中的每个嵌入都是 通过从输入序列元素中集成信息来构造 通过注意力机制实现。

自注意力的 self 部分是指参与 而不是指向其他上下文。自注意力是 转换器构建块,并使用字典查询功能 查询字词,例如“查询”“键”和“值”。

自注意力层始于一系列输入表示, 。单词的输入表示可以是简单的 嵌入。对于输入序列中的每个字词,网络 为字词与整个序列中每个元素的相关性评分, 字词。相关性得分决定了该单词的最终表示形式 会合并其他字词的表示形式。

例如,请思考以下句子:

动物没有过马路,因为它太累了。

下图(摘自 Transformer:一种新的语言神经网络架构 了解) 显示了代词 it 的自注意力层的注意力模式,其中 每一行的黑暗程度都表示每个字词对 表示法:

自注意力层会突出显示与“it”相关的字词。在本课中, 注意力层已经学会突出显示 为动物指定最高权重。

对于一系列n 词元,自注意力机制可将一个序列转换为 嵌入的 n 个单独时间,在序列中的每个位置一次。

情感分析

使用统计或机器学习算法确定组的 对于某个服务、产品、服务、 组织或主题例如,使用 自然语言理解, 一种算法可以对文本反馈进行情感分析, 以确定学生可以获得哪些学位 喜欢或不喜欢这门课程。

序列到序列任务

将令牌的输入序列转换为输出的任务 词元序列。例如,两种常见的序列到序列 任务:

- 译者:

<ph type="x-smartling-placeholder">

- </ph>

- 输入序列示例:“I love you。”

- 示例输出序列:“Je t'aime”。

- 问答:

<ph type="x-smartling-placeholder">

- </ph>

- 示例输入序列:“Do I need my car in New York City?”(在纽约市需要我的车吗?)

- 示例输出序列:“No.请把车放在家里。”

skip-gram

可能会省略(或“跳过”)原始字词的 n 元语法 上下文,这意味着 N 个字词最初可能并不相邻。更多 “k-skip-n-gram”是一个 N 元语法,其中最多有 k 个字词 已跳过。

例如:"the quick brown fox"可能的两元语法:

- “快节奏”

- "快速棕色"

- “棕色的狐狸”

“1-skip-2-gram”是指之间最多包含 1 个字词的一对字词。 因此,“The quick brown fox”具有以下 1-skip 2-gram:

- “棕色的”

- “quick fox”

此外,所有 2-gram 也都是 1-skip-2-gram,因为较少 可能会跳过一个字词。

跳过语法对于理解字词上下文的更多上下文非常有用。 在此示例中,即“fox”与“快速”在 1-skip-2-gram,但不在 2-gram 集合中。

Skip-gram 帮助训练 词嵌入模型。

软提示调优

对大语言模型进行调参的方法 用于特定任务,而无需占用大量资源 微调。您不必重新训练 模型中的权重、软提示调优 自动调整提示,以实现相同的目标。

给定文本提示、软提示调优 通常会将额外的词元嵌入附加到提示,并使用 以优化输入。

“困难”提示包含实际词元,而不是词元嵌入。

稀疏特征

一种特征,其值主要为零或为空。 例如,包含单个 1 值和一百万个 0 值的特征 即 Sparse。相比之下,密集特征则具有 则不为零或为空。

在机器学习中,数量惊人的特征是稀疏特征。 分类特征通常是稀疏特征。 例如,某森林内有 300 种可能的树种, 可能只是“枫树”。或者,在数以百万计的 视频库中可能存在的视频,那么可能只用一个示例 只有“Casablanca”

在模型中,您通常使用 独热编码。如果独热编码很大, 就可以将嵌入层 进行独热编码,以提高效率。

稀疏表示法

仅存储稀疏特征中非零元素的位置。

例如,假设名为 species 的分类特征标识了 36

特定森林中的树木品种。进一步假设每个

example 仅标识一个物种。

您可以使用独热矢量来表示每个样本中的树种。

独热矢量将包含一个 1(用来表示

以及 35 个 0(表示

有 35 个树种,因此,独热表示法

的 maple 可能如下所示:

或者,稀疏表示法则直接确定

特定物种。如果 maple 位于位置 24,则使用稀疏表示法

的 maple 可能只是:

24

请注意,稀疏表示法比独热表示法更紧凑 表示。

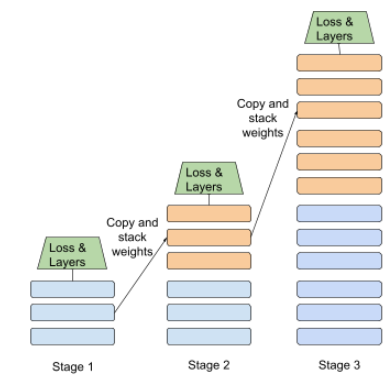

分阶段训练

一种以一系列离散阶段训练模型的策略。目标可以是 以加快训练过程或获得更好的模型质量。

下图展示了渐进式堆叠方法:

- 阶段 1 包含 3 个隐藏层,阶段 2 包含 6 个隐藏层, 第 3 阶段包含 12 个隐藏层。

- 第 2 阶段开始使用 3 个隐藏层中学到的权重进行训练 第 1 阶段的设置。第 3 阶段开始使用第 6 层中学到的权重 隐藏层。

另请参阅流水线。

子词词元

例如,输入“itemize”可能会分成多个“项” (根词)和“ize”(一个后缀),其中每个后缀都由其自己的 令牌。将不常见的字词拆分为这样的片段(称为子字词) 来对单词的更常见组成部分进行操作, 例如前缀和后缀

与“参加”等常用词语相反可能不会被分解 由单个词元表示。

T

T5

文本到文本迁移学习 模型 引入 2020 年的 Google AI。 T5 是一个编码器-解码器模型, Transformer 架构,基于超大型模型 数据集。它可有效处理各种自然语言处理任务, 例如生成文本、翻译语言、回答 对话形式。

T5 得名于“文本到文本传输转换器”中的五个 T。

T5X

一个设计出来的开源机器学习框架 构建和训练大规模自然语言处理模型, (NLP) 模型。T5 在 T5X 代码库(即 基于 JAX 和 Flax 构建)。

温度

用于控制随机性程度的超参数 模型输出。温度越高,输出的随机性越强, 而较低的温度产生的随机输出较少。

选择最佳温度取决于具体应用和 模型输出的首选属性。例如,您应 可能会在创建应用 生成广告素材输出相反,您可能会降低温度 并构建用于对图片或文本进行分类的模型,以改进 模型的准确性和一致性。

温度通常与 softmax 一起使用。

文本跨度

与文本字符串的特定子部分关联的数组索引 span。

例如,Python 字符串 s="Be good now" 中的单词 good 占据

文本范围为 3 到 6。

token

在语言模型中,模型采用的原子单位 基于这些特征进行训练并进行预测。令牌通常是 以下:

- 字词,例如短语“狗像猫”包含三个单词 “dogs”、“like”和“cats”。

- 字符,例如短语“自行车鱼”包含 9 个 字符标记。(请注意,空格也算作其中一个标记。)

- 子词 - 其中单个词可以是单个词法单元,也可以是多个词法单元。 子词由根词、前缀或后缀组成。例如: 使用子词作为词元的语言模型可能会看到“dogs” 作为两个词元(根词“dog”和复数后缀“s”)表示。同样的 因此,语言模型可能会看到单个单词“taller”作为两个子词(即 根词“高”和后缀“er”)。

在语言模型以外的领域,令牌可以表示其他类型的 原子单元。例如,在计算机视觉中,一个词元可能是 图像。

Transformer

由 Google 开发的神经网络架构, 依靠自注意力机制来将 将输入嵌入序列转换为 而无需依赖卷积或 循环神经网络。Transformer 可以 自注意力层堆栈。

Transformer 可以包含以下任何内容:

编码器将一系列嵌入转换为 相同长度的编码器包括 N 个相同的层,每个层包含两个 子层。这两个子层在输入层的每个位置应用, 嵌入序列,将序列的每个元素转换为新的 嵌入。第一个编码器子层汇总来自 输入序列。第二个编码器子层将聚合的 输出嵌入。

解码器将一系列输入嵌入转换为 输出嵌入,可能长度不同。解码器还包括 N 个相同的层,包含三个子层,其中两个子层类似于 编码器子层。第三个解码器子层将 并将自注意力机制应用于 并从中收集信息

博文 Transformer:一种新的语言神经网络架构 了解 对 Transformer 进行了很好的介绍。

三元语法

一种 N 元语法,其中 N=3。

U

单向

系统只评估文本的目标部分之前的文本。 相反,双向系统会同时评估 在文本目标部分之前和之后的文本。 如需了解详情,请参阅双向。

单向语言模型

一种语言模型,该模型仅根据 令牌出现在目标令牌之前,而不是之后。 与双向语言模型相对。

V

变分自编码器 (VAE)

一种利用差异的自动编码器 以生成输入的修改版本。 变分自动编码器对于生成式 AI 非常有用。

VAE 基于变分推断,这是一种 参数。

W

字词嵌入

表示 embedding 向量;也就是说,将每个字词表示为 介于 0.0 和 1.0 之间的浮点值的向量。包含类似字词的字词 与具有不同含义的字词相比,“词汇”具有更相似的表征。 例如,“carrots”“celery”和“cucumbers” 这种表示方式, 包括飞机、太阳镜和牙膏。

Z

零样本提示

| 一个提示的组成部分 | 备注 |

|---|---|

| 指定国家/地区的官方货币是什么? | 您希望 LLM 回答的问题。 |

| 印度: | 实际查询。 |

大语言模型可能会返回以下任一项作为响应:

- 卢比符号

- INR

- ₹

- 印度卢比

- 卢比

- 印度卢比

所有答案都正确,但您可能更喜欢某种特定格式。

将零样本提示与以下术语进行比较和对比: