এই পৃষ্ঠায় মেট্রিক্স শব্দকোষের শব্দাবলী রয়েছে। সমস্ত শব্দকোষের শব্দাবলীর জন্য, এখানে ক্লিক করুন ।

ক

নির্ভুলতা

সঠিক শ্রেণীবিভাগের পূর্বাভাসের সংখ্যাকে মোট পূর্বাভাসের সংখ্যা দিয়ে ভাগ করলে। অর্থাৎ:

উদাহরণস্বরূপ, একটি মডেল যা ৪০টি সঠিক ভবিষ্যদ্বাণী এবং ১০টি ভুল ভবিষ্যদ্বাণী করেছে তার নির্ভুলতা হবে:

বাইনারি শ্রেণীবিভাগ সঠিক ভবিষ্যদ্বাণী এবং ভুল ভবিষ্যদ্বাণীর বিভিন্ন শ্রেণীর জন্য নির্দিষ্ট নাম প্রদান করে। সুতরাং, বাইনারি শ্রেণীবিভাগের নির্ভুলতা সূত্রটি নিম্নরূপ:

কোথায়:

- TP হলো প্রকৃত ধনাত্মক সংখ্যা (সঠিক ভবিষ্যদ্বাণী)।

- TN হলো সত্য ঋণাত্মক সংখ্যা (সঠিক ভবিষ্যদ্বাণী)।

- FP হলো মিথ্যা ধনাত্মক (ভুল ভবিষ্যদ্বাণী) সংখ্যা।

- FN হলো মিথ্যা নেতিবাচক (ভুল ভবিষ্যদ্বাণী) সংখ্যা।

নির্ভুলতা এবং প্রত্যাহারের সাথে তুলনা করুন এবং বৈসাদৃশ্য করুন।

আরও তথ্যের জন্য মেশিন লার্নিং ক্র্যাশ কোর্সে শ্রেণীবিভাগ: নির্ভুলতা, প্রত্যাহার, নির্ভুলতা এবং সম্পর্কিত মেট্রিক্স দেখুন।

পিআর বক্ররেখার অধীনে ক্ষেত্রফল

PR AUC (PR বক্ররেখার অধীনে এলাকা) দেখুন।

ROC বক্ররেখার অধীনে ক্ষেত্রফল

AUC (ROC বক্ররেখার অধীনে এলাকা) দেখুন।

AUC (ROC বক্ররেখার অধীনে এলাকা)

০.০ এবং ১.০ এর মধ্যে একটি সংখ্যা যা একটি বাইনারি শ্রেণীবিভাগ মডেলের ধনাত্মক শ্রেণী থেকে ঋণাত্মক শ্রেণী আলাদা করার ক্ষমতাকে প্রতিনিধিত্ব করে। AUC 1.0 এর যত কাছাকাছি হবে, মডেলের একে অপরের থেকে শ্রেণী আলাদা করার ক্ষমতা তত ভালো হবে।

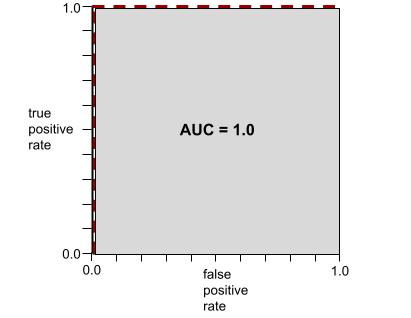

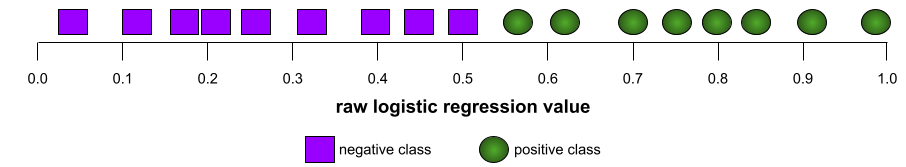

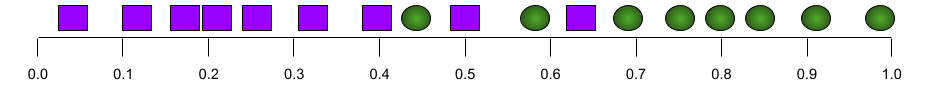

উদাহরণস্বরূপ, নিম্নলিখিত চিত্রটিতে একটি শ্রেণিবিন্যাস মডেল দেখানো হয়েছে যা ধনাত্মক শ্রেণি (সবুজ ডিম্বাকৃতি) এবং ঋণাত্মক শ্রেণি (বেগুনি আয়তক্ষেত্র) কে নিখুঁতভাবে পৃথক করে। এই অবাস্তবভাবে নিখুঁত মডেলটির AUC 1.0:

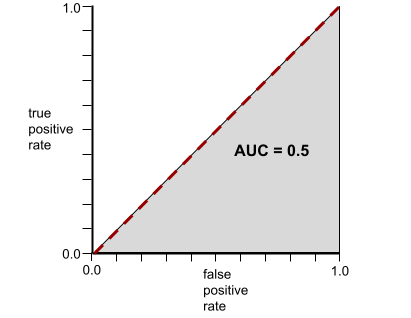

বিপরীতভাবে, নিম্নলিখিত চিত্রটি একটি শ্রেণিবিন্যাস মডেলের ফলাফল দেখায় যা এলোমেলো ফলাফল তৈরি করে। এই মডেলের AUC 0.5:

হ্যাঁ, পূর্ববর্তী মডেলটির AUC 0.0 নয়, 0.5।

বেশিরভাগ মডেল দুটি চরমের মাঝামাঝি কোথাও থাকে। উদাহরণস্বরূপ, নিম্নলিখিত মডেলটি ইতিবাচক এবং নেতিবাচককে কিছুটা আলাদা করে, এবং তাই এর AUC 0.5 এবং 1.0 এর মধ্যে কোথাও রয়েছে:

AUC আপনার দ্বারা শ্রেণীবিভাগের সীমা নির্ধারণ করা যেকোনো মান উপেক্ষা করে। পরিবর্তে, AUC সমস্ত সম্ভাব্য শ্রেণীবিভাগের সীমা বিবেচনা করে।

আরও তথ্যের জন্য শ্রেণীবিভাগ: মেশিন লার্নিং ক্র্যাশ কোর্সে ROC এবং AUC দেখুন।

k এ গড় নির্ভুলতা

একটি একক প্রম্পটে মডেলের কর্মক্ষমতা সারসংক্ষেপ করার জন্য একটি মেট্রিক যা র্যাঙ্ক করা ফলাফল তৈরি করে, যেমন বইয়ের সুপারিশের একটি সংখ্যাযুক্ত তালিকা। k- তে গড় নির্ভুলতা হল, প্রতিটি প্রাসঙ্গিক ফলাফলের জন্য k মানের নির্ভুলতার গড়। অতএব k- তে গড় নির্ভুলতার সূত্র হল:

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

কোথায়:

- \(n\) হল তালিকার প্রাসঙ্গিক আইটেমের সংখ্যা।

k তে প্রত্যাহারের সাথে তুলনা করুন।

খ

বেসলাইন

অন্য মডেল (সাধারণত, আরও জটিল একটি) কতটা ভালো পারফর্ম করছে তা তুলনা করার জন্য একটি মডেলকে রেফারেন্স পয়েন্ট হিসেবে ব্যবহার করা হয়। উদাহরণস্বরূপ, একটি লজিস্টিক রিগ্রেশন মডেল একটি গভীর মডেলের জন্য একটি ভালো বেসলাইন হিসেবে কাজ করতে পারে।

একটি নির্দিষ্ট সমস্যার জন্য, বেসলাইন মডেল ডেভেলপারদের ন্যূনতম প্রত্যাশিত কর্মক্ষমতা পরিমাপ করতে সাহায্য করে যা একটি নতুন মডেলকে নতুন মডেলটি কার্যকর করার জন্য অর্জন করতে হবে।

বুলিয়ান প্রশ্ন (BoolQ)

হ্যাঁ-না-না প্রশ্নের উত্তর দেওয়ার ক্ষেত্রে একজন এলএলএম-এর দক্ষতা মূল্যায়নের জন্য একটি ডেটাসেট। ডেটাসেটের প্রতিটি চ্যালেঞ্জের তিনটি উপাদান রয়েছে:

- একটি প্রশ্ন

- প্রশ্নের উত্তর বোঝানো একটি অনুচ্ছেদ।

- সঠিক উত্তর, যা হয় হ্যাঁ অথবা না ।

উদাহরণস্বরূপ:

- প্রশ্ন : মিশিগানে কি কোন পারমাণবিক বিদ্যুৎ কেন্দ্র আছে?

- উত্তরণ : ...তিনটি পারমাণবিক বিদ্যুৎ কেন্দ্র মিশিগানকে তার প্রায় ৩০% বিদ্যুৎ সরবরাহ করে।

- সঠিক উত্তর : হ্যাঁ

গবেষকরা বেনামী, সমষ্টিগত গুগল অনুসন্ধান কোয়েরি থেকে প্রশ্নগুলি সংগ্রহ করেছেন এবং তারপরে তথ্য ভিত্তি করার জন্য উইকিপিডিয়া পৃষ্ঠাগুলি ব্যবহার করেছেন।

আরও তথ্যের জন্য, BoolQ: প্রাকৃতিক হ্যাঁ/না প্রশ্নের আশ্চর্যজনক অসুবিধা অন্বেষণ দেখুন।

BoolQ হল SuperGLUE এনসেম্বলের একটি উপাদান।

BoolQ সম্পর্কে

বুলিয়ান প্রশ্নের সংক্ষিপ্ত রূপ।

গ

সিবি

কমিটমেন্টব্যাংকের সংক্ষিপ্ত রূপ।

অক্ষর N-গ্রাম F-স্কোর (ChrF)

মেশিন অনুবাদ মডেল মূল্যায়নের জন্য একটি মেট্রিক। অক্ষর N-গ্রাম F-স্কোর নির্ধারণ করে যে রেফারেন্স টেক্সটে N-গ্রামগুলি একটি ML মডেলের তৈরি টেক্সটে N-গ্রামগুলিকে কতটা ওভারল্যাপ করে।

অক্ষর N-গ্রাম F-স্কোর ROUGE এবং BLEU পরিবারের মেট্রিক্সের অনুরূপ, তবে:

- অক্ষর N-গ্রাম F-স্কোর অক্ষর N-গ্রামের উপর কাজ করে।

- ROUGE এবং BLEU শব্দ N-গ্রাম বা টোকেন ব্যবহার করে কাজ করে।

সম্ভাব্য বিকল্পের পছন্দ (COPA)

একটি ডেটাসেট যা মূল্যায়ন করে যে একজন এলএলএম একটি প্রিমাইজের দুটি বিকল্প উত্তরের মধ্যে সেরাটি কতটা ভালোভাবে সনাক্ত করতে পারে। ডেটাসেটের প্রতিটি চ্যালেঞ্জ তিনটি উপাদান নিয়ে গঠিত:

- একটি ভিত্তি, যা সাধারণত একটি বিবৃতি এবং তারপরে একটি প্রশ্ন থাকে

- মূলনীতিতে উত্থাপিত প্রশ্নের দুটি সম্ভাব্য উত্তর, যার একটি সঠিক এবং অন্যটি ভুল

- সঠিক উত্তর

উদাহরণস্বরূপ:

- স্থান: লোকটির পায়ের আঙুল ভেঙে গেছে। এর কারণ কী ছিল?

- সম্ভাব্য উত্তর:

- তার মোজায় একটা ছিদ্র হয়ে গেছে।

- সে তার পায়ে হাতুড়ি মারল।

- সঠিক উত্তর: ২

COPA হল SuperGLUE সমষ্টির একটি উপাদান।

কমিটমেন্টব্যাংক (সিবি)

একটি ডেটাসেট যা একজন LLM-এর দক্ষতা মূল্যায়ন করে এবং নির্ধারণ করে যে কোনও প্যাসেজের লেখক সেই প্যাসেজের মধ্যে একটি লক্ষ্য ধারা বিশ্বাস করেন কিনা। ডেটাসেটের প্রতিটি এন্ট্রিতে রয়েছে:

- একটি উত্তরণ

- ঐ অনুচ্ছেদের মধ্যে একটি লক্ষ্য ধারা

- একটি বুলিয়ান মান যা নির্দেশ করে যে প্যাসেজের লেখক লক্ষ্য ধারাটি বিশ্বাস করেন কিনা

উদাহরণস্বরূপ:

- উত্তর: আর্টেমিসের হাসি শুনতে কত মজা। সে এত গম্ভীর একটা বাচ্চা। আমি জানতাম না যে তার রসবোধ আছে।

- লক্ষ্য ধারা: তার রসবোধ ছিল

- বুলিয়ান : সত্য, যার অর্থ লেখক লক্ষ্য ধারাটি বিশ্বাস করেন

কমিটমেন্টব্যাংক হল সুপারগ্লু এনসেম্বলের একটি উপাদান।

কোপা

"প্রকৃত বিকল্প নির্বাচন" এর সংক্ষিপ্ত রূপ।

খরচ

ক্ষতির সমার্থক শব্দ।

প্রতি-তথ্যমূলক ন্যায্যতা

একটি ন্যায্যতা মেট্রিক যা পরীক্ষা করে যে একটি শ্রেণীবদ্ধকরণ মডেল একজন ব্যক্তির জন্য একই ফলাফল দেয় কিনা যা অন্য ব্যক্তির জন্য প্রথমটির সাথে অভিন্ন, এক বা একাধিক সংবেদনশীল বৈশিষ্ট্য ব্যতীত। প্রতি-তত্ত্বীয় ন্যায্যতার জন্য একটি শ্রেণীবদ্ধকরণ মডেল মূল্যায়ন করা একটি মডেলে পক্ষপাতের সম্ভাব্য উৎসগুলি প্রকাশ করার একটি পদ্ধতি।

আরও তথ্যের জন্য নিম্নলিখিত যেকোনো একটি দেখুন:

- ন্যায্যতা: মেশিন লার্নিং ক্র্যাশ কোর্সে কাউন্টারফ্যাক্টুয়াল ন্যায্যতা ।

- যখন পৃথিবী সংঘর্ষে লিপ্ত হয়: ন্যায্যতার মধ্যে বিভিন্ন প্রতি-তথ্যমূলক অনুমানকে একীভূত করা

ক্রস-এনট্রপি

বহু-শ্রেণীর শ্রেণীবিভাগ সমস্যায় লগ লস -এর একটি সাধারণীকরণ। ক্রস-এনট্রপি দুটি সম্ভাব্যতা বন্টনের মধ্যে পার্থক্য পরিমাপ করে। আরও দেখুন বিভ্রান্তি ।

ক্রমবর্ধমান বিতরণ ফাংশন (CDF)

একটি ফাংশন যা লক্ষ্য মানের চেয়ে কম বা সমান নমুনার ফ্রিকোয়েন্সি নির্ধারণ করে। উদাহরণস্বরূপ, অবিচ্ছিন্ন মানের একটি স্বাভাবিক বন্টন বিবেচনা করুন। একটি CDF আপনাকে বলে যে প্রায় 50% নমুনা গড়ের চেয়ে কম বা সমান হওয়া উচিত এবং প্রায় 84% নমুনা গড়ের উপরে একটি আদর্শ বিচ্যুতির চেয়ে কম বা সমান হওয়া উচিত।

দ

জনসংখ্যার সমতা

একটি ন্যায্যতা মেট্রিক যা একটি মডেলের শ্রেণীবিভাগের ফলাফল যদি একটি প্রদত্ত সংবেদনশীল বৈশিষ্ট্যের উপর নির্ভরশীল না হয় তবে সন্তুষ্ট হয়।

উদাহরণস্বরূপ, যদি লিলিপুটিয়ান এবং ব্রোবডিংনাগিয়ান উভয়ই গ্লুবডুবড্রিব বিশ্ববিদ্যালয়ে আবেদন করে, তাহলে জনসংখ্যার সমতা অর্জিত হবে যদি লিলিপুটিয়ানদের ভর্তির শতাংশ এবং ব্রোবডিংনাগিয়ানদের ভর্তির শতাংশ একই হয়, তা নির্বিশেষে, একটি গ্রুপ অন্যটির তুলনায় গড়ে বেশি যোগ্য কিনা।

সমতুল্য প্রতিকূলতা এবং সুযোগের সমতার সাথে তুলনা করুন, যা সংবেদনশীল বৈশিষ্ট্যের উপর নির্ভর করে সমষ্টিগত শ্রেণীবিভাগের ফলাফলকে অনুমতি দেয়, কিন্তু নির্দিষ্ট নির্দিষ্ট গ্রাউন্ড ট্রুথ লেবেলের জন্য সংবেদনশীল বৈশিষ্ট্যের উপর নির্ভর করে শ্রেণীবিভাগের ফলাফলকে অনুমতি দেয় না। জনসংখ্যাতাত্ত্বিক সমতার জন্য অপ্টিমাইজ করার সময় ট্রেডঅফগুলি অন্বেষণ করার জন্য একটি ভিজ্যুয়ালাইজেশনের জন্য "স্মার্ট মেশিন লার্নিং দিয়ে বৈষম্য আক্রমণ" দেখুন।

আরও তথ্যের জন্য মেশিন লার্নিং ক্র্যাশ কোর্সে ফেয়ারনেস: ডেমোগ্রাফিক প্যারিটি দেখুন।

ই

পৃথিবী চালকের দূরত্ব (EMD)

দুটি বণ্টনের আপেক্ষিক মিলের পরিমাপ। পৃথিবী চালকের দূরত্ব যত কম হবে, বণ্টনের মিল তত বেশি হবে।

দূরত্ব সম্পাদনা করুন

দুটি টেক্সট স্ট্রিং একে অপরের সাথে কতটা মিল তার পরিমাপ। মেশিন লার্নিংয়ে, সম্পাদনা দূরত্ব নিম্নলিখিত কারণে কার্যকর:

- সম্পাদনা দূরত্ব গণনা করা সহজ।

- দূরত্ব সম্পাদনা করলে দুটি স্ট্রিং তুলনা করা যাবে যা একে অপরের সাথে সাদৃশ্যপূর্ণ বলে পরিচিত।

- দূরত্ব সম্পাদনা করলে বিভিন্ন স্ট্রিং একটি নির্দিষ্ট স্ট্রিংয়ের সাথে কতটা মিল তা নির্ধারণ করা যায়।

সম্পাদনা দূরত্বের বেশ কয়েকটি সংজ্ঞা বিদ্যমান, প্রতিটিতে আলাদা স্ট্রিং অপারেশন ব্যবহার করা হয়। উদাহরণের জন্য লেভেনস্টাইন দূরত্ব দেখুন।

অভিজ্ঞতামূলক ক্রমবর্ধমান বন্টন ফাংশন (eCDF বা EDF)

একটি বাস্তব ডেটাসেট থেকে অভিজ্ঞতালব্ধ পরিমাপের উপর ভিত্তি করে একটি ক্রমবর্ধমান বন্টন ফাংশন । x-অক্ষ বরাবর যেকোনো বিন্দুতে ফাংশনের মান হল ডেটাসেটে পর্যবেক্ষণের ভগ্নাংশ যা নির্দিষ্ট মানের চেয়ে কম বা সমান।

এনট্রপি

তথ্য তত্ত্বে , সম্ভাব্যতা বন্টন কতটা অপ্রত্যাশিত তার বর্ণনা। বিকল্পভাবে, এনট্রপিকে প্রতিটি উদাহরণে কত তথ্য রয়েছে তা হিসাবেও সংজ্ঞায়িত করা হয়। একটি বন্টনের সর্বোচ্চ সম্ভাব্য এনট্রপি থাকে যখন একটি এলোমেলো চলকের সমস্ত মান সমানভাবে সম্ভাব্য হয়।

দুটি সম্ভাব্য মান "0" এবং "1" (উদাহরণস্বরূপ, একটি বাইনারি শ্রেণীবিভাগ সমস্যার লেবেল) সহ একটি সেটের এনট্রপির নিম্নলিখিত সূত্র রয়েছে:

H = -p লগ p - q লগ q = -p লগ p - (1-p) * লগ (1-p)

কোথায়:

- H হলো এনট্রপি।

- p হল "1" উদাহরণের ভগ্নাংশ।

- q হল "0" উদাহরণের ভগ্নাংশ। লক্ষ্য করুন যে q = (1 - p)

- log সাধারণত log 2 হয়। এই ক্ষেত্রে, এনট্রপি ইউনিটটি একটি বিট।

উদাহরণস্বরূপ, ধরুন নিম্নলিখিতগুলি:

- ১০০টি উদাহরণে "১" মান রয়েছে

- ৩০০টি উদাহরণে "০" মান রয়েছে

অতএব, এনট্রপির মান হল:

- পি = ০.২৫

- q = ০.৭৫

- H = (-0.25)log 2 (0.25) - (0.75)log 2 (0.75) = প্রতি উদাহরণে 0.81 বিট

একটি সেট যা পুরোপুরি ভারসাম্যপূর্ণ (উদাহরণস্বরূপ, ২০০ "০" এবং ২০০ "১") তার প্রতিটি উদাহরণের জন্য ১.০ বিটের এনট্রপি থাকবে। একটি সেট যত বেশি ভারসাম্যহীন হবে, তার এনট্রপি ০.০ এর দিকে চলে যাবে।

ডিসিশন ট্রিতে , এনট্রপি তথ্য লাভ গঠনে সাহায্য করে যাতে স্প্লিটার একটি ক্লাসিফিকেশন ডিসিশন ট্রির বৃদ্ধির সময় শর্ত নির্বাচন করতে পারে।

এনট্রপির তুলনা করুন:

- গিনি অপবিত্রতা

- ক্রস-এনট্রপি লস ফাংশন

এনট্রপিকে প্রায়শই শ্যাননের এনট্রপি বলা হয়।

আরও তথ্যের জন্য ডিসিশন ফরেস্ট কোর্সে সংখ্যাসূচক বৈশিষ্ট্য সহ বাইনারি শ্রেণীবিভাগের জন্য সঠিক স্প্লিটার দেখুন।

সুযোগের সমতা

একটি সংবেদনশীল বৈশিষ্ট্যের সমস্ত মানের জন্য একটি মডেল সমানভাবে ভালভাবে কাঙ্ক্ষিত ফলাফলের পূর্বাভাস দিচ্ছে কিনা তা মূল্যায়ন করার জন্য একটি ন্যায্যতা মেট্রিক । অন্য কথায়, যদি একটি মডেলের জন্য কাঙ্ক্ষিত ফলাফল ধনাত্মক শ্রেণী হয়, তাহলে লক্ষ্য হবে সকল গোষ্ঠীর জন্য প্রকৃত ধনাত্মক হার একই হওয়া।

সুযোগের সমতা সমান প্রতিকূলতার সাথে সম্পর্কিত, যার জন্য সকল গোষ্ঠীর জন্য সত্য ধনাত্মক হার এবং মিথ্যা ধনাত্মক হার উভয়ই একই হওয়া প্রয়োজন।

ধরুন, গ্লুবডুবড্রিব বিশ্ববিদ্যালয় লিলিপুটিয়ান এবং ব্রোবডিংনাগিয়ান উভয়কেই একটি কঠোর গণিত প্রোগ্রামে ভর্তি করে। লিলিপুটিয়ানদের মাধ্যমিক বিদ্যালয়গুলি গণিত ক্লাসের একটি শক্তিশালী পাঠ্যক্রম অফার করে এবং বেশিরভাগ শিক্ষার্থী বিশ্ববিদ্যালয় প্রোগ্রামের জন্য যোগ্য। ব্রোবডিংনাগিয়ানদের মাধ্যমিক বিদ্যালয়গুলি মোটেও গণিত ক্লাস অফার করে না, এবং ফলস্বরূপ, তাদের ছাত্রদের মধ্যে অনেক কম সংখ্যকই যোগ্য। জাতীয়তার (লিলিপুটিয়ান বা ব্রোবডিংনাগিয়ান) ক্ষেত্রে "ভর্তি" এর পছন্দের লেবেলের জন্য সুযোগের সমতা পূরণ করা হয় যদি যোগ্য শিক্ষার্থীরা লিলিপুটিয়ান বা ব্রোবডিংনাগিয়ান যাই হোক না কেন, ভর্তি হওয়ার সম্ভাবনা সমানভাবে থাকে।

উদাহরণস্বরূপ, ধরুন ১০০ জন লিলিপুটিয়ান এবং ১০০ জন ব্রোবডিংনাগিয়ান গ্লুবডুবড্রিব বিশ্ববিদ্যালয়ে আবেদন করেন এবং ভর্তির সিদ্ধান্ত নিম্নরূপ নেওয়া হয়:

সারণী ১. লিলিপুটিয়ান আবেদনকারী (৯০% যোগ্য)

| যোগ্য | অযোগ্য | |

|---|---|---|

| ভর্তি | ৪৫ | ৩ |

| প্রত্যাখ্যাত | ৪৫ | ৭ |

| মোট | ৯০ | ১০ |

| ভর্তিকৃত যোগ্য শিক্ষার্থীর শতাংশ: ৪৫/৯০ = ৫০% অযোগ্য শিক্ষার্থী প্রত্যাখ্যাত হওয়ার শতাংশ: ৭/১০ = ৭০% লিলিপুটিয়ান ভর্তিচ্ছু শিক্ষার্থীদের মোট শতাংশ: (৪৫+৩)/১০০ = ৪৮% | ||

সারণী ২। ব্রোবডিংনাগিয়ান আবেদনকারী (১০% যোগ্য):

| যোগ্য | অযোগ্য | |

|---|---|---|

| ভর্তি | ৫ | ৯ |

| প্রত্যাখ্যাত | ৫ | ৮১ |

| মোট | ১০ | ৯০ |

| ভর্তিকৃত যোগ্য শিক্ষার্থীদের শতাংশ: ৫/১০ = ৫০% অযোগ্য শিক্ষার্থী প্রত্যাখ্যাত হওয়ার শতাংশ: ৮১/৯০ = ৯০% ভর্তি হওয়া ব্রোবডিংনাগিয়ান শিক্ষার্থীদের মোট শতাংশ: (৫+৯)/১০০ = ১৪% | ||

পূর্ববর্তী উদাহরণগুলি যোগ্য শিক্ষার্থীদের গ্রহণের সুযোগের সমতা পূরণ করে কারণ যোগ্য লিলিপুটিয়ান এবং ব্রোবডিংনাগিয়ান উভয়েরই ভর্তির সম্ভাবনা ৫০%।

সুযোগের সমতা সন্তুষ্ট হলেও, নিম্নলিখিত দুটি ন্যায্যতা মেট্রিক্স সন্তুষ্ট নয়:

- জনসংখ্যার সমতা : লিলিপুটিয়ান এবং ব্রোবডিংনাগিয়ানদের বিশ্ববিদ্যালয়ে ভর্তির হার ভিন্ন; লিলিপুটিয়ানদের ৪৮% শিক্ষার্থী ভর্তি হয়, কিন্তু ব্রোবডিংনাগিয়ানদের মাত্র ১৪% শিক্ষার্থী ভর্তি হয়।

- সমান সম্ভাবনা : যদিও যোগ্য লিলিপুটিয়ান এবং ব্রোবডিংনাগিয়ান উভয় শিক্ষার্থীর ভর্তির সম্ভাবনা সমান, তবুও অতিরিক্ত সীমাবদ্ধতা যে অযোগ্য লিলিপুটিয়ান এবং ব্রোবডিংনাগিয়ান উভয়েরই প্রত্যাখ্যাত হওয়ার সম্ভাবনা সমান তা পূরণ হয় না। অযোগ্য লিলিপুটিয়ানদের প্রত্যাখ্যানের হার ৭০%, যেখানে অযোগ্য ব্রোবডিংনাগিয়ানদের প্রত্যাখ্যানের হার ৯০%।

আরও তথ্যের জন্য "ফেয়ারনেস: মেশিন লার্নিং ক্র্যাশ কোর্সে সুযোগের সমতা" দেখুন।

সমান ব্যবধান

একটি ন্যায্যতা মেট্রিক যা মূল্যায়ন করে যে একটি মডেল একটি সংবেদনশীল বৈশিষ্ট্যের সমস্ত মানের জন্য সমানভাবে ভাল ফলাফল পূর্বাভাস দিচ্ছে কিনা , ইতিবাচক শ্রেণী এবং নেতিবাচক শ্রেণী উভয়ের ক্ষেত্রেই - কেবল একটি শ্রেণী বা অন্য শ্রেণীর ক্ষেত্রেই নয়। অন্য কথায়, সমস্ত গোষ্ঠীর জন্য প্রকৃত ইতিবাচক হার এবং মিথ্যা নেতিবাচক হার উভয়ই একই হওয়া উচিত।

সমতুল্য প্রতিকূলতা সুযোগের সমতার সাথে সম্পর্কিত, যা শুধুমাত্র একটি একক শ্রেণীর (ধনাত্মক বা নেতিবাচক) ত্রুটির হারের উপর দৃষ্টি নিবদ্ধ করে।

উদাহরণস্বরূপ, ধরুন গ্লুবডুবড্রিব বিশ্ববিদ্যালয় লিলিপুটিয়ান এবং ব্রোবডিংনাগিয়ান উভয়কেই একটি কঠোর গণিত প্রোগ্রামে ভর্তি করে। লিলিপুটিয়ানদের মাধ্যমিক বিদ্যালয়গুলি গণিত ক্লাসের একটি শক্তিশালী পাঠ্যক্রম অফার করে এবং বেশিরভাগ শিক্ষার্থী বিশ্ববিদ্যালয় প্রোগ্রামের জন্য যোগ্য। ব্রোবডিংনাগিয়ানদের মাধ্যমিক বিদ্যালয়গুলি মোটেও গণিত ক্লাস অফার করে না, এবং ফলস্বরূপ, তাদের ছাত্রদের মধ্যে অনেক কম যোগ্য। সমান সম্ভাবনা পূরণ করা হয় যদি আবেদনকারী লিলিপুটিয়ান বা ব্রোবডিংনাগিয়ান যাই হোক না কেন, যদি তারা যোগ্য হয়, তবে তাদের প্রোগ্রামে ভর্তি হওয়ার সম্ভাবনা সমানভাবে বেশি, এবং যদি তারা যোগ্য না হয়, তবে তাদের প্রত্যাখ্যাত হওয়ার সম্ভাবনা সমানভাবে বেশি।

ধরুন ১০০ জন লিলিপুটিয়ান এবং ১০০ জন ব্রোবডিংনাগিয়ান গ্লুবডুবড্রিব বিশ্ববিদ্যালয়ে আবেদন করেন এবং ভর্তির সিদ্ধান্ত নিম্নরূপ নেওয়া হয়:

সারণী ৩। লিলিপুটিয়ান আবেদনকারী (৯০% যোগ্য)

| যোগ্য | অযোগ্য | |

|---|---|---|

| ভর্তি | ৪৫ | ২ |

| প্রত্যাখ্যাত | ৪৫ | ৮ |

| মোট | ৯০ | ১০ |

| ভর্তিকৃত যোগ্য শিক্ষার্থীর শতাংশ: ৪৫/৯০ = ৫০% অযোগ্য শিক্ষার্থী প্রত্যাখ্যাত হওয়ার শতাংশ: ৮/১০ = ৮০% লিলিপুটিয়ান ভর্তিচ্ছু শিক্ষার্থীদের মোট শতাংশ: (৪৫+২)/১০০ = ৪৭% | ||

সারণী ৪। ব্রোবডিংনাগিয়ান আবেদনকারী (১০% যোগ্য):

| যোগ্য | অযোগ্য | |

|---|---|---|

| ভর্তি | ৫ | ১৮ |

| প্রত্যাখ্যাত | ৫ | ৭২ |

| মোট | ১০ | ৯০ |

| ভর্তিকৃত যোগ্য শিক্ষার্থীদের শতাংশ: ৫/১০ = ৫০% অযোগ্য শিক্ষার্থী প্রত্যাখ্যাত হওয়ার শতাংশ: ৭২/৯০ = ৮০% ব্রোবডিংনাগিয়ান ভর্তিচ্ছু শিক্ষার্থীদের মোট শতাংশ: (৫+১৮)/১০০ = ২৩% | ||

সমান সম্ভাবনা পূরণ করা হয় কারণ যোগ্য লিলিপুটিয়ান এবং ব্রোবডিংনাগিয়ান উভয় শিক্ষার্থীরই ভর্তির সম্ভাবনা ৫০% এবং অযোগ্য লিলিপুটিয়ান এবং ব্রোবডিংনাগিয়ানের প্রত্যাখ্যাত হওয়ার সম্ভাবনা ৮০%।

"তত্ত্বাবধানে থাকা শিক্ষায় সুযোগের সমতা" তে সমান প্রতিকূলতাকে আনুষ্ঠানিকভাবে নিম্নরূপে সংজ্ঞায়িত করা হয়েছে: "যদি Ŷ এবং A স্বাধীন, Y এর উপর শর্তাধীন হয়, তাহলে ভবিষ্যদ্বাণীকারী Ŷ সুরক্ষিত বৈশিষ্ট্য A এবং ফলাফল Y এর ক্ষেত্রে সমান প্রতিকূলতা পূরণ করে।"

মূল্যায়ন

প্রাথমিকভাবে LLM মূল্যায়নের সংক্ষিপ্ত রূপ হিসেবে ব্যবহৃত হয়। আরও বিস্তৃতভাবে বলতে গেলে, evals হল যেকোনো ধরণের মূল্যায়নের সংক্ষিপ্ত রূপ।

মূল্যায়ন

একটি মডেলের গুণমান পরিমাপ করার বা একে অপরের সাথে বিভিন্ন মডেলের তুলনা করার প্রক্রিয়া।

একটি তত্ত্বাবধানে থাকা মেশিন লার্নিং মডেল মূল্যায়ন করার জন্য, আপনি সাধারণত একটি বৈধতা সেট এবং একটি পরীক্ষা সেটের বিপরীতে এটি বিচার করেন। একটি LLM মূল্যায়নের ক্ষেত্রে সাধারণত বৃহত্তর গুণমান এবং সুরক্ষা মূল্যায়ন জড়িত থাকে।

হুবহু মিল

একটি অল-অর-নাথিং মেট্রিক যেখানে মডেলের আউটপুট হয় গ্রাউন্ড ট্রুথ বা রেফারেন্স টেক্সটের সাথে হুবহু মিলে যায় অথবা নাও মিলে। উদাহরণস্বরূপ, যদি গ্রাউন্ড ট্রুথ orange হয়, তাহলে একমাত্র মডেল আউটপুট যা সঠিক মিল পূরণ করে তা হল orange ।

Exact match এমন মডেলগুলিকেও মূল্যায়ন করতে পারে যাদের আউটপুট একটি ক্রম (আইটেমের একটি র্যাঙ্ক করা তালিকা)। সাধারণভাবে, exact match-এর জন্য জেনারেট করা র্যাঙ্ক করা তালিকাটি গ্রাউন্ড ট্রুথের সাথে হুবহু মেলে; অর্থাৎ, উভয় তালিকার প্রতিটি আইটেম একই ক্রমে থাকতে হবে। যাইহোক, যদি গ্রাউন্ড ট্রুথ একাধিক সঠিক ক্রম নিয়ে গঠিত হয়, তাহলে exact match-এর জন্য শুধুমাত্র মডেলের আউটপুট সঠিক ক্রমগুলির একটির সাথে মেলে।

চরম সারসংক্ষেপ (xsum)

একটি একক নথির সারসংক্ষেপ তৈরি করার জন্য একজন LLM-এর ক্ষমতা মূল্যায়নের জন্য একটি ডেটাসেট। ডেটাসেটের প্রতিটি এন্ট্রিতে রয়েছে:

- ব্রিটিশ ব্রডকাস্টিং কর্পোরেশন (বিবিসি) দ্বারা রচিত একটি নথি।

- সেই নথির এক বাক্যের সারাংশ।

বিস্তারিত জানার জন্য, "আমাকে বিস্তারিত জানাবেন না, শুধু সারাংশ! চরম সারসংক্ষেপের জন্য বিষয়-সচেতন কনভোলিউশনাল নিউরাল নেটওয়ার্ক" দেখুন।

চ

এফ ১

একটি "রোল-আপ" বাইনারি শ্রেণীবিভাগ মেট্রিক যা নির্ভুলতা এবং প্রত্যাহার উভয়ের উপর নির্ভর করে। সূত্রটি এখানে:

ন্যায্যতা মেট্রিক

"ন্যায্যতা" এর একটি গাণিতিক সংজ্ঞা যা পরিমাপযোগ্য। কিছু সাধারণভাবে ব্যবহৃত ন্যায্যতা মেট্রিক্সের মধ্যে রয়েছে:

অনেক ন্যায্যতা মেট্রিক্স পারস্পরিকভাবে একচেটিয়া; ন্যায্যতা মেট্রিক্সের অসঙ্গতি দেখুন।

মিথ্যা নেতিবাচক (FN)

একটি উদাহরণ যেখানে মডেলটি ভুল করে নেতিবাচক শ্রেণীর ভবিষ্যদ্বাণী করে। উদাহরণস্বরূপ, মডেলটি ভবিষ্যদ্বাণী করে যে একটি নির্দিষ্ট ইমেল বার্তা স্প্যাম নয় (নেতিবাচক শ্রেণী), কিন্তু সেই ইমেল বার্তাটি আসলে স্প্যাম ।

মিথ্যা ঋণাত্মক হার

মডেলটি ভুল করে নেতিবাচক শ্রেণীর ভবিষ্যদ্বাণী করেছে এমন প্রকৃত ধনাত্মক উদাহরণের অনুপাত। নিম্নলিখিত সূত্রটি মিথ্যা ঋণাত্মক হার গণনা করে:

আরও তথ্যের জন্য মেশিন লার্নিং ক্র্যাশ কোর্সের থ্রেশহোল্ড এবং বিভ্রান্তি ম্যাট্রিক্স দেখুন।

মিথ্যা পজিটিভ (FP)

একটি উদাহরণ যেখানে মডেলটি ভুল করে ইতিবাচক শ্রেণীর ভবিষ্যদ্বাণী করে। উদাহরণস্বরূপ, মডেলটি ভবিষ্যদ্বাণী করে যে একটি নির্দিষ্ট ইমেল বার্তা স্প্যাম (ধনাত্মক শ্রেণী), কিন্তু সেই ইমেল বার্তাটি আসলে স্প্যাম নয় ।

আরও তথ্যের জন্য মেশিন লার্নিং ক্র্যাশ কোর্সের থ্রেশহোল্ড এবং বিভ্রান্তি ম্যাট্রিক্স দেখুন।

মিথ্যা পজিটিভ রেট (FPR)

মডেলটি ভুল করে ধনাত্মক শ্রেণীর পূর্বাভাস দিয়েছে এমন প্রকৃত নেতিবাচক উদাহরণের অনুপাত। নিম্নলিখিত সূত্রটি মিথ্যা ধনাত্মক হার গণনা করে:

মিথ্যা ধনাত্মক হার হল একটি ROC বক্ররেখার x-অক্ষ।

আরও তথ্যের জন্য শ্রেণীবিভাগ: মেশিন লার্নিং ক্র্যাশ কোর্সে ROC এবং AUC দেখুন।

বৈশিষ্ট্যের গুরুত্ব

পরিবর্তনশীল গুরুত্বের প্রতিশব্দ।

ভিত্তি মডেল

একটি বিশাল এবং বৈচিত্র্যময় প্রশিক্ষণ সেটের উপর প্রশিক্ষিত একটি খুব বড় প্রাক-প্রশিক্ষিত মডেল । একটি ভিত্তি মডেল নিম্নলিখিত দুটি কাজ করতে পারে:

- বিভিন্ন ধরণের অনুরোধের প্রতি ভালোভাবে সাড়া দিন।

- অতিরিক্ত সূক্ষ্ম-টিউনিং বা অন্যান্য কাস্টমাইজেশনের জন্য বেস মডেল হিসেবে পরিবেশন করুন।

অন্য কথায়, একটি ফাউন্ডেশন মডেল ইতিমধ্যেই সাধারণ অর্থে খুব সক্ষম কিন্তু একটি নির্দিষ্ট কাজের জন্য আরও বেশি কার্যকর হওয়ার জন্য এটিকে আরও কাস্টমাইজ করা যেতে পারে।

সাফল্যের ভগ্নাংশ

একটি ML মডেলের তৈরি টেক্সট মূল্যায়নের জন্য একটি মেট্রিক। সাফল্যের ভগ্নাংশ হল "সফল" তৈরি টেক্সট আউটপুটের সংখ্যাকে মোট তৈরি টেক্সট আউটপুটের সংখ্যা দিয়ে ভাগ করলে। উদাহরণস্বরূপ, যদি একটি বৃহৎ ভাষা মডেল 10টি কোড ব্লক তৈরি করে, যার মধ্যে পাঁচটি সফল হয়, তাহলে সাফল্যের ভগ্নাংশ হবে 50%।

যদিও পরিসংখ্যান জুড়ে সাফল্যের ভগ্নাংশ ব্যাপকভাবে কার্যকর, ML-এর মধ্যে, এই মেট্রিকটি প্রাথমিকভাবে কোড জেনারেশন বা গণিত সমস্যার মতো যাচাইযোগ্য কাজগুলি পরিমাপের জন্য কার্যকর।

গ

গিনি অপবিত্রতা

এনট্রপির অনুরূপ একটি মেট্রিক। স্প্লিটারগুলি জিনি ইম্পিউরিটি বা এনট্রপি থেকে প্রাপ্ত মান ব্যবহার করে শ্রেণীবিভাগ সিদ্ধান্ত বৃক্ষের জন্য শর্ত তৈরি করে। তথ্য লাভ এনট্রপি থেকে উদ্ভূত। জিনি ইম্পিউরিটি থেকে উদ্ভূত মেট্রিকের জন্য কোনও সর্বজনীনভাবে গৃহীত সমতুল্য শব্দ বিদ্যমান নেই; তবে, এই নামহীন মেট্রিক তথ্য লাভের মতোই গুরুত্বপূর্ণ।

গিনি অপবিত্রতাকে গিনি সূচক বা কেবল গিনিও বলা হয়।

জ

কব্জা ক্ষতি

শ্রেণীবিভাগের জন্য ক্ষতি ফাংশনের একটি পরিবার যা প্রতিটি প্রশিক্ষণ উদাহরণ থেকে যতটা সম্ভব দূরে সিদ্ধান্ত সীমানা খুঁজে বের করার জন্য ডিজাইন করা হয়েছে, এইভাবে উদাহরণ এবং সীমানার মধ্যে মার্জিন সর্বাধিক করে তোলে। KSVM গুলি হিঞ্জ লস (অথবা সম্পর্কিত ফাংশন, যেমন স্কোয়ারড হিঞ্জ লস) ব্যবহার করে। বাইনারি শ্রেণীবিভাগের জন্য, হিঞ্জ লস ফাংশনটি নিম্নরূপ সংজ্ঞায়িত করা হয়েছে:

যেখানে y হল সত্যিকারের লেবেল, হয় -1 অথবা +1, এবং y' হল শ্রেণীবিভাগ মডেলের কাঁচা আউটপুট:

ফলস্বরূপ, (y * y') বনাম কব্জা ক্ষতির একটি প্লট নিম্নরূপ দেখায়:

আমি

ন্যায্যতার মেট্রিক্সের অসঙ্গতি

ন্যায্যতার কিছু ধারণা পারস্পরিকভাবে অসঙ্গত এবং একই সাথে সন্তুষ্ট হতে পারে না এই ধারণা। ফলস্বরূপ, ন্যায্যতার পরিমাপের জন্য এমন কোনও একক সার্বজনীন মেট্রিক নেই যা সমস্ত ML সমস্যার ক্ষেত্রে প্রয়োগ করা যেতে পারে।

যদিও এটি হতাশাজনক বলে মনে হতে পারে, ন্যায্যতা মেট্রিক্সের অসঙ্গতি বোঝায় না যে ন্যায্যতা প্রচেষ্টা নিষ্ফল। পরিবর্তে, এটি পরামর্শ দেয় যে ন্যায্যতাকে একটি নির্দিষ্ট ML সমস্যার জন্য প্রাসঙ্গিকভাবে সংজ্ঞায়িত করা উচিত, যার লক্ষ্য এর ব্যবহারের ক্ষেত্রে নির্দিষ্ট ক্ষতি প্রতিরোধ করা।

ন্যায্যতার মেট্রিক্সের অসঙ্গতি সম্পর্কে আরও বিস্তারিত আলোচনার জন্য "ন্যায়পরায়ণতার (অ)সম্ভাব্যতা সম্পর্কে" দেখুন।

ব্যক্তিগত ন্যায্যতা

একটি ন্যায্যতা মেট্রিক যা একই ধরণের ব্যক্তিদের একইভাবে শ্রেণীবদ্ধ করা হয়েছে কিনা তা পরীক্ষা করে। উদাহরণস্বরূপ, ব্রোবডিংনাগিয়ান একাডেমি একই গ্রেড এবং মানসম্মত পরীক্ষার স্কোর সহ দুজন শিক্ষার্থীর ভর্তির সম্ভাবনা সমানভাবে নিশ্চিত করে ব্যক্তিগত ন্যায্যতা পূরণ করতে চাইতে পারে।

মনে রাখবেন যে ব্যক্তিগত ন্যায্যতা সম্পূর্ণরূপে আপনি "সাদৃশ্য" কীভাবে সংজ্ঞায়িত করেন তার উপর নির্ভর করে (এই ক্ষেত্রে, গ্রেড এবং পরীক্ষার স্কোর), এবং যদি আপনার সাদৃশ্য মেট্রিকে গুরুত্বপূর্ণ তথ্য (যেমন একজন শিক্ষার্থীর পাঠ্যক্রমের কঠোরতা) বাদ দেওয়া হয় তবে আপনি নতুন ন্যায্যতা সমস্যার প্রবর্তনের ঝুঁকি নিতে পারেন।

ব্যক্তিগত ন্যায্যতা সম্পর্কে আরও বিস্তারিত আলোচনার জন্য "সচেতনতার মাধ্যমে ন্যায্যতা" দেখুন।

তথ্য লাভ

ডিসিশন ফরেস্টে , একটি নোডের এনট্রপি এবং তার শিশু নোডের এনট্রপির ওজনযুক্ত (উদাহরণ সংখ্যা অনুসারে) যোগফলের মধ্যে পার্থক্য। একটি নোডের এনট্রপি হল সেই নোডের উদাহরণগুলির এনট্রপি।

উদাহরণস্বরূপ, নিম্নলিখিত এনট্রপি মানগুলি বিবেচনা করুন:

- প্যারেন্ট নোডের এনট্রপি = 0.6

- ১৬টি প্রাসঙ্গিক উদাহরণ সহ একটি চাইল্ড নোডের এনট্রপি = ০.২

- ২৪টি প্রাসঙ্গিক উদাহরণ সহ অন্য একটি চাইল্ড নোডের এনট্রপি = ০.১

তাহলে ৪০% উদাহরণ একটি চাইল্ড নোডে এবং ৬০% অন্য চাইল্ড নোডে। অতএব:

- চাইল্ড নোডের ওয়েটেড এনট্রপি যোগফল = (০.৪ * ০.২) + (০.৬ * ০.১) = ০.১৪

সুতরাং, তথ্য লাভ হল:

- তথ্য লাভ = প্যারেন্ট নোডের এনট্রপি - ওয়েটেড এনট্রপি চাইল্ড নোডের যোগফল

- তথ্য লাভ = ০.৬ - ০.১৪ = ০.৪৬

বেশিরভাগ স্প্লিটার এমন পরিস্থিতি তৈরি করতে চায় যা সর্বাধিক তথ্য লাভ করে।

আন্তঃ-রেটার চুক্তি

কোনও কাজ করার সময় মানুষের মূল্যায়নকারীরা কতবার একমত হন তার একটি পরিমাপ। মূল্যায়নকারীরা যদি একমত না হন, তাহলে কাজের নির্দেশাবলী উন্নত করার প্রয়োজন হতে পারে। এটিকে কখনও কখনও আন্তঃ-টীকাকার চুক্তি বা আন্তঃ-রেটারের নির্ভরযোগ্যতাও বলা হয়। কোহেনের কাপ্পাও দেখুন, যা সবচেয়ে জনপ্রিয় আন্তঃ-রেটারের চুক্তি পরিমাপগুলির মধ্যে একটি।

আরও তথ্যের জন্য শ্রেণীগত তথ্য: মেশিন লার্নিং ক্র্যাশ কোর্সে সাধারণ সমস্যা দেখুন।

ল

এল ১ ক্ষতি

একটি ক্ষতি ফাংশন যা প্রকৃত লেবেল মান এবং একটি মডেলের ভবিষ্যদ্বাণী করা মানের মধ্যে পার্থক্যের পরম মান গণনা করে। উদাহরণস্বরূপ, পাঁচটি উদাহরণের একটি ব্যাচের জন্য L 1 ক্ষতির গণনা এখানে দেওয়া হল:

| উদাহরণের প্রকৃত মান | মডেলের পূর্বাভাসিত মান | ডেল্টার পরম মান |

|---|---|---|

| ৭ | ৬ | ১ |

| ৫ | ৪ | ১ |

| ৮ | ১১ | ৩ |

| ৪ | ৬ | ২ |

| ৯ | ৮ | ১ |

| ৮ = এল ১ ক্ষতি | ||

L 1 ক্ষতি L 2 ক্ষতির তুলনায় বহির্মুখী ক্ষতির প্রতি কম সংবেদনশীল।

গড় পরম ত্রুটি হল প্রতি উদাহরণের গড় L 1 ক্ষতি।

আরও তথ্যের জন্য লিনিয়ার রিগ্রেশন: মেশিন লার্নিং ক্র্যাশ কোর্সে ক্ষতি দেখুন।

L 2 ক্ষতি

একটি ক্ষতি ফাংশন যা প্রকৃত লেবেল মান এবং একটি মডেলের ভবিষ্যদ্বাণী করা মানের মধ্যে পার্থক্যের বর্গ গণনা করে। উদাহরণস্বরূপ, পাঁচটি উদাহরণের একটি ব্যাচের জন্য L 2 ক্ষতির গণনা এখানে দেওয়া হল:

| উদাহরণের প্রকৃত মান | মডেলের পূর্বাভাসিত মান | ব-দ্বীপের বর্গক্ষেত্র |

|---|---|---|

| ৭ | ৬ | ১ |

| ৫ | ৪ | ১ |

| ৮ | ১১ | ৯ |

| ৪ | ৬ | ৪ |

| ৯ | ৮ | ১ |

| ১৬ = L ২ ক্ষতি | ||

বর্গীকরণের কারণে, L 2 ক্ষতি বহির্মুখীদের প্রভাবকে বাড়িয়ে তোলে। অর্থাৎ, L 2 ক্ষতি L 1 ক্ষতির চেয়ে খারাপ পূর্বাভাসের প্রতি বেশি জোরালোভাবে প্রতিক্রিয়া দেখায়। উদাহরণস্বরূপ, পূর্ববর্তী ব্যাচের জন্য L 1 ক্ষতি 16 এর পরিবর্তে 8 হবে। লক্ষ্য করুন যে একটি একক বহির্মুখী 16 এর মধ্যে 9 এর জন্য দায়ী।

রিগ্রেশন মডেলগুলি সাধারণত L 2 লসকে লস ফাংশন হিসেবে ব্যবহার করে।

The Mean Squared Error is the average L 2 loss per example. Squared loss is another name for L 2 loss.

See Logistic regression: Loss and regularization in Machine Learning Crash Course for more information.

LLM evaluations (evals)

A set of metrics and benchmarks for assessing the performance of large language models (LLMs). At a high level, LLM evaluations:

- Help researchers identify areas where LLMs need improvement.

- Are useful in comparing different LLMs and identifying the best LLM for a particular task.

- Help ensure that LLMs are safe and ethical to use.

See Large language models (LLMs) in Machine Learning Crash Course for more information.

loss

During the training of a supervised model , a measure of how far a model's prediction is from its label .

A loss function calculates the loss.

See Linear regression: Loss in Machine Learning Crash Course for more information.

loss function

During training or testing, a mathematical function that calculates the loss on a batch of examples. A loss function returns a lower loss for models that makes good predictions than for models that make bad predictions.

The goal of training is typically to minimize the loss that a loss function returns.

Many different kinds of loss functions exist. Pick the appropriate loss function for the kind of model you are building. For example:

- L 2 loss (or Mean Squared Error ) is the loss function for linear regression .

- Log Loss is the loss function for logistic regression .

ম

matrix factorization

In math, a mechanism for finding the matrixes whose dot product approximates a target matrix.

In recommendation systems , the target matrix often holds users' ratings on items . For example, the target matrix for a movie recommendation system might look something like the following, where the positive integers are user ratings and 0 means that the user didn't rate the movie:

| Casablanca | The Philadelphia Story | ব্ল্যাক প্যান্থার | নারী | Pulp Fiction | |

|---|---|---|---|---|---|

| User 1 | ৫.০ | ৩.০ | 0.0 | ২.০ | 0.0 |

| User 2 | ৪.০ | 0.0 | 0.0 | ১.০ | ৫.০ |

| User 3 | ৩.০ | ১.০ | ৪.০ | ৫.০ | 0.0 |

The movie recommendation system aims to predict user ratings for unrated movies. For example, will User 1 like Black Panther ?

One approach for recommendation systems is to use matrix factorization to generate the following two matrixes:

- A user matrix , shaped as the number of users X the number of embedding dimensions.

- An item matrix , shaped as the number of embedding dimensions X the number of items.

For example, using matrix factorization on our three users and five items could yield the following user matrix and item matrix:

User Matrix Item Matrix 1.1 2.3 0.9 0.2 1.4 2.0 1.2 0.6 2.0 1.7 1.2 1.2 -0.1 2.1 2.5 0.5

The dot product of the user matrix and item matrix yields a recommendation matrix that contains not only the original user ratings but also predictions for the movies that each user hasn't seen. For example, consider User 1's rating of Casablanca , which was 5.0. The dot product corresponding to that cell in the recommendation matrix should hopefully be around 5.0, and it is:

(1.1 * 0.9) + (2.3 * 1.7) = 4.9More importantly, will User 1 like Black Panther ? Taking the dot product corresponding to the first row and the third column yields a predicted rating of 4.3:

(1.1 * 1.4) + (2.3 * 1.2) = 4.3Matrix factorization typically yields a user matrix and item matrix that, together, are significantly more compact than the target matrix.

MBPP

Abbreviation for Mostly Basic Python Problems .

গড় পরম ত্রুটি (MAE)

The average loss per example when L 1 loss is used. Calculate Mean Absolute Error as follows:

- Calculate the L 1 loss for a batch.

- Divide the L 1 loss by the number of examples in the batch.

For example, consider the calculation of L 1 loss on the following batch of five examples:

| Actual value of example | Model's predicted value | Loss (difference between actual and predicted) |

|---|---|---|

| ৭ | ৬ | ১ |

| ৫ | ৪ | ১ |

| ৮ | ১১ | ৩ |

| ৪ | ৬ | ২ |

| ৯ | ৮ | ১ |

| 8 = L 1 loss | ||

So, L 1 loss is 8 and the number of examples is 5. Therefore, the Mean Absolute Error is:

Mean Absolute Error = L1 loss / Number of Examples Mean Absolute Error = 8/5 = 1.6

Contrast Mean Absolute Error with Mean Squared Error and Root Mean Squared Error .

mean average precision at k (mAP@k)

The statistical mean of all average precision at k scores across a validation dataset. One use of mean average precision at k is to judge the quality of recommendations generated by a recommendation system .

Although the phrase "mean average" sounds redundant, the name of the metric is appropriate. After all, this metric finds the mean of multiple average precision at k values.

গড় বর্গাকার ত্রুটি (MSE)

The average loss per example when L 2 loss is used. Calculate Mean Squared Error as follows:

- Calculate the L 2 loss for a batch.

- Divide the L 2 loss by the number of examples in the batch.

For example, consider the loss on the following batch of five examples:

| Actual value | Model's prediction | Loss | Squared loss |

|---|---|---|---|

| ৭ | ৬ | ১ | ১ |

| ৫ | ৪ | ১ | ১ |

| ৮ | ১১ | ৩ | ৯ |

| ৪ | ৬ | ২ | ৪ |

| ৯ | ৮ | ১ | ১ |

| 16 = L 2 loss | |||

Therefore, the Mean Squared Error is:

Mean Squared Error = L2 loss / Number of Examples Mean Squared Error = 16/5 = 3.2

Mean Squared Error is a popular training optimizer , particularly for linear regression .

Contrast Mean Squared Error with Mean Absolute Error and Root Mean Squared Error .

TensorFlow Playground uses Mean Squared Error to calculate loss values.

মেট্রিক

A statistic that you care about.

An objective is a metric that a machine learning system tries to optimize.

Metrics API (tf.metrics)

A TensorFlow API for evaluating models. For example, tf.metrics.accuracy determines how often a model's predictions match labels.

minimax loss

A loss function for generative adversarial networks , based on the cross-entropy between the distribution of generated data and real data.

Minimax loss is used in the first paper to describe generative adversarial networks.

See Loss Functions in the Generative Adversarial Networks course for more information.

model capacity

The complexity of problems that a model can learn. The more complex the problems that a model can learn, the higher the model's capacity. A model's capacity typically increases with the number of model parameters. For a formal definition of classification model capacity, see VC dimension .

Momentum

A sophisticated gradient descent algorithm in which a learning step depends not only on the derivative in the current step, but also on the derivatives of the step(s) that immediately preceded it. Momentum involves computing an exponentially weighted moving average of the gradients over time, analogous to momentum in physics. Momentum sometimes prevents learning from getting stuck in local minima.

Mostly Basic Python Problems (MBPP)

A dataset for evaluating an LLM's proficiency in generating Python code. Mostly Basic Python Problems provides about 1,000 crowd-sourced programming problems. Each problem in the dataset contains:

- A task description

- Solution code

- Three automated test cases

ন

negative class

In binary classification , one class is termed positive and the other is termed negative . The positive class is the thing or event that the model is testing for and the negative class is the other possibility. For example:

- The negative class in a medical test might be "not tumor."

- The negative class in an email classification model might be "not spam."

Contrast with positive class .

ও

উদ্দেশ্যমূলক

A metric that your algorithm is trying to optimize.

objective function

The mathematical formula or metric that a model aims to optimize. For example, the objective function for linear regression is usually Mean Squared Loss . Therefore, when training a linear regression model, training aims to minimize Mean Squared Loss.

In some cases, the goal is to maximize the objective function. For example, if the objective function is accuracy, the goal is to maximize accuracy.

See also loss .

প

pass at k (pass@k)

A metric to determine the quality of code (for example, Python) that a large language model generates. More specifically, pass at k tells you the likelihood that at least one generated block of code out of k generated blocks of code will pass all of its unit tests.

Large language models often struggle to generate good code for complex programming problems. Software engineers adapt to this problem by prompting the large language model to generate multiple ( k ) solutions for the same problem. Then, software engineers test each of the solutions against unit tests. The calculation of pass at k depends on the outcome of the unit tests:

- If one or more of those solutions pass the unit test, then the LLM Passes that code generation challenge.

- If none of the solutions pass the unit test, then the LLM Fails that code generation challenge.

The formula for pass at k is as follows:

\[\text{pass at k} = \frac{\text{total number of passes}} {\text{total number of challenges}}\]

In general, higher values of k produce higher pass at k scores; however, higher values of k require more large language model and unit testing resources.

কর্মক্ষমতা

Overloaded term with the following meanings:

- The standard meaning within software engineering. Namely: How fast (or efficiently) does this piece of software run?

- The meaning within machine learning. Here, performance answers the following question: How correct is this model ? That is, how good are the model's predictions?

permutation variable importances

A type of variable importance that evaluates the increase in the prediction error of a model after permuting the feature's values. Permutation variable importance is a model-independent metric.

perplexity

One measure of how well a model is accomplishing its task. For example, suppose your task is to read the first few letters of a word a user is typing on a phone keyboard, and to offer a list of possible completion words. Perplexity, P, for this task is approximately the number of guesses you need to offer in order for your list to contain the actual word the user is trying to type.

Perplexity is related to cross-entropy as follows:

positive class

The class you are testing for.

For example, the positive class in a cancer model might be "tumor." The positive class in an email classification model might be "spam."

Contrast with negative class .

PR AUC (area under the PR curve)

Area under the interpolated precision-recall curve , obtained by plotting (recall, precision) points for different values of the classification threshold .

precision

A metric for classification models that answers the following question:

When the model predicted the positive class , what percentage of the predictions were correct?

Here is the formula:

where:

- true positive means the model correctly predicted the positive class.

- false positive means the model mistakenly predicted the positive class.

For example, suppose a model made 200 positive predictions. Of these 200 positive predictions:

- 150 were true positives.

- 50 were false positives.

In this case:

Contrast with accuracy and recall .

See Classification: Accuracy, recall, precision and related metrics in Machine Learning Crash Course for more information.

precision at k (precision@k)

A metric for evaluating a ranked (ordered) list of items. Precision at k identifies the fraction of the first k items in that list that are "relevant." That is:

\[\text{precision at k} = \frac{\text{relevant items in first k items of the list}} {\text{k}}\]

The value of k must be less than or equal to the length of the returned list. Note that the length of the returned list is not part of the calculation.

Relevance is often subjective; even expert human evaluators often disagree on which items are relevant.

Compare with:

precision-recall curve

A curve of precision versus recall at different classification thresholds .

prediction bias

A value indicating how far apart the average of predictions is from the average of labels in the dataset.

Not to be confused with the bias term in machine learning models or with bias in ethics and fairness .

predictive parity

A fairness metric that checks whether, for a given classification model , the precision rates are equivalent for subgroups under consideration.

For example, a model that predicts college acceptance would satisfy predictive parity for nationality if its precision rate is the same for Lilliputians and Brobdingnagians.

Predictive parity is sometime also called predictive rate parity .

See "Fairness Definitions Explained" (section 3.2.1) for a more detailed discussion of predictive parity.

predictive rate parity

Another name for predictive parity .

probability density function

A function that identifies the frequency of data samples having exactly a particular value. When a dataset's values are continuous floating-point numbers, exact matches rarely occur. However, integrating a probability density function from value x to value y yields the expected frequency of data samples between x and y .

For example, consider a normal distribution having a mean of 200 and a standard deviation of 30. To determine the expected frequency of data samples falling within the range 211.4 to 218.7, you can integrate the probability density function for a normal distribution from 211.4 to 218.7.

র

Reading Comprehension with Commonsense Reasoning Dataset (ReCoRD)

A dataset to evaluate an LLM's ability to perform commonsense reasoning. Each example in the dataset contains three components:

- A paragraph or two from a news article

- A query in which one of the entities explicitly or implicitly identified in the passage is masked .

- The answer (the name of the entity that belongs in the mask)

See ReCoRD for an extensive list of examples.

ReCoRD is a component of the SuperGLUE ensemble.

RealToxicityPrompts

A dataset that contains a set of sentence beginnings that might contain toxic content. Use this dataset to evaluate an LLM's ability to generate non-toxic text to complete the sentence. Typically, you use the Perspective API to determine how well the LLM performed at this task.

See RealToxicityPrompts: Evaluating Neural Toxic Degeneration in Language Models for details.

স্মরণ করা

A metric for classification models that answers the following question:

When ground truth was the positive class , what percentage of predictions did the model correctly identify as the positive class?

Here is the formula:

\[\text{Recall} = \frac{\text{true positives}} {\text{true positives} + \text{false negatives}} \]

where:

- true positive means the model correctly predicted the positive class.

- false negative means that the model mistakenly predicted the negative class .

For instance, suppose your model made 200 predictions on examples for which ground truth was the positive class. Of these 200 predictions:

- 180 were true positives.

- 20 were false negatives.

In this case:

\[\text{Recall} = \frac{\text{180}} {\text{180} + \text{20}} = 0.9 \]

See Classification: Accuracy, recall, precision and related metrics for more information.

recall at k (recall@k)

A metric for evaluating systems that output a ranked (ordered) list of items. Recall at k identifies the fraction of relevant items in the first k items in that list out of the total number of relevant items returned.

\[\text{recall at k} = \frac{\text{relevant items in first k items of the list}} {\text{total number of relevant items in the list}}\]

Contrast with precision at k .

Recognizing Textual Entailment (RTE)

A dataset for evaluating an LLM's ability to determine whether a hypothesis can be entailed (logically drawn) from a text passage. Each example in an RTE evaluation consists of three parts:

- A passage, typically from news or Wikipedia articles

- A hypothesis

- The correct answer, which is either:

- True, meaning the hypothesis can be entailed from the passage

- False, meaning the hypothesis can't be entailed from the passage

উদাহরণস্বরূপ:

- Passage: The Euro is the currency of the European Union.

- Hypothesis: France uses the Euro as currency.

- Entailment: True, because France is part of the European Union.

RTE is a component of the SuperGLUE ensemble.

ReCoRD

Abbreviation for Reading Comprehension with Commonsense Reasoning Dataset .

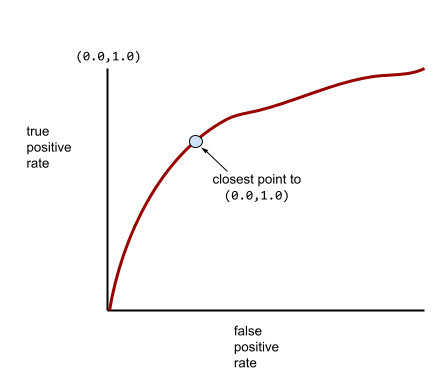

ROC (receiver operating characteristic) Curve

A graph of true positive rate versus false positive rate for different classification thresholds in binary classification.

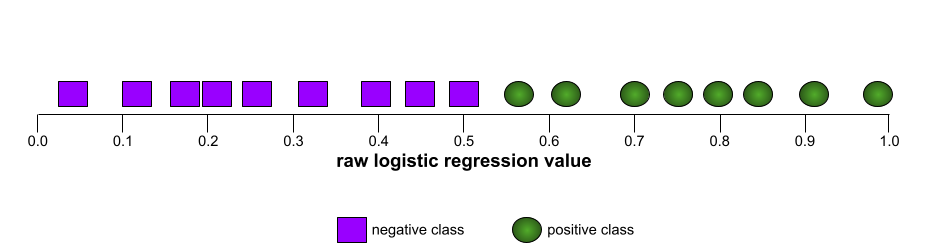

The shape of an ROC curve suggests a binary classification model's ability to separate positive classes from negative classes. Suppose, for example, that a binary classification model perfectly separates all the negative classes from all the positive classes:

The ROC curve for the preceding model looks as follows:

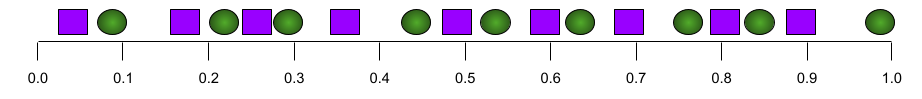

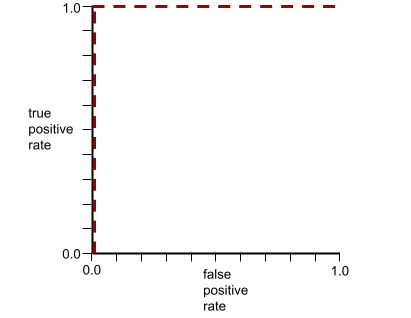

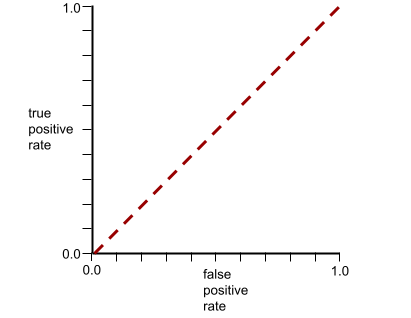

In contrast, the following illustration graphs the raw logistic regression values for a terrible model that can't separate negative classes from positive classes at all:

The ROC curve for this model looks as follows:

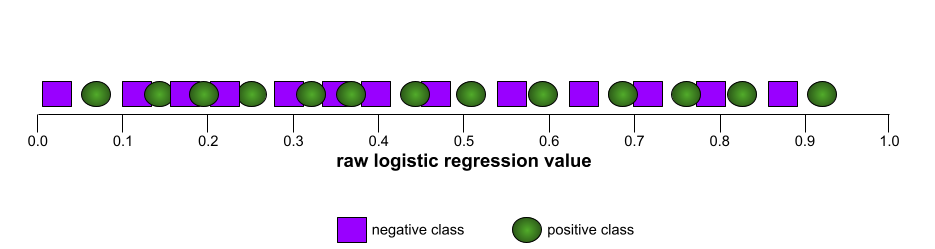

Meanwhile, back in the real world, most binary classification models separate positive and negative classes to some degree, but usually not perfectly. So, a typical ROC curve falls somewhere between the two extremes:

The point on an ROC curve closest to (0.0,1.0) theoretically identifies the ideal classification threshold. However, several other real-world issues influence the selection of the ideal classification threshold. For example, perhaps false negatives cause far more pain than false positives.

A numerical metric called AUC summarizes the ROC curve into a single floating-point value.

Root Mean Squared Error (RMSE)

The square root of the Mean Squared Error .

ROUGE (Recall-Oriented Understudy for Gisting Evaluation)

A family of metrics that evaluate automatic summarization and machine translation models. ROUGE metrics determine the degree to which a reference text overlaps an ML model's generated text . Each member of the ROUGE family measures overlap in a different way. Higher ROUGE scores indicate more similarity between the reference text and generated text than lower ROUGE scores.

Each ROUGE family member typically generates the following metrics:

- নির্ভুলতা

- Recall

- F 1

For details and examples, see:

ROUGE-L

A member of the ROUGE family focused on the length of the longest common subsequence in the reference text and generated text . The following formulas calculate recall and precision for ROUGE-L:

You can then use F 1 to roll up ROUGE-L recall and ROUGE-L precision into a single metric:

ROUGE-L ignores any newlines in the reference text and generated text, so the longest common subsequence could cross multiple sentences. When the reference text and generated text involve multiple sentences, a variation of ROUGE-L called ROUGE-Lsum is generally a better metric. ROUGE-Lsum determines the longest common subsequence for each sentence in a passage and then calculates the mean of those longest common subsequences.

ROUGE-N

A set of metrics within the ROUGE family that compares the shared N-grams of a certain size in the reference text and generated text . For example:

- ROUGE-1 measures the number of shared tokens in the reference text and generated text.

- ROUGE-2 measures the number of shared bigrams (2-grams) in the reference text and generated text.

- ROUGE-3 measures the number of shared trigrams (3-grams) in the reference text and generated text.

You can use the following formulas to calculate ROUGE-N recall and ROUGE-N precision for any member of the ROUGE-N family:

You can then use F 1 to roll up ROUGE-N recall and ROUGE-N precision into a single metric:

ROUGE-S

A forgiving form of ROUGE-N that enables skip-gram matching. That is, ROUGE-N only counts N-grams that match exactly , but ROUGE-S also counts N-grams separated by one or more words. For example, consider the following:

- reference text : White clouds

- generated text : White billowing clouds

When calculating ROUGE-N, the 2-gram, White clouds doesn't match White billowing clouds . However, when calculating ROUGE-S, White clouds does match White billowing clouds .

R-squared

A regression metric indicating how much variation in a label is due to an individual feature or to a feature set. R-squared is a value between 0 and 1, which you can interpret as follows:

- An R-squared of 0 means that none of a label's variation is due to the feature set.

- An R-squared of 1 means that all of a label's variation is due to the feature set.

- An R-squared between 0 and 1 indicates the extent to which the label's variation can be predicted from a particular feature or the feature set. For example, an R-squared of 0.10 means that 10 percent of the variance in the label is due to the feature set, an R-squared of 0.20 means that 20 percent is due to the feature set, and so on.

R-squared is the square of the Pearson correlation coefficient between the values that a model predicted and ground truth .

আরটিই

Abbreviation for Recognizing Textual Entailment .

স

scoring

The part of a recommendation system that provides a value or ranking for each item produced by the candidate generation phase.

similarity measure

In clustering algorithms, the metric used to determine how alike (how similar) any two examples are.

sparsity

The number of elements set to zero (or null) in a vector or matrix divided by the total number of entries in that vector or matrix. For example, consider a 100-element matrix in which 98 cells contain zero. The calculation of sparsity is as follows:

Feature sparsity refers to the sparsity of a feature vector; model sparsity refers to the sparsity of the model weights.

SQuAD

Acronym for Stanford Question Answering Dataset , introduced in the paper SQuAD: 100,000+ Questions for Machine Comprehension of Text . The questions in this dataset come from people posing questions about Wikipedia articles. Some of the questions in SQuAD have answers, but other questions intentionally don't have answers. Therefore, you can use SQuAD to evaluate an LLM's ability to do both of the following:

- Answer questions that can be answered.

- Identify questions that cannot be answered.

Exact match in combination with F 1 are the most common metrics for evaluating LLMs against SQuAD.

squared hinge loss

The square of the hinge loss . Squared hinge loss penalizes outliers more harshly than regular hinge loss.

squared loss

Synonym for L 2 loss .

SuperGLUE

An ensemble of datasets for rating an LLM's overall ability to understand and generate text. The ensemble consists of the following datasets:

- Boolean Questions (BoolQ)

- CommitmentBank (CB)

- Choice of Plausible Alternatives (COPA)

- Multi-sentence Reading Comprehension (MultiRC)

- Reading Comprehension with Commonsense Reasoning Dataset (ReCoRD)

- Recognizing Textual Entailment (RTE)

- Words in Context (WiC)

- Winograd Schema Challenge (WSC)

For details, see SuperGLUE: A Stickier Benchmark for General-Purpose Language Understanding Systems .

হ

test loss

A metric representing a model's loss against the test set . When building a model , you typically try to minimize test loss. That's because a low test loss is a stronger quality signal than a low training loss or low validation loss .

A large gap between test loss and training loss or validation loss sometimes suggests that you need to increase the regularization rate .

top-k accuracy

The percentage of times that a "target label" appears within the first k positions of generated lists. The lists could be personalized recommendations or a list of items ordered by softmax .

Top-k accuracy is also known as accuracy at k .

toxicity

The degree to which content is abusive, threatening, or offensive. Many machine learning models can identify, measure, and classify toxicity. Most of these models identify toxicity along multiple parameters, such as the level of abusive language and the level of threatening language.

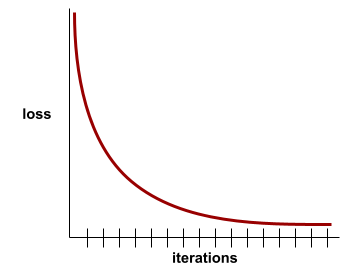

training loss

A metric representing a model's loss during a particular training iteration. For example, suppose the loss function is Mean Squared Error . Perhaps the training loss (the Mean Squared Error) for the 10th iteration is 2.2, and the training loss for the 100th iteration is 1.9.

A loss curve plots training loss versus the number of iterations. A loss curve provides the following hints about training:

- A downward slope implies that the model is improving.

- An upward slope implies that the model is getting worse.

- A flat slope implies that the model has reached convergence .

For example, the following somewhat idealized loss curve shows:

- A steep downward slope during the initial iterations, which implies rapid model improvement.

- A gradually flattening (but still downward) slope until close to the end of training, which implies continued model improvement at a somewhat slower pace then during the initial iterations.

- A flat slope towards the end of training, which suggests convergence.

Although training loss is important, see also generalization .

Trivia Question Answering

Datasets to evaluate an LLM's ability to answer trivia questions. Each dataset contains question-answer pairs authored by trivia enthusiasts. Different datasets are grounded by different sources, including:

- Web search (TriviaQA)

- Wikipedia (TriviaQA_wiki)

For more information see TriviaQA: A Large Scale Distantly Supervised Challenge Dataset for Reading Comprehension .

true negative (TN)

An example in which the model correctly predicts the negative class . For example, the model infers that a particular email message is not spam , and that email message really is not spam .

true positive (TP)

An example in which the model correctly predicts the positive class . For example, the model infers that a particular email message is spam, and that email message really is spam.

true positive rate (TPR)

Synonym for recall . That is:

True positive rate is the y-axis in an ROC curve .

Typologically Diverse Question Answering (TyDi QA)

A large dataset for evaluating an LLM's proficiency in answering questions. The dataset contains question and answer pairs in many languages.

For details, see TyDi QA: A Benchmark for Information-Seeking Question Answering in Typologically Diverse Languages .

হ

validation loss

A metric representing a model's loss on the validation set during a particular iteration of training.

See also generalization curve .

variable importances

A set of scores that indicates the relative importance of each feature to the model.

For example, consider a decision tree that estimates house prices. Suppose this decision tree uses three features: size, age, and style. If a set of variable importances for the three features are calculated to be {size=5.8, age=2.5, style=4.7}, then size is more important to the decision tree than age or style.

Different variable importance metrics exist, which can inform ML experts about different aspects of models.

হ

Wasserstein loss

One of the loss functions commonly used in generative adversarial networks , based on the earth mover's distance between the distribution of generated data and real data.

WiC

Abbreviation for Words in Context .

WikiLingua (wiki_lingua)

A dataset for evaluating an LLM's ability to summarize short articles. WikiHow , an encyclopedia of articles explaining how to do various tasks, is the human-authored source for both the articles and the summaries. Each entry in the dataset consists of:

- An article, which is created by appending each step of the prose (paragraph) version of the numbered list, minus the opening sentence of each step.

- A summary of that article, consisting of the opening sentence of each step in the numbered list.

For details, see WikiLingua: A New Benchmark Dataset for Cross-Lingual Abstractive Summarization .

Winograd Schema Challenge (WSC)

A format (or dataset conforming to that format) for evaluating an LLM's ability to determine the noun phrase that a pronoun refers to.

Each entry in a Winograd Schema Challenge consists of:

- A short passage, which contains a target pronoun

- A target pronoun

- Candidate noun phrases, followed by the correct answer (a Boolean). If the target pronoun refers to this candidate, the answer is True. If the target pronoun does not refer to this candidate, the answer is False.

উদাহরণস্বরূপ:

- Passage : Mark told Pete many lies about himself, which Pete included in his book. He should have been more truthful.

- Target pronoun : He

- Candidate noun phrases :

- Mark: True, because the target pronoun refers to Mark

- Pete: False, because the target pronoun doesn't refer to Peter

The Winograd Schema Challenge is a component of the SuperGLUE ensemble.

Words in Context (WiC)

A dataset for evaluating how well an LLM uses context to understand words that have multiple meanings. Each entry in the dataset contains:

- Two sentences, each containing the target word

- The target word

- The correct answer (a Boolean), where:

- True means the target word has the same meaning in the two sentences

- False means the target word has a different meaning in the two sentences

উদাহরণস্বরূপ:

- Two sentences:

- There's a lot of trash on the bed of the river.

- I keep a glass of water next to my bed when I sleep.

- The target word: bed

- Correct answer : False, because the target word has a different meaning in the two sentences.

For details, see WiC: the Word-in-Context Dataset for Evaluating Context-Sensitive Meaning Representations .

Words in Context is a component of the SuperGLUE ensemble.

WSC

Abbreviation for Winograd Schema Challenge .

এক্স

XL-Sum (xlsum)

A dataset for evaluating an LLM's proficiency in summarizing text. XL-Sum provides entries in many languages. Each entry in the dataset contains:

- An article, taken from the British Broadcasting Company (BBC).

- A summary of the article, written by the article's author. Note that that summary can contain words or phrases not present in the article.

For details, see XL-Sum: Large-Scale Multilingual Abstractive Summarization for 44 Languages .