이 페이지에는 측정항목 용어집 용어가 포함되어 있습니다. 모든 용어집 용어는 여기를 클릭하세요.

A

정확성

올바른 분류 예측 수를 총 예측 수로 나눈 값입니다. 이는 다음과 같은 의미입니다.

예를 들어 올바른 예측을 40번 하고 잘못된 예측을 10번 한 모델의 정확도는 다음과 같습니다.

이진 분류는 올바른 예측과 잘못된 예측의 다양한 카테고리에 대한 구체적인 이름을 제공합니다. 따라서 이진 분류의 정확도 공식은 다음과 같습니다.

각 항목의 의미는 다음과 같습니다.

자세한 내용은 머신러닝 단기집중과정의 분류: 정확도, 재현율, 정밀도 및 관련 측정항목을 참고하세요.

PR 곡선 아래 영역

PR AUC (PR 곡선 아래 영역)를 참고하세요.

ROC 곡선 아래 영역

AUC (ROC 곡선 아래 영역)을 참고하세요.

AUC (ROC 곡선 아래 영역)

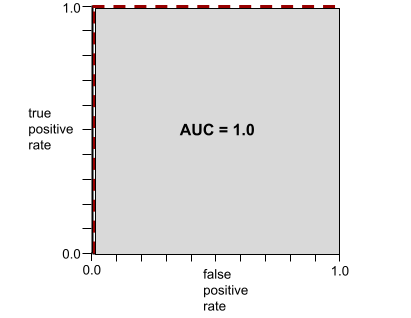

긍정 클래스와 부정 클래스를 구분하는 이진 분류 모델의 능력을 나타내는 0.0~1.0 사이의 숫자입니다. AUC가 1.0에 가까울수록 모델이 클래스를 서로 분리하는 능력이 우수합니다.

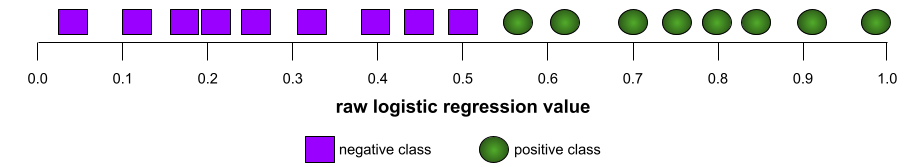

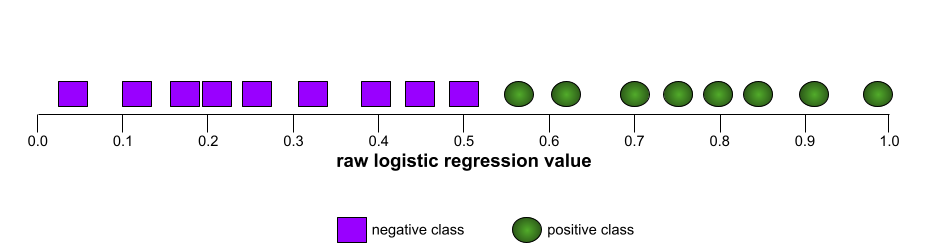

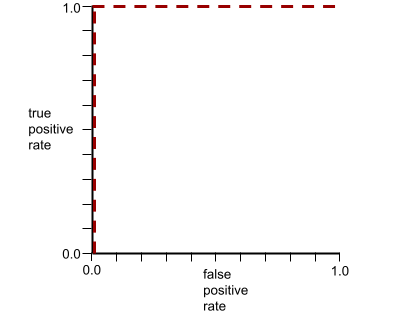

예를 들어 다음 그림은 포지티브 클래스 (녹색 타원)를 네거티브 클래스 (보라색 직사각형)와 완벽하게 구분하는 분류 모델을 보여줍니다. 이 비현실적으로 완벽한 모델의 AUC는 1.0입니다.

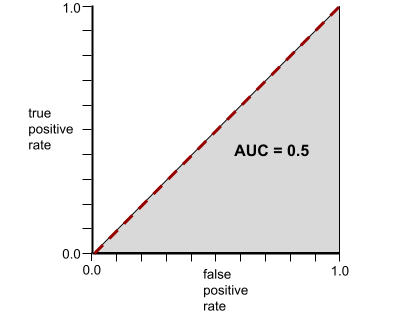

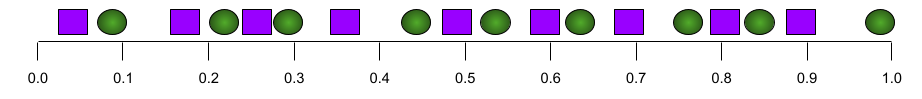

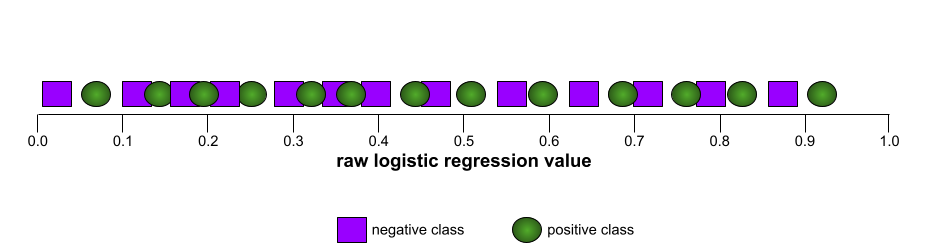

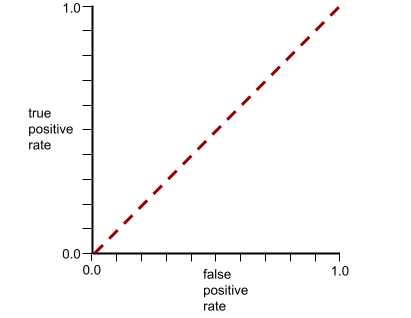

반대로 다음 그림은 무작위 결과를 생성한 분류 모델의 결과를 보여줍니다. 이 모델의 AUC는 0.5입니다.

예, 앞의 모델의 AUC는 0.0이 아닌 0.5입니다.

대부분의 모델은 두 극단 사이에 있습니다. 예를 들어 다음 모델은 긍정적인 것과 부정적인 것을 어느 정도 구분하므로 AUC가 0.5와 1.0 사이에 있습니다.

AUC는 분류 임계값에 설정된 값을 무시합니다. AUC는 가능한 모든 분류 임곗값을 고려합니다.

자세한 내용은 머신러닝 단기집중과정의 분류: ROC 및 AUC를 참고하세요.

k에서의 평균 정밀도

순위가 지정된 결과(예: 책 추천의 번호가 매겨진 목록)를 생성하는 단일 프롬프트에 대한 모델의 성능을 요약하는 측정항목입니다. k에서의 평균 정밀도는 각 관련 결과의 k에서의 정밀도 값의 평균입니다. 따라서 k에서의 평균 정밀도 공식은 다음과 같습니다.

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

각 항목의 의미는 다음과 같습니다.

- \(n\) 은 목록에 있는 관련 항목의 수입니다.

k에서의 재현율과 대비되는 개념입니다.

B

기준

다른 모델 (일반적으로 더 복잡한 모델)의 성능을 비교하는 데 참조용으로 사용되는 모델입니다. 예를 들어 로지스틱 회귀 모델은 심층 모델의 좋은 기준이 될 수 있습니다.

특정 문제의 경우 기준은 새 모델이 유용하려면 달성해야 하는 최소 예상 성능을 모델 개발자가 수치화하는 데 도움이 됩니다.

불리언 질문 (BoolQ)

예/아니요 질문에 답변하는 LLM의 숙련도를 평가하기 위한 데이터 세트입니다. 데이터 세트의 각 챌린지에는 세 가지 구성요소가 있습니다.

- 질문

- 질문에 대한 답변을 암시하는 구절입니다.

- 정답(예 또는 아니요)

예를 들면 다음과 같습니다.

- 질문: 미시간에 원자력 발전소가 있나요?

- 통로: ...미시간에 전력의 약 30% 를 공급하는 원자력 발전소 3곳이 있습니다.

- 정답: 예

연구자들은 익명 처리되고 집계된 Google 검색 질문에서 질문을 수집한 다음 Wikipedia 페이지를 사용하여 정보를 뒷받침했습니다.

자세한 내용은 BoolQ: Exploring the Surprising Difficulty of Natural Yes/No Questions을 참고하세요.

BoolQ는 SuperGLUE 앙상블의 구성요소입니다.

BoolQ

Boolean Questions의 약어입니다.

C

CB

CommitmentBank의 약어입니다.

문자 N-그램 F 점수 (ChrF)

기계 번역 모델을 평가하는 측정항목입니다. 문자 N-그램 F 점수는 참조 텍스트의 N-그램이 ML 모델의 생성된 텍스트의 N-그램과 얼마나 중복되는지 결정합니다.

문자 N-그램 F 점수는 ROUGE 및 BLEU 계열의 측정항목과 유사하지만 다음과 같은 차이점이 있습니다.

- 문자 N-그램 F 점수는 문자 N-그램에서 작동합니다.

- ROUGE와 BLEU는 단어 N-그램 또는 토큰을 기반으로 작동합니다.

가능한 대안 선택 (COPA)

LLM이 전제에 대한 두 가지 대안 답변 중 더 나은 답변을 얼마나 잘 식별할 수 있는지 평가하기 위한 데이터 세트입니다. 데이터 세트의 각 챌린지는 다음 세 가지 구성요소로 구성됩니다.

- 전제(일반적으로 질문이 뒤따르는 문장)

- 전제에 제시된 질문에 대한 두 가지 가능한 답변(하나는 정답이고 다른 하나는 오답)

- 정답

예를 들면 다음과 같습니다.

- 전제: 남자가 발가락이 부러졌습니다. 이 문제의 원인은 무엇인가요?

- 예시 답변:

- 양말에 구멍이 났어.

- 발에 망치를 떨어뜨렸어.

- 정답: 2

COPA는 SuperGLUE 앙상블의 구성요소입니다.

CommitmentBank (CB)

LLM이 한 구절의 저자가 해당 구절 내의 타겟 절을 믿는지 여부를 판단하는 능력을 평가하기 위한 데이터 세트입니다. 데이터 세트의 각 항목에는 다음이 포함됩니다.

- 문구

- 해당 구절 내의 타겟 절

- 단락의 작성자가 타겟 조항을

예를 들면 다음과 같습니다.

- 구절: 아르테미스가 웃는 소리를 들으니 정말 즐거웠어. 정말 진지한 아이예요. 그녀에게 유머 감각이 있는 줄 몰랐어.

- 타겟 절: 그녀는 유머 감각이 있었습니다.

- Boolean: True. 즉, 작성자가 타겟 조항을

CommitmentBank는 SuperGLUE 앙상블의 구성요소입니다.

COPA

Choice of Plausible Alternatives의 약어입니다.

비용

손실의 동의어입니다.

반사실적 공정성

민감한 속성이 하나 이상 다르다는 점을 제외하고 첫 번째 개인과 동일한 두 번째 개인에 대해 분류 모델이 동일한 결과를 생성하는지 확인하는 공정성 측정항목입니다. 반사실적 공정성을 위해 분류 모델을 평가하는 것은 모델에서 잠재적인 편향 소스를 파악하는 한 가지 방법입니다.

자세한 내용은 다음 중 하나를 참고하세요.

- 머신러닝 단기집중과정의 공정성: 반사실적 공정성

- When Worlds Collide: Integrating Different Counterfactual Assumptions in Fairness

교차 엔트로피

로그 손실을 다중 클래스 분류 문제로 일반화한 것입니다. 교차 엔트로피는 두 확률 분포 간의 차이를 계량합니다. 퍼플렉시티도 참고하세요.

누적 분포 함수 (CDF)

타겟 값 이하의 샘플 빈도를 정의하는 함수입니다. 예를 들어 연속 값의 정규 분포를 생각해 보세요. CDF는 샘플의 약 50% 가 평균 이하이고 샘플의 약 84% 가 평균보다 1표준편차 이상임을 나타냅니다.

D

인구통계 동등성

모델의 분류 결과가 지정된 민감한 속성에 종속되지 않는 경우 충족되는 공정성 측정항목입니다.

예를 들어 소인국인과 거인국인이 모두 글럽덥드립 대학에 지원하는 경우, 한 그룹이 다른 그룹보다 평균적으로 자격 요건을 더 충족하는지 여부와 관계없이 입학한 소인국인의 비율이 입학한 거인국인의 비율과 동일하면 인구통계학적 균형이 달성됩니다.

균등한 확률 및 기회의 평등과 대조됩니다. 이러한 개념은 집계된 분류 결과가 민감한 속성에 의존하는 것을 허용하지만 특정 정답 라벨의 분류 결과가 민감한 속성에 의존하는 것은 허용하지 않습니다. 인구통계학적 균형을 위해 최적화할 때의 절충안을 살펴볼 수 있는 시각화는 '더 스마트한 머신러닝으로 차별을 타파하기'를 참고하세요.

자세한 내용은 머신러닝 단기집중과정의 공정성: 인구통계학적 동등성을 참고하세요.

E

earth mover's distance (EMD)

두 분포의 상대적 유사성을 나타내는 측정값입니다. 지구 이동 거리(EMD)가 낮을수록 분포가 더 유사합니다.

편집 거리

두 텍스트 문자열이 서로 얼마나 유사한지를 측정한 값입니다. 머신러닝에서 편집 거리는 다음과 같은 이유로 유용합니다.

- 편집 거리는 쉽게 계산할 수 있습니다.

- 편집 거리는 서로 유사한 것으로 알려진 두 문자열을 비교할 수 있습니다.

- 편집 거리는 서로 다른 문자열이 지정된 문자열과 얼마나 유사한지 확인할 수 있습니다.

편집 거리에는 여러 정의가 있으며 각 정의는 서로 다른 문자열 작업을 사용합니다. 예는 레벤슈타인 거리를 참고하세요.

경험적 누적 분포 함수 (eCDF 또는 EDF)

실제 데이터 세트의 실증적 측정을 기반으로 하는 누적 분포 함수 x축을 따라 어느 지점에서든 함수의 값은 지정된 값보다 작거나 같은 데이터 세트의 관측치 비율입니다.

엔트로피

정보 이론에서 확률 분포가 얼마나 예측 불가능한지를 설명합니다. 또는 엔트로피는 각 예시에 포함된 정보의 양으로도 정의됩니다. 분포는 확률 변수의 모든 값이 동일할 가능성이 있을 때 가능한 가장 높은 엔트로피를 갖습니다.

가능한 값이 두 개인 집합('0'과 '1', 예를 들어 이진 분류 문제의 라벨)의 엔트로피는 다음 공식을 따릅니다.

H = -p log p - q log q = -p log p - (1-p) * log (1-p)

각 항목의 의미는 다음과 같습니다.

- H는 엔트로피입니다.

- p는 '1' 예시의 비율입니다.

- q는 '0' 예시의 비율입니다. q = (1 - p)입니다.

- log는 일반적으로 log2입니다. 이 경우 엔트로피 단위는 비트입니다.

예를 들어 다음을 가정합니다.

- 100개의 예에 값 '1'이 포함되어 있습니다.

- 300개의 예시에는 '0' 값이 포함되어 있습니다.

따라서 엔트로피 값은 다음과 같습니다.

- p = 0.25

- q = 0.75

- H = (-0.25)log2(0.25) - (0.75)log2(0.75) = 0.81비트/예시

완벽하게 균형이 잡힌 집합 (예: '0' 200개와 '1' 200개)의 엔트로피는 예시당 1.0비트입니다. 세트가 불균형해질수록 엔트로피는 0.0에 가까워집니다.

결정 트리에서 엔트로피는 분류 결정 트리의 성장 중에 분할기가 조건을 선택하는 데 도움이 되는 정보 획득을 공식화하는 데 도움이 됩니다.

다음과 엔트로피 비교:

- gini impurity

- 교차 엔트로피 손실 함수

엔트로피는 흔히 섀넌의 엔트로피라고 불립니다.

자세한 내용은 결정 트리 과정의 숫자 특징이 있는 이진 분류를 위한 정확한 분할기를 참고하세요.

기회의 평등

모델이 민감한 속성의 모든 값에 대해 원하는 결과를 동일하게 잘 예측하는지 평가하는 공정성 측정항목 즉, 모델의 바람직한 결과가 양성 클래스인 경우 목표는 모든 그룹에 대해 참양성률을 동일하게 만드는 것입니다.

기회의 균등은 균등화된 오즈와 관련이 있으며, 이를 위해서는 참양성률과 거짓양성률이 모든 그룹에 대해 동일해야 합니다.

글럽더브드립 대학교에서 소인국인과 거인국인을 모두 엄격한 수학 프로그램에 입학시킨다고 가정해 보겠습니다. 릴리풋의 중등학교에서는 수학 수업을 위한 강력한 커리큘럼을 제공하며, 대부분의 학생이 대학 프로그램에 적합합니다. 브로브딩나그의 중등학교에서는 수학 수업을 전혀 제공하지 않으므로 자격을 갖춘 학생이 훨씬 적습니다. 자격 요건을 갖춘 학생이 릴리풋 사람인지 브로브딩낵 사람인지에 관계없이 입학할 가능성이 동일한 경우 국적 (릴리풋 또는 브로브딩낵)과 관련하여 '입학'이라는 선호 라벨에 대한 기회 균등이 충족됩니다.

예를 들어 100명의 소인과 100명의 거인이 Glubbdubdrib University에 지원하고 입학 결정이 다음과 같이 내려진다고 가정해 보겠습니다.

표 1. 릴리풋 지원자 (90% 가 자격 요건을 충족함)

| 적격성 확인됨 | 자격 없음 | |

|---|---|---|

| 허용됨 | 45 | 3 |

| 거부됨 | 45 | 7 |

| 합계 | 90 | 10 |

|

자격 요건을 충족하는 학생의 합격률: 45/90 = 50% 자격 요건을 충족하지 않는 학생의 불합격률: 7/10 = 70% 릴리풋 학생의 총 합격률: (45+3)/100 = 48% |

||

표 2. 브로브딩나그 지원자 (10% 가 자격 요건을 충족함):

| 적격성 확인됨 | 자격 없음 | |

|---|---|---|

| 허용됨 | 5 | 9 |

| 거부됨 | 5 | 81 |

| 합계 | 10 | 90 |

|

자격 요건을 충족하는 학생 중 합격자 비율: 5/10 = 50% 자격 요건을 충족하지 않는 학생 중 불합격자 비율: 81/90 = 90% Brobdingnagian 학생 중 합격자 비율: (5+9)/100 = 14% |

||

위의 예에서는 자격을 갖춘 릴리풋인과 브로브딩나그인 모두 입학할 확률이 50% 이므로 자격을 갖춘 학생의 입학 기회가 균등하게 제공됩니다.

기회의 균등은 충족되지만 다음 두 공정성 측정항목은 충족되지 않습니다.

- 인구통계학적 동등성: 릴리풋인과 브로브딩나그인이 대학에 입학하는 비율이 다릅니다. 릴리풋인 학생의 48% 가 입학하지만 브로브딩나그인 학생의 14% 만 입학합니다.

- 균등한 기회: 자격 요건을 충족하는 소인국 학생과 거인국 학생 모두 입학할 기회가 동일하지만 자격 요건을 충족하지 않는 소인국 학생과 거인국 학생 모두 거부될 기회가 동일하다는 추가 제약 조건은 충족되지 않습니다. 자격이 없는 Lilliputian의 거부율은 70% 인 반면 자격이 없는 Brobdingnagian의 거부율은 90% 입니다.

자세한 내용은 머신러닝 단기집중과정의 공정성: 기회의 평등을 참고하세요.

균등한 기회

모델이 양성 클래스 및 음성 클래스 모두에 대해 민감한 속성의 모든 값에 대해 결과를 동일하게 잘 예측하는지 평가하는 공정성 측정항목입니다. 한 클래스 또는 다른 클래스만 독점적으로 평가하지 않습니다. 즉, 모든 그룹의 참양성률과 거짓음성률이 동일해야 합니다.

균등화된 오즈는 단일 클래스 (양수 또는 음수)의 오류율에만 초점을 맞추는 기회의 균등과 관련이 있습니다.

예를 들어 Glubbdubdrib University에서 Lilliputians와 Brobdingnagians를 모두 엄격한 수학 프로그램에 입학시킨다고 가정해 보겠습니다. 릴리풋의 중등학교에서는 수학 수업의 강력한 커리큘럼을 제공하며, 대다수의 학생이 대학 프로그램에 적합합니다. 브로브딩나그의 중등학교에서는 수학 수업을 전혀 제공하지 않으므로 자격을 갖춘 학생이 훨씬 적습니다. 지원자가 소인국 사람인지 거인국 사람인지에 관계없이 자격이 있는 경우 프로그램에 입학할 가능성이 동일하고 자격이 없는 경우 거부될 가능성이 동일하다면 균등한 기회가 충족됩니다.

100명의 소인국인과 100명의 거인국인이 글럽덥드립 대학에 지원하고 입학 결정이 다음과 같이 내려진다고 가정해 보겠습니다.

표 3. 릴리풋 지원자 (90% 가 자격 요건을 충족함)

| 적격성 확인됨 | 자격 없음 | |

|---|---|---|

| 허용됨 | 45 | 2 |

| 거부됨 | 45 | 8 |

| 합계 | 90 | 10 |

|

자격 요건을 충족하는 학생의 합격률: 45/90 = 50% 자격 요건을 충족하지 않는 학생의 불합격률: 8/10 = 80% 릴리풋 학생의 총 합격률: (45+2)/100 = 47% |

||

표 4. 브로브딩나그 지원자 (10% 가 자격 요건을 충족함):

| 적격성 확인됨 | 자격 없음 | |

|---|---|---|

| 허용됨 | 5 | 18 |

| 거부됨 | 5 | 72 |

| 합계 | 10 | 90 |

|

자격 요건을 충족하는 학생 중 합격한 학생의 비율: 5/10 = 50% 자격 요건을 충족하지 않는 학생 중 불합격한 학생의 비율: 72/90 = 80% Brobdingnagian 학생 중 합격한 학생의 총 비율: (5+18)/100 = 23% |

||

자격 요건을 충족하는 소인국 학생과 거인국 학생 모두 입학할 확률이 50% 이고 자격 요건을 충족하지 않는 소인국 학생과 거인국 학생 모두 거부될 확률이 80% 이므로 균등한 기회가 충족됩니다.

균등화된 오즈는 '감독 학습의 기회 균등'에서 다음과 같이 공식적으로 정의됩니다. '예측 변수 Ŷ이 보호 속성 A 및 결과 Y와 관련하여 균등화된 오즈를 충족하는 경우는 Ŷ과 A가 Y에 따라 독립적인 경우입니다.'

평가

주로 LLM 평가의 약어로 사용됩니다. 평가는 더 광범위하게 모든 형태의 평가를 나타내는 약어입니다.

평가

모델의 품질을 측정하거나 서로 다른 모델을 비교하는 프로세스입니다.

지도 머신러닝 모델을 평가하려면 일반적으로 검증 세트 및 테스트 세트를 기준으로 판단합니다. LLM 평가에는 일반적으로 더 광범위한 품질 및 안전성 평가가 포함됩니다.

일치검색

모델의 출력이 정답 또는 참조 텍스트와 정확히 일치하거나 일치하지 않는 전무후무한 측정항목입니다. 예를 들어 정답이 orange인 경우 완전 일치를 충족하는 유일한 모델 출력은 orange입니다.

정확한 일치로 출력이 시퀀스(순위가 지정된 항목 목록)인 모델을 평가할 수도 있습니다. 일반적으로 일치검색을 위해서는 생성된 순위 목록이 그라운드 트루스와 정확히 일치해야 합니다. 즉, 두 목록의 각 항목이 동일한 순서여야 합니다. 하지만 정답이 여러 개의 올바른 시퀀스로 구성된 경우 정확한 일치에는 모델의 출력이 올바른 시퀀스 중 하나와 일치하기만 하면 됩니다.

Extreme Summarization (xsum)

단일 문서를 요약하는 LLM의 기능을 평가하기 위한 데이터 세트입니다. 데이터 세트의 각 항목은 다음으로 구성됩니다.

- 영국 방송 공사 (BBC)에서 작성한 문서입니다.

- 해당 문서의 한 문장 요약입니다.

자세한 내용은 세부정보는 필요 없고 요약만 알려 줘! Topic-Aware Convolutional Neural Networks for Extreme Summarization.

F

F1

정밀도와 재현율을 모두 사용하는 '롤업' 이진 분류 측정항목입니다. 공식은 다음과 같습니다.

공정성 측정항목

측정 가능한 '공정성'의 수학적 정의 일반적으로 사용되는 공정성 측정항목은 다음과 같습니다.

많은 공정성 측정항목은 상호 배타적입니다. 공정성 측정항목의 비호환성을 참고하세요.

거짓음성 (FN)

모델에서 네거티브 클래스로 잘못 예측한 예입니다. 예를 들어 모델에서 특정 이메일 메시지가 스팸이 아닌 것으로(네거티브 클래스) 예측했지만 해당 이메일 메시지가 실제로 스팸인 경우가 여기에 해당합니다.

거짓음성률

모델이 네거티브 클래스로 잘못 예측한 실제 포지티브 예의 비율입니다. 다음 공식은 거짓 음성 비율을 계산합니다.

자세한 내용은 머신러닝 단기집중과정의 기준점 및 혼동 행렬을 참고하세요.

거짓양성 (FP)

모델에서 포지티브 클래스로 잘못 예측한 예입니다. 예를 들어 모델에서 특정 이메일 메시지가 스팸 (포지티브 클래스)인 것으로 예측했지만 실제로는 스팸이 아닌 경우가 여기에 해당합니다.

자세한 내용은 머신러닝 단기집중과정의 기준점 및 혼동 행렬을 참고하세요.

거짓양성률 (FPR)

모델이 포지티브 클래스로 잘못 예측한 실제 네거티브 예의 비율입니다. 다음 공식은 거짓양성률을 계산합니다.

거짓양성률은 ROC 곡선의 x축입니다.

자세한 내용은 머신러닝 단기집중과정의 분류: ROC 및 AUC를 참고하세요.

특성 중요도

변수 중요도의 동의어입니다.

파운데이션 모델

방대하고 다양한 학습 세트로 학습된 매우 큰 사전 학습된 모델입니다. 파운데이션 모델은 다음을 모두 수행할 수 있습니다.

즉, 파운데이션 모델은 일반적인 의미에서 이미 매우 유능하지만 특정 작업에 더욱 유용하도록 추가로 맞춤설정할 수 있습니다.

성공 횟수의 비율

ML 모델의 생성된 텍스트를 평가하는 측정항목입니다. 성공 비율은 '성공' 생성 텍스트 출력 수를 생성된 총 텍스트 출력 수로 나눈 값입니다. 예를 들어 대규모 언어 모델이 코드 블록 10개를 생성했는데 그중 5개가 성공했다면 성공 비율은 50%입니다.

성공률은 통계 전반에서 광범위하게 유용하지만 ML에서는 이 측정항목이 주로 코드 생성이나 수학 문제와 같은 검증 가능한 작업을 측정하는 데 유용합니다.

G

gini 불순도

엔트로피와 유사한 측정항목입니다. 분할기는 지니 불순도 또는 엔트로피에서 파생된 값을 사용하여 분류 결정 트리의 조건을 구성합니다. 정보 획득은 엔트로피에서 파생됩니다. 지니 불순도에서 파생된 측정항목에 대해 보편적으로 허용되는 동등한 용어는 없습니다. 하지만 이 이름이 지정되지 않은 측정항목은 정보 획득만큼 중요합니다.

지니 불순도는 지니 계수 또는 간단히 지니라고도 합니다.

H

힌지 손실

각 학습 예제에서 최대한 멀리 떨어진 결정 경계를 찾아 예제와 경계 사이의 마진을 최대화하도록 설계된 분류용 손실 함수군입니다. KSVM은 힌지 손실을 사용하거나 제곱 힌지 손실 등의 관련 함수를 사용합니다. 이진 분류의 경우 힌지 손실 함수는 다음과 같이 정의됩니다.

여기서 y는 -1 또는 +1인 실제 라벨이고 y'는 분류 모델의 원시 출력입니다.

따라서 힌지 손실 대 (y * y') 그래프는 다음과 같습니다.

I

공정성 측정항목의 비호환성

일부 공정성 개념은 서로 호환되지 않으며 동시에 충족할 수 없다는 아이디어입니다. 따라서 모든 ML 문제에 적용할 수 있는 공정성을 정량화하는 단일 범용 측정항목은 없습니다.

이러한 결과가 실망스러울 수 있지만 공정성 측정항목의 비호환성이 공정성을 위한 노력이 헛되다는 의미는 아닙니다. 대신 공정성은 사용 사례에 특정한 피해를 방지한다는 목표를 가지고 주어진 ML 문제에 맞는 맥락 속에서 정의되어야 한다고 제안합니다.

공정성 측정항목의 비호환성에 관한 자세한 내용은 '공정성의 (불)가능성'을 참고하세요.

개별 공정성

유사한 개인이 유사하게 분류되는지 확인하는 공정성 측정항목입니다. 예를 들어 브로브딩나그 대학에서는 성적과 표준화된 시험 점수가 동일한 두 학생이 입학할 가능성이 동일하도록 하여 개인 공정성을 충족하려고 할 수 있습니다.

개별 공정성은 '유사성'(이 경우 성적 및 시험 점수)을 정의하는 방식에 전적으로 의존하며, 유사성 측정항목에 중요한 정보 (예: 학생의 커리큘럼의 엄격성)가 누락되면 새로운 공정성 문제가 발생할 수 있습니다.

개별 공정성에 관한 자세한 내용은 '인식을 통한 공정성'을 참고하세요.

정보 획득

결정 포레스트에서 노드의 엔트로피와 하위 노드의 엔트로피의 가중치 (예 수 기준) 합계 간의 차이입니다. 노드의 엔트로피는 해당 노드의 예시의 엔트로피입니다.

예를 들어 다음 엔트로피 값을 고려해 보세요.

- 상위 노드의 엔트로피 = 0.6

- 관련 예가 16개인 한 하위 노드의 엔트로피 = 0.2

- 관련 예가 24개인 다른 하위 노드의 엔트로피 = 0.1

따라서 예의 40% 는 한 하위 노드에 있고 60% 는 다른 하위 노드에 있습니다. 따라서 날짜는 다음과 같이 계산합니다.

- 가중 엔트로피 합계 = (0.4 * 0.2) + (0.6 * 0.1) = 0.14

따라서 정보 획득은 다음과 같습니다.

- 정보 획득 = 상위 노드의 엔트로피 - 하위 노드의 가중 엔트로피 합계

- 정보 획득 = 0.6 - 0.14 = 0.46

대부분의 분할기는 정보 획득을 극대화하는 조건을 만들려고 합니다.

평가자 간 동의

인간 평가자가 작업을 수행할 때 얼마나 자주 동의하는지를 측정한 값입니다. 평가자가 동의하지 않는 경우 작업 안내를 개선해야 할 수 있습니다. 평정자 간 동의 또는 평가자 간 신뢰성이라고도 합니다. 가장 널리 사용되는 평가자 간 동의 측정 방식 중 하나인 Cohen's kappa를 참고하세요.

자세한 내용은 머신러닝 단기집중과정의 범주형 데이터: 일반적인 문제를 참고하세요.

L

L1 손실

실제 라벨 값과 모델이 예측한 값 간의 차이의 절대값을 계산하는 손실 함수입니다. 예를 들어 예 5개의 배치에 대한 L1 손실 계산은 다음과 같습니다.

| 예의 실제 값 | 모델의 예측값 | 델타의 절댓값 |

|---|---|---|

| 7 | 6 | 1 |

| 5 | 4 | 1 |

| 8 | 11 | 3 |

| 4 | 6 | 2 |

| 9 | 8 | 1 |

| 8 = L1 손실 | ||

평균 절대 오차는 예시당 평균 L1 손실입니다.

자세한 내용은 머신러닝 단기집중과정의 선형 회귀: 손실을 참고하세요.

L2 손실

실제 라벨 값과 모델이 예측한 값 간의 차이 제곱을 계산하는 손실 함수입니다. 예를 들어 예 5개의 배치에 대한 L2 손실 계산은 다음과 같습니다.

| 예의 실제 값 | 모델의 예측값 | 델타의 제곱 |

|---|---|---|

| 7 | 6 | 1 |

| 5 | 4 | 1 |

| 8 | 11 | 9 |

| 4 | 6 | 4 |

| 9 | 8 | 1 |

| 16 = L2 손실 | ||

제곱으로 인해 L2 손실은 이상치의 영향을 증폭합니다. 즉, L2 손실은 L1 손실보다 잘못된 예측에 더 강하게 반응합니다. 예를 들어 이전 배치에 대한 L1 손실은 16이 아닌 8이 됩니다. 단일 이상치가 16개 중 9개를 차지합니다.

회귀 모델은 일반적으로 L2 손실을 손실 함수로 사용합니다.

평균 제곱 오차는 예시당 평균 L2 손실입니다. 제곱 손실은 L2 손실의 또 다른 이름입니다.

자세한 내용은 머신러닝 단기집중과정의 로지스틱 회귀: 손실 및 정규화를 참고하세요.

LLM 평가

대규모 언어 모델 (LLM)의 성능을 평가하기 위한 측정항목 및 벤치마크 세트입니다. 개략적으로 LLM 평가는 다음과 같습니다.

- 연구자가 LLM을 개선해야 하는 영역을 파악할 수 있도록 지원합니다.

- 다양한 LLM을 비교하고 특정 작업에 가장 적합한 LLM을 식별하는 데 유용합니다.

- LLM을 안전하고 윤리적으로 사용할 수 있도록 지원합니다.

자세한 내용은 머신러닝 단기집중과정의 대규모 언어 모델 (LLM)을 참고하세요.

손실

지도 모델의 학습 중에 모델의 예측이 라벨에서 얼마나 벗어났는지 나타내는 척도입니다.

손실 함수는 손실을 계산합니다.

자세한 내용은 머신러닝 단기집중과정의 선형 회귀: 손실을 참고하세요.

손실 함수

학습 또는 테스트 중에 예시 배치의 손실을 계산하는 수학 함수입니다. 손실 함수는 부정확한 예측을 하는 모델보다 정확한 예측을 하는 모델에 더 낮은 손실을 반환합니다.

학습의 목표는 일반적으로 손실 함수가 반환하는 손실을 최소화하는 것입니다.

다양한 종류의 손실 함수가 있습니다. 빌드 중인 모델의 종류에 적합한 손실 함수를 선택합니다. 예를 들면 다음과 같습니다.

M

행렬 분해

수학에서 내적이 대상 행렬에 근접한 행렬을 찾는 메커니즘입니다.

추천 시스템에서 타겟 행렬은 항목에 대한 사용자의 평점을 보유하는 경우가 많습니다. 예를 들어 영화 추천 시스템의 대상 행렬이 다음과 같이 표시될 수 있습니다. 여기서 양의 정수는 사용자 평점이고 0은 사용자가 해당 영화에 대해 평가하지 않은 것을 의미합니다.

| 카사블랑카 | 필라델피아 이야기 | 블랙 팬서 | 원더 우먼 | 펄프 픽션 | |

|---|---|---|---|---|---|

| 사용자 1 | 5.0 | 3.0 | 0.0 | 2.0 | 0.0 |

| 사용자 2 | 4.0 | 0.0 | 0.0 | 1.0 | 5.0 |

| 사용자 3 | 3.0 | 1.0 | 4.0 | 5.0 | 0.0 |

영화 추천 시스템은 평가되지 않은 영화에 대한 사용자 평점을 예측하는 것을 목표로 합니다. 예를 들어 사용자 1은 블랙 팬서를 좋아할까요?

추천 시스템에 대한 한 가지 접근법은 행렬 분해를 사용하여 다음 두 행렬을 생성하는 것입니다.

예를 들어 3명의 사용자와 5개 항목에 대한 행렬 분해를 사용하여 다음과 같은 사용자 행렬과 항목 행렬을 얻을 수 있습니다.

User Matrix Item Matrix 1.1 2.3 0.9 0.2 1.4 2.0 1.2 0.6 2.0 1.7 1.2 1.2 -0.1 2.1 2.5 0.5

사용자 행렬과 항목 행렬의 내적은 원래 사용자 평점과 각 사용자가 보지 않은 영화에 대한 예측을 포함하는 추천 행렬을 생성합니다. 예를 들어 카사블랑카에 대한 사용자 1의 평점(5.0)을 고려합니다. 추천 행렬에서 해당 셀에 해당하는 내적은 약 5.0이어야 하며 다음과 같습니다.

(1.1 * 0.9) + (2.3 * 1.7) = 4.9그렇다면 사용자 1은 블랙 팬서를 좋아할까요? 첫 번째 행과 세 번째 열에 해당하는 내적을 사용하여 예측 평점 4.3을 산출합니다.

(1.1 * 1.4) + (2.3 * 1.2) = 4.3행렬 분해는 일반적으로 대상 행렬보다 훨씬 간결한 사용자 행렬 및 항목 행렬을 생성합니다.

MBPP

Mostly Basic Python Problems의 약어입니다.

평균 절대 오차 (MAE)

L1 손실이 사용될 때 예시당 평균 손실입니다. 다음과 같이 평균 절대 오차를 계산합니다.

- 배치의 L1 손실을 계산합니다.

- L1 손실을 배치에 있는 예시 수로 나눕니다.

예를 들어 다음 5개 예시 배치에서 L1 손실을 계산하는 경우를 생각해 보겠습니다.

| 예의 실제 값 | 모델의 예측값 | 손실 (실제와 예측 간의 차이) |

|---|---|---|

| 7 | 6 | 1 |

| 5 | 4 | 1 |

| 8 | 11 | 3 |

| 4 | 6 | 2 |

| 9 | 8 | 1 |

| 8 = L1 손실 | ||

따라서 L1 손실은 8이고 예시 수는 5입니다. 따라서 평균 절대 오차는 다음과 같습니다.

Mean Absolute Error = L1 loss / Number of Examples Mean Absolute Error = 8/5 = 1.6

평균 제곱 오차 및 평균 제곱근 오차와 평균 절대 오차를 비교합니다.

k에서의 평균 정밀도 (mAP@k)

검증 데이터 세트에서 모든 k에서의 평균 정밀도 점수의 통계적 평균입니다. k에서의 평균 정밀도의 한 가지 용도는 추천 시스템에서 생성된 추천의 품질을 판단하는 것입니다.

'평균 평균'이라는 문구가 중복되는 것처럼 들리지만 측정항목의 이름은 적절합니다. 결국 이 측정항목은 여러 k에서의 평균 정밀도 값의 평균을 구합니다.

평균 제곱 오차 (MSE)

L2 손실이 사용될 때 예시당 평균 손실입니다. 다음과 같이 평균 제곱 오차를 계산합니다.

- 배치의 L2 손실을 계산합니다.

- L2 손실을 배치에 있는 예시 수로 나눕니다.

예를 들어 다음 5개 예시 배치에서 손실을 고려해 보겠습니다.

| 실제 금액 | 모델의 예측 | 손실 | 제곱 손실 |

|---|---|---|---|

| 7 | 6 | 1 | 1 |

| 5 | 4 | 1 | 1 |

| 8 | 11 | 3 | 9 |

| 4 | 6 | 2 | 4 |

| 9 | 8 | 1 | 1 |

| 16 = L2 손실 | |||

따라서 평균 제곱 오차는 다음과 같습니다.

Mean Squared Error = L2 loss / Number of Examples Mean Squared Error = 16/5 = 3.2

평균 제곱 오차는 특히 선형 회귀에서 널리 사용되는 학습 최적화 프로그램입니다.

평균 절대 오차 및 평균 제곱근 오차와 평균 제곱 오차를 비교합니다.

TensorFlow Playground에서는 평균 제곱 오차를 사용하여 손실 값을 계산합니다.

측정항목

관심 있는 통계입니다.

목표는 머신러닝 시스템이 최적화하려고 하는 측정항목입니다.

측정항목 API (tf.metrics)

모델 평가를 위한 TensorFlow API입니다. 예를 들어 tf.metrics.accuracy는 모델의 예측이 라벨과 일치하는 빈도를 결정합니다.

minimax loss

생성된 데이터와 실제 데이터의 분포 간 교차 엔트로피를 기반으로 하는 생성적 적대 네트워크의 손실 함수입니다.

미니맥스 손실은 첫 번째 논문에서 생성적 적대적 네트워크를 설명하는 데 사용됩니다.

자세한 내용은 생성적 적대 네트워크 과정의 손실 함수를 참고하세요.

모델 용량

모델이 학습할 수 있는 문제의 복잡성입니다. 모델이 학습할 수 있는 문제가 복잡할수록 모델 용량은 더 큽니다. 일반적으로 모델의 매개변수 수가 많을수록 모델 용량은 더 커집니다. 분류 모델 용량의 공식 정의는 VC 차원을 참고하세요.

모멘텀

학습 단계가 현재 단계의 도함수뿐만 아니라 바로 이전 단계의 도함수에도 의존하는 정교한 경사하강법 알고리즘입니다. 모멘텀은 물리학의 모멘텀과 유사하게 시간에 따른 그라데이션의 지수 가중 이동 평균을 계산하는 것을 포함합니다. 모멘텀은 학습이 국소 최솟값에 갇히는 것을 방지하는 데 도움이 됩니다.

Mostly Basic Python Problems (MBPP)

LLM의 Python 코드 생성 능력을 평가하기 위한 데이터 세트입니다. Mostly Basic Python Problems에는 크라우드소싱된 프로그래밍 문제가 약 1,000개 포함되어 있습니다. 데이터 세트의 각 문제에는 다음이 포함됩니다.

- 작업 설명

- 솔루션 코드

- 3개의 자동 테스트 사례

N

음성 클래스

이진 분류에서는 클래스 중 하나는 포지티브로, 다른 하나는 네거티브로 규정됩니다. 포지티브 클래스는 모델에서 테스트하는 대상 또는 이벤트이고, 네거티브 클래스는 그와 다른 가능성입니다. 예를 들면 다음과 같습니다.

- 의료 검사의 네거티브 클래스는 '종양 아님'일 수 있습니다.

- 이메일 분류 모델의 네거티브 클래스는 '스팸 아님'일 수 있습니다.

포지티브 클래스와 대비되는 개념입니다.

O

목표

알고리즘에서 최적화하려는 측정항목입니다.

목표 함수

모델이 최적화하고자 하는 수학 공식 또는 측정항목입니다. 예를 들어 선형 회귀의 목적 함수는 일반적으로 평균 제곱 손실입니다. 따라서 선형 회귀 모델을 학습시킬 때 학습의 목표는 평균 제곱 손실을 최소화하는 것입니다.

목표 함수를 최대화하는 것이 목표인 경우도 있습니다. 예를 들어 목표 함수가 정확도인 경우 목표는 정확도를 최대화하는 것입니다.

손실도 참고하세요.

P

k에서 통과 (pass@k)

대규모 언어 모델이 생성하는 코드 (예: Python)의 품질을 판단하는 측정항목입니다. 더 구체적으로 말하면 통과 비율 k는 생성된 k개의 코드 블록 중 하나 이상이 모든 단위 테스트를 통과할 가능성을 나타냅니다.

대규모 언어 모델은 복잡한 프로그래밍 문제에 적합한 코드를 생성하는 데 어려움을 겪는 경우가 많습니다. 소프트웨어 엔지니어는 대규모 언어 모델에 동일한 문제에 대한 여러 (k) 솔루션을 생성하도록 프롬프트를 표시하여 이 문제에 적응합니다. 그런 다음 소프트웨어 엔지니어가 단위 테스트를 기반으로 각 솔루션을 테스트합니다. k에서의 합격 계산은 단위 테스트 결과에 따라 달라집니다.

- 이러한 해결 방법 중 하나 이상이 단위 테스트를 통과하면 LLM이 해당 코드 생성 챌린지를 통과합니다.

- 솔루션 중 단위 테스트를 통과하는 솔루션이 없으면 LLM이 해당 코드 생성 챌린지에서 실패합니다.

k에서의 통과 비율 공식은 다음과 같습니다.

\[\text{pass at k} = \frac{\text{total number of passes}} {\text{total number of challenges}}\]

일반적으로 k 값이 높을수록 k에서 통과 점수가 높아집니다. 하지만 k 값이 높을수록 더 많은 대규모 언어 모델 및 단위 테스트 리소스가 필요합니다.

performance

다음과 같은 의미로 중복 정의된 용어입니다.

- 소프트웨어 공학에서 보편적으로 사용되는 의미입니다. 즉, 특정 소프트웨어가 얼마나 빠르게 또는 효율적으로 실행되는지를 의미합니다.

- 머신러닝에서의 의미 여기서 성능은 모델이 얼마나 정확한지라는 질문에 대한 답입니다. 즉, 모델의 예측이 얼마나 효과적인지를 나타냅니다.

순열 변수 중요도

특성의 값을 순열한 후 모델의 예측 오류 증가를 평가하는 변수 중요도의 한 유형입니다. 순열 변수 중요도는 모델에 종속되지 않는 측정항목입니다.

퍼플렉시티

모델의 작업 수행 능력을 나타내는 척도입니다. 예를 들어 사용자가 휴대전화 키보드에 입력하는 단어의 처음 몇 글자를 읽고 가능한 완성 단어 목록을 제공하는 것이 작업이라고 가정해 보겠습니다. 이 작업의 혼란도 P는 사용자가 입력하려고 하는 실제 단어가 목록에 포함되도록 제공해야 하는 추측 수와 대략적으로 같습니다.

퍼플렉시티와 교차 엔트로피의 관계는 다음과 같습니다.

양성 클래스

테스트할 클래스입니다.

예를 들어 암 모델의 포지티브 클래스는 '종양'일 수 있습니다. 이메일 분류 모델의 포지티브 클래스는 '스팸'일 수 있습니다.

네거티브 클래스와 대비되는 개념입니다.

PR AUC (PR 곡선 아래 영역)

다양한 분류 임계값에 대해 (재현율, 정밀도) 점을 표시하여 얻은 보간된 정밀도-재현율 곡선 아래의 면적입니다.

precision

분류 모델과 관련해 다음과 같은 의문에 답하는 측정항목입니다.

모델이 포지티브 클래스를 예측한 경우 예측의 몇 퍼센트가 올바른가요?

공식은 다음과 같습니다.

각 항목의 의미는 다음과 같습니다.

- 참양성은 모델이 포지티브 클래스를 정확하게 예측했음을 의미합니다.

- 거짓양성은 모델이 포지티브 클래스를 잘못 예측했음을 의미합니다.

예를 들어 모델에서 200개의 포지티브 예측을 했다고 가정해 보겠습니다. 이 200개의 긍정적 예측 중

- 150개가 참양성이었습니다.

- 50건은 거짓양성이었습니다.

이 경우에는 다음과 같습니다.

자세한 내용은 머신러닝 단기집중과정의 분류: 정확도, 재현율, 정밀도 및 관련 측정항목을 참고하세요.

k에서의 정밀도 (precision@k)

순위가 지정된 (정렬된) 항목 목록을 평가하는 측정항목입니다. k에서의 정밀도는 목록의 처음 k개 항목 중 '관련성'이 있는 항목의 비율을 나타냅니다. 이는 다음과 같은 의미입니다.

\[\text{precision at k} = \frac{\text{relevant items in first k items of the list}} {\text{k}}\]

k 값은 반환된 목록의 길이보다 작거나 같아야 합니다. 반환된 목록의 길이는 계산에 포함되지 않습니다.

관련성은 주관적인 경우가 많습니다. 전문가 인간 평가자조차 어떤 항목이 관련성이 있는지에 대해 의견이 일치하지 않는 경우가 많습니다.

비교 대상:

정밀도-재현율 곡선

다양한 분류 임곗값에서 정밀도와 재현율을 비교한 곡선입니다.

예측 편향

예측의 평균이 데이터 세트의 라벨 평균과 얼마나 떨어져 있는지를 나타내는 값입니다.

머신러닝 모델의 바이어스 항 또는 윤리학 및 공정성의 편향과 혼동하지 마시기 바랍니다.

예측 패리티

특정 분류 모델의 경우 고려 중인 하위 그룹의 정밀도 비율이 동일한지 확인하는 공정성 측정항목입니다.

예를 들어 대학 합격을 예측하는 모델의 정밀도 비율이 릴리풋인과 브로브딩나그인에 대해 동일한 경우 국적에 대한 예측 패리티가 충족됩니다.

예측 패리티를 예측 비율 패리티라고도 합니다.

예측 패리티에 관한 자세한 내용은 '공정성 정의 설명' (섹션 3.2.1)을 참고하세요.

예측 요금 동등성

예측 패리티의 또 다른 이름입니다.

확률 밀도 함수

정확히 특정 값을 갖는 데이터 샘플의 빈도를 식별하는 함수입니다. 데이터 세트의 값이 연속 부동 소수점 숫자인 경우 정확한 일치가 거의 발생하지 않습니다. 하지만 x에서 y까지의 확률 밀도 함수를 통합하면 x와 y 사이의 데이터 샘플의 예상 빈도가 산출됩니다.

예를 들어 평균이 200이고 표준 편차가 30인 정규 분포를 생각해 보세요. 211.4~218.7 범위에 속하는 데이터 샘플의 예상 빈도를 확인하려면 211.4~218.7 범위의 정규 분포에 대한 확률 밀도 함수를 통합하면 됩니다.

R

상식적 추론 데이터 세트 (ReCoRD)를 사용한 독해

상식적 추론을 수행하는 LLM의 능력을 평가하는 데이터 세트입니다. 데이터 세트의 각 예시에는 세 가지 구성요소가 포함됩니다.

- 뉴스 기사의 단락 1~2개

- 본문에서 명시적 또는 암시적으로 식별된 항목 중 하나가 마스킹된 질문입니다.

- 답변 (마스크에 속하는 항목의 이름)

다양한 예는 ReCoRD를 참고하세요.

ReCoRD는 SuperGLUE 앙상블의 구성요소입니다.

RealToxicityPrompts

유해한 콘텐츠가 포함될 수 있는 문장 시작 부분의 집합이 포함된 데이터 세트입니다. 이 데이터 세트를 사용하여 문장을 완성하는 유해하지 않은 텍스트를 생성하는 LLM의 능력을 평가하세요. 일반적으로 Perspective API를 사용하여 LLM이 이 작업을 얼마나 잘 수행했는지 확인합니다.

자세한 내용은 RealToxicityPrompts: Evaluating Neural Toxic Degeneration in Language Models를 참고하세요.

recall

분류 모델과 관련해 다음과 같은 의문에 답하는 측정항목입니다.

그라운드 트루스가 포지티브 클래스인 경우 모델이 포지티브 클래스로 올바르게 식별한 예측의 비율은 얼마인가요?

공식은 다음과 같습니다.

\[\text{Recall} = \frac{\text{true positives}} {\text{true positives} + \text{false negatives}} \]

각 항목의 의미는 다음과 같습니다.

- 참양성은 모델이 포지티브 클래스를 정확하게 예측했음을 의미합니다.

- 거짓음성은 모델이 네거티브 클래스를 잘못 예측했음을 의미합니다.

예를 들어 모델이 정답이 포지티브 클래스인 예시에 대해 200개의 예측을 했다고 가정해 보겠습니다. 이 200개의 예측 중

- 180개가 참양성이었습니다.

- 20건은 거짓음성이었습니다.

이 경우에는 다음과 같습니다.

\[\text{Recall} = \frac{\text{180}} {\text{180} + \text{20}} = 0.9 \]

자세한 내용은 분류: 정확도, 재현율, 정밀도 및 관련 측정항목을 참고하세요.

k에서의 재현율 (recall@k)

순위가 지정된 (정렬된) 항목 목록을 출력하는 시스템을 평가하는 측정항목입니다. k에서의 재현율은 반환된 관련 항목의 총수 중에서 목록의 처음 k개 항목에 있는 관련 항목의 비율을 나타냅니다.

\[\text{recall at k} = \frac{\text{relevant items in first k items of the list}} {\text{total number of relevant items in the list}}\]

k에서의 정밀도와 대비되는 개념입니다.

텍스트 내포 관계 인식 (RTE)

텍스트 문장에서 가설을 수반 (논리적으로 도출)할 수 있는지 여부를 판단하는 LLM의 능력을 평가하기 위한 데이터 세트입니다. RTE 평가의 각 예시는 다음 세 부분으로 구성됩니다.

- 일반적으로 뉴스 또는 Wikipedia 문서에서 가져온 구절

- 가설

- 정답은 다음 중 하나입니다.

- 참입니다. 즉, 가설이 지문에서 수반될 수 있습니다.

- False, 즉 가설이 본문에서 수반될 수 없음을 의미합니다.

예를 들면 다음과 같습니다.

- 지문: 유로는 유럽 연합의 통화입니다.

- 가설: 프랑스에서는 유로를 통화로 사용합니다.

- 함의: 프랑스는 유럽 연합에 속하므로 참입니다.

RTE는 SuperGLUE 앙상블의 구성요소입니다.

ReCoRD

상식적 추론 데이터 세트를 사용한 독해의 약어입니다.

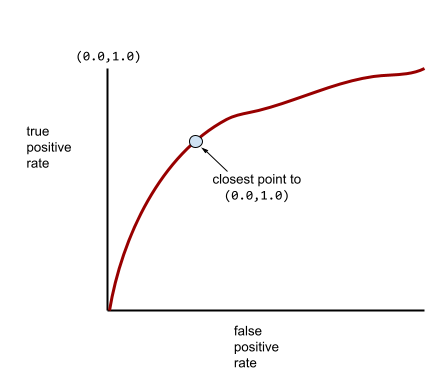

수신자 조작 특성 곡선 (ROC curve, Receiver Operating Characteristic curve)

이진 분류에서 다양한 분류 임곗값에 대한 참양성률과 거짓양성률의 그래프입니다.

ROC 곡선의 모양은 이진 분류 모델이 포지티브 클래스와 네거티브 클래스를 구분하는 능력을 나타냅니다. 예를 들어 이진 분류 모델이 모든 음성 클래스를 모든 양성 클래스와 완벽하게 구분한다고 가정해 보겠습니다.

위 모델의 ROC 곡선은 다음과 같습니다.

반면 다음 그림은 부정 클래스를 긍정 클래스와 전혀 구분할 수 없는 형편없는 모델의 원시 로지스틱 회귀 값을 그래프로 나타냅니다.

이 모델의 ROC 곡선은 다음과 같습니다.

한편 실제 세계에서는 대부분의 이진 분류 모델이 포지티브 클래스와 네거티브 클래스를 어느 정도 구분하지만 완벽하지는 않습니다. 따라서 일반적인 ROC 곡선은 두 극단 사이에 있습니다.

이론적으로 ROC 곡선에서 (0.0,1.0)에 가장 가까운 점은 이상적인 분류 임곗값을 나타냅니다. 하지만 이상적인 분류 기준점을 선택하는 데 영향을 미치는 다른 실제 문제가 몇 가지 있습니다. 예를 들어 거짓음성이 거짓양성보다 훨씬 더 큰 고통을 유발할 수 있습니다.

AUC라는 수치 측정항목은 ROC 곡선을 단일 부동 소수점 값으로 요약합니다.

평균 제곱근 오차(RMSE)

평균 제곱 오차의 제곱근입니다.

ROUGE(Recall-Oriented Understudy for Gisting Evaluation)

자동 요약 및 기계 번역 모델을 평가하는 측정항목 계열입니다. ROUGE 측정항목은 참조 텍스트가 ML 모델의 생성된 텍스트와 얼마나 중복되는지 결정합니다. ROUGE 패밀리의 각 구성원은 서로 다른 방식으로 중복을 측정합니다. ROUGE 점수가 높을수록 참조 텍스트와 생성된 텍스트 간의 유사성이 낮을수록 높습니다.

각 ROUGE 계열 구성원은 일반적으로 다음 측정항목을 생성합니다.

- 정밀도

- 재현율

- F1

자세한 내용과 예는 다음을 참고하세요.

ROUGE-L

참조 텍스트와 생성된 텍스트의 최장 공통 부분 수열 길이에 중점을 둔 ROUGE 계열의 측정항목입니다. 다음 공식은 ROUGE-L의 재현율과 정밀도를 계산합니다.

그런 다음 F1을 사용하여 ROUGE-L 재현율과 ROUGE-L 정밀도를 단일 측정항목으로 롤업할 수 있습니다.

ROUGE-L은 참조 텍스트와 생성된 텍스트의 줄바꿈을 무시하므로 최장 공통 부분 수열이 여러 문장을 교차할 수 있습니다. 참조 텍스트와 생성된 텍스트에 여러 문장이 포함된 경우 일반적으로 ROUGE-Lsum이라는 ROUGE-L 변형이 더 나은 측정항목입니다. ROUGE-Lsum은 지문의 각 문장의 최장 공통 부분 수열을 결정한 다음 이러한 최장 공통 부분 수열의 평균을 계산합니다.

ROUGE-N

참조 텍스트와 생성된 텍스트의 특정 크기로 공유된 N-그램을 비교하는 ROUGE 패밀리 내의 측정항목 집합입니다. 예를 들면 다음과 같습니다.

- ROUGE-1은 참조 텍스트와 생성된 텍스트에서 공유된 토큰 수를 측정합니다.

- ROUGE-2는 참조 텍스트와 생성된 텍스트에서 공유된 바이그램 (2-그램)의 수를 측정합니다.

- ROUGE-3은 참조 텍스트와 생성된 텍스트에서 공유된 트라이그램 (3그램)의 수를 측정합니다.

다음 수식을 사용하여 ROUGE-N 계열의 모든 구성원에 대한 ROUGE-N 재현율과 ROUGE-N 정밀도를 계산할 수 있습니다.

그런 다음 F1을 사용하여 ROUGE-N 재현율과 ROUGE-N 정밀도를 단일 측정항목으로 집계할 수 있습니다.

ROUGE-S

skip-gram 일치를 지원하는 ROUGE-N의 관대한 형태입니다. 즉, ROUGE-N은 정확하게 일치하는 N-그램만 계산하지만 ROUGE-S는 하나 이상의 단어로 구분된 N-그램도 계산합니다. 예를 들어 다음 사항을 고려해 보세요.

ROUGE-N을 계산할 때 2-그램인 흰 구름은 흰 뭉게구름과 일치하지 않습니다. 하지만 ROUGE-S를 계산할 때는 흰 구름이 흰 뭉게구름과 일치합니다.

R 제곱

라벨의 변동이 개별 특성 또는 특성 세트로 인해 발생하는 정도를 나타내는 회귀 측정항목입니다. R 제곱은 0과 1 사이의 값으로, 다음과 같이 해석할 수 있습니다.

- R 제곱이 0이면 라벨의 변동이 기능 세트로 인한 것이 아님을 의미합니다.

- R 제곱이 1이면 라벨의 모든 변동이 기능 세트 때문임을 의미합니다.

- 0~1 사이의 R 제곱은 특정 특성 또는 특성 세트에서 라벨의 변동을 예측할 수 있는 정도를 나타냅니다. 예를 들어 R 제곱이 0.10이면 라벨의 분산 중 10%가 특성 세트로 인한 것이고, R 제곱이 0.20이면 20%가 특성 세트로 인한 것입니다.

R 제곱은 모델이 예측한 값과 그라운드 트루스 간의 피어슨 상관 계수의 제곱입니다.

RTE

Recognizing Textual Entailment의 약어입니다.

S

점수 매기기

후보 생성 단계에서 생성된 각 항목에 값을 제공하거나 순위를 지정하는 추천 시스템의 일부입니다.

유사도 측정

클러스터링 알고리즘에서 두 예의 유사성을 측정하는 데 사용되는 측정항목입니다.

희소성

벡터 또는 행렬에서 0 (또는 null)으로 설정된 요소 수를 해당 벡터 또는 행렬의 총 항목 수로 나눈 값입니다. 예를 들어 98개의 셀에 0이 포함된 100개 요소 행렬을 생각해 보세요. 희소성 계산은 다음과 같습니다.

특성 희소성은 특성 벡터의 희소성을 나타내고 모델 희소성은 모델 가중치의 희소성을 나타냅니다.

SQuAD

SQuAD: 100,000+ Questions for Machine Comprehension of Text 논문에 소개된 Stanford Question Answering Dataset의 약어입니다. 이 데이터 세트의 질문은 Wikipedia 문서에 관해 질문하는 사람들의 질문에서 가져온 것입니다. SQuAD의 일부 질문에는 답변이 있지만 다른 질문에는 의도적으로 답변이 없습니다. 따라서 SQuAD를 사용하여 다음 두 가지 작업을 수행하는 LLM의 능력을 평가할 수 있습니다.

- 답변할 수 있는 질문에 답변합니다.

- 답변할 수 없는 질문을 식별합니다.

F1과 함께 일치검색은 LLM을 SQuAD에 대해 평가하는 데 가장 일반적으로 사용되는 측정항목입니다.

제곱 힌지 손실

힌지 손실의 제곱입니다. 제곱 힌지 손실은 일반 힌지 손실보다 이상치에 더 가혹한 페널티를 적용합니다.

제곱 손실

L2 손실의 동의어입니다.

SuperGLUE

LLM의 텍스트 이해 및 생성 전반적인 능력을 평가하기 위한 데이터 세트 앙상블입니다. 앙상블은 다음 데이터 세트로 구성됩니다.

- 불리언 질문 (BoolQ)

- CommitmentBank (CB)

- 가능한 대안 선택 (COPA)

- 다중 문장 독해 (MultiRC)

- 상식 추론 데이터 세트 (ReCoRD)를 사용한 독해

- 텍스트 내포 관계 인식 (RTE)

- 문맥 속 단어 (WiC)

- Winograd Schema Challenge (WSC)

자세한 내용은 SuperGLUE: 범용 언어 이해 시스템을 위한 더 강력한 벤치마크를 참고하세요.

T

테스트 손실

테스트 세트에 대한 모델의 손실을 나타내는 측정항목입니다. 모델을 빌드할 때는 일반적으로 테스트 손실을 최소화하려고 합니다. 테스트 손실이 낮을수록 학습 손실 또는 검증 손실이 낮을 때보다 품질 신호가 더 강하기 때문입니다.

테스트 손실과 학습 손실 또는 검증 손실 간의 큰 격차는 정규화 비율을 늘려야 함을 나타낼 수 있습니다.

top-k 정확도

생성된 목록의 처음 k개 위치에 '타겟 라벨'이 표시되는 횟수의 비율입니다. 목록은 맞춤 추천 또는 softmax로 정렬된 항목 목록일 수 있습니다.

상위 k 정확도는 k에서의 정확도라고도 합니다.

유해

콘텐츠가 악용적이거나, 위협적이거나, 불쾌감을 주는 정도 많은 머신러닝 모델이 유해성을 식별, 측정, 분류할 수 있습니다. 이러한 모델 대부분은 욕설 수준, 위협적인 언어 수준 등 여러 매개변수에 따라 유해성을 식별합니다.

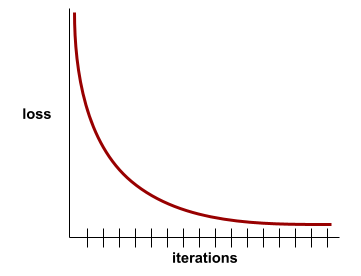

학습 손실

특정 학습 반복 중에 모델의 손실을 나타내는 측정항목입니다. 예를 들어 손실 함수가 평균 제곱 오차라고 가정해 보겠습니다. 예를 들어 10번째 반복의 학습 손실 (평균 제곱 오차)이 2.2이고 100번째 반복의 학습 손실이 1.9일 수 있습니다.

손실 곡선은 학습 손실과 반복 수를 비교하여 표시합니다. 손실 곡선은 학습에 관한 다음과 같은 힌트를 제공합니다.

- 하향 경사는 모델이 개선되고 있음을 의미합니다.

- 위쪽으로 기울어지면 모델이 나빠지고 있음을 의미합니다.

- 경사가 평평하다는 것은 모델이 수렴에 도달했음을 의미합니다.

예를 들어 다음은 다소 이상적인 손실 곡선을 보여줍니다.

- 초기 반복 중에 급격한 하향 경사: 모델이 빠르게 개선됨을 의미합니다.

- 학습이 끝날 때까지 점차 평탄해지지만 여전히 하향하는 경사로, 이는 초기 반복보다 약간 느린 속도로 모델이 계속 개선됨을 의미합니다.

- 학습이 끝날 때 평평한 기울기(수렴을 나타냄)

학습 손실도 중요하지만 일반화도 참고하세요.

상식 질문 답변

LLM의 상식 질문 답변 능력을 평가하는 데 사용되는 데이터 세트입니다. 각 데이터 세트에는 퀴즈 애호가가 작성한 질문-답변 쌍이 포함되어 있습니다. 다양한 데이터 세트는 다음과 같은 다양한 소스를 기반으로 합니다.

- 웹 검색 (TriviaQA)

- 위키백과 (TriviaQA_wiki)

자세한 내용은 TriviaQA: A Large Scale Distantly Supervised Challenge Dataset for Reading Comprehension을 참고하세요.

참음성 (TN, true negative)

모델에서 네거티브 클래스를 올바르게 예측한 예입니다. 예를 들어 모델에서 특정 이메일 메시지가 스팸이 아닌 것으로 추론했으며 실제로도 스팸이 아닌 경우가 여기에 해당합니다.

참양성 (TP)

모델에서 포지티브 클래스로 올바르게 예측한 예입니다. 예를 들어 모델에서 특정 이메일 메시지가 스팸인 것으로 추론했으며 실제로도 스팸이었던 경우가 여기에 해당합니다.

참양성률 (TPR)

재현율의 동의어입니다. 이는 다음과 같은 의미입니다.

참양성률은 ROC 곡선의 y축입니다.

Typologically Diverse Question Answering (TyDi QA)

LLM의 질문 응답 능력을 평가하기 위한 대규모 데이터 세트입니다. 데이터 세트에는 여러 언어로 된 질문과 답변 쌍이 포함되어 있습니다.

자세한 내용은 TyDi QA: A Benchmark for Information-Seeking Question Answering in Typologically Diverse Languages를 참고하세요.

V

검증 손실

학습의 특정 반복 중에 검증 세트에 대한 모델의 손실을 나타내는 측정항목입니다.

일반화 곡선도 참고하세요.

변수 중요도

모델에 대한 각 특성의 상대적 중요도를 나타내는 점수 집합입니다.

예를 들어 주택 가격을 추정하는 결정 트리를 생각해 보세요. 이 결정 트리에서 크기, 연령, 스타일의 세 가지 특징을 사용한다고 가정해 보겠습니다. 세 가지 특징의 변수 중요도가 {size=5.8, age=2.5, style=4.7}로 계산되면 크기가 연령이나 스타일보다 의사결정 트리에 더 중요합니다.

다양한 변수 중요도 측정항목이 있으며, 이를 통해 ML 전문가에게 모델의 다양한 측면에 관한 정보를 제공할 수 있습니다.

W

Wasserstein 손실

생성적 적대 네트워크에서 일반적으로 사용되는 손실 함수 중 하나로, 생성된 데이터와 실제 데이터의 분포 간 지구 이동기 거리를 기반으로 합니다.

WiC

Words in Context의 약어입니다.

WikiLingua (wiki_lingua)

LLM의 짧은 기사 요약 능력을 평가하기 위한 데이터 세트입니다. 다양한 작업을 수행하는 방법을 설명하는 문서 백과사전인 WikiHow는 문서와 요약 모두의 인간 작성 소스입니다. 데이터 세트의 각 항목은 다음으로 구성됩니다.

- 번호가 매겨진 목록의 산문 (단락) 버전의 각 단계를 각 단계의 시작 문장을 제외하고 추가하여 생성된 문서입니다.

- 번호가 매겨진 목록에 있는 각 단계의 첫 문장으로 구성된 문서의 요약입니다.

자세한 내용은 WikiLingua: A New Benchmark Dataset for Cross-Lingual Abstractive Summarization을 참고하세요.

Winograd Schema Challenge (WSC)

대명사가 참조하는 명사구를 결정하는 LLM의 능력을 평가하기 위한 형식 (또는 해당 형식을 준수하는 데이터 세트)입니다.

Winograd Schema Challenge의 각 항목은 다음으로 구성됩니다.

- 타겟 대명사가 포함된 짧은 문구

- 대상 대명사

- 후보 명사구와 정답 (불리언)이 차례로 나옵니다. 타겟 대명사가 이 후보자를 가리키면 대답은 True입니다. 타겟 대명사가 이 후보자를 가리키지 않으면 대답은 False입니다.

예를 들면 다음과 같습니다.

- 구절: 마크는 자신에 대해 많은 거짓말을 피트에게 말했고, 피트는 이를 자신의 책에 포함했습니다. 그는 더 솔직했어야 했습니다.

- 대상 인칭 대명사: He

- 후보 명사구:

- 마크: 타겟 대명사가 마크를 가리키므로 True

- 피트: 거짓. 타겟 대명사가 피트를 가리키지 않기 때문입니다.

Winograd Schema Challenge는 SuperGLUE 앙상블의 구성요소입니다.

문맥 속 단어 (WiC)

LLM이 컨텍스트를 사용하여 의미가 여러 개인 단어를 얼마나 잘 이해하는지 평가하기 위한 데이터 세트입니다. 데이터 세트의 각 항목에는 다음이 포함됩니다.

- 타겟 단어가 포함된 두 문장

- 타겟 단어

- 정답 (불리언)입니다. 여기서

- True는 타겟 단어가 두 문장에서 동일한 의미를 갖는다는 뜻입니다.

- False는 타겟 단어가 두 문장에서 의미가 다름을 의미합니다.

예를 들면 다음과 같습니다.

- 두 문장:

- 강바닥에 쓰레기가 많이 있습니다.

- 잘 때 침대 옆에 물 한 잔을 둡니다.

- 타겟 단어: 침대

- 정답: 거짓. 두 문장에서 타겟 단어의 의미가 다르기 때문입니다.

자세한 내용은 WiC: the Word-in-Context Dataset for Evaluating Context-Sensitive Meaning Representations를 참고하세요.

Words in Context는 SuperGLUE 앙상블의 구성요소입니다.

WSC

Winograd Schema Challenge의 약어입니다.

X

XL-Sum (xlsum)

텍스트 요약에 대한 LLM의 숙련도를 평가하기 위한 데이터 세트입니다. XL-Sum은 다양한 언어로 항목을 제공합니다. 데이터 세트의 각 항목에는 다음이 포함됩니다.

- 영국 방송 공사 (BBC)에서 가져온 기사입니다.

- 기사 작성자가 작성한 기사의 요약입니다. 요약에는 기사에 없는 단어나 구문이 포함될 수 있습니다.

자세한 내용은 XL-Sum: 44개 언어를 위한 대규모 다국어 추출 요약을 참고하세요.