במילון המונחים הזה מוגדרים מונחים שקשורים לבינה מלאכותית.

A

אבלציה

טכניקה להערכת החשיבות של תכונה או רכיב על ידי הסרה זמנית של התכונה או הרכיב ממודל. לאחר מכן, מאמנים מחדש את המודל בלי התכונה או הרכיב האלה. אם הביצועים של המודל שאומן מחדש גרועים משמעותית, סביר להניח שהתכונה או הרכיב שהוסרו היו חשובים.

לדוגמה, נניח שאימנתם מודל סיווג על 10 מאפיינים והשגתם 88% דיוק בקבוצת נתונים לבדיקה. כדי לבדוק את החשיבות של התכונה הראשונה, אפשר לאמן מחדש את המודל באמצעות תשע התכונות האחרות בלבד. אם הביצועים של המודל שאומן מחדש גרועים משמעותית (לדוגמה, דיוק של פחות מ-55%), כנראה שהתכונה שהוסרה הייתה חשובה. לעומת זאת, אם המודל שאומן מחדש מניב ביצועים טובים באותה מידה, כנראה שהתכונה הזו לא הייתה חשובה במיוחד.

הסרת תכונות יכולה לעזור גם לקבוע את החשיבות של:

- רכיבים גדולים יותר, כמו מערכת משנה שלמה של מערכת ML גדולה יותר

- תהליכים או טכניקות, כמו שלב של עיבוד מקדים של נתונים

בשני המקרים, תוכלו לראות איך הביצועים של המערכת משתנים (או לא משתנים) אחרי שתסירו את הרכיב.

A/B Testing

דרך סטטיסטית להשוואה בין שתי טכניקות (או יותר) – A ו-B. בדרך כלל, A היא טכניקה קיימת ו-B היא טכניקה חדשה. בדיקת A/B לא רק קובעת איזו טכניקה מניבה ביצועים טובים יותר, אלא גם אם ההבדל מובהק מבחינה סטטיסטית.

בדרך כלל, בבדיקות A/B משווים מדד יחיד בין שתי טכניקות. לדוגמה, מהי ההשוואה בין הדיוק של מודל בין שתי טכניקות? עם זאת, בדיקות A/B יכולות גם להשוות בין מספר סופי כלשהו של מדדים.

צ'יפ של פעולה שכיחה

קטגוריה של רכיבי חומרה מיוחדים שנועדו לבצע חישובים של מפתחות שנדרשים לאלגוריתמים של למידה עמוקה.

שבבי האצה (או בקיצור מאיצים) יכולים להגדיל באופן משמעותי את המהירות והיעילות של משימות אימון והסקת מסקנות בהשוואה למעבד למטרות כלליות. הם אידיאליים לאימון רשתות עצביות ולמשימות דומות שדורשות הרבה כוח מחשוב.

דוגמאות לשבבי האצה:

- יחידות Tensor Processing Units (TPU) של Google עם חומרה ייעודית ללמידה עמוקה.

- מעבדים גרפיים של NVIDIA, שלמרות שהם תוכננו במקור לעיבוד גרפי, הם מיועדים לאפשר עיבוד מקבילי, שיכול להגדיל באופן משמעותי את מהירות העיבוד.

דיוק

מספר התחזיות הנכונות של הסיווג חלקי המספר הכולל של התחזיות. כלומר:

לדוגמה, למודל שביצע 40 חיזויים נכונים ו-10 חיזויים לא נכונים יהיה דיוק של:

סיווג בינארי מספק שמות ספציפיים לקטגוריות השונות של תחזיות נכונות ותחזיות שגויות. לכן, הנוסחה לחישוב הדיוק בסיווג בינארי היא:

where:

- TP הוא מספר החיוביים האמיתיים (תחזיות נכונות).

- TN הוא מספר השליליים האמיתיים (חיזויים נכונים).

- FP הוא מספר החיוביים השגויים (תחזיות שגויות).

- FN הוא מספר התוצאות השליליות השגויות (תחזיות שגויות).

השוו בין דיוק לבין דיוק והחזרה.

מידע נוסף זמין במאמר סיווג: דיוק, היזכרות, פרסיזיה ומדדים קשורים בסדנה ללמידת מכונה.

פעולה

בלמידת חיזוק, המנגנון שבאמצעותו הסוכן עובר בין מצבים של הסביבה. הסוכן בוחר את הפעולה באמצעות מדיניות.

פונקציית הפעלה

פונקציה שמאפשרת לרשתות נוירונים ללמוד קשרים לא ליניאריים (מורכבים) בין התכונות לבין התווית.

פונקציות הפעלה פופולריות כוללות:

הגרפים של פונקציות ההפעלה אף פעם לא קווים ישרים. לדוגמה, הגרף של פונקציית ההפעלה ReLU מורכב משני קווים ישרים:

גרף של פונקציית ההפעלה הסיגמואידית נראה כך:

מידע נוסף מופיע במאמר רשתות עצביות: פונקציות הפעלה בסדנה ללימוד מכונת למידה.

מצב למידה פעיל

גישת אימון שבה האלגוריתם בוחר חלק מהנתונים שהוא לומד מהם. למידה פעילה שימושית במיוחד כשקשה להשיג דוגמאות עם תוויות או שהן יקרות. במקום לחפש באופן אקראי מגוון רחב של דוגמאות מתויגות, אלגוריתם של למידה פעילה מחפש באופן סלקטיבי את טווח הדוגמאות הספציפי שהוא צריך עבור מצב למידה.

AdaGrad

אלגוריתם מורכב של ירידת גרדיאנט שמשנה את קנה המידה של הגרדיאנטים של כל פרמטר, וכך למעשה נותן לכל פרמטר קצב למידה עצמאי. הסבר מלא זמין במאמר Adaptive Subgradient Methods for Online Learning and Stochastic Optimization.

התאמה

מילה נרדפת לשיפור או לכוונון עדין.

נציג

תוכנה שיכולה להסיק מסקנות לגבי קלט משתמש מולטי-מודאלי כדי לתכנן ולבצע פעולות בשם המשתמש.

בלמידת חיזוק, סוכן הוא הישות שמשתמשת במדיניות כדי למקסם את התשואה הצפויה שמתקבלת ממעבר בין מצבים של הסביבה.

אג'נטי

צורת שם התואר של agent. המונח 'סוכנותי' מתייחס לתכונות שיש לסוכנים (כמו אוטונומיה).

תהליך עבודה אג'נטי

תהליך דינמי שבו סוכן מתכנן ומבצע פעולות באופן אוטונומי כדי להשיג מטרה. התהליך עשוי לכלול חשיבה רציונלית, הפעלה של כלים חיצוניים ותיקון עצמי של התוכנית.

סידור באשכולות (clustering) היררכי מצטבר

ראו אשכול היררכי.

AI slop

פלט ממערכת AI גנרטיבי שמעדיפה כמות על פני איכות. לדוגמה, דף אינטרנט עם תוכן באיכות נמוכה שנוצר על ידי AI מלא בתוכן באיכות נמוכה שנוצר על ידי AI בעלות נמוכה.

זיהוי אנומליות

התהליך של זיהוי ערכים חריגים. לדוגמה, אם הממוצע של תכונה מסוימת הוא 100 עם סטיית תקן של 10, אז זיהוי האנומליות צריך לסמן ערך של 200 כחשוד.

AR

קיצור של מציאות רבודה.

השטח מתחת לעקומת ה-PR

מידע נוסף על PR AUC (השטח מתחת לעקומת ה-PR)

השטח מתחת לעקומת ה-ROC

מידע נוסף על AUC (השטח מתחת לעקומת ROC)

בינה מלאכותית כללית

מנגנון לא אנושי שמדגים מגוון רחב של יכולות לפתרון בעיות, יצירתיות ויכולת הסתגלות. לדוגמה, תוכנה שמדגימה בינה מלאכותית כללית יכולה לתרגם טקסט, להלחין סימפוניות ולהצטיין במשחקים שעדיין לא הומצאו.

לגבי בינה מלאכותית,

תוכנה או מודל לא אנושיים שיכולים לפתור משימות מורכבות. לדוגמה, תוכנית או מודל שמתרגמים טקסט, או תוכנית או מודל שמזהים מחלות מתמונות רדיולוגיות, שניהם מציגים בינה מלאכותית.

באופן רשמי, למידת מכונה היא תחום משנה של בינה מלאכותית. עם זאת, בשנים האחרונות, חלק מהארגונים התחילו להשתמש במונחים בינה מלאכותית ולמידת מכונה לסירוגין.

תשומת הלב,

מנגנון שמשמש ברשת נוירונים ומציין את החשיבות של מילה מסוימת או חלק ממילה. תשומת הלב דוחסת את כמות המידע שמודל צריך כדי לחזות את הטוקן או המילה הבאים. מנגנון תשומת לב טיפוסי עשוי לכלול סכום משוקלל של קבוצת קלטים, כאשר המשקל של כל קלט מחושב על ידי חלק אחר ברשת הנוירונים.

אפשר גם לעיין במאמרים בנושא קשב עצמי וקשב עצמי מרובה ראשים, שהם אבני הבניין של טרנספורמרים.

מידע נוסף על מנגנון תשומת הלב העצמית מופיע במאמר מודלים גדולים של שפה (LLM): מהו מודל שפה גדול? בסדנת למידת מכונה.

מאפיין

מילה נרדפת לתכונה.

בהקשר של הוגנות בלמידת מכונה, מאפיינים מתייחסים לרוב למאפיינים שקשורים לאנשים פרטיים.

דגימת מאפיינים

טקטיקה לאימון יער החלטות שבה כל עץ החלטות מתבסס רק על קבוצת משנה אקראית של תכונות אפשריות כשהוא במצב למידה את התנאי. באופן כללי, קבוצת משנה שונה של תכונות נדגמת עבור כל צומת. לעומת זאת, כשמאמנים עץ החלטה בלי דגימת מאפיינים, כל התכונות האפשריות נלקחות בחשבון לכל צומת.

AUC (השטח מתחת לעקומת ROC)

מספר בין 0.0 ל-1.0 שמייצג את היכולת של מודל סיווג בינארי להפריד בין סיווגים חיוביים לבין סיווגים שליליים. ככל שערך ה-AUC קרוב יותר ל-1.0, כך יכולת המודל להפריד בין המחלקות טובה יותר.

לדוגמה, באיור הבא מוצג מודל סיווג שמפריד בצורה מושלמת בין מחלקות חיוביות (אליפסות ירוקות) לבין מחלקות שליליות (מלבנים סגולים). למודל המושלם הלא-מציאותי הזה יש AUC של 1.0:

לעומת זאת, באיור הבא מוצגות התוצאות של מודל סיווג שיצר תוצאות אקראיות. המודל הזה כולל AUC של 0.5:

כן, למודל הקודם יש AUC של 0.5, ולא 0.0.

רוב הדגמים נמצאים איפשהו בין שני הקצוות. לדוגמה, המודל הבא מפריד בין ערכים חיוביים לשליליים במידה מסוימת, ולכן ערך ה-AUC שלו הוא בין 0.5 ל-1.0:

המדד AUC מתעלם מכל ערך שתגדירו לסף הסיווג. במקום זאת, AUC מתחשב בכל ספי הסיווג האפשריים.

מידע נוסף זמין במאמר בנושא סיווג: ROC ו-AUC בקורס המקוצר על למידת מכונה.

מציאות רבודה

טכנולוגיה שמציגה תמונה ממוחשבת על גבי התצוגה של המשתמש בעולם האמיתי, וכך מספקת תצוגה מורכבת.

autoencoder

מערכת שלומדת לחלץ את המידע הכי חשוב מהקלט. אוטו-מקודדים הם שילוב של מקודד ומפענח. התהליך של קידוד אוטומטי כולל שני שלבים:

- המקודד ממפה את הקלט לפורמט (ביניים) נמוך ממדי (בדרך כלל) עם דחיסת נתונים.

- הפענוח יוצר גרסה עם דחיסת נתונים (lossy) של הקלט המקורי על ידי מיפוי של הפורמט עם פחות ממדים לפורמט הקלט המקורי עם יותר ממדים.

מכשירים אוטומטיים לאינקוד (Autoencoders) מאומנים מקצה לקצה, כך שהמפענח מנסה לשחזר את הקלט המקורי מהפורמט הביניים של המקודד בצורה הכי מדויקת שאפשר. מכיוון שהפורמט הביניים קטן יותר (ממדים נמוכים יותר) מהפורמט המקורי, האוטו-מקודד נאלץ ללמוד איזה מידע בקלט הוא חיוני, והפלט לא יהיה זהה לחלוטין לקלט.

לדוגמה:

- אם נתוני הקלט הם גרפיקה, העותק הלא מדויק יהיה דומה לגרפיקה המקורית, אבל עם שינויים מסוימים. יכול להיות שהעותק הלא מדויק מסיר רעשים מהגרפיקה המקורית או ממלא פיקסלים חסרים.

- אם נתוני הקלט הם טקסט, מקודד אוטומטי ייצור טקסט חדש שמחקה את הטקסט המקורי (אבל לא זהה לו).

אפשר לקרוא גם על מקודדים אוטומטיים משתנים.

הערכה אוטומטית

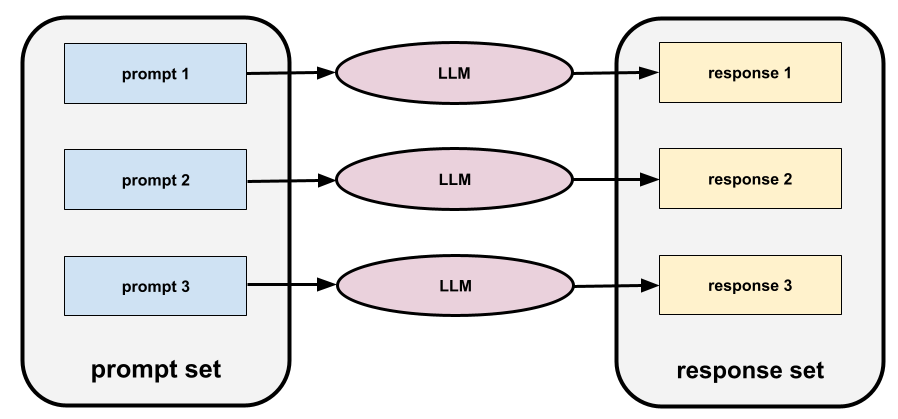

שימוש בתוכנה כדי לשפוט את איכות הפלט של מודל.

כשהפלט של המודל פשוט יחסית, סקריפט או תוכנית יכולים להשוות את הפלט של המודל לתשובה מושלמת. הסוג הזה של הערכה אוטומטית נקרא לפעמים הערכה פרוגרמטית. מדדים כמו ROUGE או BLEU שימושיים לעיתים קרובות להערכה פרוגרמטית.

כשפלט המודל מורכב או אין תשובה נכונה אחת, לפעמים מתבצעת הערכה אוטומטית על ידי תוכנת ML נפרדת שנקראת בודק אוטומטי.

ההבדל בין זה לבין בדיקה אנושית.

הטיית אוטומציה

מצב שבו מקבל החלטות אנושי מעדיף המלצות שנוצרו על ידי מערכת אוטומטית לקבלת החלטות על פני מידע שנוצר ללא אוטומציה, גם כשהמערכת האוטומטית לקבלת החלטות מבצעת טעויות.

מידע נוסף זמין במאמר הוגנות: סוגי הטיה בסדנת מבוא ללמידת מכונה.

AutoML

כל תהליך אוטומטי ליצירת מודלים של למידת מכונה. AutoML יכול לבצע באופן אוטומטי משימות כמו:

- מחפשים את המודל המתאים ביותר.

- כוונון היפר-פרמטרים.

- הכנת הנתונים (כולל ביצוע הנדסת תכונות).

- פורסים את המודל שנוצר.

AutoML שימושי למדעני נתונים כי הוא יכול לחסוך להם זמן ומאמץ בפיתוח צינורות של למידת מכונה ולשפר את דיוק התחזיות. הוא שימושי גם למי שאינם מומחים, כי הוא מאפשר להם לבצע משימות מורכבות של למידת מכונה.

מידע נוסף מופיע במאמר Automated Machine Learning (AutoML) בקורס המקוצר על למידת מכונה.

הערכה של כלי לדירוג אוטומטי

מנגנון היברידי להערכת האיכות של הפלט של מודל AI גנרטיבי, שמשלב הערכה אנושית עם הערכה אוטומטית. דירוג אוטומטי הוא מודל למידת מכונה שאומן על נתונים שנוצרו על ידי הערכה אנושית. באופן אידיאלי, מערכת לדירוג אוטומטי לומדת לחקות בודק אנושי.יש כלי הערכה אוטומטיים מוכנים מראש, אבל כדאי לכוונן אותם במיוחד למשימה שאתם מעריכים.

מודל אוטו-רגרסיבי

מודל שמסיק חיזוי על סמך החיזויים הקודמים שלו. לדוגמה, מודלים אוטומטיים של שפה חוזים את הטוקן הבא על סמך הטוקנים שנחזו קודם. כל המודלים הגדולים של שפה שמבוססים על Transformer הם אוטורגרסיביים.

לעומת זאת, מודלים של תמונות שמבוססים על GAN בדרך כלל לא רגרסיביים אוטומטיים, כי הם יוצרים תמונה במעבר קדימה יחיד ולא באופן איטרטיבי בשלבים. עם זאת, מודלים מסוימים ליצירת תמונות הם אוטומטיים רגרסיביים כי הם יוצרים תמונה בשלבים.

הפסד עזר

פונקציית הפסד – משמשת בשילוב עם פונקציית ההפסד הראשית של מודל רשת נוירונים, ומסייעת להאיץ את האימון במהלך האיטרציות הראשונות, כשמשקלים מאותחלים באופן אקראי.

פונקציות הפסד עזר דוחפות גרדיאנטים יעילים אל השכבות הקודמות. הפעולה הזו מקלה על התכנסות במהלך האימון על ידי התמודדות עם בעיית הגרדיאנט הנעלם.

דיוק ממוצע ב-k

מדד לסיכום הביצועים של מודל בהנחיה יחידה שמפיקה תוצאות מדורגות, כמו רשימה ממוספרת של המלצות לספרים. הדיוק הממוצע ב-k הוא, ובכן, הממוצע של ערכי הדיוק ב-k לכל תוצאה רלוונטית. לכן, הנוסחה לחישוב הדיוק הממוצע ב-k היא:

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

where:

- \(n\) הוא מספר הפריטים הרלוונטיים ברשימה.

השוואה לrecall ב-k.

תנאי שמתייחס לציר

בעץ החלטה, תנאי שכולל רק תכונה אחת. לדוגמה, אם area הוא מאפיין, התנאי הבא הוא תנאי שמתיישר עם הציר:

area > 200

השוואה לתנאי אלכסוני.

B

backpropagation

האלגוריתם שמיישם ירידת גרדיאנט ברשתות נוירונים.

אימון של רשת נוירונים כולל הרבה איטרציות של המחזור הבא בן שני השלבים:

- במהלך המעבר קדימה, המערכת מעבדת אצווה של דוגמאות כדי להפיק חיזויים. המערכת משווה כל תחזית לכל ערך של תווית. ההפרש בין התחזית לבין ערך התווית הוא ההפסד של הדוגמה הזו. המערכת מסכמת את ההפסדים של כל הדוגמאות כדי לחשב את ההפסד הכולל של האצווה הנוכחית.

- במהלך המעבר לאחור (backpropagation), המערכת מצמצמת את אובדן המידע על ידי התאמת המשקלים של כל הנוירונים בכל השכבות הנסתרות.

נוירונים מלאכותיות מכילות בדרך כלל הרבה נוירונים בהרבה שכבות נסתרות. כל אחד מהנוירונים האלה תורם להפסד הכולל בדרכים שונות. האלגוריתם Backpropagation קובע אם להגדיל או להקטין את המשקלים שמוחלים על נוירונים מסוימים.

קצב הלמידה הוא מכפיל שקובע את מידת ההגדלה או ההקטנה של כל משקל בכל מעבר לאחור. קצב למידה גבוה יגדיל או יקטין כל משקל יותר מקצב למידה נמוך.

במונחים של חשבון אינפיניטסימלי, backpropagation מיישם את כלל השרשרת מתוך חשבון אינפיניטסימלי. כלומר, בשיטת backpropagation מחושב הנגזרת החלקית של השגיאה ביחס לכל פרמטר.

לפני שנים, מומחים ל-ML היו צריכים לכתוב קוד כדי להטמיע backpropagation. ממשקי API מודרניים של למידת מכונה, כמו Keras, מטמיעים עכשיו בשבילכם את האלגוריתם backpropagation. סוף סוף!

מידע נוסף זמין במאמר רשתות עצביות בקורס המקוצר על למידת מכונה.

bagging

שיטה לאימון אנסמבל שבו כל מודל מרכיב מתאמן על קבוצת משנה אקראית של דוגמאות לאימון שנדגמו עם החזרה. לדוגמה, יער אקראי הוא אוסף של עצי החלטה שאומנו באמצעות שיטת ה-bagging.

המונח bagging הוא קיצור של bootstrap aggregating.

מידע נוסף זמין במאמר יערות אקראיים בקורס בנושא יערות החלטה.

bag of words

ייצוג של המילים בביטוי או בפסקה, ללא קשר לסדר. לדוגמה, bag of words מייצג את שלושת הביטויים הבאים באופן זהה:

- הכלב קופץ

- קופץ מעל הכלב

- כלב קופץ

כל מילה ממופה לאינדקס בוקטור חסכוני, שבו לכל מילה באוצר המילים יש אינדקס. לדוגמה, הביטוי the dog jumps ממופה לווקטור תכונות עם ערכים שונים מאפס בשלושת האינדקסים שמתאימים למילים the, dog ו-jumps. הערך שאינו אפס יכול להיות כל אחת מהאפשרויות הבאות:

- 1 כדי לציין את נוכחות המילה.

- ספירה של מספר הפעמים שמילה מופיעה בתיק. לדוגמה, אם הביטוי הוא the maroon dog is a dog with maroon fur, אז גם maroon וגם dog ייוצגו כ-2, בעוד שהמילים האחרות ייוצגו כ-1.

- ערך אחר, כמו הלוגריתם של מספר הפעמים שמילה מופיעה בתיק.

baseline

מודל שמשמש כנקודת השוואה לביצועים של מודל אחר (בדרך כלל מודל מורכב יותר). לדוגמה, מודל רגרסיה לוגיסטית יכול לשמש כבסיס טוב למודל עמוק.

במקרה של בעיה מסוימת, ה-Baseline עוזר למפתחי מודלים לכמת את הביצועים המינימליים הצפויים שמודל חדש צריך להשיג כדי שהוא יהיה שימושי.

מודל בסיס

מודל שאומן מראש שיכול לשמש כנקודת התחלה לכוונון עדין כדי לטפל במשימות או באפליקציות ספציפיות.

כדאי לעיין גם במודל שעבר אימון מראש ובמודל בסיסי.

אצווה

קבוצת הדוגמאות שמשמשת באיטרציה אחת של אימון. גודל האצווה קובע את מספר הדוגמאות באצווה.

הסבר על הקשר בין אצווה לבין תקופה מופיע במאמר בנושא תקופה.

מידע נוסף זמין במאמר רגרסיה ליניארית: היפר-פרמטרים בקורס המקוצר על למידת מכונה.

היקש באצווה

התהליך של הסקת תחזיות על כמה דוגמאות לא מסומנות שמחולקות לקבוצות משנה קטנות יותר ("אצוות").

הסקת מסקנות באצווה יכולה לנצל את תכונות הטעינה במקביל של שבבי האצה. כלומר, כמה מאיצים יכולים להסיק תחזיות בו-זמנית על קבוצות שונות של דוגמאות לא מסומנות, וכך להגדיל באופן משמעותי את מספר ההסקות בשנייה.

מידע נוסף מופיע במאמר מערכות ML בייצור: הסקה סטטית לעומת הסקה דינמית בקורס המזורז ללמידת מכונה.

נורמליזציה של אצווה

נרמול של הקלט או הפלט של פונקציות ההפעלה בשכבה מוסתרת. לנורמליזציה של קבוצות יש כמה יתרונות:

- הגנה מפני משקלים של חריג חשוד טעות כדי להפוך רשתות עצביות ליציבות יותר.

- הפעלת שיעורי למידה גבוהים יותר, שיכולים להאיץ את האימון.

- הפחתת התאמת יתר.

גודל אצווה

מספר הדוגמאות באצווה. לדוגמה, אם גודל האצווה הוא 100, המודל מעבד 100 דוגמאות לכל איטרציה.

אלה כמה אסטרטגיות פופולריות לגודל אצווה:

- Stochastic Gradient Descent (SGD), שבו גודל האצווה הוא 1.

- קבוצת נתונים מלאה, שבה גודל הקבוצה הוא מספר הדוגמאות בקבוצת נתונים לאימון כולה. לדוגמה, אם קבוצת נתונים לאימון מכילה מיליון דוגמאות, גודל האצווה יהיה מיליון דוגמאות. שיטה של עדכון מלא של נתונים היא בדרך כלל לא יעילה.

- מיני-batch שבו גודל אצווה הוא בדרך כלל בין 10 ל-1,000. בדרך כלל, אסטרטגיית המיני-batch היא היעילה ביותר.

מידע נוסף מפורט במאמרים הבאים:

- מערכות ML לייצור: הסקה סטטית לעומת הסקה דינמית בקורס המקוצר על למידת מכונה.

- מדריך לשיפור הביצועים של למידה עמוקה.

רשת נוירונים בייסיאנית

רשת נוירונים הסתברותית שמתחשבת באי-ודאות במשקלים ובפלט. מודל רגרסיה של רשת נוירונים רגילה בדרך כלל מנבא ערך סקלרי. לדוגמה, מודל רגיל מנבא מחיר בית של 853,000. לעומת זאת, רשת נוירונים בייסיאנית חוזה התפלגות של ערכים. לדוגמה, מודל בייסיאני חוזה מחיר בית של 853,000 עם סטיית תקן של 67,200.

רשת נוירונים בייסיאנית מסתמכת על משפט בייס כדי לחשב את אי הוודאות במשקלים ובתחזיות. רשת עצבית בייסיאנית יכולה להיות שימושית כשחשוב לכמת את אי הוודאות, למשל במודלים שקשורים לתרופות. רשתות נוירונים בייסיאניות יכולות גם לעזור למנוע התאמת יתר.

אופטימיזציה בייסיאנית

מודל רגרסיה הסתברותי טכניקה לאופטימיזציה של פונקציות מטרה שדורשות הרבה משאבי מחשוב. במקום זאת, המודל מבצע אופטימיזציה של פונקציית סרוגייט שמבצעת כימות של אי-הוודאות באמצעות טכניקת למידה בייסיאנית. מכיוון שאופטימיזציה בייסיאנית היא תהליך יקר מאוד, בדרך כלל משתמשים בה כדי לבצע אופטימיזציה של משימות יקרות להערכה שיש להן מספר קטן של פרמטרים, כמו בחירה של היפרפרמטרים.

משוואת בלמן

בלמידת חיזוק, הזהות הבאה מסופקת על ידי פונקציית ה-Q האופטימלית:

\[Q(s, a) = r(s, a) + \gamma \mathbb{E}_{s'|s,a} \max_{a'} Q(s', a')\]

אלגוריתמים של למידת חיזוק מיישמים זהות זו כדי ליצור למידת Q באמצעות כלל העדכון הבא:

\[Q(s,a) \gets Q(s,a) + \alpha \left[r(s,a) + \gamma \displaystyle\max_{\substack{a_1}} Q(s',a') - Q(s,a) \right] \]

מעבר ללמידת חיזוק, למשוואת בלמן יש יישומים בתכנות דינמי. אפשר לעיין ב ערך בוויקיפדיה בנושא משוואת בלמן.

BERT (ייצוגים דו-כיווניים של מקודד מטרנספורמרים)

ארכיטקטורת מודל לייצוג של טקסט. מודל BERT מאומן יכול לשמש כחלק ממודל גדול יותר לסיווג טקסט או למשימות אחרות של למידת מכונה.

ל-BERT יש את המאפיינים הבאים:

- משתמש בארכיטקטורת Transformer, ולכן מסתמך על self-attention.

- משתמש בחלק המקודד של הטרנספורמר. תפקיד המקודד הוא ליצור ייצוגים טובים של טקסט, ולא לבצע משימה ספציפית כמו סיווג.

- היא דו-כיוונית.

- משתמש במיסוך לאימון לא מפוקח.

הווריאציות של BERT כוללות:

במאמר Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing מופיע סקירה כללית של BERT.

הטיה (אתיקה/הוגנות)

1. הצגת סטריאוטיפים, דעות קדומות או העדפה של דברים, אנשים או קבוצות מסוימים על פני אחרים. ההטיות האלה יכולות להשפיע על איסוף הנתונים ועל הפרשנות שלהם, על עיצוב המערכת ועל האופן שבו המשתמשים מבצעים אינטראקציה עם המערכת. דוגמאות להטיות מסוג זה:

- הטיית אוטומציה

- הטיית אישור

- הטיה של עורכי הניסוי

- הטיה בשיוך לקבוצה

- הטיה מרומזת

- הטיה לטובת קבוצת השייכות

- הטיית הומוגניות של קבוצת חוץ

2. שגיאה שיטתית שנובעת מהליך דגימה או דיווח. דוגמאות להטיות מסוג זה:

לא להתבלבל עם מונח ההטיה במודלים של למידת מכונה או עם הטיה בתחזית.

מידע נוסף זמין במאמר הוגנות: סוגי הטיה בקורס המזורז ללימוד מכונת למידה.

הטיה (מתמטיקה) או מונח הטיה

נקודת חיתוך או היסט מנקודת המוצא. הטיה היא פרמטר במודלים של למידת מכונה, שמסומל באחד מהערכים הבאים:

- b

- w0

לדוגמה, הטיה היא b בנוסחה הבאה:

בקו דו-ממדי פשוט, הטיה פשוט מייצגת את נקודת החיתוך עם ציר ה-y. לדוגמה, ההטיה של הקו באיור הבא היא 2.

ההטיה קיימת כי לא כל המודלים מתחילים מהמקור (0,0). לדוגמה, נניח שעלות הכניסה לפארק שעשועים היא 2 אירו, ועל כל שעה שהלקוח נמצא בפארק הוא משלם עוד 0.5 אירו. לכן, למודל שממפה את העלות הכוללת יש הטיה של 2 כי העלות הנמוכה ביותר היא 2 אירו.

הטיה לא זהה להטיה באתיקה ובהוגנות או להטיה בתחזיות.

מידע נוסף זמין במאמר רגרסיה ליניארית בקורס המקוצר על למידת מכונה.

דו-כיווני

מונח שמשמש לתיאור מערכת שמעריכה את הטקסט שקודם לקטע טקסט יעד וגם את הטקסט שבא אחריו. לעומת זאת, מערכת חד-כיוונית מעריכה רק את הטקסט שקודם לקטע טקסט היעד.

לדוגמה, נניח שיש מודל שפה עם מיסוך שצריך לקבוע את ההסתברויות של המילה או המילים שמיוצגות על ידי הקו התחתון בשאלה הבאה:

מה הבעיה שלך?

מודל שפה חד-כיווני יצטרך לבסס את ההסתברויות שלו רק על ההקשר שנוצר על ידי המילים 'What', 'is' ו-'the'. לעומת זאת, מודל שפה דו-כיווני יכול גם לקבל הקשר מהמילים 'עם' ו'אתה', מה שיכול לעזור למודל ליצור תחזיות טובות יותר.

מודל שפה דו-כיווני

מודל שפה שקובע את ההסתברות שאסימון נתון נמצא במיקום נתון בקטע טקסט, על סמך הטקסט שקדם לו והטקסט שבא אחריו.

ביגרמה

N-gram שבו N=2.

סיווג בינארי

סוג של משימת סיווג שבה המודל מנבא אחת משתי קטגוריות שאינן חופפות:

לדוגמה, כל אחד משני המודלים הבאים של למידת מכונה מבצע סיווג בינארי:

- מודל שקובע אם הודעות אימייל הן ספאם (הסיווג החיובי) או לא ספאם (הסיווג השלילי).

- מודל שמעריך תסמינים רפואיים כדי לקבוע אם לאדם מסוים יש מחלה מסוימת (הסיווג החיובי) או שאין לו את המחלה הזו (הסיווג השלילי).

ההפך מסיווג רב-מחלקתי.

אפשר לעיין גם במאמרים בנושא רגרסיה לוגיסטית וסף סיווג.

מידע נוסף זמין במאמר סיווג בקורס המקוצר על למידת מכונה.

תנאי בינארי

בעץ החלטה, תנאי שיש לו רק שתי תוצאות אפשריות, בדרך כלל כן או לא. לדוגמה, התנאי הבא הוא תנאי בינארי:

temperature >= 100

ההפך ממצב א-בינארי.

מידע נוסף זמין במאמר סוגי תנאים בקורס בנושא יערות החלטה.

binning

מילה נרדפת לחלוקה לקטגוריות.

מודל קופסה שחורה

מודל שאת ה"חשיבה הרציונלית" שלו בלתי אפשרי או קשה לבני אדם להבין. כלומר, למרות שאנשים יכולים לראות איך הנחיות משפיעות על התשובות, הם לא יכולים לדעת בדיוק איך מודל קופסה שחורה קובע את התשובה. במילים אחרות, למודל של קופסה שחורה חסרה יכולת פירוש.

רוב המודלים העמוקים והמודלים הגדולים של שפה הם קופסאות שחורות.

BLEU (Bilingual Evaluation Understudy)

מדד בין 0.0 ל-1.0 להערכת תרגומים אוטומטיים, למשל מספרדית ליפנית.

כדי לחשב ציון, בדרך כלל BLEU משווה בין התרגום של מודל ML (טקסט שנוצר) לבין התרגום של מומחה אנושי (טקסט ייחוס). מידת ההתאמה בין N-grams בטקסט שנוצר לבין טקסט ההשוואה קובעת את ציון ה-BLEU.

המאמר המקורי בנושא המדד הזה הוא BLEU: a Method for Automatic Evaluation of Machine Translation.

מידע נוסף זמין במאמר בנושא BLEURT.

BLEURT (Bilingual Evaluation Understudy from Transformers)

מדד להערכת תרגומים אוטומטיים משפה אחת לשפה אחרת, במיוחד מאנגלית ואליה.

בתרגומים לאנגלית ומאנגלית, התוצאות של BLEURT קרובות יותר לדירוגים של בני אדם מאשר התוצאות של BLEU. בניגוד ל-BLEU, BLEURT מדגיש דמיון סמנטי (משמעות) ויכול להתאים לניסוח מחדש.

BLEURT מסתמך על מודל שפה גדול שעבר אימון מראש (BERT ליתר דיוק), ואז עובר כוונון עדין על טקסט שנוצר על ידי מתרגמים אנושיים.

המאמר המקורי על המדד הזה הוא BLEURT: Learning Robust Metrics for Text Generation.

שאלות בוליאניות (BoolQ)

מערך נתונים להערכת היכולת של LLM לענות על שאלות של כן או לא. כל אחת מהבעיות בקבוצת הנתונים כוללת שלושה רכיבים:

- שאילתה

- קטע שממנו אפשר להסיק את התשובה לשאילתה.

- התשובה הנכונה, שהיא כן או לא.

לדוגמה:

- שאילתה: האם יש תחנות כוח גרעיניות במישיגן?

- פסקה: ...שלוש תחנות כוח גרעיניות מספקות למישיגן כ-30% מהחשמל שלה.

- תשובה נכונה: כן

החוקרים אספו את השאלות מתוך שאילתות אנונימיות ומצטברות בחיפוש Google, ואז השתמשו בדפי ויקיפדיה כדי לבסס את המידע.

מידע נוסף זמין במאמר BoolQ: Exploring the Surprising Difficulty of Natural Yes/No Questions.

BoolQ הוא רכיב של SuperGLUE ensemble.

BoolQ

קיצור של שאלות בוליאניות.

הגדלה

טכניקה של למידת מכונה שמשלבת באופן איטרטיבי קבוצה של מודלים פשוטים לסיווג (שנקראים 'מסווגים חלשים') שלא תמיד מדויקים, למודל סיווג עם רמת דיוק גבוהה ('מסווג חזק'). השילוב מתבצע על ידי הגדלת המשקל של הדוגמאות שהמודל מסווג בצורה שגויה.

מידע נוסף זמין במאמר מהם עצי החלטה עם שיטת Gradient Boosting? בקורס בנושא יערות החלטה.

תיבה תוחמת (bounding box)

בתמונה, הקואורדינטות (x, y) של מלבן שמקיף אזור שמעניין אתכם, כמו הכלב בתמונה שלמטה.

שידור

הרחבת הצורה של אופרנד בפעולה מתמטית של מטריצה לממדים שתואמים לפעולה הזו. לדוגמה, באלגברה לינארית, שני האופרנדים בפעולת חיבור מטריצות צריכים להיות בעלי אותם ממדים. לכן, אי אפשר להוסיף מטריצה בצורה (m, n) לווקטור באורך n. השידור מאפשר את הפעולה הזו על ידי הרחבה וירטואלית של הווקטור באורך n למטריצה בצורה (m, n) על ידי שכפול אותם ערכים בכל עמודה.

פרטים נוספים מופיעים בתיאור הבא של שידור ב-NumPy.

bucketing

המרת תכונה אחת לכמה תכונות בינאריות שנקראות buckets או bins, בדרך כלל על סמך טווח ערכים. התכונה 'חיתוך' היא בדרך כלל תכונה רציפה.

לדוגמה, במקום לייצג את רמת האקראיות כמאפיין יחיד של נקודה צפה רציפה, אפשר לחלק טווחי רמות אקראיות למאגרי נתונים נפרדים, כמו:

- <= 10 degrees Celsius would be the "cold" bucket.

- 11 עד 24 מעלות צלזיוס יהיו בקטגוריה 'ממוזג'.

- >= 25 degrees Celsius יהיה הדלי 'warm'.

המודל יתייחס לכל הערכים באותו דלי באופן זהה. לדוגמה, הערכים 13 ו-22 נמצאים שניהם בדלי של אזורים ממוזגים, ולכן המודל מתייחס לשני הערכים בצורה זהה.

מידע נוסף מופיע במאמר נתונים מספריים: חלוקה לקטגוריות בקורס המקוצר על למידת מכונה.

C

שכבת כיול

התאמה שמתבצעת אחרי החיזוי, בדרך כלל כדי לפצות על הטיה בחיזוי. התחזיות וההסתברויות המותאמות צריכות להתאים להתפלגות של קבוצת תוויות שנצפתה.

יצירת מועמדים

קבוצת ההמלצות הראשונית שנבחרה על ידי מערכת המלצות. לדוגמה, נניח שיש חנות ספרים שמציעה 100,000 כותרים. בשלב יצירת המועמדים, המערכת יוצרת רשימה קטנה בהרבה של ספרים מתאימים למשתמש מסוים, למשל 500. אבל גם 500 ספרים זה יותר מדי ספרים להמלצה למשתמש. בשלבים הבאים והיקרים יותר של מערכת ההמלצות (כמו דירוג ודירוג מחדש), מספר ההמלצות מצטמצם לסט קטן יותר ושימושי יותר.

מידע נוסף זמין במאמר סקירה כללית על יצירת מועמדים בקורס בנושא מערכות המלצה.

דגימה של מועמדים

אופטימיזציה בזמן האימון שמחשבת הסתברות לכל התוויות החיוביות, באמצעות, למשל, softmax, אבל רק עבור מדגם אקראי של תוויות שליליות. לדוגמה, אם יש לכם דוגמה עם התוויות beagle ו-dog, דגימת המועמדים מחשבת את ההסתברויות החזויות ואת מונחי ההפסד המתאימים ל:

- beagle

- dog

- קבוצת משנה אקראית של שאר הסיווגים השליליים (לדוגמה, חתול, סוכרייה על מקל, גדר).

הרעיון הוא שסיווגים שליליים יכולים ללמוד מחיזוק שלילי בתדירות נמוכה יותר, כל עוד סיווגים חיוביים תמיד מקבלים חיזוק חיובי מתאים. זה אכן מה שנצפה באופן אמפירי.

דגימת מועמדים יעילה יותר מבחינת חישובים מאלגוריתמים לאימון שמחשבים תחזיות עבור כל המחלקות השליליות, במיוחד כשמספר המחלקות השליליות גדול מאוד.

נתונים קטגוריים

מאפיינים עם קבוצה ספציפית של ערכים אפשריים. לדוגמה, נניח שיש מאפיין קטגוריאלי בשם traffic-light-state, שיכול לקבל רק אחד משלושת הערכים האפשריים הבאים:

redyellowgreen

אם מייצגים את traffic-light-state כמאפיין קטגורי, מודל יכול ללמוד את ההשפעות השונות של red, green ו-yellow על התנהגות הנהג.

תכונות קטגוריות נקראות לפעמים תכונות בדידות.

ההפך מנתונים מספריים.

מידע נוסף זמין במאמר עבודה עם נתונים שמחולקים לקטגוריות בקורס המקוצר על למידת מכונה.

מודל שפה סיבתי

מילה נרדפת למונח מודל שפה חד-כיווני.

כדי להבין את ההבדלים בין גישות שונות של מודלים לשפה, אפשר לעיין במאמר בנושא מודל שפה דו-כיווני.

CB

קיצור של CommitmentBank.

נקודת המרכז

המרכז של אשכול שנקבע על ידי אלגוריתם k-means או k-median. לדוגמה, אם k הוא 3, האלגוריתם k-means או k-median מוצא 3 מרכזים.

מידע נוסף זמין במאמר אלגוריתמים של אשכולות בקורס בנושא אשכולות.

centroid-based clustering

קטגוריה של אלגוריתמים של אשכולות שמארגנים נתונים באשכולות לא היררכיים. k-means הוא האלגוריתם הנפוץ ביותר של אשכולות מבוססי-מרכז.

בניגוד לאלגוריתמים של אשכול היררכי.

מידע נוסף זמין במאמר אלגוריתמים של אשכולות בקורס בנושא אשכולות.

הנחיות בטכניקת שרשרת מחשבה

טכניקה של הנדסת הנחיות שמעודדת מודל שפה גדול (LLM) להסביר את ההיגיון שלו, שלב אחר שלב. לדוגמה, נבחן את ההנחיה הבאה, תוך שימת לב מיוחדת למשפט השני:

כמה כוחות G יחווה נהג ברכב שמאיץ מ-0 ל-60 מייל לשעה ב-7 שניות? בתשובה, צריך להציג את כל החישובים הרלוונטיים.

התשובה של ה-LLM תהיה כנראה:

- תציג רצף של נוסחאות בפיזיקה, ותציב את הערכים 0, 60 ו-7 במקומות המתאימים.

- תסביר למה היא בחרה בנוסחאות האלה ומה המשמעות של המשתנים השונים.

הנחיות בטכניקת שרשרת מחשבה מאלצות את ה-LLM לבצע את כל החישובים, מה שעשוי להוביל לתשובה נכונה יותר. בנוסף, הנחיה מסוג chain-of-thought מאפשרת למשתמש לבדוק את השלבים של מודל ה-LLM כדי לקבוע אם התשובה הגיונית.

ציון F של N-gram של תווים (ChrF)

מדד להערכת מודלים של תרגום אוטומטי. ציון F של N-גרמות של תווים קובע את מידת החפיפה בין N-גרמות בטקסט ההפניה לבין ה-N-גרמות בטקסט שנוצר על ידי מודל ML.

המדד Character N-gram F-score דומה למדדים במשפחות ROUGE ו-BLEU, אבל:

- המדד F-score של N-gram של תווים פועל על N-gram של תווים.

- המדדים ROUGE ו-BLEU פועלים על N-gram של מילים או על אסימונים.

צ'אט, צ'ט, צאט, צט

התוכן של דיאלוג הלוך ושוב עם מערכת למידת מכונה, בדרך כלל מודל שפה גדול. האינטראקציה הקודמת בצ'אט (מה שהקלדתם ואיך מודל השפה הגדול הגיב) הופכת להקשר לחלקים הבאים של הצ'אט.

צ'אט בוט הוא יישום של מודל שפה גדול.

נקודת ביקורת

נתונים שמתעדים את המצב של הפרמטרים של מודל, במהלך האימון או אחרי שהאימון מסתיים. לדוגמה, במהלך האימון, תוכלו:

- הפסקת האימון, אולי בכוונה או אולי כתוצאה משגיאות מסוימות.

- מצלמים את נקודת הביקורת.

- בשלב מאוחר יותר, טוענים מחדש את נקודת הבדיקה, אולי בחומרה אחרת.

- להתחיל מחדש את ההדרכה.

בחירת חלופות סבירות (COPA)

מערך נתונים להערכת היכולת של מודל LLM לזהות את התשובה הטובה יותר מבין שתי תשובות חלופיות להנחת יסוד. כל אחת מהבעיות במערך הנתונים מורכבת משלושה רכיבים:

- הנחת יסוד, שהיא בדרך כלל הצהרה שאחריה מופיעה שאלה

- שתי תשובות אפשריות לשאלה שמוצגת בפריט, שאחת מהן נכונה והשנייה לא נכונה

- התשובה הנכונה

לדוגמה:

- הנחת יסוד: הגבר שבר את הבוהן. מה הייתה הסיבה לכך?

- תשובות אפשריות:

- הוא קיבל חור בגרב.

- הוא הפיל פטיש על הרגל שלו.

- תשובה נכונה: 2

COPA הוא רכיב של SuperGLUE ensemble.

כיתה

קטגוריה שתווית יכולה להשתייך אליה. לדוגמה:

- במודל סיווג בינארי שמזהה ספאם, שתי המחלקות יכולות להיות ספאם ולא ספאם.

- במודל סיווג מרובה מחלקות שמזהה גזעי כלבים, המחלקות יכולות להיות פודל, ביגל, פאג וכן הלאה.

מודל סיווג חוזה את הסיווג. לעומת זאת, מודל רגרסיה חוזה מספר ולא מחלקה.

מידע נוסף זמין במאמר סיווג בקורס המקוצר על למידת מכונה.

קבוצת נתונים מאוזנת לפי כיתה

מערך נתונים שמכיל תוויות קטגוריות שבהן מספר המקרים של כל קטגוריה שווה בערך. לדוגמה, נניח שיש מערך נתונים בוטני עם תווית בינארית שיכולה להיות צמח מקומי או צמח לא מקומי:

- מערך נתונים עם 515 צמחים מקומיים ו-485 צמחים לא מקומיים הוא מערך נתונים מאוזן.

- מערך נתונים עם 875 צמחים מקומיים ו-125 צמחים לא מקומיים הוא מערך נתונים לא מאוזן לפי סיווג.

אין קו חלוקה רשמי בין מערכי נתונים מאוזנים לפי מחלקה לבין מערכי נתונים לא מאוזנים לפי מחלקה. ההבחנה הזו חשובה רק כשמודל שאומן על מערך נתונים עם חוסר איזון קיצוני בין המחלקות לא מצליח להתכנס. פרטים נוספים זמינים במאמר קבוצות נתונים: קבוצות נתונים לא מאוזנות בסדנה ללמידת מכונה.

מודל סיווג

מודל שהחיזוי שלו הוא סיווג. לדוגמה, כל אלה הם מודלים של סיווג:

- מודל שמנבא את השפה של משפט קלט (צרפתית? ספרדית? איטלקית?).

- מודל שמנבא מיני עצים (אדר? אלון? באובב?).

- מודל שמנבא את הסיווג החיובי או השלילי של מצב רפואי מסוים.

לעומת זאת, מודלים של רגרסיה חוזים מספרים ולא סיווגים.

שני סוגים נפוצים של מודלים לסיווג הם:

סף סיווג (classification threshold)

בסיווג בינארי, מספר בין 0 ל-1 שממיר את הפלט הגולמי של מודל רגרסיה לוגיסטית לתחזית של הסיווג החיובי או של הסיווג השלילי. חשוב לזכור שסף הסיווג הוא ערך שנבחר על ידי בן אדם, ולא ערך שנבחר על ידי אימון המודל.

מודל רגרסיה לוגיסטית מחזיר ערך גולמי בין 0 ל-1. לאחר מכן:

- אם הערך הגולמי הזה גדול יותר מסף הסיווג, אז המערכת חוזה את הסיווג החיובי.

- אם הערך הגולמי הזה נמוך מסף הסיווג, המערכת תנבא את הסיווג השלילי.

לדוגמה, נניח שסף הסיווג הוא 0.8. אם הערך הגולמי הוא 0.9, המודל חוזה את המחלקה החיובית. אם הערך הגולמי הוא 0.7, המודל חוזה את המחלקה השלילית.

הבחירה של סף הסיווג משפיעה מאוד על מספר החיוביים הכוזבים והשליליים הכוזבים.

מידע נוסף זמין במאמר ערכי סף ומטריצת בלבול בקורס המקוצר על למידת מכונה.

מסווג

מונח לא רשמי למודל סיווג.

קבוצת נתונים לא מאוזנת מבחינת כיתות

מערך נתונים של סיווג שבו המספר הכולל של תוויות של כל סיווג שונה באופן משמעותי. לדוגמה, נניח שיש קבוצת נתונים של סיווג בינארי עם שתי תוויות שמחולקות באופן הבא:

- 1,000,000 תוויות שליליות

- 10 תוויות חיוביות

היחס בין תוויות שליליות לחיוביות הוא 100,000 ל-1, ולכן זהו מערך נתונים עם חוסר איזון בין המחלקות.

לעומת זאת, מערך הנתונים הבא הוא מאוזן לפי מחלקות כי היחס בין התוויות השליליות לתוויות החיוביות קרוב יחסית ל-1:

- 517 תוויות שליליות

- 483 תוויות חיוביות

יכול להיות גם חוסר איזון בין הכיתות במערכי נתונים עם כמה כיתות. לדוגמה, מערך הנתונים הבא של סיווג רב-מחלקתי הוא גם לא מאוזן מבחינת מחלקות, כי לתווית אחת יש הרבה יותר דוגמאות מאשר לשתי התוויות האחרות:

- 1,000,000 תוויות עם הסיווג 'ירוק'

- 200 תוויות עם המחלקה purple

- 350 תוויות עם המחלקה orange

אימון של מערכי נתונים לא מאוזנים בכיתות יכול להציב אתגרים מיוחדים. פרטים נוספים זמינים במאמר Imbalanced datasets (מערכי נתונים לא מאוזנים) בסדנה בנושא למידת מכונה.

אפשר לעיין גם בערכים אנטרופיה, מחלקת הרוב ומחלקת המיעוט.

חיתוך

טכניקה לטיפול בערכים חריגים באמצעות אחת מהפעולות הבאות או שתיהן:

- הפחתת ערכים של תכונה שגדולים מסף מקסימלי עד לסף המקסימלי הזה.

- הגדלת ערכי התכונות שקטנים מסף מינימלי עד לסף המינימלי הזה.

לדוגמה, נניח שפחות מ-0.5% מהערכים של תכונה מסוימת נמצאים מחוץ לטווח 40-60. במקרה כזה, אפשר לבצע את הפעולות הבאות:

- כל הערכים מעל 60 (הסף המקסימלי) יקוצצו ל-60 בדיוק.

- כל הערכים שקטנים מ-40 (סף המינימום) יוגבלו ל-40 בדיוק.

ערכים חריגים עלולים לפגוע במודלים, ולפעמים לגרום למשקלים לגלוש במהלך האימון. חלק מהערכים החריגים יכולים גם לפגוע באופן משמעותי במדדים כמו דיוק. חיתוך הוא טכניקה נפוצה להגבלת הנזק.

חיתוך שיפועים מאלץ ערכי שיפועים בטווח מוגדר במהלך האימון.

מידע נוסף זמין במאמר נתונים מספריים: נורמליזציה בסדנה ללימוד מכונת למידה.

Cloud TPU

מאיץ חומרה ייעודי שנועד להאיץ עומסי עבודה של למידת מכונה ב-Google Cloud.

סידור באשכולות

קיבוץ דוגמאות קשורות, במיוחד במהלך למידה לא מפוקחת. אחרי שכל הדוגמאות מקובצות, אפשר להוסיף משמעות לכל אשכול.

קיימים אלגוריתמים רבים של קיבוץ באשכולות. לדוגמה, האלגוריתם k-means מקבץ דוגמאות על סמך הקרבה שלהן למרכז מסה, כמו בתרשים הבא:

לאחר מכן, חוקר אנושי יכול לבדוק את האשכולות ולתת להם שמות. לדוגמה, הוא יכול לתת לאשכול 1 את השם 'עצים ננסיים' ולאשכול 2 את השם 'עצים בגודל מלא'.

דוגמה נוספת: אלגוריתם של אשכולות שמבוסס על המרחק של דוגמה מנקודת מרכז, כמו בדוגמה הבאה:

מידע נוסף זמין בקורס בנושא אשכולות.

עיבוד משותף

התנהגות לא רצויה שבה נוירונים חוזים דפוסים בנתוני האימון על ידי הסתמכות כמעט בלעדית על הפלט של נוירונים ספציפיים אחרים, במקום להסתמך על ההתנהגות של הרשת כולה. אם הדפוסים שגורמים להתאמה משותפת לא מופיעים בנתוני האימות, ההתאמה המשותפת גורמת להתאמת יתר. רגולריזציה של נשירה מפחיתה את ההתאמה המשותפת כי הנשירה מבטיחה שהנוירונים לא יוכלו להסתמך רק על נוירונים ספציפיים אחרים.

סינון שיתופי

חיזוי תחומי העניין של משתמש מסוים על סמך תחומי העניין של משתמשים רבים אחרים. סינון שיתופי משמש לעיתים קרובות במערכות המלצה.

מידע נוסף זמין במאמר בנושא סינון שיתופי בקורס בנושא מערכות המלצה.

CommitmentBank (CB)

מערך נתונים להערכת רמת המיומנות של מודל LLM בקביעה אם מחבר הקטע מאמין לסעיף היעד בתוך הקטע. כל רשומה במערך הנתונים מכילה:

- פסקה

- סעיף יעד בתוך הפסקה הזו

- ערך בוליאני שמציין אם מחבר הקטע מאמין שהסעיף

לדוגמה:

- פסקה: איזה כיף לשמוע את ארטמיס צוחקת. היא ילדה כל כך רצינית. לא ידעתי שיש לה חוש הומור.

- סעיף היעד: she had a sense of humor

- Boolean: True, כלומר המחבר מאמין שהסעיף הממוקד

CommitmentBank הוא רכיב של SuperGLUE ensemble.

מודל קומפקטי

כל מודל קטן שמיועד להפעלה במכשירים קטנים עם משאבי מחשוב מוגבלים. לדוגמה, מודלים קומפקטיים יכולים לפעול בטלפונים ניידים, בטאבלטים או במערכות מוטמעות.

מחשוב

(שם עצם) משאבי המחשוב שמשמשים מודל או מערכת, כמו כוח עיבוד, זיכרון ואחסון.

סחף קונספט

שינוי בקשר בין התכונות לתווית. עם הזמן, סחף מושגים מפחית את איכות המודל.

במהלך האימון, המודל לומד את הקשר בין התכונות לבין התוויות שלהן בקבוצת הנתונים לאימון. אם התוויות ב קבוצת נתונים לאימון הן תחליפים טובים לעולם האמיתי, אז המודל צריך לספק תחזיות טובות לגבי העולם האמיתי. עם זאת, בגלל סחף מושגים, התחזיות של המודל נוטות להידרדר עם הזמן.

לדוגמה, נניח שיש מודל של סיווג בינארי שמנבא אם מודל רכב מסוים הוא "חסכוני בדלק" או לא. כלומר, התכונות יכולות להיות:

- משקל הרכב

- דחיסת מנוע

- סוג תיבת ההילוכים

כשהתווית היא אחת מהאפשרויות הבאות:

- חסכוני בדלק

- לא חסכוני בדלק

עם זאת, ההגדרה של "מכונית חסכונית בדלק" משתנה כל הזמן. דגם מכונית שסומן כחסכוני בדלק בשנת 1994, כמעט בוודאות יסומן כלא חסכוני בדלק בשנת 2024. מודל שסובל מסחף מושגים נוטה להפיק חיזויים פחות ופחות שימושיים לאורך זמן.

השוו והבדילו עם nonstationarity.

תנאי

בעץ החלטה, כל צומת שמבצע בדיקה. לדוגמה, עץ ההחלטות הבא מכיל שני תנאים:

תנאי נקרא גם פיצול או בדיקה.

תנאי ניגודיות עם עלה.

ראה גם:

מידע נוסף זמין במאמר סוגי תנאים בקורס בנושא יערות החלטה.

המצאת סיפורים

מילה נרדפת למונח הזיה.

יכול להיות שהמונח 'המצאת סיפורים' מדויק יותר מבחינה טכנית מהמונח 'הזיה'. עם זאת, ההזיה הפכה לפופולרית קודם.

הגדרות אישיות

התהליך של הקצאת ערכי המאפיינים הראשוניים שמשמשים לאימון מודל, כולל:

- השכבות שמרכיבות את המודל

- המיקום של הנתונים

- היפר-פרמטרים כמו:

בפרויקטים של למידת מכונה, אפשר לבצע הגדרה באמצעות קובץ הגדרה מיוחד או באמצעות ספריות הגדרה כמו אלה:

הטיית אישור

הנטייה לחפש מידע, לפרש אותו, להעדיף אותו ולזכור אותו באופן שמחזק את האמונות או ההשערות הקיימות של האדם. יכול להיות שמפתחים של למידת מכונה יאספו או יתייגו נתונים בדרכים שישפיעו על התוצאה ויאשרו את האמונות הקיימות שלהם. הטיית אישור היא סוג של הטיה מרומזת.

הטיה של עורכי ניסויים היא סוג של הטיית אישור שבה עורך ניסויים ממשיך לאמן מודלים עד שמאושרת השערה קיימת.

מטריצת בלבול

טבלה בגודל NxN שמסכמת את מספר התחזיות הנכונות והלא נכונות שבוצעו על ידי מודל סיווג. לדוגמה, הנה מטריצת בלבול עבור מודל של סיווג בינארי:

| גידול (צפוי) | Non-Tumor (predicted) | |

|---|---|---|

| גידול (אמת קרקע) | 18 (TP) | 1 (FN) |

| Non-Tumor (ground truth) | 6 (FP) | 452 (TN) |

מטריצת הבלבול שלמעלה מציגה את הנתונים הבאים:

- מתוך 19 התחזיות שבהן אמת קרקע הייתה Tumor, המודל סיווג 18 מהן בצורה נכונה ו-1 בצורה שגויה.

- מתוך 458 התחזיות שבהן אמת הקרקע הייתה Non-Tumor, המודל סיווג 452 בצורה נכונה ו-6 בצורה שגויה.

מטריצת הבלבול של בעיית סיווג רב-מחלקתי יכולה לעזור לכם לזהות דפוסים של טעויות. לדוגמה, נניח שיש מטריצת בלבול למודל סיווג רב-סוגי עם 3 סוגים, שמסווג 3 סוגים שונים של אירוסים (Virginica, Versicolor ו-Setosa). כשערך אמת הקרקע היה Virginica, מטריצת הטעות מראה שהמודל היה הרבה יותר סביר לטעות ולחזות Versicolor מאשר Setosa:

| Setosa (predicted) | Versicolor (צפוי) | Virginica (חזוי) | |

|---|---|---|---|

| Setosa (אמת קרקע) | 88 | 12 | 0 |

| Versicolor (אמת קרקע) | 6 | 141 | 7 |

| Virginica (אמת קרקע) | 2 | 27 | 109 |

דוגמה נוספת: מטריצת בלבול יכולה לחשוף שמודל שאומן לזיהוי ספרות בכתב יד נוטה לחזות בטעות 9 במקום 4, או לחזות בטעות 1 במקום 7.

מטריצות השגיאה מכילות מספיק מידע כדי לחשב מגוון מדדי ביצועים, כולל דיוק ורגישות.

ניתוח של מחוז בחירה

חלוקת משפט למבנים דקדוקיים קטנים יותר ("רכיבים"). חלק מאוחר יותר במערכת למידת המכונה, כמו מודל של הבנת שפה טבעית, יכול לנתח את המרכיבים בקלות רבה יותר מאשר המשפט המקורי. לדוגמה, המשפט הבא:

החבר שלי אימץ שני חתולים.

מנתח של מרכיבי משפט יכול לחלק את המשפט הזה לשני מרכיבים:

- My friend הוא צירוף שם.

- adopted two cats הוא צירוף פועל.

אפשר לחלק את המרכיבים האלה למרכיבים קטנים יותר. לדוגמה, צירוף הפועל

אימצתי שני חתולים

אפשר לחלק אותם עוד יותר לקטגוריות הבאות:

- adopted הוא פועל.

- two cats (שני חתולים) הוא עוד צירוף שם עצם.

הטמעת שפה בהתאם להקשר

הטמעה שמתקרבת ל'הבנה' של מילים וביטויים בדרכים שדוברי שפה אנושית שוטפת יכולים להבין. הטמעות של שפה בהקשר יכולות להבין תחביר, סמנטיקה והקשר מורכבים.

לדוגמה, נבחן הטמעות של המילה cow באנגלית. הטמעות ישנות יותר, כמו word2vec, יכולות לייצג מילים באנגלית כך שהמרחק במרחב ההטמעה מcow (פרה) לbull (שור) דומה למרחק מewe (כבשה) לram (איל) או מfemale (נקבה) לmale (זכר). הטמעות שפה בהקשר יכולות ללכת צעד אחד קדימה ולזהות שדוברי אנגלית משתמשים לפעמים במילה cow באופן לא רשמי כדי להתייחס לפרה או לשור.

חלון ההקשר

מספר הטוקנים שמודל יכול לעבד בהנחיה נתונה. ככל שחלון ההקשר גדול יותר, המודל יכול להשתמש ביותר מידע כדי לספק תשובות עקביות וקוהרנטיות להנחיה.

תכונה רציפה

תכונה של נקודה צפה עם טווח אינסופי של ערכים אפשריים, כמו רמת אקראיות או משקל.

ההבדל בין התכונה הזו לבין תכונה נפרדת.

דגימת נוחות [ברבים: דגימות נוחוּת]

שימוש במערך נתונים שלא נאסף בצורה מדעית כדי להריץ ניסויים מהירים. בהמשך, חשוב לעבור למערך נתונים שנאסף באופן מדעי.

התכנסות

מצב שמתקבל כשערכי ההפסד משתנים מעט מאוד או לא משתנים בכלל בכל איטרציה. לדוגמה, מעקומת ההפסד הבאה אפשר לראות שההתכנסות מתרחשת בערך אחרי 700 איטרציות:

מודל מתכנס כשאימון נוסף לא ישפר אותו.

בלמידה עמוקה, ערכי ההפסד נשארים לפעמים קבועים או כמעט קבועים במשך הרבה איטרציות לפני שהם יורדים בסופו של דבר. במהלך תקופה ארוכה של ערכי הפסד קבועים, יכול להיות שתקבלו באופן זמני תחושה מוטעית של התכנסות.

אפשר לעיין גם במאמר בנושא עצירה מוקדמת.

מידע נוסף זמין במאמר Model convergence and loss curves (התכנסות מודלים ועקומות הפסד) בסדנה בנושא למידת מכונה.

תכנות בממשק שיחה

תיבת דו-שיח איטרטיבית ביניכם לבין מודל AI גנרטיבי, במטרה ליצור תוכנה. אתם מזינים הנחיה שמתארת תוכנה מסוימת. לאחר מכן, המודל משתמש בתיאור הזה כדי ליצור קוד. אחר כך, מזינים הנחיה חדשה כדי לטפל בפגמים בהנחיה הקודמת או בקוד שנוצר, והמודל יוצר קוד מעודכן. אתם ממשיכים להחליף תשובות עד שהתוכנה שנוצרה מספיק טובה.

קידוד שיחות הוא למעשה המשמעות המקורית של תכנות בשיטת Vibe coding.

ההבדל בין זה לבין תכנות לפי מפרט.

פונקציה קמורה

פונקציה שבה האזור שמעל הגרף שלה הוא קבוצה קמורה. הצורה של פונקציה קמורה טיפוסית דומה לצורה של האות U. לדוגמה, הפונקציות הבאות הן פונקציות קמורות:

לעומת זאת, הפונקציה הבאה היא לא קמורה. שימו לב שהאזור שמעל הגרף הוא לא קבוצה קמורה:

לפונקציה קמורה לחלוטין יש בדיוק נקודת מינימום מקומית אחת, שהיא גם נקודת המינימום הגלובלית. הפונקציות הקלאסיות בצורת U הן פונקציות קמורות לחלוטין. עם זאת, חלק מהפונקציות הקמורות (למשל, קווים ישרים) לא יוצרות צורה של U.

מידע נוסף זמין במאמר התכנסות ופונקציות קמורות בסדנה ללימוד מכונתית.

אופטימיזציה קמורה

התהליך של שימוש בטכניקות מתמטיות כמו ירידת גרדיאנט כדי למצוא את המינימום של פונקציה קמורה. חלק גדול מהמחקר בתחום למידת המכונה מתמקד בניסוח של בעיות שונות כבעיות אופטימיזציה קמורות, ובפתרון הבעיות האלה בצורה יעילה יותר.

פרטים נוספים זמינים בספר Convex Optimization של Boyd ו-Vandenberghe.

קבוצה קמורה

קבוצת משנה של מרחב אוקלידי, כך שקו שמצויר בין שתי נקודות כלשהן בקבוצת המשנה נשאר כולו בתוך קבוצת המשנה. לדוגמה, שתי הצורות הבאות הן קבוצות קמורות:

לעומת זאת, שתי הצורות הבאות הן לא קבוצות קמורות:

קונבולוציה

במתמטיקה, באופן לא רשמי, תערובת של שתי פונקציות. בלימוד מכונה, קונבולוציה היא ערבוב של מסנן קונבולוציוני ומטריצת הקלט כדי לאמן משקלים.

המונח 'קונבולוציה' בלמידת מכונה הוא לרוב קיצור לפעולת קונבולוציה או לשכבת קונבולוציה.

ללא קונבולוציות, אלגוריתם של למידת מכונה יצטרך ללמוד משקל נפרד לכל תא בטנסור גדול. לדוגמה, אלגוריתם של למידת מכונה שאומן על תמונות בגודל 2K x 2K יצטרך למצוא 4 מיליון משקלים נפרדים. בזכות קונבולוציות, אלגוריתם של למידת מכונה צריך למצוא משקלים רק לכל תא במסנן הקונבולוציה, וכך מצטמצם באופן משמעותי הזיכרון שנדרש לאימון המודל. כשמחילים את המסנן הקונבולוציוני, הוא פשוט משוכפל בתאים כך שכל תא מוכפל במסנן.

מסנן קונבולוציה

אחד משני השחקנים בפעולת קונבולוציה. (השחקן השני הוא פרוסה של מטריצת קלט). מסנן קונבולוציה הוא מטריצה עם דרגה זהה לזו של מטריצת הקלט, אבל עם צורה סגורה קטנה יותר. לדוגמה, אם מטריצת הקלט היא בגודל 28x28, המסנן יכול להיות כל מטריצה דו-ממדית קטנה יותר מ-28x28.

במניפולציה של תמונות, כל התאים במסנן קונבולוציה מוגדרים בדרך כלל לתבנית קבועה של אחדות ואפסים. בלמידת מכונה, מסנני קונבולוציה בדרך כלל מאותחלים עם מספרים אקראיים, ואז הרשת מתאמנת על הערכים האידיאליים.

שכבת קונבולוציה

שכבה של רשת עצבית עמוקה שבה מסנן קונבולוציה עובר לאורך מטריצת קלט. לדוגמה, נבחן את מסנן הקונבולוציה הבא בגודל 3x3:

![מטריצה בגודל 3x3 עם הערכים הבאים: [[0,1,0], [1,0,1], [0,1,0]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalFilter33.svg?authuser=0&hl=he)

באנימציה הבאה מוצגת שכבת קונבולוציה שמורכבת מ-9 פעולות קונבולוציה שכוללות את מטריצת הקלט בגודל 5x5. שימו לב שכל פעולת קונבולוציה פועלת על פרוסת 3x3 שונה של מטריצת הקלט. מטריצת 3x3 שמתקבלת (משמאל) מורכבת מתוצאות של 9 פעולות קונבולוציה:

![אנימציה שמציגה שתי מטריצות. המטריצה הראשונה היא מטריצה בגודל 5x5: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].

המטריצה השנייה היא מטריצה בגודל 3x3:

[[181,303,618], [115,338,605], [169,351,560]].

המטריצה השנייה מחושבת על ידי החלת המסנן הקונבולוציוני [[0, 1, 0], [1, 0, 1], [0, 1, 0]] על קבוצות משנה שונות בגודל 3x3 של המטריצה בגודל 5x5.](https://developers.google.cn/static/machine-learning/glossary/images/AnimatedConvolution.gif?authuser=0&hl=he)

רשת נוירונים קונבולוציונית

רשת נוירונים שבה לפחות שכבה אחת היא שכבת קונבולוציה. רשת נוירונים קונבולוציונית טיפוסית מורכבת משילוב כלשהו של השכבות הבאות:

רשתות נוירונים קונבולוציוניות (CNN) השיגו הצלחה רבה בפתרון בעיות מסוימות, כמו זיהוי תמונות.

פעולה של קונבולוציה

הפעולה המתמטית הבאה בת שני השלבים:

- הכפלה של כל רכיב במסנן הקונבולוציה עם פרוסת מטריצת קלט. (לפרוסת מטריצת הקלט יש דרגה וגודל זהים לאלה של מסנן הקונבולוציה).

- סכום כל הערכים במטריצת המוצרים שמתקבלת.

לדוגמה, מטריצת הקלט הבאה בגודל 5x5:

![מטריצה 5x5: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerInputMatrix.svg?authuser=0&hl=he)

עכשיו נדמיין מסנן קונבולוציה בגודל 2x2:

![המטריצה 2x2: [[1, 0], [0, 1]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerFilter.svg?authuser=0&hl=he)

כל פעולת קונבולוציה כוללת פרוסה אחת בגודל 2x2 של מטריצת הקלט. לדוגמה, נניח שאנחנו משתמשים בפלח בגודל 2x2 בפינה הימנית העליונה של מטריצת הקלט. לכן, פעולת הקונבולוציה על הפרוסה הזו נראית כך:

![החלת מסנן קונבולוציה [[1, 0], [0, 1]] על החלק בגודל 2x2 בפינה הימנית העליונה של מטריצת הקלט, שהוא [[128,97], [35,22]].

המסנן הקונבולוציוני משאיר את הערכים 128 ו-22 ללא שינוי, אבל מאפס את הערכים 97 ו-35. לכן, פעולת הקונבולוציה מחזירה את הערך 150 (128+22).](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerOperation.svg?authuser=0&hl=he)

שכבת קונבולוציה מורכבת מסדרה של פעולות קונבולוציה, שכל אחת מהן פועלת על פרוסה אחרת של מטריצת הקלט.

COPA

קיצור של בחירת חלופות סבירות.

עלות

מילה נרדפת להפסד.

אימון משותף

גישה של למידה מונחית למחצה, שימושית במיוחד כשכל התנאים הבאים הם TRUE:

- היחס בין דוגמאות לא מסומנות לבין דוגמאות מסומנות במערך הנתונים גבוה.

- זו בעיית סיווג (בינארי או מרובה מחלקות).

- מערך הנתונים מכיל שני סטים שונים של תכונות חיזוי, שהם בלתי תלויים ומשלימים זה את זה.

במהלך האימון המשותף, אותות עצמאיים מוגברים והופכים לאות חזק יותר. לדוגמה, נניח שיש מודל סיווג שמסווג מכוניות משומשות בודדות כטובות או כגרועות. קבוצה אחת של תכונות חיזויות עשויה להתמקד במאפיינים מצטברים כמו השנה, היצרן והדגם של המכונית. קבוצה אחרת של תכונות חיזויות עשויה להתמקד ברשומת הנהיגה של הבעלים הקודם ובהיסטוריית התחזוקה של המכונית.

מאמר חשוב בנושא אימון משותף הוא Combining Labeled and Unlabeled Data with Co-Training מאת Blum ו-Mitchell.

הוגנות קונטרה-פקטואלית

מדד הוגנות שבודק אם מודל סיווג מפיק את אותה תוצאה עבור אדם מסוים כמו עבור אדם אחר זהה, למעט מאפיינים רגישים מסוימים. הערכה של מודל סיווג מבחינת הוגנות קונטרה-פקטואלית היא שיטה אחת לחשיפת מקורות פוטנציאליים של הטיה במודל.

מידע נוסף זמין במאמרים הבאים:

- הוגנות: הוגנות מנוגדת לעובדות בקורס המקוצר על למידת מכונה.

- When Worlds Collide: Integrating Different Counterfactual Assumptions in Fairness

הטיית כיסוי

ראו הטיית בחירה.

crash blossom

משפט או ביטוי עם משמעות לא ברורה. תופעת ה-crash blossoms יוצרת בעיה משמעותית בהבנת שפה טבעית. לדוגמה, הכותרת Red Tape Holds Up Skyscraper היא כותרת בעלת משמעות כפולה, כי מודל NLU יכול לפרש את הכותרת באופן מילולי או באופן פיגורטיבי.

מבקר/ת

מילה נרדפת ל-Deep Q-Network.

אנטרופיה צולבת

הכללה של Log Loss לבעיות סיווג מרובות מחלקות. האנטרופיה הצולבת מכמתת את ההבדל בין שתי התפלגויות הסתברות. מידע נוסף זמין במאמר בנושא perplexity.

אימות צולב

מנגנון להערכת מידת ההתאמה של מודל לנתונים חדשים. ההערכה מתבצעת על ידי בדיקת המודל מול קבוצות משנה של נתונים שלא חופפות זו לזו, שלא נכללו בקבוצת נתונים לאימון.

פונקציית התפלגות מצטברת (CDF)

פונקציה שמגדירה את התדירות של דגימות שקטנות מערך יעד או שוות לו. לדוגמה, נניח שיש התפלגות נורמלית של ערכים רציפים. פונקציית CDF מראה שכ-50% מהדגימות צריכות להיות קטנות מהממוצע או שוות לו, וכ-84% מהדגימות צריכות להיות קטנות מהממוצע בסטיית תקן אחת או שוות לו.

D

ניתוח נתונים

הבנת הנתונים על ידי בחינת דוגמאות, מדידות והמחשה. ניתוח נתונים יכול להיות שימושי במיוחד כשמקבלים מערך נתונים בפעם הראשונה, לפני שיוצרים את המודל הראשון. הוא גם חשוב להבנת ניסויים ולניפוי באגים במערכת.

הגדלת מערך הנתונים

הגדלה מלאכותית של טווח הדוגמאות ושל מספר הדוגמאות לאימון על ידי שינוי דוגמאות קיימות כדי ליצור דוגמאות נוספות. לדוגמה, נניח שתמונות הן אחת מהתכונות שלכם, אבל מערך הנתונים לא מכיל מספיק דוגמאות של תמונות כדי שהמודל יוכל ללמוד שיוכים שימושיים. מומלץ להוסיף למערך הנתונים מספיק תמונות מתויגות כדי לאפשר אימון תקין של המודל. אם זה לא אפשרי, אפשר להשתמש בהגדלת מערך הנתונים כדי לסובב, למתוח ולשקף כל תמונה כדי ליצור וריאציות רבות של התמונה המקורית. יכול להיות שזה יניב מספיק נתונים מתויגים כדי לאפשר אימון מצוין.

DataFrame

סוג נתונים פופולרי של pandas לייצוג מערכי נתונים בזיכרון.

אובייקט DataFrame דומה לטבלה או לגיליון אלקטרוני. לכל עמודה ב-DataFrame יש שם (כותרת), ולכל שורה יש מספר ייחודי שמזהה אותה.

כל עמודה ב-DataFrame בנויה כמו מערך דו-ממדי, אבל לכל עמודה אפשר להקצות סוג נתונים משלה.

אפשר לעיין גם בדף העיון הרשמי של pandas.DataFrame.

מקביליות נתונים

שיטה להרחבת אימון או הסקת מסקנות, שבה משכפלים מודל שלם למספר מכשירים ואז מעבירים לכל מכשיר קבוצת משנה של נתוני הקלט. מקביליות נתונים יכולה לאפשר אימון והסקת מסקנות בגדלים גדולים מאוד של אצווה. עם זאת, מקביליות נתונים מחייבת שהמודל יהיה קטן מספיק כדי להתאים לכל המכשירים.

בדרך כלל, מקביליות נתונים מזרזת את האימון וההסקה.

אפשר לעיין גם במאמר בנושא מקביליות של מודלים.

Dataset API (tf.data)

API ברמה גבוהה של TensorFlow לקריאת נתונים ולהמרה שלהם לפורמט שנדרש לאלגוריתם של למידת מכונה.

אובייקט tf.data.Dataset מייצג רצף של רכיבים, שכל אחד מהם מכיל Tensor אחד או יותר. אובייקט tf.data.Iterator

מספק גישה לרכיבים של Dataset.

קבוצת נתונים

אוסף של נתונים גולמיים, בדרך כלל (אבל לא רק) באחד מהפורמטים הבאים:

- גיליון אלקטרוני

- קובץ בפורמט CSV (ערכים מופרדים בפסיקים)

גבול ההחלטה

הקו המפריד בין classes שנלמדו על ידי model בbinary class או בmulti-class classification problems. לדוגמה, בתמונה הבאה שמייצגת בעיית סיווג בינארית, גבול ההחלטה הוא הגבול בין המחלקה הכתומה למחלקה הכחולה:

יער החלטות

מודל שנוצר מכמה עצי החלטה. כדי לבצע חיזוי, יער ההחלטות צובר את החיזויים של עצי ההחלטות שלו. סוגים פופולריים של יערות החלטה כוללים יערות אקראיים ועצים עם שיפור גרדיאנט.

מידע נוסף זמין בקטע יערות של החלטות בקורס בנושא יערות של החלטות.

סף ההחלטה

מילה נרדפת לסף סיווג.

עץ החלטה

מודל של למידה מונחית שמורכב מקבוצה של תנאים וענפים שמאורגנים בהיררכיה. לדוגמה, זהו עץ החלטות:

מפענח

באופן כללי, כל מערכת ML שמבצעת המרה מייצוג מעובד, צפוף או פנימי לייצוג גולמי, דליל או חיצוני יותר.

מפענחים הם לרוב רכיב של מודל גדול יותר, ולעתים קרובות הם משולבים עם מקודד.

במשימות של רצף לרצף, מפענח מתחיל עם המצב הפנימי שנוצר על ידי המקודד כדי לחזות את הרצף הבא.

במאמר Transformer מופיעה הגדרה של מפענח בארכיטקטורת Transformer.

מידע נוסף זמין במאמר מודלים גדולים של שפה בקורס Machine Learning Crash Course.

מודל עמוק

רשת נוירונים שמכילה יותר משכבה נסתרת.

מודל עמוק נקרא גם רשת עצבית עמוקה.

ההבדל בינו לבין מודל רחב.

של רשת עצבית עמוקה

מילה נרדפת למודל עמוק.

Deep Q-Network (DQN)

ב-Q-learning, נעשה שימוש ברשת עצבית עמוקה כדי לחזות פונקציות Q.

Critic הוא מילה נרדפת ל-Deep Q-Network.

שוויון דמוגרפי

מדד הוגנות שמתקיים אם תוצאות הסיווג של המודל לא תלויות במאפיין רגיש נתון.

לדוגמה, אם גם אנשי ליליפוט וגם אנשי ברובדינגנאג מגישים בקשה להתקבל לאוניברסיטת גלאבדאבדריב, מתקבלת שוויון דמוגרפי אם אחוז אנשי ליליפוט שהתקבלו זהה לאחוז אנשי ברובדינגנאג שהתקבלו, ללא קשר לשאלה אם קבוצה אחת מוסמכת יותר מהשנייה בממוצע.

ההגדרה הזו שונה מסיכויים שווים ומשוויון הזדמנויות, שמאפשרות לתוצאות הסיווג הכוללות להיות תלויות במאפיינים רגישים, אבל לא מאפשרות לתוצאות הסיווג של תוויות אמת בסיסית מסוימות להיות תלויות במאפיינים רגישים. במאמר "Attacking discrimination with smarter machine learning" (התמודדות עם אפליה באמצעות למידת מכונה חכמה יותר) מוצג תרשים שממחיש את היתרונות והחסרונות של אופטימיזציה להשגת שוויון דמוגרפי.

מידע נוסף זמין במאמר בנושא הוגנות: שוויון דמוגרפי בקורס המקוצר על למידת מכונה.

ניקוי רעשים

גישה נפוצה ללמידה מונחית עצמית שבה:

הסרת רעשים מאפשרת מצב למידה מדוגמאות לא מסומנות. מערך הנתונים המקורי משמש כיעד או כתווית, והנתונים הרועשים משמשים כקלט.

חלק ממודלים של שפה עם מיסוך משתמשים בהסרת רעשים באופן הבא:

- רעש מתווסף באופן מלאכותי למשפט לא מסומן על ידי מיסוך של חלק מהטוקנים.

- המודל מנסה לחזות את הטוקנים המקוריים.

תכונה צפופה

תכונה שרוב הערכים שלה או כולם הם לא אפס, בדרך כלל טנזור של ערכים מסוג נקודה צפה. לדוגמה, טנסור 10-אלמנטים הבא הוא צפוף כי 9 מהערכים שלו הם לא אפס:

| 8 | 3 | 7 | 5 | 2 | 4 | 0 | 4 | 9 | 6 |

ההבדל בין התכונה הזו לבין sparse feature.

שכבה צפופה

מילה נרדפת לשכבה מקושרת באופן מלא.

depth

הסכום של הרכיבים הבאים ברשת נוירונים:

- מספר השכבות הנסתרות

- מספר שכבות הפלט, שבדרך כלל הוא 1

- מספר שכבות ההטמעה

לדוגמה, רשת נוירונים עם חמש שכבות נסתרות ושכבת פלט אחת היא בעומק 6.

שימו לב ששכבת הקלט לא משפיעה על העומק.

רשת נוירונים מלאכותית (CNN) עם קונבולוציה נפרדת לפי עומק (sepCNN)

ארכיטקטורה של רשת נוירונים מורכבת שמבוססת על Inception, אבל מודולי Inception מוחלפים בה ב-convolutions נפרדים לפי עומק. נקרא גם Xception.

קונבולוציה ניתנת להפרדה לפי עומק (שנקראת גם קונבולוציה ניתנת להפרדה) מפרקת קונבולוציה תלת-ממדית רגילה לשתי פעולות קונבולוציה נפרדות שהן יעילות יותר מבחינת חישוב: קודם, קונבולוציה לפי עומק, עם עומק של 1 (n ✕ n ✕ 1), ואז, קונבולוציה לפי נקודה, עם אורך ורוחב של 1 (1 ✕ 1 ✕ n).

מידע נוסף זמין במאמר Xception: Deep Learning with Depthwise Separable Convolutions.

תווית נגזרת

מילה נרדפת ל-תווית proxy.

מכשיר

מונח עמוס עם שתי הגדרות אפשריות:

- קטגוריה של חומרה שיכולה להריץ סשן של TensorFlow, כולל מעבדי CPU, מעבדי GPU ומעבדי TPU.

- כשמבצעים אימון של מודל ML על שבבי האצה (GPU או TPU), החלק במערכת שמבצע בפועל מניפולציה של טנסורים ושל הטבעות. המכשיר פועל על שבבי האצה. לעומת זאת, המארח פועל בדרך כלל במעבד.

פרטיות דיפרנציאלית

במידת מכונה, גישה לאנונימיזציה שמטרתה להגן על נתונים רגישים (לדוגמה, מידע אישי של אדם מסוים) שכלולים במערך האימונים של מודל מפני חשיפה. הגישה הזו מבטיחה שהמודל לא ילמד או יזכור הרבה על אדם ספציפי. ההגנה הזו מושגת באמצעות דגימה והוספת רעש במהלך אימון המודל, כדי להסתיר נקודות נתונים פרטניות ולצמצם את הסיכון לחשיפת נתוני אימון רגישים.

פרטיות דיפרנציאלית משמשת גם מחוץ ללמידת מכונה. לדוגמה, מדעני נתונים משתמשים לפעמים בפרטיות דיפרנציאלית כדי להגן על הפרטיות של משתמשים ספציפיים כשהם מחשבים נתונים סטטיסטיים על השימוש במוצר עבור מאפיינים דמוגרפיים שונים.

הפחתת ממדים

הקטנת מספר המאפיינים שמשמשים לייצוג תכונה מסוימת בווקטור תכונות, בדרך כלל על ידי המרה לווקטור הטמעה.

מימדים

מונח בעל עומס יתר עם אחת מההגדרות הבאות:

מספר הרמות של הקואורדינטות בTensor. לדוגמה:

- לסקלר יש אפס ממדים, לדוגמה:

["Hello"]. - לווקטור יש מימד אחד, לדוגמה,

[3, 5, 7, 11]. - למטריצה יש שני מאפיינים, לדוגמה,

[[2, 4, 18], [5, 7, 14]]. אפשר לציין באופן ייחודי תא מסוים בווקטור חד-ממדי באמצעות קואורדינטה אחת, אבל צריך שתי קואורדינטות כדי לציין באופן ייחודי תא מסוים במטריצה דו-ממדית.

- לסקלר יש אפס ממדים, לדוגמה:

מספר הרשומות בוקטור מאפיינים.

מספר האלמנטים בשכבת הטמעה.

מתן הנחיות ישירות

מילה נרדפת להנחיות בלי דוגמאות (zero-shot prompting).

תכונה נפרדת

תכונה עם קבוצה סופית של ערכים אפשריים. לדוגמה, מאפיין שהערכים שלו יכולים להיות רק animal (בעל חיים), vegetable (ירק) או mineral (מינרל) הוא מאפיין בדיד (או קטגורי).

ההפך מתכונה מתמשכת.

מודל דיסקרימינטיבי

מודל שמנבא תוויות מתוך קבוצה של תכונות אחת או יותר. באופן רשמי יותר, מודלים דיסקרימינטיביים מגדירים את ההסתברות המותנית של פלט בהינתן התכונות והמשקלים, כלומר:

p(output | features, weights)

לדוגמה, מודל שמנבא אם אימייל הוא ספאם על סמך תכונות ומשקלים הוא מודל דיסקרימינטיבי.

רוב המודלים של למידה מונחית, כולל מודלים של סיווג ורגרסיה, הם מודלים דיסקרימינטיביים.

ההגדרה הזו שונה ממודל גנרטיבי.

דיסקרימינטור

מערכת שקובעת אם הדוגמאות אמיתיות או מזויפות.

לחלופין, מערכת המשנה בתוך רשת גנרטיבית יריבה שקובעת אם הדוגמאות שנוצרו על ידי הגנרטור הן אמיתיות או מזויפות.

מידע נוסף זמין במאמר המסווג בקורס GAN.

השפעה שונה

קבלת החלטות לגבי אנשים שמשפיעות באופן לא פרופורציונלי על קבוצות משנה שונות באוכלוסייה. בדרך כלל הכוונה היא למצבים שבהם תהליך אלגוריתמי של קבלת החלטות פוגע בקבוצות משנה מסוימות יותר מאחרות, או מועיל להן יותר מאשר לאחרות.

לדוגמה, נניח שיש אלגוריתם שקובע אם אדם זכאי להלוואה לרכישת בית זעיר. סביר יותר שהאלגוריתם יסווג את האדם כ'לא זכאי' אם כתובת למשלוח דואר שלו מכילה מיקוד מסוים. אם לליליפוטים מסוג Big-Endian יש סיכוי גבוה יותר לכתובות למשלוח עם המיקוד הזה מאשר לליליפוטים מסוג Little-Endian, יכול להיות שהאלגוריתם הזה יגרום להשפעה לא פרופורציונלית.

הגדרה זו שונה מיחס מפלה, שמתמקדת בפערים שנוצרים כשמאפיינים של תת-קבוצה הם קלט מפורש לתהליך קבלת החלטות אלגוריתמי.

יחס שונה

הכללת מאפיינים רגישים של נושאים בתהליך קבלת החלטות אלגוריתמי, כך שקבוצות משנה שונות של אנשים מקבלות יחס שונה.

לדוגמה, נניח שיש אלגוריתם שקובע אם אנשים מליליפוט זכאים להלוואה לרכישת בית מיניאטורי על סמך הנתונים שהם מספקים בבקשת ההלוואה. אם האלגוריתם משתמש בנתונים משוייכים של תושב ליליפוט כ-Big-Endian או כ-Little-Endian כקלט, הוא מבצע אפליה לאורך הממד הזה.

ההגדרה הזו שונה מהשפעה לא פרופורציונלית, שמתמקדת בפערים בהשפעות החברתיות של החלטות אלגוריתמיות על קבוצות משנה, בלי קשר לשאלה אם קבוצות המשנה האלה הן נתוני קלט למודל.

זיקוק

תהליך של הקטנת מודל אחד (שנקרא מורה) למודל קטן יותר (שנקרא תלמיד) שמדמה את התחזיות של המודל המקורי בצורה הכי נאמנה שאפשר. זיקוק מועיל כי למודל הקטן יש שני יתרונות מרכזיים על פני המודל הגדול יותר (המודל המלמד):

- זמן הסקת מסקנות מהיר יותר

- צריכת זיכרון ואנרגיה מופחתת

עם זאת, בדרך כלל התחזיות של התלמידים לא טובות כמו התחזיות של המורים.

בזיקוק, המודל התלמיד מאומן למזער פונקציית הפסד על סמך ההבדל בין התוצאות של התחזיות של מודל התלמיד ומודל המורה.

השוו והבדילו בין זיקוק לבין המונחים הבאים:

מידע נוסף מופיע במאמר מודלים גדולים של שפה (LLM): כוונון עדין, זיקוק והנדסת הנחיות בסדנה המקוונת בנושא למידת מכונה.

distribution

התדירות והטווח של ערכים שונים עבור תכונה או תווית נתונים מסוימת. התפלגות מתעדת את הסבירות של ערך מסוים.

בתמונה הבאה מוצגים היסטוגרמות של שתי התפלגויות שונות:

- בצד ימין, התפלגות חוק החזקה של העושר לעומת מספר האנשים שמחזיקים בעושר הזה.

- משמאל, התפלגות נורמלית של הגובה לעומת מספר האנשים בגובה הזה.

הבנת הפיזור של כל תכונה ותווית יכולה לעזור לכם לקבוע איך לנרמל ערכים ולזהות ערכים חריגים.

הביטוי out of distribution מתייחס לערך שלא מופיע במערך הנתונים או שהוא נדיר מאוד. לדוגמה, תמונה של כוכב שבתאי תיחשב כחריגה מהתפלגות הנתונים במערך נתונים שמורכב מתמונות של חתולים.

סידור באשכולות באמצעות חלוקה

ראו אשכול היררכי.

דגימה ברזולוציה נמוכה

מונח עמוס שיכול להתייחס לאחת מהאפשרויות הבאות:

- צמצום כמות המידע בתכונה כדי לאמן מודל בצורה יעילה יותר. לדוגמה, לפני אימון מודל לזיהוי תמונות, מבצעים דגימת חסר של תמונות ברזולוציה גבוהה לפורמט ברזולוציה נמוכה יותר.

- אימון על אחוז נמוך באופן לא פרופורציונלי של דוגמאות של סיווגים שמיוצגים יתר על המידה, כדי לשפר את אימון המודל על סיווגים שמיוצגים פחות. לדוגמה, במערך נתונים עם חוסר איזון בין מחלקות, המודלים נוטים ללמוד הרבה על מחלקת הרוב ולא מספיק על מחלקת המיעוט. הפחתת דגימה עוזרת לאזן את כמות האימון של רוב המחלקות ומיעוט המחלקות.

מידע נוסף זמין במאמר מערכי נתונים: מערכי נתונים לא מאוזנים בקורס המקוצר על למידת מכונה.

DQN

קיצור של Deep Q-Network (רשת Q עמוקה).

רגולריזציה של ניתוק

סוג של רגולריזציה שמועיל באימון של רשתות נוירונים. הרגולריזציה של Dropout מסירה בחירה אקראית של מספר קבוע של יחידות בשכבת רשת לשלב גרדיאנט יחיד. ככל שיותר יחידות נושרות, כך הרגולריזציה חזקה יותר. זה דומה לאימון הרשת כדי לחקות אנסמבל גדול באופן אקספוננציאלי של רשתות קטנות יותר. פרטים מלאים זמינים במאמר Dropout: A Simple Way to Prevent Neural Networks from Overfitting.

דינמי

משהו שעושים לעיתים קרובות או באופן רציף. המונחים דינמי ואונליין הם מילים נרדפות בתחום למידת המכונה. אלה שימושים נפוצים במונחים דינמי ואונליין בלמידת מכונה:

- מודל דינמי (או מודל אונליין) הוא מודל שעובר אימון מחדש לעיתים קרובות או באופן רציף.

- הדרכה דינמית (או הדרכה אונליין) היא תהליך של הדרכה בתדירות גבוהה או באופן רציף.

- הסקת מסקנות דינמית (או הסקת מסקנות אונליין) היא תהליך של יצירת תחזיות לפי דרישה.

מודל דינמי

מודל שעובר אימון מחדש לעיתים קרובות (אולי אפילו באופן רציף). מודל דינמי הוא 'לומד לכל החיים' שמתאים את עצמו כל הזמן לנתונים משתנים. מודל דינמי נקרא גם מודל אונליין.

השוואה למודל סטטי.

E

הרצה מיידית

סביבת תכנות של TensorFlow שבה פעולות מופעלות באופן מיידי. לעומת זאת, פעולות שמופעלות בהרצת גרף לא מופעלות עד שהן מוערכות באופן מפורש. ההרצה המיידית היא ממשק אימפרטיבי, בדומה לקוד ברוב שפות התכנות. בדרך כלל קל הרבה יותר לבצע ניפוי באגים בתוכניות של ביצוע Eager מאשר בתוכניות של ביצוע גרפים.

עצירה מוקדמת

שיטה לרגולריזציה שכוללת סיום של אימון לפני שההפסד של האימון מפסיק לרדת. בשיטת העצירה המוקדמת, עוצרים בכוונה את אימון המודל כשההפסד במערך נתוני האימות מתחיל לעלות, כלומר כשביצועי ההכללה מתדרדרים.

ההפך מיציאה מוקדמת.

מרחק בין תמונות (EMD)

מדד לדמיון היחסי בין שתי התפלגויות. ככל שהמרחק בין המכונות קטן יותר, כך ההתפלגויות דומות יותר.

מרחק עריכה

מדד של מידת הדמיון בין שתי מחרוזות טקסט. בלמידת מכונה, מרחק העריכה שימושי מהסיבות הבאות:

- קל לחשב את מרחק העריכה.

- מרחק העריכה יכול להשוות בין שתי מחרוזות שידוע שהן דומות זו לזו.

- מרחק העריכה יכול לקבוע את מידת הדמיון בין מחרוזות שונות למחרוזת נתונה.

יש כמה הגדרות של מרחק עריכה, וכל אחת מהן משתמשת בפעולות שונות על מחרוזות. דוגמה מופיעה במאמר בנושא מרחק לבנשטיין.

סימון איינשטיין

סימון יעיל לתיאור האופן שבו צריך לשלב בין שני טנסורים. הטנסורים משולבים על ידי הכפלת הרכיבים של טנסור אחד ברכיבים של הטנסור השני, ואז חישוב סכום המכפלות. בסימון איינסום משתמשים בסמלים כדי לזהות את הצירים של כל טנזור, ואותם סמלים מסודרים מחדש כדי לציין את הצורה סגורה של הטנזור החדש שמתקבל.

NumPy מספקת הטמעה נפוצה של Einsum.

שכבת הטמעה

שכבה נסתרת מיוחדת שעוברת אימון על מאפיין קטגורי עם הרבה ממדים, כדי ללמוד בהדרגה וקטור הטמעה עם פחות ממדים. שכבת הטמעה מאפשרת לרשת נוירונים להתאמן בצורה יעילה הרבה יותר מאשר אימון רק על תכונה קטגורית רב-ממדית.

לדוגמה, נכון לעכשיו, Earth תומך בכ-73,000 מיני עצים. נניח שהתכונה במודל היא מיני עצים, ולכן שכבת הקלט של המודל כוללת וקטור one-hot באורך 73,000 אלמנטים.

לדוגמה, יכול להיות שהתו baobab ייוצג כך:

מערך עם 73,000 רכיבים הוא ארוך מאוד. אם לא מוסיפים למודל שכבת הטמעה, האימון ייקח הרבה זמן כי צריך להכפיל 72,999 אפסים. יכול להיות שתבחרו ששכבת ההטמעה תכלול 12 ממדים. כתוצאה מכך, שכבת ההטמעה תלמד בהדרגה וקטור הטמעה חדש לכל מין של עץ.

במצבים מסוימים, גיבוב הוא חלופה סבירה לשכבת הטמעה.

מידע נוסף זמין במאמר Embeddings בקורס המקוצר על למידת מכונה.

מרחב הטמעה

מרחב וקטורי d-ממדי שאליו ממופים מאפיינים ממרחב וקטורי רב-ממדי. מרחב ההטמעה מאומן לזהות מבנה שמשמעותי לאפליקציה המיועדת.

המכפלה הסקלרית של שני וקטורי הטמעה היא מדד לדמיון ביניהם.

וקטור הטמעה

באופן כללי, מערך של מספרים ממשיים שמופיעים בכל שכבה נסתרת ומתארים את נתוני הקלט של אותה שכבה נסתרת. לרוב, וקטור הטמעה הוא מערך של מספרים בנקודה צפה שאומנו בשכבת הטמעה. לדוגמה, נניח ששכבת הטמעה צריכה ללמוד וקטור הטמעה לכל אחד מ-73,000 מיני העצים בכדור הארץ. יכול להיות שהמערך הבא הוא וקטור ההטמעה של עץ באובב:

וקטור הטמעה הוא לא אוסף של מספרים אקראיים. שכבת הטמעה קובעת את הערכים האלה באמצעות אימון, בדומה לאופן שבו רשת נוירונים לומדת משקלים אחרים במהלך האימון. כל רכיב במערך הוא דירוג של מאפיין מסוים של מין עצים. איזה רכיב מייצג את המאפיין של איזה מין עץ? קשה מאוד לבני אדם לקבוע את זה.

החלק המדהים מבחינה מתמטית בווקטור הטמעה הוא שפריטים דומים כוללים קבוצות דומות של מספרים בנקודה צפה. לדוגמה, מינים דומים של עצים יניבו קבוצה דומה יותר של מספרים עם נקודה עשרונית מאשר מינים שונים של עצים. עצי סקוויה ועצי רדווד הם מינים קרובים של עצים, ולכן יהיה להם סט דומה יותר של מספרים עם נקודה צפה מאשר לעצי רדווד ולעצי קוקוס. המספרים בווקטור ההטמעה ישתנו בכל פעם שתאמנו מחדש את המודל, גם אם תאמנו אותו מחדש עם קלט זהה.

פונקציית התפלגות מצטברת אמפירית (eCDF או EDF)

פונקציית התפלגות מצטברת שמבוססת על מדידות אמפיריות ממערך נתונים אמיתי. הערך של הפונקציה בכל נקודה לאורך ציר ה-x הוא החלק של התצפיות במערך הנתונים שקטן מהערך שצוין או שווה לו.

מזעור סיכון אמפירי (ERM)

בחירת הפונקציה שממזערת את ההפסד בקבוצת הנתונים לאימון. השוואה לצמצום סיכונים מבניים.

מקודד

באופן כללי, כל מערכת ML שמבצעת המרה מייצוג גולמי, דליל או חיצוני לייצוג מעובד יותר, צפוף יותר או פנימי יותר.

מקודדים הם לרוב רכיב של מודל גדול יותר, ולעתים קרובות הם משולבים עם מפענח. חלק מהטרנספורמרים משלבים מקודדים עם מפענחים, אבל טרנספורמרים אחרים משתמשים רק במקודד או רק במפענח.

במערכות מסוימות, הפלט של המקודד משמש כקלט לרשת סיווג או לרשת רגרסיה.

במשימות של רצף לרצף, מקודד מקבל רצף קלט ומחזיר מצב פנימי (וקטור). לאחר מכן, המפענח משתמש במצב הפנימי הזה כדי לחזות את הרצף הבא.

הגדרה של מקודד בארכיטקטורת טרנספורמר מופיעה במאמר בנושא טרנספורמר.

מידע נוסף מופיע במאמר LLMs: What's a large language model (מודלים גדולים של שפה: מהו מודל גדול של שפה) בקורס Machine Learning Crash Course (קורס מקוצר על למידת מכונה).

נקודות קצה

מיקום שאפשר להגיע אליו דרך הרשת (בדרך כלל כתובת URL) שבו אפשר לקבל שירות.

ensemble

אוסף של מודלים שאומנו באופן עצמאי והתחזיות שלהם מחושבות כממוצע או מצטברות. במקרים רבים, מודל משולב מניב תחזיות טובות יותר ממודל יחיד. לדוגמה, יער אקראי הוא אנסמבל שנבנה מכמה עצי החלטה. חשוב לזכור שלא כל יערות ההחלטות הם אנסמבלים.

מידע נוסף זמין במאמר Random Forest בקורס המקוצר על למידת מכונה.

אנטרופיה

ב תורת המידע, אנטרופיה היא תיאור של מידת חוסר הצפיות של התפלגות הסתברותית. לחלופין, אנטרופיה מוגדרת גם ככמות המידע שכל דוגמה מכילה. הפיזור הוא בעל האנטרופיה הגבוהה ביותר האפשרית כשכל הערכים של משתנה אקראי הם בעלי סבירות שווה.

הנוסחה לחישוב האנטרופיה של קבוצה עם שני ערכים אפשריים, 0 ו-1 (לדוגמה, התוויות בבעיית סיווג בינארי), היא:

H = -p log p - q log q = -p log p - (1-p) * log (1-p)

where:

- H היא האנטרופיה.

- p הוא החלק היחסי של דוגמאות מסוג '1'.

- q הוא החלק של הדוגמאות עם הערך '0'. שימו לב: q = (1 - p)

- הערך log הוא בדרך כלל log2. במקרה הזה, יחידת האנטרופיה היא ביט.

לדוגמה, נניח את הדברים הבאים:

- 100 דוגמאות מכילות את הערך '1'

- 300 דוגמאות מכילות את הערך '0'

לכן, ערך האנטרופיה הוא:

- p = 0.25

- q = 0.75

- H = (-0.25)log2(0.25) - (0.75)log2(0.75) = 0.81 bits per example

קבוצה מאוזנת לחלוטין (לדוגמה, 200 ערכים של '0' ו-200 ערכים של '1') תהיה בעלת אנטרופיה של 1.0 ביט לכל דוגמה. ככל שקבוצה הופכת לא מאוזנת יותר, האנטרופיה שלה מתקרבת ל-0.0.

בעצי החלטה, האנטרופיה עוזרת לגבש רווח מידע כדי לעזור למפצל לבחור את התנאים במהלך הצמיחה של עץ החלטה לסיווג.

השוואה של האנטרופיה עם:

- מדד גיני לאי-טוהר

- פונקציית האובדן cross-entropy

אנטרופיה נקראת לעיתים קרובות אנטרופיה של שאנון.

מידע נוסף זמין במאמר Exact splitter for binary classification with numerical features בקורס Decision Forests.

environment

בלמידת חיזוק, העולם שמכיל את הסוכן ומאפשר לסוכן לצפות במצב של העולם הזה. לדוגמה, העולם המיוצג יכול להיות משחק כמו שחמט, או עולם פיזי כמו מבוך. כשהסוכן מיישם פעולה בסביבה, הסביבה עוברת בין מצבים.

פרק

בשיטת הלמידה באמצעות חיזוקים, כל אחד מהניסיונות החוזרים של הסוכן ללמוד סביבה.

תקופה של זמן מערכת

מעבר אימון מלא על קבוצת הנתונים לאימון כולה, כך שכל דוגמה עברה עיבוד פעם אחת.

אפוקה מייצגת N/גודל אצווה

אימונים של איטרציות, כאשר N הוא

מספר הדוגמאות הכולל.

לדוגמה, נניח את הדברים הבאים:

- מערך הנתונים מורכב מ-1,000 דוגמאות.

- גודל הקבוצה הוא 50 דוגמאות.

לכן, כל אפוקה דורשת 20 איטרציות:

1 epoch = (N/batch size) = (1,000 / 50) = 20 iterations

מידע נוסף זמין במאמר רגרסיה ליניארית: היפר-פרמטרים בקורס המקוצר על למידת מכונה.

מדיניות חמדנית של אפסילון

בלמידת חיזוק, מדיניות שפועלת לפי מדיניות אקראית בהסתברות אפסילון, או לפי מדיניות חמדנית בכל מקרה אחר. לדוגמה, אם אפסילון הוא 0.9, המדיניות היא מדיניות אקראית ב-90% מהמקרים ומדיניות חמדנית ב-10% מהמקרים.

במהלך פרקים עוקבים, האלגוריתם מקטין את הערך של אפסילון כדי לעבור ממדיניות אקראית למדיניות חמדנית. בשיטת המדיניות הזו, הנציג קודם בוחן את הסביבה באופן אקראי ואז מנצל את התוצאות של הבחינה האקראית.

שוויון הזדמנויות

מדד הוגנות להערכת היכולת של המודל לחזות את התוצאה הרצויה באופן שווה לכל הערכים של מאפיין רגיש. במילים אחרות, אם התוצאה הרצויה של מודל היא הסיווג החיובי, המטרה היא ששיעור החיוביים האמיתיים יהיה זהה לכל הקבוצות.

שוויון הזדמנויות קשור לסיכויים שווים, שדורש שגם שיעורי ה-TRUE האמיתיים וגם שיעורי ה-FALSE הכוזבים יהיו זהים בכל הקבוצות.

נניח שבאוניברסיטת גלאבדאבדריב מתקבלים ללימודי מתמטיקה גם ליליפוטים וגם ברובדינגנאגים. בבתי הספר התיכוניים של ליליפוט מוצעת תוכנית לימודים מקיפה של שיעורי מתמטיקה, ורוב התלמידים עומדים בדרישות של התוכנית האוניברסיטאית. בבתי הספר התיכוניים בברובדינגנאג לא מוצעים שיעורי מתמטיקה בכלל, וכתוצאה מכך, הרבה פחות תלמידים עומדים בדרישות. התנאי של שוויון הזדמנויות מתקיים לגבי התווית המועדפת 'התקבל/ה' בהקשר של לאום (ליליפוט או ברובדינגנאג) אם לתלמידים שעומדים בדרישות יש סיכוי שווה להתקבל, בלי קשר ללאום שלהם (ליליפוט או ברובדינגנאג).

לדוגמה, נניח ש-100 אנשים מליליפוט ו-100 אנשים מברובדינגנאג הגישו בקשה להתקבל לאוניברסיטת גלובדאבדריב, וההחלטות לגבי הקבלה מתקבלות באופן הבא:

טבלה 1. מועמדים קטנים מאוד (90% מהם עומדים בדרישות)

| כשירים | לא מתאים | |

|---|---|---|

| התקבל | 45 | 3 |

| נדחה | 45 | 7 |

| סה"כ | 90 | 10 |

|

אחוז הסטודנטים שעומדים בדרישות והתקבלו: 45/90 = 50% אחוז הסטודנטים שלא עומדים בדרישות ונדחו: 7/10 = 70% האחוז הכולל של סטודנטים מליליפוט שהתקבלו: (45+3)/100 = 48% |

||

טבלה 2. מועמדים גדולים מאוד (10% כשירים):

| כשירים | לא מתאים | |

|---|---|---|

| התקבל | 5 | 9 |

| נדחה | 5 | 81 |

| סה"כ | 10 | 90 |

|

אחוז הסטודנטים שעומדים בדרישות שהתקבלו: 5/10 = 50% אחוז הסטודנטים שלא עומדים בדרישות שנדחו: 81/90 = 90% אחוז הסטודנטים הכולל מ-Brobdingnag שהתקבלו: (5+9)/100 = 14% |

||

הדוגמאות הקודמות עומדות בדרישה לשוויון הזדמנויות לקבלה של תלמידים שעומדים בדרישות, כי גם לליליפוטים וגם לברובדינגנאגים שעומדים בדרישות יש סיכוי של 50% להתקבל.

למרות שהשוויון בהזדמנויות מתקיים, שני מדדי ההוגנות הבאים לא מתקיימים:

- שוויון דמוגרפי: שיעורי הקבלה של ליליפוטים ושל ברובדינגנאגים לאוניברסיטה שונים; 48% מהסטודנטים הליליפוטים מתקבלים, אבל רק 14% מהסטודנטים הברובדינגנאגים מתקבלים.

- סיכויים שווים: לתלמידים זכאים מליליפוט ומברובדינגנאג יש סיכוי שווה להתקבל, אבל התנאי הנוסף שלפיו לתלמידים לא זכאים מליליפוט ומברובדינגנאג יש סיכוי שווה להידחות לא מתקיים. שיעור הדחייה של ליליפוטים לא מוסמכים הוא 70%, לעומת 90% של ברובדינגנאגים לא מוסמכים.

מידע נוסף זמין במאמר הוגנות: שוויון הזדמנויות בקורס Machine Learning Crash Course.

הסתברות שווה

מדד הוגנות שנועד להעריך אם מודל חוזה תוצאות באותה רמת דיוק לכל הערכים של מאפיין רגיש ביחס לסיווג החיובי ולסיווג השלילי – ולא רק ביחס לסיווג אחד. במילים אחרות, גם שיעור החיוביים האמיתיים וגם שיעור השליליים הכוזבים צריכים להיות זהים בכל הקבוצות.

הסיכויים שווים קשורים לשוויון הזדמנויות, שמתמקד רק בשיעורי השגיאות עבור סיווג יחיד (חיובי או שלילי).

לדוגמה, נניח שאוניברסיטת גלאבדאבדריב מקבלת לתוכנית לימודים קפדנית במתמטיקה גם ליליפוטים וגם ברובדינגנאגים. בתי הספר התיכוניים של ליליפוט מציעים תוכנית לימודים מקיפה של שיעורי מתמטיקה, ורוב התלמידים עומדים בדרישות של התוכנית האוניברסיטאית. בבתי הספר התיכוניים בברובדינגנאג לא מוצעים שיעורי מתמטיקה בכלל, וכתוצאה מכך, הרבה פחות תלמידים עומדים בדרישות. הקריטריון של סיכויים שווים מתקיים אם הסיכוי של מועמד מתאים להתקבל לתוכנית שווה לסיכוי של מועמד מתאים אחר להתקבל לתוכנית, בלי קשר לגודל שלו (ליליפוט או ברובדינגנאג), והסיכוי של מועמד לא מתאים להידחות שווה לסיכוי של מועמד לא מתאים אחר להידחות.

נניח ש-100 אנשים מליליפוט ו-100 אנשים מברובדינגנאג מגישים בקשה להתקבל לאוניברסיטת גלובדאבדריב, והחלטות הקבלה מתקבלות באופן הבא:

טבלה 3. מועמדים קטנים מאוד (90% מהם עומדים בדרישות)

| כשירים | לא מתאים | |

|---|---|---|

| התקבל | 45 | 2 |

| נדחה | 45 | 8 |

| סה"כ | 90 | 10 |

|

אחוז התלמידים שעומדים בדרישות והתקבלו: 45/90 = 50% אחוז התלמידים שלא עומדים בדרישות ונדחו: 8/10 = 80% האחוז הכולל של תלמידי ליליפוט שהתקבלו: (45+2)/100 = 47% |

||

טבלה 4. מועמדים גדולים מאוד (10% כשירים):

| כשירים | לא מתאים | |

|---|---|---|

| התקבל | 5 | 18 |

| נדחה | 5 | 72 |

| סה"כ | 10 | 90 |

|

אחוז הסטודנטים שעומדים בדרישות והתקבלו: 5/10 = 50% אחוז הסטודנטים שלא עומדים בדרישות ונדחו: 72/90 = 80% אחוז הסטודנטים הכולל מברובדינגנאג שהתקבלו: (5+18)/100 = 23% |

||

ההגדרה 'סיכויים שווים' מתקיימת כי לסטודנטים כשירים מליליפוט ומברובדינגנאג יש סיכוי של 50% להתקבל, ולסטודנטים לא כשירים מליליפוט ומברובדינגנאג יש סיכוי של 80% להידחות.

ההגדרה הפורמלית של סיכויים שווים מופיעה במאמר "Equality of Opportunity in Supervised Learning" (שוויון הזדמנויות בלמידה מפוקחת) באופן הבא: "הערך החזוי Ŷ מקיים סיכויים שווים ביחס לתכונה המוגנת A ולתוצאה Y אם Ŷ ו-A הם בלתי תלויים, בהינתן Y".

Estimator

TensorFlow API שהוצא משימוש. כדאי להשתמש ב-tf.keras במקום ב-Estimators.

evals

משמש בעיקר כקיצור להערכות של מודלים גדולים של שפה. באופן כללי, evals הוא קיצור לכל סוג של הערכה.

הערכה

התהליך של מדידת האיכות של מודל או השוואה בין מודלים שונים.

כדי להעריך מודל של למידת מכונה מבוקרת, בדרך כלל משווים אותו לקבוצת נתונים לתיקוף ולקבוצת נתונים לבדיקה. הערכה של מודל שפה גדול כוללת בדרך כלל הערכות רחבות יותר של איכות ובטיחות.

התאמה מדויקת

מדד של הכול או כלום, שבו הפלט של המודל תואם לאמת הקרקע או לטקסט ההפניה בדיוק או שלא תואם בכלל. לדוגמה, אם אמת הקרקע היא orange, הפלט היחיד של המודל שעומד בדרישות של התאמה מדויקת הוא orange.

התאמה מדויקת יכולה גם להעריך מודלים שהפלט שלהם הוא רצף (רשימה מדורגת של פריטים). באופן כללי, התאמה מדויקת מחייבת שהרשימה המדורגת שנוצרה תהיה זהה לאמת הקרקע; כלומר, כל פריט בשתי הרשימות צריך להיות באותו סדר. עם זאת, אם אמת קרקע מורכבת מכמה רצפים נכונים, התאמה מדויקת דורשת רק שהפלט של המודל יתאים לאחד מהרצפים הנכונים.

דוגמה

הערכים של שורה אחת ב-features ואולי גם label. דוגמאות בלמידה מונחית מתחלקות לשתי קטגוריות כלליות:

- דוגמה עם תווית מורכבת מתכונה אחת או יותר ומתווית. דוגמאות עם תוויות משמשות במהלך האימון.

- דוגמה לא מסומנת מורכבת מתכונה אחת או יותר, אבל לא כוללת תווית. דוגמאות ללא תוויות משמשות במהלך ההסקה.

לדוגמה, נניח שאתם מאמנים מודל כדי לקבוע את ההשפעה של תנאי מזג האוויר על ציוני התלמידים במבחנים. הנה שלוש דוגמאות עם תוויות:

| תכונות | תווית | ||

|---|---|---|---|

| טמפרטורה | לחות | לחץ | ציון הבדיקה |

| 15 | 47 | 998 | טוב |

| 19 | 34 | 1020 | מצוינת |

| 18 | 92 | 1012 | גרועה |

הנה שלוש דוגמאות ללא תווית:

| טמפרטורה | לחות | לחץ | |

|---|---|---|---|

| 12 | 62 | 1014 | |

| 21 | 47 | 1017 | |

| 19 | 41 | 1021 |

השורה במערך נתונים היא בדרך כלל המקור הגולמי לדוגמה. כלומר, דוגמה בדרך כלל מורכבת מקבוצת משנה של העמודות במערך הנתונים. בנוסף, התכונות בדוגמה יכולות לכלול גם תכונות סינתטיות, כמו תכונות מצטלבות.

מידע נוסף זמין במאמר למידה מפוקחת בקורס מבוא ללמידת מכונה.

חזרה על חוויה

בלמידת חיזוק, שיטת DQN משמשת לצמצום קורלציות זמניות בנתוני האימון. הסוכן שומר את מעברי המצב במאגר נתונים זמני של הפעלה חוזרת, ואז דוגם מעברים ממאגר נתונים זמני של הפעלה חוזרת כדי ליצור נתוני אימון.

הטיה של עורכי הניסוי

בעיית הגרדיאנט המתפוצץ

הנטייה של גרדיאנטים ברשתות נוירונים עמוקות (במיוחד רשתות נוירונים חוזרות) להיות תלולים (גבוהים) באופן מפתיע. שיפועים תלולים גורמים לעדכונים גדולים מאוד של המשקלים של כל צומת ברשת עצבית עמוקה.

קשה או בלתי אפשרי לאמן מודלים שסובלים מבעיית הגרדיאנט המתפוצץ. חיתוך הדרגתי יכול לצמצם את הבעיה הזו.

השוואה לבעיית שיפוע נעלם.

סיכום קיצוני (xsum)

מערך נתונים להערכת היכולת של LLM לסכם מסמך יחיד. כל רשומה במערך הנתונים כוללת:

- מסמך שנכתב על ידי British Broadcasting Corporation (BBC).

- סיכום של המסמך במשפט אחד.

פרטים נוספים זמינים במאמר Don't Give Me the Details, Just the Summary! Topic-Aware Convolutional Neural Networks for Extreme Summarization.

F

F1

מדד סיווג בינארי מסכם שמסתמך על דיוק וגם על היזכרות. זו הנוסחה:

עובדתיות

בעולם של למידת מכונה, מאפיין שמתאר מודל שהפלט שלו מבוסס על המציאות. המושג 'עובדתיות' הוא מושג ולא מדד. לדוגמה, נניח שאתם שולחים את הפרומפט הבא אל מודל שפה גדול:

מהי הנוסחה הכימית של מלח שולחן?

מודל שמבצע אופטימיזציה של נכונות העובדות ישיב:

NaCl

קל להניח שכל המודלים צריכים להתבסס על עובדות. עם זאת, יש הנחיות מסוימות, כמו ההנחיות הבאות, שגורמות למודל AI גנרטיבי לבצע אופטימיזציה של יצירתיות ולא של דיוק עובדתי.

תכתוב לי חמשיר על אסטרונאוט וזחל.

לא סביר שהלימריק שיתקבל יתבסס על המציאות.

ההגדרה הזו שונה מהתבססות על עובדות.

מגבלת הוגנות

החלת אילוץ על אלגוריתם כדי להבטיח שמתקיימת הגדרה אחת או יותר של הוגנות. דוגמאות למגבלות הוגנות:- עיבוד שלאחר יצירת הפלט של המודל.

- שינוי פונקציית ההפסד כדי לשלב קנס על הפרה של מדד הוגנות.

- הוספה ישירה של אילוץ מתמטי לבעיית אופטימיזציה.

מדד הוגנות

הגדרה מתמטית של 'הוגנות' שאפשר למדוד. דוגמאות למדדי הוגנות הכי רווחיים:

הרבה מדדים של הוגנות הם בלעדיים הדדית. אפשר לעיין באי-התאמה של מדדים של הוגנות.

FALSE שלילי (FN)

דוגמה שבה המודל מנבא בטעות את הסיווג השלילי. לדוגמה, המודל חוזה שהודעת אימייל מסוימת אינה ספאם (הסיווג השלילי), אבל הודעת האימייל הזו היא למעשה ספאם.

שיעור השליליים השגויים

החלק היחסי של דוגמאות חיוביות אמיתיות שהמודל טעה לגביהן וחיזוי שהוא שייך לסיווג השלילי. הנוסחה הבאה משמשת לחישוב שיעור התוצאות השליליות השגויות:

מידע נוסף זמין במאמר ערכי סף ומטריצת בלבול בקורס המקוצר על למידת מכונה.

FALSE חיובי שגוי (FP)

דוגמה שבה המודל חוזה בטעות את הסיווג החיובי. לדוגמה, המודל חוזה שהודעת אימייל מסוימת היא ספאם (הסיווג החיובי), אבל הודעת האימייל הזו לא ספאם בפועל.

מידע נוסף זמין במאמר ערכי סף ומטריצת בלבול בקורס המקוצר על למידת מכונה.

שיעור התוצאות החיוביות השגויות (FPR)

השיעור של הדוגמאות השליליות בפועל שהמודל טעה בהן וניבא את הסיווג החיובי. הנוסחה הבאה משמשת לחישוב שיעור התוצאות החיוביות הכוזבות:

שיעור התוצאות החיוביות השגויות הוא ציר ה-X בעקומת ROC.

מידע נוסף זמין במאמר בנושא סיווג: ROC ו-AUC בקורס המקוצר על למידת מכונה.

דעיכה מהירה

טכניקת אימון לשיפור הביצועים של מודלים גדולים של שפה (LLM). התכלות מהירה כוללת הפחתה מהירה של קצב הלמידה במהלך האימון. השיטה הזו עוזרת למנוע התאמת יתר של המודל לנתוני האימון, ומשפרת את ההכללה.

מאפיין

משתנה קלט במודל למידת מכונה. דוגמה מורכבת מתכונה אחת או יותר. לדוגמה, נניח שאתם מאמנים מודל כדי לקבוע את ההשפעה של תנאי מזג האוויר על ציוני התלמידים במבחנים. בטבלה הבאה מוצגות שלוש דוגמאות, שכל אחת מהן מכילה שלוש תכונות ותווית אחת:

| תכונות | תווית | ||

|---|---|---|---|

| טמפרטורה | לחות | לחץ | ציון הבדיקה |

| 15 | 47 | 998 | 92 |

| 19 | 34 | 1020 | 84 |