Como evitar o overfitting

Como em qualquer modelo de aprendizado de máquina, uma das principais preocupações ao treinar uma rede neural convolucional é o overfitting: um modelo tão ajustado aos detalhes dos dados de treinamento que não consegue generalizar para novos exemplos. Duas técnicas para evitar o ajuste excessivo ao criar uma CNN são:

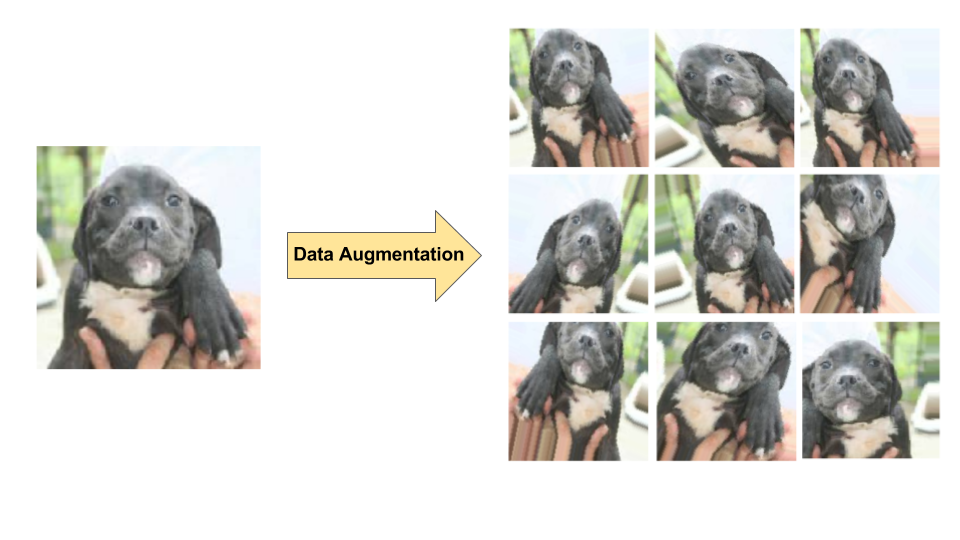

- Aumento de dados: aumentar artificialmente a diversidade e o número de exemplos de treinamento realizando transformações aleatórias em imagens existentes para criar um conjunto de novas variantes (consulte a Figura 7). O aumento de dados é especialmente útil quando o conjunto de dados de treinamento original é relativamente pequeno.

- Regularização de dropout: remoção aleatória de unidades da rede neural durante uma etapa de gradiente de treinamento.

Figura 7. Aumento de dados

em uma única imagem de cachorro (extraída do conjunto de dados"Dogs vs. Cats"

disponível no Kaggle). Esquerda: imagem original do cachorro do conjunto de treinamento.

Certo: nove novas imagens geradas a partir da imagem original usando transformações

aleatórias.

Figura 7. Aumento de dados

em uma única imagem de cachorro (extraída do conjunto de dados"Dogs vs. Cats"

disponível no Kaggle). Esquerda: imagem original do cachorro do conjunto de treinamento.

Certo: nove novas imagens geradas a partir da imagem original usando transformações

aleatórias.