Überanpassung verhindern

Wie bei jedem Modell für maschinelles Lernen ist beim Training eines Convolutional Neural Networks die Überanpassung ein wichtiges Problem: Ein Modell, das so auf die Besonderheiten der Trainingsdaten abgestimmt ist, dass es nicht auf neue Beispiele verallgemeinert werden kann. Zwei Methoden, um beim Erstellen einer CNN ein Überanpassen zu verhindern, sind:

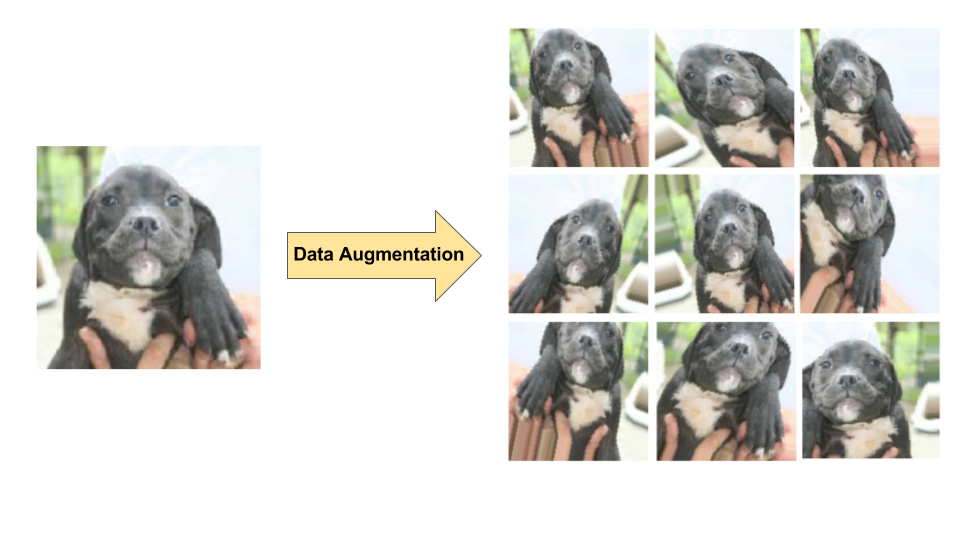

- Datenerweiterung: Die Vielfalt und Anzahl der Trainingsbeispiele wird künstlich erhöht, indem an vorhandenen Bildern zufällige Transformationen vorgenommen werden, um eine Reihe neuer Varianten zu erstellen (siehe Abbildung 7). Die Datenerweiterung ist besonders nützlich, wenn der ursprüngliche Trainingsdatensatz relativ klein ist.

- Dropout-Regelungsmechanismus: Beim Training werden Einheiten zufällig aus dem neuronalen Netzwerk entfernt.

Abbildung 7. Datenaugmentation an einem einzelnen Hundebild (Auszug aus dem Dataset „Hunde gegen Katzen“, das auf Kaggle verfügbar ist). Links: Originalbild eines Hundes aus dem Trainings-Dataset.

Rechts: Neun neue Bilder, die aus dem Originalbild mithilfe von zufälligen Transformationen generiert wurden.

Abbildung 7. Datenaugmentation an einem einzelnen Hundebild (Auszug aus dem Dataset „Hunde gegen Katzen“, das auf Kaggle verfügbar ist). Links: Originalbild eines Hundes aus dem Trainings-Dataset.

Rechts: Neun neue Bilder, die aus dem Originalbild mithilfe von zufälligen Transformationen generiert wurden.