Evitare l'overfitting

Come per qualsiasi modello di machine learning, un problema chiave durante l'addestramento di una rete neurale convezionale è l'overfitting: un modello così ottimizzato per le specifiche dei dati di addestramento da non essere in grado di generalizzare a nuovi esempi. Esistono due tecniche per evitare l'overfitting durante la creazione di una CNN:

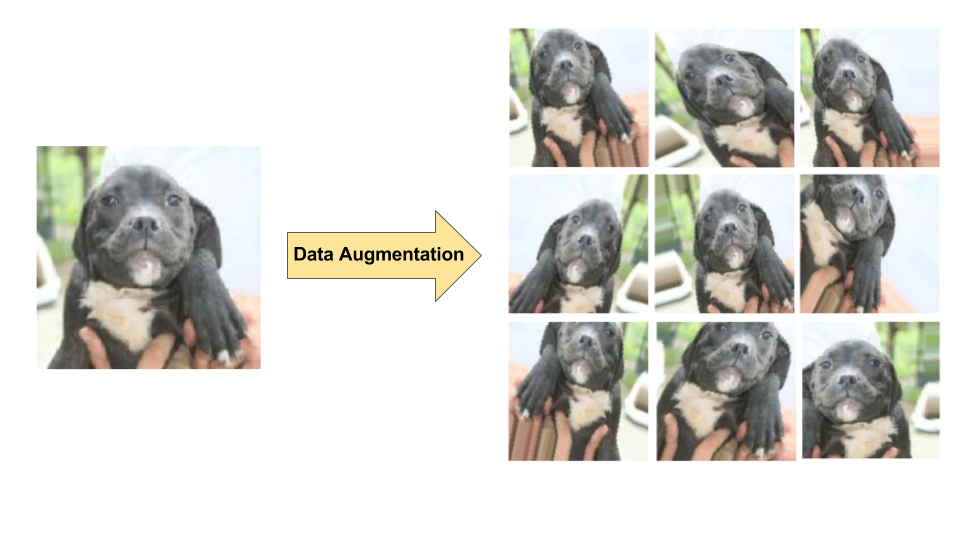

- Aumento dei dati: aumenta artificialmente la diversità e il numero di esempi di addestramento eseguendo trasformazioni casuali sulle immagini esistenti per creare un insieme di nuove varianti (vedi Figura 7). L'aumento dei dati è particolarmente utile quando il set di dati di addestramento originale è relativamente piccolo.

- Regolarizzazione con dropout: rimuovi in modo casuale le unità dalla rete neurale durante un passaggio del gradiente di addestramento.

Figura 7. Aumentazione dei dati su una singola immagine di cane (estratto dal set di dati"Cani contro gatti" disponibile su Kaggle). A sinistra: immagine originale di un cane del set di addestramento.

A destra: nove nuove immagini generate dall'immagine originale utilizzando trasformazioni random.

Figura 7. Aumentazione dei dati su una singola immagine di cane (estratto dal set di dati"Cani contro gatti" disponibile su Kaggle). A sinistra: immagine originale di un cane del set di addestramento.

A destra: nove nuove immagini generate dall'immagine originale utilizzando trasformazioni random.