Zapobieganie nadmiernemu dopasowaniu

Podobnie jak w przypadku każdego modelu uczenia maszynowego, podczas trenowania sieci neuronowej skonwertowanej kluczowym problemem jest nadmierne dopasowanie: model jest tak dopasowany do specyfiki danych treningowych, że nie jest w stanie uogólniać na nowe przykłady. Istnieją 2 techniki zapobiegania przetrenowywania podczas tworzenia sieci CNN:

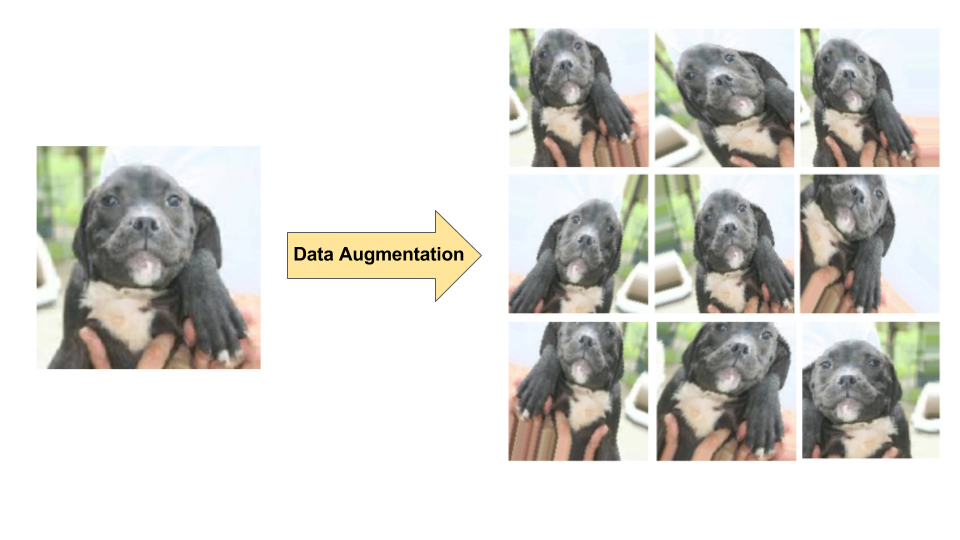

- Powiększanie zbioru danych: sztuczne zwiększanie różnorodności i liczby przykładów treningowych przez losowe przekształcanie dotychczasowych obrazów w celu utworzenia zestawu nowych wariantów (patrz rys. 7). Powiększanie danych jest szczególnie przydatne, gdy oryginalny zbiór danych treningowych jest stosunkowo mały.

- Regulacja polegająca na pomijaniu: losowe usuwanie jednostek z sieci neuronowej podczas kroku gradientu treningowego.

Rysunek 7. Rozszerzanie danych na podstawie pojedynczego obrazu psa (wycinek ze zbioru danych „Dogs vs. Cats” dostępnego na Kaggle). Po lewej: oryginalny obraz psa ze zbioru treningowego.

Prawo: 9 nowych obrazów wygenerowanych na podstawie oryginalnego obrazu za pomocą losowych przekształceń.

Rysunek 7. Rozszerzanie danych na podstawie pojedynczego obrazu psa (wycinek ze zbioru danych „Dogs vs. Cats” dostępnego na Kaggle). Po lewej: oryginalny obraz psa ze zbioru treningowego.

Prawo: 9 nowych obrazów wygenerowanych na podstawie oryginalnego obrazu za pomocą losowych przekształceń.