تعرّف على الآلية التي اتّبعتها Google لتطوير أحدث نموذج لتصنيف الصور الذي يوفّر إمكانية البحث في "صور Google". يمكنك الحصول على دورة تدريبية عن الشبكات العصبونية التشويهية، ثم إنشاء أداة تصنيف للصور لتمييز صور القطط عن صور الكلاب.

المتطلبات الأساسية

الدورة التدريبية لتعلّم الآلة أو ما يعادله من خبرة مع أساسيات تعلُّم الآلة

إجادة أساسيات البرمجة، وبعض الخبرة في الترميز في Python

المقدمة

في أيار (مايو) 2013، أصدرت Google بحثًا عن الصور الشخصية، منح المستخدمين القدرة على استرداد الصور في مكتباتهم استنادًا إلى العناصر المتوفّرة في الصور.

الشكل 1. يبحث تطبيق"صور Google"عن

قطط القطط عبر البريد.

الشكل 1. يبحث تطبيق"صور Google"عن

قطط القطط عبر البريد.

وكانت هذه الميزة، التي تم دمجها لاحقًا في خدمة صور Google في عام 2015، قد تغيّرت نظرة المستخدمين إلى أداة تغيير الألعاب، ما يشكّل دليلاً على مفهوم أنّ برامج الرؤية الحاسوبية يمكنها تصنيف الصور وفقًا للمعايير البشرية، ما يضيف قيمة من عدة طرق:

- ولم يعد المستخدمون بحاجة إلى وضع علامات على الصور باستخدام تصنيفات مثل ""beach"لتصنيف محتوى الصورة، ما يلغي عملية يدوية قد تكون مملة جدًا عند إدارة مجموعات من مئات أو آلاف الصور.

- يمكن للمستخدمين استكشاف مجموعتهم من الصور بطرق جديدة، وذلك باستخدام عبارات البحث لتحديد موقع الصور مع العناصر التي ربما لم يتم وضع علامة عليها. على سبيل المثال، كان بإمكانهم البحث عن "شجرة نخيل"" لعرض جميع صور عطلاتهم التي تحتوي على أشجار نخيل في الخلفية.

- من المحتمل أن تكون "البرامج عرضًا بغرض"

آلية عمل تصنيف الصور

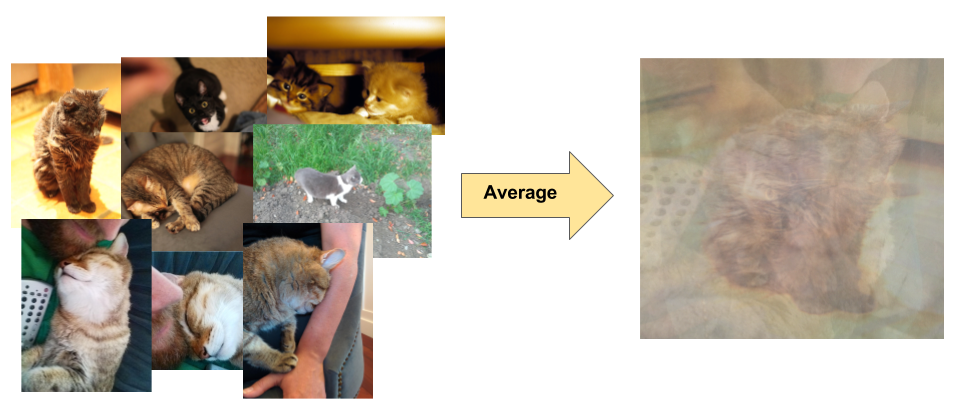

تصنيف الصور هو مشكلة تعلُّم خاضعة للإشراف: حدِّد مجموعة من الفئات المستهدَفة (العناصر التي يجب تحديدها في الصور) ودرِّب نموذجًا للتعرّف عليها باستخدام أمثلة الصور المصنّفة. اعتمدت نماذج الرؤية الحاسوبية المبكرة على بيانات البكسل الأولية كإدخال للنموذج. ومع ذلك، كما هو موضّح في الشكل 2، لا تقدّم بيانات وحدة البكسل الأولية وحدها تمثيلاً ثابتًا كافيًا لتضمين نُسخ متعددة من العنصر كما يتم التقاطه في الصورة. ويمكن أن يؤدي موضع العنصر والخلفية وراء الكائن والإضاءة المحيطة وزاوية الكاميرا والتركيز على الكاميرا إلى تقلبات في بيانات وحدة البكسل الأولية. هذه الاختلافات مهمة بما يكفي بحيث لا يمكن تصحيحها من خلال حساب القيم المتوسطة المرجّحة لقيم RGB للبكسل.

الشكل 2. على اليسار: يمكن التقاط الهررة

في صورة بأوضاع مختلفة، مع خلفيات مختلفة وحالتها المختلفة للإضاءة. يمين الصفحة: لا يوفّر متوسط بيانات وحدة البكسل لهذه النوعية من المعلومات أي معلومات مفيدة.

الشكل 2. على اليسار: يمكن التقاط الهررة

في صورة بأوضاع مختلفة، مع خلفيات مختلفة وحالتها المختلفة للإضاءة. يمين الصفحة: لا يوفّر متوسط بيانات وحدة البكسل لهذه النوعية من المعلومات أي معلومات مفيدة.

لوضع نماذج أكثر مرونة، أضافت نماذج الرؤية الحاسوبية الكلاسيكية ميزات جديدة مُستمَدة من بيانات وحدات البكسل، مثل الرسومات البيانية للألوان والزخارف والأشكال. ويتمثل الجانب السلبي من هذا المنهج في أن هندسة الميزات أصبحت عبئًا حقيقيًا، إذ توفّرت مدخلات كثيرة لتعديلها. بالنسبة إلى مصنّف القطط، ما هي الألوان الأكثر صلة بموضوع البحث؟ ما مدى مرونة تعريفات الأشكال؟ وبما أنّ الميزات كانت بحاجة إلى أن يتم تعديلها بدقة، كان إنشاء نماذج فعّالة أمرًا صعبًا للغاية وتعرّضت للدقة.