Üretken yapay zeka modelleri güçlü araçlar olsa da sınırlamaları olmadan. Çok yönlülükleri ve uygulanabilirlikleri bazen hatalı, yanlı veya hatalı çıkışlar gibi beklenmedik çıkışlara yol açabilir. rahatsız edici. Sürekli iyileştirmenin yapıldığı durumlarda işleme sonrası ve titizli manuel değerlendirme bu tür çıkışların zarar verme riskini azaltır.

Gemini API'nin sağladığı modeller çok çeşitli amaçlarla kullanılabilir Üretken yapay zeka ve doğal dil işleme (NLP) uygulamaları. Bunların kullanımı işlevleri yalnızca Gemini API veya Google AI Studio web üzerinden kullanılabilir. uygulamasını indirin. Gemini API kullanımınız, Üretken Yapay Zeka Yasaklanan Kullanım Politikası'na da tabidir. Politika ve Gemini API Hizmet Şartları.

Büyük dil modellerini (LLM) bu kadar kullanışlı kılan nedenlerinden biri, yaratıcı araçlar konusunda uzmanlaştık. Maalesef aynı zamanda büyük dil modellerinin sizin tarafınızdan bekleyin, metin de dahil Rahatsız edici, duyarsız veya yanlış bilgiler içeren fotoğraflar. Dahası, çok yönlülüğünü de göz önünde bulundurmak daha da zordur. tam olarak ne tür istenmeyen çıktılar üretebileceklerini tahmin etmek için kullanılır. Araç Gemini API, Google'ın yapay zekasıyla tasarlandı ilkeleri kapsamında değerlendirdiğimizde, geliştiricilerin sorumlu bir şekilde uygulayacaksınız. Geliştiricilerin güvenli, sorumluluk sahibi bir ürün oluşturmalarına yardımcı olmak Gemini API'de yerleşik içerik filtrelemenin yanı sıra 4 farklı zarar boyutunda ayarlanabilir güvenlik ayarları. Daha fazla bilgi için güvenlik ayarları kılavuzundan yararlanabilirsiniz.

Bu belge, çalışırken ortaya çıkabilecek bazı güvenlik risklerini LLM'lerin kullanımını ele alabilir ve yeni güvenlik tasarımları ile geliştirmeyi öneriler. (Yasaların ve yönetmeliklerin kısıtlamalara tabi olabileceğini de unutmayın. ancak bu tür hususlar bu kılavuzun kapsamında değildir.)

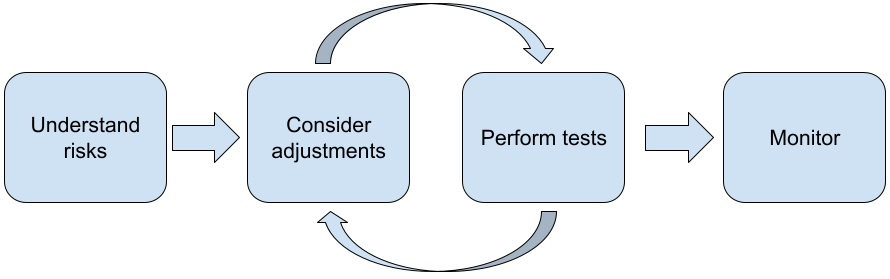

LLM'lerle uygulama oluştururken aşağıdaki adımlar önerilir:

- Uygulamanızın güvenlik risklerini anlama

- Güvenlik risklerini azaltmak için düzenlemeler yapma

- Kullanım alanınıza uygun güvenlik testleri gerçekleştirme

- Kullanıcılardan geri bildirim isteme ve kullanımı izleme

Ayarlama ve test aşamaları, siz hedefinize ulaşana kadar performans elde edebilirsiniz.

Uygulamanızın güvenlik risklerini anlayın

Bu bağlamda güvenlik, LLM'nin kaçınılması gereken bir işlem olarak Örneğin, rahatsız edici dil veya içerik oluşturarak kullanıcılarına zarar verme bir grup insandır. Gemini API aracılığıyla kullanılabilen modeller Google'ın yapay zeka ilkeleri düşünülerek tasarlanmıştır ve kullanımınız Üretken Yapay Zeka Yasaklanan Kullanım Politika. API yaygın dil modellerinin düzeltilmesine yardımcı olmak için yerleşik güvenlik filtreleri rahatsız edici dil ve nefret söylemi gibi sorunlar ve kapsayıcılık için çaba gösterme ve klişelerden kaçınma. Ancak, her uygulama farklı bir grup oluşturabilir sorumlu olduğunu açıklayacağım. Uygulama sahibi olarak, projeden etkilenen kullanıcılarınızı ve uygulamanızın neden olabileceği olası zararları bilmek ve uygulamanızın LLM'leri güvenli ve sorumlu bir şekilde kullandığından emin olun.

Bu değerlendirme kapsamında, zararın ortaya çıkma olasılığını göz önünde bulundurmanız gerekir. ve sorunun ciddiyetini ve etkisini belirlemek için önemlidir. Örneğin, gerçeğe dayalı olaylara dayalı makaleler oluşturan uygulamaların daha dikkatli olması gerekir. hakkında yanlış bilgilendirme yapıyor. Kurgusal içerikler üretenlere kıyasla hikaye anlatacağım. Potansiyel güvenlik risklerini keşfetmeye başlamanın iyi bir yoludur son kullanıcılarınızı ve deneyiminizden etkilenebilecek diğer kişileri araştırmak sonuçlarıyla ilgili daha fazla bilgi edinin. Bu işlem, bir reklamın durumunu araştırmak da dahil olmak üzere kullanıcıların benzer uygulamaları nasıl kullandığını gözlemleyerek uygulama alanınızdaki sanat çalışmalarını inceleyerek veya kullanıcı araştırması yapmak ya da onlarla gayriresmi görüşmeler yapmak yardımcı olur.

Gelişmiş ipuçları

- Hedefinizdeki potansiyel kullanıcılardan oluşan farklı bir kitleye hitap edin amacı hakkında bilgi vermek üzere Potansiyel riskler hakkında daha geniş bir perspektif elde etmek ve çeşitliliği, göre belirlemeniz gerekir.

- AI Risk Yönetimi Çerçevesi tarafından yayınlanan ABD Ulusal Standartlar ve Teknoloji Enstitüsü (NIST) daha fazla bilgi ayrıntılı rehberlik ve ek öğrenme kaynakları sunar.

- DeepMind'ın dil modellerinden kaynaklanan etik ve sosyal zarar riskleri 'nı inceleyin. dil modelinin farklı ve etkili bir şekilde uygulamalar zarara neden olabilir.

Güvenlik risklerini azaltmak için düzenlemeler yapma

Artık riskleri anladığınıza göre riskleri nasıl azaltacağınıza oluşturabilirsiniz. Hangi risklere öncelik verileceğini ve bu riskleri ele almak için hataları önceliklendirme gibi bir yazılımda da kritik bir karardır. belirler. Önceliklerinizi belirledikten sonra, ekibinizin her tür çözümü gözden geçirmeniz gerekir. Basit değişiklikler genellikle ve riskleri azaltır.

Örneğin, bir uygulama tasarlarken şunları göz önünde bulundurun:

- Projenizde kabul edilebilir olanı daha iyi yansıtmak için model çıkışını ayarlama daha yakından inceleyeceğiz. İnce ayar yapmak, modelin çıktısını daha iyi hâle getirebilir öngörülebilir ve tutarlıdır ve dolayısıyla belirli riskleri azaltmaya yardımcı olabilir.

- Daha güvenli çıkışlar sağlayan bir giriş yöntemi sunma. Tam giriş LLM'ye sunduğunuz, çıktının kalitesinde fark yaratabilir. Google Ads'de en güvenli seçeneği bulmak için giriş istemleriyle denemeler yaparak ortaya koyacağınız yeni bir yöntem sunar. Çünkü daha sonra, kullanıcılara bu süreci kolaylaştırır. Örneğin, kullanıcıları yalnızca belirli bir açılır listesi kullanabilir veya açıklayıcı uygulamanızın bağlamında güvenli bir şekilde uygulandığını tespit ettiğiniz kelime öbekleridir.

Güvenli olmayan girişleri ve çıkışları filtreleyerek belirtir. Basit durumlarda, engellenenler listeleri kullanıcıyı tespit edip engellemek için kullanılabilir. istem veya yanıtlarda güvenli olmayan kelimeler ya da ifadeler veya inceleme uzmanları manuel olarak değiştirmek veya engellemek.

Her istemi potansiyel zararlarla veya yanıltıcı sinyaller. Ardından projenin başarısını garantilemek için Tespit edilen zararın türüne göre talebi işleme alabilir. Örneğin, girişte açıkça rahatsız edici nitelikte veya kötüye kullanım amaçlı olduğu için bu girişler engellenebilir ve önceden tanımlanmış bir yanıt çıktı.

İleri düzey ipucu

-

Sinyaller çıkışın zararlı olduğunu belirlerse

uygulama aşağıdaki seçenekleri kullanabilir:

- Hata mesajı veya önceden komutlanmış çıkış sağlayın.

- Alternatif güvenli çıkışın olması ihtimaline karşı istemi tekrar deneyin oluşturulur, çünkü bazen aynı istem farklı çıkışlar sağlayabilir.

-

Sinyaller çıkışın zararlı olduğunu belirlerse

uygulama aşağıdaki seçenekleri kullanabilir:

Bilinçli kötüye kullanıma karşı önlemler almak (ör. Her kullanıcıya benzersiz bir kimlik atar ve kullanıcı sorgularının hacmine bir sınır uygular belirli bir süre içinde gönderilebilir. Diğer bir önlem de olası istem yerleştirmeye karşı koruma sağlar. SQL'e çok benzer istem yerleştirme yerleştirme, kötü amaçlı kullanıcıların Örneğin bir giriş istemi göndererek modelin çıkışını manipüle eder yok saymalıdır. Bkz. Üretken Yapay Zeka Yasaklanan Kullanım Politikası sayfasına göz atın.

İşlevleri, yapısı gereği daha az risk taşıyan bir değere ayarlamak. Kapsamı daha dar olan görevler (ör. metin) veya insan denetiminin daha fazla olduğu içerikler (ör. kısa videolar oluşturma) içerik (gerçek kişi tarafından incelenecek) genellikle daha düşük bir risktir. Bu nedenle gibi bir e-posta yanıtı yazmak için bir ana hat üzerinde genişleyen veya birkaç farklı ifadeler kullanabilirsiniz.

Kullanım alanınıza uygun güvenlik testleri yapın

Testler, sağlam ve güvenli uygulamalar oluşturmanın önemli bir parçasıdır. Ancak testler, testin kapsamı ve stratejileri değişiklik gösterir. Örneğin, eğlence amaçlı bir haiku oluşturmak, örneğin, oluşturmak istediğiniz uygulama veya . Ama haiku oluşturucusu daha geniş bir kullanıcı yelpazesi tarafından kullanılabilir. yanıltıcı girişimler ve hatta istenmeyen zararlı girişler riski, daha büyüktür. Uygulama bağlamı da önemlidir. Örneğin, bir uygulamadaki Herhangi bir işlem yapılmadan önce gerçek kişi olan uzmanlar tarafından incelenen çıktılarla aynı sonuca kıyasla zararlı çıktılar üretme olasılığının daha düşük olduğu düşünülebilir. uygulamaya geçiremez.

Çeşitli değişiklikler ve testler yapmak pek çok yinelemeli bir uygulamadır. emin bir şekilde başlatmadığınız takdirde, nispeten düşük risktir. Yapay zeka için özellikle yararlı olan iki tür test vardır uygulamalar:

Güvenlik karşılaştırma işleminde, güvenlik metriklerinizi yansıtan güvenli olma olasılığının ne kadar yüksek olduğu bağlamında uygulamanızın metriklerdeki performansını test edin. nasıl kullanacağımızı konuştuk. Bütçeyi aşmak için gereken minimum test etmeden önce kabul edilebilir düzeyde güvenlik metriği test sonuçlarını bu beklentiler doğrultusunda değerlendirebilir ve 2) sizin için önemli olan metrikleri değerlendiren testlere dayalı olarak değerlendirme veri kümesi hesap ekiplerinizle görüşün.

Gelişmiş ipuçları

- Muhtemelen değişime hazır olmayabileceği için “raf dışı” yaklaşımlara veri kümeleri oluşturmak için gerçek kişilerden oluşan derecelendirme araçlarını uygun olduğundan emin olun.

- Birden fazla metriğiniz varsa, bunları nasıl bir metrikte iyileşme sağlaması durumunda bu değişimden ödün vermeden zarar gördüğüne işaret eder. Diğer performans mühendisliklerinde olduğu gibi değerlendirme boyunca en kötü durum performansına odaklanmak isteyebilir temel alınmıştır.

Yanıltıcı testler, bir uygulamadır. Hedef, zayıf olduğunuz noktaları belirleyip adımları uygulamaktır. Yanıltıcı testler, uygulamanızda uzmanlığı olan değerlendirmeciler tarafından önemli ölçüde zaman/çaba göstermeniz gerekir. Ancak bunu ne kadar çok yaparsanız sorunları tespit etme şansınız o kadar artar özellikle, nadiren veya yalnızca bir uygulamadır.

- Yanıltıcı testler, makine öğreniminin sistematik olarak değerlendirilmesine yönelik bir yöntemdir.

nasıl davrandığını öğrenmek amacıyla bir model kullanarak

istemeden zararlı olan giriş:

- Bir giriş açıkça şu şekilde tasarlandığında kötü amaçlı olabilir: güvenli olmayan veya zararlı bir çıktı oluşturma (örneğin, belirli bir konu hakkında nefret söylemini yaratmak için din.

- Bir girişin kendisi zararlı olabilirken, o giriş yanlışlıkla zararlıdır zararsızdır, ancak zararlı sonuçlar veriyordur (örneğin, belirli bir etnik kökene sahip bir kişiyi tanımlamak için ırkçı bir çıkış almak.

- Zorlayıcı bir testi standart değerlendirmeden ayıran şey, testin

verilerin bileşimidir. Yanıltıcı testler için

sorunlu sonuçlar doğurabilecek en olası test verilerini

bahsedeceğim. Bu, modelin tüm etkinlik türleri için davranışını araştırmak

Ayrıca, nadir veya olağandışı örnekler de dahil olmak üzere,

sıra dışı durumlara örnek verelim. Proje yürütme

cümlenin farklı boyutlarında, örneğin yapısı,

anlam ve uzunluk. Google'ın Sorumlu Yapay Zeka

uygulama

adalet

inceleyin.

Gelişmiş ipuçları

- Tekliflerinizi otomatikleştirmek ve optimize etmek için otomatik test geleneksel yaklaşım yerine insanları "kırmızı ekipler"e ve çökertmeye çalışın. Otomatik testte, "kırmızı takım" bulanık bir giriş metni bulan başka bir dil modelidir. bu da test edilen modelin zararlı çıkışları olmasına yol açıyor.

- Yanıltıcı testler, makine öğreniminin sistematik olarak değerlendirilmesine yönelik bir yöntemdir.

nasıl davrandığını öğrenmek amacıyla bir model kullanarak

istemeden zararlı olan giriş:

Sorunları izleme

Ne kadar test edip azaltsanız da mükemmelliği garanti edemezsiniz. ortaya çıkan sorunları nasıl tespit edip bunlarla başa çıkacağınızı önceden planlayın. Genel yaklaşımlar, kullanıcıların geri bildirim paylaşabileceği izlenen bir kanal oluşturmayı içerir. (ör. beğenme/beğenmeme puanı) ve proaktif olarak izin istemek için bir kullanıcı çalışması yürütme çok çeşitli kullanıcılardan gelen geri bildirimler, özellikle de kullanım alışkanlıkları beklentilerden farklıdır.

Gelişmiş ipuçları

- Kullanıcılar yapay zeka ürünlerine geri bildirim verdiğinde bu, yapay zekayı büyük ölçüde iyileştirebilir performans ve kullanıcı deneyimini analiz etmek, örneğin Böylece, istem ayarlama için daha iyi örnekler seçebilirsiniz. İlgili içeriği oluşturmak için kullanılan Geri Bildirim ve Kontrol bölümü Google'ın İnsanlar ve Yapay Zeka rehberinde tasarlarken göz önünde bulundurulması gereken ve geri bildirim mekanizmalarını kullanmaya ne dersiniz?

Sonraki adımlar

- Daha fazla bilgi için hakkında bilgi edinmek için güvenlik ayarları kılavuzunu güvenlik ayarlarını kullanabilirsiniz.

- Aşağıdakileri almak için isteme giriş ilk istemlerinizi yazmaya başladınız.