يحدّد هذا المسرد مصطلحات الذكاء الاصطناعي.

A

الاستئصال

أسلوب لتقييم أهمية ميزة أو مكوّن من خلال إزالته مؤقتًا من نموذج بعد ذلك، يمكنك إعادة تدريب النموذج بدون تلك الميزة أو المكوّن، وإذا كان أداء النموذج الذي تمت إعادة تدريبه أسوأ بكثير، فمن المحتمل أنّ الميزة أو المكوّن الذي تمت إزالته كان مهمًا.

على سبيل المثال، لنفترض أنّك درّبت نموذج تصنيف على 10 ميزات وحقّقت دقة بنسبة% 88 على مجموعة الاختبار. للتحقّق من أهمية الميزة الأولى، يمكنك إعادة تدريب النموذج باستخدام الميزات التسع الأخرى فقط. إذا كان أداء النموذج الذي تم إعادة تدريبه أسوأ بكثير (على سبيل المثال، دقة أقل من% 55)، من المحتمل أنّ الميزة التي تمت إزالتها كانت مهمة. في المقابل، إذا كان النموذج الذي تمّت إعادة تدريبه يؤدي بشكل جيد بنفس القدر، فمن المحتمل أنّ هذه الميزة لم تكن مهمة.

يمكن أن تساعد عملية الاستئصال أيضًا في تحديد أهمية ما يلي:

- المكوّنات الأكبر، مثل نظام فرعي كامل من نظام تعلُّم آلي أكبر

- العمليات أو الأساليب، مثل خطوة المعالجة المُسبقة للبيانات

في كلتا الحالتين، ستلاحظ كيف يتغيّر أداء النظام (أو لا يتغيّر) بعد إزالة المكوّن.

اختبار A/B

طريقة إحصائية لمقارنة أسلوبَين (أو أكثر)، وهما أ وب. عادةً، يكون أ أسلوبًا حاليًا، وب أسلوبًا جديدًا. لا يحدّد اختبار A/B الأسلوب الأفضل أداءً فحسب، بل يحدّد أيضًا ما إذا كان الفرق ذا دلالة إحصائية.

عادةً ما تقارن اختبارات A/B مقياسًا واحدًا بين أسلوبَين، مثل مقارنة دقة النموذج بين أسلوبَين. ومع ذلك، يمكن أن تقارن اختبارات A/B أيضًا أي عدد محدود من المقاييس.

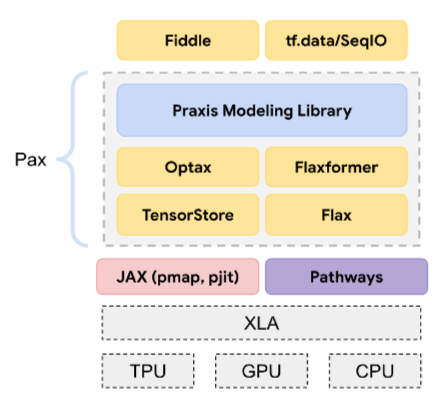

شريحة تسريع

فئة من مكوّنات الأجهزة المتخصّصة المصمَّمة لإجراء العمليات الحسابية الأساسية اللازمة لخوارزميات التعلّم العميق

يمكن أن تؤدي شرائح المعالجة السريعة (أو المعالجات السريعة باختصار) إلى زيادة سرعة وكفاءة مهام التدريب والاستدلال بشكل كبير مقارنةً بوحدة المعالجة المركزية للأغراض العامة. وهي مثالية لتدريب الشبكات العصبية والمهام المشابهة التي تتطلّب قدرة حاسوبية عالية.

تشمل أمثلة شرائح المعالجة السريعة ما يلي:

- وحدات معالجة الموتّرات (TPU) من Google مع أجهزة مخصّصة للتعليم المعمّق

- وحدات معالجة الرسومات من NVIDIA، والتي تم تصميمها في البداية لمعالجة الرسومات، تم تصميمها لتمكين المعالجة المتوازية، ما يمكن أن يؤدي إلى زيادة كبيرة في سرعة المعالجة.

الدقة

عدد التوقّعات الصحيحة للتصنيف مقسومًا على إجمالي عدد التوقّعات والمقصود:

على سبيل المثال، إذا قدّم نموذج 40 توقّعًا صحيحًا و10 توقّعات خاطئة، ستكون دقة النموذج كما يلي:

يقدّم التصنيف الثنائي أسماء محدّدة لمختلف فئات التوقعات الصحيحة والتوقعات غير الصحيحة. إذًا، صيغة الدقة للتصنيف الثنائي هي كما يلي:

where:

- يشير TP إلى عدد الحالات الموجبة الصحيحة (التوقّعات الصحيحة).

- تمثّل TN عدد الحالات السالبة الصحيحة (التوقعات الصحيحة).

- FP هو عدد الحالات الموجبة الخاطئة (التوقعات غير الصحيحة).

- FN هو عدد الحالات السالبة الخاطئة (التوقعات غير الصحيحة).

تحديد أوجه التشابه والاختلاف بين الدقة والضبط والاسترجاع

يمكنك الاطّلاع على التصنيف: الدقة والاسترجاع والضبط والمقاييس ذات الصلة في "دورة تدريبية مكثّفة حول تعلُّم الآلة" للحصول على مزيد من المعلومات.

إجراء

في التعلّم التعزيزي، تُعرَّف الحالة بأنّها الآلية التي ينتقل بها الوكيل بين حالات البيئة. يختار الوكيل الإجراء باستخدام سياسة.

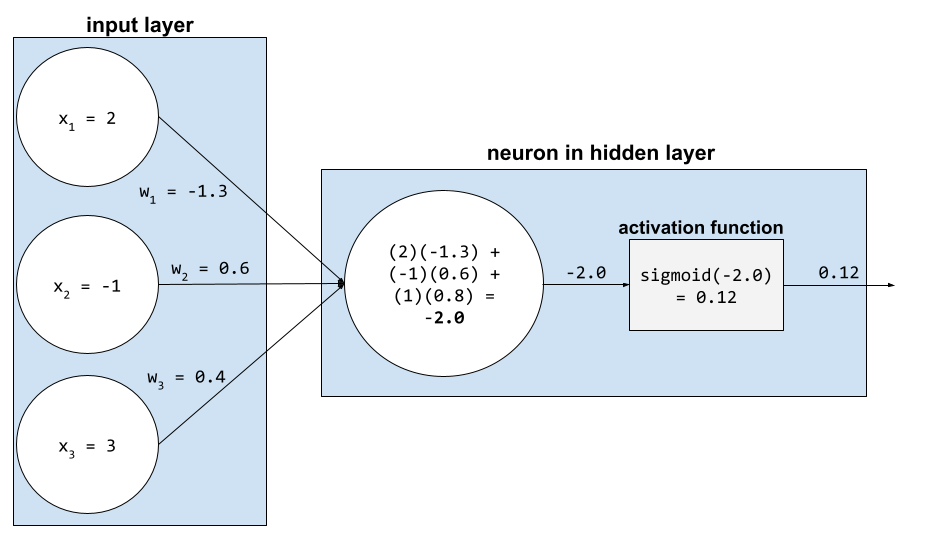

دالّة التفعيل

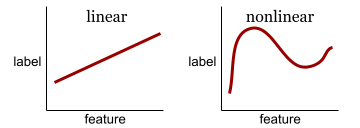

هي دالة تتيح للشبكات العصبونية التعرّف على العلاقات غير الخطية (المعقّدة) بين الميزات والتصنيف.

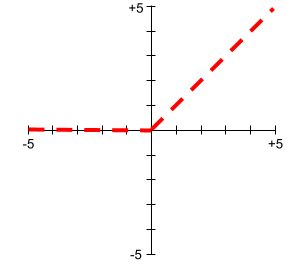

تشمل دوال التنشيط الشائعة ما يلي:

لا تكون رسومات دوال التنشيط البيانية أبدًا خطوطًا مستقيمة مفردة. على سبيل المثال، يتألف رسم دالة التنشيط ReLU من خطَّين مستقيمَين:

يبدو الرسم البياني لدالة التنشيط السينية كما يلي:

لمزيد من المعلومات، يُرجى الاطّلاع على الشبكات العصبية: دوال التنشيط في "الدورة التدريبية المكثّفة حول تعلُّم الآلة".

التعلّم النشط

التدريب هو أسلوب تستخدم فيه الخوارزمية اختيار بعض البيانات التي تتعلّم منها. يكون التعلّم النشط مفيدًا بشكل خاص عندما تكون الأمثلة المصنّفة نادرة أو مكلفة. بدلاً من البحث بشكل عشوائي عن مجموعة متنوّعة من الأمثلة المصنّفة، تبحث خوارزمية التعلّم النشط بشكل انتقائي عن مجموعة الأمثلة المحدّدة التي تحتاجها للتعلّم.

AdaGrad

خوارزمية متطورة لانحدار التدرّج تعيد ضبط مقياس تدرّجات كل مَعلمة، ما يمنح كل مَعلمة معدّل تعلّم مستقلاً. للحصول على شرح كامل، يمكنك الاطّلاع على مقالة Adaptive Subgradient Methods for Online Learning and Stochastic Optimization.

التكيّف

مرادف لعملية الضبط أو الضبط الدقيق

وكيل

برنامج يمكنه تحليل مدخلات المستخدم المتعددة الوسائط من أجل التخطيط وتنفيذ الإجراءات نيابةً عن المستخدم.

في التعلّم التعزيزي، يكون الوكيل هو الكيان الذي يستخدم سياسة لتحقيق أقصى عائد متوقّع من الانتقال بين الحالات الخاصة بالبيئة.

يستند إلى الذكاء الاصطناعي الوكيل

تمثّل هذه السمة صيغة الصفة من وكيل. تشير كلمة "وكيل" إلى الصفات التي يتمتّع بها الوكلاء (مثل الاستقلالية).

سير العمل القائم على وكلاء الذكاء الاصطناعي

عملية ديناميكية يخطّط فيها الوكيل وينفّذ الإجراءات بشكل مستقل لتحقيق هدف. قد تتضمّن العملية الاستدلال واستخدام أدوات خارجية وتصحيح الخطة ذاتيًا.

التجميع من الأسفل إلى الأعلى

اطّلِع على التجميع الهرمي.

هراء الذكاء الاصطناعي

ناتج من نظام ذكاء اصطناعي توليدي يفضّل الكمية على الجودة. على سبيل المثال، صفحة ويب مليئة بمحتوى منخفض الجودة من إنشاء الذكاء الاصطناعي وبكلفة منخفضة.

رصد القيم الشاذة

عملية تحديد القيم الشاذة على سبيل المثال، إذا كان المتوسط لـ ميزة معيّنة هو 100 مع انحراف معياري يبلغ 10، يجب أن تحدّد ميزة "رصد القيم الشاذة" القيمة 200 على أنّها مشبوهة.

الواقع المعزّز

اختصار الواقع المعزّز

المساحة تحت منحنى الدقة والاستدعاء

اطّلِع على المساحة تحت منحنى الدقة والاستدعاء (PR AUC).

المساحة تحت منحنى ROC

اطّلِع على المساحة تحت منحنى ROC.

الذكاء الاصطناعي العام

آلية غير بشرية تُظهر مجموعة واسعة من القدرات على حل المشاكل والإبداع والتكيّف. على سبيل المثال، يمكن لبرنامج يوضّح الذكاء الاصطناعي العام ترجمة النصوص وتأليف السيمفونيات والتفوق في الألعاب التي لم يتم ابتكارها بعد.

الذكاء الاصطناعي

برنامج أو نموذج غير بشري يمكنه حلّ مهام معقّدة على سبيل المثال، يندرج ضمن الذكاء الاصطناعي برنامج أو نموذج يترجم النصوص أو برنامج أو نموذج يحدّد الأمراض من صور الأشعة.

تعلُّم الآلة هو مجال فرعي من الذكاء الاصطناعي. ومع ذلك، بدأت بعض المؤسسات في السنوات الأخيرة تستخدم مصطلحَي الذكاء الاصطناعي وتعلُّم الآلة بالتبادل.

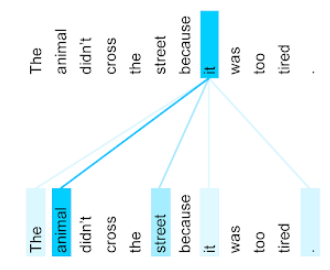

تنبيه

آلية مستخدَمة في شبكة عصبية تشير إلى أهمية كلمة معيّنة أو جزء من كلمة. تؤدي آلية الانتباه إلى تقليل كمية المعلومات التي يحتاج إليها النموذج لتوقّع الرمز المميز/الكلمة التالية. قد تتألف آلية الانتباه النموذجية من مجموع مرجّح على مجموعة من المدخلات، حيث يتم احتساب الوزن لكل مدخل من خلال جزء آخر من الشبكة العصبية.

يُرجى الرجوع أيضًا إلى الانتباه الذاتي والانتباه الذاتي المتعدد الرؤوس، وهما اللبنات الأساسية في المحوّلات.

يمكنك الاطّلاع على النماذج اللغوية الكبيرة: ما هو النموذج اللغوي الكبير؟ في "دورة تدريبية مكثّفة حول تعلُّم الآلة" لمزيد من المعلومات حول الانتباه الذاتي.

السمة

مرادف ميزة

في سياق عدالة تعلُّم الآلة، تشير السمات غالبًا إلى الخصائص المتعلقة بالأفراد.

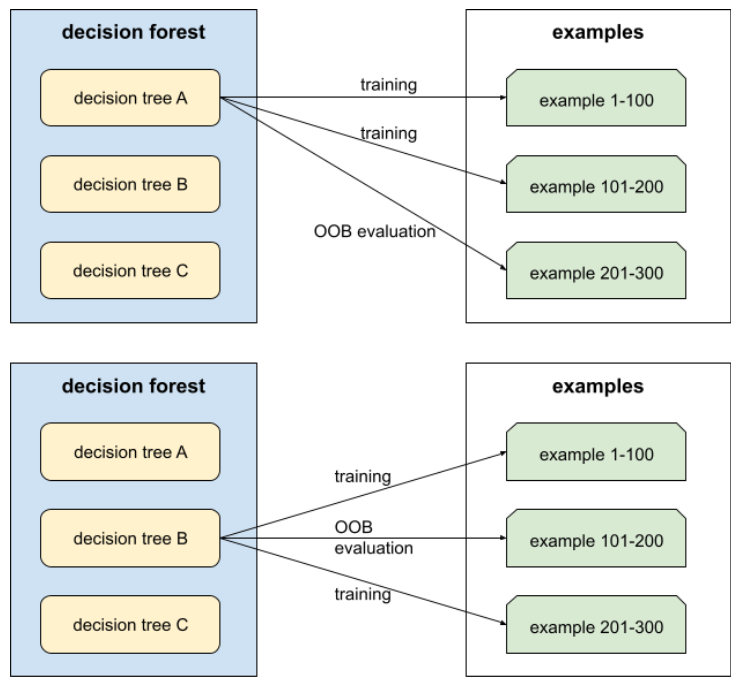

أخذ عيّنات من السمات

أسلوب لتدريب غابة القرارات، حيث لا تأخذ كل شجرة قرارات في الاعتبار سوى مجموعة فرعية عشوائية من الميزات المحتملة عند تعلّم الشرط. بشكل عام، يتم أخذ عيّنة من مجموعة فرعية مختلفة من الميزات لكل عقدة. في المقابل، عند تدريب شجرة قرارات بدون أخذ عيّنات من السمات، يتم أخذ جميع الميزات المحتملة في الاعتبار لكل عقدة.

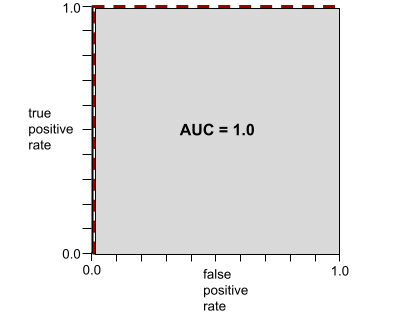

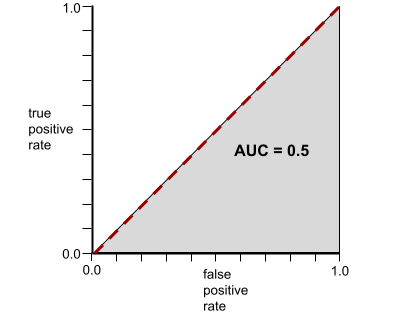

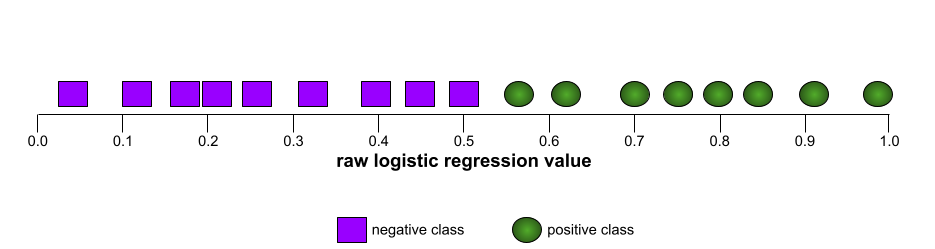

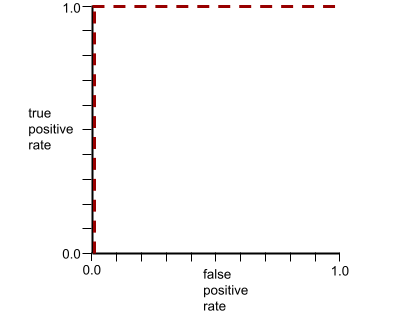

المساحة تحت منحنى ROC

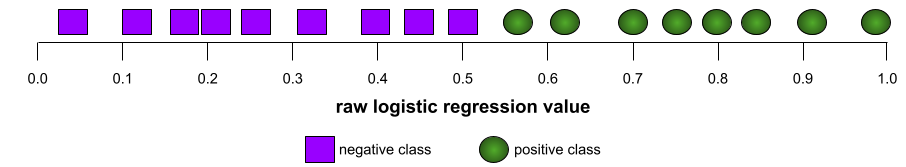

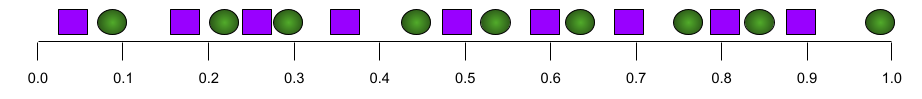

رقم يتراوح بين 0.0 و1.0 يمثّل قدرة نموذج التصنيف الثنائي على فصل الفئات الإيجابية عن الفئات السلبية. كلما اقتربت قيمة AUC من 1.0، كانت قدرة النموذج على فصل الفئات عن بعضها البعض أفضل.

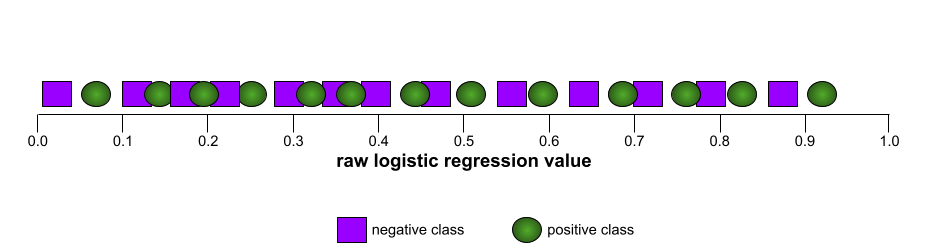

على سبيل المثال، توضّح الصورة التالية نموذج تصنيف يفصل تمامًا بين الفئات الإيجابية (الدوائر الخضراء) والفئات السلبية (المستطيلات الأرجوانية). يحقّق هذا النموذج المثالي بشكل غير واقعي قيمة AUC تبلغ 1.0:

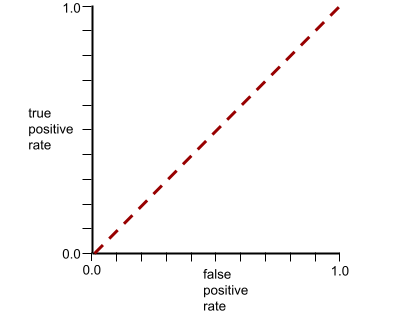

في المقابل، يوضّح الرسم التوضيحي التالي نتائج نموذج تصنيف أنشأ نتائج عشوائية. يحتوي هذا النموذج على قيمة AUC تبلغ 0.5:

نعم، النموذج السابق لديه قيمة AUC تبلغ 0.5، وليس 0.0.

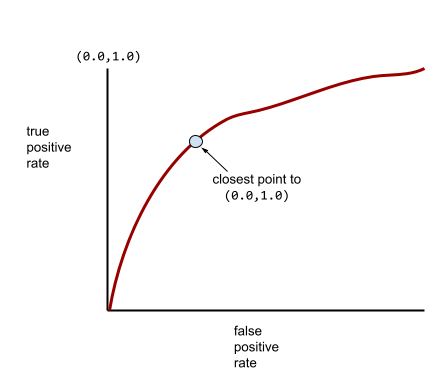

وتقع معظم النماذج في مكان ما بين هذين الحدّين. على سبيل المثال، يفصل النموذج التالي بين القيم الإيجابية والسلبية إلى حد ما، وبالتالي يكون لديه قيمة AUC تتراوح بين 0.5 و1.0:

تتجاهل مقاييس AUC أي قيمة تحدّدها لحدّ التصنيف. بدلاً من ذلك، تأخذ المساحة تحت منحنى ROC في الاعتبار جميع عتبات التصنيف الممكنة.

يمكنك الاطّلاع على التصنيف: منحنى ROC ومقياس AUC في "دورة مكثّفة عن تعلّم الآلة" للحصول على مزيد من المعلومات.

الواقع المعزّز

هي تكنولوجيا تفرض صورة من إنشاء الكمبيوتر على رؤية المستخدم للعالم الحقيقي، ما يوفّر بالتالي عرضًا مركّبًا.

autoencoder

نظام يتعلّم استخراج المعلومات الأكثر أهمية من البيانات المُدخلة. تتألف برامج الترميز التلقائي من برنامج ترميز وبرنامج فك ترميز. تعتمد برامج الترميز التلقائي على العملية التالية المكوّنة من خطوتَين:

- يحوّل برنامج الترميز الإدخال إلى تنسيق (وسيط) مضغوط (عادةً) ذي أبعاد أقل.

- ينشئ برنامج الترميز نسخة منخفضة الدقة من الإدخال الأصلي من خلال ربط التنسيق المنخفض الأبعاد بتنسيق الإدخال الأصلي العالي الأبعاد.

يتم تدريب برامج الترميز التلقائي بشكل شامل من خلال جعل برنامج فك الترميز يحاول إعادة إنشاء الإدخال الأصلي من التنسيق الوسيط لبرنامج الترميز بأقرب شكل ممكن. بما أنّ التنسيق الوسيط أصغر (أقل أبعادًا) من التنسيق الأصلي، يتم إجبار الترميز التلقائي على التعرّف على المعلومات الأساسية في الإدخال، ولن يكون الإخراج مطابقًا تمامًا للإدخال.

على سبيل المثال:

- إذا كانت بيانات الإدخال عبارة عن رسم، سيكون النسخ غير المطابق مشابهاً للرسم الأصلي، ولكن مع بعض التعديلات. ربما تزيل النسخة غير المطابقة الضوضاء من الرسم الأصلي أو تملأ بعض وحدات البكسل الناقصة.

- إذا كانت بيانات الإدخال نصًا، سينشئ الترميز التلقائي نصًا جديدًا يحاكي النص الأصلي (ولكنه ليس مطابقًا له).

يمكنك الاطّلاع أيضًا على المشفّرات التلقائية المتغيرة.

التقييم التلقائي

استخدام برامج للحكم على جودة نتائج النموذج

عندما يكون ناتج النموذج بسيطًا نسبيًا، يمكن لنص برمجي أو برنامج مقارنة ناتج النموذج بالردّ المثالي. يُطلق على هذا النوع من التقييم التلقائي أحيانًا اسم التقييم الآلي. غالبًا ما تكون مقاييس مثل ROUGE أو BLEU مفيدة للتقييم الآلي.

عندما تكون نتائج النموذج معقّدة أو لا تتضمّن إجابة صحيحة واحدة، يتم أحيانًا إجراء التقييم التلقائي من خلال برنامج منفصل للتعلم الآلي يُعرف باسم المقيّم التلقائي.

يختلف ذلك عن التقييم من جانب المستخدمين.

الانحياز للاقتراحات الآلية

عندما يفضّل صانع القرار البشري الاقتراحات التي تقدّمها أنظمة آلية لاتخاذ القرارات على المعلومات التي يتم جمعها بدون استخدام أنظمة آلية، حتى عندما ترتكب هذه الأنظمة أخطاءً

لمزيد من المعلومات، يُرجى الاطّلاع على الإنصاف: أنواع التحيز في "الدورة التدريبية المكثّفة حول تعلُّم الآلة".

AutoML

أي عملية مبرمَجة لإنشاء نماذج تعلُّم الآلة يمكن لـ AutoML تنفيذ مهام مثل ما يلي تلقائيًا:

- ابحث عن النموذج الأنسب.

- اضبط المعلَمات الفائقة.

- إعداد البيانات (بما في ذلك إجراء هندسة الميزات)

- فعِّل النموذج الناتج.

تُعدّ AutoML مفيدة لعلماء البيانات لأنّها يمكن أن توفّر لهم الوقت والجهد في تطوير مسارات تعلُّم الآلة وتحسين دقة التوقّعات. وهي مفيدة أيضًا لغير الخبراء، إذ تتيح لهم تنفيذ مهام معقّدة متعلقة بتعلُّم الآلة.

تتضمّن مكتبات AutoML في Google AI Flow Studio وPyGlove.لمزيد من المعلومات، يمكنك الاطّلاع على تعلُّم الآلة المبرمَج (AutoML) في "دورة مكثّفة عن تعلُّم الآلة".

تقييم autorater

آلية مختلطة لتقييم جودة نتائج نموذج الذكاء الاصطناعي التوليدي تجمع بين التقييم البشري والتقييم الآلي. أداة التقييم التلقائي هي نموذج لتعلُّم الآلة تم تدريبه على بيانات تم إنشاؤها من خلال التقييم البشري. من المفترض أن يتعلّم نظام التقييم الآلي محاكاة أداء المقيِّم البشري.تتوفّر أدوات تقييم تلقائي جاهزة، ولكن أفضلها هي تلك التي تم تحسينها وتخصيصها لتناسب المهمة التي يتم تقييمها.

نموذج الانحدار التلقائي

نموذج يستنتج توقّعًا استنادًا إلى توقعاته السابقة. على سبيل المثال، تتوقّع نماذج اللغة ذات الانحدار الذاتي الرمز المميز التالي استنادًا إلى الرموز المميزة التي تم توقّعها سابقًا. جميع النماذج اللغوية الكبيرة المستندة إلى Transformer هي نماذج ذات انحدار تلقائي.

في المقابل، لا تكون نماذج الصور المستندة إلى الشبكات العدائية التوليدية (GAN) عادةً ذات انحدار تلقائي، لأنّها تنشئ صورة في تمريرة واحدة للأمام وليس بشكل متكرّر على خطوات. ومع ذلك، فإنّ بعض نماذج إنشاء الصور تكون ذات انحدار تلقائي لأنّها تنشئ صورة على عدّة خطوات.

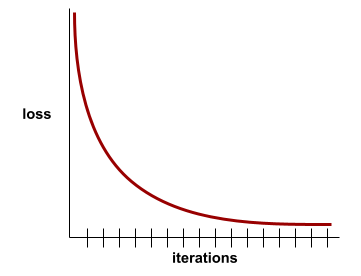

الخسارة الإضافية

دالة الخسارة: تُستخدَم مع دالة الخسارة الرئيسية للنموذج للشبكة العصبية، وتساعد في تسريع عملية التدريب أثناء التكرارات الأولى عندما يتم ضبط الأوزان عشوائيًا.

تساعد دوال الفقدان المساعدة في دفع التدرجات الفعالة إلى الطبقات السابقة. يسهّل ذلك عملية التقارب أثناء التدريب من خلال معالجة مشكلة التدرّج المتلاشي.

متوسط الدقة عند k

مقياس لتلخيص أداء نموذج بشأن طلب واحد يؤدي إلى إنشاء نتائج مرتبة، مثل قائمة مرقّمة باقتراحات كتب متوسط الدقة عند k هو، حسنًا، متوسط قيم الدقة عند k لكل نتيجة ذات صلة. وبالتالي، فإنّ صيغة متوسط الدقة عند k هي:

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

where:

- تمثّل السمة\(n\) عدد العناصر ذات الصلة في القائمة.

يختلف هذا المقياس عن مقياس الاسترجاع عند k.

شرط محاذي للمحور

في شجرة القرارات، شرط

يتضمّن ميزة واحدة فقط. على سبيل المثال، إذا كانت area

هي إحدى السمات، يكون الشرط التالي متوافقًا مع المحور:

area > 200

تتعارض مع الشرط المائل.

B

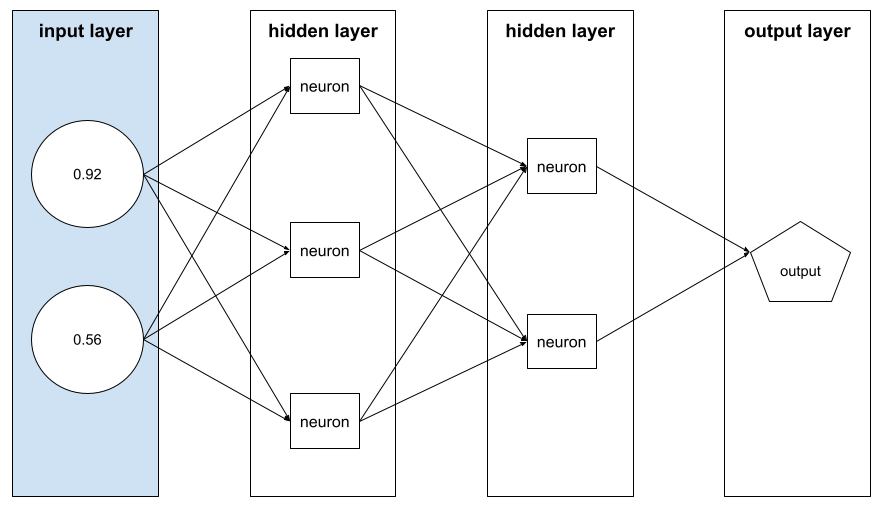

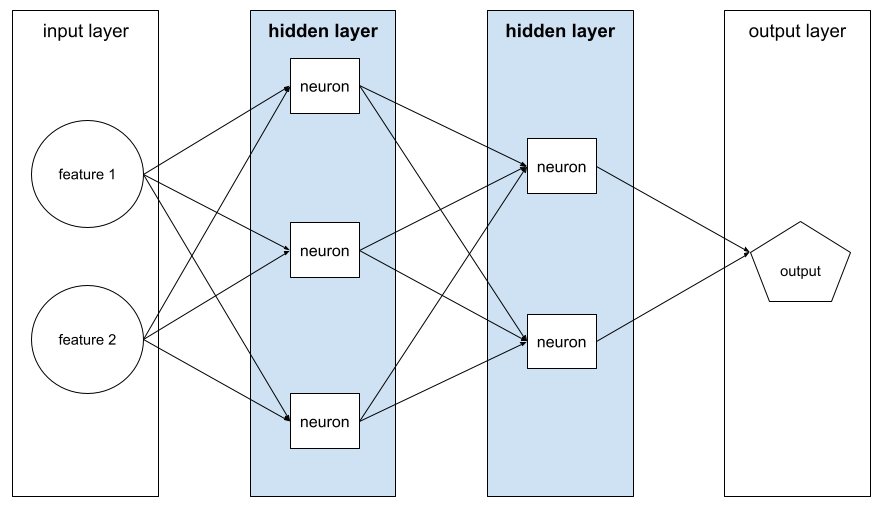

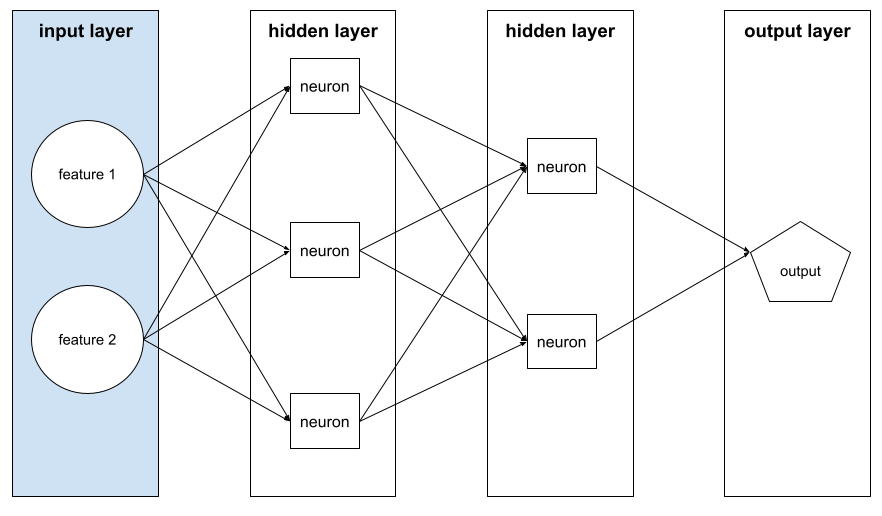

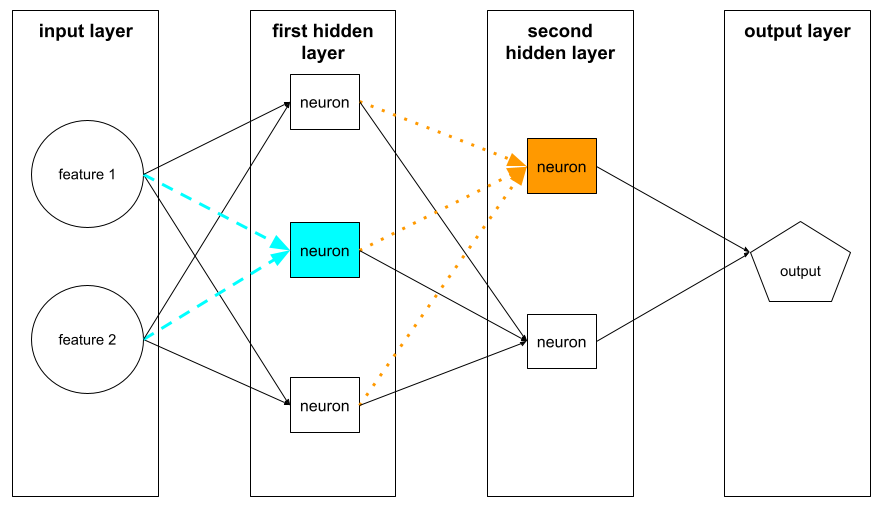

الانتشار العكسي

الخوارزمية التي تنفّذ خوارزمية انحدار التدرّج في الشبكات العصبية

يتضمّن تدريب الشبكة العصبونية العديد من التكرارات للدورة التالية المكوّنة من خطوتَين:

- أثناء التمرير الأمامي، يعالج النظام دفعة من الأمثلة لإنتاج التوقعات. يقارن النظام كل توقّع بقيمة كل تصنيف. الفرق بين القيمة المتوقّعة وقيمة التصنيف هو الخطأ في هذا المثال. يجمع النظام الخسائر لجميع الأمثلة من أجل احتساب إجمالي الخسارة للدُفعة الحالية.

- أثناء التمرير الخلفي (الانتشار الخلفي)، يقلّل النظام من الفقد من خلال تعديل أوزان جميع الخلايا العصبية في جميع الطبقات المخفية.

غالبًا ما تحتوي الشبكات العصبية على العديد من الخلايا العصبية في العديد من الطبقات المخفية. يساهم كل عصبون من هذه العصبونات في الخسارة الإجمالية بطرق مختلفة. تحدّد عملية الانتشار العكسي ما إذا كان يجب زيادة الأوزان المطبَّقة على الخلايا العصبية المحدّدة أو خفضها.

معدّل التعلّم هو عامل ضرب يتحكّم في درجة زيادة أو خفض كل وزن في كل تمرير للخلف. سيؤدي معدّل التعلّم الكبير إلى زيادة أو خفض كل وزن بشكل أكبر من معدّل التعلّم الصغير.

من الناحية الحسابية، تنفّذ عملية الانتشار العكسي قاعدة السلسلة من الحساب التفاضلي والتكاملي. أي أنّ عملية الانتشار العكسي تحسب المشتق الجزئي للخطأ بالنسبة إلى كل مَعلمة.

قبل سنوات، كان على مطوّري تعلُّم الآلة كتابة تعليمات برمجية لتنفيذ الانتشار الخلفي. تنفّذ واجهات برمجة التطبيقات الحديثة لتعلُّم الآلة، مثل Keras، الآن عملية الانتشار العكسي نيابةً عنك. أخيرًا!

لمزيد من المعلومات، يُرجى الاطّلاع على الشبكات العصبونية في "دورة مكثّفة عن تعلّم الآلة".

التجميع

يشير ذلك المصطلح إلى طريقة تدريب مجموعة موحّدة يتم فيها تدريب كل نموذج مكوِّن على مجموعة فرعية عشوائية من أمثلة التدريب يتم جمع عيّناتها مع الاستبدال. على سبيل المثال، الغابة العشوائية هي مجموعة من أشجار القرارات التي يتم تدريبها باستخدام أسلوب التجميع.

مصطلح bagging هو اختصار لعبارة bootstrap aggregating.

يمكنك الاطّلاع على الغابات العشوائية في دورة "أشجار القرارات" للحصول على مزيد من المعلومات.

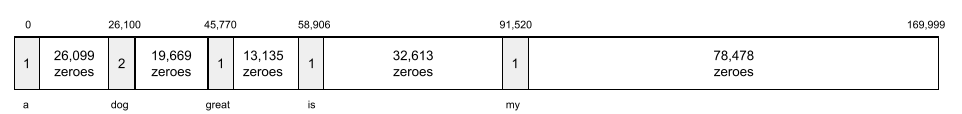

حقيبة الكلمات

تمثيل للكلمات في عبارة أو فقرة، بغض النظر عن الترتيب على سبيل المثال، تمثّل حقيبة الكلمات العبارات الثلاث التالية بشكل مطابق:

- الكلب يقفز

- قفز الكلب

- كلب يقفز

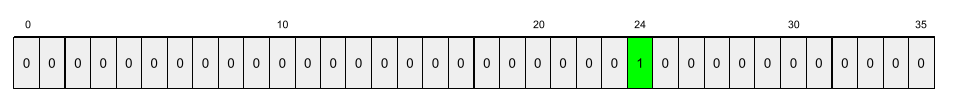

يتم ربط كل كلمة بفهرس في متجه متفرق، حيث يتضمّن المتجه فهرسًا لكل كلمة في المفردات. على سبيل المثال، يتم ربط العبارة الكلب يقفز بمتجه ميزات يتضمّن قيمًا غير صفرية في الفهارس الثلاثة المقابلة للكلمات الكلب ويقفز والـ. يمكن أن تكون القيمة غير الصفرية أيًّا ممّا يلي:

- الرقم 1 للإشارة إلى وجود كلمة

- عدد المرّات التي تظهر فيها كلمة في الحزمة على سبيل المثال، إذا كانت العبارة هي الكلب الأحمر هو كلب ذو فرو أحمر، سيتم تمثيل كل من أحمر وكلب بالرقم 2، بينما سيتم تمثيل الكلمات الأخرى بالرقم 1.

- قيمة أخرى، مثل اللوغاريتم الخاص بعدد مرات ظهور كلمة في الحزمة

المرجع

نموذج يُستخدَم كنقطة مرجعية لمقارنة مستوى أداء نموذج آخر (عادةً ما يكون أكثر تعقيدًا). على سبيل المثال، يمكن أن يكون نموذج الانحدار اللوجستي أساسًا جيدًا للنموذج العميق.

بالنسبة إلى مشكلة معيّنة، يساعد خط الأساس مطوّري النماذج في تحديد الحد الأدنى المتوقّع للأداء الذي يجب أن يحقّقه النموذج الجديد ليكون مفيدًا.

النموذج الأساسي

نموذج مدرَّب مسبقًا يمكن استخدامه كنقطة بداية للتحسين من أجل معالجة مهام أو تطبيقات محدّدة.

اطّلِع أيضًا على النموذج المدرَّب مسبقًا والنموذج الأساسي.

دفعة

مجموعة الأمثلة المستخدَمة في إحدى التكرارات التدريبية. يحدّد حجم الدفعة عدد الأمثلة في الدفعة.

راجِع مقالة الفترة للحصول على شرح حول كيفية ارتباط الدفعة بالفترة.

يمكنك الاطّلاع على الانحدار الخطي: المَعلمات الفائقة في "دورة مكثّفة عن تعلّم الآلة" للحصول على مزيد من المعلومات.

الاستدلال المجمّع

عملية استنتاج التوقعات بشأن عدة أمثلة غير مصنّفة مقسّمة إلى مجموعات فرعية أصغر ("دفعات").

يمكن أن تستفيد الاستنتاجات المجمّعة من ميزات التوازي في شرائح الأجهزة المسرّعة. وهذا يعني أنّه يمكن للعديد من أدوات التسريع أن تستنتج التوقعات في الوقت نفسه بشأن مجموعات مختلفة من الأمثلة غير المصنّفة، ما يؤدي إلى زيادة عدد الاستنتاجات في الثانية بشكل كبير.

يمكنك الاطّلاع على أنظمة تعلُّم الآلة الخاصة بالإنتاج: الاستنتاج الثابت مقابل الاستنتاج الديناميكي في "دورة تدريبية مكثّفة حول تعلُّم الآلة" للحصول على مزيد من المعلومات.

التسوية على دفعات

تسوية الإدخال أو الإخراج لدوال التنشيط في طبقة مخفية يمكن أن يوفّر التسوية على مستوى المجموعة المزايا التالية:

- زيادة استقرار الشبكات العصبونية من خلال الحماية من الأوزان الشاذة

- فعِّل معدّلات التعلّم الأعلى، ما قد يؤدي إلى تسريع التدريب.

- تقليل التطابق الزائد

حجم الدفعة

عدد الأمثلة في دفعة على سبيل المثال، إذا كان حجم الدفعة 100، سيعالج النموذج 100 مثال لكل تكرار.

في ما يلي استراتيجيات شائعة لحجم الدُفعات:

- النزول المتدرّج العشوائي (SGD)، حيث يكون حجم الدفعة 1

- المجموعة الكاملة، حيث يكون حجم المجموعة هو عدد الأمثلة في مجموعة التدريب بأكملها. على سبيل المثال، إذا كانت مجموعة التدريب تحتوي على مليون مثال، سيكون حجم الدفعة مليون مثال. عادةً ما تكون الدفعة الكاملة استراتيجية غير فعّالة.

- الدُفعات الصغيرة التي يتراوح حجم الدفعة فيها عادةً بين 10 و1000. عادةً ما تكون استراتيجية الدُفعات الصغيرة هي الأكثر كفاءة.

يُرجى الاطّلاع على ما يلي لمزيد من المعلومات:

- أنظمة تعلُّم الآلة في مرحلة الإنتاج: الاستنتاج الثابت مقابل الاستنتاج الديناميكي في "دورة مكثّفة عن تعلُّم الآلة"

- Deep Learning Tuning Playbook

شبكة عصبية بايزية

شبكة عصبية احتمالية تأخذ في الاعتبار عدم اليقين في الأوزان والنتائج. عادةً ما يتوقّع نموذج الانحدار المستند إلى الشبكة العصبية القياسية قيمة عددية، فعلى سبيل المثال، يتوقّع النموذج القياسي سعر منزل يبلغ 853,000 ريال سعودي. في المقابل، تتنبّأ الشبكة العصبية البايزية بتوزيع القيم، فعلى سبيل المثال، يتنبّأ نموذج بايزي بسعر منزل يبلغ 853,000 دولار أمريكي بانحراف معياري يبلغ 67,200 دولار أمريكي.

تعتمد الشبكة العصبية البايزية على نظرية بايز لحساب حالات عدم اليقين في الأوزان والتوقعات. يمكن أن تكون الشبكة العصبية البايزية مفيدة عندما يكون من المهم تحديد مقدار عدم اليقين، كما هو الحال في النماذج المتعلقة بالأدوية. يمكن أن تساعد الشبكات العصبونية البايزية أيضًا في منع التطابق الزائد.

التحسين البايزي

نموذج الانحدار الاحتمالي هو أسلوب لتحسين دوال الهدف التي تتطلّب قدرًا كبيرًا من العمليات الحسابية، وذلك من خلال تحسين بديل يحدّد مقدار عدم اليقين باستخدام أسلوب التعلّم "بايزي". بما أنّ عملية التحسين المستندة إلى الإحصاء البايزي مكلفة جدًا، يتم استخدامها عادةً لتحسين المهام التي يصعب تقييمها والتي تتضمّن عددًا صغيرًا من المَعلمات، مثل اختيار المَعلمات الفائقة.

معادلة بيلمان

في التعلّم المعزّز، يتم استيفاء الهوية التالية من خلال دالة Q المثالية:

\[Q(s, a) = r(s, a) + \gamma \mathbb{E}_{s'|s,a} \max_{a'} Q(s', a')\]

تطبّق خوارزميات التعلّم المعزّز هذه الهوية لإنشاء تعلّم Q باستخدام قاعدة التعديل التالية:

\[Q(s,a) \gets Q(s,a) + \alpha \left[r(s,a) + \gamma \displaystyle\max_{\substack{a_1}} Q(s',a') - Q(s,a) \right] \]

بالإضافة إلى التعلّم المعزّز، يمكن تطبيق معادلة بيلمان في البرمجة الديناميكية. يمكنك الاطّلاع على مدخل Wikipedia حول معادلة بيلمان.

BERT (تمثيلات الترميز الثنائية الاتجاه من المحولات)

بنية نموذج لتمثيل النص يمكن أن يعمل نموذج BERT مدرَّب كجزء من نموذج أكبر لتصنيف النصوص أو مهام تعلُّم آلي أخرى.

تتضمّن BERT الخصائص التالية:

- يستخدم بنية Transformer، وبالتالي يعتمد على الانتباه الذاتي.

- يستخدم جزء برنامج الترميز في Transformer. مهمة أداة الترميز هي إنتاج تمثيلات نصية جيدة، وليس تنفيذ مهمة محددة مثل التصنيف.

- ثنائي الاتجاه

- تستخدم الإخفاء في التدريب غير الخاضع للإشراف.

تشمل صيغ BERT ما يلي:

يمكنك الاطّلاع على Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing للحصول على نظرة عامة حول BERT.

التحيّز (الأخلاقيات/العدالة)

1. التحيّز أو التمييز أو المحاباة تجاه بعض الأشياء أو الأشخاص أو المجموعات دون غيرها يمكن أن تؤثّر هذه الانحيازات في جمع البيانات وتفسيرها، وفي تصميم النظام، وفي طريقة تفاعل المستخدمين مع النظام. تشمل أشكال هذا النوع من التحيز ما يلي:

- تحيّز الأتمتة

- الانحياز التأكيدي

- تحيّز المجرب

- الانحياز لتشابه المجموعة

- التحيّز الضمني

- الانحياز لأفراد المجموعة

- الانحياز للتشابه خارج المجموعة

2. خطأ منهجي ناتج عن إجراءات أخذ العيّنات أو إعداد التقارير تشمل أشكال هذا النوع من التحيز ما يلي:

- انحياز في التغطية

- الانحياز لعدم الإجابة

- انحياز المشاركة

- الانحياز لتكرار التقارير

- انحياز في جمع العيّنات

- الانحياز في الاختيار

يجب عدم الخلط بينه وبين مصطلح الانحياز في نماذج تعلُّم الآلة أو انحياز التوقّعات.

يمكنك الاطّلاع على الإنصاف: أنواع التحيز في "الدورة التدريبية المكثّفة حول تعلُّم الآلة" للحصول على مزيد من المعلومات.

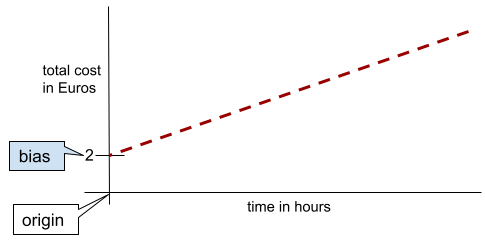

الانحياز (رياضيات) أو مصطلح الانحياز

نقطة اعتراض أو إزاحة من نقطة الأصل التحيّز هو مَعلمة في نماذج تعلُّم الآلة، ويتم تمثيله بأحد الرمزين التاليين:

- b

- w0

على سبيل المثال، التحيز هو b في الصيغة التالية:

في خط بسيط ثنائي الأبعاد، يعني التحيز ببساطة "نقطة التقاطع مع المحور الصادي". على سبيل المثال، يبلغ ميل الخط في الرسم التوضيحي التالي 2.

يحدث التحيز لأنّ بعض النماذج لا تبدأ من نقطة الأصل (0,0). على سبيل المثال، لنفترض أنّ تكلفة الدخول إلى مدينة ملاهٍ هي 2 يورو، بالإضافة إلى 0.5 يورو لكل ساعة يقضيها العميل. لذلك، فإنّ نموذجًا يربط التكلفة الإجمالية بانحياز قدره 2 لأنّ أدنى تكلفة هي 2 يورو.

يجب عدم الخلط بين التحيز والتحيز في الأخلاقيات والعدالة أو التحيز في التوقعات.

يمكنك الاطّلاع على الانحدار الخطي في "دورة مكثّفة عن تعلّم الآلة" للحصول على مزيد من المعلومات.

ثنائي الاتجاه

مصطلح يُستخدم لوصف نظام يقيّم النص الذي يسبق والنص الذي يلي جزءًا مستهدفًا من النص. في المقابل، لا يقيّم النظام أحادي الاتجاه سوى النص الذي يسبق جزءًا مستهدفًا من النص.

على سبيل المثال، فكِّر في نموذج لغة مخفي يجب أن يحدّد احتمالات الكلمة أو الكلمات التي تمثّل الخط السفلي في السؤال التالي:

ما هي _____ لديك؟

يجب أن يستند النموذج اللغوي أحادي الاتجاه إلى الاحتمالات التي يوفّرها السياق فقط من خلال الكلمات "ما" و"هو" و "ال". في المقابل، يمكن لنموذج لغة ثنائي الاتجاه أن يستمد السياق أيضًا من الكلمتين "مع" و "أنت"، ما قد يساعد النموذج في إنشاء توقّعات أفضل.

نموذج لغوي ثنائي الاتجاه

نموذج لغوي يحدّد احتمالية ظهور رمز مميز معيّن في موضع معيّن ضمن مقتطف نصي استنادًا إلى النص السابق والنص التالي.

bigram

ثنائي حيث ن=2

التصنيف الثنائي

نوع من مهام التصنيف التي تتوقّع إحدى الفئتين الحصريتين:

على سبيل المثال، يؤدي نموذجا تعلُّم الآلة التاليان التصنيف الثنائي:

- نموذج يحدّد ما إذا كانت الرسائل الإلكترونية غير مرغوب فيها (الفئة الإيجابية) أو مرغوب فيها (الفئة السلبية).

- نموذج يقيّم الأعراض الطبية لتحديد ما إذا كان الشخص مصابًا بمرض معيّن (الفئة الإيجابية) أو غير مصاب به (الفئة السلبية).

يجب عدم الخلط بينه وبين التصنيف المتعدد الفئات.

راجِع أيضًا الانحدار اللوجستي وحد التصنيف.

يمكنك الاطّلاع على التصنيف في "دورة مكثّفة عن تعلّم الآلة" للحصول على مزيد من المعلومات.

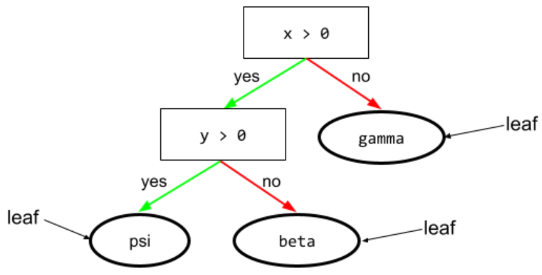

الشرط الثنائي

في شجرة القرار، الشرط الذي يتضمّن نتيجتَين محتمَلتَين فقط، عادةً نعم أو لا. على سبيل المثال، الشرط الثنائي التالي:

temperature >= 100

يختلف عن الحالة غير الثنائية.

اطّلِع على أنواع الشروط في دورة "غابات القرارات" للحصول على مزيد من المعلومات.

تحويل القيم

مرادف للتجميع في مجموعات

نموذج الصندوق الأسود

نموذج يستحيل أو يصعب على البشر فهم "طريقة تفكيره". أي أنّه على الرغم من أنّ البشر يمكنهم معرفة كيف تؤثر الطلبات في الردود، لا يمكنهم تحديد الطريقة التي يحدّد بها نموذج الصندوق الأسود الردّ. بعبارة أخرى، يفتقر نموذج الصندوق الأسود إلى التفسير.

معظم النماذج العميقة والنماذج اللغوية الكبيرة هي صناديق سوداء.

BLEU (التقييم الثنائي للترجمة الآلية)

مقياس يتراوح بين 0.0 و1.0 لتقييم الترجمات الآلية، مثلاً من الإسبانية إلى اليابانية

لحساب النتيجة، تقارن مقاييس BLEU عادةً ترجمة نموذج تعلُّم الآلة (النص الذي تم إنشاؤه) بترجمة خبير بشري (النص المرجعي). تُحدّد درجة تطابق العبارات المكونة من N كلمة في النص الذي تم إنشاؤه مع النص المرجعي درجة BLEU.

يمكنك الاطّلاع على الورقة البحثية الأصلية حول هذا المقياس BLEU: a Method for Automatic Evaluation of Machine Translation.

يمكنك الاطّلاع أيضًا على BLEURT.

BLEURT (التقييم الثنائي اللغة باستخدام أدوات تحويل)

مقياس لتقييم الترجمات الآلية من لغة إلى أخرى، لا سيما من الإنجليزية وإليها.

بالنسبة إلى الترجمات من الإنجليزية وإليها، تتوافق مقاييس BLEURT بشكل أكبر مع تقييمات البشر مقارنةً بمقاييس BLEU. على عكس BLEU، تؤكّد BLEURT على التشابهات الدلالية (المعنى) ويمكنها استيعاب إعادة الصياغة.

يعتمد مقياس BLEURT على نموذج لغوي كبير مدرَّب مسبقًا (BERT تحديدًا) يتم بعد ذلك تحسينه باستخدام نصوص من مترجمين بشريين.

المستند الأصلي حول هذا المقياس هو BLEURT: Learning Robust Metrics for Text Generation.

أسئلة منطقية (BoolQ)

مجموعة بيانات لتقييم مدى إتقان نموذج لغوي كبير للإجابة عن أسئلة بنعم أو لا يتضمّن كل تحدٍّ في مجموعة البيانات ثلاثة عناصر:

- طلب البحث

- تمثّل هذه السمة مقطعًا يشير إلى الإجابة عن طلب البحث.

- الإجابة الصحيحة، وهي إما نعم أو لا

على سبيل المثال:

- طلب البحث: هل هناك أي محطات طاقة نووية في ميشيغان؟

- المقطع: ...توفّر ثلاث محطات للطاقة النووية حوالي% 30 من الكهرباء في ولاية ميشيغان.

- الإجابة الصحيحة: نعم

جمع الباحثون الأسئلة من طلبات بحث مجمّعة ومجهولة المصدر على "بحث Google"، ثم استخدموا صفحات Wikipedia لتحديد المعلومات الأساسية.

لمزيد من المعلومات، يُرجى الاطّلاع على BoolQ: Exploring the Surprising Difficulty of Natural Yes/No Questions.

BoolQ هي أحد مكوّنات مجموعة SuperGLUE.

BoolQ

اختصار الأسئلة المنطقية

التعزيز

إحدى تقنيات تعلُّم الآلة التي تجمع بشكل متكرّر مجموعة من نماذج التصنيف البسيطة وغير الدقيقة جدًا (المعروفة باسم "المصنّفات الضعيفة") في نموذج تصنيف عالي الدقة (يُعرف باسم "المصنّف القوي") من خلال زيادة وزن الأمثلة التي يصنّفها النموذج حاليًا بشكل خاطئ.

يمكنك الاطّلاع على أشجار القرارات المعزّزة بالتدرّج في دورة "غابات القرارات" للحصول على مزيد من المعلومات.

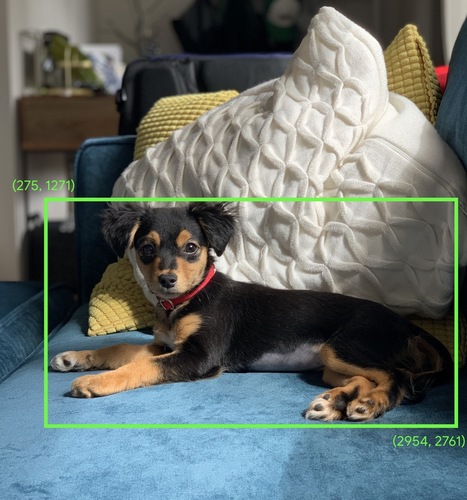

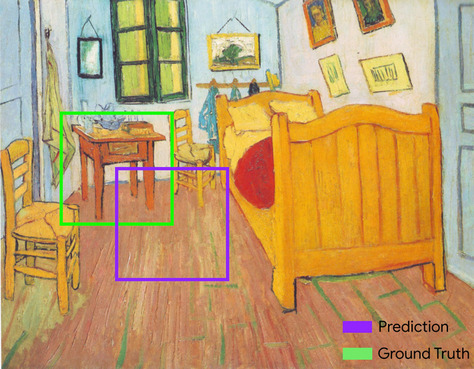

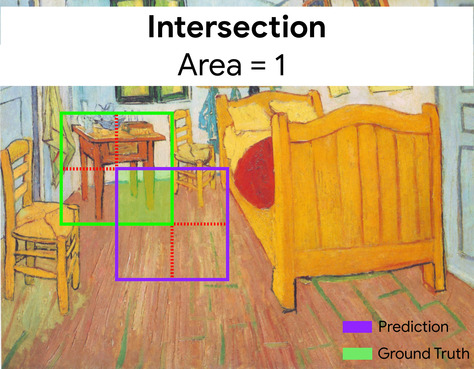

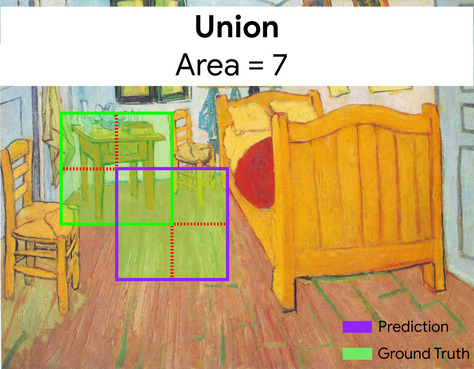

مربّع الحدود

في الصورة، تمثّل الإحداثيات (x، y) مستطيلاً يحيط بمنطقة مهمة، مثل الكلب في الصورة أدناه.

البث

توسيع شكل عامل في عملية حسابية على المصفوفات إلى أبعاد متوافقة مع هذه العملية على سبيل المثال، يتطلّب الجبر الخطي أن يكون للمعاملَين في عملية إضافة المصفوفة الأبعاد نفسها. وبالتالي، لا يمكنك إضافة مصفوفة ذات شكل (m, n) إلى متجه بطول n. تتيح عملية البث هذه العملية من خلال توسيع المتّجه الذي يبلغ طوله n إلى مصفوفة ذات شكل (m, n) عن طريق تكرار القيم نفسها في كل عمود.

اطّلِع على الوصف التالي للبث في NumPy للحصول على مزيد من التفاصيل.

تقسيم البيانات إلى مجموعات

تحويل سمة واحدة إلى سمات ثنائية متعددة تُعرف باسم حِزم أو فئات، ويتم ذلك عادةً استنادًا إلى نطاق قيمة. عادةً ما تكون الميزة المقطّعة ميزة مستمرة.

على سبيل المثال، بدلاً من تمثيل درجة الحرارة كميزة واحدة مستمرة ذات فاصلة عائمة، يمكنك تقسيم نطاقات درجات الحرارة إلى فئات منفصلة، مثل:

- ستكون درجة الحرارة التي تقل عن أو تساوي 10 درجات مئوية ضمن فئة "البارد".

- ستكون درجات الحرارة بين 11 و24 درجة مئوية ضمن الفئة "معتدلة".

- >= 25 درجة مئوية ستكون الفئة "دافئ".

سيتعامل النموذج مع كل قيمة في المجموعة نفسها بشكل مماثل. على سبيل المثال، تندرج القيمتان 13 و22 ضمن الفئة المعتدلة، وبالتالي يتعامل النموذج مع القيمتين بشكل مماثل.

لمزيد من المعلومات، راجِع البيانات الرقمية: التصنيف إلى فئات في "دورة مكثّفة عن تعلّم الآلة".

C

طبقة المعايرة

تعديل ما بعد التوقّع، ويتم عادةً لتفسير تحيّز التوقّع. يجب أن تتطابق التوقعات والاحتمالات المعدَّلة مع توزيع مجموعة من التصنيفات التي تمت ملاحظتها.

إنشاء العناصر المحفّزة لعرض الإعلانات

المجموعة الأولية من الاقتراحات التي يختارها نظام الاقتراحات على سبيل المثال، تخيّل مكتبة تبيع 100,000 عنوان. تنشئ مرحلة إنشاء المرشّحين قائمة أصغر بكثير من الكتب المناسبة لمستخدم معيّن، ولنفترض أنّها تضم 500 كتاب. ولكن حتى 500 كتاب هو عدد كبير جدًا لاقتراحه على المستخدم. تؤدي المراحل اللاحقة والأكثر تكلفة في نظام التوصية (مثل التسجيل وإعادة الترتيب) إلى تقليل عدد هذه النتائج البالغ 500 إلى مجموعة أصغر بكثير وأكثر فائدة من التوصيات.

يمكنك الاطّلاع على نظرة عامة حول إنشاء المرشّحين في دورة "أنظمة الاقتراحات" التدريبية للحصول على مزيد من المعلومات.

تحليل العينات المُحتملة

تحسين وقت التدريب الذي يحسب احتمالية لجميع التصنيفات الإيجابية، باستخدام، على سبيل المثال، softmax، ولكن فقط لعينة عشوائية من التصنيفات السلبية على سبيل المثال، إذا كان لديك مثال مصنّف على أنّه كلب بيغل وكلب، فإنّ أخذ عينات من المرشّحين يحسب الاحتمالات المتوقّعة ومصطلحات الخسارة المقابلة لما يلي:

- بيغل

- dog

- مجموعة فرعية عشوائية من الفئات السلبية المتبقية (على سبيل المثال، قطة ومصاصة وسياج).

الفكرة هي أنّ الفئات السلبية يمكن أن تستفيد من التعزيز السلبي الأقل تكرارًا طالما أنّ الفئات الإيجابية تتلقّى دائمًا التعزيز الإيجابي المناسب، وقد تم رصد ذلك تجريبيًا بالفعل.

تكون عملية أخذ عينات من المرشحين أكثر فعالية من حيث الحوسبة مقارنةً بخوارزميات التدريب التي تحسب التوقعات لكل الفئات السلبية، خاصةً عندما يكون عدد الفئات السلبية كبيرًا جدًا.

البيانات الفئوية

السمات التي تتضمّن مجموعة محدّدة من القيم المحتملة على سبيل المثال، لنفترض أنّ هناك ميزة فئوية باسم traffic-light-state، والتي يمكن أن تتضمّن إحدى القيم الثلاث التالية فقط:

redyellowgreen

من خلال تمثيل traffic-light-state كميزة فئوية، يمكن للنموذج التعرّف على التأثيرات المختلفة لكل من red وgreen وyellow في سلوك السائق.

يُطلق على الميزات الفئوية أحيانًا اسم الميزات المنفصلة.

يختلف عن البيانات الرقمية.

لمزيد من المعلومات، راجِع استخدام البيانات الفئوية في "الدورة التدريبية المكثّفة حول تعلُّم الآلة".

نموذج لغوي سببي

مرادف نموذج اللغة أحادي الاتجاه

يمكنك الاطّلاع على نموذج اللغة الثنائي الاتجاه للمقارنة بين الأساليب المختلفة للاتجاهات في نماذج اللغة.

CB

اختصار CommitmentBank

مركز

مركز المجموعة كما تحدده خوارزمية k-means أو خوارزمية k-median على سبيل المثال، إذا كانت قيمة k هي 3، ستعثر الخوارزمية التصنيفية أو خوارزمية تحليل المجموعات على 3 نقاط مركزية.

لمزيد من المعلومات، يمكنك الاطّلاع على خوارزميات التجميع في دورة التجميع.

التجميع العنقودي المستند إلى النقاط المركزية

فئة من خوارزميات التجميع العنقودي التي تنظّم البيانات في مجموعات غير هرمية، وتُعد خوارزمية k-means الأكثر استخدامًا بين خوارزميات التجميع العنقودي المستندة إلى نقطة مركزية.

يختلف ذلك عن خوارزميات التجميع الهرمي.

لمزيد من المعلومات، يمكنك الاطّلاع على خوارزميات التجميع في دورة التجميع.

توجيه سلسلة الأفكار

إحدى تقنيات تصميم الطلبات التي تشجّع النماذج اللغوية الكبيرة (LLM) على شرح طريقة تفكيرها خطوة بخطوة. على سبيل المثال، اطّلِع على الطلب التالي، مع التركيز بشكل خاص على الجملة الثانية:

ما هو عدد قوى الجاذبية التي سيشعر بها السائق في سيارة تنتقل من 0 إلى 60 ميلاً في الساعة خلال 7 ثوانٍ؟ في الإجابة، أدرِج جميع العمليات الحسابية ذات الصلة.

من المرجّح أن يكون رد النموذج اللغوي الكبير على النحو التالي:

- عرض سلسلة من صيغ الفيزياء، مع إدخال القيم 0 و60 و7 في الأماكن المناسبة

- اشرح سبب اختيار هذه الصيغ وما تعنيه المتغيّرات المختلفة.

يفرض الطلب المستند إلى سلسلة الأفكار على النموذج اللغوي الكبير إجراء جميع العمليات الحسابية، ما قد يؤدي إلى تقديم إجابة أكثر صحة. بالإضافة إلى ذلك، يتيح أسلوب "سلسلة الأفكار" للمستخدم فحص خطوات النموذج اللغوي الكبير لتحديد ما إذا كانت الإجابة منطقية أم لا.

مقياس دقة الاختبار (F-score) لـ N-gram الخاص بالأحرف (ChrF)

مقياس لتقييم نماذج الترجمة الآلية تحدّد نتيجة F الخاصة بـ N-gram للأحرف درجة تطابق N-gram في النص المرجعي مع N-gram في النص الذي تم إنشاؤه بواسطة نموذج تعلّم آلي.

يشبه مقياس F-score الخاص بـ N-gram للأحرف المقاييس في عائلتَي ROUGE وBLEU، باستثناء ما يلي:

- تعمل نتيجة F-score لـ N-gram الأحرف على N-gram الأحرف.

- تعمل مقاييس ROUGE وBLEU على كلمات N-grams أو رموز.

محادثة

محتوى حوار ذهابًا وإيابًا مع نظام تعلُّم آلي، ويكون عادةً نموذجًا لغويًا كبيرًا. تصبح التفاعلات السابقة في المحادثة (ما كتبته وكيفية ردّ النموذج اللغوي الكبير) هي سياق الأجزاء اللاحقة من المحادثة.

روبوت الدردشة هو تطبيق لنموذج لغوي كبير.

نقطة تفتيش

البيانات التي تسجّل حالة المَعلمات الخاصة بالنموذج، سواء أثناء التدريب أو بعد اكتماله على سبيل المثال، أثناء التدريب، يمكنك إجراء ما يلي:

- إيقاف التدريب، ربما عن قصد أو ربما نتيجة حدوث أخطاء معيّنة

- احفظ النقطة المرجعية.

- بعد ذلك، أعِد تحميل نقطة التحقّق، ربما على جهاز مختلف.

- إعادة بدء التدريب

اختيار البدائل المعقولة (COPA)

مجموعة بيانات لتقييم مدى قدرة نموذج لغوي كبير على تحديد أفضل إجابتَين بديلتَين عن فرضية. يتألف كل تحدٍ في مجموعة البيانات من ثلاثة عناصر:

- مقدمة، وهي عادةً عبارة متبوعة بسؤال

- إجابتان محتملتان عن السؤال المطروح في المقدمة، إحداهما صحيحة والأخرى غير صحيحة

- الإجابة الصحيحة

على سبيل المثال:

- الفرضية: كسر الرجل إصبع قدمه. ما هو سبب حدوث ذلك؟

- الإجابات المحتملة:

- ظهر ثقب في جوربه.

- سقط مطرقة على قدمه.

- الإجابة الصحيحة: 2

COPA هي أحد مكوّنات مجموعة SuperGLUE.

صنف

فئة يمكن أن تنتمي إليها التسمية. على سبيل المثال:

- في نموذج التصنيف الثنائي الذي يرصد الرسائل غير المرغوب فيها، قد تكون الفئتان رسائل غير مرغوب فيها وليست رسائل غير مرغوب فيها.

- في نموذج التصنيف المتعدّد الفئات الذي يحدّد سلالات الكلاب، قد تكون الفئات بودل وبيغل وبَغ وما إلى ذلك.

نموذج التصنيف يتنبأ بفئة. في المقابل، يتنبأ نموذج الانحدار برقم بدلاً من فئة.

يمكنك الاطّلاع على التصنيف في "دورة مكثّفة عن تعلّم الآلة" للحصول على مزيد من المعلومات.

مجموعة بيانات متوازنة الفئات

مجموعة بيانات تحتوي على تصنيفات فئوية يكون فيها عدد مثيلات كل فئة متساويًا تقريبًا. على سبيل المثال، لنفترض أنّ لديك مجموعة بيانات نباتية يمكن أن تكون تصنيفاتها الثنائية إما نبات محلي أو نبات غير محلي:

- مجموعة البيانات التي تتضمّن 515 نباتًا أصليًا و485 نباتًا غير أصلي هي مجموعة بيانات متوازنة الفئات.

- مجموعة البيانات التي تتضمّن 875 نباتًا أصليًا و125 نباتًا غير أصلي هي مجموعة بيانات غير متوازنة الفئات.

لا يوجد خط فاصل رسمي بين مجموعات البيانات المتوازنة الفئات ومجموعات البيانات غير المتوازنة الفئات. لا يصبح التمييز مهمًا إلا عندما يتعذّر تقارب نموذج تم تدريبه على مجموعة بيانات غير متوازنة بشكل كبير. راجِع مجموعات البيانات: مجموعات البيانات غير المتوازنة في "دورة مكثّفة عن تعلُّم الآلة" للحصول على التفاصيل.

نموذج التصنيف

نموذج يكون توقّعه فئة. على سبيل المثال، كلّ ما يلي هي نماذج تصنيف:

- نموذج يتوقّع لغة جملة إدخال (هل هي فرنسية؟ الإسبانية؟ الإيطالية؟

- نموذج يتوقّع أنواع الأشجار (قيقب؟ سنديان؟ Baobab?).

- نموذج يتنبأ بالفئة الإيجابية أو السلبية لحالة طبية معيّنة.

في المقابل، تتنبأ نماذج الانحدار بالأرقام بدلاً من الفئات.

في ما يلي نوعان شائعان من نماذج التصنيف:

عتبة التصنيف

في التصنيف الثنائي، يكون العدد بين 0 و1 الذي يحوّل الناتج الأولي لنموذج الانحدار اللوجستي إلى توقع إما الفئة الإيجابية أو الفئة السلبية. يُرجى العِلم أنّ حدّ التصنيف هو قيمة يختارها الإنسان، وليس قيمة يختارها تدريب النموذج.

يُخرج نموذج الانحدار اللوجستي قيمة أولية بين 0 و1. بعد ذلك:

- إذا كانت هذه القيمة الأولية أكبر من حد التصنيف، سيتم توقّع الفئة الموجبة.

- إذا كانت هذه القيمة الأولية أقل من حد التصنيف، يتم التنبؤ بالفئة السلبية.

على سبيل المثال، لنفترض أنّ حد التصنيف هو 0.8. إذا كانت القيمة الأولية 0.9، سيتوقّع النموذج الفئة الموجبة. إذا كانت القيمة الأولية 0.7، يتوقّع النموذج الفئة السلبية.

يؤثر اختيار حد التصنيف بشكل كبير في عدد الموجب الخاطئ والسالب الخاطئ.

لمزيد من المعلومات، يمكنك الاطّلاع على الحدود ومصفوفة الالتباس في "دورة مكثّفة عن تعلّم الآلة".

مصنِّف

مصطلح عام يشير إلى نموذج التصنيف.

مجموعة بيانات غير متوازنة الفئات

مجموعة بيانات خاصة بالتصنيف يختلف فيها إجمالي عدد التصنيفات لكل فئة بشكل كبير. على سبيل المثال، لنفترض أنّ لديك مجموعة بيانات تصنيف ثنائي مقسّمة إلى فئتَين على النحو التالي:

- مليون تصنيف سلبي

- 10 تصنيفات إيجابية

نسبة التصنيفات السلبية إلى الإيجابية هي 100,000 إلى 1، لذا هذه مجموعة بيانات غير متوازنة الفئات.

في المقابل، مجموعة البيانات التالية متوازنة الفئات لأنّ نسبة التصنيفات السلبية إلى التصنيفات الإيجابية قريبة نسبيًا من 1:

- 517 تصنيفًا سلبيًا

- 483 تصنيفًا إيجابيًا

يمكن أن تكون مجموعات البيانات المتعددة الفئات غير متوازنة الفئات أيضًا. على سبيل المثال، مجموعة بيانات التصنيف المتعدد الفئات التالية غير متوازنة الفئات أيضًا لأنّ إحدى التصنيفات تتضمّن أمثلة أكثر بكثير من التصنيفين الآخرين:

- مليون تصنيف من الفئة "أخضر"

- 200 تصنيف بالصف "أرجواني"

- 350 تصنيفًا بالصف "برتقالي"

يمكن أن يواجه تدريب مجموعات البيانات غير المتوازنة الفئات تحديات خاصة. راجِع مجموعات البيانات غير المتوازنة في "دورة مكثّفة عن تعلّم الآلة" للحصول على التفاصيل.

يمكنك الاطّلاع أيضًا على الإنتروبيا وفئة الأغلبية وفئة الأقلية.

القص

أسلوب للتعامل مع القيم الشاذة من خلال تنفيذ أحد الإجراءَين التاليَين أو كليهما:

- تخفيض قيم السمة التي تتجاوز الحد الأقصى إلى هذا الحد الأقصى

- زيادة قيم الميزات التي تقل عن الحد الأدنى إلى هذا الحد الأدنى

على سبيل المثال، لنفترض أنّ <0.5% من قيم ميزة معيّنة تقع خارج النطاق 40-60. في هذه الحالة، يمكنك إجراء ما يلي:

- يجب أن تكون جميع القيم التي تزيد عن 60 (الحدّ الأقصى) هي 60 بالضبط.

- يجب أن تكون جميع القيم الأقل من 40 (الحد الأدنى) هي 40 بالضبط.

يمكن أن تتسبّب القيم الشاذة في إتلاف النماذج، ما يؤدي أحيانًا إلى تجاوز الأوزان أثناء التدريب. يمكن أن تؤدي بعض القيم الشاذة أيضًا إلى إفساد مقاييس مثل الدقة بشكل كبير. القص هو أسلوب شائع للحد من الضرر.

تفرض عملية اقتطاع التدرّج أن تكون قيم التدرّج ضمن نطاق محدّد أثناء التدريب.

لمزيد من المعلومات، راجِع البيانات الرقمية: التسوية في "الدورة التدريبية المكثّفة حول تعلُّم الآلة".

Cloud TPU

أداة تسريع أجهزة متخصّصة مصمّمة لتسريع مهام تعلُّم الآلة على Google Cloud

التجميع

تجميع الأمثلة ذات الصلة، خاصةً أثناء التعلّم غير الموجَّه بعد تجميع كل الأمثلة، يمكن للمستخدم أن يقدّم بشكل اختياري معنى لكل مجموعة.

تتوفّر العديد من خوارزميات التجميع العنقودي. على سبيل المثال، تجمع خوارزمية k-means الأمثلة استنادًا إلى مدى قربها من نقطة مركزية، كما هو موضّح في الرسم البياني التالي:

يمكن بعد ذلك أن يراجع باحث بشري المجموعات ويصنّف المجموعة 1 على أنّها "أشجار قزمة" والمجموعة 2 على أنّها "أشجار كاملة الحجم".

كمثال آخر، لنفترض أنّ هناك خوارزمية تجميع عنقودي تستند إلى المسافة بين مثال ونقطة مركزية، كما هو موضّح أدناه:

يمكنك الاطّلاع على دورة التجميع لمزيد من المعلومات.

التكيّف المشترك

هي سلوك غير مرغوب فيه يحدث عندما تتوقّع الخلايا العصبية أنماطًا في بيانات التدريب من خلال الاعتماد بشكل حصري تقريبًا على نواتج خلايا عصبية أخرى معيّنة بدلاً من الاعتماد على سلوك الشبكة ككل. عندما لا تتوفّر الأنماط التي تؤدي إلى التكيّف المشترك في بيانات التحقّق، يؤدي التكيّف المشترك إلى الإفراط في التكيّف. تؤدي التسوية باستخدام التساقط إلى الحد من التكيّف المشترك، لأنّ التساقط يضمن عدم اعتماد الخلايا العصبية على خلايا عصبية أخرى معيّنة فقط.

الفلترة حسب الاهتمامات الجماعية

تقديم توقّعات بشأن اهتمامات مستخدم معيّن استنادًا إلى اهتمامات العديد من المستخدمين الآخرين يتم استخدام التصفية التعاونية غالبًا في أنظمة التوصية.

يمكنك الاطّلاع على الترشيح التعاوني في دورة "أنظمة الاقتراحات" للحصول على مزيد من المعلومات.

CommitmentBank (CB)

مجموعة بيانات لتقييم مدى إتقان نموذج لغوي كبير في تحديد ما إذا كان مؤلف مقطع نصي يعتقد بصحة عبارة مستهدَفة ضمن هذا المقطع. يحتوي كل إدخال في مجموعة البيانات على ما يلي:

- مقطع

- عبارة مستهدَفة ضمن هذه الفقرة

- قيمة منطقية تشير إلى ما إذا كان مؤلف المقطع يعتقد أنّ العبارة المستهدَفة

على سبيل المثال:

- المقطع: كم كان من الممتع سماع ضحكة أرتميس. إنّها طفلة جدّية للغاية. لم أكن أعرف أنّ لديها حس فكاهي.

- الجملة المستهدَفة: كانت تتمتّع بروح الدعابة

- قيمة منطقية: True، ما يعني أنّ المؤلف يعتقد أنّ الجملة المستهدَفة

CommitmentBank هو أحد مكوّنات مجموعة SuperGLUE.

طراز صغير الحجم

أي نموذج صغير مصمّم للعمل على أجهزة صغيرة ذات موارد حسابية محدودة على سبيل المثال، يمكن تشغيل النماذج المدمجة على الهواتف الجوّالة أو الأجهزة اللوحية أو الأنظمة المضمّنة.

الحوسبة

(اسم) الموارد الحاسوبية التي يستخدمها نموذج أو نظام، مثل قوة المعالجة والذاكرة والتخزين

اطّلِع على شرائح تسريع الأداء.

تغيُّر المفهوم

تغيير في العلاقة بين الميزات والتصنيف وبمرور الوقت، يؤدي تغيُّر المفهوم إلى خفض جودة النموذج.

أثناء التدريب، يتعرّف النموذج على العلاقة بين الميزات والتصنيفات في مجموعة التدريب. إذا كانت التصنيفات في مجموعة التدريب تمثّل العالم الحقيقي بشكل جيد، من المفترض أن يقدّم النموذج توقّعات جيدة في العالم الحقيقي. ومع ذلك، بسبب تغيُّر المفهوم، تميل توقّعات النموذج إلى التدهور بمرور الوقت.

على سبيل المثال، لنفترض أنّ هناك نموذج تصنيف ثنائي يتنبّأ بما إذا كان طراز سيارة معيّن "موفرًا للوقود" أم لا. أي أنّ الميزات يمكن أن تكون:

- وزن السيارة

- ضغط المحرّك

- نوع آليات نقل الطاقة

بينما يكون التصنيف إما:

- موفر للوقود

- غير فعّالة في استهلاك الوقود

ومع ذلك، فإنّ مفهوم "السيارة الموفّرة للوقود" يتغيّر باستمرار. فطراز السيارة الذي كان يُصنّف على أنّه موفر للوقود في عام 1994، سيُصنّف على الأرجح على أنّه غير موفر للوقود في عام 2024. النموذج الذي يعاني من تغيُّر المفهوم يميل إلى تقديم توقّعات أقل فائدة بمرور الوقت.

قارِن بينها وبين عدم الثبات.

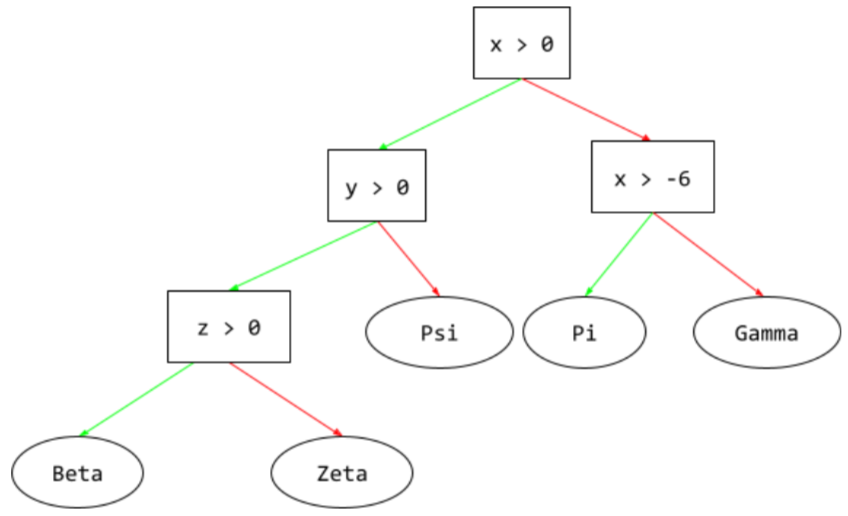

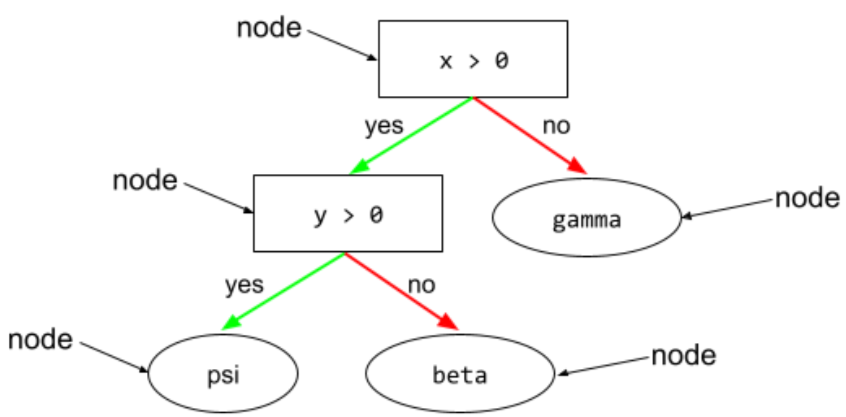

الشرط

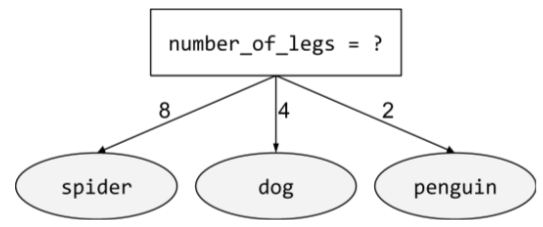

في شجرة القرارات، يشير ذلك المصطلح إلى أي عقدة تجري اختبارًا. على سبيل المثال، تحتوي شجرة القرارات التالية على شرطَين:

يُطلق على الشرط أيضًا اسم تقسيم أو اختبار.

حالة التباين مع ورقة الشجر

انظر أيضًا:

اطّلِع على أنواع الشروط في دورة "غابات القرارات" للحصول على مزيد من المعلومات.

التلفيق

مرادف لكلمة هلوسة

من المحتمل أنّ مصطلح "التلفيق" هو المصطلح الأكثر دقة من الناحية الفنية مقارنةً بمصطلح "الهلوسة". ومع ذلك، أصبحت الهلوسة شائعة أولاً.

الإعدادات

عملية تحديد قيم السمات الأولية المستخدَمة لتدريب نموذج، بما في ذلك:

- طبقات النموذج

- موقع البيانات

- المعلَمات الفائقة، مثل:

في مشاريع تعلُّم الآلة، يمكن إجراء عملية الإعداد من خلال ملف إعداد خاص أو باستخدام مكتبات الإعداد، مثل ما يلي:

الانحياز التأكيدي

الميل إلى البحث عن المعلومات وتفسيرها وتفضيلها وتذكّرها بطريقة تؤكد صحة المعتقدات أو الفرضيات الموجودة مسبقًا قد يجمع مطوّرو تعلُّم الآلة البيانات أو يصنّفونها عن غير قصد بطرق تؤثّر في نتيجة تدعم معتقداتهم الحالية. التحيز التأكيدي هو شكل من أشكال التحيز الضمني.

التحيز لدى المجرب هو شكل من أشكال التحيز التأكيدي، حيث يواصل المجرب تدريب النماذج إلى أن يتم تأكيد فرضية موجودة مسبقًا.

مصفوفة نجاح التوقعات

جدول NxN يلخّص عدد التوقّعات الصحيحة والخاطئة التي قدّمها نموذج التصنيف. على سبيل المثال، إليك مصفوفة الالتباس التالية الخاصة بنموذج التصنيف الثنائي:

| ورم (متوقّع) | غير ورم (متوقّع) | |

|---|---|---|

| ورم (معلومات فعلية) | 18 (TP) | 1 (FN) |

| غير ورمي (معلومات فعلية) | 6 (FP) | 452 (TN) |

تعرض مصفوفة الالتباس السابقة ما يلي:

- من بين 19 توقّعًا كانت فيها الحقيقة الأساسية هي "ورم"، صنّف النموذج 18 منها بشكل صحيح وصنّف 1 منها بشكل غير صحيح.

- من بين 458 توقّعًا كانت الحقيقة الأساسية فيها هي "غير ورمي"، صنّف النموذج 452 منها بشكل صحيح و6 منها بشكل غير صحيح.

يمكن أن تساعدك مصفوفة الالتباس في تصنيف متعدد الفئات في تحديد أنماط الأخطاء. على سبيل المثال، لنفترض مصفوفة الالتباس التالية لنموذج تصنيف متعدد الفئات يتضمّن 3 فئات ويصنّف ثلاثة أنواع مختلفة من زهور السوسن (Virginica وVersicolor وSetosa). عندما كانت الحقيقة الأساسية هي Virginica، توضّح مصفوفة الالتباس أنّ النموذج كان أكثر عرضة للتنبؤ بشكل خاطئ بأنّها Versicolor بدلاً من Setosa:

| Setosa (متوقّع) | Versicolor (متوقّعة) | Virginica (متوقّع) | |

|---|---|---|---|

| Setosa (المعلومات الفعلية) | 88 | 12 | 0 |

| Versicolor (المعلومات الفعلية) | 6 | 141 | 7 |

| Virginica (المعلومات الفعلية) | 2 | 27 | 109 |

كمثال آخر، يمكن أن تكشف مصفوفة الالتباس أنّ نموذجًا تم تدريبه على التعرّف على الأرقام المكتوبة بخط اليد يميل إلى توقّع الرقم 9 بدلاً من 4، أو توقّع الرقم 1 بدلاً من 7.

تحتوي مصفوفات الالتباس على معلومات كافية لحساب مجموعة متنوعة من مقاييس الأداء، بما في ذلك الدقة والاستدعاء.

تحليل الدوائر الانتخابية

تقسيم الجملة إلى بنى نحوية أصغر ("مكوّنات") يمكن لجزء لاحق من نظام تعلُّم الآلة، مثل نموذج فهم اللغات الطبيعية، تحليل المكوّنات بسهولة أكبر من الجملة الأصلية. على سبيل المثال، فكِّر في الجملة التالية:

تبنّى صديقي قطتين.

يمكن أن يقسّم محلّل البنية هذه الجملة إلى المكوّنين التاليين:

- صديقي هي عبارة اسمية.

- تبنّيتُ قطتَين هي عبارة فعلية.

ويمكن تقسيم هذه المكوّنات إلى مكوّنات أصغر. على سبيل المثال، عبارة الفعل

تبنّيتُ قطتين

يمكن تقسيمها إلى:

- adopted هي فعل.

- قطتان هي عبارة اسمية أخرى.

تضمين اللغة حسب السياق

تضمين يقترب من "فهم" الكلمات والعبارات بطرق يفهمها المتحدثون بطلاقة. يمكن أن تفهم عمليات التضمين المستندة إلى السياق التركيب النحوي والدلالات والسياق المعقّد.

على سبيل المثال، ضع في اعتبارك تضمينات الكلمة الإنجليزية cow. يمكن أن تمثّل عمليات التضمين القديمة، مثل word2vec، الكلمات الإنجليزية بطريقة تجعل المسافة في مساحة التضمين بين بقرة وثور مشابهة للمسافة بين نعجة (أنثى الخروف) وكبش (ذكر الخروف) أو بين أنثى وذكر. يمكن أن تتجاوز تضمينات اللغة المستندة إلى السياق ذلك من خلال إدراك أنّ المتحدثين باللغة الإنجليزية يستخدمون أحيانًا كلمة بقرة بشكل غير رسمي للإشارة إلى البقرة أو الثور.

قدرة الاستيعاب

عدد الرموز المميزة التي يمكن للنموذج معالجتها في طلب معيّن كلما كانت قدرة الاستيعاب أكبر، زادت المعلومات التي يمكن للنموذج استخدامها لتقديم ردود متسقة وذات صلة بالطلب.

خاصية مستمرة

ميزة ذات فاصلة عشرية عائمة مع نطاق لا نهائي من القيم المحتملة، مثل درجة الحرارة أو الوزن

يجب التمييز بينها وبين الخاصية المحدّدة القيم.

عينة عشوائية

استخدام مجموعة بيانات لم يتم جمعها بشكل علمي لإجراء تجارب سريعة في وقت لاحق، من الضروري التبديل إلى مجموعة بيانات تم جمعها بشكل علمي.

التقارب

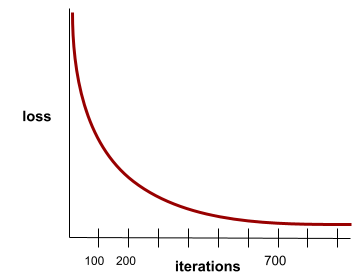

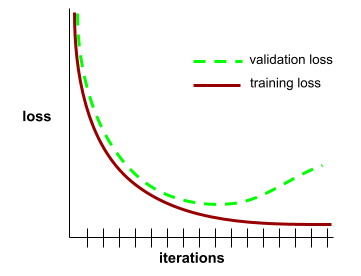

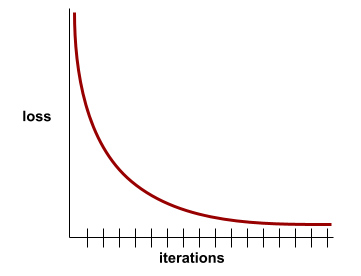

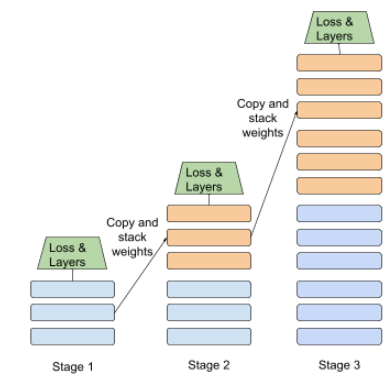

هي الحالة التي يتم الوصول إليها عندما تتغير قيم الخسارة بشكل طفيف جدًا أو لا تتغير على الإطلاق مع كل تكرار. على سبيل المثال، يشير منحنى الخسارة التالي إلى التقارب عند حوالي 700 تكرار:

يتقارب النموذج عندما لا يؤدي التدريب الإضافي إلى تحسينه.

في التعلم العميق، تبقى قيم الخسارة ثابتة أحيانًا أو قريبة من ذلك في العديد من التكرارات قبل أن تنخفض أخيرًا. خلال فترة طويلة من قيم الخسارة الثابتة، قد تشعر مؤقتًا بأنّ هناك تقاربًا خاطئًا.

اطّلِع أيضًا على الإيقاف المبكر.

لمزيد من المعلومات، يُرجى الاطّلاع على تقارب النماذج ومنحنيات الخسارة في "دورة تدريبية مكثّفة حول تعلُّم الآلة".

البرمجة الحوارية

حوار متكرّر بينك وبين نموذج ذكاء اصطناعي توليدي بغرض إنشاء برامج تُصدر طلبًا يصف بعض البرامج. بعد ذلك، يستخدم النموذج هذا الوصف لإنشاء الرمز. بعد ذلك، تقدّم طلبًا جديدًا لمعالجة العيوب في الطلب السابق أو في الرمز البرمجي الذي تم إنشاؤه، وينشئ النموذج رمزًا برمجيًا معدَّلاً. ويستمرّان في تبادل الرسائل إلى أن يصبح البرنامج الذي تم إنشاؤه جيدًا بما يكفي.

البرمجة الوصفية هي في الأساس المعنى الأصلي للبرمجة الوصفية.

يختلف عن الترميز التحديدي.

دالّة محدّبة

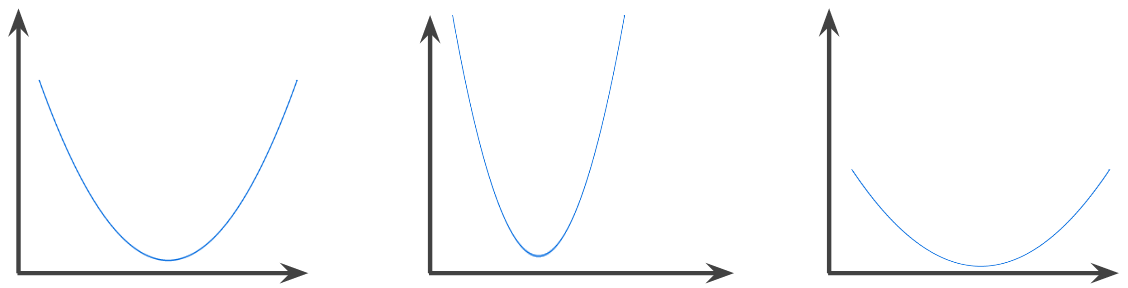

الدالة التي تكون فيها المنطقة الواقعة فوق الرسم البياني للدالة مجموعة محدّبة تتخذ الدالة المحدبة النموذجية شكلًا يشبه الحرف U. على سبيل المثال، جميع الدوال التالية هي دوال محدّبة:

في المقابل، الدالة التالية ليست محدّبة. لاحظ كيف أنّ المنطقة أعلاه الرسم البياني ليست مجموعة محدّبة:

الدالة المحدّبة تمامًا لها نقطة حد أدنى محلّي واحدة فقط، وهي أيضًا نقطة الحد الأدنى العام. الدوال الكلاسيكية على شكل حرف U هي دوال محدّبة تمامًا. ومع ذلك، بعض الدوال المحدّبة (مثل الخطوط المستقيمة) ليست على شكل حرف U.

يمكنك الاطّلاع على التقارب والدوال المحدّبة في "دورة تدريبية مكثّفة حول تعلُّم الآلة" للحصول على مزيد من المعلومات.

تحسين الدالّة المحدّبة

عملية استخدام تقنيات رياضية، مثل النزول التدريجي، للعثور على الحد الأدنى لدالة محدّبة تركّز الكثير من الأبحاث في مجال تعلّم الآلة على صياغة مشاكل مختلفة على أنّها مشاكل تحسين محدّبة وعلى حلّ هذه المشاكل بشكل أكثر فعالية.

للاطّلاع على التفاصيل الكاملة، يُرجى الرجوع إلى كتاب Boyd and Vandenberghe، Convex Optimization.

مجموعة محدّبة

مجموعة فرعية من الفضاء الإقليدي، بحيث يبقى الخط المرسوم بين أي نقطتين في المجموعة الفرعية ضمن المجموعة الفرعية تمامًا. على سبيل المثال، الشكلان التاليان هما مجموعتان محدّبتان:

في المقابل، الشكلان التاليان ليسا مجموعتَين محدّبتَين:

الالتفاف

في الرياضيات، وبشكل عام، هي مزيج من دالتين. في التعلّم الآلي، يجمع الالتفاف بين فلتر الالتفاف ومصفوفة الإدخال من أجل تدريب الأوزان.

في سياق تعلُّم الآلة، يشير مصطلح "الالتفاف" غالبًا إلى عملية الالتفاف أو طبقة الالتفاف.

بدون الالتفافات، يجب أن تتعلّم خوارزمية تعلُّم الآلة وزنًا منفصلاً لكل خلية في موتر كبير. على سبيل المثال، إذا تم تدريب خوارزمية تعلُّم آلي على صور بدقة 2000 × 2000، سيتم إجبارها على العثور على 4 ملايين وزن منفصل. بفضل الالتفافات، لا يحتاج خوارزمية تعلُّم الآلة سوى إلى العثور على أوزان لكل خلية في فلتر الالتفاف، ما يقلّل بشكل كبير من الذاكرة اللازمة لتدريب النموذج. عند تطبيق فلتر التفافي، يتم ببساطة تكراره على مستوى الخلايا بحيث يتم ضرب كل خلية في الفلتر.

فلتر التفافي

أحد العنصرَين في عملية التفاف (العنصر الآخر هو شريحة من مصفوفة إدخال). الفلتر الالتفافي هو مصفوفة لها الترتيب نفسه مثل مصفوفة الإدخال، ولكن بشكل أصغر. على سبيل المثال، عند توفّر مصفوفة إدخال 28x28، يمكن أن يكون الفلتر أي مصفوفة ثنائية الأبعاد أصغر من 28x28.

في معالجة الصور، يتم عادةً ضبط جميع الخلايا في فلتر التفاف على نمط ثابت من الآحاد والأصفار. في تعلُّم الآلة، يتم عادةً إدخال أرقام عشوائية إلى فلاتر الالتفاف، ثم تدريب الشبكة على القيم المثالية.

الطبقة الالتفافية

طبقة من شبكة عصبية عميقة يتم فيها تمرير فلتر التفافي على طول مصفوفة إدخال. على سبيل المثال، إليك فلتر التفاف بحجم 3x3:

![مصفوفة 3x3 بالقيم التالية: [[0,1,0], [1,0,1], [0,1,0]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalFilter33.svg?authuser=19&hl=ar)

تعرض الصورة المتحركة التالية طبقة التفافية تتألف من 9 عمليات التفافية تتضمّن مصفوفة الإدخال 5x5. لاحظ أنّ كل عملية التفاف تعمل على شريحة مختلفة من مصفوفة الإدخال بحجم 3×3. تتألف مصفوفة 3x3 الناتجة (على اليسار) من نتائج عمليات الالتفاف التسع:

![صورة متحرّكة تعرض مصفوفتَين. المصفوفة الأولى هي المصفوفة 5x5: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].

المصفوفة الثانية هي المصفوفة 3x3:

[[181,303,618], [115,338,605], [169,351,560]].

يتم احتساب المصفوفة الثانية من خلال تطبيق فلتر التفاف

[[0, 1, 0], [1, 0, 1], [0, 1, 0]] على

مجموعات فرعية مختلفة بحجم 3x3 من المصفوفة 5x5.](https://developers.google.cn/static/machine-learning/glossary/images/AnimatedConvolution.gif?authuser=19&hl=ar)

شبكة عصبونية التفافية

شبكة عصبية تتضمّن طبقة واحدة على الأقل التفافية. تتألف الشبكة العصبية الالتفافية النموذجية من بعض المجموعات من الطبقات التالية:

حققت الشبكات العصبونية الالتفافية نجاحًا كبيرًا في أنواع معيّنة من المشاكل، مثل التعرّف على الصور.

عملية الالتفاف

العملية الرياضية التالية المكوَّنة من خطوتَين:

- الضرب حسب العناصر بين فلتر الالتفاف وشريحة من مصفوفة الإدخال (يحتوي جزء مصفوفة الإدخال على الترتيب والحجم نفسيهما كفلتر الالتفاف).

- مجموع كل القيم في مصفوفة المنتجات الناتجة

على سبيل المثال، ضع في اعتبارك مصفوفة الإدخال التالية بحجم 5x5:

![المصفوفة 5x5: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerInputMatrix.svg?authuser=19&hl=ar)

لنفترض الآن فلتر التفافي 2x2 التالي:

![المصفوفة 2x2: [[1, 0], [0, 1]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerFilter.svg?authuser=19&hl=ar)

تتضمّن كل عملية التفاف شريحة واحدة بحجم 2×2 من مصفوفة الإدخال. على سبيل المثال، لنفترض أنّنا نستخدم شريحة 2x2 في أعلى يسار مصفوفة الإدخال. وبالتالي، تبدو عملية الالتفاف على هذه الشريحة كما يلي:

![تطبيق فلتر التفاف [[1, 0], [0, 1]] على القسم 2x2 في أعلى يمين مصفوفة الإدخال، وهو [[128,97], [35,22]].

يترك الفلتر التفافي القيمتين 128 و22 كما هما، ولكنّه يضبط القيمتين 97 و35 على صفر. وبالتالي، تؤدي عملية الالتفاف إلى القيمة 150 (128+22).](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerOperation.svg?authuser=19&hl=ar)

تتألف الطبقة الالتفافية من سلسلة من العمليات الالتفافية، وتعمل كل عملية على شريحة مختلفة من مصفوفة الإدخال.

COPA

اختصار اختيار البدائل المعقولة

التكلفة

مرادف لكلمة خسارة

التدريب المشترك

أسلوب التعلّم شبه الموجّه مفيد بشكل خاص عندما تكون جميع الشروط التالية صحيحة:

- نسبة الأمثلة غير المصنَّفة إلى الأمثلة المصنَّفة في مجموعة البيانات مرتفعة.

- هذه مشكلة تصنيف (ثنائي أو متعدد الفئات).

- تحتوي مجموعة البيانات على مجموعتَين مختلفتَين من السمات التنبؤية المستقلة عن بعضها البعض والمتكاملة.

تعمل عملية التدريب المشترك بشكل أساسي على تضخيم الإشارات المستقلة وتحويلها إلى إشارة أقوى. على سبيل المثال، لنفترض أنّ هناك نموذج تصنيف يصنّف السيارات المستعملة الفردية إلى جيدة أو سيئة. قد تركّز إحدى مجموعات الميزات التوقعية على الخصائص المجمّعة، مثل سنة تصنيع السيارة وعلامتها التجارية وطرازها، وقد تركّز مجموعة أخرى من الميزات التوقعية على سجل القيادة الخاص بالمالك السابق وسجل صيانة السيارة.

إنّ الورقة البحثية الأساسية حول التدريب المشترك هي Combining Labeled and Unlabeled Data with Co-Training من تأليف Blum وMitchell.

العدالة الشرطية

مقياس العدالة الذي يتحقّق مما إذا كان نموذج التصنيف يعطي النتيجة نفسها لشخص ما كما يعطيها لشخص آخر مطابق للأول، باستثناء ما يتعلق بواحدة أو أكثر من السمات الحسّاسة. يُعدّ تقييم نموذج التصنيف من حيث الإنصاف الواقعي الافتراضي إحدى الطرق للكشف عن المصادر المحتملة للانحياز في النموذج.

يمكنك الاطّلاع على أيّ مما يلي للحصول على مزيد من المعلومات:

- الإنصاف: الإنصاف الواقعي الافتراضي في "دورة مكثّفة عن تعلُّم الآلة"

- When Worlds Collide: Integrating Different Counterfactual Assumptions in Fairness

انحياز في التغطية

اطّلِع على الانحياز في الاختيار.

عبارات مبهمة

جملة أو عبارة ذات معنى غامض تُشكّل أخطاء "الازدهار المفاجئ" مشكلة كبيرة في فهم اللغة الطبيعية. على سبيل المثال، العنوان Red Tape Holds Up Skyscraper هو مثال على crash blossom لأنّ نموذج فهم اللغة الطبيعية يمكن أن يفسّر العنوان حرفيًا أو مجازيًا.

ناقد

مرادف شبكة Q العميقة

الإنتروبيا المتقاطعة

تعميم فقدان اللوغاريتم على مشاكل التصنيف المتعدد الفئات يقيس الانتروبيا المتقاطعة الفرق بين توزيعَين احتماليَين. يمكنك الاطّلاع أيضًا على الارتباك.

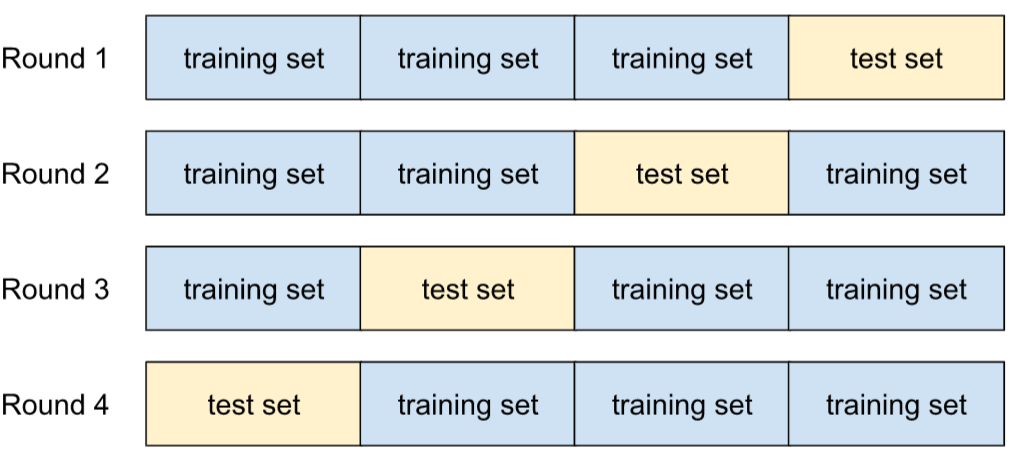

التحقّق المتقاطع

آلية لتقدير مدى قدرة النموذج على التعميم على البيانات الجديدة من خلال اختبار النموذج على مجموعة فرعية واحدة أو أكثر من البيانات غير المتداخلة التي تم حجبها من مجموعة التدريب

دالة التوزيع التراكمي (CDF)

دالة تحدّد عدد المرّات التي تكون فيها العيّنات أقل من قيمة مستهدَفة أو مساوية لها. على سبيل المثال، لنفترض أنّ هناك توزيعًا طبيعيًا للقيم المستمرة. يخبرك التوزيع التراكمي بأنّ% 50 تقريبًا من العيّنات يجب أن تكون أقل من أو تساوي المتوسط، وأنّ% 84 تقريبًا من العيّنات يجب أن تكون أقل من أو تساوي الانحراف المعياري الواحد فوق المتوسط.

D

تحليل البيانات

فهم البيانات من خلال النظر في العيّنات والقياس والعرض المرئي يمكن أن يكون تحليل البيانات مفيدًا بشكل خاص عند تلقّي مجموعة بيانات لأول مرة، قبل إنشاء النموذج الأول. وهي ضرورية أيضًا لفهم التجارب وتصحيح الأخطاء في النظام.

توسيع نطاق البيانات

زيادة نطاق وعدد أمثلة التدريب بشكل مصطنع من خلال تحويل الأمثلة الحالية لإنشاء أمثلة إضافية على سبيل المثال، لنفترض أنّ الصور هي إحدى الميزات، ولكن مجموعة البيانات لا تحتوي على أمثلة كافية من الصور ليتعلّم النموذج الارتباطات المفيدة. من المفترض أن تضيف عددًا كافيًا من الصور المصنَّفة إلى مجموعة البيانات كي يتم تدريب النموذج بشكل صحيح. إذا لم يكن ذلك ممكنًا، يمكن أن تؤدي عملية زيادة البيانات إلى تدوير كل صورة وتمديدها وعكسها لإنتاج العديد من الصيغ من الصورة الأصلية، ما قد يؤدي إلى توفير بيانات مصنّفة كافية لإجراء تدريب ممتاز.

DataFrame

نوع بيانات pandas شائع لتمثيل مجموعات البيانات في الذاكرة

يشبه DataFrame الجدول أو جدول البيانات. يحتوي كل عمود في DataFrame على اسم (عنوان)، ويتم تحديد كل صف برقم فريد.

يتم تنظيم كل عمود في إطار البيانات على شكل مصفوفة ثنائية الأبعاد، إلا أنّه يمكن تعيين نوع بيانات خاص لكل عمود.

يمكنك أيضًا الاطّلاع على صفحة pandas.DataFrame المرجعية الرسمية.

التوازي على مستوى البيانات

طريقة لتوسيع نطاق التدريب أو الاستدلال عن طريق تكرار نموذج كامل على أجهزة متعددة، ثم تمرير مجموعة فرعية من البيانات المدخلة إلى كل جهاز. يمكن أن تتيح موازاة البيانات التدريب والاستدلال على أحجام دفعات كبيرة جدًا، ولكنها تتطلّب أن يكون النموذج صغيرًا بما يكفي ليتناسب مع جميع الأجهزة.

تؤدي موازاة البيانات عادةً إلى تسريع التدريب والاستنتاج.

يمكنك أيضًا الاطّلاع على التوازي بين النماذج.

Dataset API (tf.data)

واجهة برمجة تطبيقات TensorFlow عالية المستوى لقراءة البيانات وتحويلها إلى نموذج تتطلّبه خوارزمية تعلُّم الآلة

يمثّل كائن tf.data.Dataset تسلسلاً من العناصر، يحتوي كل عنصر فيه على Tensor واحد أو أكثر. يتيح عنصر tf.data.Iterator الوصول إلى عناصر Dataset.

مجموعة البيانات

مجموعة من البيانات الأولية، يتم تنظيمها عادةً (وليس حصريًا) بأحد التنسيقات التالية:

- جدول بيانات

- ملف بتنسيق CSV (قيم مفصولة بفواصل)

فاصل بين الفئات

وهي الفاصل بين الفئات التي تعلّمها نموذج في مشاكل التصنيف الثنائي أو مشاكل التصنيف المتعدّد الفئات. على سبيل المثال، في الصورة التالية التي تمثّل مشكلة تصنيف ثنائي، الحد الفاصل هو الحد بين الفئة البرتقالية والفئة الزرقاء:

غابة القرارات

نموذج تم إنشاؤه من عدة أشجار قرارات. تُجري غابة القرارات عملية توقّع من خلال تجميع التوقّعات التي تقدّمها أشجار القرارات. تشمل الأنواع الشائعة من غابات القرارات الغابات العشوائية وأشجار التدرّج المعزّز.

يمكنك الاطّلاع على قسم أشجار القرارات العشوائية في دورة "أشجار القرارات العشوائية" للحصول على مزيد من المعلومات.

حدّ اتّخاذ القرار

مرادف لعتبة التصنيف

شجرة القرارات

نموذج تعلّم بإشراف يتألف من مجموعة من الشروط والعُقد الطرفية منظَّمة بشكل هرمي. على سبيل المثال، ما يلي هو شجرة قرارات:

برنامج فك الترميز

بشكل عام، أي نظام تعلُّم آلي يحوّل من تمثيل معالَج أو كثيف أو داخلي إلى تمثيل أكثر أولية أو تفرّقًا أو خارجية.

غالبًا ما تكون أدوات فك الترميز جزءًا من نموذج أكبر، حيث يتم دمجها بشكل متكرر مع أداة ترميز.

في مهام التسلسل إلى التسلسل، يبدأ برنامج الترميز بالحالة الداخلية التي أنشأها برنامج الترميز ليتوقّع التسلسل التالي.

راجِع المحوّل للتعرّف على تعريف برنامج فك الترميز ضمن بنية المحوّل.

لمزيد من المعلومات، يمكنك الاطّلاع على النماذج اللغوية الكبيرة في "دورة مكثّفة عن تعلّم الآلة".

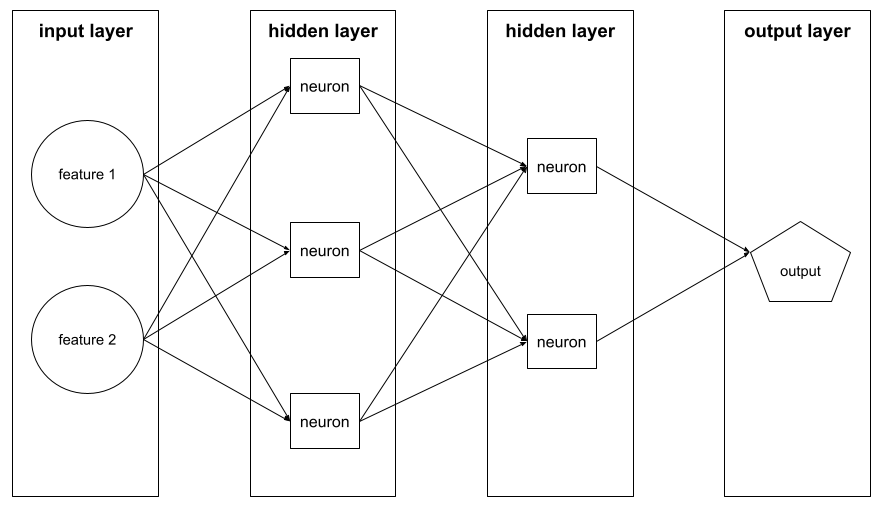

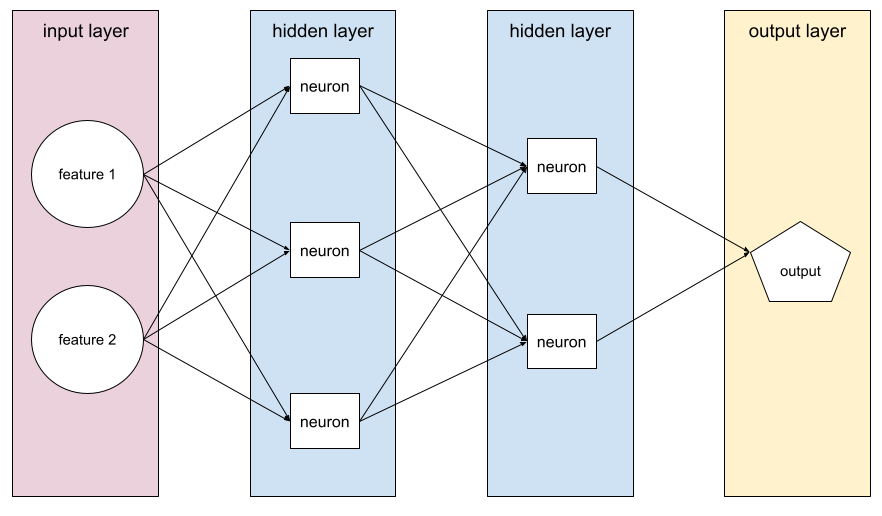

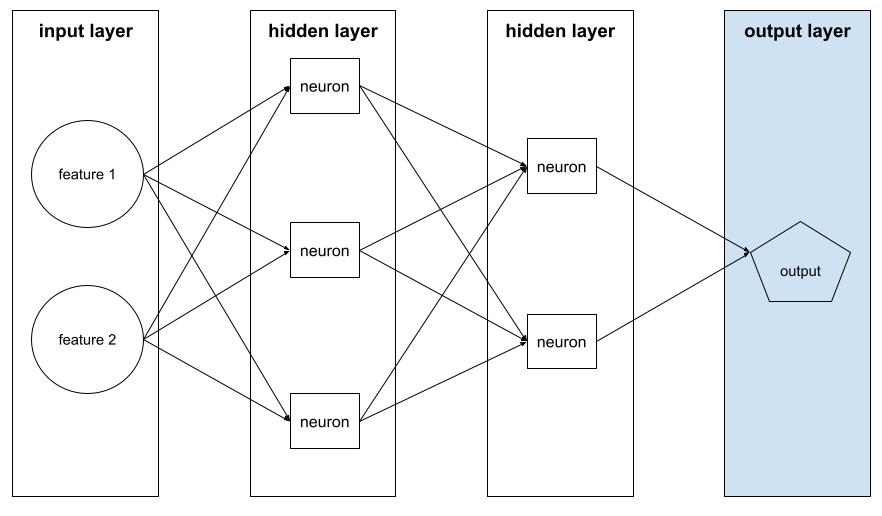

نموذج عميق

شبكة عصبية تحتوي على أكثر من طبقة مخفية

يُطلق على النموذج العميق أيضًا اسم شبكة عصبية عميقة.

يختلف عن النموذج الواسع.

شبكة عصبية عميقة

مرادف للنموذج العميق

شبكة Q العميقة (DQN)

في تعلُّم Q، يتم استخدام شبكة عصبية عميقة لتوقُّع دالات Q.

Critic هو مرادف لـ Deep Q-Network.

التكافؤ بين الجنسين

مقياس العدالة الذي يتم استيفاؤه إذا كانت نتائج تصنيف النموذج لا تعتمد على سمة حساسة معيّنة.

على سبيل المثال، إذا كان كل من سكان ليليبوت وبروبدينغناغ يتقدّمون بطلبات إلى جامعة غلوبدوبدريب، يتم تحقيق التكافؤ الديموغرافي إذا كانت النسبة المئوية للطلاب المقبولين من ليليبوت هي نفسها النسبة المئوية للطلاب المقبولين من بروبدينغناغ، بغض النظر عمّا إذا كانت إحدى المجموعتين أكثر تأهيلاً من الأخرى في المتوسط.

يختلف هذا المقياس عن التكافؤ في الاحتمالات وتكافؤ الفرص، اللذين يسمحان بأن تعتمد نتائج التصنيف بشكل إجمالي على السمات الحسّاسة، ولكنّهما لا يسمحان بأن تعتمد نتائج التصنيف لبعض تصنيفات الحقيقة الأساسية المحدّدة على السمات الحسّاسة. يمكنك الاطّلاع على "مكافحة التمييز من خلال تعلُّم الآلة بشكل أكثر ذكاءً" للاطّلاع على رسم بياني يوضّح المفاضلة بين الخيارات عند تحسين التكافؤ الديمغرافي.

يمكنك الاطّلاع على الإنصاف: التكافؤ الديمغرافي في "دورة مكثّفة عن تعلّم الآلة" للحصول على مزيد من المعلومات.

إزالة التشويش

أسلوب شائع في التعلّم الذاتي يتم فيه:

تتيح إزالة التشويش التعلّم من أمثلة غير مصنَّفة. تعمل مجموعة البيانات الأصلية كهدف أو تصنيف، وتعمل البيانات المشوّشة كمدخل.

تستخدم بعض نماذج اللغة المقنّعة أسلوب إزالة التشويش على النحو التالي:

- تتم إضافة تشويش بشكل اصطناعي إلى جملة غير مصنّفة من خلال إخفاء بعض الرموز المميزة.

- يحاول النموذج توقّع الرموز المميزة الأصلية.

خاصية كثيفة

ميزة تكون معظم قيمها أو كلها غير صفرية، وعادةً ما تكون Tensor من قيم الفاصلة العائمة. على سبيل المثال، يكون Tensor التالي المكوّن من 10 عناصر كثيفًا لأنّ 9 من قيمه غير صفرية:

| 8 | 3 | 7 | 5 | 2 | 4 | 0 | 4 | 9 | 6 |

يختلف عن الخاصية المتناثرة.

طبقة كثيفة

مرادف طبقة مكتملة الاتصال

العمق

مجموع ما يلي في شبكة عصبونية:

- عدد الطبقات المخفية

- عدد الطبقات النهائية، وهو عادةً 1

- عدد أي طبقات تضمين

على سبيل المثال، تحتوي الشبكة العصبية التي تتضمّن خمس طبقات مخفية وطبقة إخراج واحدة على عمق يبلغ 6.

يُرجى العِلم أنّ طبقة الإدخال لا تؤثر في العمق.

شبكة عصبونية التفافية قابلة للفصل حسب العمق (sepCNN)

بنية شبكة عصبية التفافية تستند إلى Inception، ولكن يتم فيها استبدال وحدات Inception بعمليات التفاف منفصلة حسب العمق. يُعرف أيضًا باسم Xception.

تُقسّم عملية الالتفاف المنفصلة حسب العمق (المعروفة أيضًا باسم الالتفاف المنفصل) عملية الالتفاف الثلاثية الأبعاد العادية إلى عمليتَي التفاف منفصلتَين أكثر فعالية من الناحية الحسابية: أولاً، عملية التفاف حسب العمق بعمق 1 (n ✕ n ✕ 1)، ثم عملية التفاف نقطية بطول وعرض 1 (1 ✕ 1 ✕ n).

لمزيد من المعلومات، يُرجى الاطّلاع على Xception: Deep Learning with Depthwise Separable Convolutions.

تصنيف مشتق

مرادف للتصنيف التقريبي

جهاز

مصطلح محمل بشكل زائد مع تعريفَين محتملَين:

- فئة من الأجهزة التي يمكنها تشغيل جلسة TensorFlow، بما في ذلك وحدات المعالجة المركزية (CPU) ووحدات معالجة الرسومات (GPU) ووحدات معالجة الموتّرات (TPU)

- عند تدريب نموذج تعلُّم آلي على شرائح تسريع (وحدات معالجة الرسومات أو وحدات معالجة الموتّرات)، يكون هذا الجزء من النظام هو المسؤول عن معالجة الموتّرات وعمليات التضمين. يعمل الجهاز باستخدام شرائح تسريع. في المقابل، يعمل المضيف عادةً على وحدة معالجة مركزية.

الخصوصية التفاضلية

في تعلُّم الآلة، يشير هذا المصطلح إلى أسلوب لإخفاء الهوية بهدف حماية أي بيانات حساسة (مثل المعلومات الشخصية لأحد الأفراد) مضمّنة في مجموعة التدريب الخاصة بأحد النماذج من التعرّض. يضمن هذا النهج ألا يتعلّم النموذج أو يتذكّر الكثير من المعلومات حول فرد معيّن. ويتم ذلك من خلال أخذ عيّنات وإضافة تشويش أثناء تدريب النموذج لإخفاء نقاط البيانات الفردية، ما يقلّل من خطر الكشف عن بيانات التدريب الحسّاسة.

يتم استخدام الخصوصية التفاضلية أيضًا خارج نطاق تعلُّم الآلة. على سبيل المثال، يستخدم علماء البيانات أحيانًا الخصوصية التفاضلية لحماية خصوصية الأفراد عند احتساب إحصاءات استخدام المنتج لمختلف الخصائص الديمغرافية.

تخفيض عدد السمات

تقليل عدد السمات المستخدَمة لتمثيل ميزة معيّنة في متّجه الميزات، عادةً من خلال التحويل إلى متّجه تضمين

الأبعاد

مصطلح محمل بشكل زائد يتضمّن أيًا من التعريفات التالية:

عدد مستويات الإحداثيات في Tensor على سبيل المثال:

- المقياس العددي له صفر من الأبعاد، على سبيل المثال،

["Hello"]. - يتضمّن المتّجه سمة واحدة، مثل

[3, 5, 7, 11]. - تحتوي المصفوفة على بُعدَين، مثل

[[2, 4, 18], [5, 7, 14]]. يمكنك تحديد خلية معيّنة بشكل فريد في متّجه أحادي البُعد باستخدام إحداثي واحد، ولكنك تحتاج إلى إحداثيَين لتحديد خلية معيّنة بشكل فريد في مصفوفة ثنائية الأبعاد.

- المقياس العددي له صفر من الأبعاد، على سبيل المثال،

عدد الإدخالات في متّجه الميزات

عدد العناصر في طبقة التضمين

توجيه الطلبات مباشرةً

مرادف للتلقين بلا أمثلة

خاصية محدّدة القيم

الميزة التي تتضمّن مجموعة محدودة من القيم المحتملة على سبيل المثال، السمة التي لا يمكن أن تتضمّن قيمًا سوى حيوان أو نبات أو معدن هي سمة منفصلة (أو فئوية).

يختلف عن الخاصية المستمرة.

النموذج التمييزي

نموذج يتوقّع تصنيفات من مجموعة تتضمّن ميزة واحدة أو أكثر. بشكل أكثر رسمية، تحدّد النماذج التمييزية الاحتمالية الشرطية للناتج بالنظر إلى الميزات والأوزان، أي:

p(output | features, weights)

على سبيل المثال، النموذج الذي يتنبأ بما إذا كانت الرسالة الإلكترونية غير مرغوب فيها من الميزات والأوزان هو نموذج تمييزي.

إنّ الغالبية العظمى من نماذج التعلّم الخاضع للإشراف، بما في ذلك نماذج التصنيف والانحدار، هي نماذج تمييزية.

يُرجى الرجوع إلى النموذج التوليدي.

المُميِّز

نظام يحدّد ما إذا كانت الأمثلة حقيقية أو مزيفة.

أو، هي النظام الفرعي ضمن شبكة معادية توليدية يحدّد ما إذا كانت الأمثلة التي أنشأها المولّد حقيقية أو مزيفة.

راجِع المميّز في دورة GAN التدريبية للحصول على مزيد من المعلومات.

التأثير غير المتكافئ

اتّخاذ قرارات بشأن أشخاص تؤثّر بشكل غير متناسب في مجموعات فرعية مختلفة من السكان ويشير ذلك عادةً إلى الحالات التي تؤدي فيها عملية اتخاذ القرارات المستندة إلى الخوارزميات إلى إلحاق الضرر ببعض المجموعات الفرعية أو تحقيق فائدة لها أكثر من غيرها.

على سبيل المثال، لنفترض أنّ خوارزمية تحدّد أهلية شخص من ليليبوت للحصول على قرض لشراء منزل صغير، ومن المرجّح أن تصنّفه على أنّه "غير مؤهّل" إذا كان عنوانه البريدي يتضمّن رمزًا بريديًا معيّنًا. إذا كان من المرجّح أن يكون لدى سكان ليليبوت الذين يستخدمون تنسيق Big-Endian عناوين بريدية تتضمّن هذا الرمز البريدي أكثر من سكان ليليبوت الذين يستخدمون تنسيق Little-Endian، قد تؤدي هذه الخوارزمية إلى تأثير متفاوت.

يختلف ذلك عن المعاملة غير المتكافئة، التي تركّز على التفاوتات الناتجة عندما تكون خصائص المجموعة الفرعية مدخلات صريحة في عملية اتخاذ القرار المستندة إلى الخوارزميات.

المعاملة غير المتكافئة

إدخال السمات الحسّاسة الخاصة بالأشخاص في عملية اتخاذ القرار المستندة إلى الخوارزميات، ما يؤدي إلى معاملة المجموعات الفرعية المختلفة من الأشخاص بشكل مختلف

على سبيل المثال، لنفترض أنّ هناك خوارزمية تحدّد أهلية سكان ليليبوت للحصول على قرض لشراء منزل صغير استنادًا إلى البيانات التي يقدّمونها في طلب القرض. إذا كانت الخوارزمية تستخدم انتماء شخص من ليليبوت إلى Big-Endian أو Little-Endian كمدخل، فإنّها تمارس معاملة مختلفة على هذا الأساس.

يختلف ذلك عن التأثير غير المتكافئ الذي يركّز على التفاوتات في التأثيرات المجتمعية للقرارات الخوارزمية على المجموعات الفرعية، بغض النظر عمّا إذا كانت هذه المجموعات الفرعية مدخلات للنموذج.

التقطير

عملية تقليل حجم نموذج واحد (يُعرف باسم النموذج الأساسي) إلى نموذج أصغر (يُعرف باسم النموذج الثانوي) يحاكي توقّعات النموذج الأصلي بأكبر قدر ممكن من الدقة التقطير مفيد لأنّ النموذج الأصغر حجمًا يتضمّن ميزتَين رئيسيتَين مقارنةً بالنموذج الأكبر حجمًا (المعلّم):

- وقت استنتاج أسرع

- تقليل استخدام الذاكرة والطاقة

ومع ذلك، لا تكون توقعات الطالب جيدة عادةً مثل توقعات المعلّم.

تدرّب عملية التقطير نموذج الطالب على تقليل دالة الخسارة استنادًا إلى الفرق بين نواتج التوقعات التي يقدّمها نموذج الطالب ونموذج المعلّم.

قارِن بين التقطير والمصطلحات التالية:

لمزيد من المعلومات، يمكنك الاطّلاع على النماذج اللغوية الكبيرة: الضبط الدقيق والتقطير وهندسة الطلبات في "دورة مكثّفة عن تعلّم الآلة".

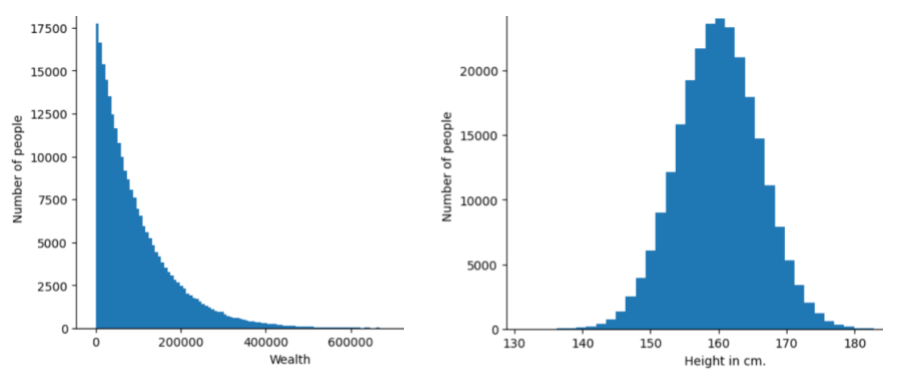

distribution

تمثّل هذه السمة عدد المرات التي تظهر فيها القيم المختلفة للميزة أو التصنيف ونطاقها. يعرض التوزيع مدى احتمالية ظهور قيمة معيّنة.

تعرض الصورة التالية المدرّجات التكرارية لتوزيعَين مختلفَين:

- على اليمين، يظهر توزيع قانون القوة للثروة مقابل عدد الأشخاص الذين يملكون هذه الثروة.

- على اليسار، يظهر التوزيع الطبيعي للطول مقابل عدد الأشخاص الذين يبلغ طولهم هذا المقدار.

يمكن أن يساعدك فهم توزيع كل ميزة وتصنيف في تحديد كيفية تسوية القيم ورصد القيم الشاذة.

تشير عبارة خارج التوزيع إلى قيمة لا تظهر في مجموعة البيانات أو تظهر بشكل نادر جدًا. على سبيل المثال، ستُصنّف صورة لكوكب زحل على أنّها خارج نطاق التوزيع لمجموعة بيانات تتضمّن صورًا للقطط.

التجميع التقسيمي

اطّلِع على التجميع الهرمي.

تصغير نطاق العيّنات

مصطلح عام يمكن أن يعني أحد ما يلي:

- تقليل كمية المعلومات في ميزة بهدف تدريب نموذج بشكل أكثر فعالية على سبيل المثال، قبل تدريب نموذج للتعرّف على الصور، يتم تقليل دقة الصور العالية الدقة إلى تنسيق أقل دقة.

- التدريب على نسبة منخفضة بشكل غير متناسب من أمثلة الفئة الممثَّلة بشكل مفرط بهدف تحسين تدريب النموذج على الفئات الممثَّلة بشكل ناقص على سبيل المثال، في مجموعة بيانات غير متوازنة الفئات، تميل النماذج إلى التعرّف على الكثير من المعلومات حول الفئة الأكبر، ولكن ليس بالقدر الكافي حول الفئة الأصغر. يساعد تقليل معدّل أخذ العيّنات في تحقيق التوازن بين مقدار التدريب على الفئات الأغلبية والأقلية.

لمزيد من المعلومات، راجِع مجموعات البيانات: مجموعات البيانات غير المتوازنة في "دورة مكثّفة عن تعلّم الآلة".

DQN

اختصار شبكة Q العميقة

تسوية الإسقاط

هو شكل من أشكال التسوية المفيد في تدريب الشبكات العصبونية. تزيل عملية التسوية باستخدام Dropout مجموعة عشوائية من عدد ثابت من الوحدات في إحدى طبقات الشبكة خلال خطوة واحدة من التدرّج. وكلما زاد عدد الوحدات التي تم تجاهلها، زادت قوة التسوية. وهذا يشبه تدريب الشبكة على محاكاة مجموعة كبيرة بشكل كبير من الشبكات الأصغر. للاطّلاع على التفاصيل الكاملة، يُرجى الرجوع إلى Dropout: A Simple Way to Prevent Neural Networks from Overfitting.

ديناميكي

شيء يتم بشكل متكرر أو مستمر المصطلحان ديناميكي وعلى الإنترنت مترادفان في تعلُّم الآلة. في ما يلي الاستخدامات الشائعة للديناميكية والإنترنت في تعلّم الآلة:

- النموذج الديناميكي (أو النموذج المباشر) هو نموذج تتم إعادة تدريبه بشكل متكرر أو مستمر.

- التدريب الديناميكي (أو التدريب على الإنترنت) هو عملية التدريب بشكل متكرر أو مستمر.

- الاستنتاج الديناميكي (أو الاستنتاج المباشر) هو عملية إنشاء توقعات عند الطلب.

نموذج ديناميكي

نموذج يتم إعادة تدريبه بشكل متكرر (ربما بشكل مستمر). النموذج الديناميكي هو "متعلّم مدى الحياة" يتكيّف باستمرار مع البيانات المتطورة. يُعرف النموذج الديناميكي أيضًا باسم النموذج المباشر.

يجب التمييز بينه وبين النموذج الثابت.

E

التنفيذ الفوري

بيئة برمجة في TensorFlow يتم فيها تنفيذ العمليات على الفور. في المقابل، لا يتم تنفيذ العمليات التي يتم استدعاؤها في تنفيذ الرسم البياني إلا بعد تقييمها بشكل صريح. التنفيذ الفوري هو واجهة أمرية، تشبه إلى حد كبير الرموز البرمجية في معظم لغات البرمجة. تكون برامج التنفيذ الحريص أسهل بكثير في تصحيح الأخطاء من برامج التنفيذ البياني.

الإيقاف المبكر

طريقة التسوية التي تتضمّن إنهاء التدريب قبل أن يتوقف معدّل انخفاض خسارة التدريب. في عملية الإيقاف المبكر، يتم إيقاف تدريب النموذج عمدًا عندما يبدأ معدل الخطأ في مجموعة بيانات التحقّق من الصحة في الارتفاع، أي عندما يتدهور أداء التعميم.

يختلف ذلك عن الخروج المبكر.

مسافة نقل التراب (EMD)

مقياس للتشابه النسبي بين توزيعَين كلّما كانت مسافة نقل التراب أقل، تشابهت التوزيعات أكثر.

مسافة التعديل

مقياس لمدى تشابه سلسلتَي نص مع بعضهما البعض. في مجال تعلُّم الآلة، تكون مسافة التعديل مفيدة للأسباب التالية:

- يسهل احتساب مسافة التعديل.

- يمكن أن تقارن مسافة التعديل بين سلسلتَين معروفتَين بأنّهما متشابهتان.

- يمكن أن تحدّد مسافة التعديل درجة تشابه السلاسل المختلفة مع سلسلة معيّنة.

تتوفّر عدة تعريفات لمسافة التعديل، ويستخدم كل منها عمليات مختلفة على السلاسل. يمكنك الاطّلاع على مسافة ليفنشتاين للحصول على مثال.

Einsum notation

تمثّل هذه السلسلة طريقة فعّالة لوصف كيفية دمج موترَين. يتم دمج الموترات عن طريق ضرب عناصر أحد الموترات في عناصر الموتر الآخر ثم جمع النواتج. تستخدم طريقة كتابة Einsum رموزًا لتحديد محاور كل موتر، ويتم إعادة ترتيب هذه الرموز نفسها لتحديد شكل الموتر الناتج الجديد.

توفّر حزمة NumPy عملية تنفيذ شائعة للدالة Einsum.

طبقة التضمين

طبقة مخفية خاصة يتم تدريبها على سمة فئوية ذات أبعاد عالية، وذلك بهدف التعلّم تدريجيًا لمتجه تضمين ذي أبعاد أقل. تتيح طبقة التضمين للشبكة العصبية التدريب بكفاءة أكبر بكثير من التدريب على الميزة الفئوية العالية الأبعاد فقط.

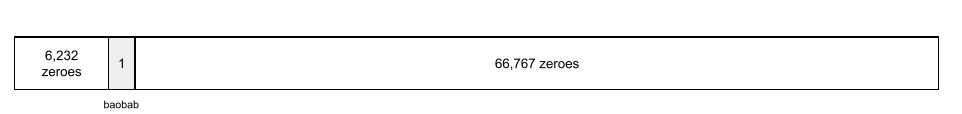

على سبيل المثال، يتيح Earth حاليًا حوالي 73,000 نوع من الأشجار. لنفترض أنّ نوع الشجرة هو سمة في نموذجك، وبالتالي تتضمّن طبقة الإدخال في نموذجك متجهًا ذا ترميز ساخن بطول 73,000 عنصر.

على سبيل المثال، قد يتم تمثيل baobab على النحو التالي:

إنّ مصفوفة تضم 73,000 عنصر طويلة جدًا. إذا لم تضِف طبقة تضمين إلى النموذج، سيستغرق التدريب وقتًا طويلاً جدًا بسبب ضرب 72,999 صفرًا. لنفترض أنّك اخترت أن تتألف طبقة التضمين من 12 سمة. وبالتالي، ستتعلّم طبقة التضمين تدريجيًا متجه تضمين جديدًا لكل نوع من أنواع الأشجار.

في بعض الحالات، يكون التجزئة بديلاً مناسبًا لطبقة التضمين.

يمكنك الاطّلاع على التضمينات في "دورة مكثّفة عن تعلّم الآلة" للحصول على مزيد من المعلومات.

مساحة التضمين

مساحة المتجهات ذات الأبعاد d التي يتم ربط الميزات من مساحة المتجهات ذات الأبعاد الأعلى بها يتم تدريب مساحة التضمين لالتقاط البنية ذات الصلة بالتطبيق المقصود.

الضرب النقطي بين تضمينَين هو مقياس لتشابههما.

متّجه التضمين

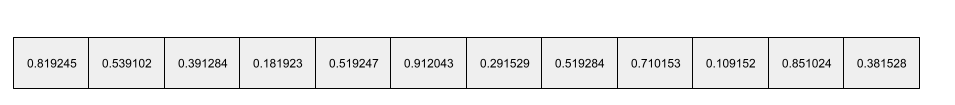

بشكل عام، هي مجموعة من الأرقام العشرية المأخوذة من أي طبقة مخفية تصف المدخلات إلى تلك الطبقة المخفية. في كثير من الأحيان، يكون متّجه التضمين عبارة عن مصفوفة من الأرقام النقطية العائمة التي تم تدريبها في طبقة تضمين. على سبيل المثال، لنفترض أنّ طبقة تضمين يجب أن تتعرّف على متجه تضمين لكل نوع من أنواع الأشجار البالغ عددها 73,000 نوع على الأرض. ربما تكون المصفوفة التالية هي متّجه التضمين لشجرة الباوباب:

متجه التضمين ليس مجموعة من الأرقام العشوائية. تحدّد طبقة التضمين هذه القيم من خلال التدريب، بطريقة مشابهة للطريقة التي تتعلّم بها الشبكة العصبية الأوزان الأخرى أثناء التدريب. كل عنصر من عناصر المصفوفة هو تقييم لبعض خصائص أنواع الأشجار. أي عنصر يمثّل سمة أي نوع من الأشجار؟ ويصعب على البشر تحديد ذلك.

الجزء المميّز رياضيًا في متّجه التضمين هو أنّ العناصر المتشابهة تتضمّن مجموعات متشابهة من الأرقام النقطية العائمة. على سبيل المثال، تتضمّن أنواع الأشجار المتشابهة مجموعة أكثر تشابهًا من الأرقام العشرية مقارنةً بأنواع الأشجار غير المتشابهة. أشجار الخشب الأحمر وأشجار السكويا هي أنواع أشجار مرتبطة ببعضها، لذا سيكون لديها مجموعة أكثر تشابهًا من الأرقام ذات الفاصلة العائمة مقارنةً بأشجار الخشب الأحمر وأشجار جوز الهند. ستتغيّر الأرقام في متجه التضمين في كل مرة تعيد فيها تدريب النموذج، حتى إذا أعدت تدريبه باستخدام الإدخال نفسه.

دالة التوزيع التراكمي التجريبية (eCDF أو EDF)

دالة التوزيع التراكمي استنادًا إلى القياسات التجريبية من مجموعة بيانات حقيقية قيمة الدالة عند أي نقطة على طول المحور س هي جزء الملاحظات في مجموعة البيانات التي تكون أقل من أو تساوي القيمة المحددة.

تقليص المخاطر التجريبية (ERM)

اختيار الدالة التي تقلّل الخسارة إلى الحدّ الأدنى في مجموعة التدريب يختلف ذلك عن تقليص المخاطر البنيوية.

برنامج تشفير

بشكل عام، أي نظام تعلّم آلي يحوّل البيانات من تمثيل أولي أو متفرّق أو خارجي إلى تمثيل أكثر معالجة أو كثافة أو داخلية.

غالبًا ما تكون أجهزة الترميز جزءًا من نموذج أكبر، حيث يتم دمجها بشكل متكرر مع جهاز فك ترميز. تجمع بعض أدوات التحويل بين برامج الترميز وبرامج فك الترميز، بينما تستخدم أدوات التحويل الأخرى برنامج الترميز فقط أو برنامج فك الترميز فقط.

تستخدم بعض الأنظمة ناتج أداة الترميز كمدخل إلى شبكة تصنيف أو انحدار.

في مهام التسلسل إلى التسلسل، يأخذ برنامج الترميز تسلسلاً من الإدخالات ويعرض حالة داخلية (متجه). بعد ذلك، يستخدم برنامج الترميز هذه الحالة الداخلية للتنبؤ بالتسلسل التالي.

راجِع المحوّل للتعرّف على تعريف برنامج الترميز في بنية المحوّل.

لمزيد من المعلومات، يمكنك الاطّلاع على النماذج اللغوية الكبيرة: ما هو النموذج اللغوي الكبير؟ في "دورة مكثّفة عن تعلُّم الآلة".

نقاط النهاية

موقع جغرافي يمكن الوصول إليه عبر الشبكة (عادةً ما يكون عنوان URL) حيث يمكن الوصول إلى الخدمة

مجموعة موحدة

مجموعة من النماذج المدرَّبة بشكل مستقل والتي يتم حساب متوسط توقعاتها أو تجميعها. في كثير من الحالات، ينتج عن المجموعة توقعات أفضل من النموذج الفردي. على سبيل المثال، الغابة العشوائية هي مجموعة نماذج تم إنشاؤها من عدة أشجار قرارات. يُرجى العِلم أنّ بعض غابات القرارات ليست مجموعات.

لمزيد من المعلومات، يمكنك الاطّلاع على الغابة العشوائية في "دورة مكثّفة عن تعلّم الآلة".

الإنتروبيا

في نظرية المعلومات، هو وصف لمدى عدم القدرة على التنبؤ بتوزيع الاحتمالات. ويمكن أيضًا تعريف القصور على أنّه مقدار المعلومات التي يحتوي عليها كل مثال. يكون التوزيع ذا أعلى إنتروبيا ممكنة عندما تكون جميع قيم المتغيّر العشوائي متساوية الاحتمالية.

إنّ إنتروبيا مجموعة تتضمّن قيمتَين محتملتَين هما "0" و "1" (على سبيل المثال، التصنيفات في مسألة تصنيف ثنائي) لها الصيغة التالية:

H = -p log p - q log q = -p log p - (1-p) * log (1-p)

where:

- H هي القصور.

- p هي نسبة الأمثلة التي تكون فيها القيمة "1".

- q هو نسبة الأمثلة التي تكون فيها القيمة "0". يُرجى العِلم أنّ q = (1 - p)

- log هو بشكل عام log2. في هذه الحالة، وحدة الإنتروبيا هي بت.

على سبيل المثال، لنفترض ما يلي:

- تحتوي 100 عينة على القيمة "1"

- تحتوي 300 عينة على القيمة "0"

وبالتالي، تكون قيمة القصور كما يلي:

- p = 0.25

- q = 0.75

- H = (-0.25)log2(0.25) - (0.75)log2(0.75) = 0.81 bits per example

ستكون قيمة الإنتروبيا لمجموعة متوازنة تمامًا (على سبيل المثال، 200 من القيمة "0" و200 من القيمة "1") هي 1.0 بت لكل مثال. كلما أصبحت المجموعة أكثر عدم توازن، اقترب القصور فيها من 0.0.

في أشجار القرارات، يساعد الانتروبيا في صياغة تحصيل المعلومات لمساعدة المقسّم في اختيار الشروط أثناء نمو شجرة قرارات التصنيف.

مقارنة الإنتروبيا مع:

- مقياس جيني للتفاوت

- دالة الخسارة الإنتروبيا المتداخلة

يُطلق على القصور غالبًا اسم قصور شانون.

لمزيد من المعلومات، راجِع Exact splitter for binary classification with numerical features في دورة "أشجار القرار".

بيئة

في التعلّم المعزّز، يشير مصطلح "البيئة" إلى العالم الذي يحتوي على الوكيل ويسمح له بمراقبة حالته. على سبيل المثال، يمكن أن يكون العالم الممثَّل لعبة مثل الشطرنج أو عالمًا ماديًا مثل المتاهة. عندما ينفّذ الوكيل إجراءً على البيئة، تنتقل البيئة بين الحالات.

حلقة

في التعلّم المعزّز، كل محاولة متكررة يقوم بها الوكيل لتعلّم بيئة.

حقبة

هي عملية تدريب كاملة على مجموعة التدريب بحيث تتم معالجة كل مثال مرة واحدة.

تمثّل الحقبة N/حجم الدفعة

تكرارات التدريب، حيث N هو

إجمالي عدد الأمثلة.

على سبيل المثال، لنفترض ما يلي:

- تتألف مجموعة البيانات من 1,000 مثال.

- يبلغ حجم الدفعة 50 مثالاً.

لذلك، تتطلّب الحقبة الواحدة 20 تكرارًا:

1 epoch = (N/batch size) = (1,000 / 50) = 20 iterations

يمكنك الاطّلاع على الانحدار الخطي: المَعلمات الفائقة في "دورة مكثّفة عن تعلّم الآلة" للحصول على مزيد من المعلومات.

سياسة إبسيلون الجشعة

في التعلّم المعزّز، السياسة التي تتّبع إما سياسة عشوائية باحتمالية إبسيلون أو سياسة جشعة في الحالات الأخرى. على سبيل المثال، إذا كانت قيمة إبسيلون 0.9، ستتّبع السياسة سياسة عشوائية بنسبة% 90 من الوقت وسياسة جشعة بنسبة% 10 من الوقت.

على مدار حلقات متتالية، تقلّل الخوارزمية قيمة إبسيلون من أجل الانتقال من اتّباع سياسة عشوائية إلى اتّباع سياسة جشعة. من خلال تغيير السياسة، يستكشف الوكيل البيئة أولاً بشكل عشوائي ثم يستغل بشكل جشع نتائج الاستكشاف العشوائي.

تكافؤ الفرص

مقياس الإنصاف لتقييم ما إذا كان النموذج يتوقّع النتيجة المطلوبة بشكل جيد وبالمقدار نفسه لجميع قيم السمة الحسّاسة بعبارة أخرى، إذا كانت النتيجة المرغوبة لنموذج هي الفئة الإيجابية، سيكون الهدف هو أن يكون معدّل الإيجابية الحقيقية هو نفسه لجميع المجموعات.

يرتبط تكافؤ الفرص بتكافؤ الاحتمالات، الذي يتطلّب أن يكون كلّ من معدلات الموجب الصائب ومعدلات الموجب الخاطئ متطابقًا لجميع المجموعات.

لنفترض أنّ جامعة Glubbdubdrib تقبل طلابًا من Lilliput وBrobdingnag في برنامج رياضيات صارم. تقدّم المدارس الثانوية في ليليبوت منهجًا دراسيًا قويًا في الرياضيات، ومعظم الطلاب مؤهّلون للالتحاق بالبرنامج الجامعي. لا تقدّم المدارس الثانوية في بروبدنجناغ أي دروس في الرياضيات، ونتيجة لذلك، يكون عدد الطلاب المؤهّلين أقل بكثير. يتم استيفاء شرط تكافؤ الفرص للتصنيف المفضّل "مقبول" فيما يتعلق بالجنسية (ليليبوتية أو بروبدنجناغية) إذا كان من المرجّح أن يتم قبول الطلاب المؤهّلين بالتساوي بغض النظر عما إذا كانوا ليليبوتايين أو بروبدنجناغيين.

على سبيل المثال، لنفترض أنّ 100 شخص من ليليبوت و100 شخص من بروبدينغناغ يقدّمون طلبات التحاق بجامعة غلوبدبدريب، ويتم اتخاذ قرارات القبول على النحو التالي:

الجدول 1. مقدّمو الطلبات من البلدان الصغيرة (90% منهم مؤهَّلون)

| مؤهَّل | غير معرَّف | |

|---|---|---|

| تم قبول الطلب | 45 | 3 |

| تم الرفض | 45 | 7 |

| المجموع | 90 | 10 |

|

النسبة المئوية للطلاب المؤهّلين المقبولين: 45/90 =%50 النسبة المئوية للطلاب غير المؤهّلين المرفوضين: 7/10 =%70 النسبة المئوية الإجمالية للطلاب المقبولين من Lilliputian: (45+3)/100 = %48 |

||

الجدول 2. مقدّمو الطلبات من Brobdingnagian (10% مؤهَّلون):

| مؤهَّل | غير معرَّف | |

|---|---|---|

| تم قبول الطلب | 5 | 9 |

| تم الرفض | 5 | 81 |

| المجموع | 10 | 90 |

|