Prévenir le surapprentissage

Comme c'est le cas pour tout modèle de machine learning, le surapprentissage constitue une préoccupation majeure lors de l'apprentissage d'un réseau de neurones convolutif. En fait, il arrive fréquemment qu'un modèle soit si bien adapté aux spécificités des données d'apprentissage que la généralisation à de nouveaux exemples est impossible. Deux techniques permettent de prévenir le surapprentissage lors de la construction d'un réseau de neurones convolutif:

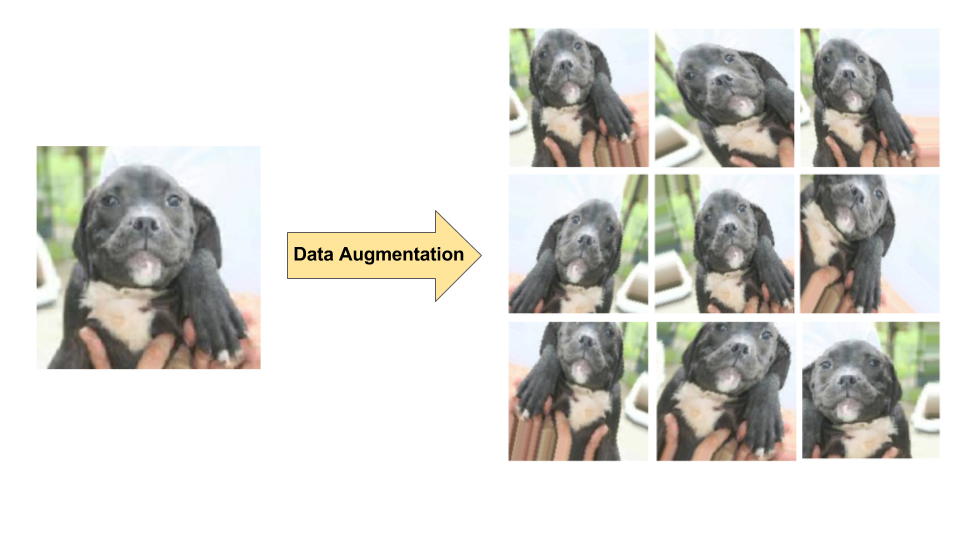

- Augmentation des données: augmentation artificielle de la diversité et du nombre d'exemples d'apprentissage en appliquant des transformations aléatoires aux images existantes pour créer un ensemble de nouvelles variantes (voir figure 7). L'augmentation des données est particulièrement utile lorsque l'ensemble de données d'apprentissage d'origine est relativement petit.

- Régularisation par abandon: suppression aléatoire d'unités du réseau de neurones lors d'une étape de gradient d'apprentissage.

Figure 7. Augmentation des données sur une seule image de chien (extraite de l'ensemble de données "Dogs vs. Cats" disponible sur Kaggle). À gauche: image de chien originale tirée de l'ensemble d'apprentissage.

À droite: neuf nouvelles images générées à partir de l'image d'origine à l'aide de transformations aléatoires.

Figure 7. Augmentation des données sur une seule image de chien (extraite de l'ensemble de données "Dogs vs. Cats" disponible sur Kaggle). À gauche: image de chien originale tirée de l'ensemble d'apprentissage.

À droite: neuf nouvelles images générées à partir de l'image d'origine à l'aide de transformations aléatoires.