Modelle für generative KI sind leistungsstarke Tools, ohne ihre Einschränkungen. Ihre Vielseitigkeit und Anwendbarkeit kann zu unerwarteten Ergebnissen führen, etwa ungenaue, verzerrte oder anstößig sein. Die Nachbearbeitung und eine strenge manuelle Bewertung sind unerlässlich, das Risiko von Schäden durch solche Ausgaben zu begrenzen.

Die von der Gemini API bereitgestellten Modelle können für eine Vielzahl von Anwendungen für generative KI und Natural Language Processing (NLP) Verwendung Funktionen sind nur über die Gemini API oder die Google AI Studio-Webversion verfügbar Ihre Nutzung der Gemini API unterliegt auch der verbotenen Nutzung für Generative AI Richtlinie und die Nutzungsbedingungen für die Gemini API.

Der Nutzen von Large Language Models (LLMs) liegt unter anderem darin, dass sie Creative-Tools, die viele verschiedene Sprachaufgaben lösen können. Leider bedeutet das auch, dass Large Language Models Ausgabedaten generieren können, die nicht erwartet, einschließlich Text die anstößig, unsensibel oder faktisch falsch sind. Außerdem werden die Aufgrund der enormen Vielseitigkeit dieser Modelle ist es genau vorherzusagen, welche Art von unerwünschter Ausgabe sie erzeugen könnte. Während die Die Gemini API wurde mit KI von Google entwickelt Grundsätze berücksichtigt, müssen die Entwickler diese Modelle verantwortungsvoll anwenden. Entwickler dabei zu unterstützen, sichere, verantwortungsvolle bietet die Gemini API integrierte Inhaltsfilterung sowie anpassbare Sicherheitseinstellungen in 4 Dimensionen für Schäden. Weitere Informationen finden Sie im Sicherheitseinstellungen finden Sie weitere Informationen.

Mit diesem Dokument werden einige Sicherheitsrisiken beschrieben, die auftreten können, wenn LLMs einsetzen und neue Sicherheitsdesigns empfehlen Empfehlungen. Beachten Sie, dass Gesetze und Vorschriften auch Einschränkungen aber solche Überlegungen würden den Rahmen dieses Leitfadens sprengen.)

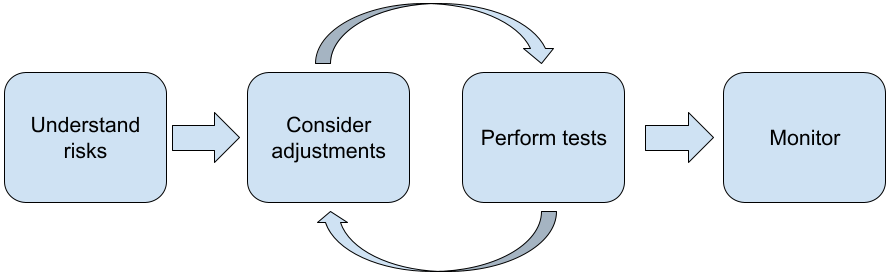

Beim Erstellen von Anwendungen mit LLMs werden die folgenden Schritte empfohlen:

- Sicherheitsrisiken Ihrer Anwendung verstehen

- Anpassungen erwägen, um Sicherheitsrisiken zu mindern

- Für Ihren Anwendungsfall geeignete Sicherheitstests durchführen

- Nutzerfeedback einholen und Nutzung überwachen

Die Anpassungs- und Testphasen sollten iterativ sein, bis Sie die für Ihre Anwendung angemessen ist.

Sicherheitsrisiken Ihrer Anwendung verstehen

In diesem Kontext wird Sicherheit als die Fähigkeit eines LLM definiert, Nutzern Schaden zuzufügen, z. B. durch das Generieren schädlicher Sprache oder Inhalte die Stereotypen fördert. Die über die Gemini API verfügbaren Modelle wurden wurde unter Berücksichtigung der KI-Grundsätze von Google entwickelt und Ihre Nutzung unterliegt der verbotenen Nutzung für Generative AI Richtlinien: Die API bietet integrierte Sicherheitsfilter für gängige Sprachmodelle Probleme wie unangemessene Sprache und Hassrede sowie das Streben nach Inklusion und zur Vermeidung von Stereotypen. Jede Anwendung kann jedoch einen anderen Satz enthalten. für die Nutzenden zu identifizieren. Als Anwendungsinhaber sind Sie für die Kenntnis Ihrer Nutzer und der potenziellen Schäden, die Ihre Anwendung verursachen kann, sowie Sie sorgen dafür, dass Ihre Anwendung LLMs sicher und verantwortungsvoll nutzt.

Im Rahmen dieser Bewertung sollten Sie berücksichtigen, wie wahrscheinlich es ist, und die Ernsthaftigkeit und die Abhilfemaßnahmen zu bestimmen. Beispiel: Apps, die Aufsätze basierend auf Sachereignissen erstellen, sollten besonders vorsichtig sein im Vergleich zu einer App, die fiktive Geschichten zur Unterhaltung. Eine gute Möglichkeit, potenzielle Sicherheitsrisiken zu untersuchen ist es, Ihre Endanwendenden und andere, die von Ihrer Anwendungsergebnisse. Dies kann viele Formen annehmen, einschließlich der Untersuchung des Zustands der die Kunststudien in Ihrer App-Domain, die Beobachtung, wie Nutzer ähnliche Apps nutzen, oder die Durchführung von Nutzerstudien, Umfragen oder die Durchführung informeller Interviews mit potenziellen Nutzenden.

Weitere Tipps

- Sprechen Sie mit einer vielfältigen Mischung potenzieller Nutzer innerhalb Ihrer Zielgruppe über Ihre App und ihren beabsichtigten Zweck informieren, einen besseren Überblick über potenzielle Risiken zu erhalten und die Vielfalt anzupassen. nach Bedarf Kriterien zu erfüllen.

- Das Risikomanagement für KI von der US-Regierung freigesprochen Das National Institute of Standards and Technology (NIST) bietet mehr ausführliche Anleitungen und zusätzliche Lernressourcen zum Risikomanagement von KI.

- Die Veröffentlichung von DeepMind auf der ethische und soziale Schadensrisiken durch Language Models beschreibt im Detail, wie das Language Model Anwendungen Schaden anrichten können.

Anpassungen erwägen, um Sicherheitsrisiken zu mindern

Jetzt, da Sie die Risiken kennen, können Sie entscheiden, wie Sie sie mindern . Bestimmen, welche Risiken priorisiert werden sollten und wie viel Sie tun sollten, um zu versuchen, zu verhindern, ist eine kritische Entscheidung, ähnlich wie bei der Untersuchung von Fehlern in einer Software Projekt arbeiten. Sobald Sie Prioritäten festgelegt haben, können Sie darüber nachdenken, die am besten geeignet sind. Oft können einfache Änderungen und Risiken reduzieren.

Berücksichtigen Sie beim Entwerfen einer Anwendung beispielsweise Folgendes:

- Abstimmung der Modellausgabe, um besser widerzuspiegeln, was in Ihrem Anwendungskontext. Eine Abstimmung kann die Ausgabe des Modells vorhersehbar und konsistent sind und daher dazu beitragen können, bestimmte Risiken zu mindern.

- Eine Eingabemethode, die sicherere Ergebnisse ermöglicht. Die genaue Eingabe die Sie einem LLM geben, die Qualität der Ausgabe beeinflussen können. Sie experimentieren mit Eingabeaufforderungen, um herauszufinden, was in Ihrem ist den Aufwand auf jeden Fall wert, da Sie dann eine UX bereitstellen können, dies erleichtert. Beispielsweise können Sie festlegen, dass Nutzer nur aus einer Dropdown-Liste mit Eingabeaufforderungen oder Pop-up-Vorschläge mit beschreibend Wortgruppen, die Ihrer Meinung nach in Ihrem Anwendungskontext sicher funktionieren.

Unsichere Eingaben blockieren und Ausgabe filtern, bevor sie dem Nutzer angezeigt wird Nutzer. In einfachen Fällen lassen sich mit Sperrlisten unsichere Wörter oder Wortgruppen in Prompts oder Antworten bzw. von Prüfern solche Inhalte manuell zu ändern oder zu blockieren.

Mithilfe von trainierten Klassifikatoren jede Aufforderung mit potenziellen Schäden oder bösartigen Signalen zu erkennen. Verschiedene Strategien können dann angewendet werden, je nach Art des erkannten Schadens zu verarbeiten. Wenn zum Beispiel der Parameter Eingabe offenkundig feindselig oder missbräuchlich ist, könnten sie blockiert und eine vorgegebene Antwort.

Tipp für Fortgeschrittene

-

Wenn Signale feststellen, dass die Ausgabe schädlich ist,

kann die Anwendung die folgenden Optionen verwenden:

- Geben Sie eine Fehlermeldung oder eine vorgefertigte Ausgabe ein.

- Versuchen Sie es noch einmal für den Fall, dass eine alternative sichere Ausgabe generiert, da derselbe Prompt manchmal unterschiedliche Ausgaben haben.

-

Wenn Signale feststellen, dass die Ausgabe schädlich ist,

kann die Anwendung die folgenden Optionen verwenden:

Ergreifen von Absicherungen gegen absichtlichen Missbrauch, z. B. das Zuweisen von Jedem Nutzer eine eindeutige ID zuweisen und die Anzahl der Nutzeranfragen begrenzen die innerhalb eines bestimmten Zeitraums eingereicht werden können. Eine weitere Absicherung besteht darin, Schutz vor möglichen Einschleusungen von Prompts. Prompt-Einschleusung ähnlich wie SQL einschleusen, können böswillige Nutzende eine Eingabe-Prompts entwerfen, manipuliert die Ausgabe des Modells, z. B. durch Senden eines Eingabe-Prompts , der das Modell anweist, alle vorherigen Beispiele zu ignorieren. Weitere Informationen finden Sie in der Richtlinie zur unzulässigen Nutzung von generativer KI .

Die Funktionalität auf etwas mit weniger Risiken einstellen. Aufgaben mit einem enger gefassten Umfang (z.B. das Extrahieren von Schlüsselwörtern aus Abschnitten eines Text) oder mit größerer menschlicher Aufsicht (z.B. Erstellung von die manuell überprüft werden, stellen oft ein geringeres Risiko dar. Für -Instanz erstellt, anstatt eine Anwendung zum Schreiben einer E-Mail-Antwort können Sie es stattdessen auf eine Gliederung erweitern oder alternative Formulierungen.

Auf Ihren Anwendungsfall abgestimmte Sicherheitstests durchführen

Tests sind ein wichtiger Bestandteil bei der Entwicklung zuverlässiger und sicherer Anwendungen, Umfang und Strategien für Tests variieren. Beispiel: Ein Haiku, der einfach nur Spaß macht weniger schwerwiegende Risiken darstellt als etwa eine Anwendung, für Anwaltskanzleien, um Rechtsdokumente zusammenzufassen und Verträge zu entwerfen. Aber kann der Haiku-Generator von einer größeren Vielfalt von Nutzenden verwendet werden. oder sogar unbeabsichtigte schädliche Eingaben, sogar noch größer. Auch der Kontext der Implementierung ist wichtig. Beispiel: Eine Anwendung mit den Ergebnissen, die von menschlichen Fachleuten überprüft werden, bevor Maßnahmen ergriffen werden. mit geringerer Wahrscheinlichkeit schädliche Inhalte erzeugen als eine identische ohne ein solches Versäumnis.

Es ist nicht ungewöhnlich, dass bei der Durchführung von Änderungen und Tests mehrere Iterationen durchlaufen werden bevor Sie sich sicher sind, dass Sie zur Markteinführung bereit sind. Dies gilt selbst für Anwendungen, sind mit einem relativ geringen Risiko verbunden. Zwei Arten von Tests sind für KI besonders nützlich Anwendungen:

Beim Sicherheits-Benchmarking werden Sicherheitsmesswerte entwickelt, die wie Ihre Anwendung im Hinblick auf die Wahrscheinlichkeit, Testen Sie dann, wie gut Ihre Anwendung anhand der Messwerte funktioniert, mit Bewertungs-Datasets. Es empfiehlt sich, die Mindestanforderungen akzeptable Sicherheitsmetriken vor dem Testen, damit Sie 1) Bewerten Sie die Testergebnisse anhand dieser Erwartungen und 2) Sie können das Bewertungs-Dataset basierend auf den Tests, mit denen die für Sie relevanten Messwerte ausgewertet werden über die meisten Fragen.

Weitere Tipps

- Achten Sie darauf, sich zu sehr auf „Standard“-Ansätze zu verlassen, da dies wahrscheinlich müssen Sie Ihre eigenen Test-Datasets mit Prüfern erstellen, um vollständig zum Kontext Ihrer Anwendung passen.

- Wenn Sie mehrere Messwerte haben, müssen Sie festlegen, wenn eine Änderung zu einer Verbesserung eines Messwerts zum Nachteil einer anderen. Wie bei anderen Performance-Engines sollten Sie sich bei der Bewertung auf die Worst-Case-Leistung konzentrieren und nicht die durchschnittliche Leistung.

Bei Angreifertests wird proaktiv versucht, . Ziel ist es, Schwachstellen zu identifizieren, damit Sie entsprechende Abhilfemaßnahmen einleiten. Adversarial Tests können erheblicher Zeit-/Aufwand von Bewertern, die sich mit Ihrer Anwendung auskennen – Aber je mehr Sie tun, desto größer sind Ihre Chancen, Probleme zu erkennen, insbesondere solche, die selten oder erst nach wiederholten Ausführungen des .

- Adversarial Testing ist eine Methode zur systematischen Bewertung eines ML-Systems.

um zu lernen, wie es sich verhält, wenn es

bösartige oder unbeabsichtigt schädliche Eingaben:

- Eine Eingabe kann schädlich sein, wenn sie eindeutig dazu dient, eine unsichere oder schädliche Ausgabe erzeugen, z. B. um hasserfüllte Schimpftiraden über ein bestimmtes Religion.

- Eine Eingabe ist unbeabsichtigt schädlich, wenn sie selbst möglicherweise harmlos, aber zu schädlichen Ergebnissen führen, z. B. wenn Sie eine Textnachricht das Modell einer Person einer bestimmten ethnischen Herkunft und eine rassistische Ausgabe erhalten.

- Was unterscheidet einen Angreifertest von einer Standardbewertung?

Zusammensetzung der Testdaten. Wählen Sie für bösartige Tests

Testdaten, die am ehesten problematische Ausgabe

Modell zu verstehen. Das bedeutet, das Verhalten des Modells für alle

Mögliche Schäden, einschließlich seltener oder ungewöhnlicher Beispiele

die für Sicherheitsrichtlinien relevant sind. Außerdem sollte sie

Vielfalt in den

verschiedenen Dimensionen eines Satzes,

Bedeutung und Länge. Weitere Informationen finden Sie im Leitfaden Responsible AI von Google

Praktiken in

Fairness

finden Sie weitere Informationen dazu, was beim Erstellen eines Test-Datasets zu beachten ist.

Weitere Tipps

- Verwenden Sie automatisierte Tests anstelle der traditionellen Methode, Menschen in „rote Teams“ aufzunehmen, um deine App zu zerstören. Bei automatischen Tests "red team" ein weiteres Sprachmodell, das Eingabetext findet, schädliche Ausgaben aus dem zu testenden Modell verursachen.

- Adversarial Testing ist eine Methode zur systematischen Bewertung eines ML-Systems.

um zu lernen, wie es sich verhält, wenn es

bösartige oder unbeabsichtigt schädliche Eingaben:

Auf Probleme prüfen

Egal wie sehr Sie testen und mindern, Sie können niemals Perfektion garantieren. im Voraus zu planen, wie Sie auftretende Probleme erkennen und mit ihnen umgehen. Häufig besteht die Möglichkeit, einen überwachten Kanal einzurichten, über den Nutzer Feedback geben können. (z. B. Daumen nach oben/unten) und eine Nutzerstudie durchführen, um proaktiv die Bitte um Feedback zu bitten. Feedback von unterschiedlichen Nutzern – besonders nützlich, wenn Nutzungsmuster den Erwartungen nicht entspricht.

Weitere Tipps

- Wenn Nutzer Feedback zu KI-Produkten geben, kann die KI erheblich verbessert werden. die Leistung und die Nutzererfahrung im Laufe der Zeit, z. B. Ihnen bei der Auswahl besserer Beispiele für die Prompt-Abstimmung helfen. Die Kapitel „Feedback und Steuerung“ im Google Guidebook für Menschen und KI hebt wichtige Überlegungen hervor, die beim Entwerfen von Feedbackmechanismen ein.

Nächste Schritte

- Weitere Informationen finden Sie im Sicherheitseinstellungen beschrieben, um mehr über die anpassbaren Sicherheitseinstellungen, die über die Gemini API verfügbar sind.

- In der Einführung zu Prompts erhalten Sie Ihre ersten Prompts zu schreiben.