To jest wół.

Rysunek 19. wół,

W 1906 roku w Anglia odbyły się zawody w sędziowaniu wagi. 787 osób zgadnęło wagę wołu. Średnia niezgodność poszczególnych szacunków wynosiła 37 lb (niezgodność 3,1%). Jednak ogólna mediana szacunków była tylko o 4 kg od rzeczywistej wagi byka (539 kg), co oznacza błąd wynoszący zaledwie 0,7%.

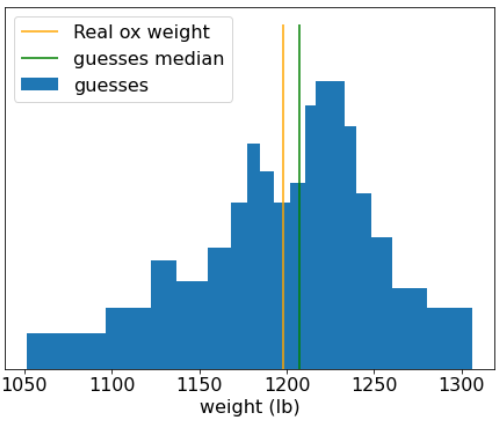

Rysunek 20. Histogram z poszczególnymi przypuszczalnymi wartościami wagi.

Ta anegdota ilustruje mądrość tłumu: w pewnych sytuacjach zbiorcza opinia pozwala na bardzo trafne oceny.

Matematycznie mądrość tłumu można modelować za pomocą twierdzenia centralnego limitu rozkładu: nieformalnie błąd kwadratowy między wartością a średnią z N szumowych oszacowań tej wartości zmierza do zera z współczynnikiem 1/N. Jeśli jednak zmienne nie są niezależne, odchylenie standardowe jest większe.

W uczeniu maszynowym zbiór to zbiór modeli, których prognozy są uśredniane (lub w jakiś sposób agregowane). Jeśli modele zbiorcze są na tyle różne, że nie są zbyt złe pojedynczo, jakość zbioru jest zazwyczaj lepsza niż jakość poszczególnych modeli. Model zbiorczy wymaga więcej czasu na trenowanie i wykonywanie wnioskowania niż pojedynczy model. W końcu musisz przeprowadzić trenowanie i wykonywanie wniosków na wielu modelach, a nie na jednym.

Aby modele zbiorcze działały jak najlepiej, poszczególne modele powinny być niezależne. Na przykład ensemble złożone z 10 identycznych modeli (czyli w żaden sposób nie niezależnych) nie będzie lepsze od pojedynczego modelu. Z drugiej strony wymuszenie niezależności modeli może spowodować ich pogorszenie. Skuteczne tworzenie zbiorów wymaga znalezienia równowagi między niezależnością modelu a jakością jego podmodeli.