牡牛です。

図 19. 牛。

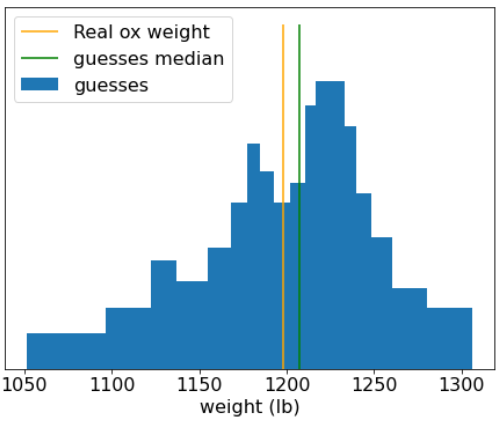

1906 年、英国で体重審査の大会が開催されました。787 人の参加者が牛の体重を推測しました。個々の推測の中央値の誤差は 37 ポンド(3.1% の誤差)でした。ただし、推測の全体的な中央値は、牛の実際の重量(1,198 ポンド)からわずか 9 ポンドしか離れていません。誤差はわずか 0.7% です。

図 20. 個々の体重推定のヒストグラム。

この逸話は、群衆の知恵を物語っています。特定の状況では、集団の意見が非常に優れた判断をもたらします。

数学的には、群知恵は中央極限定理でモデル化できます。非公式には、ある値と、この値のノイズのある推定値の平均との間の二乗誤差は、1/N の係数でゼロに近づきます。ただし、変数が独立していない場合、分散は大きくなります。

機械学習では、アンサンブルは、予測が平均化(またはなんらかの方法で集約)されたモデルのコレクションです。アンサンブル モデルが個別に悪くならずに十分に異なる場合、アンサンブルの品質は通常、個々のモデルの品質よりも優れています。アンサンブルでは、単一モデルよりも多くのトレーニング時間と推論時間が必要になります。結局のところ、単一のモデルではなく複数のモデルでトレーニングと推論を行う必要があります。

アンサンブルが最適に機能するには、個々のモデルが独立している必要があります。たとえば、まったく独立していない 10 個のまったく同じモデルで構成されたアンサンブルは、個々のモデルよりも優れた結果は得られません。一方、モデルを強制的に独立させると、モデルの品質が低下する可能性があります。効果的なアンサンブルを作成するには、モデルの独立性とサブモデルの品質のバランスを見つける必要があります。