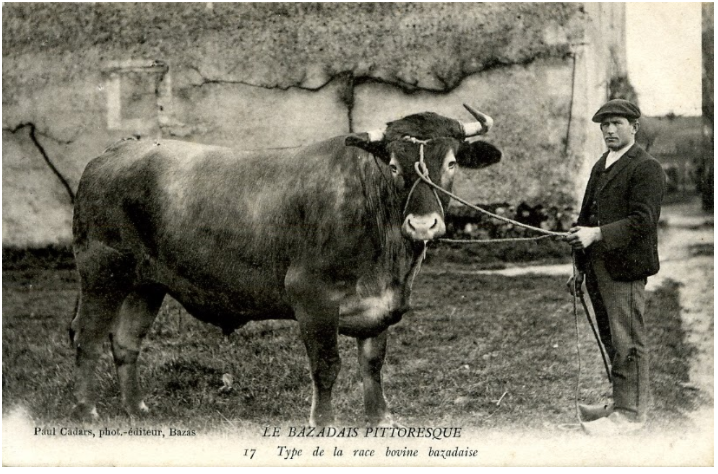

Questo è un bue.

Figura 19. Un bue.

Nel 1906, in Inghilterra, si è tenuta una gara di valutazione del peso. 787 partecipanti hanno indovinato il peso di un bue. L'errore medio delle singole stime è stato di 17 kg (un errore del 3,1%). Tuttavia, la mediana complessiva delle supposizioni era distante solo 4 kg dal peso reale del bue (542 kg), ovvero un errore dello 0,7%.

Figura 20. Istogramma delle singole supposizioni sul peso.

Questa aneddoto illustra la saggezza della folla: in determinate situazioni, l'opinione collettiva fornisce un giudizio molto buono.

Dal punto di vista matematico, la saggezza della massa può essere modellata con il teorema del limite centrale: in modo informale, l'errore quadratico tra un valore e la media di N stima con rumore di questo valore tende a zero con un fattore 1/N. Tuttavia, se le variabili non sono indipendenti, la varianza è maggiore.

Nel machine learning, un ensemble è una raccolta di modelli le cui previsioni vengono mediate (o aggregate in qualche modo). Se i modelli di ensemble sono sufficientemente diversi senza essere troppo scadenti singolarmente, la qualità dell'ensemble è in genere migliore della qualità di ciascun singolo modello. Un ensemble richiede più tempo di addestramento e di inferenza rispetto a un singolo modello. Dopotutto, devi eseguire l'addestramento e l'inferenza su più modelli invece che su un singolo modello.

In modo informale, per il miglior funzionamento di un ensemble, i singoli modelli devono essere indipendenti. Ad esempio, un ensemble composto da 10 modelli esattamente uguali (ovvero non indipendenti) non sarà migliore del singolo modello. D'altro canto, forzare i modelli a essere indipendenti potrebbe peggiorarli. Un'unione efficace richiede di trovare l'equilibrio tra l'indipendenza del modello e la qualità dei relativi sottomodelli.