Isso é um boi.

Figura 19. Um boi.

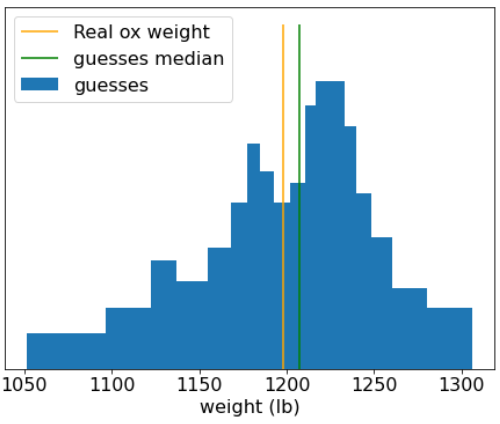

Em 1906, uma competição de julgamento de peso foi realizada na Inglaterra. 787 participantes adivinharam o peso de um boi. O erro mediano das estimativas individuais foi de 37 lb (um erro de 3,1%). No entanto, a mediana geral das estimativas estava a apenas 4 kg do peso real do boi (5.400 kg), o que representava um erro de apenas 0,7%.

Figura 20. Histograma de estimativas de peso individuais.

Esta anedota ilustra a sabedoria da multidão: em certas situações, a opinião coletiva fornece um julgamento muito bom.

Matematicamente, a sabedoria da multidão pode ser modelada com o Teorema do limite central: informalmente, o erro ao quadrado entre um valor e a média de N estimativas com ruído desse valor tende a zero com um fator 1/N. No entanto, se as variáveis não forem independentes, a variação será maior.

No aprendizado de máquina, um conjunto é uma coleção de modelos cujas previsões são calculadas em média (ou agregadas de alguma forma). Se os modelos do conjunto forem diferentes o suficiente sem serem muito ruins individualmente, a qualidade do conjunto geralmente será melhor do que a qualidade de cada um dos modelos individuais. Um conjunto exige mais tempo de treinamento e inferência do que um único modelo. Afinal, você precisa realizar o treinamento e a inferência em vários modelos, em vez de um único modelo.

Informalmente, para que um conjunto funcione melhor, os modelos individuais precisam ser independentes. Como exemplo, um conjunto composto por 10 modelos idênticos (ou seja, não independentes) não será melhor do que o modelo individual. Por outro lado, forçar os modelos a serem independentes pode piorá-los. O agrupamento eficaz exige encontrar o equilíbrio entre a independência do modelo e a qualidade dos submodelos.