황소입니다.

그림 19. 황소입니다.

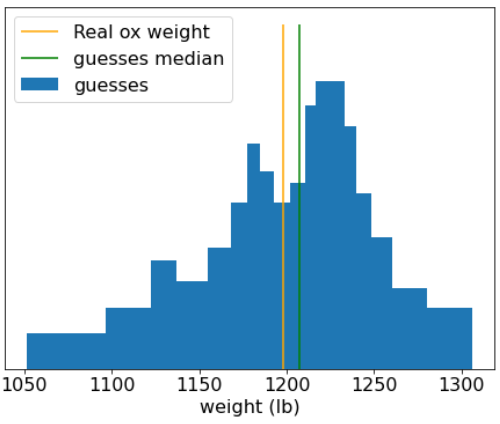

1906년 영국에서 체중 심사 대회가 열렸습니다. 787명의 참여자가 소의 무게를 추측했습니다. 개별 추측의 중앙값 오류는 37파운드 (3.1% 오류)였습니다. 하지만 추측의 전반적인 중앙값은 황소의 실제 무게(1,198파운드)에서 9파운드(0.7%)밖에 차이가 나지 않았습니다.

그림 20. 개별 체중 추측의 히스토그램입니다.

이 일화는 집단지성을 보여줍니다. 특정 상황에서는 집단의 의견이 매우 좋은 판단을 제공합니다.

수학적으로는 중앙 극한 정리를 사용하여 군중의 지혜를 모델링할 수 있습니다. 비공식적으로는 값과 이 값의 노이즈가 있는 추정치 N개 평균 간의 제곱 오차가 1/N 계수와 함께 0으로 수렴합니다. 그러나 변수가 독립적이지 않으면 분산이 더 큽니다.

머신러닝에서 앙상블은 예측이 평균화되거나 어떤 방식으로든 집계되는 모델 모음입니다. 앙상블 모델이 개별적으로 너무 나쁘지 않으면서도 충분히 다르면 일반적으로 앙상블의 품질이 각 개별 모델의 품질보다 우수합니다. 앙상블에는 단일 모델보다 더 많은 학습 및 추론 시간이 필요합니다. 결국 단일 모델이 아닌 여러 모델에서 학습 및 추론을 실행해야 합니다.

비공식적으로, 앙상블이 가장 잘 작동하려면 개별 모델이 독립적이어야 합니다. 예를 들어 정확히 동일한 10개의 모델 (즉, 전혀 독립적이지 않음)로 구성된 앙상블은 개별 모델보다 나을 수 없습니다. 반면에 모델을 독립적으로 강제하면 모델이 더 나빠질 수 있습니다. 효과적인 앙상블링을 위해서는 모델 독립성과 하위 모델의 품질 간의 균형을 찾아야 합니다.