रैंडम फ़ॉरेस्ट के उलट, ग्रेडिएंट बूस्टर ट्री हो सकते हैं. इसलिए, नेटवर्क के लिए, पुष्टि करने वाले डेटासेट का इस्तेमाल करके, रेगुलराइज़ेशन और जल्दी रोकने की सुविधा लागू की जा सकती है.

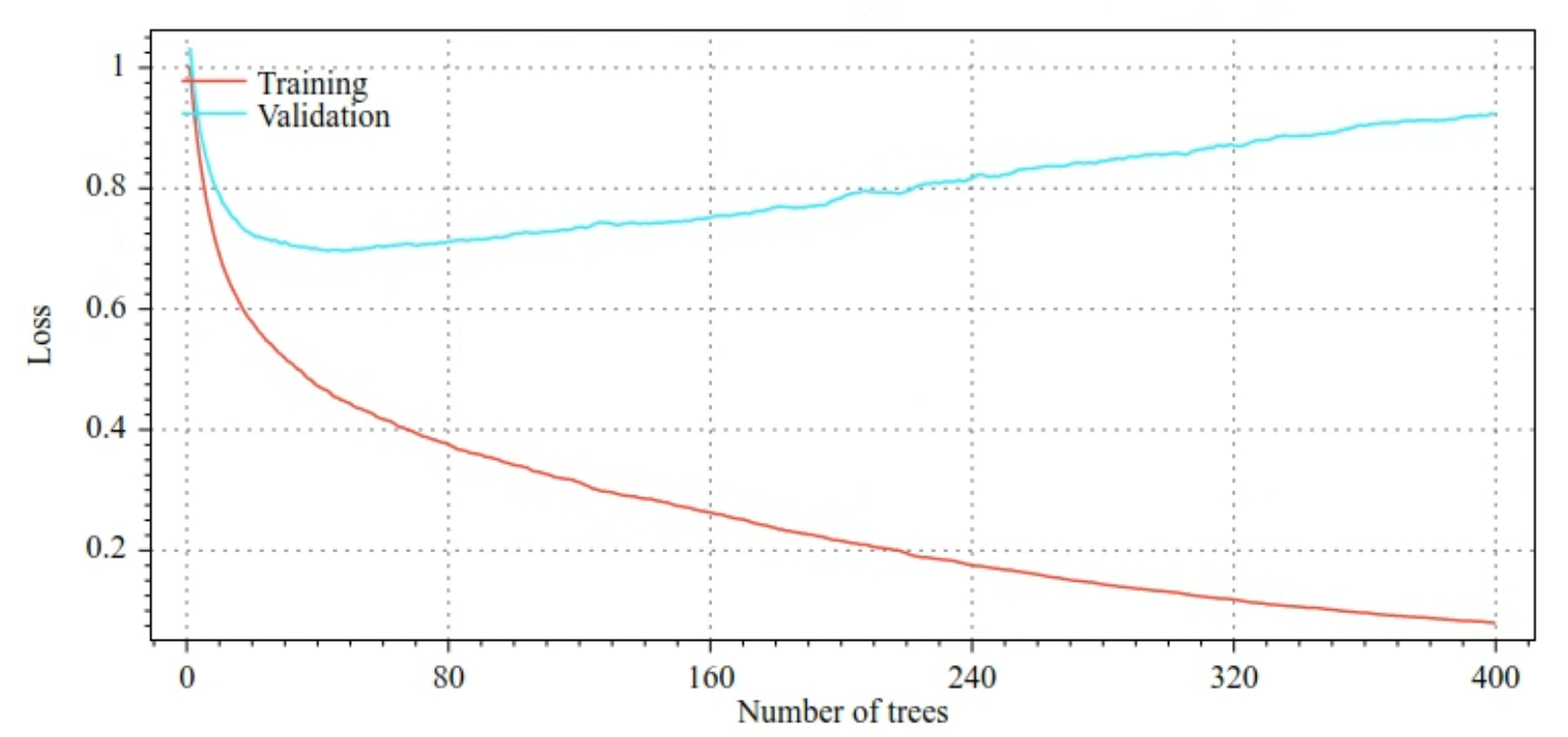

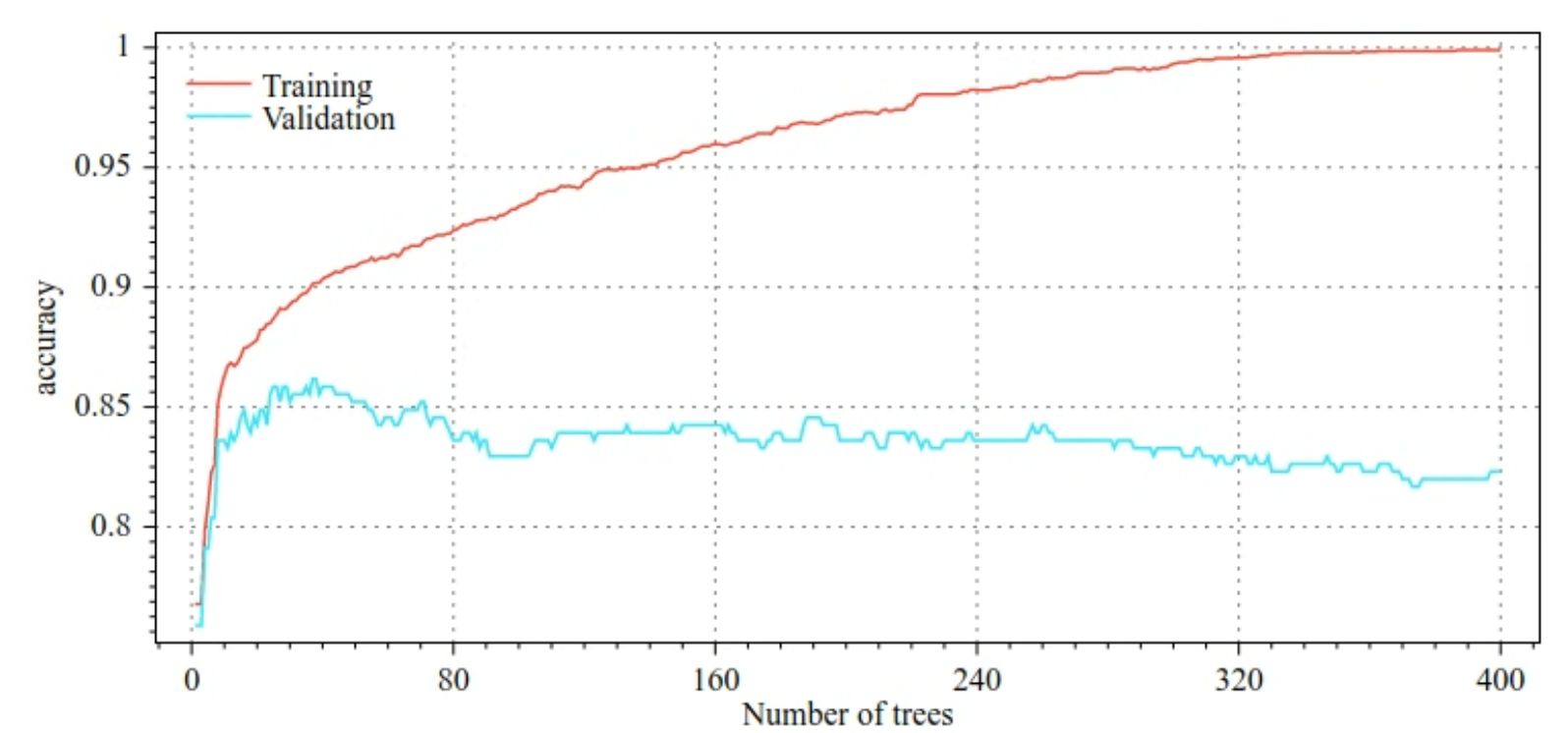

उदाहरण के लिए, नीचे दिए गए आंकड़े, GBT मॉडल को ट्रेनिंग देते समय, ट्रेनिंग और पुष्टि करने वाले सेट के लिए, लॉस और सटीक जानकारी वाले कर्व दिखाते हैं. ध्यान दें कि कर्व कितने अलग-अलग हैं, जिससे पता चलता है कि मॉडल का ओवरफ़िट होना ज़्यादा है.

29वां चित्र. लॉस बनाम डिसीज़न ट्री की संख्या.

30वीं इमेज. सटीक होने की दर बनाम डिसीज़न ट्री की संख्या.

ग्रेडिएंट बूस्ड ट्री के लिए सामान्य रेगुलराइज़ेशन पैरामीटर में ये शामिल हैं:

- ट्री डेटा स्ट्रक्चर की ज़्यादा से ज़्यादा गहराई.

- सिकुड़ने की दर.

- हर नोड पर टेस्ट किए गए एट्रिब्यूट का अनुपात.

- नुकसान पर L1 और L2 कोएफ़िशिएंट.

ध्यान दें कि आम तौर पर, डेसिज़न ट्री, रैंडम फ़ॉरेस्ट मॉडल की तुलना में बहुत कम डेटा पर काम करते हैं. डिफ़ॉल्ट रूप से, TF-DF में ग्रेडिएंट बूस्टर वाले ट्री को छठी लेवल तक बढ़ाया जाता है. ट्री डेटा Shallow होता है. इसलिए, हर लीफ़ के लिए कम से कम उदाहरणों की संख्या का कम असर पड़ता है और आम तौर पर इसे ट्यून नहीं किया जाता.

जब ट्रेनिंग के उदाहरणों की संख्या कम होती है, तब पुष्टि करने वाले डेटासेट की ज़रूरत होती है. इसलिए, क्रॉस-वैलिडेशन लूप में ग्रेडिएंट बूस्ड ट्री को ट्रेन करना आम बात है. इसके अलावा, जब मॉडल ओवरफ़िट न हो, तो ट्रेनिंग को जल्दी बंद करने की सुविधा बंद की जा सकती है.

इस्तेमाल का उदाहरण

पिछले चैप्टर में, हमने छोटे डेटासेट पर रैंडम फ़ॉरेस्ट को ट्रेन किया था. इस उदाहरण में, हम रेंडम फ़ॉरेस्ट मॉडल को ग्रेडिएंट बूस्ड ट्री मॉडल से बदल देंगे:

model = tfdf.keras.GradientBoostedTreesModel()

# Part of the training dataset will be used as validation (and removed

# from training).

model.fit(tf_train_dataset)

# The user provides the validation dataset.

model.fit(tf_train_dataset, validation_data=tf_valid_dataset)

# Disable early stopping and the validation dataset. All the examples are

# used for training.

model.fit(

tf_train_dataset,

validation_ratio=0.0,

early_stopping="NONE")

# Note: When "validation_ratio=0", early stopping is automatically disabled,

# so early_stopping="NONE" is redundant here.

इस्तेमाल और सीमाएं

ग्रेडिएंट बूस्ड ट्री मॉडल के कुछ फ़ायदे और नुकसान हैं.

फ़ायदे

- ये मशीन लर्निंग मॉडल, डिसीज़न ट्री की तरह ही संख्यात्मक और कैटगरी वाली वैल्यू के साथ काम करते हैं. साथ ही, आम तौर पर इनमें वैल्यू को पहले से प्रोसेस करने की ज़रूरत नहीं होती.

- ग्रेडिएंट बूस्ड ट्री में डिफ़ॉल्ट हाइपरपैरामीटर होते हैं, जो अक्सर बेहतर नतीजे देते हैं. हालांकि, उन हाइपरपैरामीटर को ट्यून करके, मॉडल को काफ़ी बेहतर बनाया जा सकता है.

- आम तौर पर, ग्रेडिएंट बूस्ड ट्री मॉडल छोटे होते हैं. इनमें नोड और मेमोरी की संख्या कम होती है. साथ ही, ये तेज़ी से काम करते हैं. आम तौर पर, एक या कुछ µs / उदाहरणों में ये काम कर लेते हैं.

नुकसान

- डिसिज़न ट्री को क्रम से ट्रेन किया जाना चाहिए. इससे ट्रेनिंग की प्रोसेस काफ़ी धीमी हो सकती है. हालांकि, ट्रेनिंग में लगने वाले समय में हुई कमी की वजह यह है कि डिसीज़न ट्री छोटे हैं.

- रेंडम फ़ॉरेस्ट की तरह, ग्रेडिएंट बूस्ड ट्री भी इंटरनल रेप्रज़ेंटेशन को सीख और फिर से इस्तेमाल नहीं कर सकते. हर डेसिज़न ट्री (और हर डेसिज़न ट्री की हर शाखा) को डेटासेट पैटर्न को फिर से सीखना होगा. कुछ डेटासेट में, खास तौर पर ऐसे डेटासेट जिनमें स्ट्रक्चर्ड डेटा (उदाहरण के लिए, इमेज, टेक्स्ट) नहीं होता है, इस वजह से ग्रेडिएंट बूस्ड ट्री, अन्य तरीकों की तुलना में खराब नतीजे दिखाते हैं.