على عكس الغابات العشوائية، يمكن أن تُظهر أشجار التضخيم التدرّجي ملاءمة زائدة. لذلك، بالنسبة إلى الشبكات العصبية، يمكنك تطبيق تقنيات التّنظيم والتوقف المبكر باستخدام مجموعة بيانات التحقّق.

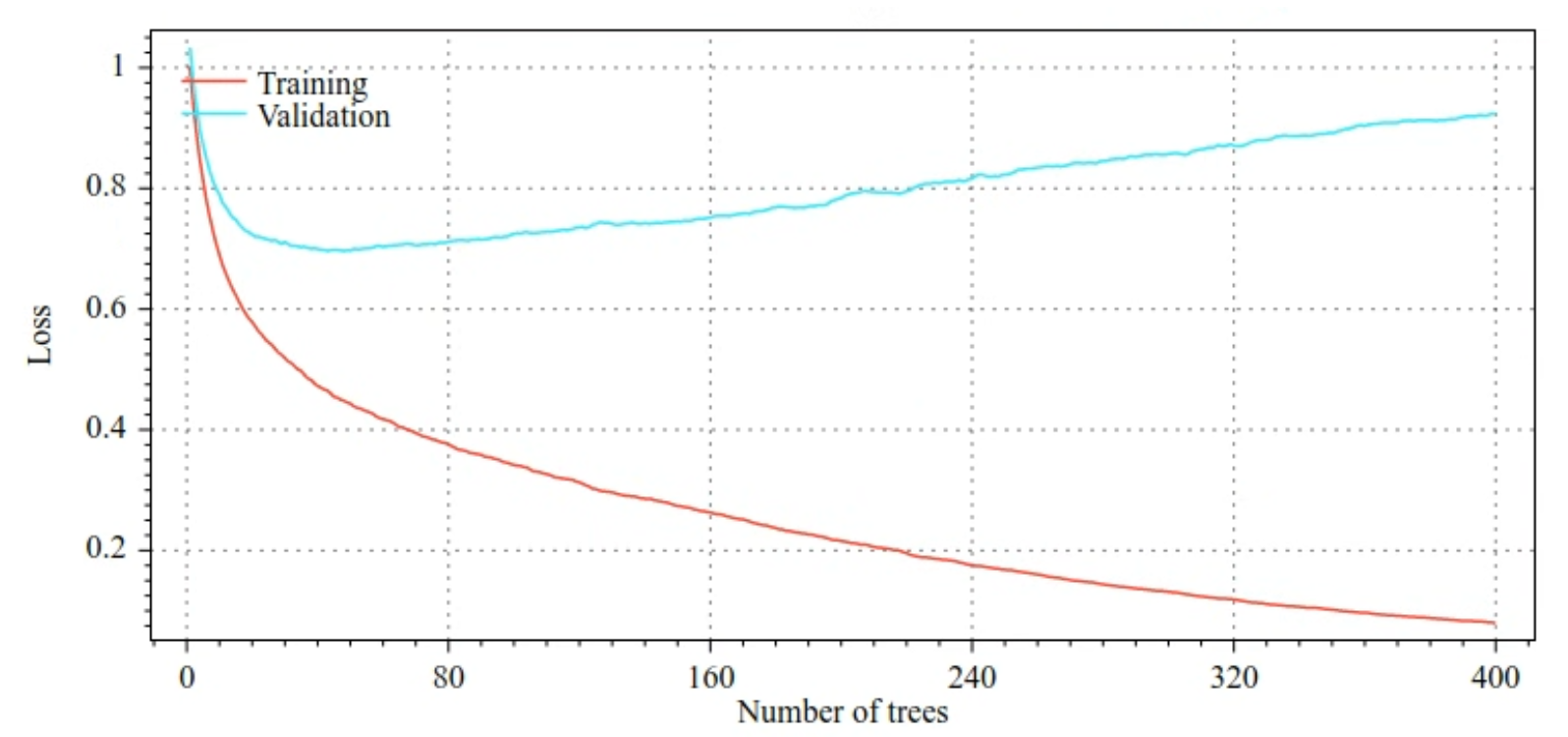

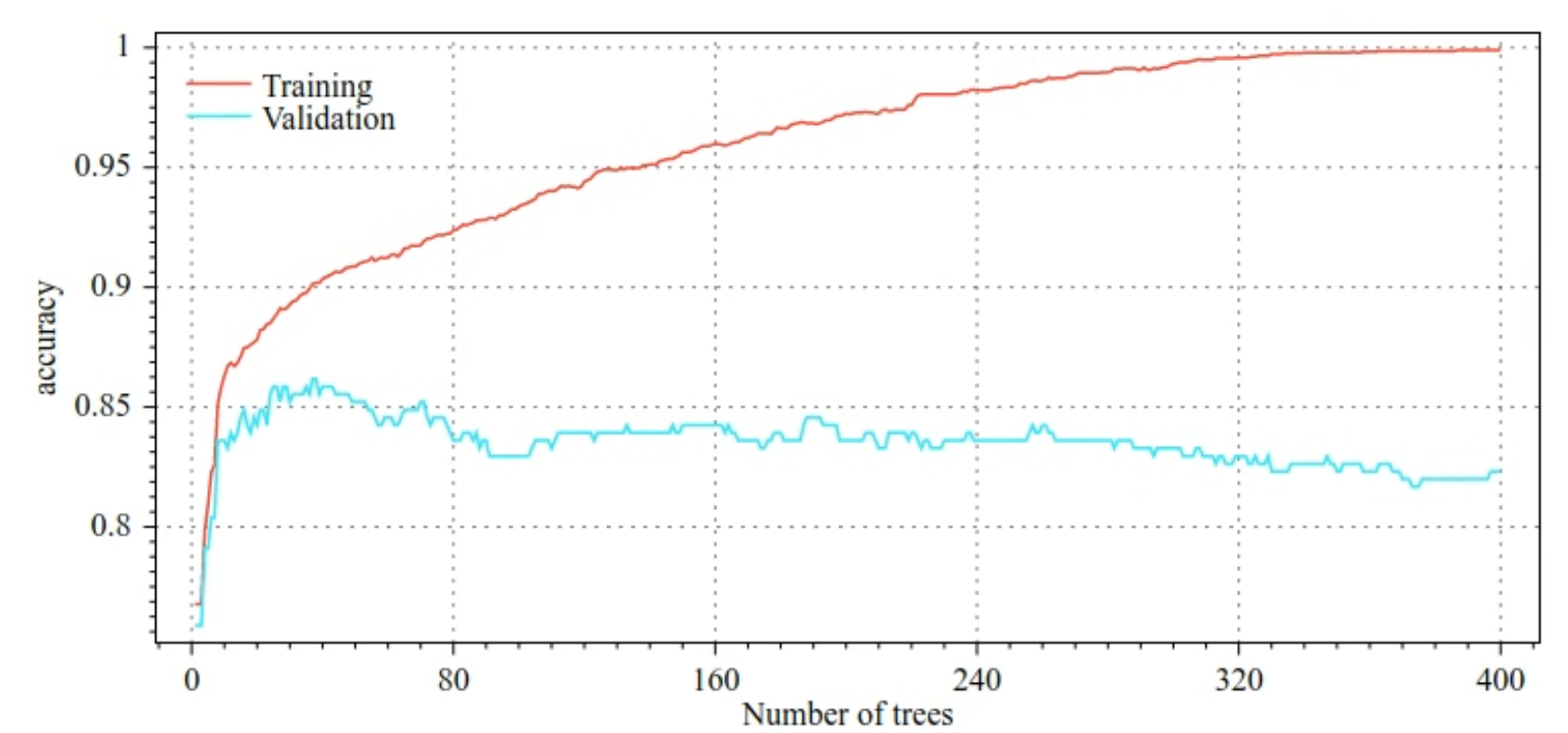

على سبيل المثال، تعرض الأشكال التالية منحنيات الخسارة والدقة لمجموعات التدريب والتحقّق عند تدريب نموذج GBT. لاحظ مدى اختلاف منحنيات الانحدار ، ما يشير إلى درجة عالية من التكيّف المفرط.

الشكل 29. الخسارة مقابل عدد أشجار القرارات

الشكل 30. الدقة في مقابل عدد أشجار القرارات

تشمل مَعلمات التنظيم الشائعة للأشجار المحسّنة بالانحدار ما يلي:

- الحد الأقصى لعمق الشجرة.

- معدّل الانكماش

- نسبة السمات التي تم اختبارها في كل عقدة

- معامل L1 وL2 للفقدان

تجدر الإشارة إلى أنّ أشجار القرار تنمو بشكل عام بشكلٍ أقل عمقًا من نماذج الغابة العشوائية. يتم تلقائيًا تطوير أشجار التعزيز التدرّجي في TF-DF إلى العمق 6. ولأنّ الأشجار سطحية، فإنّ الحدّ الأدنى لعدد الأمثلة لكل ورقة ليس له تأثير كبير ولا يتم ضبطه بشكل عام.

تُعدّ الحاجة إلى مجموعة بيانات التحقّق مشكلة عندما يكون عدد مثاليّات التدريب قليلاً. لذلك، من الشائع تدريب الأشجار المحسّنة باستخدام التدرّج ضمن حلقة التحقّق التبادلي، أو إيقاف الإيقاف المبكر عندما يكون من المعروف أنّ النموذج لا يتضمّن الكثير من التخصيص.

مثال على الاستخدام

في الفصل السابق، درّبنا غابة عشوائية على مجموعة بيانات صغيرة. في هذا المثال، سنستبدل نموذج الغابة العشوائية بنموذج أشجار شجرية محسَّنة بالتعزيز التدرّجي:

model = tfdf.keras.GradientBoostedTreesModel()

# Part of the training dataset will be used as validation (and removed

# from training).

model.fit(tf_train_dataset)

# The user provides the validation dataset.

model.fit(tf_train_dataset, validation_data=tf_valid_dataset)

# Disable early stopping and the validation dataset. All the examples are

# used for training.

model.fit(

tf_train_dataset,

validation_ratio=0.0,

early_stopping="NONE")

# Note: When "validation_ratio=0", early stopping is automatically disabled,

# so early_stopping="NONE" is redundant here.

الاستخدام والقيود

تتضمّن الأشجار المحسّنة بالانحدار بعض الإيجابيات والسلبيات.

الإيجابيات

- مثل أشجار القرار، تتيح هذه النماذج بشكلٍ أساسي استخدام السمات الرقمية والفئوية، ولا تحتاج في أغلب الأحيان إلى معالجة مسبقة للسمات.

- تحتوي الأشجار المحسّنة بالانحدار على مَعلمات متغيرة افتراضية تحقّق في أغلب الأحيان نتائج رائعة. ومع ذلك، يمكن أن يؤدي ضبط هذه المَعلمات الفائقة إلى تحسين النموذج بشكل كبير.

- تكون نماذج الأشجار المحسّنة بالانحدار عادةً صغيرة (من حيث عدد العقد و الذاكرة) وسريعة التشغيل (غالبًا ما تستغرق ملي ثانية واحدة أو بضع ملي ثوانٍ لكل مثال).

السلبيات

- يجب تدريب أشجار القرارات بشكل تسلسلي، ما قد يؤدي إلى إبطاء عملية التدريب بشكل كبير. ومع ذلك، يتم تعويض تباطؤ التدريب إلى حدّ ما من خلال كون شجرات الاختيار أصغر حجمًا.

- مثل الغابات العشوائية، لا يمكن للأشجار المحسّنة بالانحدار التعلّم من التمثيلات العميقة وإعادة استخدامها. يجب أن تعيد كل شجرة قرارات (وكل فرع من كل شجرة قرارات) تعلم نمط مجموعة البيانات. في بعض مجموعات البيانات، لا سيّما مجموعات البيانات التي تحتوي على بيانات غير منظَّمة (مثل الصور والنصوص)، يؤدي ذلك إلى عرض شجرات الصعودي المعزّز نتائج أسوأ من الطرق الأخرى.