এলোমেলো বনের বিপরীতে, গ্রেডিয়েন্ট বুস্টেড গাছ ওভারফিট করতে পারে । অতএব, নিউরাল নেটওয়ার্কগুলির জন্য, আপনি একটি বৈধতা ডেটাসেট ব্যবহার করে নিয়মিতকরণ এবং তাড়াতাড়ি বন্ধ করার আবেদন করতে পারেন।

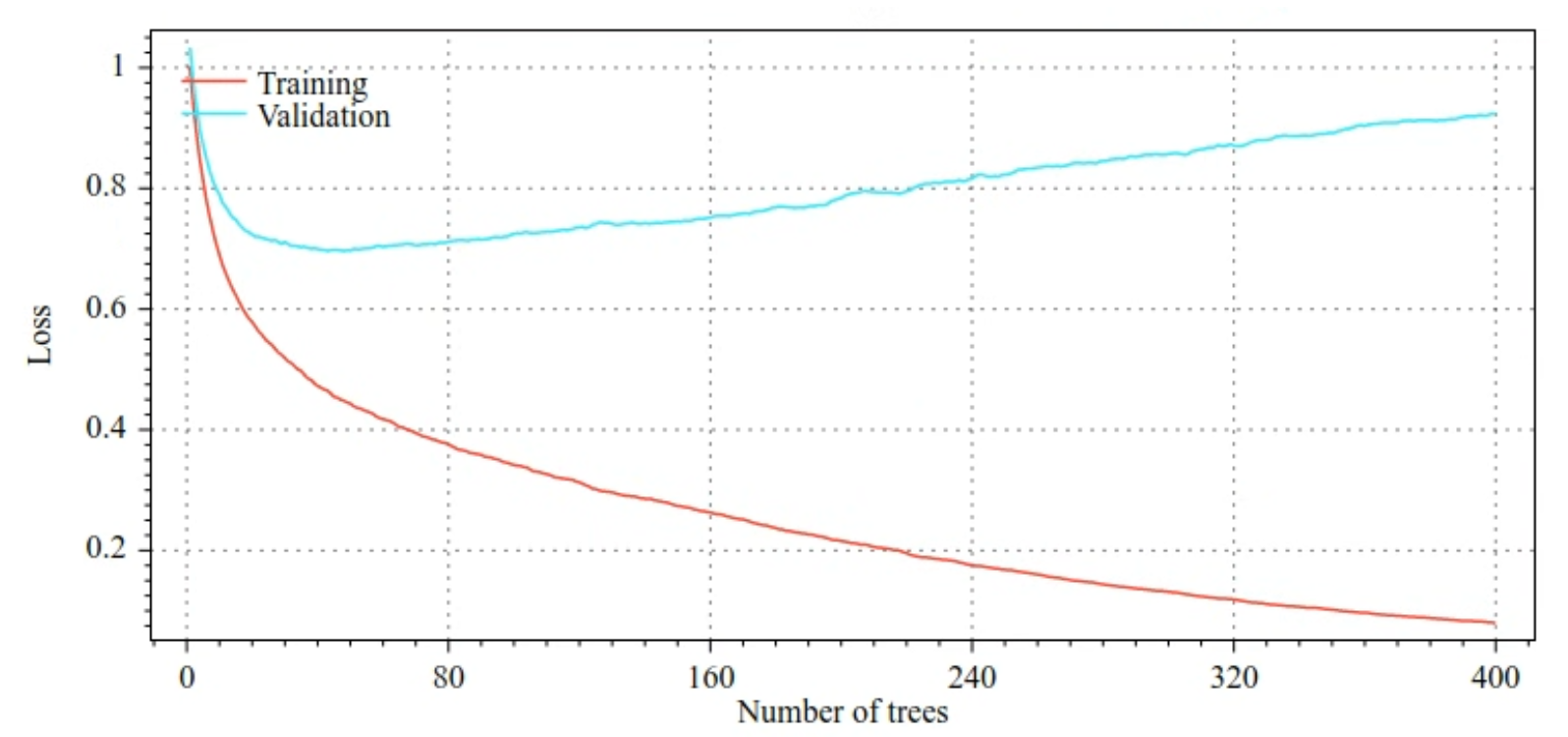

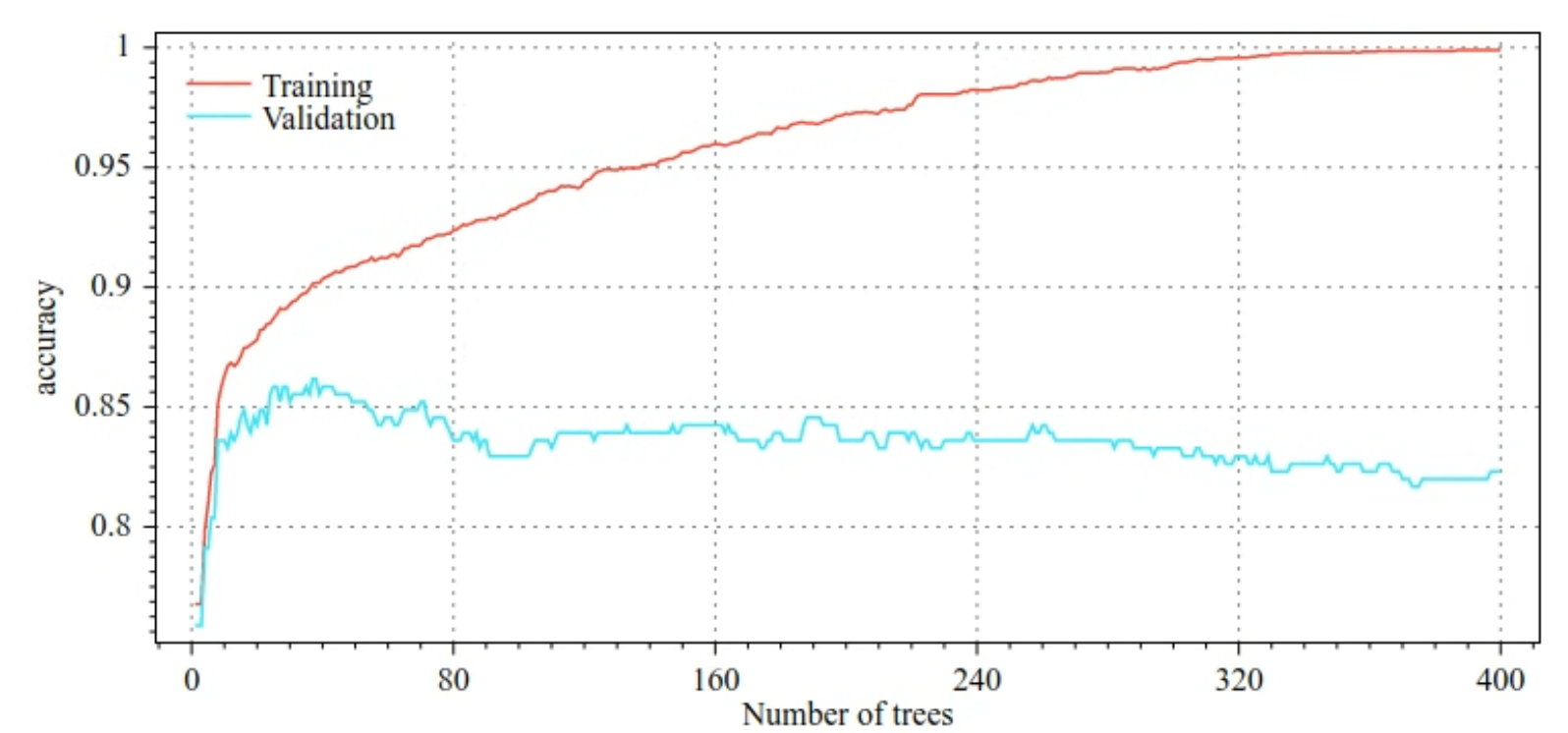

উদাহরণস্বরূপ, নিম্নলিখিত পরিসংখ্যানগুলি একটি GBT মডেলকে প্রশিক্ষণ দেওয়ার সময় প্রশিক্ষণ এবং বৈধতা সেটের জন্য ক্ষতি এবং নির্ভুলতা বক্ররেখা দেখায়। বক্ররেখাগুলি কতটা বিচ্ছিন্ন তা লক্ষ্য করুন, যা উচ্চ মাত্রার ওভারফিটিং নির্দেশ করে৷

চিত্র 29. ক্ষতি বনাম সিদ্ধান্ত গাছের সংখ্যা।

চিত্র 30. নির্ভুলতা বনাম সিদ্ধান্ত গাছের সংখ্যা।

গ্রেডিয়েন্ট বুস্টেড গাছের জন্য সাধারণ নিয়মিতকরণের পরামিতিগুলির মধ্যে রয়েছে:

- গাছের সর্বোচ্চ গভীরতা।

- সংকোচনের হার।

- প্রতিটি নোডে পরীক্ষা করা গুণাবলীর অনুপাত।

- ক্ষতির উপর L1 এবং L2 সহগ।

নোট করুন যে সিদ্ধান্ত গাছ সাধারণত এলোমেলো বন মডেলের তুলনায় অনেক অগভীর বৃদ্ধি পায়। ডিফল্টরূপে, TF-DF-এ গ্রেডিয়েন্ট বুস্টেড ট্রিস গাছগুলি গভীরতা 6-এ বেড়ে ওঠে৷ গাছগুলি অগভীর হওয়ার কারণে, প্রতি পাতায় ন্যূনতম সংখ্যক উদাহরণের সামান্য প্রভাব পড়ে এবং সাধারণত টিউন করা হয় না৷

প্রশিক্ষণের উদাহরণের সংখ্যা কম হলে একটি বৈধতা ডেটাসেটের প্রয়োজন একটি সমস্যা। অতএব, ক্রস-ভ্যালিডেশন লুপের ভিতরে গ্রেডিয়েন্ট বুস্টেড ট্রিগুলিকে প্রশিক্ষণ দেওয়া, বা মডেলটি ওভারফিট না জানার সময় তাড়াতাড়ি থামানো অক্ষম করা সাধারণ।

ব্যবহারের উদাহরণ

পূর্ববর্তী অধ্যায়ে, আমরা একটি ছোট ডেটাসেটে একটি এলোমেলো বনকে প্রশিক্ষণ দিয়েছি। এই উদাহরণে, আমরা র্যান্ডম ফরেস্ট মডেলটিকে গ্রেডিয়েন্ট বুস্টেড ট্রিস মডেল দিয়ে প্রতিস্থাপন করব:

model = tfdf.keras.GradientBoostedTreesModel()

# Part of the training dataset will be used as validation (and removed

# from training).

model.fit(tf_train_dataset)

# The user provides the validation dataset.

model.fit(tf_train_dataset, validation_data=tf_valid_dataset)

# Disable early stopping and the validation dataset. All the examples are

# used for training.

model.fit(

tf_train_dataset,

validation_ratio=0.0,

early_stopping="NONE")

# Note: When "validation_ratio=0", early stopping is automatically disabled,

# so early_stopping="NONE" is redundant here.

ব্যবহার এবং সীমাবদ্ধতা

গ্রেডিয়েন্ট বুস্টেড গাছের কিছু সুবিধা এবং অসুবিধা রয়েছে।

পেশাদার

- সিদ্ধান্ত গাছের মতো, তারা স্থানীয়ভাবে সংখ্যাসূচক এবং শ্রেণীবদ্ধ বৈশিষ্ট্যগুলিকে সমর্থন করে এবং প্রায়শই বৈশিষ্ট্য প্রাক-প্রক্রিয়াকরণের প্রয়োজন হয় না।

- গ্রেডিয়েন্ট বুস্টেড ট্রিতে ডিফল্ট হাইপারপ্যারামিটার থাকে যা প্রায়শই দুর্দান্ত ফলাফল দেয়। তবুও, এই হাইপারপ্যারামিটারগুলিকে টিউন করা মডেলটিকে উল্লেখযোগ্যভাবে উন্নত করতে পারে।

- গ্রেডিয়েন্ট বুস্টেড ট্রি মডেলগুলি সাধারণত ছোট (নোডের সংখ্যা এবং মেমরিতে) এবং দ্রুত চালানো হয় (প্রায়শই মাত্র এক বা কয়েকটি µs/উদাহরণ)।

কনস

- সিদ্ধান্ত গাছগুলিকে অবশ্যই ক্রমানুসারে প্রশিক্ষণ দেওয়া উচিত, যা প্রশিক্ষণকে যথেষ্ট ধীর করতে পারে। যাইহোক, সিদ্ধান্ত গাছ ছোট হওয়ার কারণে প্রশিক্ষণের মন্থরতা কিছুটা পূরণ হয়।

- এলোমেলো বনের মতো, গ্রেডিয়েন্ট বুস্ট করা গাছ অভ্যন্তরীণ উপস্থাপনা শিখতে এবং পুনরায় ব্যবহার করতে পারে না। প্রতিটি সিদ্ধান্ত গাছ (এবং প্রতিটি সিদ্ধান্ত গাছের প্রতিটি শাখা) অবশ্যই ডেটাসেট প্যাটার্ন পুনরায় শিখতে হবে। কিছু ডেটাসেটে, বিশেষত অসংগঠিত ডেটা সহ ডেটাসেট (উদাহরণস্বরূপ, চিত্র, পাঠ্য), এটি গ্রেডিয়েন্ট বুস্ট করা গাছগুলিকে অন্যান্য পদ্ধতির তুলনায় খারাপ ফলাফল দেখায়।