এলোমেলো বন

একটি এলোমেলো বন ( আরএফ ) সিদ্ধান্ত গাছের একটি সংকলন যেখানে প্রতিটি সিদ্ধান্ত গাছ একটি নির্দিষ্ট এলোমেলো শব্দের সাথে প্রশিক্ষিত হয়। এলোমেলো বন হল সিদ্ধান্ত গাছের সমাহারের সবচেয়ে জনপ্রিয় রূপ। এই ইউনিটটি একটি কার্যকর এলোমেলো বন নির্মাণের সম্ভাবনাগুলিকে উন্নত করার জন্য স্বাধীন সিদ্ধান্ত গাছ তৈরির জন্য বিভিন্ন কৌশল নিয়ে আলোচনা করে।

ব্যাগিং

ব্যাগিং ( b ootstrap agg regat ing ) মানে প্রতিটি সিদ্ধান্ত গাছকে প্রশিক্ষণ সেটের উদাহরণগুলির একটি এলোমেলো উপসেটে প্রশিক্ষণ দেওয়া। অন্য কথায়, এলোমেলো বনের প্রতিটি সিদ্ধান্ত গাছকে উদাহরণের একটি ভিন্ন উপসেটে প্রশিক্ষণ দেওয়া হয়।

ব্যাগিং অদ্ভুত। প্রতিটি সিদ্ধান্ত গাছকে মূল প্রশিক্ষণ সেটের মতো একই সংখ্যক উদাহরণে প্রশিক্ষণ দেওয়া হয়। উদাহরণস্বরূপ, যদি মূল প্রশিক্ষণ সেটে 60টি উদাহরণ থাকে, তাহলে প্রতিটি সিদ্ধান্ত গাছকে 60টি উদাহরণের উপর প্রশিক্ষণ দেওয়া হয়। যাইহোক, ব্যাগিং শুধুমাত্র এই উদাহরণগুলির একটি উপসেটে প্রতিটি সিদ্ধান্ত গাছকে প্রশিক্ষণ দেয় (সাধারণত, 67%)। সুতরাং, একটি প্রদত্ত সিদ্ধান্ত ট্রি প্রশিক্ষণের সময় উপসেটের সেই 40টি উদাহরণের মধ্যে কয়েকটি অবশ্যই পুনরায় ব্যবহার করা উচিত। এই পুনঃব্যবহারকে "প্রতিস্থাপন সহ" প্রশিক্ষণ বলা হয়।

উদাহরণ স্বরূপ, ছক 6 দেখায় কিভাবে ব্যাগিং তিনটি সিদ্ধান্ত গাছ জুড়ে ছয়টি উদাহরণ বিতরণ করতে পারে। নিম্নলিখিত লক্ষ্য করুন:

- প্রতিটি সিদ্ধান্ত গাছ মোট ছয়টি উদাহরণের উপর প্রশিক্ষণ দেয়।

- প্রতিটি সিদ্ধান্ত গাছ উদাহরণের একটি ভিন্ন সেটে প্রশিক্ষণ দেয়।

- প্রতিটি সিদ্ধান্ত গাছ নির্দিষ্ট উদাহরণ পুনরায় ব্যবহার করে। উদাহরণস্বরূপ, উদাহরণ #4 প্রশিক্ষণ সিদ্ধান্ত ট্রি 1 এ দুবার ব্যবহার করা হয়েছে; সুতরাং, উদাহরণ #4 এর শেখা ওজন কার্যকরভাবে সিদ্ধান্ত ট্রি 1 এ দ্বিগুণ করা হয়েছে।

সারণি 6. তিনটি সিদ্ধান্ত গাছ জুড়ে ছয়টি প্রশিক্ষণের উদাহরণ ব্যাগ করা। প্রতিটি সংখ্যা একটি প্রদত্ত প্রশিক্ষণের উদাহরণ (#1-6) একটি প্রদত্ত সিদ্ধান্ত গাছের প্রশিক্ষণ ডেটাসেটে (1-3) বারবার পুনরাবৃত্তি হয় তার সংখ্যা উপস্থাপন করে।

| প্রশিক্ষণ উদাহরণ | ||||||

|---|---|---|---|---|---|---|

| #1 | #2 | #3 | #4 | #5 | #6 | |

| মূল ডেটাসেট | 1 | 1 | 1 | 1 | 1 | 1 |

| সিদ্ধান্ত গাছ 1 | 1 | 1 | 0 | 2 | 1 | 1 |

| সিদ্ধান্ত গাছ 2 | 3 | 0 | 1 | 0 | 2 | 0 |

| সিদ্ধান্ত গাছ 3 | 0 | 1 | 3 | 1 | 0 | 1 |

ব্যাগিংয়ের ক্ষেত্রে, প্রতিটি সিদ্ধান্ত গাছকে প্রায় সবসময়ই মূল প্রশিক্ষণ সেটের মোট উদাহরণের উপর প্রশিক্ষণ দেওয়া হয়। প্রতিটি সিদ্ধান্ত গাছকে আরও উদাহরণ বা কম উদাহরণের উপর প্রশিক্ষণ দেওয়া এলোমেলো বনের গুণমানকে হ্রাস করে।

মূল র্যান্ডম ফরেস্ট পেপারে উপস্থিত না থাকলেও, উদাহরণগুলির নমুনা কখনও কখনও "প্রতিস্থাপন ছাড়া" করা হয়; অর্থাৎ, একটি সিদ্ধান্ত গাছ প্রশিক্ষণ সেটে একটি প্রশিক্ষণ উদাহরণ একাধিকবার উপস্থিত হতে পারে না। উদাহরণস্বরূপ, পূর্ববর্তী সারণিতে, সমস্ত মান 0 বা 1 হবে।

bootstrap_training_dataset=Falseঅ্যাট্রিবিউট স্যাম্পলিং

অ্যাট্রিবিউট স্যাম্পলিং এর অর্থ হল যে সমস্ত উপলব্ধ বৈশিষ্ট্যগুলির উপর সর্বোত্তম অবস্থার সন্ধান করার পরিবর্তে, প্রতিটি নোডে বৈশিষ্ট্যগুলির একটি র্যান্ডম উপসেট পরীক্ষা করা হয়। পরীক্ষিত বৈশিষ্ট্যের সেট সিদ্ধান্ত গাছের প্রতিটি নোডে এলোমেলোভাবে নমুনা করা হয়।

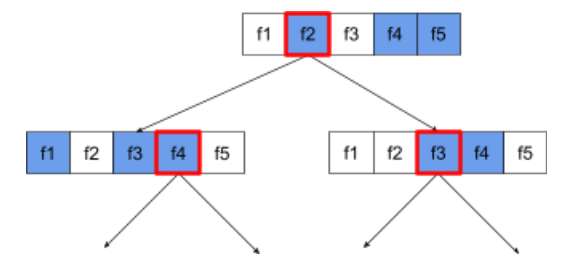

নিম্নলিখিত সিদ্ধান্ত গাছ বৈশিষ্ট্য / বৈশিষ্ট্য নমুনা চিত্রিত. এখানে একটি সিদ্ধান্ত গাছকে 5টি বৈশিষ্ট্যের (f1-f5) উপর প্রশিক্ষণ দেওয়া হয়। নীল নোডগুলি পরীক্ষিত বৈশিষ্ট্যগুলি উপস্থাপন করে যখন সাদাগুলি পরীক্ষা করা হয় না। শর্তটি সর্বোত্তম পরীক্ষিত বৈশিষ্ট্যগুলি থেকে তৈরি করা হয়েছে (লাল রূপরেখা দিয়ে উপস্থাপিত)।

চিত্র 21. অ্যাট্রিবিউট স্যাম্পলিং।

অ্যাট্রিবিউট স্যাম্পলিং এর অনুপাত একটি গুরুত্বপূর্ণ নিয়মিতকরণ হাইপারপ্যারামিটার। পূর্ববর্তী চিত্র একটি ~⅗ অনুপাত ব্যবহার করেছে৷ অনেক র্যান্ডম ফরেস্ট ইমপ্লিমেন্টেশন পরীক্ষা, ডিফল্টভাবে, রিগ্রেশনের জন্য বৈশিষ্ট্যের 1/3 এবং শ্রেণীবিভাগের জন্য sqrt (বৈশিষ্ট্যের সংখ্যা)।

TF-DF-তে, নিম্নলিখিত হাইপারপ্যারামিটার অ্যাট্রিবিউট স্যাম্পলিং নিয়ন্ত্রণ করে:

-

num_candidate_attributes -

num_candidate_attributes_ratio

উদাহরণস্বরূপ, num_candidate_attributes_ratio=0.5 হলে, প্রতিটি নোডে অর্ধেক বৈশিষ্ট্য পরীক্ষা করা হবে।

সিদ্ধান্ত গাছ নিয়মিতকরণ অক্ষম করা

এলোমেলো বনের ব্যক্তিগত সিদ্ধান্ত গাছ ছাঁটাই ছাড়াই প্রশিক্ষণ দেওয়া হয়। ( ওভারফিটিং এবং ছাঁটাই দেখুন)। এটি দুর্বল ভবিষ্যদ্বাণীমূলক গুণমান সহ অত্যধিক জটিল গাছ উত্পাদন করে। পৃথক গাছ নিয়মিত করার পরিবর্তে, গাছগুলি আরও সঠিক সামগ্রিক ভবিষ্যদ্বাণী উত্পাদন করে।

আমরা আশা করি একটি এলোমেলো বনের প্রশিক্ষণ এবং পরীক্ষার নির্ভুলতা ভিন্ন হবে। একটি এলোমেলো বনের প্রশিক্ষণের নির্ভুলতা সাধারণত অনেক বেশি (কখনও কখনও 100% এর সমান)। যাইহোক, একটি এলোমেলো বনে একটি খুব উচ্চ প্রশিক্ষণের নির্ভুলতা স্বাভাবিক এবং এটি নির্দেশ করে না যে এলোমেলো বন ওভারফিট করা হয়েছে।

এলোমেলোতার দুটি উত্স (ব্যাগিং এবং অ্যাট্রিবিউট স্যাম্পলিং) সিদ্ধান্ত গাছের মধ্যে আপেক্ষিক স্বাধীনতা নিশ্চিত করে। এই স্বাধীনতা স্বতন্ত্র সিদ্ধান্ত গাছের অতিরিক্ত ফিটিং সংশোধন করে। ফলস্বরূপ, ensemble overfitted হয় না. আমরা পরবর্তী ইউনিটে এই অ-স্বজ্ঞাত প্রভাবটি চিত্রিত করব।

বিশুদ্ধ এলোমেলো বন সর্বাধিক গভীরতা বা পাতা প্রতি ন্যূনতম সংখ্যক পর্যবেক্ষণ ছাড়াই ট্রেন করে। অনুশীলনে, প্রতি পাতায় সর্বোচ্চ গভীরতা এবং ন্যূনতম সংখ্যক পর্যবেক্ষণ সীমিত করা উপকারী। ডিফল্টরূপে, অনেক এলোমেলো বন নিম্নলিখিত ডিফল্ট ব্যবহার করে:

- সর্বাধিক গভীরতা ~16

- ~5 পাতা প্রতি পর্যবেক্ষণের সর্বনিম্ন সংখ্যা।

আপনি এই hyperparameters টিউন করতে পারেন.

শব্দের স্বচ্ছতা

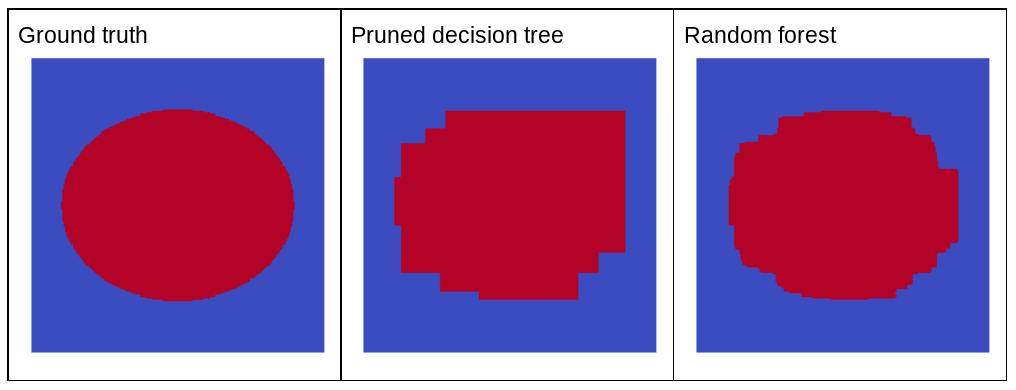

কেন এলোমেলো শব্দ একটি এলোমেলো বনের গুণমান উন্নত করবে? এলোমেলো শব্দের সুবিধাগুলি ব্যাখ্যা করার জন্য, চিত্র 22 একটি উপবৃত্তাকার প্যাটার্ন সহ সাধারণ দ্বি-মাত্রিক সমস্যার কয়েকটি উদাহরণের উপর প্রশিক্ষিত একটি ধ্রুপদী (ছাঁটা) সিদ্ধান্ত গাছ এবং একটি এলোমেলো বনের পূর্বাভাস দেখায়।

ডিসিশন ট্রি এবং ডিসিশন ফরেস্ট অ্যালগরিদম অক্ষ-সারিবদ্ধ অবস্থার সাথে শিখতে উপবৃত্তাকার প্যাটার্নগুলি কুখ্যাতভাবে কঠিন, তাই তারা একটি ভাল উদাহরণ তৈরি করে। লক্ষ্য করুন যে ছাঁটাই করা সিদ্ধান্ত গাছটি এলোমেলো বনের মতো ভবিষ্যদ্বাণীর একই গুণমান পেতে পারে না।

চিত্র 22. গ্রাউন্ড ট্রুথ বনাম ভবিষ্যদ্বাণী একটি একক ছাঁটাই করা সিদ্ধান্ত গাছ দ্বারা উত্পন্ন এবং একটি এলোমেলো বন দ্বারা উত্পন্ন ভবিষ্যদ্বাণী৷

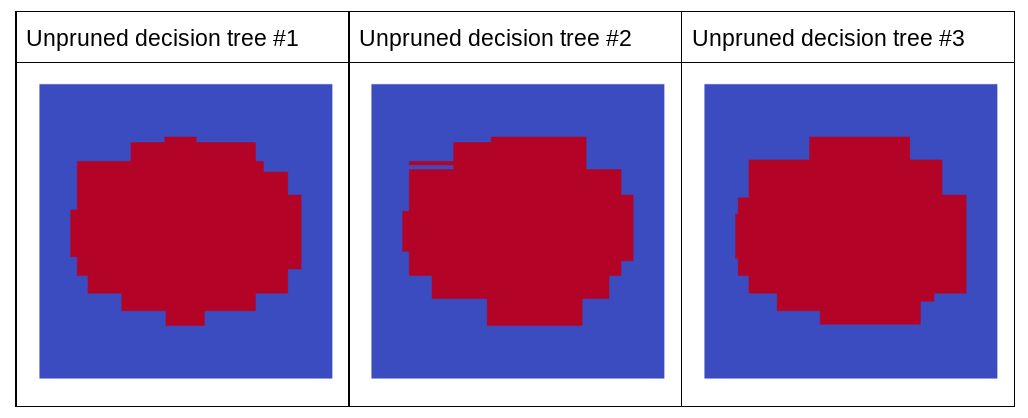

পরবর্তী প্লট এলোমেলো বনের প্রথম তিনটি ছাঁটাই করা সিদ্ধান্ত গাছের ভবিষ্যদ্বাণী দেখায়; অর্থাৎ, সিদ্ধান্ত বৃক্ষগুলিকে এর সংমিশ্রণে প্রশিক্ষিত করা হয়:

- ব্যাগিং

- বৈশিষ্ট্য নমুনা

- ছাঁটাই অক্ষম করা

লক্ষ্য করুন যে এই তিনটি সিদ্ধান্ত গাছের পৃথক ভবিষ্যদ্বাণী পূর্ববর্তী চিত্রে ছাঁটাই করা সিদ্ধান্ত গাছের ভবিষ্যদ্বাণীগুলির চেয়ে খারাপ । যাইহোক, যেহেতু স্বতন্ত্র সিদ্ধান্ত গাছের ত্রুটিগুলি শুধুমাত্র দুর্বলভাবে সম্পর্কযুক্ত, তাই তিনটি সিদ্ধান্ত গাছ কার্যকর ভবিষ্যদ্বাণী তৈরি করতে একত্রিত হয়।

চিত্র 23. তিনটি ছাঁটাই না করা সিদ্ধান্ত গাছ যা একটি কার্যকরী সংযোজন তৈরি করবে।

যেহেতু একটি এলোমেলো বনের সিদ্ধান্ত গাছগুলি ছাঁটাই করা হয় না, একটি এলোমেলো বন প্রশিক্ষণের জন্য একটি বৈধতা ডেটাসেটের প্রয়োজন হয় না৷ অনুশীলনে, এবং বিশেষত ছোট ডেটাসেটে, মডেলগুলিকে সমস্ত উপলব্ধ ডেটার উপর প্রশিক্ষণ দেওয়া উচিত।

যখন একটি এলোমেলো বন প্রশিক্ষণ, আরো সিদ্ধান্ত গাছ যোগ করা হয়, ত্রুটি প্রায় সবসময় কমে যায়; যে, মডেলের গুণমান প্রায় সবসময় উন্নত হয়। হ্যাঁ, আরো সিদ্ধান্ত গাছ যোগ করা প্রায় সবসময় এলোমেলো বনের ত্রুটি হ্রাস করে । অন্য কথায়, আরো সিদ্ধান্ত গাছ যোগ করা এলোমেলো বন ওভারফিট হতে পারে না. কিছু সময়ে, মডেলটি উন্নতি করা বন্ধ করে দেয়। লিও ব্রেইম্যান বিখ্যাতভাবে বলেছিলেন, " এলোমেলো বনগুলি অত্যধিক উপযুক্ত হয় না, কারণ আরও গাছ যুক্ত হয় "।

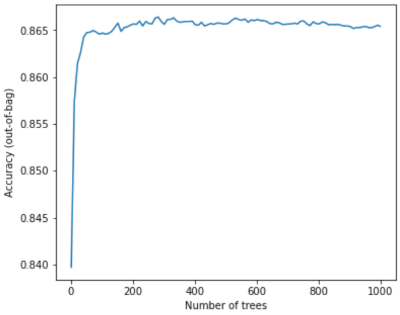

উদাহরণস্বরূপ, নিম্নলিখিত প্লটটি একটি এলোমেলো বন মডেলের পরীক্ষা মূল্যায়ন দেখায় কারণ আরও সিদ্ধান্ত গাছ যোগ করা হয়েছে। 0.865 এর কাছাকাছি মালভূমি না হওয়া পর্যন্ত নির্ভুলতা দ্রুত উন্নত হয়। যাইহোক, আরো সিদ্ধান্ত গাছ যোগ করা সঠিকতা হ্রাস করে না; অন্য কথায়, মডেল ওভারফিট না. এই আচরণটি (বেশিরভাগ) সর্বদা সত্য এবং হাইপারপ্যারামিটার থেকে স্বাধীন।

চিত্র 24. নির্ভুলতা স্থির থাকে কারণ এলোমেলো বনে আরও সিদ্ধান্ত গাছ যুক্ত হয়।