এই পৃষ্ঠায় জেনারেটিভ এআই শব্দকোষের শব্দাবলী রয়েছে। সমস্ত শব্দকোষের শব্দাবলীর জন্য, এখানে ক্লিক করুন ।

ক

অভিযোজন

টিউনিং বা ফাইন-টিউনিংয়ের সমার্থক শব্দ।

এজেন্ট

এমন সফ্টওয়্যার যা ব্যবহারকারীর পক্ষে কর্ম পরিকল্পনা এবং সম্পাদনের জন্য মাল্টিমোডাল ব্যবহারকারীর ইনপুট সম্পর্কে যুক্তি দিতে পারে।

রিইনফোর্সমেন্ট লার্নিং- এ, এজেন্ট হল সেই সত্তা যা পরিবেশের বিভিন্ন অবস্থার মধ্যে পরিবর্তন থেকে প্রাপ্ত প্রত্যাশিত রিটার্ন সর্বাধিক করার জন্য একটি নীতি ব্যবহার করে।

এজেন্টিক

এজেন্টের বিশেষণ রূপ। এজেন্টিক বলতে এজেন্টদের (যেমন স্বায়ত্তশাসন) গুণাবলী বোঝায়।

এজেন্টিক ওয়ার্কফ্লো

একটি গতিশীল প্রক্রিয়া যেখানে একজন এজেন্ট স্বায়ত্তশাসিতভাবে একটি লক্ষ্য অর্জনের জন্য কর্ম পরিকল্পনা এবং সম্পাদন করে। এই প্রক্রিয়ায় যুক্তি, বাহ্যিক সরঞ্জাম ব্যবহার এবং তার পরিকল্পনা স্ব-সংশোধন অন্তর্ভুক্ত থাকতে পারে।

এআই স্লপ

একটি জেনারেটিভ এআই সিস্টেম থেকে আউটপুট যা মানের চেয়ে পরিমাণকে বেশি প্রাধান্য দেয়। উদাহরণস্বরূপ, এআই স্লপ সহ একটি ওয়েব পৃষ্ঠা সস্তায় উৎপাদিত, এআই-উত্পাদিত, নিম্নমানের সামগ্রী দিয়ে পূর্ণ।

স্বয়ংক্রিয় মূল্যায়ন

একটি মডেলের আউটপুটের মান বিচার করার জন্য সফ্টওয়্যার ব্যবহার করা।

যখন মডেল আউটপুট তুলনামূলকভাবে সহজ হয়, তখন একটি স্ক্রিপ্ট বা প্রোগ্রাম মডেলের আউটপুটকে একটি সুবর্ণ প্রতিক্রিয়ার সাথে তুলনা করতে পারে। এই ধরণের স্বয়ংক্রিয় মূল্যায়নকে কখনও কখনও প্রোগ্রাম্যাটিক মূল্যায়ন বলা হয়। ROUGE বা BLEU এর মতো মেট্রিক্স প্রায়শই প্রোগ্রাম্যাটিক মূল্যায়নের জন্য কার্যকর।

যখন মডেল আউটপুট জটিল হয় বা কোন সঠিক উত্তর না থাকে, তখন অটোরেটর নামক একটি পৃথক ML প্রোগ্রাম কখনও কখনও স্বয়ংক্রিয় মূল্যায়ন সম্পাদন করে।

মানুষের মূল্যায়নের সাথে তুলনা করুন।

অটোরেটর মূল্যায়ন

একটি জেনারেটিভ এআই মডেলের আউটপুটের মান বিচার করার জন্য একটি হাইব্রিড প্রক্রিয়া যা মানব মূল্যায়নকে স্বয়ংক্রিয় মূল্যায়নের সাথে একত্রিত করে। একজন অটোরেটর হল একটি এমএল মডেল যা মানব মূল্যায়ন দ্বারা তৈরি ডেটার উপর প্রশিক্ষিত। আদর্শভাবে, একজন অটোরেটর একজন মানব মূল্যায়নকারীকে অনুকরণ করতে শেখে।আগে থেকে তৈরি অটোরেটর পাওয়া যায়, তবে সেরা অটোরেটরগুলি আপনার মূল্যায়ন করা কাজের সাথে বিশেষভাবে সামঞ্জস্যপূর্ণ।

স্বয়ংক্রিয়-প্রতিক্রমণ মডেল

এমন একটি মডেল যা তার পূর্ববর্তী ভবিষ্যদ্বাণীর উপর ভিত্তি করে একটি ভবিষ্যদ্বাণী অনুমান করে। উদাহরণস্বরূপ, স্বয়ংক্রিয়-প্রতিবর্তনশীল ভাষা মডেলগুলি পূর্বে পূর্বাভাসিত টোকেনের উপর ভিত্তি করে পরবর্তী টোকেনটি ভবিষ্যদ্বাণী করে। সমস্ত ট্রান্সফরমার -ভিত্তিক বৃহৎ ভাষা মডেলগুলি স্বয়ংক্রিয়-প্রতিবর্তনশীল।

বিপরীতে, GAN- ভিত্তিক চিত্র মডেলগুলি সাধারণত স্বয়ংক্রিয়ভাবে প্রতিবর্তনশীল হয় না কারণ তারা একটি একক ফরোয়ার্ড-পাসে একটি চিত্র তৈরি করে এবং ধাপে ধাপে পুনরাবৃত্তি করে না। তবে, কিছু চিত্র প্রজন্মের মডেল স্বয়ংক্রিয়ভাবে প্রতিবর্তনশীল হয় কারণ তারা ধাপে ধাপে একটি চিত্র তৈরি করে।

খ

বেস মডেল

একটি পূর্ব-প্রশিক্ষিত মডেল যা নির্দিষ্ট কাজ বা অ্যাপ্লিকেশনগুলিকে মোকাবেলা করার জন্য সূচনা বিন্দু হিসেবে কাজ করতে পারে।

প্রাক-প্রশিক্ষিত মডেল এবং ভিত্তি মডেলও দেখুন।

গ

চিন্তার শৃঙ্খল

একটি প্রম্পট ইঞ্জিনিয়ারিং কৌশল যা একটি বৃহৎ ভাষা মডেল (LLM) কে ধাপে ধাপে তার যুক্তি ব্যাখ্যা করতে উৎসাহিত করে। উদাহরণস্বরূপ, দ্বিতীয় বাক্যের প্রতি বিশেষ মনোযোগ দিয়ে নিম্নলিখিত প্রম্পটটি বিবেচনা করুন:

৭ সেকেন্ডে ০ থেকে ৬০ মাইল প্রতি ঘন্টা গতিতে চলা গাড়িতে একজন চালকের কত g বল থাকবে? উত্তরে, সমস্ত প্রাসঙ্গিক গণনা দেখাও।

এলএলএম-এর প্রতিক্রিয়া সম্ভবত হবে:

- পদার্থবিদ্যার সূত্রগুলির একটি ক্রম দেখান, যথাযথ স্থানে 0, 60 এবং 7 মানগুলি প্লাগ ইন করুন।

- কেন এটি এই সূত্রগুলি বেছে নিয়েছে এবং বিভিন্ন চলকগুলির অর্থ কী তা ব্যাখ্যা করুন।

চেইন-অফ-থট প্রম্পটিং LLM-কে সমস্ত গণনা করতে বাধ্য করে, যার ফলে আরও সঠিক উত্তর পাওয়া যেতে পারে। এছাড়াও, চেইন-অফ-থট প্রম্পটিং ব্যবহারকারীকে LLM-এর ধাপগুলি পরীক্ষা করে উত্তরটি অর্থপূর্ণ কিনা তা নির্ধারণ করতে সক্ষম করে।

চ্যাট

একটি ML সিস্টেমের সাথে, সাধারণত একটি বৃহৎ ভাষা মডেলের সাথে একটি এদিক-ওদিক সংলাপের বিষয়বস্তু। একটি চ্যাটে পূর্ববর্তী মিথস্ক্রিয়া (আপনি কী টাইপ করেছেন এবং বৃহৎ ভাষা মডেল কীভাবে প্রতিক্রিয়া জানিয়েছে) চ্যাটের পরবর্তী অংশগুলির প্রেক্ষাপটে পরিণত হয়।

চ্যাটবট হলো একটি বৃহৎ ভাষা মডেলের একটি অ্যাপ্লিকেশন।

প্রাসঙ্গিক ভাষা এম্বেডিং

এমন একটি এম্বেডিং যা শব্দ এবং বাক্যাংশগুলিকে "বোঝার" কাছাকাছি নিয়ে আসে, যেভাবে সাবলীল মানব বক্তারা পারেন। প্রসঙ্গিক ভাষা এম্বেডিং জটিল বাক্য গঠন, শব্দার্থবিদ্যা এবং প্রসঙ্গ বুঝতে পারে।

উদাহরণস্বরূপ, ইংরেজি শব্দ "cow" এর এম্বেডিং বিবেচনা করুন। word2vec এর মতো পুরানো এম্বেডিংগুলি ইংরেজি শব্দগুলিকে এমনভাবে উপস্থাপন করতে পারে যে গরু থেকে ষাঁড় পর্যন্ত এম্বেডিং স্থানের দূরত্ব ভেড়া (স্ত্রী ভেড়া) থেকে রাম (পুরুষ ভেড়া) বা মহিলা থেকে পুরুষ পর্যন্ত দূরত্বের সমান। প্রাসঙ্গিক ভাষা এম্বেডিংগুলি আরও এক ধাপ এগিয়ে যেতে পারে এই স্বীকৃতি দিয়ে যে ইংরেজি ভাষাভাষীরা কখনও কখনও আকস্মিকভাবে "cow" শব্দটি ব্যবহার করে গরু বা ষাঁড় বোঝাতে পারে।

প্রসঙ্গ উইন্ডো

একটি মডেল একটি নির্দিষ্ট প্রম্পটে কতগুলি টোকেন প্রক্রিয়া করতে পারে। প্রসঙ্গ উইন্ডো যত বড় হবে, মডেলটি প্রম্পটে সুসংগত এবং সামঞ্জস্যপূর্ণ প্রতিক্রিয়া প্রদানের জন্য তত বেশি তথ্য ব্যবহার করতে পারবে।

কথোপকথনমূলক কোডিং

সফটওয়্যার তৈরির উদ্দেশ্যে আপনার এবং একটি জেনারেটিভ এআই মডেলের মধ্যে একটি পুনরাবৃত্তিমূলক সংলাপ। আপনি কিছু সফ্টওয়্যার বর্ণনা করে একটি প্রম্পট জারি করেন। তারপর, মডেলটি কোড তৈরি করতে সেই বর্ণনা ব্যবহার করে। তারপর, আপনি পূর্ববর্তী প্রম্পট বা জেনারেটেড কোডের ত্রুটিগুলি সমাধান করার জন্য একটি নতুন প্রম্পট জারি করেন এবং মডেলটি আপডেট করা কোড তৈরি করে। জেনারেটেড সফ্টওয়্যারটি যথেষ্ট ভাল না হওয়া পর্যন্ত আপনারা দুজনে এদিক-ওদিক চলতে থাকেন।

কথোপকথন কোডিং মূলত ভাইব কোডিংয়ের আসল অর্থ।

স্পেসিফিকেশনাল কোডিংয়ের সাথে তুলনা করুন।

দ

সরাসরি প্ররোচনা

জিরো-শট প্রম্পটিং এর সমার্থক শব্দ।

পাতন

একটি মডেলের ( শিক্ষক নামে পরিচিত) আকার কমিয়ে একটি ছোট মডেলে ( ছাত্র নামে পরিচিত) রূপান্তরের প্রক্রিয়া যা মূল মডেলের ভবিষ্যদ্বাণীগুলিকে যথাসম্ভব বিশ্বস্ততার সাথে অনুকরণ করে। পাতন কার্যকর কারণ ছোট মডেলের বৃহত্তর মডেলের (শিক্ষক) তুলনায় দুটি মূল সুবিধা রয়েছে:

- দ্রুত অনুমানের সময়

- স্মৃতিশক্তি এবং শক্তির ব্যবহার হ্রাস

তবে, শিক্ষার্থীর ভবিষ্যদ্বাণী সাধারণত শিক্ষকের ভবিষ্যদ্বাণীর মতো ভালো হয় না।

পাতন পদ্ধতি শিক্ষার্থী এবং শিক্ষক মডেলের ভবিষ্যদ্বাণীর ফলাফলের পার্থক্যের উপর ভিত্তি করে শিক্ষার্থী মডেলকে ক্ষতির ফাংশন কমাতে প্রশিক্ষণ দেয়।

নিম্নলিখিত পদগুলির সাথে পাতন তুলনা করুন এবং বৈসাদৃশ্য করুন:

আরও তথ্যের জন্য LLMs: Fine-tuning, distillation, and prompt engineering in Machine Learning Crash Course দেখুন।

ই

মূল্যায়ন

প্রাথমিকভাবে LLM মূল্যায়নের সংক্ষিপ্ত রূপ হিসেবে ব্যবহৃত হয়। আরও বিস্তৃতভাবে বলতে গেলে, evals হল যেকোনো ধরণের মূল্যায়নের সংক্ষিপ্ত রূপ।

মূল্যায়ন

একটি মডেলের গুণমান পরিমাপ করার বা একে অপরের সাথে বিভিন্ন মডেলের তুলনা করার প্রক্রিয়া।

একটি তত্ত্বাবধানে থাকা মেশিন লার্নিং মডেল মূল্যায়ন করার জন্য, আপনি সাধারণত একটি বৈধতা সেট এবং একটি পরীক্ষা সেটের বিপরীতে এটি বিচার করেন। একটি LLM মূল্যায়নের ক্ষেত্রে সাধারণত বৃহত্তর গুণমান এবং সুরক্ষা মূল্যায়ন জড়িত থাকে।

চ

বাস্তবতা

ML জগতের মধ্যে, এমন একটি বৈশিষ্ট্য যা এমন একটি মডেল বর্ণনা করে যার আউটপুট বাস্তবতার উপর ভিত্তি করে। ফ্যাকচুয়ালটি একটি মেট্রিকের পরিবর্তে একটি ধারণা। উদাহরণস্বরূপ, ধরুন আপনি একটি বৃহৎ ভাষা মডেলে নিম্নলিখিত প্রম্পটটি পাঠান:

টেবিল লবণের রাসায়নিক সূত্র কী?

বাস্তবতাকে অপ্টিমাইজ করার একটি মডেল উত্তর দেবে:

NaCl - NaCl

এটা ধরে নেওয়া প্রলুব্ধকর যে সমস্ত মডেল বাস্তবতার উপর ভিত্তি করে তৈরি করা উচিত। যাইহোক, কিছু প্রম্পট, যেমন নিম্নলিখিতগুলি, একটি জেনারেটিভ এআই মডেলকে বাস্তবতার পরিবর্তে সৃজনশীলতাকে অনুকূলিত করতে বাধ্য করবে।

একজন মহাকাশচারী এবং একটি শুঁয়োপোকা সম্পর্কে একটা লিমেরিক বলো।

ফলস্বরূপ লিমেরিক বাস্তবতার উপর ভিত্তি করে তৈরি হওয়ার সম্ভাবনা কম।

ভিত্তিহীনতার সাথে তুলনা করুন।

দ্রুত ক্ষয়

এলএলএম- এর কর্মক্ষমতা উন্নত করার জন্য একটি প্রশিক্ষণ কৌশল। দ্রুত ক্ষয় হল প্রশিক্ষণের সময় শেখার হার দ্রুত হ্রাস করা। এই কৌশলটি মডেলটিকে প্রশিক্ষণের তথ্যের সাথে অতিরিক্ত মানানসই হওয়া থেকে বিরত রাখতে সাহায্য করে এবং সাধারণীকরণ উন্নত করে।

কয়েক-শট প্রম্পটিং

একটি প্রম্পট যাতে একাধিক ("কয়েকটি") উদাহরণ থাকে যা দেখায় যে বৃহৎ ভাষা মডেলটি কীভাবে প্রতিক্রিয়া জানাবে। উদাহরণস্বরূপ, নিম্নলিখিত দীর্ঘ প্রম্পটে দুটি উদাহরণ রয়েছে যা দেখায় যে একটি বৃহৎ ভাষা মডেল কীভাবে একটি প্রশ্নের উত্তর দিতে হয়।

| একটি প্রম্পটের কিছু অংশ | মন্তব্য |

|---|---|

| নির্দিষ্ট দেশের সরকারী মুদ্রা কী? | এলএলএম-এর জন্য আপনি যে প্রশ্নের উত্তর চান। |

| ফ্রান্স: ইউরো | একটি উদাহরণ। |

| যুক্তরাজ্য: জিবিপি | আরেকটি উদাহরণ। |

| ভারত: | আসল প্রশ্ন। |

জিরো-শট প্রম্পটিং এবং ওয়ান-শট প্রম্পটিং এর তুলনায় ফিউ-শট প্রম্পটিং সাধারণত বেশি পছন্দসই ফলাফল দেয়। তবে, ফিউ-শট প্রম্পটিং এর জন্য দীর্ঘ প্রম্পট প্রয়োজন।

কিছু-শট প্রম্পটিং হল কিছু-শট লার্নিংয়ের একটি রূপ যা প্রম্পট-ভিত্তিক লার্নিংয়ে প্রয়োগ করা হয়।

আরও তথ্যের জন্য মেশিন লার্নিং ক্র্যাশ কোর্সে প্রম্পট ইঞ্জিনিয়ারিং দেখুন।

সূক্ষ্ম-সুরকরণ

একটি নির্দিষ্ট ব্যবহারের ক্ষেত্রে এর পরামিতিগুলি পরিমার্জন করার জন্য একটি পূর্ব-প্রশিক্ষিত মডেলের উপর সম্পাদিত দ্বিতীয়, কার্য-নির্দিষ্ট প্রশিক্ষণ পাস। উদাহরণস্বরূপ, কিছু বৃহৎ ভাষা মডেলের জন্য সম্পূর্ণ প্রশিক্ষণ ক্রম নিম্নরূপ:

- প্রাক-প্রশিক্ষণ: একটি বিশাল সাধারণ ডেটাসেটের উপর একটি বৃহৎ ভাষা মডেলকে প্রশিক্ষণ দিন, যেমন সমস্ত ইংরেজি ভাষার উইকিপিডিয়া পৃষ্ঠা।

- ফাইন-টিউনিং: পূর্ব-প্রশিক্ষিত মডেলকে একটি নির্দিষ্ট কাজ সম্পাদনের জন্য প্রশিক্ষণ দিন, যেমন চিকিৎসা সংক্রান্ত প্রশ্নের উত্তর দেওয়া। ফাইন-টিউনিংয়ে সাধারণত নির্দিষ্ট কাজের উপর দৃষ্টি নিবদ্ধ করে শত শত বা হাজার হাজার উদাহরণ অন্তর্ভুক্ত থাকে।

আরেকটি উদাহরণ হিসেবে, একটি বৃহৎ চিত্র মডেলের জন্য সম্পূর্ণ প্রশিক্ষণ ক্রম নিম্নরূপ:

- প্রাক-প্রশিক্ষণ: একটি বিশাল সাধারণ চিত্র ডেটাসেটের উপর একটি বৃহৎ চিত্র মডেলকে প্রশিক্ষণ দিন, যেমন উইকিমিডিয়া কমন্সের সমস্ত চিত্র।

- সূক্ষ্ম সমন্বয়: পূর্ব-প্রশিক্ষিত মডেলকে একটি নির্দিষ্ট কাজ সম্পাদনের জন্য প্রশিক্ষণ দিন, যেমন অর্কাসের ছবি তৈরি করা।

ফাইন-টিউনিং নিম্নলিখিত কৌশলগুলির যেকোনো সমন্বয়কে অন্তর্ভুক্ত করতে পারে:

- পূর্ব-প্রশিক্ষিত মডেলের বিদ্যমান সমস্ত পরামিতি পরিবর্তন করা। এটিকে কখনও কখনও সম্পূর্ণ সূক্ষ্ম-সুরকরণ বলা হয়।

- প্রাক-প্রশিক্ষিত মডেলের বিদ্যমান প্যারামিটারগুলির কিছু (সাধারণত, আউটপুট লেয়ারের সবচেয়ে কাছের স্তরগুলি) পরিবর্তন করা, অন্যান্য বিদ্যমান প্যারামিটারগুলি অপরিবর্তিত রাখা (সাধারণত, ইনপুট লেয়ারের সবচেয়ে কাছের স্তরগুলি)। প্যারামিটার-দক্ষ টিউনিং দেখুন।

- আরও স্তর যুক্ত করা, সাধারণত আউটপুট স্তরের সবচেয়ে কাছের বিদ্যমান স্তরগুলির উপরে।

ফাইন-টিউনিং হল ট্রান্সফার লার্নিংয়ের একধরণের রূপ। ফলে, ফাইন-টিউনিংয়ে পূর্ব-প্রশিক্ষিত মডেলকে প্রশিক্ষণ দেওয়ার জন্য ব্যবহৃত লস ফাংশন বা ভিন্ন ধরণের মডেল ব্যবহার করা হতে পারে। উদাহরণস্বরূপ, আপনি একটি পূর্ব-প্রশিক্ষিত বৃহৎ চিত্র মডেলকে সূক্ষ্মভাবে সুরক্ষিত করতে পারেন যাতে একটি রিগ্রেশন মডেল তৈরি করা যায় যা একটি ইনপুট চিত্রে পাখির সংখ্যা ফেরত দেয়।

নিম্নলিখিত পদগুলির সাথে সূক্ষ্ম-সুরকরণের তুলনা এবং বৈসাদৃশ্য করুন:

আরও তথ্যের জন্য মেশিন লার্নিং ক্র্যাশ কোর্সে ফাইন-টিউনিং দেখুন।

ফ্ল্যাশ মডেল

তুলনামূলকভাবে ছোট জেমিনি মডেলের একটি পরিবার যা গতি এবং কম লেটেন্সির জন্য অপ্টিমাইজ করা হয়েছে। ফ্ল্যাশ মডেলগুলি বিভিন্ন ধরণের অ্যাপ্লিকেশনের জন্য ডিজাইন করা হয়েছে যেখানে দ্রুত প্রতিক্রিয়া এবং উচ্চ থ্রুপুট অত্যন্ত গুরুত্বপূর্ণ।

ভিত্তি মডেল

একটি বিশাল এবং বৈচিত্র্যময় প্রশিক্ষণ সেটের উপর প্রশিক্ষিত একটি খুব বড় প্রাক-প্রশিক্ষিত মডেল । একটি ভিত্তি মডেল নিম্নলিখিত দুটি কাজ করতে পারে:

- বিভিন্ন ধরণের অনুরোধের প্রতি ভালোভাবে সাড়া দিন।

- অতিরিক্ত সূক্ষ্ম-টিউনিং বা অন্যান্য কাস্টমাইজেশনের জন্য বেস মডেল হিসেবে পরিবেশন করুন।

অন্য কথায়, একটি ফাউন্ডেশন মডেল ইতিমধ্যেই সাধারণ অর্থে খুব সক্ষম কিন্তু একটি নির্দিষ্ট কাজের জন্য আরও বেশি কার্যকর হওয়ার জন্য এটিকে আরও কাস্টমাইজ করা যেতে পারে।

সাফল্যের ভগ্নাংশ

একটি ML মডেলের তৈরি টেক্সট মূল্যায়নের জন্য একটি মেট্রিক। সাফল্যের ভগ্নাংশ হল "সফল" তৈরি টেক্সট আউটপুটের সংখ্যাকে মোট তৈরি টেক্সট আউটপুটের সংখ্যা দিয়ে ভাগ করলে। উদাহরণস্বরূপ, যদি একটি বৃহৎ ভাষা মডেল 10টি কোড ব্লক তৈরি করে, যার মধ্যে পাঁচটি সফল হয়, তাহলে সাফল্যের ভগ্নাংশ হবে 50%।

যদিও পরিসংখ্যান জুড়ে সাফল্যের ভগ্নাংশ ব্যাপকভাবে কার্যকর, ML-এর মধ্যে, এই মেট্রিকটি প্রাথমিকভাবে কোড জেনারেশন বা গণিত সমস্যার মতো যাচাইযোগ্য কাজগুলি পরিমাপের জন্য কার্যকর।

গ

মিথুন রাশি

এই ইকোসিস্টেমে গুগলের সবচেয়ে উন্নত এআই রয়েছে। এই ইকোসিস্টেমের উপাদানগুলির মধ্যে রয়েছে:

- বিভিন্ন জেমিনি মডেল ।

- জেমিনি মডেলের ইন্টারেক্টিভ কথোপকথনমূলক ইন্টারফেস। ব্যবহারকারীরা প্রম্পট টাইপ করেন এবং জেমিনি সেই প্রম্পটগুলিতে সাড়া দেয়।

- বিভিন্ন জেমিনি এপিআই।

- জেমিনি মডেলের উপর ভিত্তি করে বিভিন্ন ব্যবসায়িক পণ্য; উদাহরণস্বরূপ, গুগল ক্লাউডের জন্য জেমিনি ।

মিথুন মডেল

গুগলের অত্যাধুনিক ট্রান্সফরমার -ভিত্তিক মাল্টিমোডাল মডেল । জেমিনি মডেলগুলি বিশেষভাবে এজেন্টদের সাথে একীভূত করার জন্য ডিজাইন করা হয়েছে।

ব্যবহারকারীরা বিভিন্ন উপায়ে জেমিনি মডেলের সাথে যোগাযোগ করতে পারেন, যার মধ্যে একটি ইন্টারেক্টিভ ডায়ালগ ইন্টারফেস এবং SDK এর মাধ্যমেও অন্তর্ভুক্ত।

জেমা

জেমিনি মডেল তৈরিতে ব্যবহৃত একই গবেষণা এবং প্রযুক্তি ব্যবহার করে তৈরি হালকা ওজনের ওপেন মডেলের একটি পরিবার। বেশ কয়েকটি ভিন্ন জেমা মডেল পাওয়া যায়, প্রতিটিতে ভিন্ন ভিন্ন বৈশিষ্ট্য রয়েছে, যেমন দৃষ্টি, কোড এবং নির্দেশনা অনুসরণ। বিস্তারিত জানার জন্য জেমা দেখুন।

জেনাএআই বা জেনাএআই

জেনারেটিভ এআই এর সংক্ষিপ্ত রূপ।

তৈরি করা টেক্সট

সাধারণভাবে, একটি ML মডেল যে টেক্সট আউটপুট করে। বৃহৎ ভাষার মডেল মূল্যায়ন করার সময়, কিছু মেট্রিক্স রেফারেন্স টেক্সটের সাথে জেনারেট করা টেক্সটের তুলনা করে। উদাহরণস্বরূপ, ধরুন আপনি নির্ধারণ করার চেষ্টা করছেন যে একটি ML মডেল ফরাসি থেকে ডাচ ভাষায় কতটা কার্যকরভাবে অনুবাদ করে। এই ক্ষেত্রে:

- উৎপন্ন টেক্সট হল ডাচ অনুবাদ যা ML মডেল আউটপুট করে।

- রেফারেন্স টেক্সট হল ডাচ অনুবাদ যা একজন মানব অনুবাদক (অথবা সফ্টওয়্যার) তৈরি করে।

মনে রাখবেন যে কিছু মূল্যায়ন কৌশলে রেফারেন্স টেক্সট জড়িত থাকে না।

জেনারেটিভ এআই

একটি উদীয়মান রূপান্তরমূলক ক্ষেত্র যার কোনও আনুষ্ঠানিক সংজ্ঞা নেই। যাইহোক, বেশিরভাগ বিশেষজ্ঞ একমত যে জেনারেটিভ এআই মডেলগুলি নিম্নলিখিত সমস্ত বিষয়বস্তু তৈরি করতে ("জেনারেট") করতে পারে:

- জটিল

- সুসংগত

- আসল

জেনারেটিভ এআই-এর উদাহরণগুলির মধ্যে রয়েছে:

- বৃহৎ ভাষা মডেল , যা পরিশীলিত মূল পাঠ্য তৈরি করতে পারে এবং প্রশ্নের উত্তর দিতে পারে।

- ইমেজ জেনারেশন মডেল, যা অনন্য ছবি তৈরি করতে পারে।

- অডিও এবং সঙ্গীত প্রজন্মের মডেল, যা মৌলিক সঙ্গীত রচনা করতে পারে বা বাস্তবসম্মত বক্তৃতা তৈরি করতে পারে।

- ভিডিও জেনারেশন মডেল, যা আসল ভিডিও তৈরি করতে পারে।

LSTM এবং RNN সহ কিছু পূর্ববর্তী প্রযুক্তিও মৌলিক এবং সুসংগত বিষয়বস্তু তৈরি করতে পারে। কিছু বিশেষজ্ঞ এই পূর্ববর্তী প্রযুক্তিগুলিকে জেনারেটিভ এআই হিসাবে দেখেন, আবার অন্যরা মনে করেন যে প্রকৃত জেনারেটিভ এআই-এর জন্য পূর্ববর্তী প্রযুক্তিগুলির তুলনায় আরও জটিল আউটপুট প্রয়োজন।

ভবিষ্যদ্বাণীমূলক ML এর সাথে তুলনা করুন।

সুবর্ণ প্রতিক্রিয়া

একটি প্রতিক্রিয়া যা ভালো বলে জানা গেছে। উদাহরণস্বরূপ, নিম্নলিখিত প্রম্পটটি দেওয়া হয়েছে:

২ + ২

আশা করি সুবর্ণ উত্তরটি হল:

৪

জিপিটি (জেনারেটিভ প্রি-ট্রেনড ট্রান্সফরমার)

OpenAI দ্বারা তৈরি ট্রান্সফরমার -ভিত্তিক বৃহৎ ভাষার মডেলের একটি পরিবার।

জিপিটি ভেরিয়েন্টগুলি একাধিক পদ্ধতিতে প্রয়োগ করা যেতে পারে, যার মধ্যে রয়েছে:

- ইমেজ জেনারেশন (উদাহরণস্বরূপ, ImageGPT)

- টেক্সট-টু-ইমেজ জেনারেশন (উদাহরণস্বরূপ, DALL-E )।

জ

হ্যালুসিনেশন

বাস্তব জগৎ সম্পর্কে একটি দাবি তৈরি করার দাবি করে এমন একটি জেনারেটিভ এআই মডেল দ্বারা সম্ভাব্য-আপাতদৃষ্টিতে ভুল আউটপুট তৈরি করা। উদাহরণস্বরূপ, একটি জেনারেটিভ এআই মডেল যা দাবি করে যে বারাক ওবামা ১৮৬৫ সালে মারা গেছেন, তা বিভ্রান্তিকর ।

মানব মূল্যায়ন

একটি প্রক্রিয়া যেখানে লোকেরা একটি ML মডেলের আউটপুটের মান বিচার করে; উদাহরণস্বরূপ, দ্বিভাষিক লোকদের দ্বারা একটি ML অনুবাদ মডেলের মান বিচার করা হয়। মানব মূল্যায়ন বিশেষ করে এমন মডেলগুলির বিচারের জন্য কার্যকর যাদের কোনও সঠিক উত্তর নেই ।

স্বয়ংক্রিয় মূল্যায়ন এবং অটোরেটর মূল্যায়নের সাথে তুলনা করুন।

লুপে মানুষ (HITL)

একটি ঢিলেঢালাভাবে সংজ্ঞায়িত বাগধারা যার অর্থ নিম্নলিখিত যেকোনো একটি হতে পারে:

- জেনারেটিভ এআই আউটপুটকে সমালোচনামূলক বা সন্দেহজনকভাবে দেখার নীতি।

- একটি কৌশল বা সিস্টেম যাতে মানুষ একটি মডেলের আচরণ গঠন, মূল্যায়ন এবং পরিমার্জন করতে সাহায্য করে। একজন মানুষকে লুপের মধ্যে রাখলে একজন AI মেশিন বুদ্ধিমত্তা এবং মানব বুদ্ধিমত্তা উভয় থেকেই উপকৃত হতে পারে। উদাহরণস্বরূপ, এমন একটি সিস্টেম যেখানে একজন AI কোড তৈরি করে এবং সফ্টওয়্যার ইঞ্জিনিয়াররা পর্যালোচনা করে তা হল একটি হিউম্যান-ইন-দ্য-লুপ সিস্টেম।

আমি

প্রেক্ষাপটে শিক্ষা

"কয়েক-শট প্রম্পটিং" এর সমার্থক শব্দ।

অনুমান

ঐতিহ্যবাহী মেশিন লার্নিং-এ, লেবেলবিহীন উদাহরণগুলিতে একটি প্রশিক্ষিত মডেল প্রয়োগ করে ভবিষ্যদ্বাণী করার প্রক্রিয়া। আরও জানতে ইন্ট্রো টু এমএল কোর্সে তত্ত্বাবধানে থাকা শিক্ষা দেখুন।

বৃহৎ ভাষা মডেলগুলিতে , অনুমান হল একটি প্রশিক্ষিত মডেল ব্যবহার করে একটি ইনপুট প্রম্পটে প্রতিক্রিয়া তৈরি করার প্রক্রিয়া।

পরিসংখ্যানে অনুমানের অর্থ কিছুটা ভিন্ন। বিস্তারিত জানার জন্য পরিসংখ্যানগত অনুমানের উপর উইকিপিডিয়া নিবন্ধটি দেখুন।

নির্দেশ টিউনিং

এক ধরণের ফাইন-টিউনিং যা একটি জেনারেটিভ এআই মডেলের নির্দেশাবলী অনুসরণ করার ক্ষমতা উন্নত করে। নির্দেশনা টিউনিং-এর মধ্যে একটি মডেলকে নির্দেশনা প্রম্পটের একটি সিরিজের উপর প্রশিক্ষণ দেওয়া হয়, যা সাধারণত বিভিন্ন ধরণের কাজকে অন্তর্ভুক্ত করে। ফলস্বরূপ নির্দেশনা-টিউন করা মডেলটি বিভিন্ন কাজের জন্য শূন্য-শট প্রম্পটের জন্য কার্যকর প্রতিক্রিয়া তৈরি করে।

তুলনা করুন এবং এর সাথে তুলনা করুন:

ল

বৃহৎ ভাষার মডেল

কমপক্ষে, এমন একটি ভাষা মডেল যার প্যারামিটারের সংখ্যা খুব বেশি। আরও অনানুষ্ঠানিকভাবে, যেকোনো ট্রান্সফরমার -ভিত্তিক ভাষা মডেল, যেমন জেমিনি বা জিপিটি ।

আরও তথ্যের জন্য মেশিন লার্নিং ক্র্যাশ কোর্সে বৃহৎ ভাষার মডেল (LLM) দেখুন।

বিলম্ব

একটি মডেলের ইনপুট প্রক্রিয়াকরণ এবং প্রতিক্রিয়া তৈরি করতে যে সময় লাগে। একটি উচ্চ লেটেন্সি প্রতিক্রিয়া তৈরি করতে কম লেটেন্সি প্রতিক্রিয়ার তুলনায় বেশি সময় লাগে।

বৃহৎ ভাষা মডেলের বিলম্বকে প্রভাবিত করে এমন কারণগুলির মধ্যে রয়েছে:

- ইনপুট এবং আউটপুট টোকেনের দৈর্ঘ্য

- মডেল জটিলতা

- মডেলটি যে অবকাঠামোর উপর চলে

প্রতিক্রিয়াশীল এবং ব্যবহারকারী-বান্ধব অ্যাপ্লিকেশন তৈরির জন্য লেটেন্সির জন্য অপ্টিমাইজেশন অত্যন্ত গুরুত্বপূর্ণ।

এলএলএম

বৃহৎ ভাষার মডেলের সংক্ষিপ্ত রূপ।

এলএলএম মূল্যায়ন (মূল্যায়ন)

বৃহৎ ভাষা মডেল (LLM) এর কর্মক্ষমতা মূল্যায়নের জন্য মেট্রিক্স এবং মানদণ্ডের একটি সেট। উচ্চ স্তরে, LLM মূল্যায়ন:

- গবেষকদের LLM-এর উন্নতির প্রয়োজন এমন ক্ষেত্রগুলি চিহ্নিত করতে সাহায্য করুন।

- বিভিন্ন LLM তুলনা করতে এবং একটি নির্দিষ্ট কাজের জন্য সেরা LLM সনাক্ত করতে কার্যকর।

- এলএলএম নিরাপদ এবং ব্যবহারের জন্য নীতিগত তা নিশ্চিত করতে সহায়তা করুন।

আরও তথ্যের জন্য মেশিন লার্নিং ক্র্যাশ কোর্সে বৃহৎ ভাষার মডেল (LLM) দেখুন।

LoRA সম্পর্কে

নিম্ন-র্যাঙ্ক অভিযোজনযোগ্যতার সংক্ষিপ্ত রূপ।

নিম্ন-র্যাঙ্ক অভিযোজনযোগ্যতা (LoRA)

সূক্ষ্ম সুরকরণের জন্য একটি প্যারামিটার-দক্ষ কৌশল যা মডেলের পূর্ব-প্রশিক্ষিত ওজনগুলিকে "স্থির" করে (যাতে সেগুলি আর পরিবর্তন করা না যায়) এবং তারপর মডেলটিতে প্রশিক্ষণযোগ্য ওজনের একটি ছোট সেট সন্নিবেশ করায়। প্রশিক্ষণযোগ্য ওজনের এই সেটটি ("আপডেট ম্যাট্রিক্স" নামেও পরিচিত) বেস মডেলের তুলনায় যথেষ্ট ছোট এবং তাই প্রশিক্ষণের জন্য অনেক দ্রুত।

LoRA নিম্নলিখিত সুবিধা প্রদান করে:

- যে ডোমেনে ফাইন টিউনিং প্রয়োগ করা হয়, সেই ডোমেনের জন্য মডেলের ভবিষ্যদ্বাণীর মান উন্নত করে।

- মডেলের সমস্ত প্যারামিটারের সূক্ষ্ম-টিউনিং প্রয়োজন এমন কৌশলগুলির চেয়ে দ্রুত সূক্ষ্ম-টিউন করে।

- একই বেস মডেল ভাগ করে নেওয়া একাধিক বিশেষায়িত মডেলের একযোগে পরিবেশন সক্ষম করে অনুমানের গণনামূলক খরচ হ্রাস করে।

ম

যন্ত্র অনুবাদ

এক মানব ভাষা থেকে অন্য মানব ভাষায়, উদাহরণস্বরূপ, ইংরেজি থেকে জাপানি ভাষায়, টেক্সট রূপান্তর করার জন্য সফটওয়্যার (সাধারণত, একটি মেশিন লার্নিং মডেল) ব্যবহার করা।

k (mAP@k) এ গড় গড় নির্ভুলতা

একটি বৈধতা ডেটাসেট জুড়ে k স্কোরে সমস্ত গড় নির্ভুলতার পরিসংখ্যানগত গড়। k তে গড় গড় নির্ভুলতার একটি ব্যবহার হল একটি সুপারিশ ব্যবস্থা দ্বারা উত্পন্ন সুপারিশের গুণমান বিচার করা।

যদিও "গড় গড়" বাক্যাংশটি অপ্রয়োজনীয় শোনাচ্ছে, মেট্রিকের নামটি উপযুক্ত। সর্বোপরি, এই মেট্রিকটি k মানের উপর একাধিক গড় নির্ভুলতার গড় খুঁজে বের করে।

বিশেষজ্ঞদের মিশ্রণ

একটি নির্দিষ্ট ইনপুট টোকেন বা উদাহরণ প্রক্রিয়া করার জন্য শুধুমাত্র তার প্যারামিটারগুলির একটি উপসেট (যাকে বিশেষজ্ঞ বলা হয়) ব্যবহার করে নিউরাল নেটওয়ার্কের দক্ষতা বৃদ্ধির একটি স্কিম। একটি গেটিং নেটওয়ার্ক প্রতিটি ইনপুট টোকেন বা উদাহরণকে যথাযথ বিশেষজ্ঞ(দের) কাছে পাঠায়।

বিস্তারিত জানার জন্য, নিম্নলিখিত কাগজপত্রগুলির যেকোনো একটি দেখুন:

- ভয়াবহভাবে বৃহৎ নিউরাল নেটওয়ার্ক: বিশেষজ্ঞদের মিশ্রণের বিক্ষিপ্ত স্তর

- বিশেষজ্ঞদের মিশ্রণ এবং বিশেষজ্ঞ পছন্দ রাউটিং

এমএমআইটি

মাল্টিমোডাল ইন্সট্রাকশন-টিউনড এর সংক্ষিপ্ত রূপ।

মডেল ক্যাসকেডিং

একটি সিস্টেম যা একটি নির্দিষ্ট অনুমান প্রশ্নের জন্য আদর্শ মডেল নির্বাচন করে।

কল্পনা করুন মডেলের একটি গ্রুপ, যার মধ্যে রয়েছে খুব বড় (অনেক প্যারামিটার ) থেকে অনেক ছোট (অনেক কম প্যারামিটার)। খুব বড় মডেলগুলি ছোট মডেলের তুলনায় অনুমানের সময় বেশি গণনামূলক সম্পদ ব্যবহার করে। তবে, খুব বড় মডেলগুলি সাধারণত ছোট মডেলের তুলনায় আরও জটিল অনুরোধ অনুমান করতে পারে। মডেল ক্যাসকেডিং অনুমান কোয়েরির জটিলতা নির্ধারণ করে এবং তারপর অনুমান সম্পাদনের জন্য উপযুক্ত মডেলটি বেছে নেয়। মডেল ক্যাসকেডিংয়ের মূল প্রেরণা হল সাধারণত ছোট মডেল নির্বাচন করে এবং আরও জটিল প্রশ্নের জন্য কেবল একটি বৃহত্তর মডেল নির্বাচন করে অনুমানের খরচ কমানো।

কল্পনা করুন যে একটি ছোট মডেল একটি ফোনে চলে এবং সেই মডেলের একটি বৃহত্তর সংস্করণ একটি রিমোট সার্ভারে চলে। ভালো মডেল ক্যাসকেডিং খরচ এবং বিলম্ব কমায়, ছোট মডেলটিকে সহজ অনুরোধগুলি পরিচালনা করতে সক্ষম করে এবং জটিল অনুরোধগুলি পরিচালনা করার জন্য কেবল রিমোট মডেলটিকে কল করে।

মডেল রাউটারটিও দেখুন।

মডেল রাউটার

মডেল ক্যাসকেডিং- এ অনুমানের জন্য আদর্শ মডেল নির্ধারণকারী অ্যালগরিদম। একটি মডেল রাউটার নিজেই সাধারণত একটি মেশিন লার্নিং মডেল যা ধীরে ধীরে একটি প্রদত্ত ইনপুটের জন্য সেরা মডেলটি কীভাবে বেছে নিতে হয় তা শিখে। তবে, একটি মডেল রাউটার কখনও কখনও একটি সহজ, নন-মেশিন লার্নিং অ্যালগরিদম হতে পারে।

মো

বিশেষজ্ঞদের মিশ্রণের সংক্ষিপ্ত রূপ।

এমটি

যন্ত্র অনুবাদের সংক্ষিপ্ত রূপ।

ন

ন্যানো

ডিভাইসে ব্যবহারের জন্য তৈরি তুলনামূলকভাবে ছোট একটি জেমিনি মডেল । বিস্তারিত জানার জন্য জেমিনি ন্যানো দেখুন।

কোন সঠিক উত্তর নেই (NORA)

একটি প্রম্পট যার একাধিক সঠিক উত্তর আছে। উদাহরণস্বরূপ, নিম্নলিখিত প্রম্পটে একটিও সঠিক উত্তর নেই:

হাতি সম্পর্কে একটা মজার কৌতুক বলো।

কোনও সঠিক উত্তর না দেওয়া প্রম্পটের উত্তর মূল্যায়ন করা সাধারণত একটি সঠিক উত্তর দেওয়া প্রম্পট মূল্যায়নের তুলনায় অনেক বেশি ব্যক্তিগত। উদাহরণস্বরূপ, একটি হাতির কৌতুক মূল্যায়নের জন্য কৌতুকটি কতটা মজার তা নির্ধারণ করার জন্য একটি পদ্ধতিগত উপায় প্রয়োজন।

নোরা

"কোনও সঠিক উত্তর নেই" এর সংক্ষিপ্ত রূপ।

নোটবুক এলএম

একটি জেমিনি-ভিত্তিক টুল যা ব্যবহারকারীদের ডকুমেন্ট আপলোড করতে এবং তারপর প্রম্পট ব্যবহার করে ডকুমেন্টগুলি সম্পর্কে প্রশ্ন জিজ্ঞাসা করতে, সারসংক্ষেপ করতে বা সংগঠিত করতে সক্ষম করে। উদাহরণস্বরূপ, একজন লেখক বেশ কয়েকটি ছোট গল্প আপলোড করতে পারেন এবং নোটবুক এলএম-কে তাদের সাধারণ থিমগুলি খুঁজে বের করতে বা কোনটি সেরা সিনেমা হতে পারে তা সনাক্ত করতে বলতে পারেন।

ও

একটি সঠিক উত্তর (ORA)

একটি প্রম্পট যার একটি মাত্র সঠিক উত্তর আছে। উদাহরণস্বরূপ, নিম্নলিখিত প্রম্পটটি বিবেচনা করুন:

সত্য না মিথ্যা: শনি গ্রহ মঙ্গলের চেয়ে বড়।

একমাত্র সঠিক উত্তর হল সত্য ।

"কোনও সঠিক উত্তর নেই" এর সাথে তুলনা করুন।

এক-শট প্রম্পটিং

একটি প্রম্পট যাতে একটি উদাহরণ থাকে যা দেখায় যে বৃহৎ ভাষা মডেলটি কীভাবে প্রতিক্রিয়া জানাবে। উদাহরণস্বরূপ, নিম্নলিখিত প্রম্পটে একটি উদাহরণ রয়েছে যা দেখায় যে একটি বৃহৎ ভাষা মডেল কীভাবে একটি প্রশ্নের উত্তর দেবে।

| একটি প্রম্পটের কিছু অংশ | মন্তব্য |

|---|---|

| What is the official currency of the specified country? | The question you want the LLM to answer. |

| France: EUR | One example. |

| India: | The actual query. |

Compare and contrast one-shot prompting with the following terms:

ওআরএ

Abbreviation for one right answer .

প

parameter-efficient tuning

A set of techniques to fine-tune a large pre-trained language model (PLM) more efficiently than full fine-tuning . Parameter-efficient tuning typically fine-tunes far fewer parameters than full fine-tuning, yet generally produces a large language model that performs as well (or almost as well) as a large language model built from full fine-tuning.

Compare and contrast parameter-efficient tuning with:

Parameter-efficient tuning is also known as parameter-efficient fine-tuning .

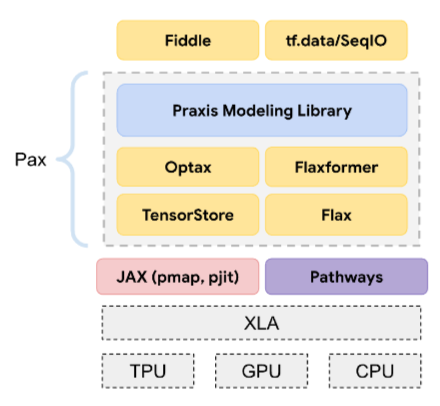

Pax

A programming framework designed for training large-scale neural network models so large that they span multiple TPU accelerator chip slices or pods .

Pax is built on Flax , which is built on JAX .

PLM

Abbreviation for pre-trained language model .

post-trained model

Loosely-defined term that typically refers to a pre-trained model that has gone through some post-processing, such as one or more of the following:

pre-trained model

Although this term could refer to any trained model or trained embedding vector , pre-trained model now typically refers to a trained large language model or other form of trained generative AI model.

See also base model and foundation model .

pre-training

The initial training of a model on a large dataset . Some pre-trained models are clumsy giants and must typically be refined through additional training. For example, ML experts might pre-train a large language model on a vast text dataset, such as all the English pages in Wikipedia. Following pre-training, the resulting model might be further refined through any of the following techniques:

প্রো

A Gemini model with fewer parameters than Ultra but more parameters than Nano . See Gemini Pro for details.

প্রম্পট

Any text entered as input to a large language model to condition the model to behave in a certain way. Prompts can be as short as a phrase or arbitrarily long (for example, the entire text of a novel). Prompts fall into multiple categories, including those shown in the following table:

| Prompt category | Example | Notes |

|---|---|---|

| প্রশ্ন | How fast can a pigeon fly? | |

| নির্দেশ | Write a funny poem about arbitrage. | A prompt that asks the large language model to do something. |

| Example | Translate Markdown code to HTML. For example: Markdown: * list item HTML: <ul> <li>list item</li> </ul> | The first sentence in this example prompt is an instruction. The remainder of the prompt is the example. |

| ভূমিকা | Explain why gradient descent is used in machine learning training to a PhD in Physics. | The first part of the sentence is an instruction; the phrase "to a PhD in Physics" is the role portion. |

| Partial input for the model to complete | The Prime Minister of the United Kingdom lives at | A partial input prompt can either end abruptly (as this example does) or end with an underscore. |

A generative AI model can respond to a prompt with text, code, images, embeddings , videos…almost anything.

prompt-based learning

A capability of certain models that enables them to adapt their behavior in response to arbitrary text input ( prompts ). In a typical prompt-based learning paradigm, a large language model responds to a prompt by generating text. For example, suppose a user enters the following prompt:

Summarize Newton's Third Law of Motion.

A model capable of prompt-based learning isn't specifically trained to answer the previous prompt. Rather, the model "knows" a lot of facts about physics, a lot about general language rules, and a lot about what constitutes generally useful answers. That knowledge is sufficient to provide a (hopefully) useful answer. Additional human feedback ("That answer was too complicated." or "What's a reaction?") enables some prompt-based learning systems to gradually improve the usefulness of their answers.

prompt design

Synonym for prompt engineering .

prompt engineering

The art of creating prompts that elicit the desired responses from a large language model . Humans perform prompt engineering. Writing well-structured prompts is an essential part of ensuring useful responses from a large language model. Prompt engineering depends on many factors, including:

- The dataset used to pre-train and possibly fine-tune the large language model.

- The temperature and other decoding parameters that the model uses to generate responses.

Prompt design is a synonym for prompt engineering.

See Introduction to prompt design for more details on writing helpful prompts.

prompt set

A group of prompts for evaluating a large language model . For example, the following illustration shows a prompt set consisting of three prompts:

Good prompt sets consist of a sufficiently "wide" collection of prompts to thoroughly evaluate the safety and helpfulness of a large language model.

See also response set .

prompt tuning

A parameter efficient tuning mechanism that learns a "prefix" that the system prepends to the actual prompt .

One variation of prompt tuning—sometimes called prefix tuning —is to prepend the prefix at every layer . In contrast, most prompt tuning only adds a prefix to the input layer .

র

reference text

An expert's response to a prompt . For example, given the following prompt:

Translate the question "What is your name?" from English to French.

An expert's response might be:

Comment vous appelez-vous?

Various metrics (such as ROUGE ) measure the degree to which the reference text matches an ML model's generated text .

reflection

A strategy for improving the quality of an agentic workflow by examining (reflecting on) a step's output before passing that output to the next step.

The examiner is often the same LLM that generated the response (though it could be a different LLM). How could the same LLM that generated a response be a fair judge of its own response? The "trick" is to put the LLM in a critical (reflective) mindset. This process is analogous to a writer who uses a creative mindset to write a first draft and then switches to a critical mindset to edit it.

For example, imagine an agentic workflow whose first step is to create text for coffee mugs. The prompt for this step might be:

You are a creative. Generate humorous, original text of less than 50 characters suitable for a coffee mug.

Now imagine the following reflective prompt:

You are a coffee drinker. Would you find the preceding response humorous?

The workflow might then only pass text that receives a high reflection score to the next stage.

Reinforcement Learning from Human Feedback (RLHF)

Using feedback from human raters to improve the quality of a model's responses . For example, an RLHF mechanism can ask users to rate the quality of a model's response with a 👍 or 👎 emoji. The system can then adjust its future responses based on that feedback.

প্রতিক্রিয়া

The text, images, audio, or video that a generative AI model infers . In other words, a prompt is the input to a generative AI model and the response is the output .

response set

The collection of responses a large language model returns to an input prompt set .

role prompting

A prompt , typically beginning with the pronoun you , that tells a generative AI model to pretend to be a certain person or a certain role when generating the response . Role prompting can help a generative AI model get into the right "mindset" in order to generate a more useful response. For example, any of the following role prompts might be appropriate depending on the kind of response you are seeking:

You have a PhD in computer science.

You are a software engineer who enjoys giving patient explanations about Python to new programming students.

You are an action hero with a very particular set of programming skills. Assure me that you will find a particular item in a Python list.

স

soft prompt tuning

A technique for tuning a large language model for a particular task, without resource intensive fine-tuning . Instead of retraining all the weights in the model, soft prompt tuning automatically adjusts a prompt to achieve the same goal.

Given a textual prompt, soft prompt tuning typically appends additional token embeddings to the prompt and uses backpropagation to optimize the input.

A "hard" prompt contains actual tokens instead of token embeddings.

specificational coding

The process of writing and maintaining a file in a human language (for example, English) that describes software. You can then tell a generative AI model or another software engineer to create the software that fulfills that description.

Automatically-generated code generally requires iteration. In specificational coding, you iterate on the description file. By contrast, in conversational coding , you iterate within the prompt box. In practice, automatic code generation sometimes involves a combination of both specificational coding and conversational coding.

হ

তাপমাত্রা

A hyperparameter that controls the degree of randomness of a model's output. Higher temperatures result in more random output, while lower temperatures result in less random output.

Choosing the best temperature depends on the specific application and or string values.

উ

আল্ট্রা

The Gemini model with the most parameters . See Gemini Ultra for details.

হ

Vertex

Google Cloud's platform for AI and machine learning. Vertex provides tools and infrastructure for building, deploying, and managing AI applications, including access to Gemini models.vibe coding

Prompting a generative AI model to create software. That is, your prompts describe the software's purpose and features, which a generative AI model translates into source code. The generated code doesn't always match your intentions, so vibe coding usually requires iteration.

Andrej Karpathy coined the term vibe coding in this X post . In the X post, Karpathy describes it as "a new kind of coding...where you fully give in to the vibes..." So, the term originally implied an intentionally loose approach to creating software in which you might not even examine the generated code. However, the term has rapidly evolved in many circles to now mean any form of AI-generated coding.

For a more detailed description of vibe coding, seeWhat is vibe coding? .

In addition, compare and contrast vibe coding with:

হ

zero-shot prompting

A prompt that does not provide an example of how you want the large language model to respond. For example:

| Parts of one prompt | Notes |

|---|---|

| What is the official currency of the specified country? | The question you want the LLM to answer. |

| India: | The actual query. |

The large language model might respond with any of the following:

- রুপি

- আইএনআর

- ₹

- Indian rupee

- The rupee

- The Indian rupee

All of the answers are correct, though you might prefer a particular format.

Compare and contrast zero-shot prompting with the following terms: