Ce glossaire définit les termes liés à l'intelligence artificielle.

A

ablation

Technique permettant d'évaluer l'importance d'une caractéristique ou d'un composant en le supprimant temporairement d'un modèle. Vous réentraînez ensuite le modèle sans cette caractéristique ni ce composant. Si le modèle réentraîné est nettement moins performant, cela signifie que la caractéristique ou le composant supprimé était probablement important.

Par exemple, supposons que vous entraîniez un modèle de classification sur 10 caractéristiques et que vous obteniez une précision de 88 % sur l'ensemble de test. Pour vérifier l'importance de la première caractéristique, vous pouvez réentraîner le modèle en utilisant uniquement les neuf autres caractéristiques. Si le modèle réentraîné est beaucoup moins performant (par exemple, avec une précision de 55 %), cela signifie probablement que la caractéristique supprimée était importante. À l'inverse, si le modèle réentraîné est aussi performant, cela signifie que cette caractéristique n'était probablement pas si importante.

L'ablation peut également aider à déterminer l'importance des éléments suivants :

- Composants plus volumineux, tels qu'un sous-système entier d'un système de ML plus vaste

- Processus ou techniques, comme une étape de prétraitement des données

Dans les deux cas, vous observerez comment les performances du système évoluent (ou non) après la suppression du composant.

Tests A/B

Méthode statistique permettant de comparer deux techniques (ou plus), A et B. En règle générale, A est une technique existante et B est une nouvelle technique. Les tests A/B permettent non seulement de déterminer quelle technique est la plus performante, mais aussi de savoir si la différence est statistiquement significative.

Les tests A/B comparent généralement une seule métrique sur deux techniques. Par exemple, comment se compare l'exactitude du modèle pour deux techniques ? Toutefois, les tests A/B peuvent également comparer un nombre fini de métriques.

chip d'accélération

Catégorie de composants matériels spécialisés conçus pour effectuer les calculs clés nécessaires aux algorithmes de deep learning.

Les puces d'accélération (ou simplement accélérateurs) peuvent augmenter considérablement la vitesse et l'efficacité des tâches d'entraînement et d'inférence par rapport à un CPU à usage général. Elles sont idéales pour l'entraînement des réseaux neuronaux et les tâches similaires nécessitant beaucoup de calculs.

Voici quelques exemples de puces d'accélération :

- Les Tensor Processing Units (TPU) de Google sont dotés d'un matériel dédié au deep learning.

- Les GPU de NVIDIA, bien qu'initialement conçus pour le traitement graphique, sont conçus pour permettre le traitement parallèle, ce qui peut augmenter considérablement la vitesse de traitement.

accuracy

Nombre de prédictions de classification correctes divisé par le nombre total de prédictions. Par exemple :

Par exemple, un modèle qui a fait 40 prédictions correctes et 10 prédictions incorrectes aurait une précision de :

La classification binaire fournit des noms spécifiques pour les différentes catégories de prédictions correctes et de prédictions incorrectes. La formule de précision pour la classification binaire est la suivante :

où :

- VP correspond au nombre de vrais positifs (prédictions correctes).

- TN correspond au nombre de vrais négatifs (prédictions correctes).

- FP correspond au nombre de faux positifs (prédictions incorrectes).

- FN correspond au nombre de faux négatifs (prédictions incorrectes).

Comparez et opposez la justesse à la précision et au rappel.

Pour en savoir plus, consultez Classification : précision, rappel, exactitude et métriques associées dans le Cours d'initiation au Machine Learning.

action

Dans l'apprentissage par renforcement, le mécanisme par lequel l'agent passe d'un état de l'environnement à un autre. L'agent choisit l'action à l'aide d'une stratégie.

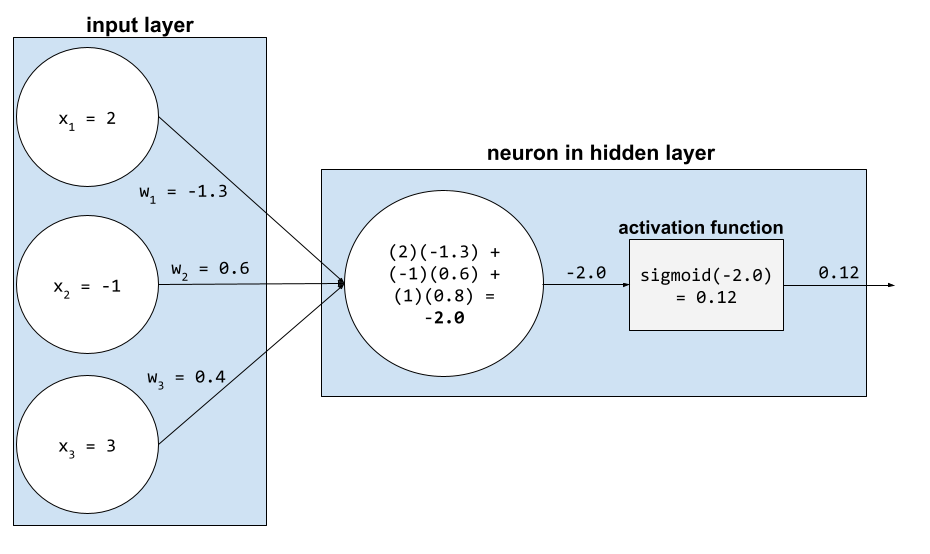

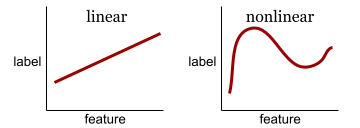

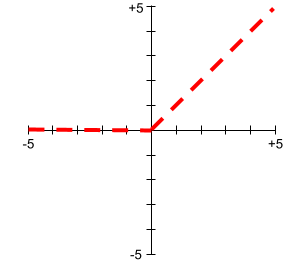

fonction d'activation

Fonction qui permet aux réseaux de neurones d'apprendre les relations non linéaires (complexes) entre les caractéristiques et le libellé.

Voici quelques fonctions d'activation courantes :

Les graphiques des fonctions d'activation ne sont jamais des lignes droites. Par exemple, le graphique de la fonction d'activation ReLU se compose de deux lignes droites :

Voici à quoi ressemble un graphique de la fonction d'activation sigmoïde :

Pour en savoir plus, consultez Réseaux de neurones : fonctions d'activation dans le Cours d'initiation au Machine Learning.

apprentissage actif

Méthode d'entraînement dans laquelle l'algorithme sélectionne une partie des données qui servent à son apprentissage. L'apprentissage actif est particulièrement utile lorsque les exemples étiquetés sont peu nombreux ou coûteux. Au lieu de rechercher sans distinction une gamme variée d'exemples étiquetés, un algorithme d'apprentissage actif recherche sélectivement la gamme spécifique des exemples qui serviront à son apprentissage.

AdaGrad

Algorithme complexe de descente de gradient qui redimensionne les gradients de chaque paramètre en attribuant à chacun des paramètres un taux d'apprentissage indépendant. Pour une explication complète, consultez Adaptive Subgradient Methods for Online Learning and Stochastic Optimization.

adaptation

Synonyme d'optimisation ou de réglage fin.

agent

Logiciel capable de raisonner sur les entrées utilisateur multimodales afin de planifier et d'exécuter des actions pour l'utilisateur.

Dans l'apprentissage par renforcement, un agent est l'entité qui utilise une stratégie pour maximiser le rendement attendu obtenu en passant d'un état de l'environnement à un autre.

mouton

Forme adjective de agent. Le terme "agentif" fait référence aux qualités que possèdent les agents (comme l'autonomie).

workflow agentif

Processus dynamique dans lequel un agent planifie et exécute de manière autonome des actions pour atteindre un objectif. Ce processus peut impliquer un raisonnement, l'appel d'outils externes et l'autocorrection de son plan.

clustering agglomératif

Voir clustering hiérarchique.

Déchets d'IA

Résultat d'un système d'IA générative qui privilégie la quantité à la qualité. Par exemple, une page Web contenant de la bouillie d'IA est remplie de contenus de mauvaise qualité, générés par IA et produits à bas prix.

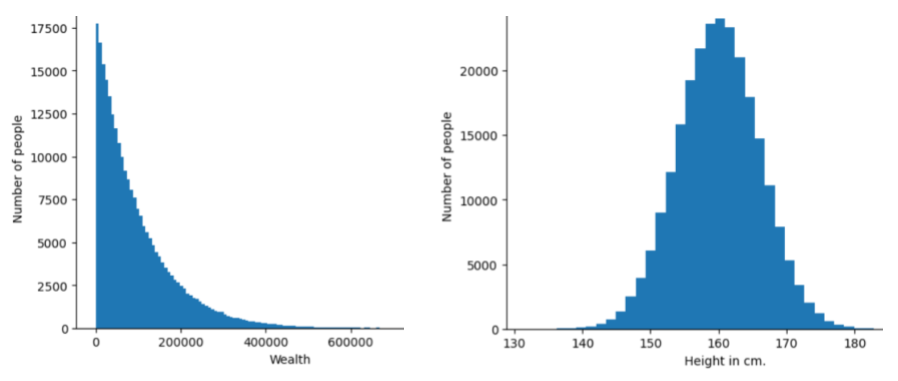

détection d'anomalies

Processus d'identification des valeurs aberrantes. Par exemple, si la moyenne d'une certaine caractéristique est de 100 avec un écart-type de 10, la détection des anomalies doit signaler une valeur de 200 comme suspecte.

RA

Abréviation de réalité augmentée.

aire sous la courbe de précision/rappel

Consultez AUC PR (aire sous la courbe de précision/rappel).

aire sous la courbe ROC

Consultez AUC (aire sous la courbe ROC).

intelligence artificielle générale

Mécanisme non humain qui fait preuve d'une large gamme de capacités de résolution de problèmes, de créativité et d'adaptabilité. Par exemple, un programme démontrant une intelligence générale artificielle pourrait traduire du texte, composer des symphonies et exceller dans des jeux qui n'ont pas encore été inventés.

intelligence artificielle

Un programme ou un modèle non humain capable de résoudre des tâches complexes. Par exemple, un programme ou un modèle qui traduit du texte, ou un programme ou un modèle qui identifie des maladies à partir d'images radiologiques, présentent tous deux une intelligence artificielle.

Formellement, le machine learning est un sous-domaine de l'intelligence artificielle. Toutefois, ces dernières années, certaines organisations ont commencé à utiliser les termes intelligence artificielle et machine learning de manière interchangeable.

"Attention",

Mécanisme utilisé dans un réseau de neurones qui indique l'importance d'un mot ou d'une partie de mot spécifique. L'attention compresse la quantité d'informations dont un modèle a besoin pour prédire le jeton/mot suivant. Un mécanisme d'attention typique peut se composer d'une somme pondérée sur un ensemble d'entrées, où le poids de chaque entrée est calculé par une autre partie du réseau de neurones.

Consultez également Auto-attention et Auto-attention multi-têtes, qui sont les éléments de base des Transformers.

Pour en savoir plus sur l'auto-attention, consultez LLM : qu'est-ce qu'un grand modèle de langage ? dans le cours d'initiation au Machine Learning.

attribut

Synonyme de caractéristique.

Dans l'équité du machine learning, les attributs font souvent référence à des caractéristiques propres aux individus.

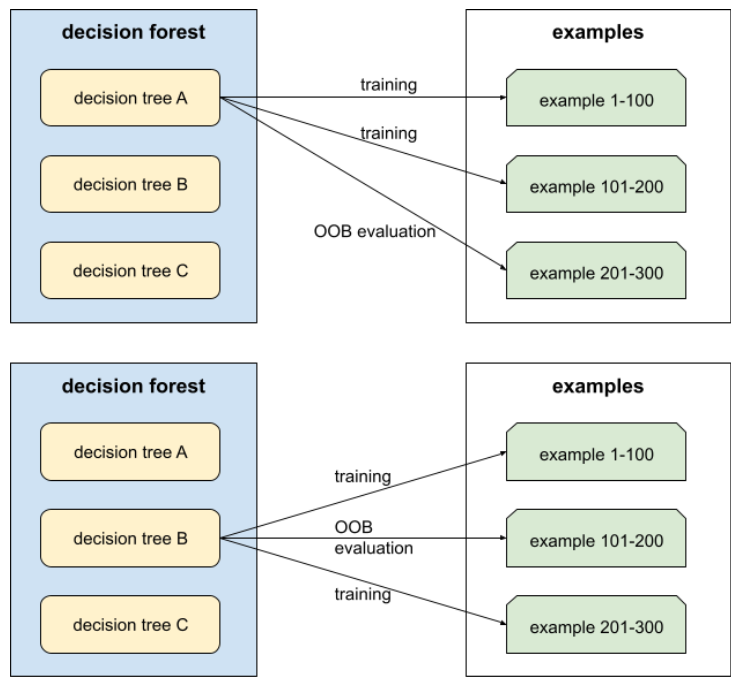

échantillonnage d'attributs

Tactique d'entraînement d'une forêt de décision dans laquelle chaque arbre de décision ne tient compte que d'un sous-ensemble aléatoire de caractéristiques lors de l'apprentissage de la condition. En général, un sous-ensemble différent de caractéristiques est échantillonné pour chaque nœud. En revanche, lorsque vous entraînez un arbre de décision sans échantillonnage d'attributs, toutes les caractéristiques possibles sont prises en compte pour chaque nœud.

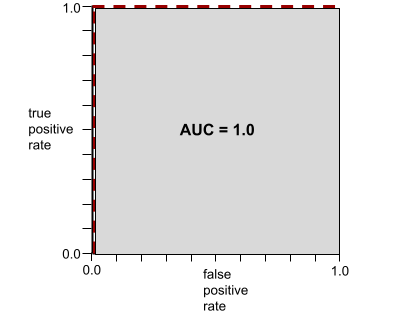

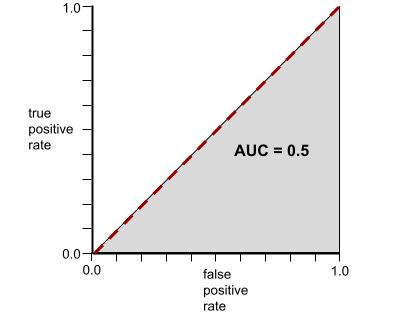

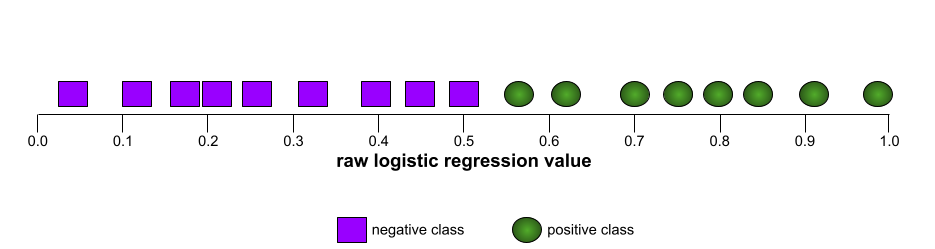

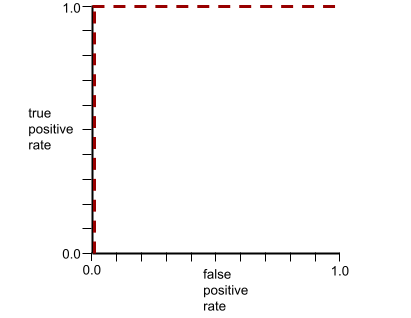

AUC (aire sous la courbe ROC)

Nombre compris entre 0,0 et 1,0 représentant la capacité d'un modèle de classification binaire à séparer les classes positives des classes négatives. Plus l'AUC est proche de 1,0, plus le modèle est performant pour séparer les classes les unes des autres.

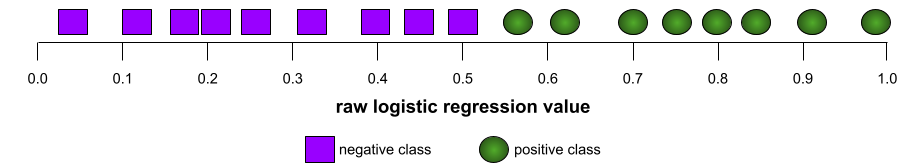

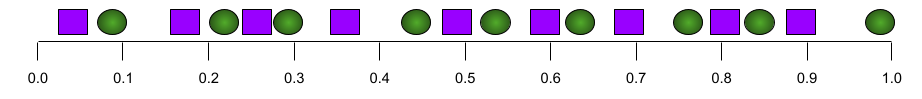

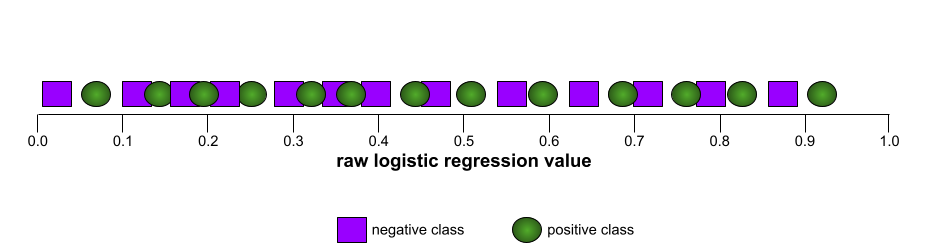

Par exemple, l'illustration suivante montre un modèle de classification qui sépare parfaitement les classes positives (ovales verts) des classes négatives (rectangles violets). Ce modèle parfait et irréaliste a une AUC de 1,0 :

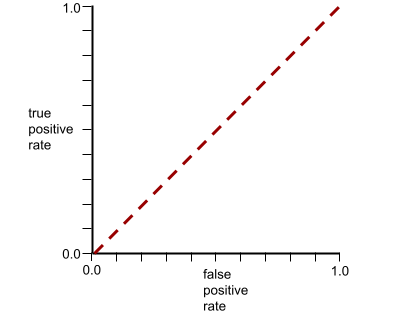

À l'inverse, l'illustration suivante montre les résultats d'un modèle de classification qui a généré des résultats aléatoires. Ce modèle a une AUC de 0,5 :

Oui, le modèle précédent a une AUC de 0,5, et non de 0.

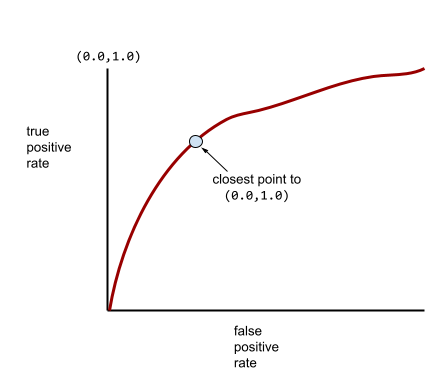

La plupart des modèles se situent entre ces deux extrêmes. Par exemple, le modèle suivant sépare plus ou moins les positifs des négatifs et présente donc une AUC comprise entre 0,5 et 1,0 :

L'AUC ignore toute valeur que vous définissez pour le seuil de classification. L'AUC prend en compte tous les seuils de classification possibles.

Pour en savoir plus, consultez Classification : ROC et AUC dans le Cours d'initiation au machine learning.

réalité augmentée

Technologie qui superpose une image générée par ordinateur à la vue de l'utilisateur sur le monde réel, fournissant ainsi une vue composite.

auto-encodeur

Système qui apprend à extraire les informations les plus importantes de l'entrée. Les auto-encodeurs sont une combinaison d'un encodeur et d'un décodeur. Les auto-encodeurs reposent sur le processus en deux étapes suivant :

- L'encodeur mappe l'entrée dans un format (intermédiaire) de dimension inférieure (généralement avec perte).

- Le décodeur crée une version avec perte de l'entrée d'origine en mappant le format de dimension inférieure au format d'entrée de dimension supérieure d'origine.

Les auto-encodeurs sont entraînés de bout en bout en demandant au décodeur de reconstruire le format intermédiaire de l'encodeur à partir de l'entrée d'origine aussi fidèlement que possible. Comme le format intermédiaire est plus petit (de dimension inférieure) que le format d'origine, l'auto-encodeur est obligé d'apprendre quelles informations de l'entrée sont essentielles. La sortie ne sera donc pas parfaitement identique à l'entrée.

Exemple :

- Si les données d'entrée sont un graphique, la copie non exacte sera semblable au graphique d'origine, mais légèrement modifiée. Il se peut que la copie non exacte supprime le bruit de l'image d'origine ou remplisse certains pixels manquants.

- Si les données d'entrée sont du texte, un auto-encodeur génère un nouveau texte qui imite (mais n'est pas identique à) le texte d'origine.

Voir aussi Auto-encodeurs variationnels.

évaluation automatique

Utilisation d'un logiciel pour évaluer la qualité de la sortie d'un modèle.

Lorsque la sortie du modèle est relativement simple, un script ou un programme peut comparer la sortie du modèle à une réponse de référence. Ce type d'évaluation automatique est parfois appelé évaluation programmatique. Les métriques telles que ROUGE ou BLEU sont souvent utiles pour l'évaluation programmatique.

Lorsque le résultat du modèle est complexe ou qu'il n'y a pas de bonne réponse, un programme de ML distinct appelé évaluateur automatique effectue parfois l'évaluation automatique.

À comparer à l'évaluation humaine.

biais d'automatisation

Lorsqu'un décisionnaire humain donne priorité aux recommandations d'un système automatisé de prise de décision par rapport aux informations ne provenant pas d'un processus d'automatisation, même en cas d'erreur du système automatisé.

Pour en savoir plus, consultez Équité : types de biais dans le cours d'initiation au machine learning.

AutoML

Tout processus automatisé de création de modèles de machine learning. AutoML peut effectuer automatiquement des tâches telles que les suivantes :

- Recherchez le modèle le plus approprié.

- Réglez les hyperparamètres.

- Préparer les données (y compris l'ingénierie des caractéristiques).

- Déployez le modèle obtenu.

AutoML est utile aux data scientists, car il leur permet de gagner du temps et de l'énergie lors du développement de pipelines de machine learning, et d'améliorer la précision des prédictions. Il est également utile aux non-experts, car il leur permet d'accéder plus facilement à des tâches complexes de machine learning.

Pour en savoir plus, consultez Automated Machine Learning (AutoML) dans le cours d'initiation au Machine Learning.

Évaluation de l'outil d'évaluation automatique

Mécanisme hybride permettant d'évaluer la qualité de la sortie d'un modèle d'IA générative, qui combine l'évaluation humaine et l'évaluation automatique. Un évaluateur automatique est un modèle de ML entraîné sur des données créées par l'évaluation humaine. Idéalement, un évaluateur automatique apprend à imiter un évaluateur humain.Des évaluateurs automatiques prédéfinis sont disponibles, mais les meilleurs sont affinés spécifiquement pour la tâche que vous évaluez.

modèle autorégressif

Un modèle qui déduit une prédiction en fonction de ses propres prédictions précédentes. Par exemple, les modèles de langage autorégressifs prédisent le prochain jeton en fonction des jetons prédits précédemment. Tous les grands modèles de langage basés sur Transformer sont autorégressifs.

En revanche, les modèles d'images basés sur les GAN ne sont généralement pas autorégressifs, car ils génèrent une image en une seule passe avant, et non de manière itérative par étapes. Cependant, certains modèles de génération d'images sont autorégressifs, car ils génèrent une image par étapes.

perte auxiliaire

Une fonction de perte (utilisée conjointement avec la fonction de perte principale d'un modèle de réseau de neurones) qui permet d'accélérer l'entraînement lors des premières itérations, lorsque les pondérations sont initialisées de manière aléatoire.

Les fonctions de perte auxiliaires transmettent des gradients efficaces aux couches précédentes. Cela facilite la convergence pendant l'entraînement en luttant contre le problème de disparition du gradient.

précision moyenne à k

Métrique permettant de résumer les performances d'un modèle sur une seule invite qui génère des résultats classés, comme une liste numérotée de recommandations de livres. La précision moyenne à k correspond à la moyenne des valeurs de précision à k pour chaque résultat pertinent. La formule de la précision moyenne à k est donc la suivante :

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

où :

- \(n\) correspond au nombre d'éléments pertinents dans la liste.

À comparer au rappel à k.

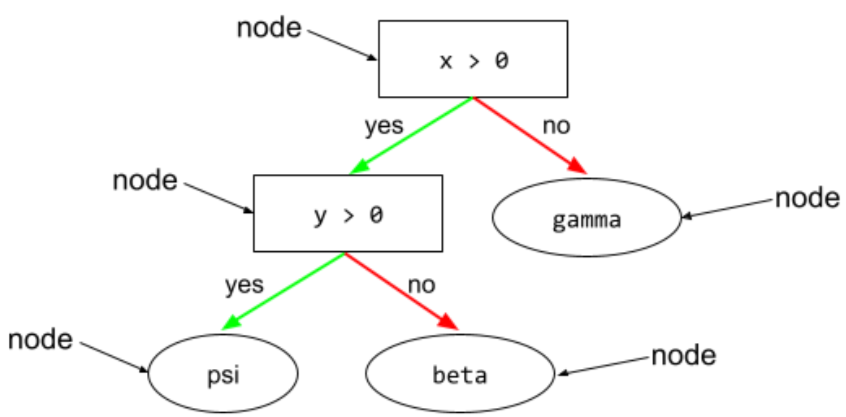

condition alignée sur un axe

Dans un arbre de décision, une condition

qui n'implique qu'une seule caractéristique. Par exemple, si area est une caractéristique, la condition suivante est alignée sur un axe :

area > 200

À comparer à condition oblique.

B

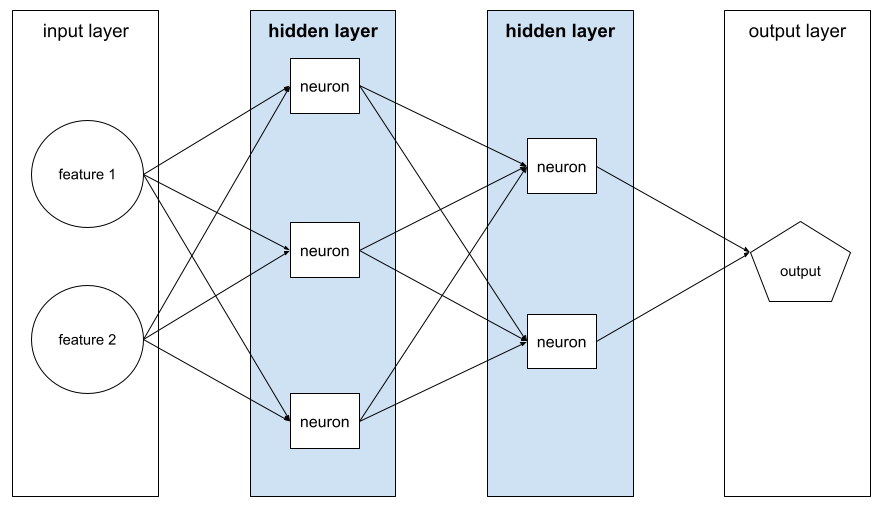

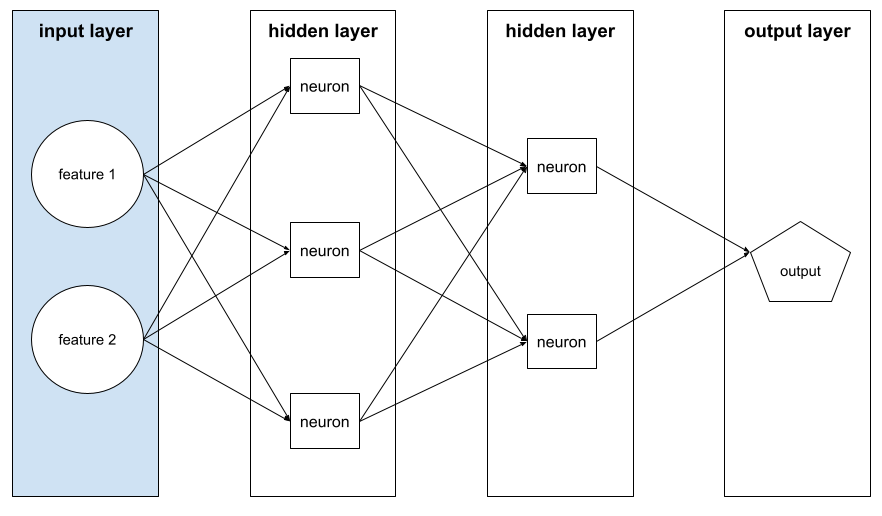

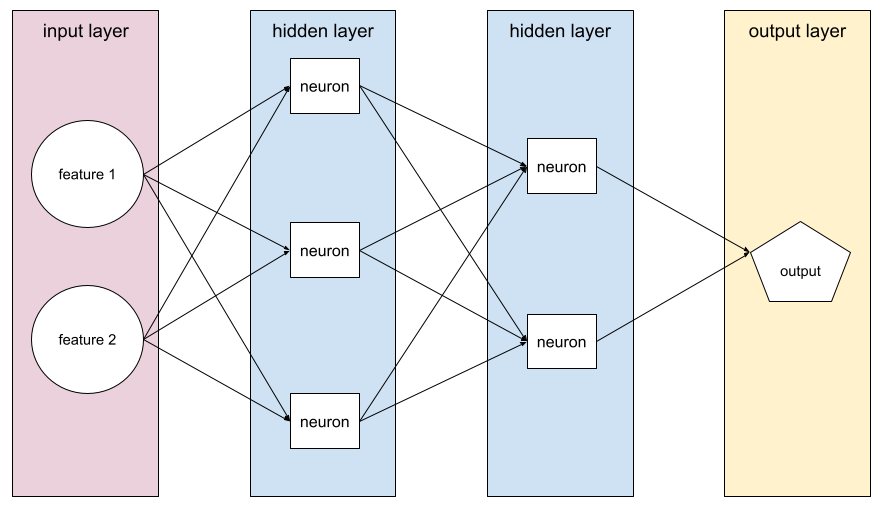

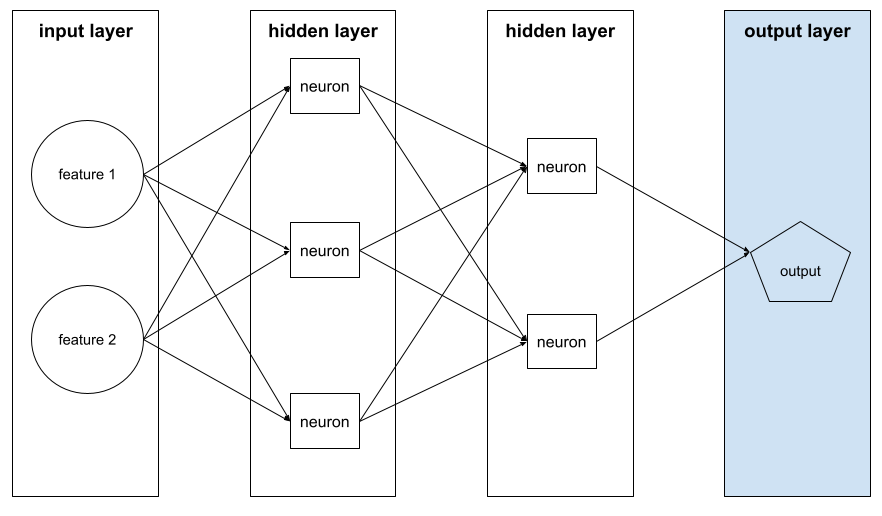

rétropropagation

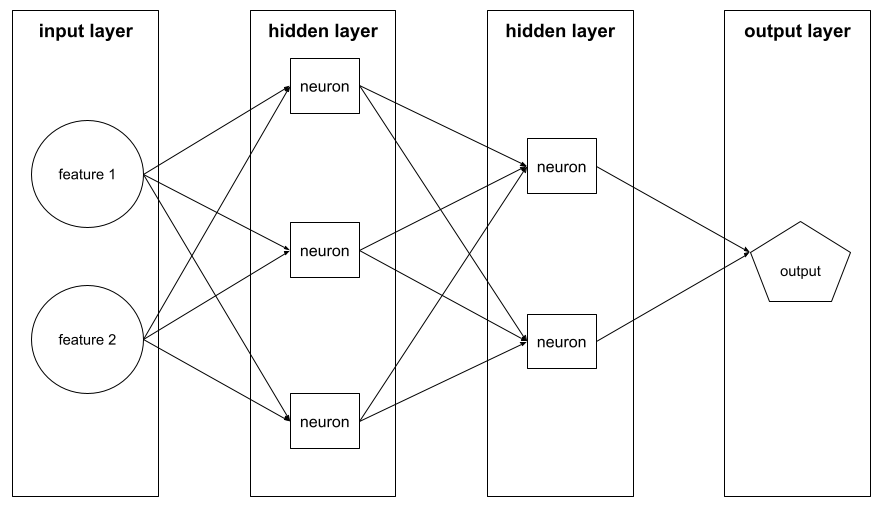

Algorithme qui implémente la descente de gradient dans les réseaux de neurones.

L'entraînement d'un réseau de neurones implique de nombreuses itérations du cycle à deux passes suivant :

- Lors de la propagation directe, le système traite un lot d'exemples pour générer une ou plusieurs prédictions. Le système compare chaque prédiction à chaque valeur de libellé. La différence entre la prédiction et la valeur du libellé correspond à la perte pour cet exemple. Le système agrège les pertes de tous les exemples pour calculer la perte totale du lot actuel.

- Lors de la propagation arrière (rétropropagation), le système réduit la perte en ajustant les pondérations de tous les neurones dans toutes les couches cachées.

Les réseaux de neurones contiennent souvent de nombreux neurones répartis sur plusieurs couches cachées. Chacun de ces neurones contribue à la perte globale de différentes manières. La rétropropagation détermine s'il faut augmenter ou diminuer les pondérations appliquées à des neurones spécifiques.

Le taux d'apprentissage est un multiplicateur qui contrôle le degré d'augmentation ou de diminution de chaque poids à chaque passe arrière. Un taux d'apprentissage élevé augmentera ou diminuera chaque poids plus qu'un taux d'apprentissage faible.

En termes de calcul, la rétropropagation implémente la règle de la chaîne du calcul. Autrement dit, la rétropropagation calcule la dérivée partielle de l'erreur par rapport à chaque paramètre.

Il y a quelques années, les spécialistes du ML devaient écrire du code pour implémenter la rétropropagation. Les API de ML modernes comme Keras implémentent désormais la rétropropagation pour vous. Ouf !

Pour en savoir plus, consultez Réseaux de neurones dans le cours d'initiation au machine learning.

bagging

Méthode d'entraînement d'un ensemble où chaque modèle constitutif s'entraîne sur un sous-ensemble aléatoire d'exemples d'entraînement échantillonnés avec remplacement. Par exemple, une forêt aléatoire est une collection d'arbres de décision entraînés avec le bagging.

Le terme bagging est l'abréviation de bootstrap aggregating.

Pour en savoir plus, consultez Forêts aléatoires dans le cours "Forêts de décision".

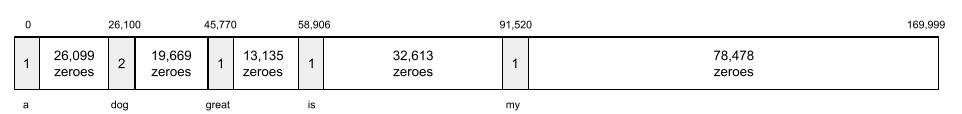

sac de mots

Représentation des mots d'une expression ou d'un extrait, quel que soit leur ordre. Par exemple, un sac de mots représente les trois phrases suivantes à l'identique :

- the dog jumps

- jumps the dog

- dog jumps the

Chaque mot est mappé à l'index correspondant d'un vecteur creux, où le vecteur a un index pour chaque mot du vocabulaire. Par exemple, la phrase the dog jumps est mappée dans un vecteur de caractéristiques dont les trois indices correspondant aux mots the, dog et jumps auront des valeurs non nulles. La valeur non nulle peut être l'une des suivantes :

- 1 pour indiquer la présence d'un mot.

- Le nombre d'apparition d'un mot dans le sac. Par exemple, si l'expression est the maroon dog is a dog with maroon fur, les mots maroon et dog seront représentés par la valeur 2, tandis que les autres mots seront représentés par la valeur 1.

- Une autre valeur, telle que le logarithme du nombre d'apparition d'un mot dans le sac.

Valeur de référence

Un modèle utilisé comme point de référence pour comparer les performances d'un autre modèle (généralement plus complexe). Par exemple, un modèle de régression logistique peut servir de bonne référence pour un modèle profond.

Pour un problème donné, la référence aide les développeurs de modèles à quantifier les performances minimales attendues qu'un nouveau modèle doit atteindre pour être utile.

modèle de base

Un modèle pré-entraîné qui peut servir de point de départ pour l'affinage afin de répondre à des tâches ou applications spécifiques.

Voir aussi modèle pré-entraîné et modèle de fondation.

lot

Ensemble d'exemples utilisés dans une itération d'entraînement. La taille de lot détermine le nombre d'exemples dans un lot.

Pour comprendre le lien entre un lot et une époque, consultez époque.

Pour en savoir plus, consultez Régression linéaire : hyperparamètres dans le Cours d'initiation au Machine Learning.

inférence par lot

Processus d'inférence des prédictions sur plusieurs exemples non étiquetés divisés en sous-ensembles plus petits ("lots").

L'inférence par lot peut tirer parti des fonctionnalités de parallélisation des puces d'accélération. Autrement dit, plusieurs accélérateurs peuvent inférer simultanément des prédictions sur différents lots d'exemples non libellés, ce qui augmente considérablement le nombre d'inférences par seconde.

Pour en savoir plus, consultez Systèmes de ML de production : inférence statique ou dynamique dans le Cours d'initiation au Machine Learning.

normalisation par lots

Normaliser l'entrée ou la sortie des fonctions d'activation dans une couche cachée. La normalisation des lots peut offrir les avantages suivants :

- Renforcer la stabilité des réseaux de neurones en les protégeant contre les pondérations aberrantes.

- Améliorer les taux d'apprentissage, ce qui peut accélérer l'entraînement.

- Réduisez le surapprentissage.

taille du lot

Nombre d'exemples dans un lot. Par exemple, si la taille de lot est de 100, le modèle traite 100 exemples par itération.

Voici quelques stratégies de taille de lot populaires :

- Descente de gradient stochastique (SGD), dans laquelle la taille du lot est de 1.

- Lot complet : la taille du lot correspond au nombre d'exemples dans l'ensemble d'entraînement. Par exemple, si l'ensemble d'entraînement contient un million d'exemples, la taille du lot sera d'un million d'exemples. Le traitement par lot complet est généralement une stratégie inefficace.

- Mini-lot : la taille de lot est généralement comprise entre 10 et 1 000. Le mini-lot est généralement la stratégie la plus efficace.

Pour en savoir plus, lisez les informations ci-après.

- Systèmes de production de ML : inférence statique ou dynamique dans le cours d'initiation au machine learning

- Playbook sur l'optimisation du deep learning.

Réseau de neurones bayésien

Réseau de neurones probabiliste qui prend en compte les incertitudes liées aux pondérations et aux résultats. Un modèle de régression de réseau neuronal standard prédit généralement une valeur scalaire. Par exemple, un modèle standard prédit le prix d'une maison à 853 000. En revanche, un réseau de neurones bayésien prédit une distribution de valeurs. Par exemple, un modèle bayésien prédit le prix d'une maison à 853 000 avec un écart type de 67 200.

Un réseau de neurones bayésien s'appuie sur le théorème de Bayes pour calculer les incertitudes liées aux pondérations et aux prédictions. Un réseau de neurones bayésien peut être utile lorsqu'il est important de quantifier l'incertitude, comme dans les modèles liés aux produits pharmaceutiques. Les réseaux de neurones bayésiens peuvent également empêcher le surapprentissage.

Optimisation bayésienne

Une technique de modélisation de régression probabiliste pour optimiser les fonctions objectives coûteuses en termes de calcul en optimisant plutôt un substitut qui quantifie l'incertitude à l'aide d'une technique d'apprentissage bayésienne. Étant donné que l'optimisation bayésienne est elle-même très coûteuse, elle est généralement utilisée pour optimiser les tâches coûteuses à évaluer qui comportent un petit nombre de paramètres, comme la sélection des hyperparamètres.

Équation de Bellman

Dans l'apprentissage par renforcement, l'identité suivante est satisfaite par la fonction Q optimale :

\[Q(s, a) = r(s, a) + \gamma \mathbb{E}_{s'|s,a} \max_{a'} Q(s', a')\]

Les algorithmes d'apprentissage par renforcement appliquent cette identité pour créer l'apprentissage par renforcement à l'aide de la règle de mise à jour suivante :

\[Q(s,a) \gets Q(s,a) + \alpha \left[r(s,a) + \gamma \displaystyle\max_{\substack{a_1}} Q(s',a') - Q(s,a) \right] \]

Au-delà de l'apprentissage par renforcement, l'équation de Bellman s'applique à la programmation dynamique. Consultez l' article Wikipédia sur l'équation de Bellman.

BERT (Bidirectional Encoder Representations from Transformers)

Architecture de modèle pour la représentation de texte. Un modèle BERT entraîné peut faire partie d'un modèle plus vaste pour la classification de texte ou d'autres tâches de ML.

BERT présente les caractéristiques suivantes :

- Utilise l'architecture Transformer et repose donc sur l'auto-attention.

- Utilise la partie encodeur du Transformer. Le rôle de l'encodeur est de produire de bonnes représentations textuelles, plutôt que d'effectuer une tâche spécifique comme la classification.

- Bidirectionnel

- Utilise le masquage pour l'entraînement non supervisé.

Voici quelques variantes de BERT :

Pour obtenir une présentation de BERT, consultez Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing.

biais (éthique/équité) (bias (ethics/fairness))

1. Stéréotypes, préjudice ou favoritisme envers certains groupes, choses ou personnes par rapport à d'autres. Ces biais peuvent avoir une incidence sur la collecte et l'interprétation des données, ainsi que sur la conception d'un système et la manière dont les utilisateurs interagissent avec celui-ci. Les formes de ce type de biais comprennent les éléments suivants :

- biais d'automatisation

- biais de confirmation

- effet expérimentateur

- biais de représentativité

- biais implicite

- biais d'appartenance

- biais d'homogénéité de l'exogroupe

2. Erreur systématique introduite par une procédure d'échantillonnage ou de rapport. Les formes de ce type de biais comprennent les éléments suivants :

- biais de couverture

- biais de non-réponse

- biais de participation

- biais de fréquence

- biais d'échantillonnage

- biais de sélection

À ne pas confondre avec le biais des modèles de machine learning ou le biais de prédiction.

Pour en savoir plus, consultez Équité : types de biais dans le cours d'initiation au machine learning.

biais (mathématiques) ou terme de biais

Ordonnée à l'origine ou décalage par rapport à une origine. Le biais est un paramètre des modèles de machine learning, symbolisé par l'un des éléments suivants :

- b

- w0

Par exemple, b représente le biais dans la formule suivante :

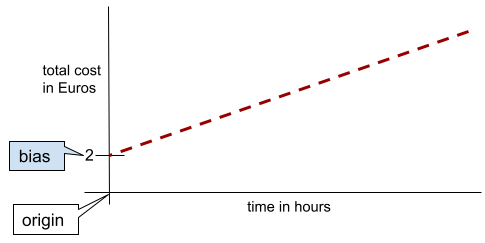

Dans une ligne bidimensionnelle simple, le biais signifie simplement "ordonnée à l'origine". Par exemple, le biais de la ligne dans l'illustration suivante est de 2.

Le biais existe, car tous les modèles ne partent pas de l'origine (0,0). Par exemple, supposons qu'un parc d'attractions coûte 2 euros à l'entrée et 0,5 euro supplémentaire par heure passée par un client. Par conséquent, un modèle mappant le coût total présente un biais de 2, car le coût le plus bas est de 2 euros.

Le biais ne doit pas être confondu avec le biais en matière d'éthique et d'équité ni avec le biais de prédiction.

Pour en savoir plus, consultez Régression linéaire dans le Cours d'initiation au Machine Learning.

bidirectionnel

Terme utilisé pour décrire un système qui évalue le texte qui précède et suit une section de texte cible. En revanche, un système unidirectionnel n'évalue que le texte qui précède une section de texte cible.

Par exemple, prenons l'exemple d'un modèle de langage masqué qui doit déterminer les probabilités du ou des mots représentant le soulignement dans la question suivante :

Qu'est-ce qui ne va pas chez toi ?

Un modèle de langage unidirectionnel devrait baser ses probabilités uniquement sur le contexte fourni par les mots "Qu'", "est" et "la". En revanche, un modèle de langage bidirectionnel pourrait également obtenir du contexte à partir de "avec" et "vous", ce qui pourrait l'aider à générer de meilleures prédictions.

modèle de langage bidirectionnel

Un modèle de langage qui détermine la probabilité qu'un jeton donné soit présent à un emplacement donné dans un extrait de texte en fonction du texte précédent et suivant.

bigramme

Un N-gramme dans lequel N=2.

classification binaire

Type de tâche de classification qui prédit l'une des deux classes mutuellement exclusives :

Par exemple, les deux modèles de machine learning suivants effectuent chacun une classification binaire :

- Modèle qui détermine si les e-mails sont du spam (classe positive) ou non-spam (classe négative).

- Un modèle qui évalue les symptômes médicaux pour déterminer si une personne est atteinte d'une maladie particulière (classe positive) ou non (classe négative).

À comparer à la classification à classes multiples.

Consultez également Régression logistique et Seuil de classification.

Pour en savoir plus, consultez la section Classification du cours d'initiation au machine learning.

condition binaire

Dans un arbre de décision, une condition qui n'a que deux résultats possibles, généralement oui ou non. Par exemple, la condition suivante est une condition binaire :

temperature >= 100

À comparer à la condition non binaire.

Pour en savoir plus, consultez Types de conditions dans le cours "Forêts de décision".

binning

Synonyme de binning.

modèle de boîte noire

Un modèle dont le "raisonnement" est impossible ou difficile à comprendre pour les humains. En d'autres termes, même si les humains peuvent voir comment les requêtes affectent les réponses, ils ne peuvent pas déterminer exactement comment un modèle de boîte noire détermine la réponse. En d'autres termes, un modèle de boîte noire manque d'interprétabilité.

La plupart des modèles profonds et des grands modèles de langage sont des boîtes noires.

BLEU (Bilingual Evaluation Understudy)

Métrique comprise entre 0 et 1 permettant d'évaluer les traductions automatiques, par exemple de l'espagnol vers le japonais.

Pour calculer un score, BLEU compare généralement la traduction d'un modèle de ML (texte généré) à la traduction d'un expert humain (texte de référence). Le score BLEU est déterminé par le degré de correspondance des n-grammes dans le texte généré et le texte de référence.

L'article d'origine sur cette métrique est BLEU: a Method for Automatic Evaluation of Machine Translation.

Voir aussi BLEURT.

BLEURT (Bilingual Evaluation Understudy from Transformers)

Métrique permettant d'évaluer les traductions automatiques d'une langue à une autre, en particulier vers et depuis l'anglais.

Pour les traductions vers et depuis l'anglais, BLEURT est plus proche des évaluations humaines que BLEU. Contrairement à BLEU, BLEURT met l'accent sur les similitudes sémantiques (sens) et peut s'adapter à la reformulation.

BLEURT s'appuie sur un grand modèle de langage pré-entraîné (BERT, pour être précis) qui est ensuite affiné sur du texte provenant de traducteurs humains.

L'article d'origine sur cette métrique est BLEURT: Learning Robust Metrics for Text Generation.

Questions booléennes (BoolQ)

Ensemble de données permettant d'évaluer la capacité d'un LLM à répondre à des questions par "oui" ou "non". Chacun des défis de l'ensemble de données comporte trois éléments :

- Une requête

- Passage impliquant la réponse à la requête.

- La bonne réponse, qui est oui ou non.

Exemple :

- Requête : Y a-t-il des centrales nucléaires dans le Michigan ?

- Extrait : …trois centrales nucléaires fournissent environ 30 % de l'électricité du Michigan.

- Bonne réponse : Oui

Les chercheurs ont recueilli les questions à partir de requêtes de recherche Google anonymisées et agrégées, puis ont utilisé les pages Wikipédia pour ancrer les informations.

Pour en savoir plus, consultez BoolQ : Exploring the Surprising Difficulty of Natural Yes/No Questions.

BoolQ est un composant de l'ensemble SuperGLUE.

BoolQ

Abréviation de Boolean Questions (questions booléennes).

booster

Technique de machine learning qui combine de manière itérative un ensemble de modèles de classification simples et peu précis (appelés "classificateurs faibles") en un modèle de classification très précis (un "classificateur fort") en surpondérant les exemples que le modèle classifie actuellement de manière erronée.

Pour en savoir plus, consultez Boosting de gradient sur arbre de décision dans le cours "Forêts de décision".

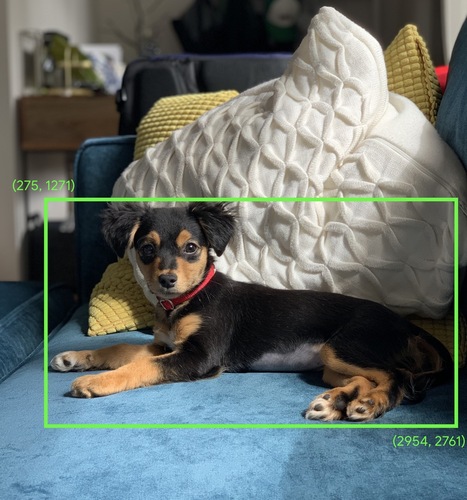

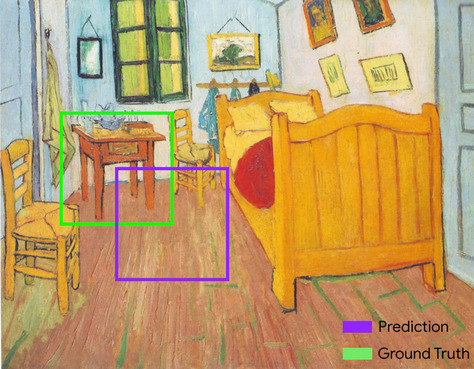

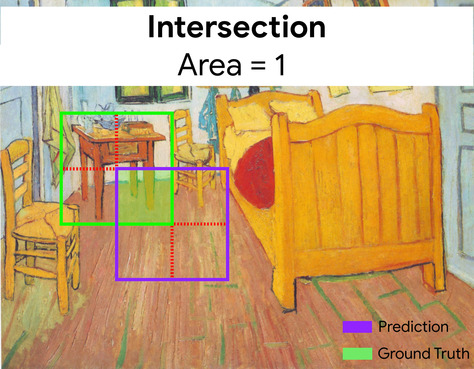

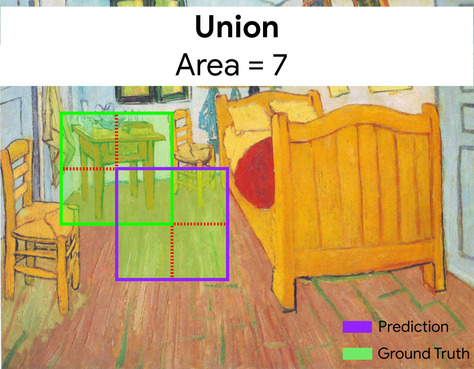

cadre de délimitation

Dans une image, les coordonnées (x, y) d'un rectangle autour d'une zone d'intérêt, comme le chien dans l'image ci-dessous.

diffusion

Développer la forme d'un opérande d'une opération mathématique matricielle à des dimensions compatibles pour cette opération. Par exemple, en algèbre linéaire, il est nécessaire que les deux opérandes d'une opération d'addition matricielle aient les mêmes dimensions. Par conséquent, vous ne pouvez pas ajouter une matrice de forme (m, n) à un vecteur de longueur n. Le broadcasting permet d'effectuer cette opération en développant virtuellement le vecteur de longueur n en une matrice de forme (m, n) en répliquant les mêmes valeurs dans chaque colonne.

Voir la description suivante de broadcasting dans NumPy pour en savoir plus.

le binning

Conversion d'une seule caractéristique en plusieurs caractéristiques binaires appelées ensembles ou classes, généralement en fonction d'une plage de valeurs. La caractéristique tronquée est généralement une caractéristique continue.

Par exemple, au lieu de représenter la température comme une seule caractéristique continue à virgule flottante, vous pouvez découper les plages de températures en buckets distincts, tels que :

- La catégorie "froid" correspond à une température inférieure ou égale à 10 degrés Celsius.

- La tranche "tempérée" correspondrait à une température comprise entre 11 et 24 degrés Celsius.

- La tranche "chaud" correspondrait à une température supérieure ou égale à 25 degrés Celsius.

Le modèle traitera chaque valeur du même bucket de manière identique. Par exemple, les valeurs 13 et 22 appartiennent toutes les deux au bucket "tempéré". Le modèle les traite donc de manière identique.

Pour en savoir plus, consultez Données numériques : binning dans le cours d'initiation au machine learning.

C

couche de calibration

Ajustement réalisé après la prédiction, généralement pour prendre en compte le biais de prédiction. Les prédictions et les probabilités ajustées doivent correspondre à la distribution d'un ensemble observé d'étiquettes.

génération de candidats

Ensemble initial de recommandations sélectionné par un système de recommandation. Prenons l'exemple d'une librairie proposant 100 000 livres. La phase de génération de candidats crée une liste beaucoup plus restreinte de livres pertinents pour un utilisateur particulier, par exemple 500. Mais recommander 500 livres à un utilisateur reste beaucoup trop. Les phases ultérieures et plus coûteuses d'un système de recommandation (comme le scoring et le reclassement) réduisent considérablement cet ensemble de 500 recommandations afin de le rendre plus utile.

Pour en savoir plus, consultez la présentation de la génération de candidats dans le cours sur les systèmes de recommandation.

échantillonnage de candidats

Optimisation réalisée lors de l'entraînement, dans laquelle une probabilité est calculée pour toutes les étiquettes positives, en utilisant par exemple softmax, mais seulement pour un échantillon aléatoire d'étiquettes négatives. Par exemple, si un exemple est étiqueté beagle et chien, l'échantillonnage de candidats calcule les probabilités prédites et les termes de pertes correspondants pour :

- beagle

- chien

- un sous-ensemble aléatoire des classes négatives restantes (par exemple, chat, sucette, clôture).

L'idée est que les classes négatives peuvent apprendre à partir d'un renforcement négatif moins fréquent tant que les classes positives sont correctement renforcées positivement, ce qui est effectivement observé empiriquement.

L'échantillonnage de candidats est plus efficace en termes de calcul que les algorithmes d'entraînement qui calculent les prédictions pour toutes les classes négatives, en particulier lorsque le nombre de classes négatives est très élevé.

données catégorielles

Caractéristiques avec un ensemble spécifique de valeurs possibles. Par exemple, prenons une caractéristique catégorielle nommée traffic-light-state, qui ne peut avoir que l'une des trois valeurs possibles suivantes :

redyellowgreen

En représentant traffic-light-state comme une caractéristique catégorielle, un modèle peut apprendre les différents impacts de red, green et yellow sur le comportement du conducteur.

Les caractéristiques catégorielles sont parfois appelées caractéristiques discrètes.

À comparer aux données numériques.

Pour en savoir plus, consultez Utiliser des données catégorielles dans le cours d'initiation au machine learning.

modèle de langage causal

Synonyme de modèle de langage unidirectionnel.

Consultez modèle de langage bidirectionnel pour comparer différentes approches directionnelles dans la modélisation du langage.

CB

Abréviation de CommitmentBank.

centroid

Centre d'un cluster tel que déterminé par un algorithme k-means ou k-median. Par exemple, si k est égal à 3, alors l'algorithme k-moyennes ou k-médiane trouve 3 centroïdes.

Pour en savoir plus, consultez Algorithmes de clustering dans le cours sur le clustering.

clustering basé sur centroïde

Catégorie d'algorithmes de clustering qui organisent les données en clusters non hiérarchiques. k-moyennes est l'algorithme de clustering basé sur centroïde le plus utilisé.

À comparer aux algorithmes de clustering hiérarchique.

Pour en savoir plus, consultez Algorithmes de clustering dans le cours sur le clustering.

prompting par chaîne de pensée

Technique d'ingénierie des requêtes qui encourage un grand modèle de langage (LLM) à expliquer son raisonnement, étape par étape. Par exemple, examinez l'invite suivante, en prêtant une attention particulière à la deuxième phrase :

Combien de forces G un conducteur ressentirait-il dans une voiture qui passe de 0 à 100 km/h en 7 secondes ? Dans la réponse, indique tous les calculs pertinents.

La réponse du LLM serait probablement :

- Affiche une séquence de formules physiques, en insérant les valeurs 0, 60 et 7 aux endroits appropriés.

- Explique pourquoi il a choisi ces formules et ce que signifient les différentes variables.

Le prompting en chaîne de pensée force le LLM à effectuer tous les calculs, ce qui peut conduire à une réponse plus correcte. De plus, l'incitation à la réflexion en chaîne permet à l'utilisateur d'examiner les étapes du LLM pour déterminer si la réponse est logique ou non.

Score F de N-grammes de caractères (ChrF)

Métrique permettant d'évaluer les modèles de traduction automatique. Le score F des n-grammes de caractères détermine le degré de chevauchement des n-grammes dans le texte de référence avec les n-grammes dans le texte généré d'un modèle de ML.

Le score F de n-grammes de caractères est semblable aux métriques des familles ROUGE et BLEU, sauf que :

- Le score F des n-grammes de caractères fonctionne sur les n-grammes de caractères.

- ROUGE et BLEU fonctionnent sur des N-grammes de mots ou des jetons.

chat

Contenu d'un dialogue avec un système de ML, généralement un grand modèle de langage. L'interaction précédente dans une discussion (ce que vous avez écrit et la réponse du grand modèle de langage) devient le contexte pour les parties suivantes de la discussion.

Un chatbot est une application d'un grand modèle de langage.

point de contrôle

Données qui capturent l'état des paramètres d'un modèle pendant l'entraînement ou une fois celui-ci terminé. Par exemple, pendant l'entraînement, vous pouvez :

- Arrêter l'entraînement, peut-être intentionnellement ou en raison de certaines erreurs.

- Capturez le point de contrôle.

- Rechargez ensuite le point de contrôle, éventuellement sur un autre matériel.

- Redémarrez l'entraînement.

Choix d'alternatives plausibles (COPA)

Ensemble de données permettant d'évaluer la capacité d'un LLM à identifier la meilleure réponse parmi deux alternatives à une prémisse. Chacun des défis de l'ensemble de données se compose de trois éléments :

- Une hypothèse, qui est généralement une affirmation suivie d'une question

- Deux réponses possibles à la question posée dans le postulat, dont l'une est correcte et l'autre incorrecte

- La bonne réponse

Exemple :

- Hypothèse : l'homme s'est cassé un orteil. Quelle est la CAUSE de ce problème ?

- Réponses possibles :

- Il a un trou dans sa chaussette.

- Il s'est fait tomber un marteau sur le pied.

- Bonne réponse : 2

COPA est un composant de l'ensemble SuperGLUE.

classe

Catégorie à laquelle un libellé peut appartenir. Exemple :

- Dans un modèle de classification binaire qui détecte le spam, les deux classes peuvent être spam et non-spam.

- Dans un modèle de classification à classes multiples qui identifie les races de chiens, les classes peuvent être caniche, beagle, carlin, etc.

Un modèle de classification prédit une classe. En revanche, un modèle de régression prédit un nombre plutôt qu'une classe.

Pour en savoir plus, consultez la section Classification du cours d'initiation au machine learning.

ensemble de données équilibré

Un ensemble de données contenant des libellés catégoriels dans lesquels le nombre d'instances de chaque catégorie est approximativement égal. Par exemple, prenons un ensemble de données botaniques dont le libellé binaire peut être plante indigène ou plante non indigène :

- Un ensemble de données contenant 515 plantes indigènes et 485 plantes non indigènes est un ensemble de données équilibré.

- Un ensemble de données comportant 875 plantes indigènes et 125 plantes non indigènes est un ensemble de données avec déséquilibre des classes.

Il n'existe pas de limite formelle entre les ensembles de données équilibrés et les ensembles de données avec déséquilibre des classes. La distinction n'est importante que lorsqu'un modèle entraîné sur un ensemble de données très déséquilibré en termes de classes ne peut pas converger. Pour en savoir plus, consultez Ensembles de données : ensembles de données déséquilibrés dans le cours d'initiation au machine learning.

modèle de classification

Un modèle dont la prédiction est une classe. Par exemple, les modèles suivants sont tous des modèles de classification :

- Modèle qui prédit la langue d'une phrase saisie (français ? Espagnol ? Italien ?).

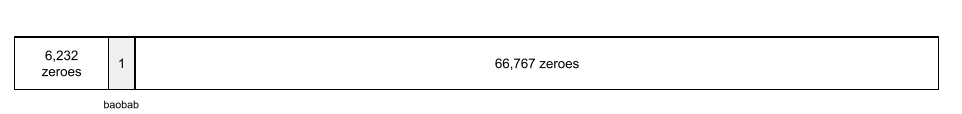

- Un modèle qui prédit les espèces d'arbres (érable ? Chêne ? Baobab ?).

- Modèle qui prédit la classe positive ou négative pour une affection médicale donnée.

En revanche, les modèles de régression prédisent des nombres plutôt que des classes.

Voici deux types courants de modèles de classification :

seuil de classification

Dans une classification binaire, il s'agit d'un nombre compris entre 0 et 1 qui convertit la sortie brute d'un modèle de régression logistique en prédiction de la classe positive ou de la classe négative. Notez que le seuil de classification est une valeur choisie par un humain, et non par l'entraînement du modèle.

Un modèle de régression logistique génère une valeur brute comprise entre 0 et 1. Ensuite :

- Si cette valeur brute est supérieure au seuil de classification, la classe positive est prédite.

- Si cette valeur brute est inférieure au seuil de classification, la classe négative est prédite.

Par exemple, supposons que le seuil de classification soit de 0,8. Si la valeur brute est de 0,9, le modèle prédit la classe positive. Si la valeur brute est de 0,7, le modèle prédit la classe négative.

Le choix du seuil de classification a une forte incidence sur le nombre de faux positifs et de faux négatifs.

Pour en savoir plus, consultez Seuils et matrice de confusion dans le Cours d'initiation au machine learning.

classificateur

Terme informel désignant un modèle de classification.

ensemble de données avec déséquilibre des classes

Un ensemble de données pour une classification dans lequel le nombre total d'étiquettes de chaque classe diffère de manière significative. Prenons l'exemple d'un ensemble de données de classification binaire dont les deux libellés sont répartis comme suit :

- 1 000 000 de libellés à exclure

- 10 libellés positifs

Le ratio d'étiquettes négatives par rapport aux étiquettes positives est de 100 000 pour 1. Il s'agit donc d'un ensemble de données avec déséquilibre des classes.

En revanche, l'ensemble de données suivant est équilibré par classe, car le ratio de libellés négatifs par rapport aux libellés positifs est relativement proche de 1 :

- 517 libellés négatifs

- 483 libellés positifs

Les ensembles de données multiclasses peuvent également présenter un déséquilibre des classes. Par exemple, l'ensemble de données de classification multiclasse suivant est également déséquilibré, car un libellé comporte beaucoup plus d'exemples que les deux autres :

- 1 000 000 d'étiquettes avec la classe "vert"

- 200 étiquettes avec la classe "violet"

- 350 libellés avec la classe "orange"

L'entraînement d'ensembles de données avec déséquilibre des classes peut présenter des difficultés particulières. Pour en savoir plus, consultez Ensembles de données déséquilibrés dans le Cours d'initiation au Machine Learning.

Voir aussi entropie, classe majoritaire et classe minoritaire.

écrêtage

Technique de gestion des valeurs aberrantes en effectuant l'une des opérations suivantes ou les deux :

- Réduire les valeurs de caractéristiques qui sont supérieures à un seuil maximal à ce seuil maximal.

- Augmenter les valeurs de caractéristiques qui sont en-dessous d'un certain seuil minimal à ce seuil minimal.

Supposons, par exemple, que moins de 0,5 % des valeurs d'une caractéristique donnée ne sont pas comprises entre 40 et 60. Dans ce cas, vous pouvez procéder comme suit :

- Borner toutes les valeurs supérieures à 60 (le seuil maximal) pour obtenir exactement 60.

- Borner toutes les valeurs inférieures à 40 (le seuil minimal) pour obtenir exactement 40.

Les valeurs aberrantes peuvent endommager les modèles et parfois entraîner un dépassement de capacité des pondérations pendant l'entraînement. Certaines valeurs aberrantes peuvent également nuire considérablement à des métriques telles que la précision. L'écrêtage est une technique courante pour limiter les dégâts.

Le bornement du gradient force les valeurs de gradient dans une plage désignée pendant l'entraînement.

Pour en savoir plus, consultez Données numériques : normalisation dans le Cours d'initiation au machine learning.

Cloud TPU

Accélérateur matériel spécialisé conçu pour accélérer les charges de travail de machine learning sur Google Cloud.

clustering

Regrouper des exemples associés, en particulier lors de l'apprentissage non supervisé. Une fois tous les exemples groupés, une personne peut éventuellement attribuer un sens à chaque cluster.

Il existe de nombreux algorithmes de clustering. Par exemple, l'algorithme k-moyennes regroupe les exemples en clusters en fonction de leur proximité avec un centroïde, comme dans le diagramme suivant :

Un chercheur pourrait alors examiner les clusters et, par exemple, étiqueter le cluster 1 en tant qu'"arbres nains" et le cluster 2 en tant qu'"arbres de taille normale".

Autre exemple, celui d'un algorithme de clustering basé sur la distance entre un exemple et un point central, illustré comme suit :

Pour en savoir plus, consultez le cours sur le clustering.

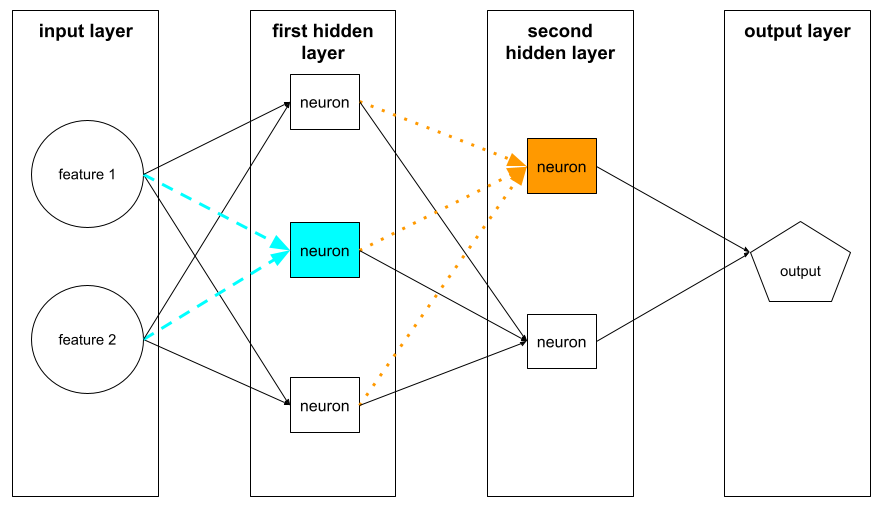

coadaptation

Comportement indésirable dans lequel les neurones prédisent des schémas dans les données d'entraînement en s'appuyant presque exclusivement sur les sorties d'autres neurones spécifiques, au lieu de s'appuyer sur le comportement du réseau dans son ensemble. Lorsque les schémas à l'origine de la coadaptation ne sont pas présents dans les données de validation, la coadaptation entraîne alors un surapprentissage. La régularisation par abandon réduit l'occurrence de la coadaptation, car l'abandon empêche les neurones de ne s'appuyer que sur d'autres neurones spécifiques.

filtrage collaboratif

Prédictions sur les centres d'intérêt d'un utilisateur en fonction de ceux de nombreux autres utilisateurs. Le filtrage collaboratif est souvent utilisé dans les systèmes de recommandation.

Pour en savoir plus, consultez la section Filtrage collaboratif du cours sur les systèmes de recommandation.

CommitmentBank (CB)

Ensemble de données permettant d'évaluer la capacité d'un LLM à déterminer si l'auteur d'un passage croit en une clause cible dans ce passage. Chaque entrée de l'ensemble de données contient les éléments suivants :

- Un extrait

- Une clause cible dans ce passage

- Valeur booléenne indiquant si l'auteur du passage croit en la clause cible.

Exemple :

- Extrait : Quel plaisir d'entendre Artemis rire. Elle est tellement sérieuse. Je ne savais pas qu'elle avait le sens de l'humour.

- Clause cible : elle avait le sens de l'humour

- Booléen : "True", ce qui signifie que l'auteur croit en la clause cible

CommitmentBank est un composant de l'ensemble SuperGLUE.

modèle compact

Tout petit modèle conçu pour s'exécuter sur de petits appareils disposant de ressources de calcul limitées. Par exemple, les modèles compacts peuvent s'exécuter sur des téléphones mobiles, des tablettes ou des systèmes embarqués.

calcul

(Nom) Ressources de calcul utilisées par un modèle ou un système, telles que la puissance de traitement, la mémoire et le stockage.

Consultez Puces d'accélération.

dérive conceptuelle

Un changement dans la relation entre les caractéristiques et l'étiquette. Au fil du temps, la dérive du concept réduit la qualité d'un modèle.

Lors de l'entraînement, le modèle apprend la relation entre les caractéristiques et leurs étiquettes dans l'ensemble d'entraînement. Si les libellés de l'ensemble d'entraînement sont de bons substituts pour le monde réel, le modèle devrait faire de bonnes prédictions dans le monde réel. Toutefois, en raison de la dérive conceptuelle, les prédictions du modèle ont tendance à se dégrader au fil du temps.

Par exemple, prenons un modèle de classification binaire qui prédit si un certain modèle de voiture est "économe en carburant". Les caractéristiques peuvent être les suivantes :

- poids du véhicule

- compression du moteur

- transmission type

lorsque le libellé est :

- économe en carburant

- ne pas être économe en carburant

Toutefois, le concept de "voiture économe en carburant" ne cesse d'évoluer. Un modèle de voiture qualifié d'économe en carburant en 1994 serait presque certainement qualifié de non économe en carburant en 2024. Un modèle souffrant de dérive du concept a tendance à faire des prédictions de moins en moins utiles au fil du temps.

Comparer et différencier avec la non-stationnarité.

état

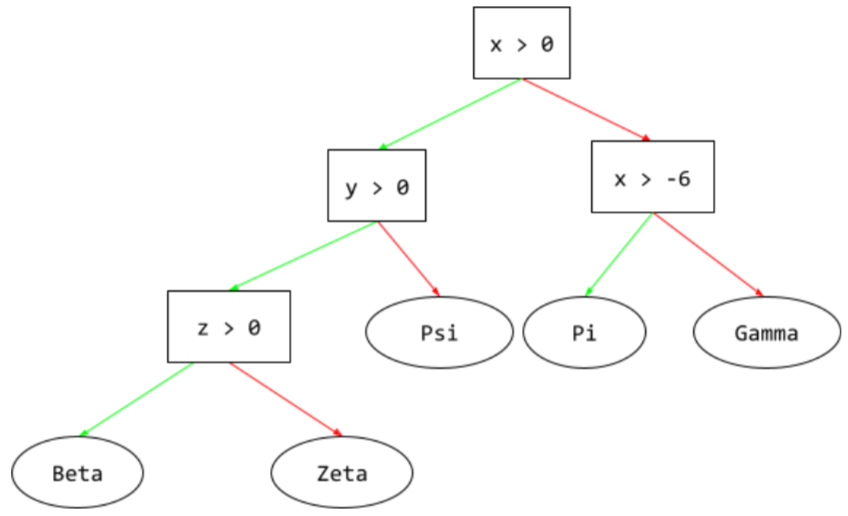

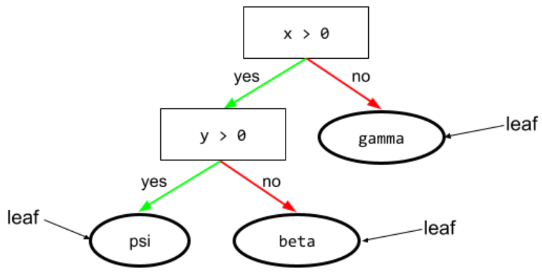

Dans un arbre de décision, tout nœud effectue un test. Par exemple, l'arbre de décision suivant contient deux conditions :

Une condition est également appelée "fractionnement" ou "test".

Condition de contraste avec leaf.

Voir également :

Pour en savoir plus, consultez Types de conditions dans le cours "Forêts de décision".

confabulation

Synonyme de hallucination.

La confabulation est probablement un terme plus précis techniquement que l'hallucination. Cependant, l'hallucination est devenue populaire en premier.

configuration

Processus d'attribution des valeurs de propriété initiales utilisées pour entraîner un modèle, y compris :

- les couches de composition du modèle.

- l'emplacement des données ;

- Hyperparamètres, tels que :

Dans les projets de machine learning, la configuration peut être effectuée à l'aide d'un fichier de configuration spécial ou de bibliothèques de configuration telles que les suivantes :

biais de confirmation

Tendance à rechercher, interpréter, favoriser et rappeler des informations d'une manière qui confirme ses propres croyances ou hypothèses préexistantes. Les développeurs en machine learning peuvent collecter ou étiqueter par inadvertance des données d'une telle manière que cela influence la production d'un résultat confortant leurs croyances existantes. Le biais de confirmation est une forme de biais implicite.

L'effet expérimentateur est une forme de biais de confirmation dans lequel un expérimentateur continue d'entraîner des modèles jusqu'à confirmation d'une hypothèse préexistante.

matrice de confusion

Table NxN qui résume le nombre de prédictions correctes et incorrectes effectuées par un modèle de classification. Prenons l'exemple de la matrice de confusion suivante pour un modèle de classification binaire :

| Tumeur (prédite) | Non tumoral (prédit) | |

|---|---|---|

| Tumeur (vérité terrain) | 18 (VP) | 1 (FN) |

| Non-Tumor (vérité terrain) | 6 (FP) | 452 (VN) |

La matrice de confusion précédente montre les éléments suivants :

- Sur les 19 prédictions où la vérité terrain était "Tumeur", le modèle en a classé 18 correctement et 1 incorrectement.

- Sur les 458 prédictions pour lesquelles la vérité terrain était "Non-Tumor", le modèle en a classé 452 correctement et 6 incorrectement.

La matrice de confusion pour un problème de classification multiclasse peut vous aider à identifier les schémas d'erreurs. Prenons l'exemple de la matrice de confusion suivante pour un modèle de classification multiclasse à trois classes qui catégorise trois types d'iris différents (Virginica, Versicolor et Setosa). Lorsque la vérité terrain était "Virginica", la matrice de confusion montre que le modèle était beaucoup plus susceptible de prédire à tort "Versicolor" que "Setosa" :

| Setosa (prédit) | Versicolor (prédit) | Virginica (prédit) | |

|---|---|---|---|

| Setosa (vérité terrain) | 88 | 12 | 0 |

| Versicolor (vérité terrain) | 6 | 141 | 7 |

| Virginica (vérité terrain) | 2 | 27 | 109 |

Par exemple, une matrice de confusion peut révéler qu'un modèle entraîné à reconnaître les chiffres écrits à la main tend à prédire de façon erronée 9 à la place de 4, ou 1 au lieu de 7.

Les matrices de confusion contiennent suffisamment d'informations pour calculer diverses métriques de performances, y compris la précision et le rappel.

analyse syntaxique par constituants

Diviser une phrase en structures grammaticales plus petites ("constituants"). Une partie ultérieure du système de ML, telle qu'un modèle de compréhension du langage naturel, peut analyser les constituants plus facilement que la phrase d'origine. Par exemple, prenons la phrase suivante :

Mon ami a adopté deux chats.

Un analyseur syntaxique peut diviser cette phrase en deux constituants :

- Mon ami est un groupe nominal.

- a adopté deux chats est un groupe verbal.

Ces composants peuvent être subdivisés en composants plus petits. Par exemple, le groupe verbal

a adopté deux chats

peut être subdivisée en :

- Adopté est un verbe.

- deux chats est un autre syntagme nominal.

embedding de langage contextualisé

Une intégration qui s'approche de la "compréhension" des mots et des expressions comme le font les locuteurs humains natifs. Les embeddings de langage contextualisés peuvent comprendre la syntaxe, la sémantique et le contexte complexes.

Prenons l'exemple des embeddings du mot anglais cow (vache). Les anciens embeddings, tels que word2vec, peuvent représenter des mots anglais de sorte que la distance dans l'espace d'embedding entre cow (vache) et bull (taureau) soit semblable à la distance entre ewe (brebis) et ram (bélier), ou entre female (femelle) et male (mâle). Les embeddings de langage contextualisés peuvent aller plus loin en reconnaissant que les anglophones utilisent parfois le mot cow (vache) pour désigner une vache ou un taureau.

fenêtre de contexte

Nombre de jetons qu'un modèle peut traiter dans une requête donnée. Plus la fenêtre de contexte est grande, plus le modèle peut utiliser d'informations pour fournir des réponses cohérentes à la requête.

caractéristique continue

Caractéristique à virgule flottante avec une plage infinie de valeurs possibles, comme la température ou le poids.

À comparer à la caractéristique discrète.

échantillonnage de commodité

Utiliser un ensemble de données collecté de manière non scientifique pour réaliser des tests rapides. Par la suite, il est essentiel de passer à un ensemble de données collecté de manière scientifique.

convergence

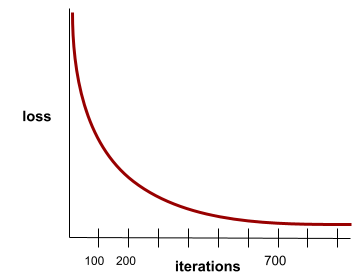

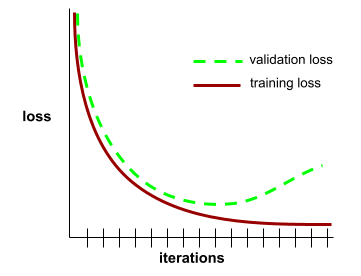

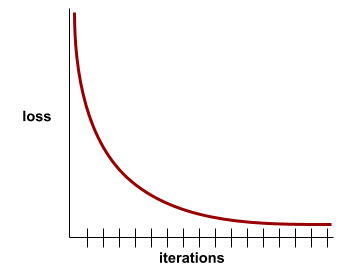

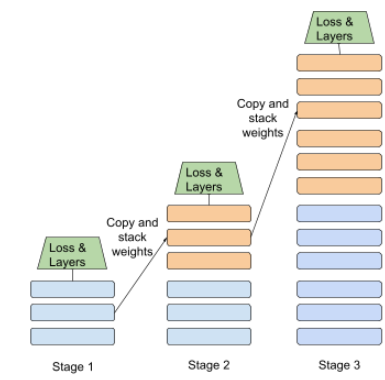

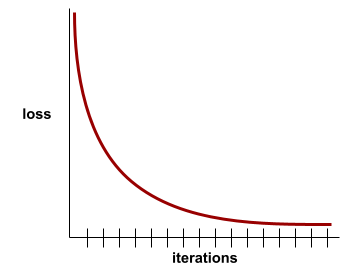

État atteint lorsque les valeurs de perte varient très peu ou pas du tout à chaque itération. Par exemple, la courbe de perte suivante suggère une convergence à environ 700 itérations :

Un modèle converge lorsque la poursuite de l'entraînement ne l'améliore pas.

Dans le deep learning, les valeurs de perte restent parfois constantes ou presque pendant de nombreuses itérations avant de finalement diminuer. Pendant une longue période de valeurs de perte constantes, vous pouvez temporairement avoir une fausse impression de convergence.

Voir aussi arrêt prématuré.

Pour en savoir plus, consultez Convergence du modèle et courbes de perte dans le Cours d'initiation au Machine Learning.

codage conversationnel

Dialogue itératif entre vous et un modèle d'IA générative dans le but de créer un logiciel. Vous émettez une requête décrivant un logiciel. Le modèle utilise ensuite cette description pour générer du code. Ensuite, vous émettez une nouvelle requête pour corriger les défauts de la requête précédente ou du code généré, et le modèle génère un code mis à jour. Vous deux continuez à échanger jusqu'à ce que le logiciel généré soit suffisamment bon.

Le codage des conversations est essentiellement la signification d'origine du vibe coding.

À comparer au codage spécificationnel.

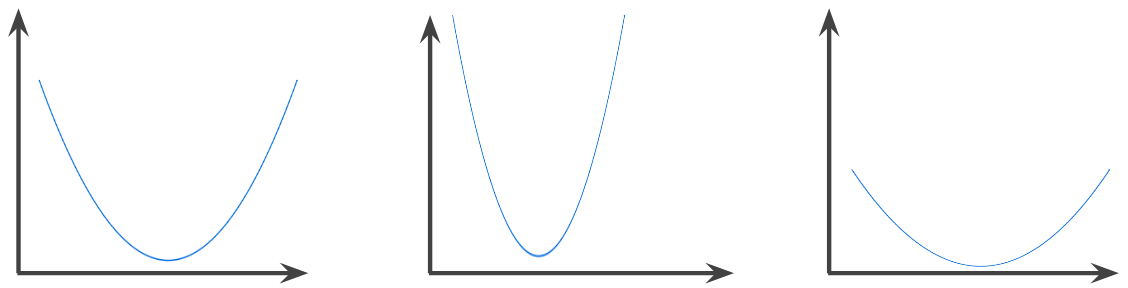

fonction convexe

Fonction dans laquelle la région au-dessus du graphique est un ensemble convexe. La fonction convexe prototypique ressemble à la lettre U. Par exemple, les fonctions suivantes sont toutes des fonctions convexes :

En revanche, la fonction suivante n'est pas convexe. Notez comment la région au-dessus du graphique diffère d'un ensemble convexe :

Une fonction strictement convexe ne possède qu'un seul point de minimum local, qui est également le point de minimum global. Les fonctions classiques en forme de U sont des fonctions strictement convexes. Ce n'est pas le cas de certaines fonctions convexes, comme les droites.

Pour en savoir plus, consultez Convergence et fonctions convexes dans le Cours d'initiation au Machine Learning.

optimisation convexe

Processus d'utilisation de techniques mathématiques telles que la descente de gradient pour trouver le minimum d'une fonction convexe. Dans le domaine du machine learning, de nombreuses études ont cherché à exprimer divers problèmes sous la forme de problèmes d'optimisation convexe pour les résoudre plus efficacement.

Pour en savoir plus, consultez Convex Optimization de Boyd et Vandenberghe.

ensemble convexe

Sous-ensemble de l'espace euclidien tel qu'une ligne tracée entre deux points quelconques du sous-ensemble reste entièrement dans le sous-ensemble. Par exemple, les deux formes suivantes sont des ensembles convexes :

À titre de comparaison, les deux formes suivantes ne sont pas des ensembles convexes :

convolution

En mathématiques, il s'agit d'un mélange de deux fonctions. Dans le machine learning, une convolution mélange le filtre convolutif et la matrice d'entrée pour entraîner les pondérations.

Dans le machine learning, le terme "convolution" est souvent une abréviation pour désigner une opération de convolution ou une couche de convolution.

Sans convolution, un algorithme de machine learning devrait apprendre une pondération différente pour chaque cellule d'un grand Tensor. Par exemple, un algorithme de machine learning dont l'entraînement s'effectue sur des images de 2K x 2K serait forcé de trouver 4 millions de pondérations. Grâce aux convolutions, un algorithme de machine learning ne doit trouver des pondérations que pour chaque cellule du filtre convolutif, ce qui réduit considérablement la mémoire nécessaire à l'entraînement du modèle. Lorsque le filtre de convolution est appliqué, il est simplement répliqué dans les cellules de sorte que chacune soit multipliée par le filtre.

filtre de convolution

L'un des deux acteurs d'une opération convolutive. (L'autre acteur est une tranche d'une matrice d'entrée.) Un filtre convolutif est une matrice de même rang que la matrice d'entrée, mais de forme plus petite. Par exemple, pour une matrice d'entrée 28x28, le filtre peut être n'importe quelle matrice 2D plus petite que 28x28.

Dans la manipulation photographique, toutes les cellules d'un filtre de convolution sont généralement définies sur un modèle constant de uns et de zéros. Dans le machine learning, les filtres de convolution sont généralement initialisés avec des nombres aléatoires, puis le réseau entraîne les valeurs idéales.

couche convolutive

Couche d'un réseau de neurones profond dans laquelle un filtre convolutif transfère une matrice d'entrée. Soit, par exemple, le filtre convolutif 3 x 3 suivant :

![Matrice 3x3 avec les valeurs suivantes : [[0,1,0], [1,0,1], [0,1,0]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalFilter33.svg?authuser=6&hl=fr)

L'animation suivante montre une couche convolutive composée de neuf opérations convolutives impliquant la matrice d'entrée 5x5. Notez que chaque opération de convolution fonctionne sur une tranche 3x3 différente de la matrice d'entrée. La matrice 3 x 3 résultante (à droite) est constituée des résultats des 9 opérations convolutives :

![Animation montrant deux matrices. La première matrice est la matrice 5x5 : [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].

La deuxième matrice est la matrice 3x3 :

[[181,303,618], [115,338,605], [169,351,560]].

La deuxième matrice est calculée en appliquant le filtre de convolution [[0, 1, 0], [1, 0, 1], [0, 1, 0]] à différents sous-ensembles 3x3 de la matrice 5x5.](https://developers.google.cn/static/machine-learning/glossary/images/AnimatedConvolution.gif?authuser=6&hl=fr)

réseau de neurones convolutif

Un réseau de neurones dans lequel au moins une couche est une couche convolutive. Un réseau de neurones convolutif typique consiste en une combinaison des couches suivantes :

Les réseaux de neurones convolutifs ont eu beaucoup de succès pour certains types de problèmes, notamment la reconnaissance d'images.

opération de convolution

L'opération mathématique en deux étapes suivante :

- Multiplication élément par élément du filtre convolutif et d'une tranche d'une matrice d'entrée. (La tranche de la matrice d'entrée est de même rang et de même taille que le filtre convolutif.)

- Somme de toutes les valeurs de la matrice de produits résultante.

Soit, par exemple, la matrice d'entrée 5 x 5 suivante :

![Matrice 5x5 : [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerInputMatrix.svg?authuser=6&hl=fr)

Soit, à présent, le filtre convolutif 2 x 2 suivant :

![Matrice 2x2 : [[1, 0], [0, 1]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerFilter.svg?authuser=6&hl=fr)

Chaque opération de convolution implique une seule tranche 2x2 de la matrice d'entrée. Par exemple, supposons que nous utilisions la tranche 2x2 en haut à gauche de la matrice d'entrée. L'opération de convolution sur cette tranche se présente comme suit :

![Application du filtre de convolution [[1, 0], [0, 1]] à la section 2x2 en haut à gauche de la matrice d'entrée, qui est [[128,97], [35,22]].

Le filtre convolutif laisse les valeurs 128 et 22 intactes, mais met à zéro les valeurs 97 et 35. Par conséquent, l'opération de convolution donne la valeur 150 (128+22).](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerOperation.svg?authuser=6&hl=fr)

Une couche convolutive consiste en une série d'opérations convolutives, chacune agissant sur une tranche différente de la matrice d'entrée.

COPA

Abréviation de Choice of Plausible Alternatives (Choix d'alternatives plausibles).

coût

Synonyme de perte.

co-apprentissage

Une approche d'apprentissage semi-supervisé est particulièrement utile lorsque toutes les conditions suivantes sont remplies :

- Le rapport entre les exemples sans étiquette et les exemples avec étiquette dans l'ensemble de données est élevé.

- Il s'agit d'un problème de classification (binaire ou à classes multiples).

- L'ensemble de données contient deux ensembles différents de caractéristiques prédictives indépendantes les unes des autres et complémentaires.

Le co-apprentissage amplifie essentiellement les signaux indépendants pour en faire un signal plus fort. Par exemple, prenons un modèle de classification qui classe les voitures d'occasion individuelles dans les catégories Bon état ou Mauvais état. Un ensemble de caractéristiques prédictives peut se concentrer sur les caractéristiques globales telles que l'année, la marque et le modèle de la voiture. Un autre ensemble de caractéristiques prédictives peut se concentrer sur l'historique de conduite du propriétaire précédent et l'historique d'entretien de la voiture.

L'article de référence sur le co-apprentissage est Combining Labeled and Unlabeled Data with Co-Training de Blum et Mitchell.

équité contrefactuelle

Une métrique d'équité qui vérifie si un modèle de classification produit le même résultat pour une personne que pour une autre qui est identique à la première, sauf en ce qui concerne un ou plusieurs attributs sensibles. L'évaluation d'un modèle de classification pour l'équité contrefactuelle est une méthode permettant d'identifier les sources potentielles de biais dans un modèle.

Pour en savoir plus, consultez les ressources suivantes :

- Équité : équité contrefactuelle dans le cours d'initiation au machine learning

- Quand les mondes se rencontrent : intégrer différentes hypothèses contrefactuelles dans l'équité

biais de couverture

Voir biais de sélection.

phrase équivoque

Phrase ou expression au sens ambigu. Les phrases équivoques posent un problème majeur pour la compréhension du langage naturel. Par exemple, le titre Red Tape Holds Up Skyscraper (L'obstacle administratif retarde la construction du gratte-ciel) est une phrase équivoque, car un modèle NLU peut l'interpréter littéralement ou figurativement.

critique

Synonyme de réseau profond Q.

entropie croisée

Généralisation de la perte logistique aux problèmes de classification à classes multiples. L'entropie croisée quantifie la différence entre deux distributions de probabilité. Voir aussi perplexité.

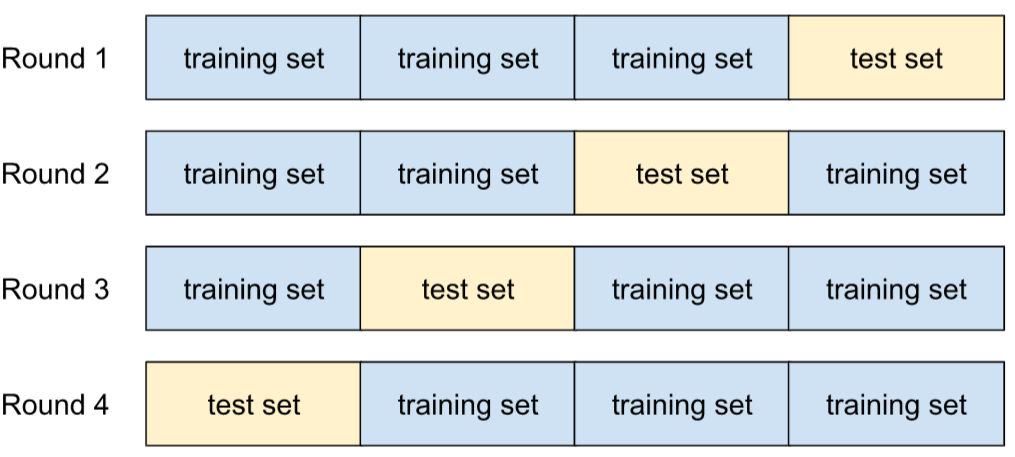

validation croisée

Mécanisme permettant d'estimer la capacité d'un modèle à être généralisé à de nouvelles données en le testant par rapport à un ou plusieurs sous-ensembles de données qui ne se chevauchent pas et sont retenus de l'ensemble d'entraînement.

fonction de distribution cumulative (CDF)

Fonction qui définit la fréquence des échantillons inférieurs ou égaux à une valeur cible. Par exemple, considérons une distribution normale de valeurs continues. Une CDF vous indique qu'environ 50 % des échantillons doivent être inférieurs ou égaux à la moyenne et qu'environ 84 % des échantillons doivent être inférieurs ou égaux à un écart-type au-dessus de la moyenne.

D

analyse des données

Procédure visant à comprendre des données en en étudiant les échantillons, les mesures et les visualisations. L'analyse de données peut s'avérer particulièrement utile à la réception d'un ensemble de données, avant la création du premier modèle. Elle est également cruciale pour interpréter les expériences et déboguer les problèmes affectant le système.

augmentation des données

Augmenter artificiellement l'éventail et le nombre d'exemples d'entraînement en transformant les exemples existants afin d'en créer de nouveaux. Supposons que votre ensemble de données contienne des exemples d'images, mais pas suffisamment pour que le modèle apprenne des associations utiles. Dans l'idéal, vous allez ajouter suffisamment d'images avec libellé à votre ensemble de données pour que votre modèle puisse s'entraîner correctement. Si ce n'est pas possible, l'augmentation des données peut faire pivoter, étirer et faire un reflet de chaque image afin de créer de nombreuses variantes de l'image originale, ce qui produira éventuellement suffisamment de données avec libellé pour un entraînement d'excellente qualité.

DataFrame

Type de données pandas populaire pour représenter les ensembles de données en mémoire.

Un DataFrame est analogue à un tableau ou à une feuille de calcul. Chaque colonne d'un DataFrame porte un nom (un en-tête) et chaque ligne est identifiée par un numéro unique.

Chaque colonne d'un DataFrame est structurée comme un tableau à deux dimensions, à la différence que chaque colonne peut se voir attribuer son propre type de données.

Consultez également la page de référence pandas.DataFrame officielle.

parallélisme des données

Méthode de mise à l'échelle de l'entraînement ou de l'inférence qui réplique un modèle entier sur plusieurs appareils, puis transmet un sous-ensemble des données d'entrée à chaque appareil. Le parallélisme des données peut permettre l'entraînement et l'inférence sur des tailles de lot très importantes. Toutefois, il nécessite que le modèle soit suffisamment petit pour tenir sur tous les appareils.

Le parallélisme des données accélère généralement l'entraînement et l'inférence.

Voir aussi parallélisme des modèles.

API Dataset (tf.data)

API TensorFlow de haut niveau pour la lecture des données et leur transformation en une forme requise par un algorithme de machine learning.

Un objet tf.data.Dataset représente une séquence d'éléments dans laquelle chaque élément contient un ou plusieurs Tensors. Un objet tf.data.Iterator permet d'accéder aux éléments d'un Dataset.

ensemble de données (data set ou dataset)

Ensemble de données brutes, généralement (mais pas exclusivement) organisé dans l'un des formats suivants :

- une feuille de calcul

- un fichier au format CSV (valeurs séparées par une virgule)

frontière de décision

Séparateur entre les classes apprises par un modèle dans les problèmes de classification binaire ou à classes multiples. Par exemple, dans l'image suivante représentant un problème de classification binaire, la frontière de décision est la limite entre la classe orange et la classe bleue :

forêt de décision

Modèle créé à partir de plusieurs arbres de décision. Une forêt de décision effectue une prédiction en agrégeant les prédictions de ses arbres de décision. Les types de forêts de décision les plus courants sont les forêts aléatoires et les arbres à boosting de gradient.

Pour en savoir plus, consultez la section Forêts de décision du cours sur les forêts de décision.

seuil de décision

Synonyme de seuil de classification.

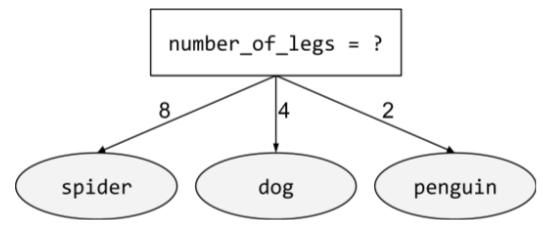

arbre de décision

Modèle d'apprentissage supervisé composé d'un ensemble de conditions et de feuilles organisées de manière hiérarchique. Par exemple, voici un arbre de décision :

décodeur

En général, tout système de ML qui convertit une représentation traitée, dense ou interne en une représentation plus brute, parcimonieuse ou externe.

Les décodeurs sont souvent un composant d'un modèle plus grand, où ils sont fréquemment associés à un encodeur.

Dans les tâches de séquence à séquence, un décodeur commence par l'état interne généré par l'encodeur pour prédire la séquence suivante.

Pour connaître la définition d'un décodeur dans l'architecture Transformer, consultez Transformer.

Pour en savoir plus, consultez Grands modèles de langage dans le cours d'initiation au machine learning.

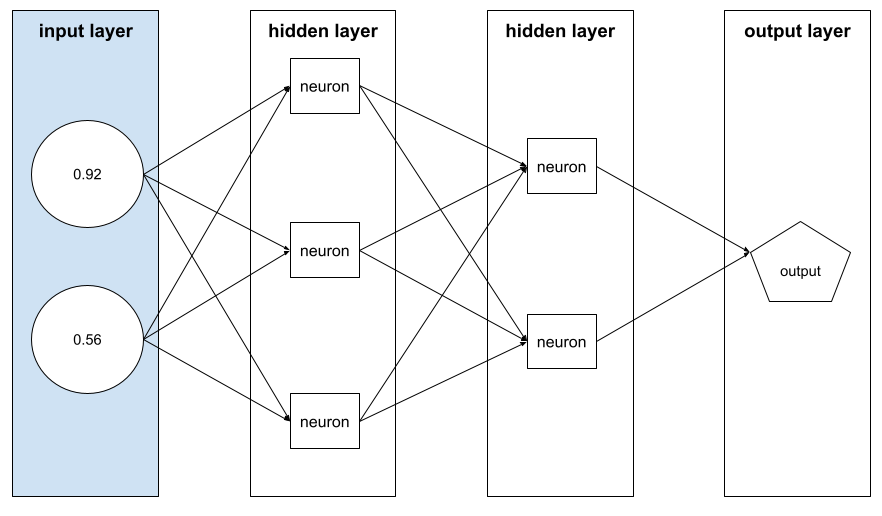

modèle deep learning

Un réseau de neurones contenant plusieurs couches cachées.

Un modèle profond est également appelé réseau de neurones profond.

À comparer au modèle large.

de réseau de neurones profond

Synonyme de modèle profond.

Deep Q-Network (DQN)

Dans l'apprentissage par renforcement Q, un réseau de neurones profond prédit les fonctions Q.

Critic est un synonyme de Deep Q-Network.

parité démographique

Une métrique d'équité est satisfaite si les résultats de la classification d'un modèle ne dépendent pas d'un attribut sensible donné.

Par exemple, si les Lilliputiens et les Brobdingnags postulent à l'université de Glubbdubdrib, la parité démographique est atteinte si le pourcentage de Lilliputiens admis est le même que celui des Brobdingnags, que l'un des groupes soit en moyenne plus qualifié que l'autre ou non.

À l'inverse de l'égalité des chances et de l'égalité des opportunités, qui autorisent les résultats de classification agrégés à dépendre des attributs sensibles, mais pas les résultats de classification pour certains libellés de vérité terrain spécifiés. Consultez l'article "Attacking discrimination with smarter machine learning" (Lutter contre les discriminations grâce à un machine learning plus intelligent) pour découvrir une visualisation explorant les compromis lors de l'optimisation pour la parité démographique.

Pour en savoir plus, consultez Équité : parité démographique dans le Cours d'initiation au machine learning.

suppression du bruit

Une approche courante de l'apprentissage autosupervisé dans laquelle :

- Du bruit est ajouté artificiellement à l'ensemble de données.

- Le modèle tente de supprimer le bruit.

La suppression du bruit permet d'apprendre à partir d'exemples sans étiquette. L'ensemble de données d'origine sert de cible ou d'étiquette, et les données bruitées servent d'entrée.

Certains modèles de langage masqués utilisent la suppression du bruit comme suit :

- Du bruit est ajouté artificiellement à une phrase non libellée en masquant certains jetons.

- Le modèle tente de prédire les jetons d'origine.

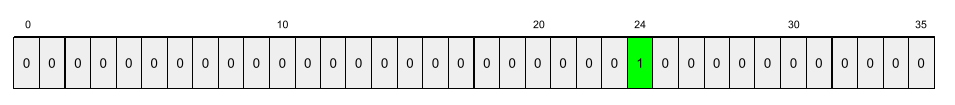

caractéristique dense

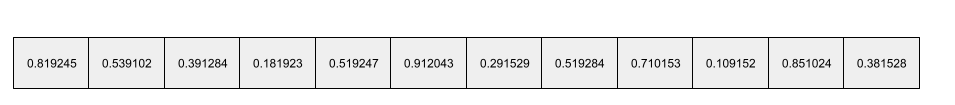

Une caractéristique dans laquelle la plupart ou la totalité des valeurs sont non nulles, généralement un Tensor de valeurs à virgule flottante. Par exemple, le Tensor à 10 éléments ci-dessous est dense, car 9 de ses valeurs sont non nulles :

| 8 | 3 | 7 | 5 | 2 | 4 | 0 | 4 | 9 | 6 |

À comparer à la caractéristique creuse.

couche dense

Synonyme de couche entièrement connectée.

profondeur

La somme des éléments suivants dans un réseau de neurones :

- le nombre de couches cachées

- le nombre de couches de sortie, qui est généralement de 1.

- le nombre de couches d'embedding

Par exemple, un réseau de neurones avec cinq couches cachées et une couche de sortie a une profondeur de 6.

Notez que la couche d'entrée n'a pas d'incidence sur la profondeur.

Réseau de neurones convolutifs séparables en profondeur (sepCNN)

Architecture de réseau de neurones convolutifs basée sur Inception, mais où les modules Inception sont remplacés par des convolutions séparables en profondeur. Également appelé Xception.

Une convolution séparable en profondeur (également appelée convolution séparable) factorise une convolution 3D standard en deux opérations de convolution distinctes qui sont plus efficaces en termes de calcul : d'abord, une convolution en profondeur, avec une profondeur de 1 (n ✕ n ✕ 1), puis une convolution ponctuelle, avec une longueur et une largeur de 1 (1 ✕ 1 ✕ n).

Pour en savoir plus, consultez Xception: Deep Learning with Depthwise Separable Convolutions.

libellé dérivé

Synonyme d'étiquette de substitution.

appareil

Terme complexe ayant deux définitions possibles :

- Catégorie de matériel pouvant exécuter une session TensorFlow, y compris les CPU, les GPU et les TPU.

- Lors de l'entraînement d'un modèle de ML sur des puces d'accélérateur (GPU ou TPU), il s'agit de la partie du système qui manipule réellement les tenseurs et les embeddings. L'appareil fonctionne avec des puces d'accélération. En revanche, l'hôte s'exécute généralement sur un processeur.

confidentialité différentielle

Dans le machine learning, approche d'anonymisation visant à protéger les données sensibles (par exemple, les informations personnelles d'un individu) incluses dans l'ensemble d'entraînement d'un modèle contre toute exposition. Cette approche garantit que le modèle n'apprend ni ne mémorise beaucoup d'informations sur une personne spécifique. Pour ce faire, nous échantillonnons et ajoutons du bruit lors de l'entraînement du modèle afin d'obscurcir les points de données individuels, ce qui réduit le risque d'exposer des données d'entraînement sensibles.

La confidentialité différentielle est également utilisée en dehors du machine learning. Par exemple, les data scientists utilisent parfois la confidentialité différentielle pour protéger la confidentialité individuelle lorsqu'ils calculent des statistiques d'utilisation des produits pour différentes données démographiques.

réduction de la dimensionnalité

Diminution du nombre de dimensions utilisées pour représenter une caractéristique particulière dans un vecteur de caractéristiques, généralement par conversion en un vecteur d'embedding.

Dimensions

Terme complexe qui a une des définitions suivantes :