Tujuan

Tutorial Validasi Alamat Volume Tinggi memandu Anda melalui berbagai skenario penggunaan validasi alamat volume tinggi. Dalam tutorial ini, kami akan memperkenalkan berbagai pola desain dalam Google Cloud Platform untuk menjalankan Validasi Alamat Volume Tinggi.

Kita akan mulai dengan ringkasan tentang menjalankan Validasi Alamat Volume Tinggi di Google Cloud Platform dengan Cloud Run, Compute Engine, atau Google Kubernetes Engine untuk eksekusi satu kali. Kemudian, kita akan melihat bagaimana kemampuan ini dapat disertakan sebagai bagian dari pipeline data.

Di akhir artikel ini, Anda akan memahami dengan baik berbagai opsi untuk menjalankan Validasi Alamat dalam volume tinggi di lingkungan Google Cloud Anda.

Arsitektur referensi di Google Cloud Platform

Bagian ini membahas lebih dalam berbagai pola desain untuk Validasi Alamat Volume Tinggi menggunakan Google Cloud Platform. Dengan berjalan di Google Cloud Platform, Anda dapat berintegrasi dengan proses dan pipeline data yang sudah ada.

Menjalankan Validasi Alamat Volume Tinggi satu kali di Google Cloud Platform

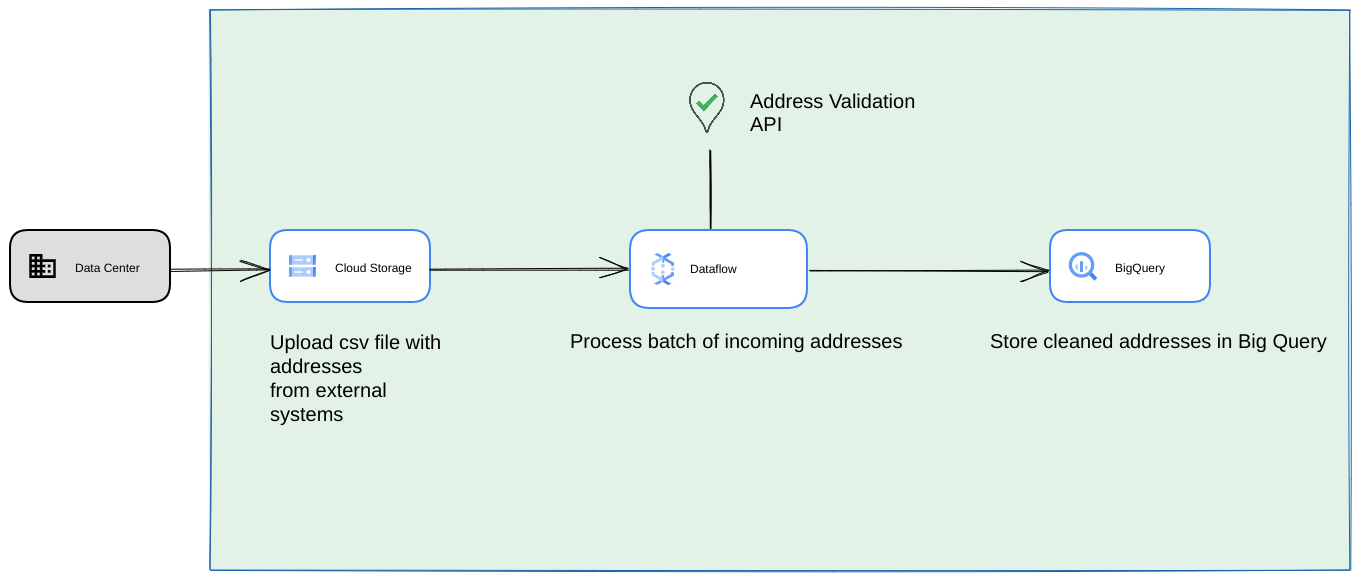

Di bawah ini adalah arsitektur referensi tentang cara membangun integrasi di Google Cloud Platform yang lebih cocok untuk operasi atau pengujian satu kali.

Dalam hal ini, sebaiknya upload file CSV ke bucket Cloud Storage. Skrip Validasi Alamat Volume Tinggi kemudian dapat dijalankan dari lingkungan Cloud Run. Namun, Anda dapat mengeksekusinya di lingkungan runtime lain seperti Compute Engine atau Google Kubernetes Engine. CSV output juga dapat diupload ke bucket Cloud Storage.

Berjalan sebagai pipeline data Google Cloud Platform

Pola deployment yang ditampilkan di bagian sebelumnya sangat cocok untuk menguji Validasi Alamat Volume Tinggi dengan cepat untuk penggunaan satu kali. Namun, jika Anda perlu menggunakannya secara rutin sebagai bagian dari pipeline data, Anda dapat memanfaatkan kemampuan native Google Cloud Platform dengan lebih baik untuk membuatnya lebih andal. Beberapa perubahan yang dapat Anda lakukan meliputi:

- Dalam hal ini, Anda dapat membuang file CSV di bucket Cloud Storage.

- Tugas Dataflow dapat mengambil alamat yang akan diproses, lalu melakukan caching di BigQuery.

- Library Python Dataflow dapat diperluas untuk memiliki logika Validasi Alamat Volume Tinggi guna memvalidasi alamat dari tugas Dataflow.

Menjalankan skrip dari pipeline data sebagai proses berulang yang berjalan lama

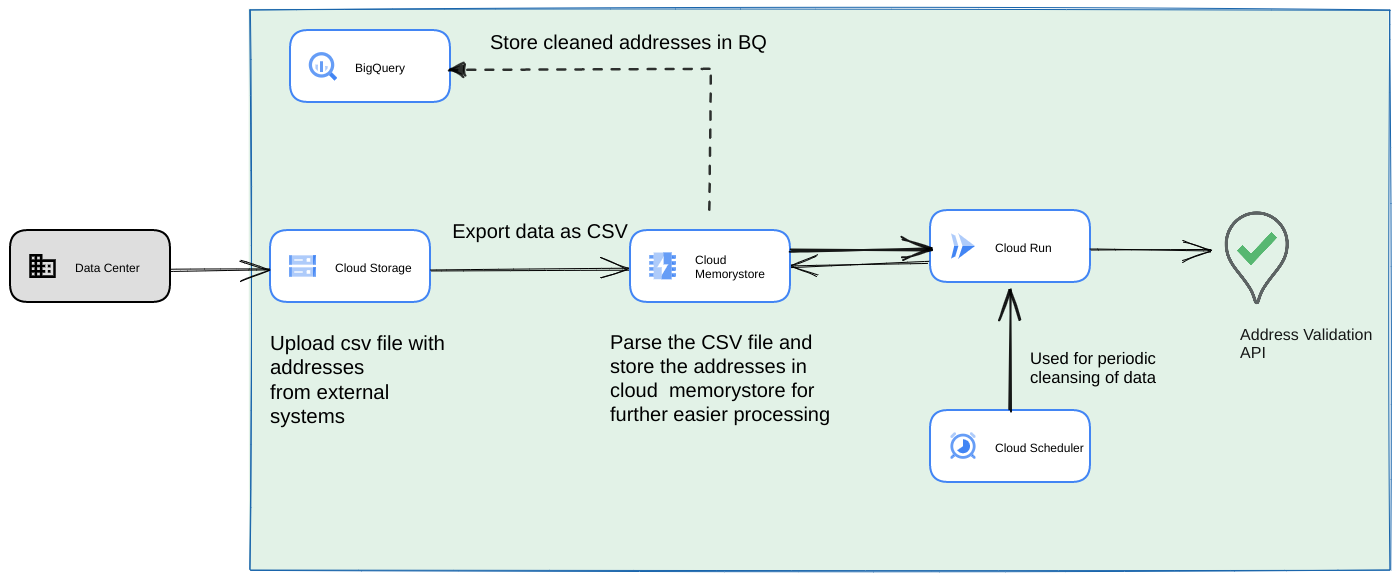

Pendekatan umum lainnya adalah memvalidasi batch alamat sebagai bagian dari pipeline data streaming sebagai proses berulang. Anda juga dapat memiliki alamat di datastore BigQuery. Dalam pendekatan ini, kita akan melihat cara membuat pipeline data berulang (yang perlu dipicu setiap hari/minggu/bulan)

- Upload file CSV awal ke bucket Cloud Storage.

- Gunakan Memorystore sebagai penyimpanan data persisten untuk mempertahankan status perantara proses yang berjalan lama.

- Simpan alamat akhir dalam cache di penyimpanan data BigQuery.

- Siapkan Cloud Scheduler untuk menjalankan skrip secara berkala.

Arsitektur ini memiliki keunggulan berikut:

- Dengan Cloud Scheduler, validasi alamat dapat dilakukan secara berkala. Anda mungkin ingin memvalidasi ulang alamat setiap bulan atau memvalidasi alamat baru setiap bulan/kuartal. Arsitektur ini membantu menyelesaikan kasus penggunaan tersebut.

Jika data pelanggan ada di BigQuery, alamat yang divalidasi atau Flag validasi dapat di-cache langsung di sana. Catatan: Apa yang dapat di-cache dan caranya dijelaskan secara mendetail dalam artikel Validasi Alamat Volume Tinggi

Menggunakan Memorystore memberikan ketahanan yang lebih tinggi dan kemampuan untuk memproses lebih banyak alamat. Langkah ini menambahkan status ke seluruh pipeline pemrosesan yang diperlukan untuk menangani set data alamat yang sangat besar. Teknologi database lain seperti Cloud SQL[https://cloud.google.com/sql] atau jenis database lainnya yang ditawarkan Google Cloud Platform juga dapat digunakan di sini. Namun, kami yakin bahwa Memorystore menyeimbangkan kebutuhan penskalaan dan kesederhanaan dengan sempurna, sehingga harus menjadi pilihan pertama.

Kesimpulan

Dengan menerapkan pola yang dijelaskan di sini, Anda dapat menggunakan Address Validation API untuk berbagai kasus penggunaan dan dari berbagai kasus penggunaan di Google Cloud Platform.

Kami telah menulis library Python open source untuk membantu Anda memulai kasus penggunaan yang dijelaskan di atas. Dapat dipanggil dari command line di komputer Anda atau dari Google Cloud Platform atau penyedia cloud lainnya.

Pelajari lebih lanjut cara menggunakan library dari artikel ini.

Langkah Berikutnya

Download Kertas Putih Meningkatkan kualitas checkout, pengiriman, dan operasi dengan alamat yang andal dan tonton Webinar Meningkatkan kualitas checkout, pengiriman, dan operasi dengan Validasi Alamat .

Bacaan lebih lanjut yang disarankan:

Kontributor

Google mengelola artikel ini. Kontributor berikut awalnya menulisnya.

Penulis utama:

Henrik Valve | Solutions Engineer

Thomas Anglaret | Solutions Engineer

Sarthak Ganguly | Solutions Engineer