Objetivo

O tutorial Validação de endereços de alto volume mostrou diferentes cenários em que essa validação pode ser usada. Neste tutorial, vamos apresentar diferentes padrões de design no Google Cloud Platform para executar a validação de endereços de alto volume.

Vamos começar com uma visão geral sobre como executar a validação de endereço de alto volume no Google Cloud Platform com o Cloud Run, o Compute Engine ou o Google Kubernetes Engine para execuções únicas. Depois, vamos ver como essa capacidade pode ser incluída em um pipeline de dados.

Ao final deste artigo, você terá um bom entendimento das diferentes opções para executar a validação de endereço em alto volume no seu ambiente do Google Cloud.

Arquitetura de referência no Google Cloud Platform

Esta seção aborda diferentes padrões de design para validação de endereços de alto volume usando o Google Cloud Platform. Ao executar no Google Cloud Platform, você pode integrar com seus processos e pipelines de dados atuais.

Executar a validação de endereços de alto volume uma vez no Google Cloud Platform

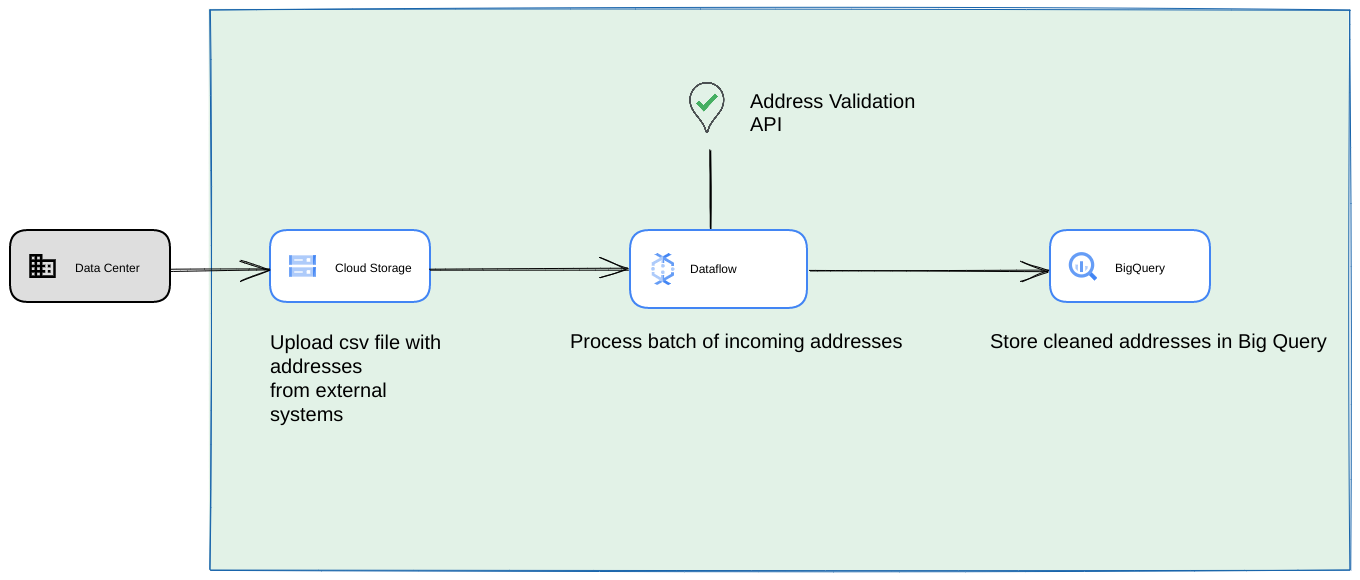

Confira abaixo uma arquitetura de referência de como criar uma integração no Google Cloud Platform, mais adequada para operações únicas ou testes.

Nesse caso, recomendamos fazer upload do arquivo CSV para um bucket do Cloud Storage. O script de validação de endereço de alto volume pode ser executado em um ambiente do Cloud Run. No entanto, é possível executá-lo em qualquer outro ambiente de execução, como o Compute Engine ou o Google Kubernetes Engine. O CSV de saída também pode ser enviado para o bucket do Cloud Storage.

Executando como um pipeline de dados do Google Cloud Platform

O padrão de implantação mostrado na seção anterior é ótimo para testar rapidamente a Validação de Endereços de Alto Volume para uso único. No entanto, se você precisar usá-lo regularmente como parte de um pipeline de dados, aproveite melhor os recursos nativos do Google Cloud Platform para torná-lo mais robusto. Algumas das mudanças que você pode fazer incluem:

- Nesse caso, você pode despejar arquivos CSV em buckets do Cloud Storage.

- Um job do Dataflow pode coletar os endereços a serem processados e armazenar em cache no BigQuery.

- A biblioteca Python do Dataflow pode ser estendida para ter lógica de validação de endereços de alto volume e validar os endereços do job do Dataflow.

Executar o script de um pipeline de dados como um processo recorrente de longa duração

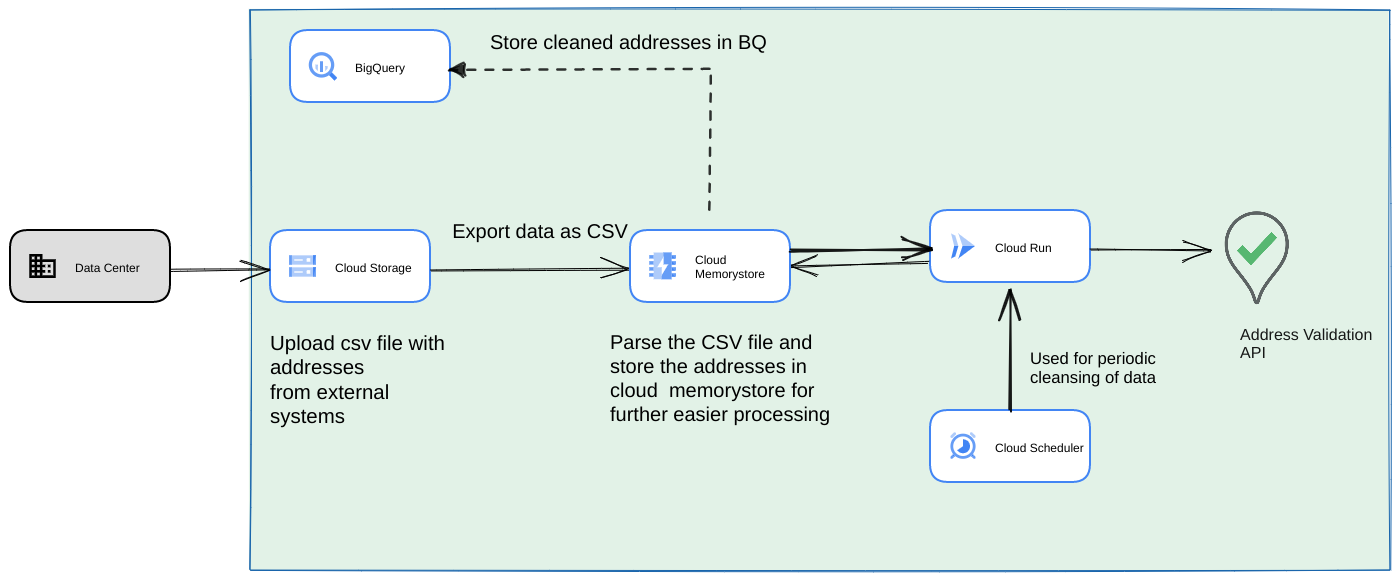

Outra abordagem comum é validar um lote de endereços como parte de um pipeline de dados de streaming como um processo recorrente. Você também pode ter os endereços em um repositório de dados do BigQuery. Nessa abordagem, vamos mostrar como criar um pipeline de dados recorrente (que precisa ser acionado diariamente/semanalmente/mensalmente).

- Faça upload do arquivo CSV inicial para um bucket do Cloud Storage.

- Use o Memorystore como um repositório de dados persistente para manter o estado intermediário do processo de longa duração.

- Armazene em cache os endereços finais em um repositório de dados do BigQuery.

- Configure o Cloud Scheduler para executar o script periodicamente.

Essa arquitetura tem as seguintes vantagens:

- Com o Cloud Scheduler, a validação de endereço pode ser feita periodicamente. Você pode querer revalidar os endereços mensalmente ou validar quaisquer novos endereços mensalmente/trimestralmente. Essa arquitetura ajuda a resolver esse caso de uso.

Se os dados do cliente estiverem no BigQuery, os endereços validados ou as flags de validação poderão ser armazenados em cache diretamente lá. Nota: O que pode ser armazenado em cache e como isso é descrito em detalhes no artigo Validação de Endereços de Alto Volume

O uso do Memorystore oferece maior capacidade de processamento e resiliência. Essa etapa adiciona um estado a todo o pipeline de processamento, o que é necessário para lidar com conjuntos de dados de endereços muito grandes. Outras tecnologias de banco de dados, como o Cloud SQL[https://cloud.google.com/sql] ou qualquer outro tipo de banco de dados oferecido pelo Google Cloud Platform, também podem ser usadas aqui. No entanto, acreditamos que o memorystore perfectless equilibra as necessidades de escalonamento e simplicidade, sendo a primeira opção.

Conclusão

Ao aplicar os padrões descritos aqui, você pode usar a API Address Validation para diferentes casos de uso e em diferentes casos de uso no Google Cloud Platform.

Criamos uma biblioteca Python de código aberto para ajudar você a começar a usar os casos de uso descritos acima. Ele pode ser invocado em uma linha de comando no seu computador ou no Google Cloud Platform ou em outros provedores de nuvem.

Saiba como usar a biblioteca neste artigo.

Próximas etapas

Baixe o Whitepaper "Melhore a finalização da compra, o envio e as operações com endereços confiáveis" e assista o Webinar "Melhore a finalização da compra, o envio e as operações com a validação de endereço" .

Leitura adicional sugerida:

- Documentação da API Address Validation

- Geocodificação e validação de endereço

- Confira a demonstração da Address Validation

Colaboradores

O Google mantém este artigo. Os colaboradores a seguir escreveram originalmente este artigo.

Principais autores:

Henrik Valve | Engenheiro de soluções

Thomas Anglaret | Engenheiro de soluções

Sarthak Ganguly | Engenheiro de soluções