برای آموزش یک مدل، به یک روش خوب برای کاهش ضرر مدل نیاز داریم. رویکرد تکراری یکی از روشهای پرکاربرد برای کاهش تلفات است و به آسانی و کارآمدی پیادهروی از تپه است.

کاهش ضرر

چگونه ضرر را کاهش دهیم؟

- فراپارامترها تنظیمات پیکربندی مورد استفاده برای تنظیم نحوه آموزش مدل هستند.

- مشتق (y - y') 2 با توجه به وزنها و سوگیریها به ما میگوید که چگونه ضرر برای یک مثال مشخص تغییر میکند.

- ساده برای محاسبه و محدب

- بنابراین ما بارها و بارها گام های کوچکی در جهتی برمی داریم که ضرر را به حداقل می رساند

- ما به این مراحل گرادیان می گوییم (اما آنها واقعاً مراحل گرادیان منفی هستند)

- این استراتژی Gradient Descent نام دارد

بلوک دیاگرام نزول گرادیان

- تمرین Gradient Descent را امتحان کنید

- وقتی تمرین را تمام کردید، برای ادامه، play ▶ را فشار دهید

مقدار اولیه وزن

- برای مشکلات محدب، وزن ها می توانند از هر جایی شروع شوند (مثلاً همه 0 ها)

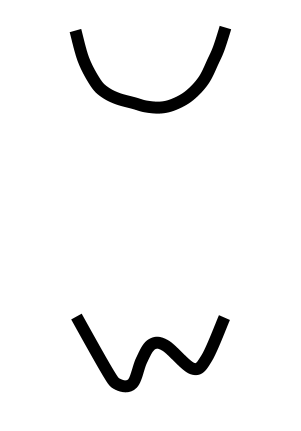

- محدب: به شکل کاسه ای فکر کنید

- فقط یک حداقل

مقدار اولیه وزن

- برای مشکلات محدب، وزن ها می توانند از هر جایی شروع شوند (مثلاً همه 0 ها)

- محدب: به شکل کاسه ای فکر کنید

- فقط یک حداقل

- پیش بینی: برای شبکه های عصبی درست نیست

- غیر محدب: به یک جعبه تخم مرغ فکر کنید

- بیش از یک حداقل

- وابستگی شدید به مقادیر اولیه

SGD & Mini-Batch Gradient Descent

- می تواند گرادیان را روی کل مجموعه داده در هر مرحله محاسبه کند، اما به نظر می رسد که این غیرضروری است

- گرادیان محاسباتی در نمونه های داده کوچک به خوبی کار می کند

- در هر مرحله، یک نمونه تصادفی جدید دریافت کنید

- نزول گرادیان تصادفی : یک مثال در یک زمان

- مینی دسته ای گرادیان نزولی : دسته های 10-1000

- تلفات و گرادیان ها در طول دسته به طور متوسط محاسبه می شوند