Este glossário define termos de machine learning.

A

ablação

Uma técnica para avaliar a importância de um atributo ou componente removendo temporariamente de um modelo. Em seguida, treine o modelo novamente sem esse recurso ou componente. Se o modelo retreinado tiver um desempenho significativamente pior, o recurso ou componente removido provavelmente era importante.

Por exemplo, suponha que você treine um modelo de classificação em 10 recursos e alcance 88% de precisão no conjunto de teste. Para verificar a importância do primeiro atributo, treine o modelo novamente usando apenas os outros nove atributos. Se o modelo retreinado tiver um desempenho significativamente pior (por exemplo, 55% de precisão), o atributo removido provavelmente era importante. Por outro lado, se o modelo retreinado tiver um desempenho igualmente bom, esse recurso provavelmente não era tão importante.

A ablação também pode ajudar a determinar a importância de:

- Componentes maiores, como um subsistema inteiro de um sistema de ML maior

- Processos ou técnicas, como uma etapa de pré-processamento de dados

Em ambos os casos, você vai observar como o desempenho do sistema muda (ou não muda) depois que o componente é removido.

Teste A/B

Uma maneira estatística de comparar duas (ou mais) técnicas: A e B. Normalmente, o A é uma técnica já existente, e o B é uma técnica nova. O teste A/B não apenas determina qual técnica tem melhor performance, mas também se a diferença é estatisticamente significativa.

O teste A/B geralmente compara uma única métrica em duas técnicas. Por exemplo, como a acurácia do modelo se compara em duas técnicas? No entanto, o teste A/B também pode comparar qualquer número finito de métricas.

ícone de atalho

Uma categoria de componentes de hardware especializados projetados para realizar cálculos importantes necessários para algoritmos de aprendizado profundo.

Os chips aceleradores (ou apenas aceleradores) podem aumentar significativamente a velocidade e a eficiência das tarefas de treinamento e inferência em comparação com uma CPU de uso geral. Elas são ideais para treinar redes neurais e tarefas semelhantes que exigem muito poder de computação.

Exemplos de chips aceleradores:

- Unidades de processamento de tensor (TPUs) do Google com hardware dedicado para aprendizado profundo.

- As GPUs da NVIDIA, embora inicialmente projetadas para processamento gráfico, são projetadas para permitir o processamento paralelo, o que pode aumentar significativamente a velocidade de processamento.

precisão

O número de previsões de classificação corretas dividido pelo número total de previsões. Ou seja:

Por exemplo, um modelo que fez 40 previsões corretas e 10 incorretas teria uma acurácia de:

A classificação binária fornece nomes específicos para as diferentes categorias de previsões corretas e incorretas. Assim, a fórmula de acurácia para classificação binária é a seguinte:

em que:

- TP é o número de verdadeiros positivos (previsões corretas).

- TN é o número de verdadeiros negativos (previsões corretas).

- FP é o número de falsos positivos (previsões incorretas).

- FN é o número de falsos negativos (previsões incorretas).

Compare e contraste a acurácia com a precisão e o recall.

Consulte Classificação: acurácia, recall, precisão e métricas relacionadas no Curso intensivo de machine learning para mais informações.

ação

Na aprendizagem por reforço, o mecanismo pelo qual o agente faz a transição entre estados do ambiente. O agente escolhe a ação usando uma política.

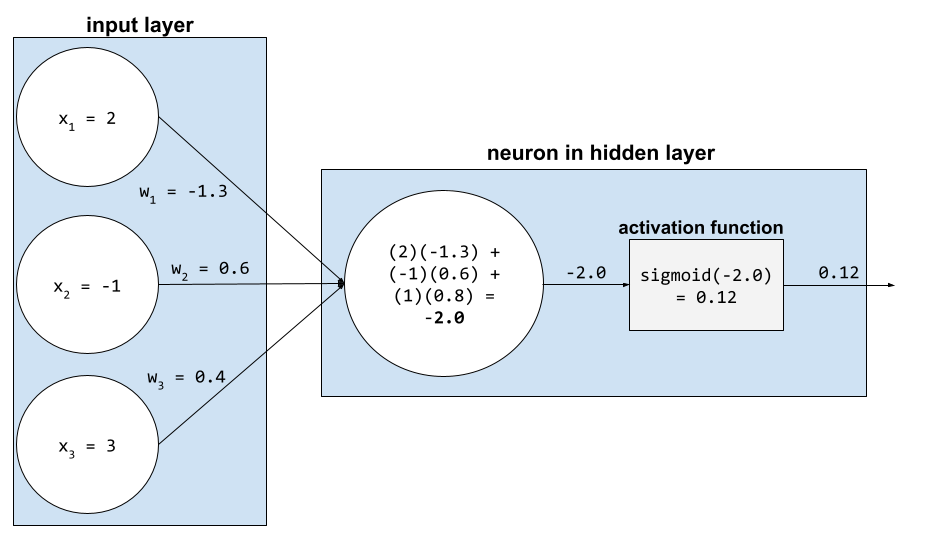

função de ativação

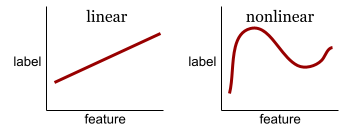

Uma função que permite que as redes neurais aprendam relações não lineares (complexas) entre os recursos e o rótulo.

As funções de ativação mais usadas incluem:

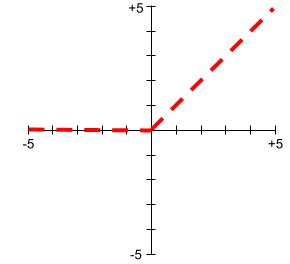

Os gráficos das funções de ativação nunca são linhas retas únicas. Por exemplo, o gráfico da função de ativação ReLU consiste em duas linhas retas:

Um gráfico da função de ativação sigmoide tem esta aparência:

Consulte Redes neurais: funções de ativação no Curso intensivo de machine learning para mais informações.

aprendizagem ativa

Uma abordagem de treinamento em que o algoritmo escolhe alguns dos dados com que aprende. O aprendizado ativo é particularmente valioso quando exemplos rotulados são escassos ou caros de obter. Em vez de buscar cegamente uma variedade de exemplos rotulados, um algoritmo de aprendizado ativo busca seletivamente o intervalo específico de exemplos de que precisa para aprender.

AdaGrad

Um algoritmo sofisticado de descida do gradiente que redimensiona os gradientes de cada parâmetro, a cada parâmetro uma taxa de aprendizado independente. Para uma explicação completa, consulte Adaptive Subgradient Methods for Online Learning and Stochastic Optimization (em inglês).

adaptação

Sinônimo de ajuste ou ajuste fino.

agente

Software que pode raciocinar sobre entradas multimodais do usuário para planejar e executar ações em nome dele.

No aprendizado por reforço, um agente é a entidade que usa uma política para maximizar o retorno esperado obtido com a transição entre estados do ambiente.

clustering aglomerativo

Consulte clustering hierárquico.

detecção de anomalias

O processo de identificar outliers. Por exemplo, se a média de um determinado recurso for 100 com um desvio padrão de 10, a detecção de anomalias vai sinalizar um valor de 200 como suspeito.

AR

Abreviação de realidade aumentada.

área sob a curva PR

Consulte AUC PR (área sob a curva PR).

área sob a curva ROC

Consulte AUC (área sob a curva ROC).

inteligência artificial geral

Um mecanismo não humano que demonstra uma ampla gama de resolução de problemas, criatividade e adaptabilidade. Por exemplo, um programa que demonstre inteligência artificial geral pode traduzir textos, compor sinfonias e se destacar em jogos que ainda não foram inventados.

inteligência artificial

Um programa ou modelo não humano que pode resolver tarefas sofisticadas. Por exemplo, programas ou modelos que traduzem texto ou que identificam doenças usando imagens radiológicas usam inteligência artificial.

Formalmente, o aprendizado de máquina é um subcampo da inteligência artificial. Mas, nos últimos anos, algumas organizações começaram a usar os termos inteligência artificial e aprendizado de máquina como sinônimos.

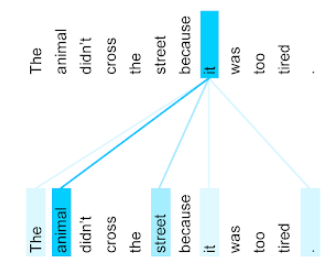

atenção

Um mecanismo usado em uma rede neural que indica a importância de uma palavra ou parte dela. A atenção comprime a quantidade de informações que um modelo precisa para prever o próximo token/palavra. Um mecanismo de atenção típico pode consistir em uma soma ponderada em um conjunto de entradas, em que o peso de cada entrada é calculado por outra parte da rede neural.

Consulte também autoatenção e autoatenção de várias cabeças, que são os blocos de construção dos Transformadores.

Consulte LLMs: o que é um modelo de linguagem grande? no Curso intensivo de machine learning para mais informações sobre autoatenção.

atributo

Sinônimo de recurso.

Na imparcialidade do aprendizado de máquina, os atributos geralmente se referem a características relacionadas a indivíduos.

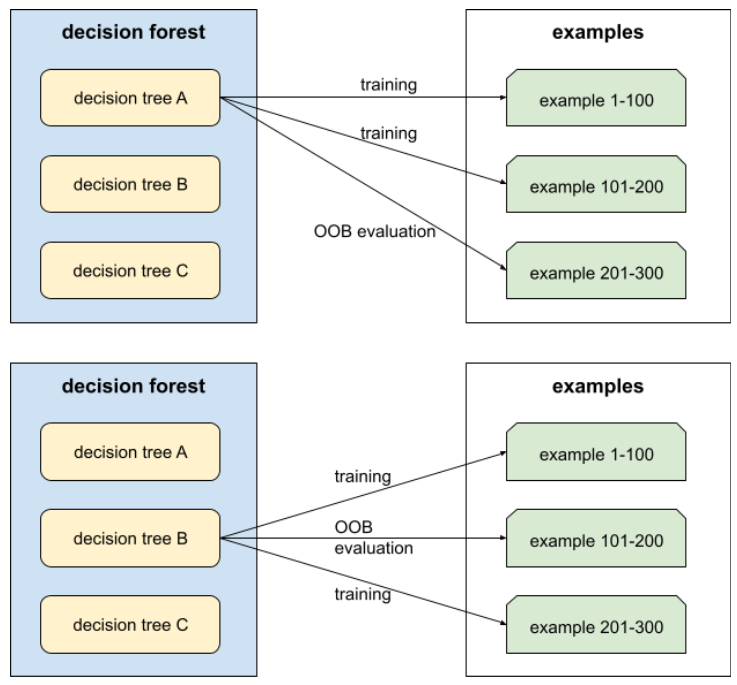

amostragem de atributos

Uma tática para treinar uma floresta de decisão em que cada árvore de decisão considera apenas um subconjunto aleatório de possíveis atributos ao aprender a condição. Em geral, um subconjunto diferente de recursos é amostrado para cada nó. Por outro lado, ao treinar uma árvore de decisão sem amostragem de atributos, todos os recursos possíveis são considerados para cada nó.

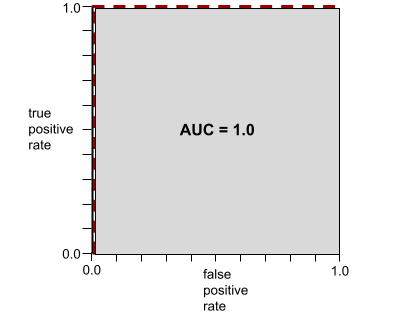

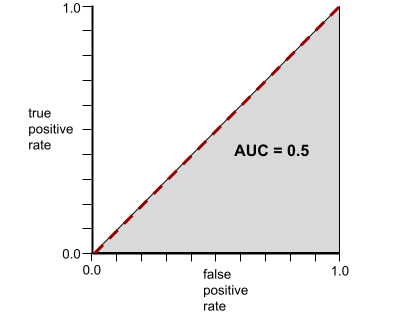

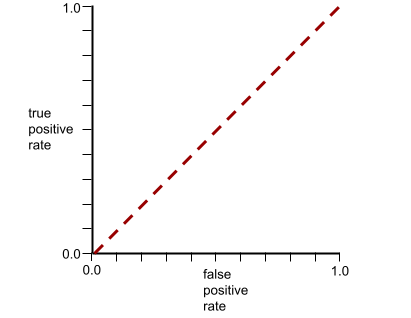

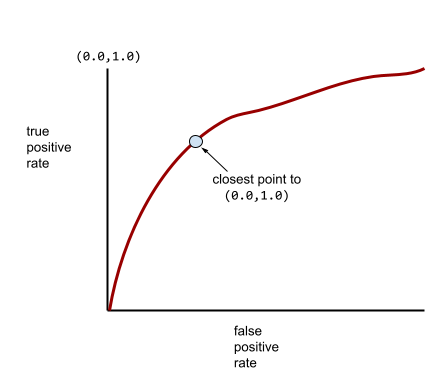

AUC (área sob a curva ROC)

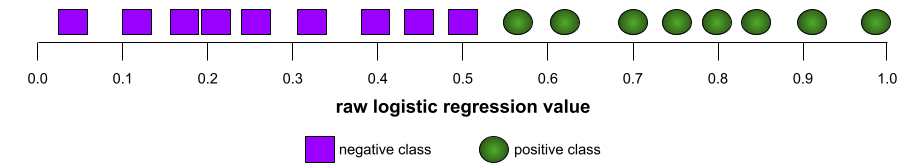

Um número entre 0,0 e 1,0 que representa a capacidade de um modelo de classificação binária separar classes positivas de classes negativas. Quanto mais perto de 1,0 a AUC estiver, melhor será a capacidade do modelo de distinguir as classes.

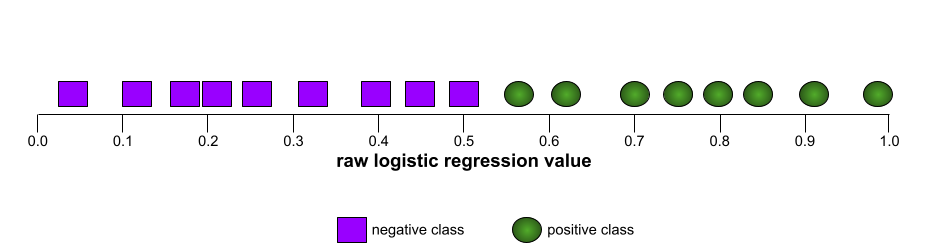

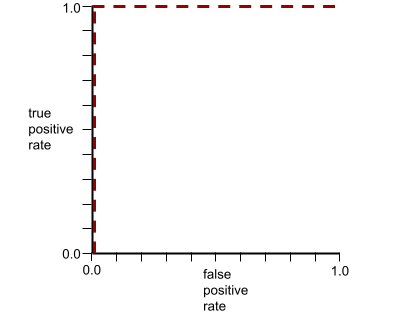

Por exemplo, a ilustração a seguir mostra um modelo de classificação que separa perfeitamente as classes positivas (ovais verdes) das negativas (retângulos roxos). Esse modelo irrealisticamente perfeito tem uma AUC de 1,0:

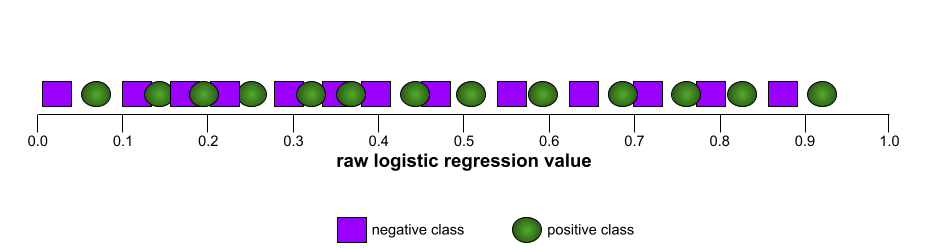

Por outro lado, a ilustração a seguir mostra os resultados de um modelo de classificação que gerou resultados aleatórios. Esse modelo tem uma AUC de 0,5:

Sim, o modelo anterior tem uma AUC de 0,5, não de 0,0.

A maioria dos modelos está em algum lugar entre os dois extremos. Por exemplo, o modelo a seguir separa um pouco os positivos dos negativos e, portanto, tem uma AUC entre 0,5 e 1,0:

A AUC ignora qualquer valor definido para o limite de classificação. Em vez disso, a AUC considera todos os limiares de classificação possíveis.

Consulte Classificação: ROC e AUC no Curso intensivo de machine learning para mais informações.

realidade aumentada

Uma tecnologia que sobrepõe uma imagem gerada por computador à visão do usuário do mundo real, fornecendo assim uma visão composta.

codificador automático

Um sistema que aprende a extrair as informações mais importantes da entrada. Os codificadores automáticos são uma combinação de um codificador e um decodificador. Os codificadores automáticos dependem do seguinte processo de duas etapas:

- O codificador mapeia a entrada para um formato (intermediário) de baixa dimensão (normalmente) com perda.

- O decodificador cria uma versão com perda da entrada original mapeando o formato de dimensão inferior para o formato de entrada original de dimensão superior.

Os codificadores automáticos são treinados de ponta a ponta fazendo com que o decodificador tente reconstruir a entrada original do formato intermediário do codificador da maneira mais fiel possível. Como o formato intermediário é menor (de dimensão inferior) do que o original, o codificador automático é forçado a aprender quais informações na entrada são essenciais, e a saída não será perfeitamente idêntica à entrada.

Exemplo:

- Se os dados de entrada forem um gráfico, a cópia não exata será semelhante ao gráfico original, mas um pouco modificada. Talvez a cópia não exata remova ruídos do gráfico original ou preencha alguns pixels ausentes.

- Se os dados de entrada forem texto, um codificador automático vai gerar um novo texto que imita (mas não é idêntico) o texto original.

Consulte também autocodificadores variacionais.

avaliação automática

Usar software para julgar a qualidade da saída de um modelo.

Quando a saída do modelo é relativamente simples, um script ou programa pode comparar a saída do modelo com uma resposta de ouro. Esse tipo de avaliação automática às vezes é chamado de avaliação programática. Métricas como ROUGE ou BLEU costumam ser úteis para avaliação programática.

Quando a saída do modelo é complexa ou não tem uma resposta certa, um programa de ML separado chamado autorrater às vezes realiza a avaliação automática.

Contraste com a avaliação humana.

viés de automação

Quando um responsável pela tomada de decisões humanas favorece as recomendações feitas por um sistema automatizado de tomada de decisões em vez de informações feitas sem automação, mesmo quando o sistema automatizado de tomada de decisões comete erros.

Consulte Imparcialidade: tipos de viés no Curso intensivo de machine learning para mais informações.

AutoML

Qualquer processo automatizado para criar modelos de machine learning . O AutoML pode realizar tarefas automaticamente, como:

- Pesquise o modelo mais adequado.

- Ajuste os hiperparâmetros.

- Prepare os dados (incluindo a realização da engenharia de atributos).

- Implante o modelo resultante.

O AutoML é útil para cientistas de dados porque economiza tempo e esforço no desenvolvimento de pipelines de machine learning e melhora a acurácia da previsão. Também é útil para pessoas sem experiência, porque torna tarefas complicadas de aprendizado de máquina mais acessíveis.

Consulte Machine learning automatizado (AutoML) no Curso intensivo de machine learning para mais informações.

avaliação do avaliador automático

Um mecanismo híbrido para julgar a qualidade da saída de um modelo de IA generativa que combina avaliação humana com avaliação automática. Um autoavaliador é um modelo de ML treinado com dados criados por avaliação humana. O ideal é que um avaliador automático aprenda a imitar um avaliador humano.Há avaliadores automáticos pré-criados, mas os melhores são ajustados especificamente para a tarefa que você está avaliando.

modelo autorregressivo

Um modelo que infere uma previsão com base nas próprias previsões anteriores. Por exemplo, os modelos de linguagem autorregressivos preveem o próximo token com base nos tokens previstos anteriormente. Todos os modelos de linguagem grandes baseados em Transformer são autorregressivos.

Em contraste, os modelos de imagem baseados em GAN geralmente não são autorregressivos, já que geram uma imagem em uma única passagem direta e não de forma iterativa em etapas. No entanto, alguns modelos de geração de imagens são autorregressivos porque geram uma imagem em etapas.

perda auxiliar

Uma função de perda, usada em conjunto com uma rede neural modelo principal função de perda, que ajuda a acelerar o treinamento durante as primeiras iterações, quando os pesos são inicializados aleatoriamente.

As funções de perda auxiliares enviam gradientes eficazes para as camadas anteriores. Isso facilita a convergência durante o treinamento, combatendo o problema de desaparecimento de gradiente.

Precisão média em k

Uma métrica para resumir a performance de um modelo em um único comando que gera resultados classificados, como uma lista numerada de recomendações de livros. A precisão média em k é, bem, a média dos valores de precisão em k para cada resultado relevante. Portanto, a fórmula para a precisão média em k é:

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

em que:

- \(n\) é o número de itens relevantes na lista.

Contraste com o recall em k.

condição alinhada ao eixo

Em uma árvore de decisão, uma condição que envolve apenas um único recurso. Por exemplo, se area for um recurso, a condição a seguir será alinhada ao eixo:

area > 200

Contraste com a condição oblíqua.

B

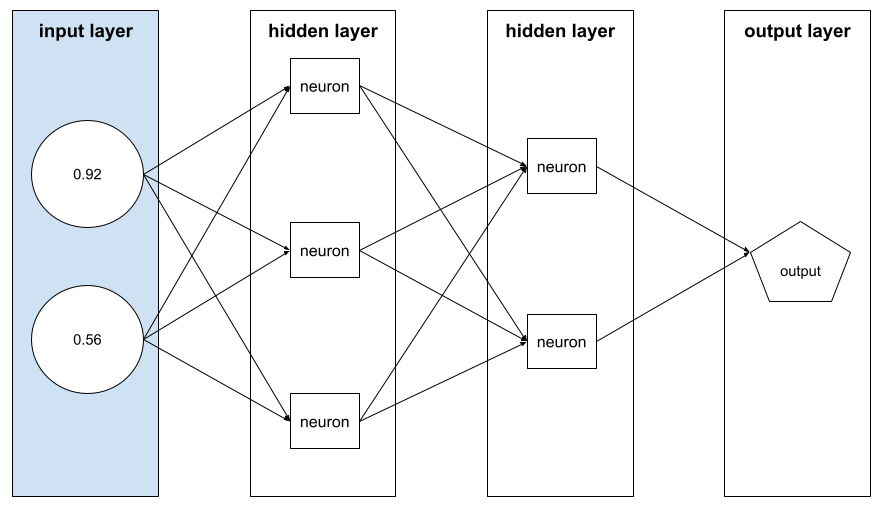

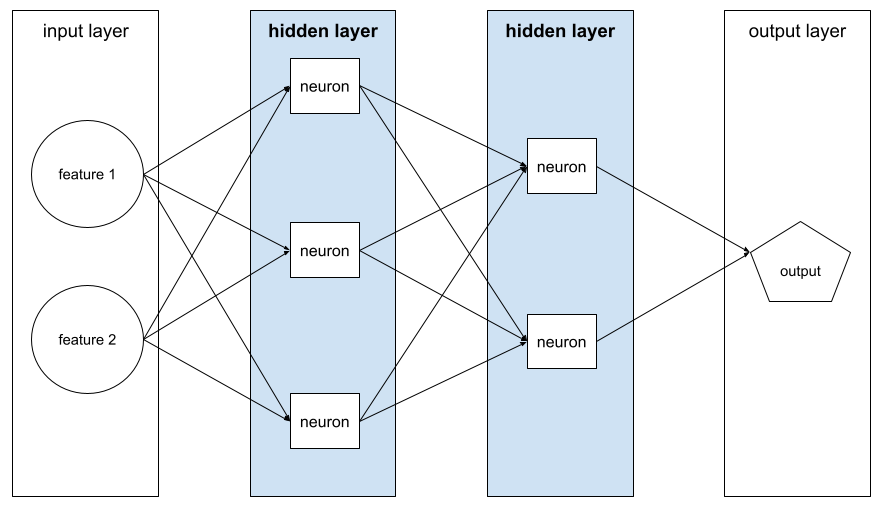

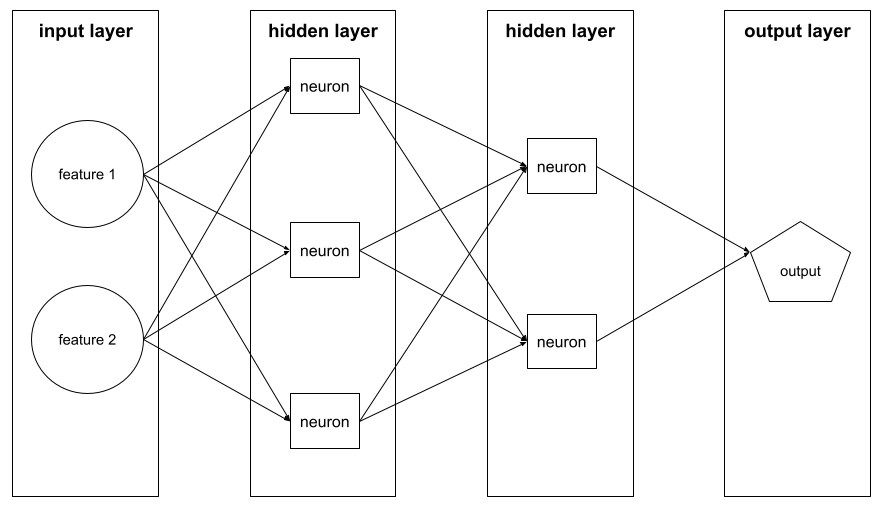

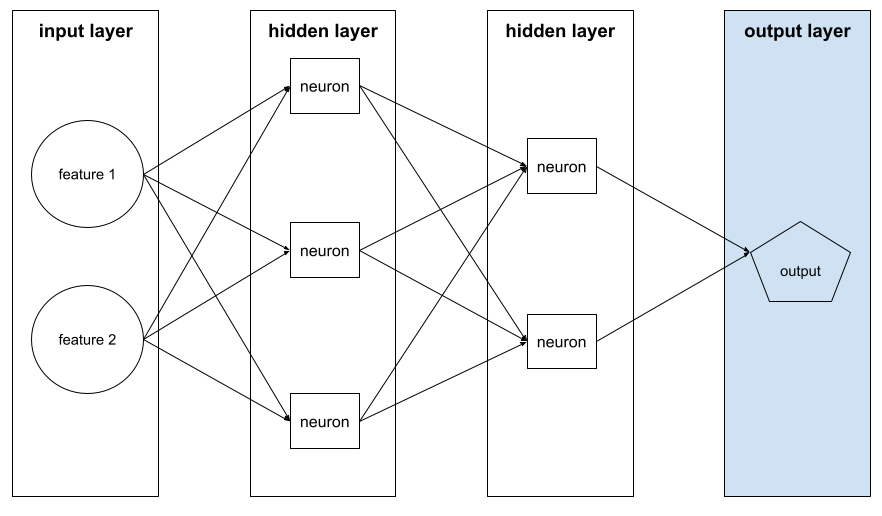

retropropagação

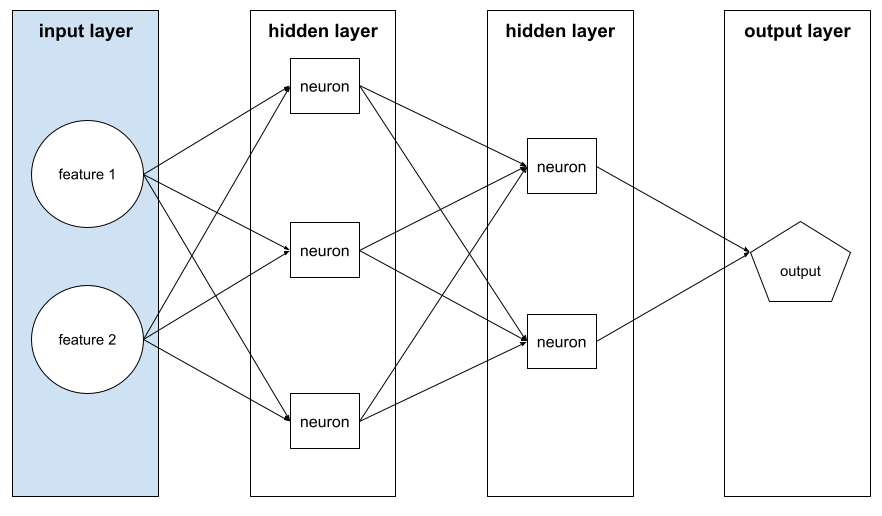

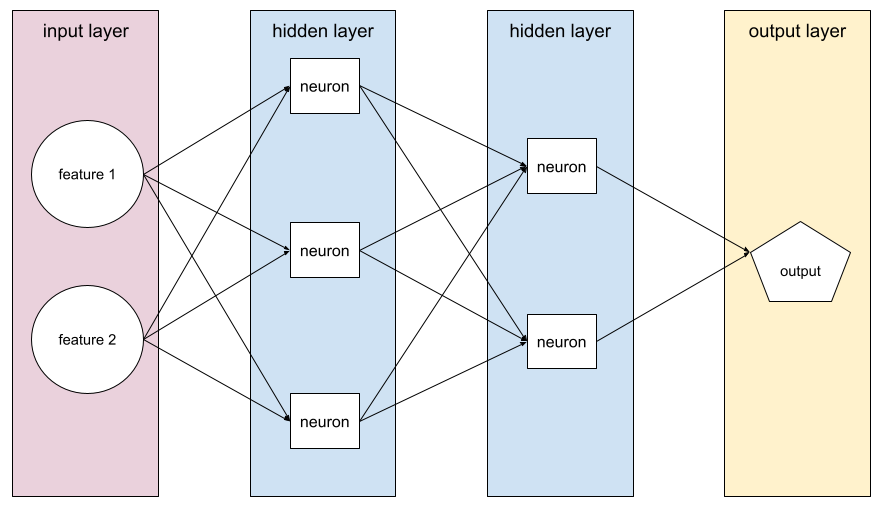

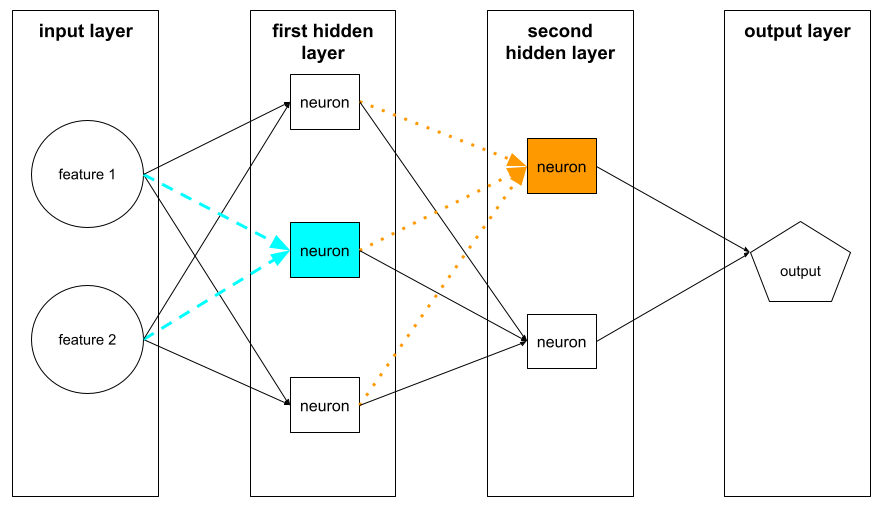

O algoritmo que implementa o gradiente descendente em redes neurais.

O treinamento de uma rede neural envolve muitas iterações do seguinte ciclo de duas passagens:

- Durante a transmissão direta, o sistema processa um lote de exemplos para gerar previsões. O sistema compara cada previsão com cada valor de rótulo. A diferença entre a previsão e o valor do rótulo é a perda desse exemplo. O sistema agrega as perdas de todos os exemplos para calcular a perda total do lote atual.

- Durante a transmissão para trás (backpropagation), o sistema reduz a perda ajustando os pesos de todos os neurônios em todas as camadas ocultas.

As redes neurais geralmente contêm muitos neurônios em várias camadas ocultas. Cada um desses neurônios contribui para a perda geral de maneiras diferentes. A retropropagação determina se é necessário aumentar ou diminuir os pesos aplicados a neurônios específicos.

A taxa de aprendizado é um multiplicador que controla o grau em que cada transmissão para trás aumenta ou diminui cada peso. Uma taxa de aprendizado grande aumenta ou diminui cada peso mais do que uma taxa pequena.

Em termos de cálculo, a retropropagação implementa a regra da cadeia do cálculo. Ou seja, a retropropagação calcula a derivada parcial do erro em relação a cada parâmetro.

Há anos, os profissionais de ML precisavam escrever código para implementar a retropropagação. APIs de ML modernas, como o Keras, agora implementam a retropropagação para você. Ufa.

Consulte Redes neurais no Curso intensivo de machine learning para mais informações.

ensacamento

Um método para treinar um conjunto em que cada modelo constituinte é treinado em um subconjunto aleatório de exemplos de treinamento amostrados com substituição. Por exemplo, uma floresta aleatória é um conjunto de árvores de decisão treinadas com bagging.

O termo bagging é uma abreviação de bootstrap aggregating.

Consulte Florestas aleatórias no curso "Florestas de decisão" para mais informações.

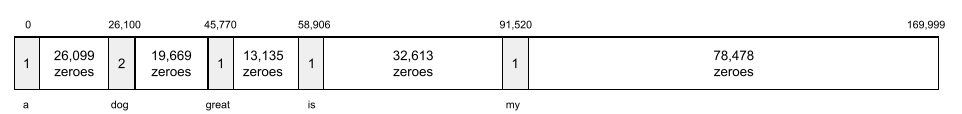

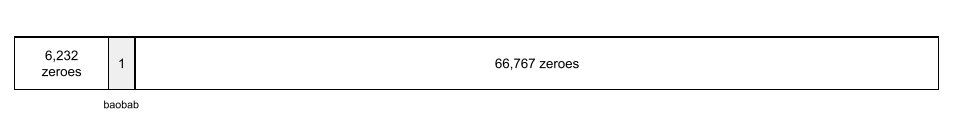

saco de palavras

Uma representação das palavras em uma frase ou passagem, independente da ordem. Por exemplo, o modelo de bolsa de palavras representa as três frases a seguir de forma idêntica:

- o cachorro pula

- pula o cachorro

- o cachorro pula o

Cada palavra é mapeada para um índice em um vetor esparso, em que o vetor tem um índice para cada palavra no vocabulário. Por exemplo, a frase o cachorro pula é mapeada em um vetor de recursos com valores diferentes de zero nos três índices correspondentes às palavras o, cachorro e pula. O valor diferente de zero pode ser qualquer um dos seguintes:

- Um "1" para indicar a presença de uma palavra.

- Uma contagem do número de vezes que uma palavra aparece na bolsa. Por exemplo, se a frase fosse o cachorro marrom é um cachorro com pelo marrom, marrom e cachorro seriam representados como 2, enquanto as outras palavras seriam representadas como 1.

- Algum outro valor, como o logaritmo da contagem do número de vezes que uma palavra aparece na bolsa.

baseline

Um modelo usado como ponto de referência para comparar o desempenho de outro modelo (normalmente, mais complexo). Por exemplo, um modelo de regressão logística pode servir como uma boa base para um modelo de aprendizado profundo.

Para um problema específico, a referência ajuda os desenvolvedores de modelos a quantificar o desempenho mínimo esperado que um novo modelo precisa alcançar para ser útil.

modelo de base

Um modelo pré-treinado que pode servir como ponto de partida para ajustes para lidar com tarefas ou aplicativos específicos.

Consulte também modelo pré-treinado e modelo de fundação.

lote

O conjunto de exemplos usados em uma iteração de treinamento. O tamanho do lote determina o número de exemplos em um lote.

Consulte época para uma explicação de como um lote se relaciona a uma época.

Consulte Regressão linear: hiperparâmetros no Curso intensivo de machine learning para mais informações.

inferência em lote

O processo de inferir previsões em vários exemplos sem rótulo divididos em subconjuntos menores ("lotes").

A inferência em lote pode aproveitar os recursos de paralelização dos chips aceleradores. Ou seja, vários aceleradores podem inferir previsões simultaneamente em diferentes lotes de exemplos sem rótulo, aumentando muito o número de inferências por segundo.

Consulte Sistemas de ML de produção: inferência estática x dinâmica no Curso intensivo de machine learning para mais informações.

normalização em lote

Normalizar a entrada ou saída das funções de ativação em uma camada oculta. A normalização em lote pode oferecer os seguintes benefícios:

- Tornar as redes neurais mais estáveis protegendo contra pesos outlier.

- Ative taxas de aprendizado mais altas, o que pode acelerar o treinamento.

- Reduza o overfitting.

tamanho do lote

O número de exemplos em um lote. Por exemplo, se o tamanho do lote for 100, o modelo vai processar 100 exemplos por iteração.

Confira a seguir algumas estratégias de tamanho de lote conhecidas:

- Gradiente descendente estocástico (GDE), em que o tamanho do lote é 1.

- Lote completo, em que o tamanho do lote é o número de exemplos em todo o conjunto de treinamento. Por exemplo, se o conjunto de treinamento tiver um milhão de exemplos, o tamanho do lote será um milhão de exemplos. O lote completo geralmente é uma estratégia ineficiente.

- minilote, em que o tamanho do lote geralmente fica entre 10 e 1.000. O mini-batch geralmente é a estratégia mais eficiente.

Para saber mais, consulte os seguintes artigos:

- Sistemas de ML de produção: inferência estática x dinâmica no Curso intensivo de machine learning.

- Manual de ajuste do aprendizado profundo.

Rede neural bayesiana

Uma rede neural probabilística que considera a incerteza nos pesos e nas saídas. Um modelo de regressão de rede neural padrão geralmente prevê um valor escalar. Por exemplo, um modelo padrão prevê o preço de uma casa de 853.000. Por outro lado, uma rede neural bayesiana prevê uma distribuição de valores. Por exemplo, um modelo bayesiano prevê um preço de imóvel de US$ 853.000 com um desvio padrão de US$ 67.200.

Uma rede neural bayesiana usa o teorema de Bayes para calcular incertezas em pesos e previsões. Uma rede neural bayesiana pode ser útil quando é importante quantificar a incerteza, como em modelos relacionados a produtos farmacêuticos. As redes neurais bayesianas também podem ajudar a evitar o overfitting.

Otimização bayesiana

Uma técnica de modelo de regressão probabilística para otimizar funções objetivas computacionalmente caras. Em vez disso, ela otimiza um substituto que quantifica a incerteza usando uma técnica de aprendizado bayesiano. Como a otimização bayesiana é muito cara, ela geralmente é usada para otimizar tarefas caras de avaliar que têm um pequeno número de parâmetros, como a seleção de hiperparâmetros.

Equação de Bellman

No aprendizado por reforço, a seguinte identidade é satisfeita pela função Q ideal:

\[Q(s, a) = r(s, a) + \gamma \mathbb{E}_{s'|s,a} \max_{a'} Q(s', a')\]

Os algoritmos de aprendizagem por reforço aplicam essa identidade para criar aprendizagem Q usando a seguinte regra de atualização:

\[Q(s,a) \gets Q(s,a) + \alpha \left[r(s,a) + \gamma \displaystyle\max_{\substack{a_1}} Q(s',a') - Q(s,a) \right] \]

Além da aprendizagem por reforço, a equação de Bellman tem aplicações na programação dinâmica. Consulte a entrada da Wikipédia para a equação de Bellman.

BERT (Bidirectional Encoder Representations from Transformers)

Uma arquitetura de modelo para representação de texto. Um modelo BERT treinado pode atuar como parte de um modelo maior para classificação de texto ou outras tarefas de ML.

O BERT tem as seguintes características:

- Usa a arquitetura Transformer e, portanto, depende da autoatenção.

- Usa a parte codificadora do Transformer. O trabalho do codificador é produzir boas representações de texto, em vez de realizar uma tarefa específica, como classificação.

- É bidirecional.

- Usa mascaramento para treinamento não supervisionado.

As variantes do BERT incluem:

Consulte Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing para uma visão geral do BERT.

viés (ética/justiça)

1. Estereótipos, preconceito ou favoritismo em relação a algumas coisas, pessoas ou grupos. Esses vieses podem afetar a coleta e a interpretação de dados, o design de um sistema e a forma como os usuários interagem com ele. Algumas formas desse tipo de viés incluem:

- viés de automação

- viés de confirmação

- Viés do experimentador

- viés de atribuição a grupos

- viés implícito

- viés de grupo

- viés de homogeneidade externa ao grupo

2. Erro sistemático introduzido por um procedimento de amostragem ou relatório. Algumas formas desse tipo de viés incluem:

- viés de cobertura

- viés de não resposta

- viés de participação

- viés de relatório

- vício de amostragem

- viés de seleção

Não confundir com o termo de viés em modelos de machine learning ou o viés de previsão.

Consulte Imparcialidade: tipos de viés no Curso intensivo de machine learning para mais informações.

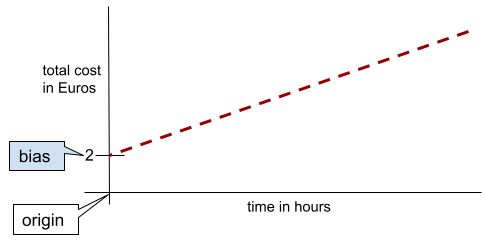

viés (matemática) ou termo de viés

Uma interceptação ou um deslocamento de uma origem. O viés é um parâmetro em modelos de machine learning, simbolizado por um dos seguintes elementos:

- b

- w0

Por exemplo, o viés é o b na seguinte fórmula:

Em uma linha bidimensional simples, a polarização significa apenas "intercepto y". Por exemplo, o viés da linha na ilustração a seguir é 2.

O viés existe porque nem todos os modelos começam na origem (0,0). Por exemplo, suponha que um parque de diversões custe 2 euros para entrar e mais 0,5 euro por hora de permanência de um cliente. Portanto, um modelo que mapeia o custo total tem um viés de 2, porque o menor custo é de 2 euros.

Não confunda viés com viés em ética e justiça ou viés de previsão.

Consulte Regressão linear no Curso intensivo de machine learning para mais informações.

bidirecional

Um termo usado para descrever um sistema que avalia o texto que precede e segue uma seção de texto de destino. Por outro lado, um sistema unidirecional avalia apenas o texto que precede uma seção de texto de destino.

Por exemplo, considere um modelo de linguagem mascarado que precisa determinar as probabilidades da palavra ou palavras que representam o sublinhado na seguinte pergunta:

Qual é o _____ com você?

Um modelo de linguagem unidirecional teria que basear suas probabilidades apenas no contexto fornecido pelas palavras "What", "is" e "the". Em contraste, um modelo de linguagem bidirecional também pode ganhar contexto com "com" e "você", o que pode ajudar o modelo a gerar previsões melhores.

modelo de linguagem bidirecional

Um modelo de linguagem que determina a probabilidade de um determinado token estar presente em um determinado local em um trecho de texto com base no texto anterior e posterior.

bigrama

Um n-grama em que N=2.

classificação binária

Um tipo de tarefa de classificação que prevê uma de duas classes mutuamente exclusivas:

Por exemplo, os dois modelos de aprendizado de máquina a seguir realizam classificação binária:

- Um modelo que determina se as mensagens de e-mail são spam (a classe positiva) ou não spam (a classe negativa).

- Um modelo que avalia sintomas médicos para determinar se uma pessoa tem uma doença específica (a classe positiva) ou não (a classe negativa).

Contraste com a classificação multiclasse.

Consulte também regressão logística e limiar de classificação.

Consulte Classificação no Curso intensivo de machine learning para mais informações.

condição binária

Em uma árvore de decisão, uma condição que tem apenas dois resultados possíveis, geralmente sim ou não. Por exemplo, esta é uma condição binária:

temperature >= 100

Contraste com a condição não binária.

Consulte Tipos de condições no curso "Florestas de decisão" para mais informações.

agrupamento por classes

Sinônimo de agrupamento em intervalos.

modelo de caixa preta

Um modelo cujo "raciocínio" é impossível ou difícil de entender para os humanos. Ou seja, embora os humanos possam ver como os comandos afetam as respostas, não é possível determinar exatamente como um modelo de caixa preta determina a resposta. Em outras palavras, um modelo de caixa preta não tem interpretabilidade.

A maioria dos modelos de aprendizado profundo e modelos de linguagem grandes são caixas pretas.

BLEU (Bilingual Evaluation Understudy)

Uma métrica entre 0,0 e 1,0 para avaliar traduções automáticas, por exemplo, de espanhol para japonês.

Para calcular uma pontuação, o BLEU geralmente compara a tradução de um modelo de ML (texto gerado) com a tradução de um especialista humano (texto de referência). O grau em que os n-gramas no texto gerado e no texto de referência correspondem determina a pontuação BLEU.

O artigo original sobre essa métrica é BLEU: a Method for Automatic Evaluation of Machine Translation (em inglês).

Consulte também BLEURT.

BLEURT (Bilingual Evaluation Understudy from Transformers)

Uma métrica para avaliar traduções automáticas de um idioma para outro, principalmente para e do inglês.

Para traduções de e para o inglês, o BLEURT se alinha mais às classificações humanas do que o BLEU. Ao contrário do BLEU, o BLEURT enfatiza as similaridades semânticas (significado) e pode acomodar paráfrases.

O BLEURT usa um modelo de linguagem grande pré-treinado (o BERT, para ser exato) que é ajustado com base em texto de tradutores humanos.

O artigo original sobre essa métrica é BLEURT: Learning Robust Metrics for Text Generation (em inglês).

incentivo

Uma técnica de machine learning que combina de forma iterativa um conjunto de modelos de classificação simples e não muito precisos (chamados de "classificadores fracos") em um modelo de classificação com alta acurácia (um "classificador forte") ao aumentar a ponderação dos exemplos que o modelo está classificando incorretamente.

Consulte Árvores de decisão com aumento de gradiente? no curso "Florestas de decisão" para mais informações.

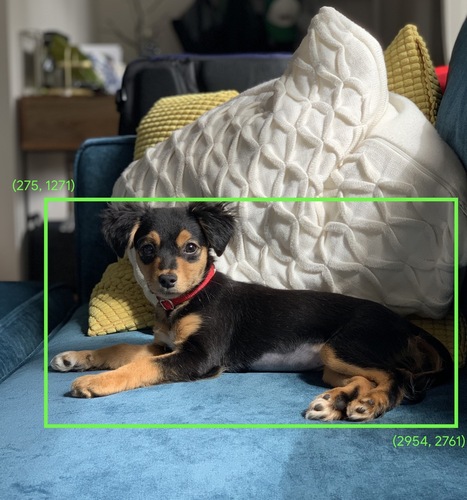

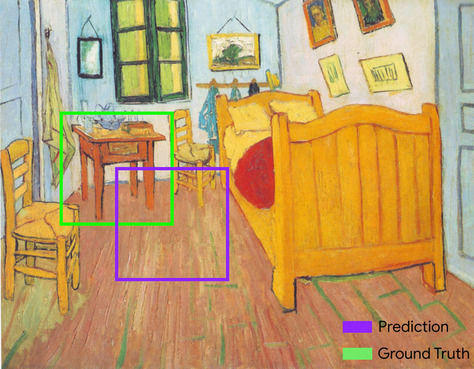

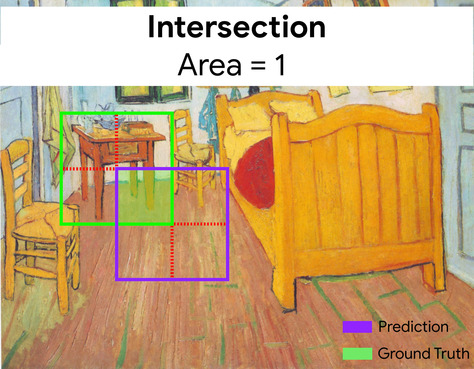

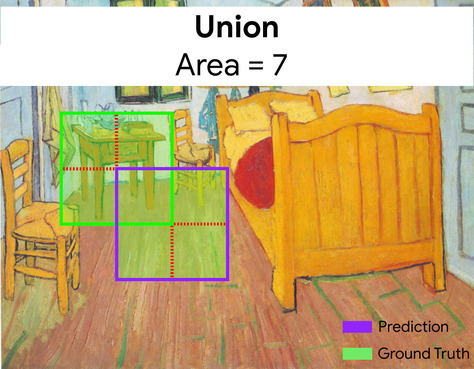

caixa delimitadora

Em uma imagem, as coordenadas (x, y) de um retângulo ao redor de uma área de interesse, como o cachorro na imagem abaixo.

transmissão

Expandir a forma de um operando em uma operação matemática de matriz para dimensões compatíveis com essa operação. Por exemplo, a álgebra linear exige que os dois operandos em uma operação de adição de matrizes tenham as mesmas dimensões. Consequentemente, não é possível adicionar uma matriz de forma (m, n) a um vetor de comprimento n. A transmissão permite essa operação expandindo virtualmente o vetor de comprimento n para uma matriz de forma (m, n) replicando os mesmos valores em cada coluna.

Consulte a descrição a seguir de transmissão em NumPy para mais detalhes.

agrupamento por classes

Converter um único atributo em vários atributos binários chamados de buckets ou classes, normalmente com base em um intervalo de valores. O atributo cortado geralmente é um atributo contínuo.

Por exemplo, em vez de representar a temperatura como um único atributo de ponto flutuante contínuo, você pode dividir intervalos de temperatura em intervalos discretos, como:

- <= 10 graus Celsius seria o grupo "frio".

- 11 a 24 graus Celsius seria o intervalo "temperado".

- >= 25 graus Celsius seria o grupo "quente".

O modelo vai tratar todos os valores no mesmo bucket de forma idêntica. Por exemplo, os valores 13 e 22 estão no bucket "temperado", então o modelo trata os dois valores de forma idêntica.

Consulte Dados numéricos: discretização no Curso intensivo de machine learning para mais informações.

C

camada de calibragem

Um ajuste pós-previsão, geralmente para explicar o vício de previsão. As previsões e probabilidades ajustadas precisam corresponder à distribuição de um conjunto de rótulos observados.

geração de candidatos

O conjunto inicial de recomendações escolhido por um sistema de recomendação. Por exemplo, considere uma livraria que oferece 100.000 títulos. A fase de geração de candidatos cria uma lista muito menor de livros adequados para um determinado usuário, digamos, 500. Mas mesmo 500 livros são muitos para recomendar a um usuário. As fases subsequentes e mais caras de um sistema de recomendação (como pontuação e reclassificação) reduzem esses 500 para um conjunto muito menor e mais útil de recomendações.

Consulte a Visão geral da geração de candidatos no curso de sistemas de recomendação para mais informações.

amostragem de candidatos

Uma otimização no momento do treinamento que calcula uma probabilidade para todos os rótulos positivos, usando, por exemplo, softmax, mas apenas para uma amostra aleatória de rótulos negativos. Por exemplo, considerando um exemplo rotulado como beagle e dog, a amostragem de candidatos calcula as probabilidades previstas e os termos de perda correspondentes para:

- beagle

- cachorro

- um subconjunto aleatório das classes negativas restantes (por exemplo, gato, pirulito, cerca).

A ideia é que as classes negativas aprendam com o reforço negativo menos frequente, desde que as classes positivas sempre recebam o reforço positivo adequado, e isso é observado empiricamente.

A amostragem candidata é mais eficiente em termos computacionais do que os algoritmos de treinamento que calculam previsões para todas as classes negativas, principalmente quando o número de classes negativas é muito grande.

dados categóricos

Atributos com um conjunto específico de valores possíveis. Por exemplo, considere um recurso categórico chamado traffic-light-state, que só pode ter um dos três valores possíveis a seguir:

redyellowgreen

Ao representar traffic-light-state como um atributo categórico, um modelo pode aprender os diferentes impactos de red, green e yellow no comportamento do motorista.

Às vezes, os recursos categóricos são chamados de recursos discretos.

Contraste com dados numéricos.

Consulte Como trabalhar com dados categóricos no Curso intensivo de machine learning para mais informações.

modelo de linguagem causal

Sinônimo de modelo de linguagem unidirecional.

Consulte modelo de linguagem bidirecional para comparar diferentes abordagens direcionais na modelagem de linguagem.

centroid

O centro de um cluster determinado por um algoritmo k-means ou k-median. Por exemplo, se k for 3, o algoritmo k-means ou k-median vai encontrar três centróides.

Consulte Algoritmos de clustering no curso de clustering para mais informações.

clustering baseado em centroide

Uma categoria de algoritmos de clustering que organiza dados em clusters não hierárquicos. O k-means é o algoritmo de clustering baseado em centroide mais usado.

Contraste com algoritmos de clustering hierárquico.

Consulte Algoritmos de clustering no curso de clustering para mais informações.

Comandos de fluxo de consciência

Uma técnica de engenharia de comandos que incentiva um modelo de linguagem grande (LLM) a explicar o raciocínio dele, etapa por etapa. Por exemplo, considere o seguinte comando, prestando atenção especial à segunda frase:

Quantas forças G um motorista sentiria em um carro que vai de 0 a 100 quilômetros por hora em 7 segundos? Na resposta, mostre todos os cálculos relevantes.

A resposta do LLM provavelmente:

- Mostre uma sequência de fórmulas de física, inserindo os valores 0, 60 e 7 nos lugares apropriados.

- Explique por que ele escolheu essas fórmulas e o que significam as várias variáveis.

O comando de fluxo de consciência força o LLM a realizar todos os cálculos, o que pode levar a uma resposta mais correta. Além disso, o comando de cadeia de pensamento permite que o usuário examine as etapas do LLM para determinar se a resposta faz sentido ou não.

chat

O conteúdo de um diálogo entre um usuário e um sistema de ML, geralmente um modelo de linguagem grande. A interação anterior em um chat (o que você digitou e como o modelo de linguagem grande respondeu) se torna o contexto para as partes subsequentes do chat.

Um chatbot é um aplicativo de um modelo de linguagem grande.

checkpoint

Dados que capturam o estado dos parâmetros de um modelo durante ou após o treinamento. Por exemplo, durante o treinamento, você pode:

- Interrompe o treinamento, talvez intencionalmente ou como resultado de determinados erros.

- Capture o checkpoint.

- Depois, recarregue o ponto de verificação, possivelmente em um hardware diferente.

- Reinicie o treinamento.

classe

Uma categoria a que um rótulo pode pertencer. Exemplo:

- Em um modelo de classificação binária que detecta spam, as duas classes podem ser spam e não spam.

- Em um modelo de classificação multiclasse que identifica raças de cachorros, as classes podem ser poodle, beagle, pug, e assim por diante.

Um modelo de classificação prevê uma classe. Já um modelo de regressão prevê um número, não uma classe.

Consulte Classificação no Curso intensivo de machine learning para mais informações.

conjunto de dados balanceado

Um conjunto de dados que contém rótulos categóricos em que o número de instâncias de cada categoria é aproximadamente igual. Por exemplo, considere um conjunto de dados botânicos cujo rótulo binário pode ser planta nativa ou planta não nativa:

- Um conjunto de dados com 515 plantas nativas e 485 plantas não nativas é um conjunto de dados com classes balanceadas.

- Um conjunto de dados com 875 plantas nativas e 125 plantas não nativas é um conjunto de dados com desequilíbrio de classes.

Não há uma linha divisória formal entre conjuntos de dados balanceados e desbalanceados. A distinção só se torna importante quando um modelo treinado em um conjunto de dados altamente desequilibrado não consegue convergir. Consulte Conjuntos de dados: conjuntos de dados desequilibrados no Curso intensivo de machine learning para mais detalhes.

modelo de classificação

Um modelo cuja previsão é uma classe. Por exemplo, todos os modelos a seguir são de classificação:

- Um modelo que prevê o idioma de uma frase de entrada (francês? Espanhol? Italiano?).

- Um modelo que prevê espécies de árvores (bordo? Carvalho? Baobá?).

- Um modelo que prevê a classe positiva ou negativa para uma condição médica específica.

Já os modelos de regressão preveem números, não classes.

Dois tipos comuns de modelos de classificação são:

limiar de classificação

Em uma classificação binária, um número entre 0 e 1 que converte a saída bruta de um modelo de regressão logística em uma previsão da classe positiva ou da classe negativa. O limite de classificação é um valor escolhido por um humano, não pelo treinamento do modelo.

Um modelo de regressão logística gera um valor bruto entre 0 e 1. Em seguida:

- Se esse valor bruto for maior que o limite de classificação, a classe positiva será prevista.

- Se esse valor bruto for menor que o limiar de classificação, a classe negativa será prevista.

Por exemplo, suponha que o limite de classificação seja 0,8. Se o valor bruto for 0,9, o modelo vai prever a classe positiva. Se o valor bruto for 0,7, o modelo vai prever a classe negativa.

A escolha do limite de classificação influencia muito o número de falsos positivos e falsos negativos.

Consulte Limiares e a matriz de confusão no Curso intensivo de machine learning para mais informações.

classificador

Um termo informal para um modelo de classificação.

conjunto de dados não balanceado

Um conjunto de dados para uma classificação em que o número total de rótulos de cada classe difere significativamente. Por exemplo, considere um conjunto de dados de classificação binária cujos dois rótulos são divididos da seguinte maneira:

- 1.000.000 de rótulos negativos

- 10 rótulos positivos

A proporção de rótulos negativos para positivos é de 100.000 para 1. Portanto, esse é um conjunto de dados com desequilíbrio de classes.

Em contraste, o conjunto de dados a seguir é equilibrado por classe porque a proporção de rótulos negativos para positivos é relativamente próxima de 1:

- 517 rótulos negativos

- 483 rótulos positivos

Os conjuntos de dados de várias classes também podem ser desbalanceados. Por exemplo, o seguinte conjunto de dados de classificação multiclasse também é desbalanceado porque um rótulo tem muito mais exemplos do que os outros dois:

- 1.000.000 de rótulos com a classe "verde"

- 200 rótulos com a classe "roxo"

- 350 rótulos com a classe "orange"

O treinamento de conjuntos de dados não balanceados pode apresentar desafios especiais. Consulte Conjuntos de dados desequilibrados no Curso intensivo de machine learning para mais detalhes.

Consulte também entropia, classe majoritária e classe minoritária.

corte

Uma técnica para processar outliers fazendo uma ou ambas as ações a seguir:

- Reduzir os valores de recurso que são maiores que um limite máximo até esse limite.

- Aumentar os valores de recursos que estão abaixo de um limite mínimo até esse limite.

Por exemplo, suponha que menos de 0,5% dos valores de um determinado atributo estejam fora do intervalo de 40 a 60. Nesse caso, você pode fazer o seguinte:

- Corte todos os valores acima de 60 (o limite máximo) para que sejam exatamente 60.

- Corte todos os valores abaixo de 40 (o limite mínimo) para que sejam exatamente 40.

Os outliers podem danificar os modelos, às vezes causando um estouro de pesos durante o treinamento. Alguns outliers também podem prejudicar muito métricas como acurácia. O corte é uma técnica comum para limitar os danos.

O ajuste de gradiente força os valores de gradiente dentro de um intervalo designado durante o treinamento.

Consulte Dados numéricos: normalização no Curso intensivo de machine learning para mais informações.

Cloud TPU

Um acelerador de hardware especializado projetado para acelerar cargas de trabalho de machine learning no Google Cloud.

clustering

Agrupar exemplos relacionados, principalmente durante o aprendizado não supervisionado. Depois que todos os exemplos são agrupados, um humano pode fornecer um significado para cada cluster.

Existem muitos algoritmos de clustering. Por exemplo, o algoritmo k-means agrupa exemplos com base na proximidade a um centroide, como no diagrama a seguir:

Um pesquisador humano pode analisar os clusters e, por exemplo, rotular o cluster 1 como "árvores anãs" e o cluster 2 como "árvores de tamanho normal".

Como outro exemplo, considere um algoritmo de clusterização baseado na distância de um exemplo de um ponto central, ilustrado da seguinte maneira:

Consulte o curso sobre clustering para mais informações.

coadaptação

Um comportamento indesejável em que neurônios preveem padrões em dados de treinamento confiando quase exclusivamente nas saídas de outros neurônios específicos, em vez de confiar no comportamento da rede como um todo. Quando os padrões que causam a coadaptação não estão presentes nos dados de validação, a coadaptação causa overfitting. A regularização de dropout reduz a coadaptação porque o dropout garante que os neurônios não possam depender apenas de outros neurônios específicos.

filtragem colaborativa

Fazer previsões sobre os interesses de um usuário com base nos interesses de muitos outros usuários. A filtragem colaborativa é usada com frequência em sistemas de recomendação.

Consulte Filtragem colaborativa no curso de sistemas de recomendação para mais informações.

modelo compacto

Qualquer modelo pequeno projetado para ser executado em dispositivos pequenos com recursos computacionais limitados. Por exemplo, modelos compactos podem ser executados em smartphones, tablets ou sistemas incorporados.

compute

(Substantivo) Os recursos computacionais usados por um modelo ou sistema, como poder de processamento, memória e armazenamento.

Consulte chips aceleradores.

desvio de conceito

Uma mudança na relação entre atributos e o rótulo. Com o tempo, o deslocamento de conceito reduz a qualidade de um modelo.

Durante o treinamento, o modelo aprende a relação entre os atributos e os rótulos no conjunto de treinamento. Se os rótulos no conjunto de treinamento forem bons indicadores do mundo real, o modelo deverá fazer boas previsões do mundo real. No entanto, devido ao deslocamento de conceito, as previsões do modelo tendem a piorar com o tempo.

Por exemplo, considere um modelo de classificação binária que prevê se um determinado modelo de carro é "eficiente em termos de consumo de combustível" ou não. Ou seja, os recursos podem ser:

- peso do carro

- compressão do motor

- transmission type

enquanto o rótulo for:

- econômico

- não é eficiente em termos de combustível

No entanto, o conceito de "carro econômico" está sempre mudando. Um modelo de carro rotulado como eficiente em termos de consumo de combustível em 1994 seria quase certamente rotulado como não eficiente em termos de consumo de combustível em 2024. Um modelo que sofre com a mudança de conceito tende a fazer previsões cada vez menos úteis com o tempo.

Compare e contraste com não estacionariedade.

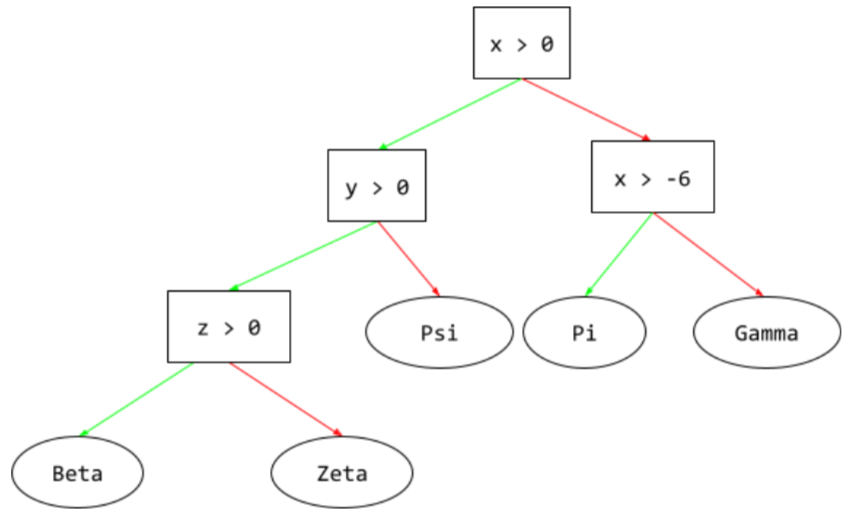

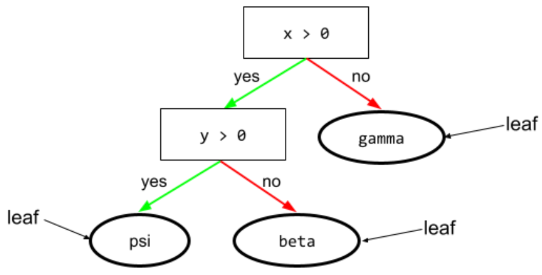

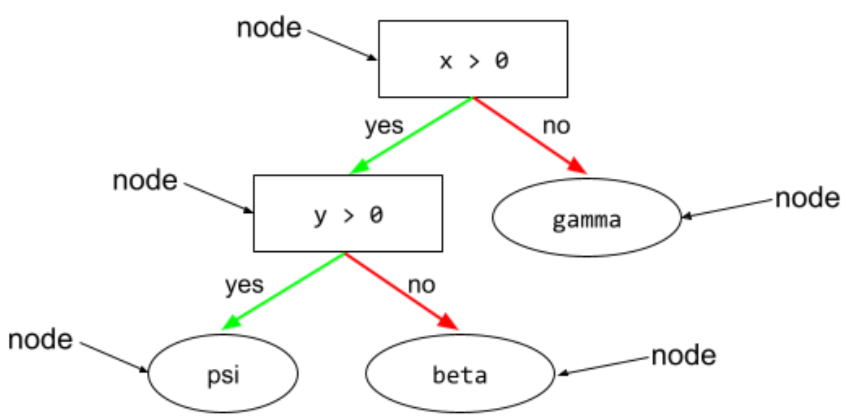

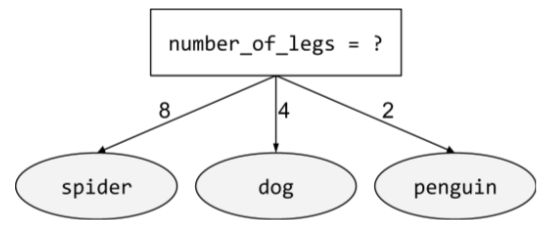

condição

Em uma árvore de decisão, qualquer nó que realiza um teste. Por exemplo, a árvore de decisão a seguir contém duas condições:

Uma condição também é chamada de divisão ou teste.

Contraste a condição com o nó.

Consulte também:

Consulte Tipos de condições no curso "Florestas de decisão" para mais informações.

confabulação

Sinônimo de alucinação.

Confabulação é provavelmente um termo mais preciso tecnicamente do que alucinação. No entanto, a alucinação se tornou popular primeiro.

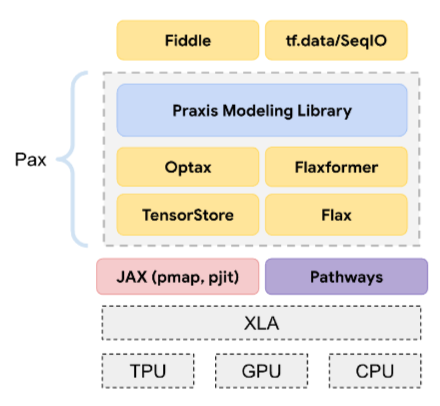

configuração

O processo de atribuição dos valores de propriedade iniciais usados para treinar um modelo, incluindo:

- as camadas de composição do modelo

- o local dos dados

- Hiperparâmetros, como:

Em projetos de machine learning, a configuração pode ser feita usando um arquivo de configuração especial ou bibliotecas de configuração, como:

viés de confirmação

A tendência de pesquisar, interpretar, favorecer e recordar informações de uma maneira que confirme as crenças ou hipóteses preexistentes. Os desenvolvedores de machine learning podem coletar ou rotular dados sem querer de maneiras que influenciam um resultado que apoia as crenças atuais deles. O viés de confirmação é uma forma de viés implícito.

O viés do experimentador é uma forma de viés de confirmação em que um experimentador continua treinando modelos até que uma hipótese pré-existente seja confirmada.

matriz de confusão

Uma tabela NxN que resume o número de previsões corretas e incorretas feitas por um modelo de classificação. Por exemplo, considere a seguinte matriz de confusão para um modelo de classificação binária:

| Tumor (previsto) | Não tumor (previsto) | |

|---|---|---|

| Tumor (informações empíricas) | 18 (VP) | 1 (FN) |

| Não tumor (informações empíricas) | 6 (FP) | 452 (VN) |

A matriz de confusão acima mostra o seguinte:

- Das 19 previsões em que a informação empírica era "Tumor", o modelo classificou 18 corretamente e 1 incorretamente.

- Das 458 previsões em que a verdade fundamental era "Não tumor", o modelo classificou corretamente 452 e incorretamente 6.

A matriz de confusão para um problema de classificação multiclasse pode ajudar a identificar padrões de erros. Por exemplo, considere a seguinte matriz de confusão para um modelo de classificação multiclasse de três classes que categoriza três tipos diferentes de íris (Virginica, Versicolor e Setosa). Quando a verdade fundamental era Virginica, a matriz de confusão mostra que o modelo tinha muito mais probabilidade de prever Versicolor do que Setosa por engano:

| Setosa (prevista) | Versicolor (previsto) | Virginica (prevista) | |

|---|---|---|---|

| Setosa (informações empíricas) | 88 | 12 | 0 |

| Versicolor (informações empíricas) | 6 | 141 | 7 |

| Virginica (informações empíricas) | 2 | 27 | 109 |

Como outro exemplo, uma matriz de confusão pode revelar que um modelo treinado para reconhecer dígitos manuscritos tende a prever erroneamente 9 em vez de 4 ou 1 em vez de 7.

As matrizes de confusão contêm informações suficientes para calcular várias métricas de performance, incluindo precisão e recall.

análise de constituintes

Dividir uma frase em estruturas gramaticais menores ("constituintes"). Uma parte posterior do sistema de ML, como um modelo de processamento de linguagem natural, pode analisar os constituintes com mais facilidade do que a frase original. Por exemplo, considere a seguinte frase:

Meu amigo adotou dois gatos.

Um analisador de constituintes pode dividir essa frase nos dois constituintes a seguir:

- Meu amigo é uma frase nominal.

- adotou dois gatos é uma frase verbal.

Esses constituintes podem ser subdivididos em constituintes menores. Por exemplo, a frase verbal

adotou dois gatos

podem ser subdivididos em:

- adotado é um verbo.

- dois gatos é outro sintagma nominal.

embedding de linguagem contextualizada

Uma embedding que se aproxima da "compreensão" de palavras e frases da mesma forma que falantes humanos fluentes. Os embeddings de linguagem contextualizada podem entender sintaxe, semântica e contexto complexos.

Por exemplo, considere embeddings da palavra em inglês cow. Incorporações mais antigas, como o word2vec, podem representar palavras em inglês de modo que a distância no espaço de incorporação de cow (vaca) para bull (touro) seja semelhante à distância de ewe (ovelha fêmea) para ram (carneiro) ou de female (feminino) para male (masculino). As incorporações de linguagem contextualizada podem ir além, reconhecendo que os falantes de inglês às vezes usam casualmente a palavra cow para se referir a vaca ou touro.

janela de contexto

O número de tokens que um modelo pode processar em um determinado comando. Quanto maior a janela de contexto, mais informações o modelo pode usar para fornecer respostas coerentes e consistentes ao comando.

atributo contínuo

Um recurso de ponto flutuante com um intervalo infinito de valores possíveis, como temperatura ou peso.

Contraste com o atributo discreto.

amostragem por conveniência

Usar um conjunto de dados que não foi coletado de forma científica para executar experimentos rápidos. Depois, é essencial mudar para um conjunto de dados coletado cientificamente.

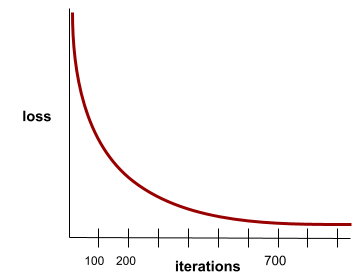

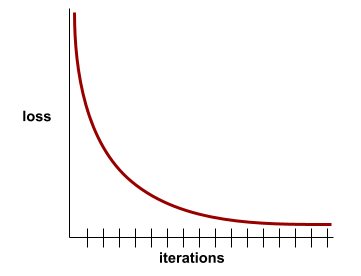

convergência

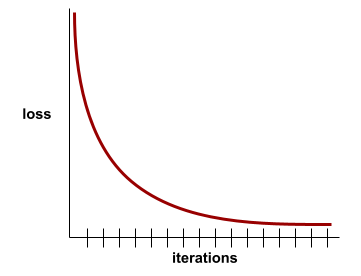

Um estado alcançado quando os valores de perda mudam muito pouco ou nada a cada iteração. Por exemplo, a curva de perda a seguir sugere convergência em torno de 700 iterações:

Um modelo converge quando um treinamento adicional não melhora o modelo.

No aprendizado profundo, os valores de perda às vezes permanecem constantes ou quase assim por muitas iterações antes de finalmente diminuírem. Durante um longo período de valores de perda constantes, você pode ter temporariamente uma falsa sensação de convergência.

Consulte também parada antecipada.

Consulte Convergência do modelo e curvas de perda no Curso intensivo de machine learning para mais informações.

programação conversacional

Um diálogo iterativo entre você e um modelo de IA generativa com o objetivo de criar software. Você emite um comando descrevendo um software. Em seguida, o modelo usa essa descrição para gerar o código. Em seguida, você envia um novo comando para corrigir as falhas no comando anterior ou no código gerado, e o modelo gera um código atualizado. Vocês dois vão continuar trocando mensagens até que o software gerado seja bom o suficiente.

A codificação de conversas é essencialmente o significado original de vibe coding.

Contraste com a codificação especificacional.

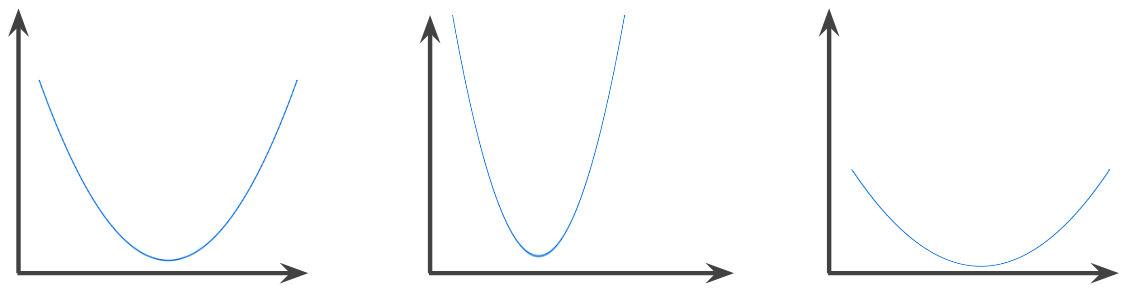

função convexa

Uma função em que a região acima do gráfico é um conjunto convexo. A função convexa prototípica tem um formato semelhante à letra U. Por exemplo, as seguintes são todas funções convexas:

Por outro lado, a função a seguir não é convexa. Observe como a região acima do gráfico não é um conjunto convexo:

Uma função estritamente convexa tem exatamente um ponto de mínimo local, que também é o ponto de mínimo global. As funções clássicas em forma de U são estritamente convexas. No entanto, algumas funções convexas (por exemplo, linhas retas) não têm formato de U.

Consulte Convergência e funções convexas no Curso intensivo de machine learning para mais informações.

otimização convexa

O processo de usar técnicas matemáticas, como gradiente descendente, para encontrar o mínimo de uma função convexa. Grande parte da pesquisa em machine learning se concentrou em formular vários problemas como problemas de otimização convexa e em resolver esses problemas de maneira mais eficiente.

Para mais detalhes, consulte Boyd e Vandenberghe, Convex Optimization.

conjunto convexo

Um subconjunto do espaço euclidiano em que uma linha traçada entre dois pontos quaisquer permanece completamente dentro do subconjunto. Por exemplo, as duas formas a seguir são conjuntos convexos:

Por outro lado, as duas formas a seguir não são conjuntos convexos:

convolução

Em matemática, falando de maneira informal, uma mistura de duas funções. No aprendizado de máquina, uma convolução mistura o filtro convolucional e a matriz de entrada para treinar pesos.

O termo "convolução" em machine learning é geralmente uma forma abreviada de se referir a uma operação convolucional ou a uma camada convolucional.

Sem convoluções, um algoritmo de aprendizado de máquina precisaria aprender um peso separado para cada célula em um grande tensor. Por exemplo, um algoritmo de aprendizado de máquina treinado em imagens de 2K x 2K seria forçado a encontrar 4 milhões de pesos separados. Graças às convoluções, um algoritmo de aprendizado de máquina só precisa encontrar pesos para cada célula no filtro convolucional, reduzindo drasticamente a memória necessária para treinar o modelo. Quando o filtro convolucional é aplicado, ele é simplesmente replicado em todas as células, de modo que cada uma seja multiplicada pelo filtro.

Consulte Introdução às redes neurais convolucionais no curso de classificação de imagens para mais informações.

filtro convolucional

Um dos dois atores em uma operação convolucional. O outro ator é uma fração de uma matriz de entrada. Um filtro convolucional é uma matriz com a mesma ordem da matriz de entrada, mas um formato menor. Por exemplo, considerando uma matriz de entrada de 28 x 28, o filtro pode ser qualquer matriz 2D menor que 28 x 28.

Na manipulação fotográfica, todas as células de um filtro convolucional são geralmente definidas como um padrão constante de uns e zeros. No aprendizado de máquina, os filtros convolucionais geralmente são inicializados com números aleatórios, e a rede treina os valores ideais.

Consulte Convolução no curso de classificação de imagens para mais informações.

camada convolucional

Uma camada de uma rede neural profunda em que um filtro convolucional transmite uma matriz de entrada. Por exemplo, considere o seguinte filtro convolucional 3x3:

![Uma matriz 3x3 com os seguintes valores: [[0,1,0], [1,0,1], [0,1,0]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalFilter33.svg?authuser=00&hl=pt)

A animação a seguir mostra uma camada convolucional com nove operações convolucionais envolvendo a matriz de entrada 5x5. Cada operação convolucional funciona em uma fatia 3x3 diferente da matriz de entrada. A matriz 3x3 resultante (à direita) consiste nos resultados das nove operações de convolução:

![Uma animação mostrando duas matrizes. A primeira matriz é a 5x5: [[128,97,53,201,198], [35,22,25,200,195], [37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].

A segunda matriz é a 3x3: [[181,303,618], [115,338,605], [169,351,560]].

A segunda matriz é calculada aplicando o filtro convolucional [[0, 1, 0], [1, 0, 1], [0, 1, 0]] em diferentes subconjuntos 3x3 da matriz 5x5.](https://developers.google.cn/static/machine-learning/glossary/images/AnimatedConvolution.gif?authuser=00&hl=pt)

Consulte Camadas totalmente conectadas no curso de classificação de imagens para mais informações.

rede neural convolucional

Uma rede neural em que pelo menos uma camada é uma camada convolucional. Uma rede neural convolucional típica consiste em alguma combinação das seguintes camadas:

As redes neurais convolucionais tiveram muito sucesso em alguns tipos de problemas, como reconhecimento de imagens.

operação de convolução

A seguinte operação matemática em duas etapas:

- Multiplicação elemento a elemento do filtro convolucional e uma fração de uma matriz de entrada. A fatia da matriz de entrada tem a mesma classificação e o mesmo tamanho do filtro convolucional.

- Soma de todos os valores na matriz de produtos resultante.

Por exemplo, considere a seguinte matriz de entrada 5x5:

![A matriz 5x5: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerInputMatrix.svg?authuser=00&hl=pt)

Agora imagine o seguinte filtro convolucional 2x2:

![A matriz 2x2: [[1, 0], [0, 1]]](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerFilter.svg?authuser=00&hl=pt)

Cada operação convolucional envolve uma única fatia 2x2 da matriz de entrada. Por exemplo, suponha que usemos a fatia 2x2 no canto superior esquerdo da matriz de entrada. Assim, a operação de convolução nessa fatia fica assim:

![Aplicando o filtro convolucional [[1, 0], [0, 1]] à seção 2x2 no canto superior esquerdo da matriz de entrada, que é [[128,97], [35,22]].

O filtro convolucional deixa 128 e 22 intactos, mas zera 97 e 35. Consequentemente, a operação de convolução gera o valor 150 (128+22).](https://developers.google.cn/static/machine-learning/glossary/images/ConvolutionalLayerOperation.svg?authuser=00&hl=pt)

Uma camada convolucional consiste em uma série de operações convolucionais, cada uma atuando em uma fatia diferente da matriz de entrada.

custo

Sinônimo de perda.

cotreinamento

Uma abordagem de aprendizagem semissupervisionada, especialmente útil quando todas as condições a seguir são verdadeiras:

- A proporção de exemplos sem rótulo para exemplos rotulados no conjunto de dados é alta.

- Esse é um problema de classificação (binária ou multiclasse).

- O conjunto de dados contém dois conjuntos diferentes de recursos preditivos que são independentes e complementares.

O treinamento conjunto amplifica indicadores independentes em um indicador mais forte. Por exemplo, considere um modelo de classificação que categoriza carros usados individuais como Bom ou Ruim. Um conjunto de recursos preditivos pode se concentrar em características agregadas, como ano, marca e modelo do carro. Outro conjunto pode se concentrar no histórico de direção do proprietário anterior e no histórico de manutenção do carro.

O artigo seminal sobre cotreinamento é Combining Labeled and Unlabeled Data with Co-Training (em inglês) de Blum e Mitchell.

justiça contrafactual

Uma métrica de justiça que verifica se um modelo de classificação produz o mesmo resultado para um indivíduo e para outro idêntico ao primeiro, exceto em relação a um ou mais atributos sensíveis. A avaliação de um modelo de classificação para imparcialidade contrafactual é um método para identificar possíveis fontes de viés em um modelo.

Para mais informações, consulte:

- Imparcialidade: imparcialidade contrafactual no curso intensivo de machine learning.

- When Worlds Collide: Integrating Different Counterfactual Assumptions in Fairness (em inglês)

viés de cobertura

Consulte viés de seleção.

crash blossom

Uma frase ou expressão com um significado ambíguo. Os crash blossoms representam um problema significativo no entendimento de linguagem natural. Por exemplo, o título Burocracia atrasa arranha-céu é um crash blossom porque um modelo de NLU pode interpretar o título de forma literal ou figurativa.

crítico

Sinônimo de rede Q profunda.

entropia cruzada

Uma generalização da perda de registro para problemas de classificação multiclasse. A entropia cruzada quantifica a diferença entre duas distribuições de probabilidade. Consulte também perplexidade.

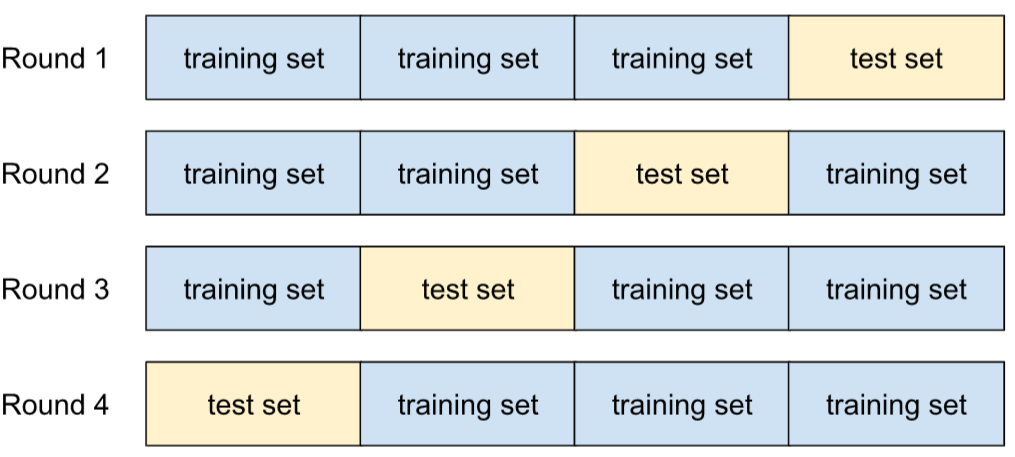

validação cruzada

Um mecanismo para estimar a capacidade de generalização de um modelo para novos dados. Para isso, o modelo é testado em um ou mais subconjuntos de dados não sobrepostos retidos do conjunto de treinamento.

função de distribuição cumulativa (CDF, na sigla em inglês)

Uma função que define a frequência de amostras menores ou iguais a um valor de destino. Por exemplo, considere uma distribuição normal de valores contínuos. Uma CDF informa que aproximadamente 50% das amostras devem ser menores ou iguais à média e que aproximadamente 84% das amostras devem ser menores ou iguais a um desvio padrão acima da média.

D

análise de dados

Entender os dados considerando amostras, medições e visualizações. A análise de dados pode ser especialmente útil quando um conjunto de dados é recebido pela primeira vez, antes da criação do primeiro modelo. Também é essencial para entender experimentos e depurar problemas com o sistema.

ampliação de dados

Aumentar artificialmente o intervalo e o número de exemplos de treinamento transformando exemplos atuais para criar mais exemplos. Por exemplo, suponha que as imagens sejam um dos seus atributos, mas seu conjunto de dados não tenha exemplos suficientes para que o modelo aprenda associações úteis. O ideal é adicionar imagens rotuladas suficientes ao conjunto de dados para que o modelo seja treinado corretamente. Se isso não for possível, a ampliação de dados poderá girar, esticar e refletir cada imagem para produzir muitas variantes da foto original, gerando dados rotulados suficientes para permitir um treinamento excelente.

DataFrame

Um tipo de dados pandas popular para representar conjuntos de dados na memória.

Um DataFrame é análogo a uma tabela ou planilha. Cada coluna de um DataFrame tem um nome (um cabeçalho), e cada linha é identificada por um número exclusivo.

Cada coluna em um DataFrame é estruturada como uma matriz 2D, exceto que cada coluna pode receber um tipo de dados próprio.

Consulte também a página de referência oficial do pandas.DataFrame.

paralelismo de dados

Uma maneira de escalonar o treinamento ou a inferência que replica um modelo inteiro em vários dispositivos e transmite um subconjunto dos dados de entrada para cada dispositivo. O paralelismo de dados permite treinamento e inferência em tamanhos de lote muito grandes. No entanto, ele exige que o modelo seja pequeno o suficiente para caber em todos os dispositivos.

O paralelismo de dados geralmente acelera o treinamento e a inferência.

Consulte também paralelismo de modelos.

API Dataset (tf.data)

Uma API TensorFlow de alto nível para ler dados e

transformá-los em um formato exigido por um algoritmo de machine learning.

Um objeto tf.data.Dataset representa uma sequência de elementos, em que

cada elemento contém um ou mais tensores. Um objeto tf.data.Iterator fornece acesso aos elementos de um Dataset.

conjunto de dados

Uma coleção de dados brutos, geralmente (mas não exclusivamente) organizada em um dos seguintes formatos:

- uma planilha

- um arquivo no formato CSV (valores separados por vírgula)

fronteira de decisão

O separador entre classes aprendido por um modelo em um problema de classificação binária ou multiclasse. Por exemplo, na imagem a seguir, que representa um problema de classificação binária, a fronteira de decisão é a fronteira entre a classe laranja e a classe azul:

floresta de decisão

Um modelo criado com várias árvores de decisão. Uma floresta de decisão faz uma previsão agregando as previsões das árvores de decisão. Os tipos mais usados de florestas de decisão incluem florestas aleatórias e árvores aprimoradas por gradiente.

Consulte a seção Florestas de decisão no curso sobre florestas de decisão para mais informações.

limiar de decisão

Sinônimo de limiar de classificação.

árvore de decisão

Um modelo de aprendizado supervisionado composto por um conjunto de condições e folhas organizadas hierarquicamente. Por exemplo, esta é uma árvore de decisão:

decodificador

Em geral, qualquer sistema de ML que converta de uma representação processada, densa ou interna para uma representação mais bruta, esparsa ou externa.

Os decodificadores costumam ser um componente de um modelo maior, em que são frequentemente pareados com um codificador.

Em tarefas de sequência para sequência, um decodificador começa com o estado interno gerado pelo codificador para prever a próxima sequência.

Consulte Transformer para ver a definição de um decodificador na arquitetura do Transformer.

Consulte Modelos de linguagem grandes no Curso intensivo de machine learning para mais informações.

modelo profundo

Uma rede neural que contém mais de uma camada oculta.

Um modelo profundo também é chamado de rede neural profunda.

Contraste com o modelo amplo.

de rede neural profunda, amplamente utilizado

Sinônimo de modelo profundo.

Rede Q profunda (DQN)

No aprendizado por Q, uma rede neural profunda prevê funções Q.

Crítico é um sinônimo de rede Q profunda.

paridade demográfica

Uma métrica de imparcialidade que é satisfeita se os resultados da classificação de um modelo não dependem de um determinado atributo sensível.

Por exemplo, se os liliputianos e os brobdingnagianos se inscreverem na Universidade de Glubbdubdrib, a paridade demográfica será alcançada se a porcentagem de liliputianos admitidos for a mesma que a de brobdingnagianos, independente de um grupo ser, em média, mais qualificado que o outro.

Contraste com odds equalizadas e igualdade de oportunidades, que permitem que os resultados da classificação agregada dependam de atributos sensíveis, mas não permitem que os resultados da classificação para determinados rótulos de informações empíricas especificados dependam de atributos sensíveis. Consulte "Como combater a discriminação com um aprendizado de máquina mais inteligente" para ver uma visualização que explora as compensações ao otimizar para a paridade demográfica.

Consulte Imparcialidade: paridade demográfica no Curso intensivo de machine learning para mais informações.

redução de ruído

Uma abordagem comum para aprendizado autossupervisionado em que:

A remoção de ruído permite o aprendizado com exemplos sem rótulo. O conjunto de dados original serve como destino ou rótulo, e os dados ruidosos como entrada.

Alguns modelos de linguagem mascarada usam a remoção de ruído da seguinte forma:

- O ruído é adicionado artificialmente a uma frase sem rótulo mascarando alguns dos tokens.

- O modelo tenta prever os tokens originais.

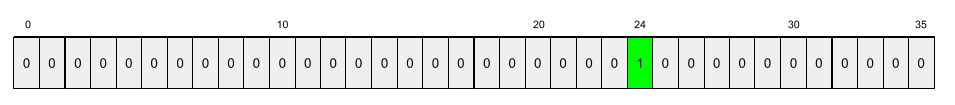

atributo denso

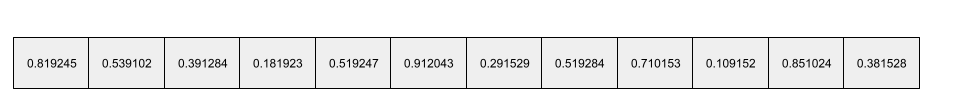

Uma característica em que a maioria ou todos os valores são diferentes de zero, geralmente um tensor de valores de ponto flutuante. Por exemplo, o tensor de 10 elementos a seguir é denso porque 9 dos valores são diferentes de zero:

| 8 | 3 | 7 | 5 | 2 | 4 | 0 | 4 | 9 | 6 |

Contraste com o atributo esparso.

camada densa

Sinônimo de camada totalmente conectada.

profundidade

A soma do seguinte em uma rede neural:

- o número de camadas ocultas

- o número de camadas de saída, que geralmente é 1

- o número de camadas de embedding

Por exemplo, uma rede neural com cinco camadas escondidas e uma de saída tem uma profundidade de 6.

A camada de entrada não influencia a profundidade.

rede neural convolucional separável por profundidade (sepCNN)

Uma arquitetura de rede neural convolucional baseada em Inception, mas em que os módulos do Inception são substituídos por convoluções separáveis em profundidade. Também conhecido como Xception.

Uma convolução separável por profundidade (também abreviada como convolução separável) transforma uma convolução 3D padrão em duas operações de convolução separadas que são mais eficientes em termos computacionais: primeiro, uma convolução separável por profundidade, com uma profundidade de 1 (n ✕ n ✕ 1) e, em seguida, uma convolução pontual, com comprimento e largura de 1 (1 ✕ 1 ✕ n).

Para saber mais, consulte Xception: Deep Learning with Depthwise Separable Convolutions (em inglês).

rótulo derivado

Sinônimo de rótulo indireto.

dispositivo

Um termo sobrecarregado com as duas definições possíveis a seguir:

- Uma categoria de hardware que pode executar uma sessão do TensorFlow, incluindo CPUs, GPUs e TPUs.

- Ao treinar um modelo de ML em chips aceleradores (GPUs ou TPUs), a parte do sistema que manipula tensores e incorporações. O dispositivo funciona com chips aceleradores. Por outro lado, o host normalmente é executado em uma CPU.

privacidade diferencial

Em machine learning, uma abordagem de anonimização para proteger dados sensíveis (por exemplo, informações pessoais de um indivíduo) incluídos no conjunto de treinamento de um modelo contra exposição. Essa abordagem garante que o modelo não aprenda nem se lembre de muita coisa sobre um indivíduo específico. Isso é feito por amostragem e adição de ruído durante o treinamento do modelo para ocultar pontos de dados individuais, reduzindo o risco de exposição de dados de treinamento sensíveis.

A privacidade diferencial também é usada fora do machine learning. Por exemplo, os cientistas de dados às vezes usam a privacidade diferencial para proteger a privacidade individual ao calcular estatísticas de uso do produto para diferentes dados demográficos.

redução de dimensão

Diminuir o número de dimensões usadas para representar um recurso específico em um vetor de recursos, geralmente convertendo para um vetor de embedding.

dimensões

Termo sobrecarregado com qualquer uma das seguintes definições:

O número de níveis de coordenadas em um Tensor. Por exemplo:

- Um escalar tem zero dimensões, por exemplo,

["Hello"]. - Um vetor tem uma dimensão, por exemplo,

[3, 5, 7, 11]. - Uma matriz tem duas dimensões, por exemplo,

[[2, 4, 18], [5, 7, 14]]. É possível especificar uma célula em um vetor unidimensional com uma coordenada, mas são necessárias duas coordenadas para especificar uma célula em uma matriz bidimensional.

- Um escalar tem zero dimensões, por exemplo,

O número de entradas em um vetor de recursos.

O número de elementos em uma camada de incorporação.

comando direto

Sinônimo de comando zero-shot.

atributo discreto

Um recurso com um conjunto finito de valores possíveis. Por exemplo, um atributo cujos valores só podem ser animal, vegetal ou mineral é um atributo discreto (ou categórico).

Contraste com atributo contínuo.

modelo discriminativo

Um modelo que prevê rótulos com base em um conjunto de um ou mais atributos. De maneira mais formal, os modelos discriminativos definem a probabilidade condicional de uma saída considerando os recursos e os pesos. Ou seja:

p(output | features, weights)

Por exemplo, um modelo que prevê se um e-mail é spam com base em recursos e pesos é um modelo discriminativo.

A grande maioria dos modelos de aprendizado supervisionado, incluindo os de classificação e regressão, são discriminativos.

Contraste com o modelo generativo.

discriminador

Um sistema que determina se exemplos são reais ou falsos.

Outra opção é o subsistema em uma rede generativa adversária que determina se os exemplos criados pelo gerador são reais ou falsos.

Consulte O discriminador no curso de GAN para mais informações.

impacto desigual

Tomar decisões sobre pessoas que afetam desproporcionalmente diferentes subgrupos da população. Isso geralmente se refere a situações em que um processo algorítmico de tomada de decisões prejudica ou beneficia alguns subgrupos mais do que outros.

Por exemplo, suponha que um algoritmo que determina a qualificação de um liliputiano para um empréstimo de uma casa em miniatura tenha mais probabilidade de classificá-lo como "não qualificado" se o endereço de correspondência contiver um determinado CEP. Se os Big-Endian Lilliputians tiverem mais probabilidade de ter endereços postais com esse CEP do que os Little-Endian Lilliputians, esse algoritmo poderá resultar em impacto desigual.

Contraste com o tratamento desigual, que se concentra nas disparidades resultantes quando as características do subgrupo são entradas explícitas em um processo algorítmico de tomada de decisões.

tratamento desigual

Considerar os atributos sensíveis dos indivíduos em um processo algorítmico de tomada de decisões para que diferentes subgrupos de pessoas sejam tratados de maneira diferente.

Por exemplo, considere um algoritmo que determina a qualificação dos liliputianos para um empréstimo de uma casa em miniatura com base nos dados fornecidos na solicitação de empréstimo. Se o algoritmo usar a afiliação de um liliputiano como Big-Endian ou Little-Endian como entrada, ele estará realizando um tratamento desigual nessa dimensão.

Em contraste com o impacto desigual, que se concentra nas disparidades nos impactos sociais das decisões algorítmicas em subgrupos, independentemente de esses subgrupos serem entradas para o modelo.

destilação

O processo de reduzir o tamanho de um modelo (conhecido como professor) em um modelo menor (conhecido como estudante) que emula as previsões do modelo original da forma mais fiel possível. A destilação é útil porque o modelo menor tem dois benefícios principais em relação ao modelo maior (o professor):

- Tempo de inferência mais rápido

- Uso reduzido de memória e energia

No entanto, as previsões dos estudantes geralmente não são tão boas quanto as dos professores.

A destilação treina o modelo estudante para minimizar uma função de perda com base na diferença entre as saídas das previsões dos modelos estudante e professor.

Compare e contraste a destilação com os seguintes termos:

Consulte LLMs: ajuste fino, destilação e engenharia de comando no Curso intensivo de machine learning para mais informações.

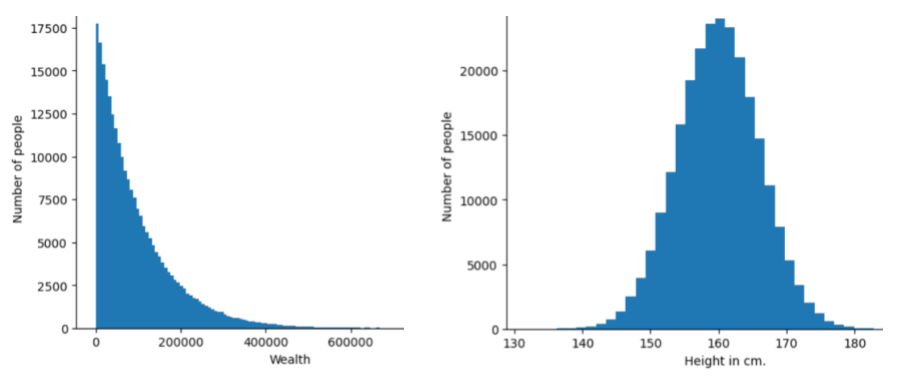

Distribuição

A frequência e o intervalo de diferentes valores para um determinado recurso ou rótulo. Uma distribuição captura a probabilidade de um valor específico.

A imagem a seguir mostra histogramas de duas distribuições diferentes:

- À esquerda, uma distribuição de lei de potência de riqueza versus o número de pessoas que possuem essa riqueza.

- À direita, uma distribuição normal de altura versus o número de pessoas com essa altura.

Entender a distribuição de cada recurso e rótulo ajuda a determinar como normalizar valores e detectar outliers.

A frase fora da distribuição se refere a um valor que não aparece no conjunto de dados ou é muito raro. Por exemplo, uma imagem do planeta Saturno seria considerada fora da distribuição para um conjunto de dados composto por imagens de gatos.

clustering divisivo

Consulte clustering hierárquico.

redução de amostragem

Termo sobrecarregado que pode significar uma das seguintes opções:

- Reduzir a quantidade de informações em um atributo para treinar um modelo com mais eficiência. Por exemplo, antes de treinar um modelo de reconhecimento de imagens, faça o downsampling de imagens de alta resolução para um formato de resolução mais baixa.

- Treinar com uma porcentagem desproporcionalmente baixa de exemplos de classe super-representada para melhorar o treinamento do modelo em classes sub-representadas. Por exemplo, em um conjunto de dados com desequilíbrio de classes, os modelos tendem a aprender muito sobre a classe majoritária e pouco sobre a classe minoritária. A subamostragem ajuda a equilibrar a quantidade de treinamento nas classes majoritária e minoritária.

Consulte Conjuntos de dados: conjuntos de dados desequilibrados no Curso intensivo de machine learning para mais informações.

DQN

Abreviação de Deep Q-Network.

regularização por dropout

Uma forma de regularização útil no treinamento de redes neurais. A regularização de dropout remove uma seleção aleatória de um número fixo de unidades em uma camada de rede para uma única etapa de gradiente. Quanto mais unidades forem descartadas, mais forte será a regularização. Isso é análogo a treinar a rede para emular um conjunto exponencialmente grande de redes menores. Para mais detalhes, consulte Dropout: uma maneira simples de evitar o overfitting de redes neurais.

dinâmico

Algo feito com frequência ou de forma contínua. Os termos dinâmico e on-line são sinônimos em machine learning. Confira a seguir usos comuns de dinâmico e on-line no aprendizado de máquina:

- Um modelo dinâmico (ou modelo on-line) é um modelo que é treinado novamente com frequência ou de forma contínua.

- O treinamento dinâmico (ou treinamento on-line) é o processo de treinamento frequente ou contínuo.

- A inferência dinâmica (ou on-line) é o processo de gerar previsões sob demanda.

modelo dinâmico

Um modelo que é treinado novamente com frequência (talvez até continuamente). Um modelo dinâmico é um "aprendiz permanente" que se adapta constantemente aos dados em evolução. Um modelo dinâmico também é conhecido como um modelo on-line.

Contraste com o modelo estático.

E

execução rápida

Um ambiente de programação do TensorFlow em que as operações são executadas imediatamente. Por outro lado, as operações chamadas na execução de gráficos não são executadas até serem avaliadas explicitamente. A execução imediata é uma interface imperativa, muito parecida com o código na maioria das linguagens de programação. Em geral, é muito mais fácil depurar programas de execução rápida do que programas de execução de gráficos.

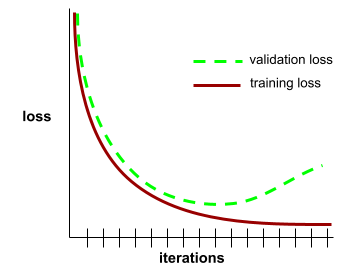

parada antecipada

Um método de regularização que envolve encerrar o treinamento antes que a perda de treinamento pare de diminuir. Na parada antecipada, você interrompe intencionalmente o treinamento do modelo quando a perda em um conjunto de dados de validação começa a aumentar, ou seja, quando o desempenho de generalização piora.

Contraste com saída antecipada.

Distância de movimentação de terra (EMD, na sigla em inglês)

Uma medida da similaridade relativa de duas distribuições. Quanto menor a distância do trabalho do operador de terra, mais semelhantes são as distribuições.

distância de edição

Uma medição de como duas strings de texto são semelhantes entre si. No aprendizado de máquina, a distância de edição é útil pelos seguintes motivos:

- É fácil calcular a distância de edição.

- A distância de edição pode comparar duas strings que são semelhantes entre si.

- A distância de edição pode determinar o grau de semelhança entre diferentes strings e uma string específica.

Existem várias definições de distância de edição, cada uma usando diferentes operações de string. Consulte Distância de Levenshtein para conferir um exemplo.

Notação Einsum

Uma notação eficiente para descrever como dois tensores devem ser combinados. Os tensores são combinados multiplicando os elementos de um tensor pelos elementos do outro e somando os produtos. A notação de Einsum usa símbolos para identificar os eixos de cada tensor, e esses mesmos símbolos são reorganizados para especificar a forma do novo tensor resultante.

O NumPy oferece uma implementação comum do Einsum.

camada de embedding