В этом глоссарии даны определения терминов, связанных с искусственным интеллектом.

А

абляция

Метод оценки важности признака или компонента путем его временного удаления из модели . Затем модель переобучается без этого признака или компонента, и если переобученная модель показывает значительно худшие результаты, то удаленный признак или компонент, вероятно, был важен.

Например, предположим, вы обучили модель классификации на 10 признаках и достигли точности 88% на тестовом наборе . Чтобы проверить важность первого признака, вы можете переобучить модель, используя только девять других признаков. Если переобученная модель показывает значительно худшие результаты (например, точность 55%), то, вероятно, удаленный признак был важен. И наоборот, если переобученная модель показывает такие же хорошие результаты, то, вероятно, этот признак был не так уж важен.

Абляция также может помочь определить значимость следующих факторов:

- Более крупные компоненты, такие как целая подсистема более крупной системы машинного обучения.

- Процессы или методы, например, этап предварительной обработки данных.

В обоих случаях вы сможете наблюдать, как изменяется (или не изменяется) производительность системы после удаления компонента.

A/B-тестирование

Статистический способ сравнения двух (или более) методов — A и B. Как правило, A — это уже существующий метод, а B — новый. A/B-тестирование позволяет не только определить, какой метод работает лучше, но и выяснить, является ли разница статистически значимой.

A/B-тестирование обычно сравнивает один показатель по двум методам; например, как точность модели соотносится с точностью двух методов? Однако A/B-тестирование может также сравнивать любое конечное число показателей.

чип-ускоритель

Категория специализированных аппаратных компонентов, предназначенных для выполнения ключевых вычислений, необходимых для алгоритмов глубокого обучения.

Ускорительные чипы (или просто ускорители ) могут значительно повысить скорость и эффективность задач обучения и вывода по сравнению с центральным процессором общего назначения. Они идеально подходят для обучения нейронных сетей и аналогичных ресурсоемких вычислительных задач.

Примерами микросхем-ускорителей являются:

- Тензорные процессоры Google ( TPU ) со специализированным оборудованием для глубокого обучения.

- Графические процессоры NVIDIA, хотя и были изначально разработаны для обработки графики, позволяют использовать параллельную обработку, что может значительно повысить скорость обработки.

точность

Количество правильных классификационных прогнозов, деленное на общее количество прогнозов. То есть:

Например, модель, сделавшая 40 правильных и 10 неправильных прогнозов, будет иметь точность:

Бинарная классификация предоставляет конкретные названия для различных категорий правильных и неправильных прогнозов . Таким образом, формула точности для бинарной классификации выглядит следующим образом:

где:

- TP — это количество истинно положительных результатов (правильных прогнозов).

- TN — это количество истинно отрицательных результатов (правильных предсказаний).

- FP — это количество ложноположительных результатов (неверных прогнозов).

- FN — это количество ложноотрицательных результатов (неверных прогнозов).

Сравните и сопоставьте точность с прецизией и полнотой .

Дополнительную информацию см. в разделе «Классификация: точность, полнота, прецизионность и связанные с ними показатели» в кратком курсе по машинному обучению.

действие

В обучении с подкреплением механизм, посредством которого агент переходит между состояниями окружающей среды , заключается в выборе действия с использованием стратегии .

функция активации

Функция, позволяющая нейронным сетям изучать нелинейные (сложные) взаимосвязи между признаками и меткой.

К популярным функциям активации относятся:

Графики функций активации никогда не представляют собой одну прямую линию. Например, график функции активации ReLU состоит из двух прямых линий:

График сигмоидной функции активации выглядит следующим образом:

Дополнительную информацию можно найти в разделе «Нейронные сети: функции активации» в кратком курсе по машинному обучению.

активное обучение

Активное обучение — это подход к обучению , при котором алгоритм выбирает часть данных, на которых он обучается. Оно особенно ценно, когда размеченные примеры редки или их получение обходится дорого. Вместо того чтобы слепо искать разнообразный набор размеченных примеров, алгоритм активного обучения избирательно ищет именно тот набор примеров, который ему необходим для обучения.

АдаГрад

Сложный алгоритм градиентного спуска, который масштабирует градиенты каждого параметра , фактически задавая каждому параметру независимую скорость обучения . Подробное объяснение см. в разделе «Адаптивные субградиентные методы для онлайн-обучения и стохастической оптимизации» .

приспособление

Синоним к слову «настройка» или «тонкая настройка» .

агент

Программное обеспечение, способное анализировать многомодальные пользовательские данные для планирования и выполнения действий от имени пользователя.

В обучении с подкреплением агент — это сущность, которая использует стратегию для максимизации ожидаемой отдачи от перехода между состояниями окружающей среды .

агентный

Прилагательная форма слова «агент» . «Агентный» относится к качествам, которыми обладают агенты (например, автономия).

агентский рабочий процесс

Динамический процесс, в котором агент автономно планирует и выполняет действия для достижения цели. Этот процесс может включать рассуждения, использование внешних инструментов и самокоррекцию плана.

агломеративная кластеризация

См. иерархическую кластеризацию .

AI slop

Результат работы генеративной системы искусственного интеллекта , которая отдает предпочтение количеству, а не качеству. Например, веб-страница, созданная с помощью ИИ, заполнена дешевым, сгенерированным ИИ, низкокачественным контентом.

обнаружение аномалий

Процесс выявления выбросов . Например, если среднее значение для определенного параметра равно 100 со стандартным отклонением 10, то система обнаружения аномалий должна пометить значение 200 как подозрительное.

АР

Сокращение от «дополненная реальность» .

площадь под кривой PR

См. PR AUC (площадь под кривой PR) .

площадь под кривой ROC

См. AUC (площадь под ROC-кривой) .

искусственный общий интеллект

Нечеловеческий механизм, демонстрирующий широкий спектр способностей к решению проблем, креативность и адаптивность. Например, программа, демонстрирующая искусственный общий интеллект, могла бы переводить текст, сочинять симфонии и преуспевать в играх, которые еще не изобретены.

искусственный интеллект

Нечеловеческая программа или модель , способная решать сложные задачи. Например, программа или модель, переводящая текст, или программа или модель, определяющая заболевания по рентгеновским снимкам, — обе демонстрируют искусственный интеллект.

Формально машинное обучение является подразделом искусственного интеллекта. Однако в последние годы некоторые организации стали использовать термины «искусственный интеллект» и «машинное обучение» как взаимозаменяемые.

внимание

Механизм внимания, используемый в нейронной сети , который указывает на важность конкретного слова или части слова. Внимание сжимает объем информации, необходимой модели для прогнозирования следующего токена/слова. Типичный механизм внимания может представлять собой взвешенную сумму по набору входных данных, где вес для каждого входного значения вычисляется другой частью нейронной сети.

Обратите также внимание на самовнимание и многоголовочное самовнимание , которые являются строительными блоками трансформеров .

Дополнительную информацию о механизме самовнимания см. в статье «LLMs: What's a large language model?» в сборнике «Machine Learning Crash Course».

атрибут

Синоним к слову "функция" .

В контексте машинного обучения под атрибутами часто подразумеваются характеристики, относящиеся к отдельным лицам.

выборка атрибутов

Тактика обучения дерева решений, при которой каждое дерево решений рассматривает только случайное подмножество возможных признаков при изучении условия . Как правило, для каждого узла выбирается разное подмножество признаков. В отличие от этого, при обучении дерева решений без выборки атрибутов для каждого узла рассматриваются все возможные признаки.

AUC (Площадь под ROC-кривой)

Число от 0,0 до 1,0, представляющее способность модели бинарной классификации разделять положительные и отрицательные классы . Чем ближе AUC к 1,0, тем лучше модель способна разделять классы.

Например, на следующем рисунке показана модель классификации , которая идеально разделяет положительные классы (зеленые овалы) от отрицательных классов (фиолетовые прямоугольники). Эта нереалистично идеальная модель имеет показатель AUC, равный 1,0:

Напротив, на следующем рисунке показаны результаты для модели классификации , которая генерировала случайные результаты. Для этой модели показатель AUC равен 0,5:

Да, у предыдущей модели показатель AUC равен 0,5, а не 0,0.

Большинство моделей находятся где-то между этими двумя крайностями. Например, следующая модель несколько разделяет положительные и отрицательные значения, и поэтому имеет AUC где-то между 0,5 и 1,0:

AUC игнорирует любые значения, которые вы задаете для порога классификации . Вместо этого AUC учитывает все возможные пороги классификации.

Дополнительную информацию см. в разделе «Классификация: ROC и AUC в экспресс-курсе по машинному обучению».

дополненная реальность

Технология, которая накладывает сгенерированное компьютером изображение на реальное изображение, видимое пользователем, создавая таким образом составное изображение.

автокодировщик

Система, которая учится извлекать наиболее важную информацию из входных данных. Автокодировщики представляют собой комбинацию кодировщика и декодера . Автокодировщики используют следующий двухэтапный процесс:

- Кодировщик преобразует входные данные в (как правило) формат с потерями, имеющий промежуточную размерность.

- Декодер создает версию исходного входного сигнала с потерями, отображая формат меньшей размерности на исходный формат входного сигнала большей размерности.

Автокодировщики обучаются сквозным методом, при котором декодер пытается максимально точно восстановить исходный входной сигнал из промежуточного формата кодировщика. Поскольку промежуточный формат меньше (менее размерен), чем исходный формат, автокодировщик вынужден изучать, какая информация во входных данных является существенной, и выходные данные не будут идеально идентичны входным.

Например:

- Если входные данные представляют собой графическое изображение, то неточная копия будет похожа на исходное изображение, но несколько изменена. Возможно, неточная копия удаляет шум из исходного изображения или заполняет некоторые недостающие пиксели.

- Если входные данные представляют собой текст, автокодировщик сгенерирует новый текст, который будет имитировать (но не идентичен) исходному тексту.

См. также вариационные автокодировщики .

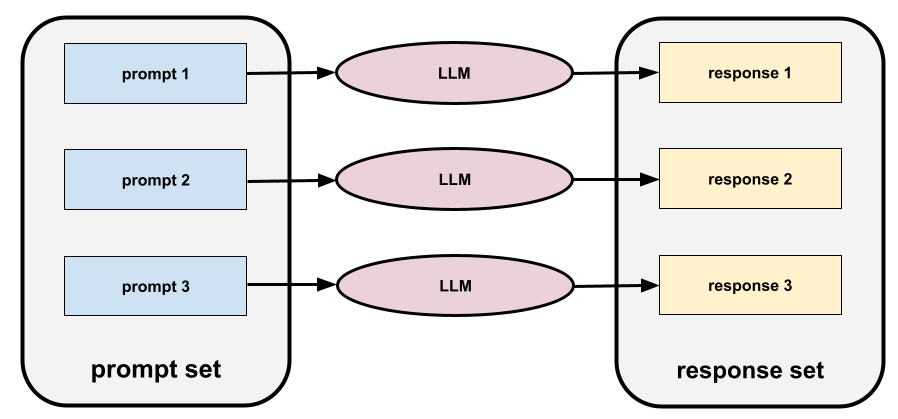

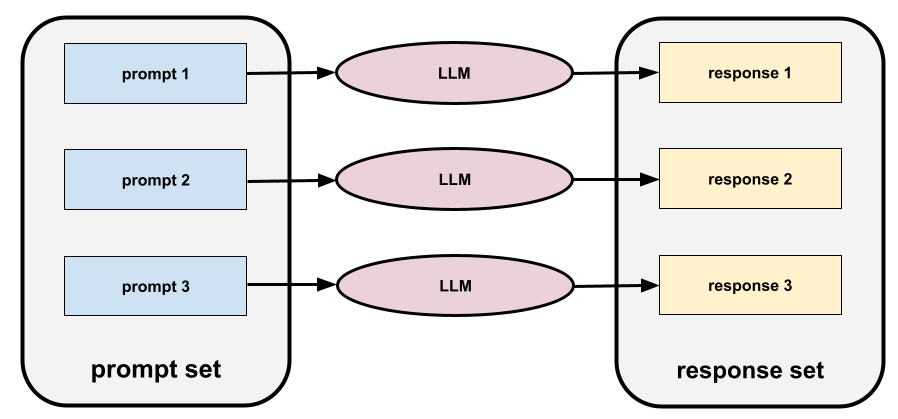

автоматическая оценка

Использование программного обеспечения для оценки качества результатов работы модели.

Когда выходные данные модели относительно просты, скрипт или программа могут сравнить выходные данные модели с эталонным ответом . Этот тип автоматической оценки иногда называют программной оценкой . Для программной оценки часто полезны такие метрики, как ROUGE или BLEU .

Когда результаты работы модели сложны или не имеют единственно правильного ответа , иногда автоматическую оценку выполняет отдельная программа машинного обучения, называемая авторизатором .

Сравните с человеческой оценкой .

предвзятость автоматизации

Когда человек, принимающий решения, отдает предпочтение рекомендациям автоматизированной системы принятия решений перед информацией, полученной без автоматизации, даже если автоматизированная система принятия решений допускает ошибки.

Дополнительную информацию см. в разделе «Справедливость: виды предвзятости в экспресс-курсе по машинному обучению».

AutoML

Любой автоматизированный процесс построения моделей машинного обучения . AutoML может автоматически выполнять такие задачи, как:

- Найдите наиболее подходящую модель.

- Настройте гиперпараметры .

- Подготовка данных (включая выполнение инженерии признаков ).

- Разверните полученную модель.

AutoML полезен для специалистов по обработке данных, поскольку позволяет сэкономить время и усилия при разработке конвейеров машинного обучения и повысить точность прогнозирования. Он также полезен для неспециалистов, делая сложные задачи машинного обучения более доступными для них.

Дополнительную информацию см. в разделе «Автоматизированное машинное обучение (AutoML)» в «Кратком курсе по машинному обучению».

авторская оценка

Гибридный механизм оценки качества результатов работы генеративной модели ИИ , сочетающий в себе оценку человеком и автоматическую оценку . Авторефер — это модель машинного обучения, обученная на данных, созданных в результате оценки человеком . В идеале авторефер учится имитировать действия человека-оценщика.В продаже имеются готовые автоматизированные системы оценки, но лучшие из них специально оптимизированы для решения конкретной задачи.

авторегрессионная модель

Модель , которая делает вывод на основе собственных предыдущих прогнозов. Например, авторегрессивные языковые модели прогнозируют следующий токен на основе ранее предсказанных токенов. Все большие языковые модели на основе Transformer являются авторегрессивными.

В отличие от них, модели обработки изображений на основе GAN обычно не являются авторегрессивными, поскольку они генерируют изображение за один прямой проход, а не итеративно пошагово. Однако некоторые модели генерации изображений являются авторегрессивными, поскольку они генерируют изображение пошагово.

вспомогательные потери

Функция потерь — используемая совместно с основной функцией потерь модели нейронной сети — помогает ускорить обучение на ранних итерациях, когда веса инициализируются случайным образом.

Вспомогательные функции потерь переносят эффективные градиенты на более ранние слои . Это способствует сходимости во время обучения , борясь с проблемой затухания градиента .

средняя точность при k

Метрика, суммирующая производительность модели при обработке одного запроса, генерирующего ранжированные результаты, например, нумерованный список рекомендаций книг. Средняя точность в точке k — это, собственно, среднее значение точности в точке k для каждого релевантного результата. Формула для расчета средней точности в точке k выглядит следующим образом:

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

где:

- \(n\) — это количество релевантных элементов в списке.

Сравните с результатами воспроизведения на этапе k .

условие выравнивания по осям

В дереве решений условие , включающее только один признак . Например, если признаком является area , то следующее условие соответствует оси распределения:

area > 200

Сравните с косым расположением .

Б

обратное распространение

Алгоритм, реализующий градиентный спуск в нейронных сетях .

Обучение нейронной сети включает в себя множество итераций следующего двухэтапного цикла:

- В процессе прямого прохода система обрабатывает пакет примеров для получения прогнозов. Система сравнивает каждый прогноз с каждым значением метки . Разница между прогнозом и значением метки представляет собой ошибку для данного примера. Система суммирует ошибки для всех примеров, чтобы вычислить общую ошибку для текущего пакета.

- В процессе обратного распространения ошибки система уменьшает потери, корректируя веса всех нейронов во всех скрытых слоях .

Нейронные сети часто содержат множество нейронов в различных скрытых слоях. Каждый из этих нейронов вносит свой вклад в общую функцию потерь. Обратное распространение ошибки определяет, следует ли увеличивать или уменьшать веса, применяемые к конкретным нейронам.

Скорость обучения — это множитель, который регулирует степень увеличения или уменьшения каждого веса при каждом обратном проходе. Высокая скорость обучения будет увеличивать или уменьшать каждый вес сильнее, чем низкая скорость обучения.

В терминах математического анализа, обратное распространение ошибки реализует правило цепочки из математического анализа. То есть, обратное распространение ошибки вычисляет частную производную ошибки по каждому параметру.

Несколько лет назад специалистам по машинному обучению приходилось писать код для реализации обратного распространения ошибки. Современные API для машинного обучения, такие как Keras, теперь реализуют обратное распространение ошибки автоматически. Уф!

Для получения более подробной информации см. раздел «Нейронные сети в кратком курсе по машинному обучению».

упаковка

Метод обучения ансамбля , в котором каждая составляющая модель обучается на случайном подмножестве обучающих примеров, выбранных с замещением . Например, случайный лес — это набор деревьев решений, обученных с помощью метода бэггинга.

Термин bagging является сокращением от bootstrap aggregate .

Дополнительную информацию см. в разделе «Случайные леса» курса «Лесорешения».

мешок слов

Представление слов во фразе или отрывке текста независимо от порядка их следования. Например, «мешок слов» идентично представляет следующие три фразы:

- собака прыгает

- прыгает на собаку

- собака перепрыгивает

Каждое слово сопоставляется с индексом в разреженном векторе , где вектор содержит индекс для каждого слова в словаре. Например, фраза «собака прыгает» сопоставляется с вектором признаков, имеющим ненулевые значения в трех индексах, соответствующих словам «собака» , «собака» и «прыгает» . Ненулевое значение может быть любым из следующих:

- Цифра 1 обозначает наличие слова.

- Подсчет количества вхождений слова в набор. Например, если фраза "were the maroon dog is a dog with maroon fur" (бордовая собака — собака с бордовой шерстью) , то слова "maroon" и "dog" будут представлены как 2, а остальные слова — как 1.

- Какое-либо другое значение, например, логарифм количества появлений слова в мешке.

исходный уровень

Модель, используемая в качестве эталона для сравнения эффективности другой модели (как правило, более сложной). Например, модель логистической регрессии может служить хорошей базовой моделью для глубокой модели .

Для решения конкретной задачи базовый уровень помогает разработчикам моделей количественно оценить минимальную ожидаемую производительность, которую должна достичь новая модель, чтобы быть полезной.

базовая модель

Предварительно обученная модель , которая может служить отправной точкой для тонкой настройки с целью решения конкретных задач или приложений.

См. также предварительно обученную модель и базовую модель .

партия

Набор примеров, используемых в одной итерации обучения. Размер пакета определяет количество примеров в пакете.

См. раздел «Эпоха» для объяснения того, как пакет данных соотносится с эпохой.

Дополнительную информацию см. в статье «Линейная регрессия: гиперпараметры в машинном обучении» (краткий курс).

пакетный вывод

Процесс вывода прогнозов на основе множества немаркированных примеров, разделенных на более мелкие подмножества («пакеты»).

Пакетный вывод может использовать преимущества возможностей распараллеливания, предоставляемых чипами ускорителей . То есть, несколько ускорителей могут одновременно делать прогнозы на разных пакетах немаркированных примеров, что значительно увеличивает количество выводов в секунду.

Дополнительную информацию можно найти в разделе «Системы машинного обучения в производственной среде: статический и динамический вывод» в «Кратком курсе по машинному обучению».

пакетная нормализация

Нормализация входных или выходных данных функций активации в скрытом слое . Пакетная нормализация может обеспечить следующие преимущества:

- Повысьте стабильность нейронных сетей , защитив их от выбросов в весовых коэффициентах.

- Необходимо обеспечить более высокую скорость обучения , что может ускорить тренировку.

- Уменьшите переобучение .

размер партии

Количество примеров в пакете . Например, если размер пакета равен 100, то модель обрабатывает 100 примеров за итерацию .

Ниже представлены популярные стратегии определения размера партии:

- Стохастический градиентный спуск (SGD) , в котором размер пакета равен 1.

- Полный пакет (Full batch) — это стратегия, в которой размер пакета равен количеству примеров во всем обучающем наборе данных . Например, если обучающий набор содержит миллион примеров, то размер пакета будет равен миллиону примеров. Стратегия полного пакета обычно неэффективна.

- Мини-партии, размер партии которых обычно составляет от 10 до 1000 единиц. Мини-партии, как правило, являются наиболее эффективной стратегией.

Дополнительную информацию см. ниже:

- Системы машинного обучения для производственных целей: статический и динамический вывод в кратком курсе по машинному обучению.

- Руководство по настройке глубокого обучения .

Байесовская нейронная сеть

Вероятностная нейронная сеть , учитывающая неопределенность весов и выходных данных. Стандартная модель регрессии на основе нейронной сети обычно предсказывает скалярное значение; например, стандартная модель предсказывает цену дома в 853 000. В отличие от этого, байесовская нейронная сеть предсказывает распределение значений; например, байесовская модель предсказывает цену дома в 853 000 со стандартным отклонением 67 200.

Байесовская нейронная сеть использует теорему Байеса для вычисления неопределенностей в весах и прогнозах. Байесовская нейронная сеть может быть полезна, когда важно количественно оценить неопределенность, например, в моделях, связанных с фармацевтикой. Байесовские нейронные сети также могут помочь предотвратить переобучение .

Байесовская оптимизация

Метод вероятностной регрессионной модели для оптимизации ресурсоемких целевых функций путем оптимизации аппроксимирующей функции, которая количественно оценивает неопределенность с помощью байесовского обучения. Поскольку байесовская оптимизация сама по себе очень затратна, она обычно используется для оптимизации сложных задач с небольшим количеством параметров, таких как выбор гиперпараметров .

Уравнение Беллмана

В обучении с подкреплением оптимальной Q-функции удовлетворяет следующее тождество:

\[Q(s, a) = r(s, a) + \gamma \mathbb{E}_{s'|s,a} \max_{a'} Q(s', a')\]

Алгоритмы обучения с подкреплением применяют это тождество для создания Q-обучения , используя следующее правило обновления:

\[Q(s,a) \gets Q(s,a) + \alpha \left[r(s,a) + \gamma \displaystyle\max_{\substack{a_1}} Q(s',a') - Q(s,a) \right] \]

Помимо обучения с подкреплением, уравнение Беллмана находит применение в динамическом программировании. См. статью в Википедии об уравнении Беллмана .

BERT (Bidirectional Encoder Representations from Transformers)

Архитектура модели для представления текста. Обученная модель BERT может выступать в качестве части более крупной модели для классификации текста или других задач машинного обучения.

BERT обладает следующими характеристиками:

- Использует архитектуру Transformer и, следовательно, полагается на механизм самовнимания .

- Использует кодировщик, являющийся частью трансформера. Задача кодировщика — создавать качественные текстовые представления, а не выполнять какую-либо конкретную задачу, например, классификацию.

- Является двунаправленным .

- Использует маскирование для обучения без учителя .

Варианты BERT включают в себя:

Для получения общего обзора BERT см. статью «Открытый исходный код BERT: передовое предварительное обучение для обработки естественного языка» .

предвзятость (этика/справедливость)

1. Стереотипизация, предвзятость или фаворитизм по отношению к одним вещам, людям или группам по сравнению с другими. Эти предубеждения могут влиять на сбор и интерпретацию данных, проектирование системы и взаимодействие пользователей с ней. К таким формам предвзятости относятся:

- предвзятость автоматизации

- предвзятость подтверждения

- Предвзятость экспериментатора

- предвзятость групповой атрибуции

- неявная предвзятость

- предвзятость внутри группы

- смещение однородности внешней группы

2. Систематическая ошибка, возникающая в результате процедуры выборки или составления отчета. К таким формам смещения относятся:

- смещение охвата

- смещение, вызванное отсутствием ответа

- предвзятость участия

- предвзятость в репортажах

- смещение выборки

- предвзятость отбора

Не следует путать с термином «смещение» в моделях машинного обучения или смещением прогнозирования .

Дополнительную информацию см. в разделе «Справедливость: виды предвзятости в экспресс-курсе по машинному обучению».

смещение (математика) или термин, обозначающий смещение

Пересечение или смещение относительно начала координат. Смещение — это параметр в моделях машинного обучения, который обозначается одним из следующих символов:

- б

- w 0

Например, смещение обозначается буквой b в следующей формуле:

В простой двумерной прямой смещение просто означает «пересечение с осью Y». Например, смещение прямой на следующем рисунке равно 2.

Смещение существует потому, что не все модели начинаются с начала координат (0,0). Например, предположим, что вход в парк развлечений стоит 2 евро, и дополнительно 0,5 евро за каждый час пребывания посетителя. Следовательно, модель, отображающая общую стоимость, имеет смещение, равное 2, поскольку минимальная стоимость составляет 2 евро.

Предвзятость не следует путать с предвзятостью в этике и справедливости или с предвзятостью прогнозирования .

Для получения более подробной информации см. краткий курс по линейной регрессии в машинном обучении.

двунаправленный

Термин, используемый для описания системы, которая оценивает текст, предшествующий и следующий за целевым разделом текста. В отличие от этого, однонаправленная система оценивает только текст, предшествующий целевому разделу текста.

Например, рассмотрим модель скрытого языка , которая должна определить вероятности для слова или слов, представляющих подчеркивание в следующем вопросе:

Что с тобой не так?

Однонаправленная языковая модель должна основывать свои вероятности только на контексте, предоставляемом словами «Что», «есть» и «это». В отличие от этого, двунаправленная языковая модель может также получать контекст из слов «с» и «ты», что может помочь модели генерировать более точные прогнозы.

двунаправленная языковая модель

Языковая модель , определяющая вероятность присутствия данного токена в данном месте в отрывке текста на основе предшествующего и последующего текста.

биграмма

N-грамма, в которой N=2.

бинарная классификация

Тип задачи классификации , в которой предсказывается один из двух взаимоисключающих классов:

Например, следующие две модели машинного обучения выполняют бинарную классификацию:

- Модель, определяющая, являются ли электронные письма спамом (положительный класс) или не спамом (отрицательный класс).

- Модель, которая оценивает медицинские симптомы, чтобы определить, есть ли у человека определенное заболевание (положительный класс) или нет (отрицательный класс).

В отличие от многоклассовой классификации .

См. также логистическую регрессию и порог классификации .

Дополнительную информацию см. в разделе «Краткий курс по классификации в машинном обучении».

бинарное условие

В дереве решений условие , имеющее только два возможных исхода, обычно «да» или «нет» . Например, следующее условие является бинарным:

temperature >= 100

Сравните с небинарным условием .

Дополнительную информацию см. в разделе «Типы условий» курса «Лесные модели принятия решений».

сортировка

Синоним слова «ведро» .

модель черного ящика

Модель , «рассуждения» которой невозможны или сложны для понимания человеком. То есть, хотя человек может видеть, как подсказки влияют на ответы , он не может точно определить, как модель «черного ящика» определяет ответ. Другими словами, модель «черного ящика» лишена интерпретируемости .

Большинство глубоких моделей и больших языковых моделей представляют собой «чёрные ящики».

BLEU (Двуязычный стажер по оценке)

Показатель от 0,0 до 1,0 для оценки машинного перевода , например, с испанского на японский.

Для расчета показателя BLEU обычно сравнивает перевод, выполненный моделью машинного обучения ( сгенерированный текст ), с переводом, выполненным экспертом ( эталонный текст ). Степень совпадения N-грамм в сгенерированном и эталонном тексте определяет показатель BLEU.

Оригинальная статья, посвященная этой метрике, называется BLEU: a Method for Automatic Evaluation of Machine Translation .

См. также BLEURT .

БЛЁРТ (студент-оценщик двуязычных курсов из компании Transformers)

Показатель для оценки машинного перевода с одного языка на другой, в частности, с английского на английский и с английского на английский.

При переводе с английского и на английский язык BLEURT больше соответствует оценкам людей, чем BLEU . В отличие от BLEU, BLEURT делает акцент на семантическом (смысловом) сходстве и допускает перефразирование.

BLEURT использует предварительно обученную большую языковую модель (точнее, BERT ), которая затем дорабатывается на текстах, предоставленных переводчиками-людьми.

Оригинальная статья, посвященная этой метрике, называется BLEURT: Learning Robust Metrics for Text Generation .

Логические вопросы (BoolQ)

Набор данных для оценки умения студентов магистратуры отвечать на вопросы с вариантами ответа «да» или «нет». Каждое из заданий в наборе данных состоит из трех компонентов:

- Запрос

- Отрывок, подразумевающий ответ на вопрос.

- Правильный ответ — да или нет .

Например:

- Вопрос : Есть ли в Мичигане атомные электростанции?

- Текст : ...три атомные электростанции обеспечивают штат Мичиган примерно 30% его электроэнергии.

- Правильный ответ : Да

Исследователи собрали вопросы из анонимизированных, агрегированных поисковых запросов Google, а затем использовали страницы Википедии для подтверждения полученной информации.

Для получения дополнительной информации см. BoolQ: Изучение удивительной сложности естественных вопросов типа «да/нет» .

BoolQ является компонентом ансамбля SuperGLUE .

BoolQ

Сокращение для логических вопросов .

повышение

Метод машинного обучения, который итеративно объединяет набор простых и не очень точных моделей классификации (называемых «слабыми классификаторами») в модель классификации с высокой точностью («сильный классификатор») путем повышения веса примеров, которые модель в данный момент классифицирует неправильно.

Дополнительную информацию см. в разделе «Градиентный бустинг деревьев решений?» в курсе «Леса решений».

ограничивающая рамка

На изображении координаты ( x , y ) прямоугольника, окружающего интересующую область, например, собаку на изображении ниже.

вещание

Расширение формы операнда в матричной математической операции до размеров, совместимых с этой операцией. Например, в линейной алгебре требуется, чтобы два операнда в операции сложения матриц имели одинаковые размеры. Следовательно, нельзя сложить матрицу формы (m, n) с вектором длины n. Широковещательная передача позволяет выполнить эту операцию, виртуально расширяя вектор длины n до матрицы формы (m, n) путем дублирования одних и тех же значений в каждом столбце.

Более подробное описание функции широковещательной рассылки в NumPy см. в следующем разделе.

ведро

Преобразование одного признака в несколько бинарных признаков, называемых интервалами или ячейками , обычно на основе диапазона значений. Обрезанный признак, как правило, является непрерывным признаком .

Например, вместо представления температуры в виде единого непрерывного значения с плавающей запятой, можно разделить диапазоны температур на дискретные интервалы, такие как:

- Температура <= 10 градусов Цельсия будет считаться "холодной".

- Температура от 11 до 24 градусов Цельсия соответствует "умеренному" климату.

- Температура выше или равная 25 градусам Цельсия будет считаться "теплой" температурой.

Модель будет обрабатывать каждое значение в одной и той же категории одинаково. Например, значения 13 и 22 находятся в категории умеренного климата, поэтому модель обрабатывает эти два значения одинаково.

Дополнительную информацию см. в разделе «Числовые данные: биннинг в машинном обучении» (краткий курс).

С

калибровочный слой

Постпрогнозная корректировка, как правило, для учета систематической ошибки прогнозирования . Скорректированные прогнозы и вероятности должны соответствовать распределению наблюдаемого набора меток.

генерация кандидатов

Первоначальный набор рекомендаций, выбранных рекомендательной системой . Например, рассмотрим книжный магазин, предлагающий 100 000 наименований. На этапе генерации кандидатов создается гораздо меньший список подходящих книг для конкретного пользователя, скажем, 500. Но даже 500 книг — это слишком много, чтобы рекомендовать их пользователю. Последующие, более дорогостоящие этапы рекомендательной системы (такие как оценка и переранжирование ) сокращают эти 500 до гораздо меньшего, более полезного набора рекомендаций.

Дополнительную информацию см. в разделе «Обзор генерации кандидатов» курса «Рекомендательные системы».

выборка кандидатов

Оптимизация времени обучения, которая вычисляет вероятность для всех положительных меток, используя, например, функцию softmax , но только для случайной выборки отрицательных меток. Например, для примера с метками «бигль» и «собака» метод выборки кандидатов вычисляет прогнозируемые вероятности и соответствующие члены функции потерь для:

- бигль

- собака

- случайное подмножество оставшихся отрицательных классов (например, кошка , леденец , забор ).

Идея заключается в том, что отрицательные классы могут учиться на менее частом отрицательном подкреплении, если положительные классы всегда получают надлежащее положительное подкрепление, и это действительно наблюдается эмпирически.

Метод выборочного отбора кандидатов более эффективен с точки зрения вычислительных ресурсов, чем алгоритмы обучения, которые вычисляют прогнозы для всех отрицательных классов, особенно когда количество отрицательных классов очень велико.

категориальные данные

Признаки, имеющие определенный набор возможных значений. Например, рассмотрим категориальный признак с именем traffic-light-state , который может принимать только одно из следующих трех возможных значений:

-

red -

yellow -

green

Представляя traffic-light-state как категориальный признак, модель может изучить различное влияние red , green и yellow на поведение водителя.

Категориальные признаки иногда называют дискретными признаками .

Сравните с числовыми данными .

Дополнительную информацию см. в разделе «Работа с категориальными данными» в кратком курсе по машинному обучению.

причинно-следственная языковая модель

Синоним для однонаправленной языковой модели .

См. двунаправленную языковую модель , чтобы сравнить различные направленные подходы в языковом моделировании.

КБ

Сокращенное название CommitmentBank .

центроид

Центр кластера определяется алгоритмом k-средних или k-медиан . Например, если k равно 3, то алгоритм k-средних или k-медиан находит 3 центроида.

Дополнительную информацию см. в разделе «Алгоритмы кластеризации» в курсе «Кластеризация».

кластеризация на основе центроидов

Категория алгоритмов кластеризации , которая организует данные в неиерархические кластеры. k-средних — наиболее широко используемый алгоритм кластеризации на основе центроидов.

Сравните с алгоритмами иерархической кластеризации .

Дополнительную информацию см. в разделе «Алгоритмы кластеризации» в курсе «Кластеризация».

цепочка мыслей подсказка

Метод разработки подсказок , который побуждает большую языковую модель (БЯМ) пошагово объяснять свои рассуждения. Например, рассмотрим следующую подсказку, обратив особое внимание на второе предложение:

Какую перегрузку (g) будет испытывать водитель в автомобиле, разгоняющемся от 0 до 60 миль в час за 7 секунд? В ответе покажите все необходимые расчеты.

Ответ магистра права, скорее всего, будет следующим:

- Представьте последовательность физических формул, подставив значения 0, 60 и 7 в соответствующие места.

- Объясните, почему были выбраны именно эти формулы и что означают различные переменные.

Метод подсказок, основанный на логической цепочке рассуждений, заставляет логическую модель выполнять все вычисления, что может привести к более правильному ответу. Кроме того, этот метод позволяет пользователю изучить шаги логической модели, чтобы определить, имеет ли ответ смысл.

F-мера N-граммы символа (ChrF)

Метрика для оценки моделей машинного перевода . Показатель F-меры для N-грамм символов определяет степень перекрытия N-грамм в эталонном тексте с N-граммами в тексте, сгенерированном моделью машинного перевода.

Показатель F-меры для N-грамм символов аналогичен метрикам семейств ROUGE и BLEU , за исключением того, что:

- Показатель F-score для символьных N-грамм применяется к символьным N-граммам.

- ROUGE и BLEU работают с N-граммами или токенами слов .

чат

Содержимое диалога с системой машинного обучения, как правило, с большой языковой моделью . Предыдущее взаимодействие в чате (то, что вы напечатали, и ответ большой языковой модели) становится контекстом для последующих частей чата.

Чат-бот — это приложение, использующее большую языковую модель.

контрольно-пропускной пункт

Данные, отражающие состояние параметров модели как во время обучения, так и после его завершения. Например, во время обучения можно:

- Прекратить тренировки, возможно, намеренно или, возможно, в результате допущенных ошибок.

- Захватите контрольно-пропускной пункт.

- Позже можно будет перезагрузить контрольную точку, возможно, на другом оборудовании.

- Перезапустить обучение.

Выбор правдоподобных альтернатив (COPA)

Набор данных для оценки того, насколько хорошо LLM может определить лучший из двух альтернативных ответов на предпосылку. Каждое из заданий в наборе данных состоит из трех компонентов:

- Предпосылка, которая обычно представляет собой утверждение, за которым следует вопрос.

- На поставленный в предпосылке вопрос можно ответить двумя способами, один из которых верен, а другой неверен.

- Правильный ответ

Например:

- Исходное предположение: Мужчина сломал палец на ноге. В чём причина этого?

- Возможные ответы:

- У него в носке образовалась дырка.

- Он уронил молоток себе на ногу.

- Правильный ответ: 2

COPA является компонентом ансамбля SuperGLUE .

сорт

Категория, к которой может относиться метка . Например:

- В модели бинарной классификации , предназначенной для обнаружения спама, два класса могут быть спамом , а два — не спамом .

- В многоклассовой модели классификации , определяющей породы собак, классами могут быть пудель , бигль , мопс и так далее.

Классификационная модель предсказывает класс. В отличие от неё, регрессионная модель предсказывает число, а не класс.

Дополнительную информацию см. в разделе «Краткий курс по классификации в машинном обучении».

сбалансированный по классам набор данных

Набор данных, содержащий категориальные метки , в котором количество экземпляров каждой категории приблизительно одинаково. Например, рассмотрим ботанический набор данных, бинарная метка которого может быть либо «местное растение» , либо «неместное растение» :

- Набор данных, содержащий 515 местных и 485 неместных растений, является сбалансированным по классам набором данных.

- Набор данных, содержащий 875 местных растений и 125 неместных растений, является несбалансированным по классам набором данных .

A formal dividing line between class-balanced datasets and class-imbalanced datasets doesn't exist. The distinction only becomes important when a model trained on a highly class-imbalanced dataset can't converge. See Datasets: imbalanced datasets in Machine Learning Crash Course for details.

модель классификации

A model whose prediction is a class . For example, the following are all classification models:

- A model that predicts an input sentence's language (French? Spanish? Italian?).

- A model that predicts tree species (Maple? Oak? Baobab?).

- A model that predicts the positive or negative class for a particular medical condition.

In contrast, regression models predict numbers rather than classes.

Two common types of classification models are:

classification threshold

In a binary classification , a number between 0 and 1 that converts the raw output of a logistic regression model into a prediction of either the positive class or the negative class . Note that the classification threshold is a value that a human chooses, not a value chosen by model training.

A logistic regression model outputs a raw value between 0 and 1. Then:

- If this raw value is greater than the classification threshold, then the positive class is predicted.

- If this raw value is less than the classification threshold, then the negative class is predicted.

For example, suppose the classification threshold is 0.8. If the raw value is 0.9, then the model predicts the positive class. If the raw value is 0.7, then the model predicts the negative class.

The choice of classification threshold strongly influences the number of false positives and false negatives .

Более подробную информацию см. в разделе «Пороги и матрица ошибок» в кратком курсе по машинному обучению.

классификатор

A casual term for a classification model .

class-imbalanced dataset

A dataset for a classification in which the total number of labels of each class differs significantly. For example, consider a binary classification dataset whose two labels are divided as follows:

- 1,000,000 negative labels

- 10 positive labels

The ratio of negative to positive labels is 100,000 to 1, so this is a class-imbalanced dataset.

In contrast, the following dataset is class-balanced because the ratio of negative labels to positive labels is relatively close to 1:

- 517 negative labels

- 483 positive labels

Multi-class datasets can also be class-imbalanced. For example, the following multi-class classification dataset is also class-imbalanced because one label has far more examples than the other two:

- 1,000,000 labels with class "green"

- 200 labels with class "purple"

- 350 labels with class "orange"

Training class-imbalanced datasets can present special challenges. See Imbalanced datasets in Machine Learning Crash Course for details.

See also entropy , majority class , and minority class .

обрезка

A technique for handling outliers by doing either or both of the following:

- Reducing feature values that are greater than a maximum threshold down to that maximum threshold.

- Увеличение значений характеристик, которые ниже минимального порогового значения, до этого минимального порогового значения.

Например, предположим, что менее 0,5% значений для определенного параметра выходят за пределы диапазона 40–60. В этом случае можно сделать следующее:

- Обрежьте все значения, превышающие 60 (максимальный порог), до значения ровно 60.

- Обрежьте все значения ниже 40 (минимальный порог) до значения ровно 40.

Выбросы могут навредить моделям, иногда вызывая переполнение весов во время обучения. Некоторые выбросы также могут значительно ухудшить такие показатели, как точность . Ограничение — распространенный метод для минимизации ущерба.

Ограничение градиента заставляет значения градиента находиться в заданном диапазоне во время обучения.

Дополнительную информацию см. в разделе «Числовые данные: нормализация в машинном обучении» (краткий курс).

Облачный TPU

Специализированный аппаратный ускоритель, разработанный для ускорения рабочих нагрузок машинного обучения в облаке Google.

кластеризация

Группировка связанных примеров , особенно в процессе обучения без учителя . После того, как все примеры сгруппированы, человек может по желанию придать смысл каждой группе.

Существует множество алгоритмов кластеризации. Например, алгоритм k-средних кластеризует примеры на основе их близости к центроиду , как показано на следующей диаграмме:

Затем исследователь-человек мог бы проанализировать эти кластеры и, например, обозначить кластер 1 как «карликовые деревья», а кластер 2 как «полноразмерные деревья».

В качестве еще одного примера рассмотрим алгоритм кластеризации, основанный на расстоянии примера от центральной точки, который иллюстрируется следующим образом:

Для получения более подробной информации см. курс «Кластеризация» .

коадаптация

Нежелательное поведение, при котором нейроны предсказывают закономерности в обучающих данных, полагаясь почти исключительно на выходные сигналы отдельных других нейронов, а не на поведение сети в целом. Когда закономерности, вызывающие коадаптацию, отсутствуют в данных валидации, коадаптация приводит к переобучению . Регуляризация с помощью Dropout уменьшает коадаптацию, поскольку Dropout гарантирует, что нейроны не могут полагаться исключительно на отдельные другие нейроны.

коллаборативная фильтрация

Прогнозирование интересов одного пользователя на основе интересов многих других пользователей. Коллаборативная фильтрация часто используется в рекомендательных системах .

Дополнительную информацию см. в разделе «Коллаборативная фильтрация» курса «Рекомендательные системы».

CommitmentBank (CB)

Набор данных для оценки уровня владения студентом магистратуры правом определять, верит ли автор отрывка текста целевому предложению в этом отрывке. Каждая запись в наборе данных содержит:

- Отрывок

- Целевое предложение в этом отрывке

- Логическое значение, указывающее, верит ли автор отрывка целевому предложению.

Например:

- Отрывок: Как же приятно слышать смех Артемиды. Она такая серьёзная девочка. Я и не знала, что у неё есть чувство юмора.

- Целевое условие: у неё было чувство юмора

- Логическое значение : True, что означает, что автор верит целевому предложению.

CommitmentBank является компонентом комплекса SuperGLUE .

компактная модель

Любая компактная модель, предназначенная для работы на небольших устройствах с ограниченными вычислительными ресурсами. Например, компактные модели могут работать на мобильных телефонах, планшетах или встроенных системах.

вычислить

(Существительное) Вычислительные ресурсы, используемые моделью или системой, такие как вычислительная мощность, память и хранилище.

См. микросхемы ускорителей .

дрейф концепции

Изменение взаимосвязи между характеристиками и меткой. Со временем дрейф концепции снижает качество модели.

В процессе обучения модель изучает взаимосвязь между признаками и их метками в обучающем наборе данных. Если метки в обучающем наборе данных хорошо соответствуют реальному миру, то модель должна делать хорошие прогнозы в реальном мире. Однако из-за дрейфа концепции точность прогнозов модели со временем имеет тенденцию снижаться.

Например, рассмотрим модель бинарной классификации , которая предсказывает, является ли определенная модель автомобиля «экономичной с точки зрения расхода топлива». То есть, признаками могут быть:

- вес автомобиля

- компрессия двигателя

- transmission type

при этом метка может быть любой из следующих:

- экономичный расход топлива

- неэкономичен с точки зрения расхода топлива

Однако концепция «экономичного автомобиля» постоянно меняется. Модель автомобиля, названная экономичной в 1994 году, почти наверняка будет названа неэкономичной в 2024 году. Модель, страдающая от концептуального дрейфа, со временем, как правило, дает все менее и менее полезные прогнозы.

Сравните и сопоставьте с нестационарностью .

состояние

В дереве решений любой узел выполняет проверку. Например, следующее дерево решений содержит два условия:

Условие также называется расщеплением или тестом.

Сравните условия с состоянием листа .

См. также:

Дополнительную информацию см. в разделе «Типы условий» курса «Лесные модели принятия решений».

конфабуляция

Синоним слова «галлюцинация» .

Конфабуляция, вероятно, является более точным с технической точки зрения термином, чем галлюцинация. Однако термин «галлюцинация» стал популярным первым.

конфигурация

Процесс присвоения начальных значений свойствам, используемым для обучения модели, включает в себя:

- составные слои модели

- местоположение данных

- гиперпараметры, такие как:

В проектах по машинному обучению настройка может осуществляться с помощью специального конфигурационного файла или библиотек конфигурации, таких как следующие:

предвзятость подтверждения

Тенденция искать, интерпретировать, отдавать предпочтение и вспоминать информацию таким образом, чтобы она подтверждала уже существующие убеждения или гипотезы. Разработчики машинного обучения могут непреднамеренно собирать или маркировать данные таким образом, что это влияет на результат, подтверждающий их существующие убеждения. Предвзятость подтверждения — это форма скрытой предвзятости .

Предвзятость экспериментатора — это форма предвзятости подтверждения, при которой экспериментатор продолжает обучение моделей до тех пор, пока не подтвердится ранее выдвинутая гипотеза.

матрица ошибок

Таблица размером NxN, в которой суммируется количество правильных и неправильных предсказаний, сделанных моделью классификации . Например, рассмотрим следующую матрицу ошибок для модели бинарной классификации :

| Опухоль (прогнозируемая) | Неопухолевый (прогнозируемый) | |

|---|---|---|

| Опухоль (эталонные данные) | 18 (ТП) | 1 (FN) |

| Нетуморальный (эталонный) | 6 (FP) | 452 (ТН) |

Представленная выше матрица ошибок показывает следующее:

- Из 19 прогнозов, в которых в качестве истинного диагноза была указана опухоль, модель правильно классифицировала 18 и неправильно классифицировала 1.

- Из 458 прогнозов, в которых истинное значение указывало на отсутствие опухоли, модель правильно классифицировала 452 случая и неправильно — 6.

The confusion matrix for a multi-class classification problem can help you identify patterns of mistakes. For example, consider the following confusion matrix for a 3-class multi-class classification model that categorizes three different iris types (Virginica, Versicolor, and Setosa). When the ground truth was Virginica, the confusion matrix shows that the model was far more likely to mistakenly predict Versicolor than Setosa:

| Setosa (predicted) | Versicolor (predicted) | Virginica (predicted) | |

|---|---|---|---|

| Setosa (ground truth) | 88 | 12 | 0 |

| Versicolor (ground truth) | 6 | 141 | 7 |

| Virginica (ground truth) | 2 | 27 | 109 |

As yet another example, a confusion matrix could reveal that a model trained to recognize handwritten digits tends to mistakenly predict 9 instead of 4, or mistakenly predict 1 instead of 7.

Confusion matrixes contain sufficient information to calculate a variety of performance metrics, including precision and recall .

анализ избирательных округов

Dividing a sentence into smaller grammatical structures ("constituents"). A later part of the ML system, such as a natural language understanding model, can parse the constituents more easily than the original sentence. For example, consider the following sentence:

My friend adopted two cats.

A constituency parser can divide this sentence into the following two constituents:

- My friend is a noun phrase.

- adopted two cats is a verb phrase.

These constituents can be further subdivided into smaller constituents. For example, the verb phrase

adopted two cats

could be further subdivided into:

- adopted is a verb.

- two cats is another noun phrase.

контекстуализированное встраивание языка

An embedding that comes close to "understanding" words and phrases in ways that fluent human speakers can. Contextualized language embeddings can understand complex syntax, semantics, and context.

For example, consider embeddings of the English word cow . Older embeddings such as word2vec can represent English words such that the distance in the embedding space from cow to bull is similar to the distance from ewe (female sheep) to ram (male sheep) or from female to male . Contextualized language embeddings can go a step further by recognizing that English speakers sometimes casually use the word cow to mean either cow or bull.

контекстное окно

The number of tokens a model can process in a given prompt . The larger the context window, the more information the model can use to provide coherent and consistent responses to the prompt.

непрерывная функция

A floating-point feature with an infinite range of possible values, such as temperature or weight.

Contrast with discrete feature .

выборочная выборка по удобству

Using a dataset not gathered scientifically in order to run quick experiments. Later on, it's essential to switch to a scientifically gathered dataset.

конвергенция

A state reached when loss values change very little or not at all with each iteration . For example, the following loss curve suggests convergence at around 700 iterations:

A model converges when additional training won't improve the model.

In deep learning , loss values sometimes stay constant or nearly so for many iterations before finally descending. During a long period of constant loss values, you may temporarily get a false sense of convergence.

See also early stopping .

See Model convergence and loss curves in Machine Learning Crash Course for more information.

разговорное программирование

An iterative dialog between you and a generative AI model for the purpose of creating software. You issue a prompt describing some software. Then, the model uses that description to generate code. Then, you issue a new prompt to address the flaws in the previous prompt or in the generated code, and the model generates updated code. You two keep going back and forth until the generated software is good enough.

Conversation coding is essentially the original meaning of vibe coding .

Contrast with specificational coding .

выпуклая функция

A function in which the region above the graph of the function is a convex set . The prototypical convex function is shaped something like the letter U . For example, the following are all convex functions:

In contrast, the following function is not convex. Notice how the region above the graph is not a convex set:

A strictly convex function has exactly one local minimum point, which is also the global minimum point. The classic U-shaped functions are strictly convex functions. However, some convex functions (for example, straight lines) are not U-shaped.

See Convergence and convex functions in Machine Learning Crash Course for more information.

выпуклая оптимизация

The process of using mathematical techniques such as gradient descent to find the minimum of a convex function . A great deal of research in machine learning has focused on formulating various problems as convex optimization problems and in solving those problems more efficiently.

For complete details, see Boyd and Vandenberghe, Convex Optimization .

выпуклое множество

A subset of Euclidean space such that a line drawn between any two points in the subset remains completely within the subset. For instance, the following two shapes are convex sets:

In contrast, the following two shapes are not convex sets:

свертка

In mathematics, casually speaking, a mixture of two functions. In machine learning, a convolution mixes the convolutional filter and the input matrix in order to train weights .

The term "convolution" in machine learning is often a shorthand way of referring to either convolutional operation or convolutional layer .

Without convolutions, a machine learning algorithm would have to learn a separate weight for every cell in a large tensor . For example, a machine learning algorithm training on 2K x 2K images would be forced to find 4M separate weights. Thanks to convolutions, a machine learning algorithm only has to find weights for every cell in the convolutional filter , dramatically reducing the memory needed to train the model. When the convolutional filter is applied, it is simply replicated across cells such that each is multiplied by the filter.

сверточный фильтр

One of the two actors in a convolutional operation . (The other actor is a slice of an input matrix.) A convolutional filter is a matrix having the same rank as the input matrix, but a smaller shape. For example, given a 28x28 input matrix, the filter could be any 2D matrix smaller than 28x28.

In photographic manipulation, all the cells in a convolutional filter are typically set to a constant pattern of ones and zeroes. In machine learning, convolutional filters are typically seeded with random numbers and then the network trains the ideal values.

сверточный слой

A layer of a deep neural network in which a convolutional filter passes along an input matrix. For example, consider the following 3x3 convolutional filter :

The following animation shows a convolutional layer consisting of 9 convolutional operations involving the 5x5 input matrix. Notice that each convolutional operation works on a different 3x3 slice of the input matrix. The resulting 3x3 matrix (on the right) consists of the results of the 9 convolutional operations:

![An animation showing two matrixes. The first matrix is the 5x5

matrix: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].

The second matrix is the 3x3 matrix:

[[181,303,618], [115,338,605], [169,351,560]].

The second matrix is calculated by applying the convolutional

filter [[0, 1, 0], [1, 0, 1], [0, 1, 0]] across

different 3x3 subsets of the 5x5 matrix.](https://developers.google.cn/static/machine-learning/glossary/images/AnimatedConvolution.gif?hl=ru)

сверточная нейронная сеть

A neural network in which at least one layer is a convolutional layer . A typical convolutional neural network consists of some combination of the following layers:

Convolutional neural networks have had great success in certain kinds of problems, such as image recognition.

сверточная операция

The following two-step mathematical operation:

- Element-wise multiplication of the convolutional filter and a slice of an input matrix. (The slice of the input matrix has the same rank and size as the convolutional filter.)

- Summation of all the values in the resulting product matrix.

For example, consider the following 5x5 input matrix:

Now imagine the following 2x2 convolutional filter:

Each convolutional operation involves a single 2x2 slice of the input matrix. For example, suppose we use the 2x2 slice at the top-left of the input matrix. So, the convolution operation on this slice looks as follows:

A convolutional layer consists of a series of convolutional operations, each acting on a different slice of the input matrix.

КОПА

Abbreviation for Choice of Plausible Alternatives .

расходы

Synonym for loss .

совместное обучение

A semi-supervised learning approach particularly useful when all of the following conditions are true:

- В наборе данных высокое соотношение немаркированных примеров к маркированным примерам .

- This is a classification problem ( binary or multi-class ).

- The dataset contains two different sets of predictive features that are independent of each other and complementary.

Co-training essentially amplifies independent signals into a stronger signal. For example, consider a classification model that categorizes individual used cars as either Good or Bad . One set of predictive features might focus on aggregate characteristics such as the year, make, and model of the car; another set of predictive features might focus on the previous owner's driving record and the car's maintenance history.

The seminal paper on co-training is Combining Labeled and Unlabeled Data with Co-Training by Blum and Mitchell.

контрфактуальная справедливость

A fairness metric that checks whether a classification model produces the same result for one individual as it does for another individual who is identical to the first, except with respect to one or more sensitive attributes . Evaluating a classification model for counterfactual fairness is one method for surfacing potential sources of bias in a model.

See either of the following for more information:

- Fairness: Counterfactual fairness in Machine Learning Crash Course.

- When Worlds Collide: Integrating Different Counterfactual Assumptions in Fairness

смещение охвата

See selection bias .

круша цветения

A sentence or phrase with an ambiguous meaning. Crash blossoms present a significant problem in natural language understanding . For example, the headline Red Tape Holds Up Skyscraper is a crash blossom because an NLU model could interpret the headline literally or figuratively.

критик

Synonym for Deep Q-Network .

перекрестная энтропия

A generalization of Log Loss to multi-class classification problems . Cross-entropy quantifies the difference between two probability distributions. See also perplexity .

перекрестная проверка

A mechanism for estimating how well a model would generalize to new data by testing the model against one or more non-overlapping data subsets withheld from the training set .

Функция кумулятивного распределения (ФКР)

A function that defines the frequency of samples less than or equal to a target value. For example, consider a normal distribution of continuous values. A CDF tells you that approximately 50% of samples should be less than or equal to the mean and that approximately 84% of samples should be less than or equal to one standard deviation above the mean.

Д

анализ данных

Obtaining an understanding of data by considering samples, measurement, and visualization. Data analysis can be particularly useful when a dataset is first received, before one builds the first model . It is also crucial in understanding experiments and debugging problems with the system.

data augmentation

Artificially boosting the range and number of training examples by transforming existing examples to create additional examples. For example, suppose images are one of your features , but your dataset doesn't contain enough image examples for the model to learn useful associations. Ideally, you'd add enough labeled images to your dataset to enable your model to train properly. If that's not possible, data augmentation can rotate, stretch, and reflect each image to produce many variants of the original picture, possibly yielding enough labeled data to enable excellent training.

DataFrame

A popular pandas data type for representing datasets in memory.

A DataFrame is analogous to a table or a spreadsheet. Each column of a DataFrame has a name (a header), and each row is identified by a unique number.

Each column in a DataFrame is structured like a 2D array, except that each column can be assigned its own data type.

See also the official pandas.DataFrame reference page .

data parallelism

A way of scaling training or inference that replicates an entire model onto multiple devices and then passes a subset of the input data to each device. Data parallelism can enable training and inference on very large batch sizes ; however, data parallelism requires that the model be small enough to fit on all devices.

Data parallelism typically speeds training and inference.

See also model parallelism .

Dataset API (tf.data)

A high-level TensorFlow API for reading data and transforming it into a form that a machine learning algorithm requires. A tf.data.Dataset object represents a sequence of elements, in which each element contains one or more Tensors . A tf.data.Iterator object provides access to the elements of a Dataset .

data set or dataset

A collection of raw data, commonly (but not exclusively) organized in one of the following formats:

- электронная таблица

- a file in CSV (comma-separated values) format

decision boundary

The separator between classes learned by a model in a binary class or multi-class classification problems . For example, in the following image representing a binary classification problem, the decision boundary is the frontier between the orange class and the blue class:

decision forest

A model created from multiple decision trees . A decision forest makes a prediction by aggregating the predictions of its decision trees. Popular types of decision forests include random forests and gradient boosted trees .

See the Decision Forests section in the Decision Forests course for more information.

decision threshold

Synonym for classification threshold .

дерево решений

A supervised learning model composed of a set of conditions and leaves organized hierarchically. For example, the following is a decision tree:

декодер

In general, any ML system that converts from a processed, dense, or internal representation to a more raw, sparse, or external representation.

Decoders are often a component of a larger model, where they are frequently paired with an encoder .

In sequence-to-sequence tasks , a decoder starts with the internal state generated by the encoder to predict the next sequence.

Refer to Transformer for the definition of a decoder within the Transformer architecture.

See Large language models in Machine Learning Crash Course for more information.

deep model

A neural network containing more than one hidden layer .

A deep model is also called a deep neural network .

Contrast with wide model .

глубокая нейронная сеть

Synonym for deep model .

Глубокая Q-сеть (DQN)

In Q-learning , a deep neural network that predicts Q-functions .

Critic is a synonym for Deep Q-Network.

демографическое равенство

A fairness metric that is satisfied if the results of a model's classification are not dependent on a given sensitive attribute .

For example, if both Lilliputians and Brobdingnagians apply to Glubbdubdrib University, demographic parity is achieved if the percentage of Lilliputians admitted is the same as the percentage of Brobdingnagians admitted, irrespective of whether one group is on average more qualified than the other.

Contrast with equalized odds and equality of opportunity , which permit classification results in aggregate to depend on sensitive attributes, but don't permit classification results for certain specified ground truth labels to depend on sensitive attributes. See "Attacking discrimination with smarter machine learning" for a visualization exploring the tradeoffs when optimizing for demographic parity.

See Fairness: demographic parity in Machine Learning Crash Course for more information.

шумоподавление

A common approach to self-supervised learning in which:

Denoising enables learning from unlabeled examples . The original dataset serves as the target or label and the noisy data as the input.

Some masked language models use denoising as follows:

- Noise is artificially added to an unlabeled sentence by masking some of the tokens.

- The model tries to predict the original tokens.

dense feature

A feature in which most or all values are nonzero, typically a Tensor of floating-point values. For example, the following 10-element Tensor is dense because 9 of its values are nonzero:

| 8 | 3 | 7 | 5 | 2 | 4 | 0 | 4 | 9 | 6 |

Contrast with sparse feature .

плотный слой

Synonym for fully connected layer .

глубина

The sum of the following in a neural network :

- the number of hidden layers

- the number of output layers , which is typically 1

- the number of any embedding layers

For example, a neural network with five hidden layers and one output layer has a depth of 6.

Notice that the input layer doesn't influence depth.

depthwise separable convolutional neural network (sepCNN)

A convolutional neural network architecture based on Inception , but where Inception modules are replaced with depthwise separable convolutions. Also known as Xception.

A depthwise separable convolution (also abbreviated as separable convolution) factors a standard 3D convolution into two separate convolution operations that are more computationally efficient: first, a depthwise convolution, with a depth of 1 (n ✕ n ✕ 1), and then second, a pointwise convolution, with length and width of 1 (1 ✕ 1 ✕ n).

To learn more, see Xception: Deep Learning with Depthwise Separable Convolutions .

derived label

Synonym for proxy label .

устройство

An overloaded term with the following two possible definitions:

- A category of hardware that can run a TensorFlow session, including CPUs, GPUs, and TPUs .

- When training an ML model on accelerator chips (GPUs or TPUs), the part of the system that actually manipulates tensors and embeddings . The device runs on accelerator chips. In contrast, the host typically runs on a CPU.

differential privacy

In machine learning, an anonymization approach to protect any sensitive data (for example, an individual's personal information) included in a model's training set from being exposed. This approach ensures that the model doesn't learn or remember much about a specific individual. This is accomplished by sampling and adding noise during model training to obscure individual data points, mitigating the risk of exposing sensitive training data.

Differential privacy is also used outside of machine learning. For example, data scientists sometimes use differential privacy to protect individual privacy when computing product usage statistics for different demographics.

dimension reduction

Decreasing the number of dimensions used to represent a particular feature in a feature vector, typically by converting to an embedding vector .

размеры

Overloaded term having any of the following definitions:

The number of levels of coordinates in a Tensor . For example:

- A scalar has zero dimensions; for example,

["Hello"]. - A vector has one dimension; for example,

[3, 5, 7, 11]. - A matrix has two dimensions; for example,

[[2, 4, 18], [5, 7, 14]]. You can uniquely specify a particular cell in a one-dimensional vector with one coordinate; you need two coordinates to uniquely specify a particular cell in a two-dimensional matrix.

- A scalar has zero dimensions; for example,

The number of entries in a feature vector .

The number of elements in an embedding layer .

direct prompting

Synonym for zero-shot prompting .

discrete feature

A feature with a finite set of possible values. For example, a feature whose values may only be animal , vegetable , or mineral is a discrete (or categorical) feature.

Contrast with continuous feature .

дискриминативная модель

A model that predicts labels from a set of one or more features . More formally, discriminative models define the conditional probability of an output given the features and weights ; that is:

p(output | features, weights)

For example, a model that predicts whether an email is spam from features and weights is a discriminative model.

The vast majority of supervised learning models, including classification and regression models, are discriminative models.

Contrast with generative model .

дискриминатор

A system that determines whether examples are real or fake.

Alternatively, the subsystem within a generative adversarial network that determines whether the examples created by the generator are real or fake.

See The discriminator in the GAN course for more information.

неравномерное воздействие

Making decisions about people that impact different population subgroups disproportionately. This usually refers to situations where an algorithmic decision-making process harms or benefits some subgroups more than others.

For example, suppose an algorithm that determines a Lilliputian's eligibility for a miniature-home loan is more likely to classify them as "ineligible" if their mailing address contains a certain postal code. If Big-Endian Lilliputians are more likely to have mailing addresses with this postal code than Little-Endian Lilliputians, then this algorithm may result in disparate impact.

Contrast with disparate treatment , which focuses on disparities that result when subgroup characteristics are explicit inputs to an algorithmic decision-making process.

неравное обращение

Factoring subjects' sensitive attributes into an algorithmic decision-making process such that different subgroups of people are treated differently.

For example, consider an algorithm that determines Lilliputians' eligibility for a miniature-home loan based on the data they provide in their loan application. If the algorithm uses a Lilliputian's affiliation as Big-Endian or Little-Endian as an input, it is enacting disparate treatment along that dimension.

Contrast with disparate impact , which focuses on disparities in the societal impacts of algorithmic decisions on subgroups, irrespective of whether those subgroups are inputs to the model.

дистилляция

The process of reducing the size of one model (known as the teacher ) into a smaller model (known as the student ) that emulates the original model's predictions as faithfully as possible. Distillation is useful because the smaller model has two key benefits over the larger model (the teacher):

- Faster inference time

- Reduced memory and energy usage

However, the student's predictions are typically not as good as the teacher's predictions.

Distillation trains the student model to minimize a loss function based on the difference between the outputs of the predictions of the student and teacher models.

Compare and contrast distillation with the following terms:

See LLMs: Fine-tuning, distillation, and prompt engineering in Machine Learning Crash Course for more information.

распределение

The frequency and range of different values for a given feature or label . A distribution captures how likely a particular value is.

The following image shows histograms of two different distributions:

- On the left, a power law distribution of wealth versus the number of people possessing that wealth.

- On the right, a normal distribution of height versus the number of people possessing that height.

Understanding each feature and label's distribution can help you determine how to normalize values and detect outliers .

The phrase out of distribution refers to a value that doesn't appear in the dataset or is very rare. For example, an image of the planet Saturn would be considered out of distribution for a dataset consisting of cat images.

divisive clustering

See hierarchical clustering .

понижение разрешения

Overloaded term that can mean either of the following:

- Reducing the amount of information in a feature in order to train a model more efficiently. For example, before training an image recognition model, downsampling high-resolution images to a lower-resolution format.

- Training on a disproportionately low percentage of over-represented class examples in order to improve model training on under-represented classes. For example, in a class-imbalanced dataset , models tend to learn a lot about the majority class and not enough about the minority class . Downsampling helps balance the amount of training on the majority and minority classes.

Дополнительную информацию см. в разделе «Наборы данных: Несбалансированные наборы данных» в кратком курсе по машинному обучению.

ДКН

Abbreviation for Deep Q-Network .

dropout regularization

A form of regularization useful in training neural networks . Dropout regularization removes a random selection of a fixed number of the units in a network layer for a single gradient step. The more units dropped out, the stronger the regularization. This is analogous to training the network to emulate an exponentially large ensemble of smaller networks. For full details, see Dropout: A Simple Way to Prevent Neural Networks from Overfitting .

динамический

Something done frequently or continuously. The terms dynamic and online are synonyms in machine learning. The following are common uses of dynamic and online in machine learning:

- A dynamic model (or online model ) is a model that is retrained frequently or continuously.

- Dynamic training (or online training ) is the process of training frequently or continuously.

- Dynamic inference (or online inference ) is the process of generating predictions on demand.

динамическая модель

A model that is frequently (maybe even continuously) retrained. A dynamic model is a "lifelong learner" that constantly adapts to evolving data. A dynamic model is also known as an online model .

Contrast with static model .

Е

eager execution