Cel

W samouczku Weryfikacja adresów o dużej liczbie zapytań przedstawiliśmy różne scenariusze, w których można używać weryfikacji adresów o dużej liczbie zapytań. W tym samouczku przedstawimy różne wzorce projektowe w Google Cloud Platform do uruchamiania weryfikacji adresów o dużej liczbie zapytań.

Zaczniemy od omówienia uruchamiania weryfikacji adresów o dużej liczbie zapytań na platformie Google Cloud za pomocą Cloud Run, Compute Engine lub Google Kubernetes Engine w przypadku jednorazowych wykonań. Następnie zobaczymy, jak można włączyć tę funkcję do potoku danych.

Po przeczytaniu tego artykułu będziesz mieć dobrą wiedzę o różnych opcjach uruchamiania weryfikacji adresu w dużej ilości w środowisku Google Cloud.

Architektura referencyjna w Google Cloud Platform

W tej sekcji znajdziesz szczegółowe informacje o różnych wzorcach projektowych do weryfikacji adresów o dużej liczbie zapytań za pomocą Google Cloud Platform. Dzięki uruchamianiu na platformie Google Cloud możesz integrować się z dotychczasowymi procesami i potokami danych.

Jednorazowe uruchomienie weryfikacji adresów o dużej liczbie zapytań w Google Cloud Platform

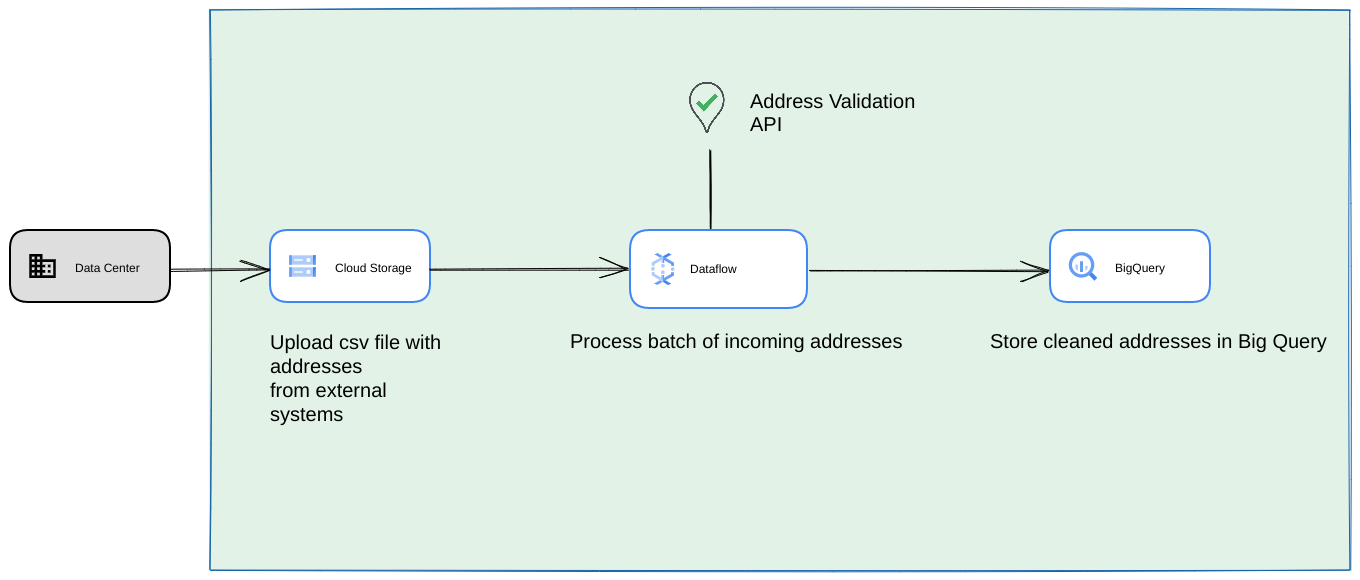

Poniżej przedstawiamy architekturę referencyjną, która pokazuje, jak utworzyć integrację na platformie Google Cloud Platform, która lepiej nadaje się do jednorazowych operacji lub testowania.

W takim przypadku zalecamy przesłanie pliku CSV do zasobnika Cloud Storage. Skrypt weryfikacji adresów o dużej liczbie można uruchomić w środowisku Cloud Run. Możesz jednak uruchomić go w dowolnym innym środowisku wykonawczym, takim jak Compute Engine lub Google Kubernetes Engine. Wyjściowy plik CSV można też przesłać do zasobnika Cloud Storage.

Uruchamianie jako potok danych Google Cloud Platform

Wzorzec wdrażania pokazany w poprzedniej sekcji doskonale nadaje się do szybkiego testowania interfejsu High Volume Address Validation w przypadku jednorazowego użycia. Jeśli jednak musisz regularnie korzystać z tej usługi w ramach potoku danych, możesz lepiej wykorzystać natywne funkcje Google Cloud Platform, aby zwiększyć jej niezawodność. Oto niektóre zmiany, które możesz wprowadzić:

- W takim przypadku możesz zrzucać pliki CSV do zasobników Cloud Storage.

- Zadanie Dataflow może pobrać adresy do przetworzenia, a następnie zapisać je w pamięci podręcznej w BigQuery.

- Bibliotekę Pythona Dataflow można rozszerzyć, aby zawierała logikę weryfikacji adresów o dużej liczbie zapytań, która będzie weryfikować adresy z zadań Dataflow.

Uruchamianie skryptu z potoku danych jako długotrwałego procesu cyklicznego

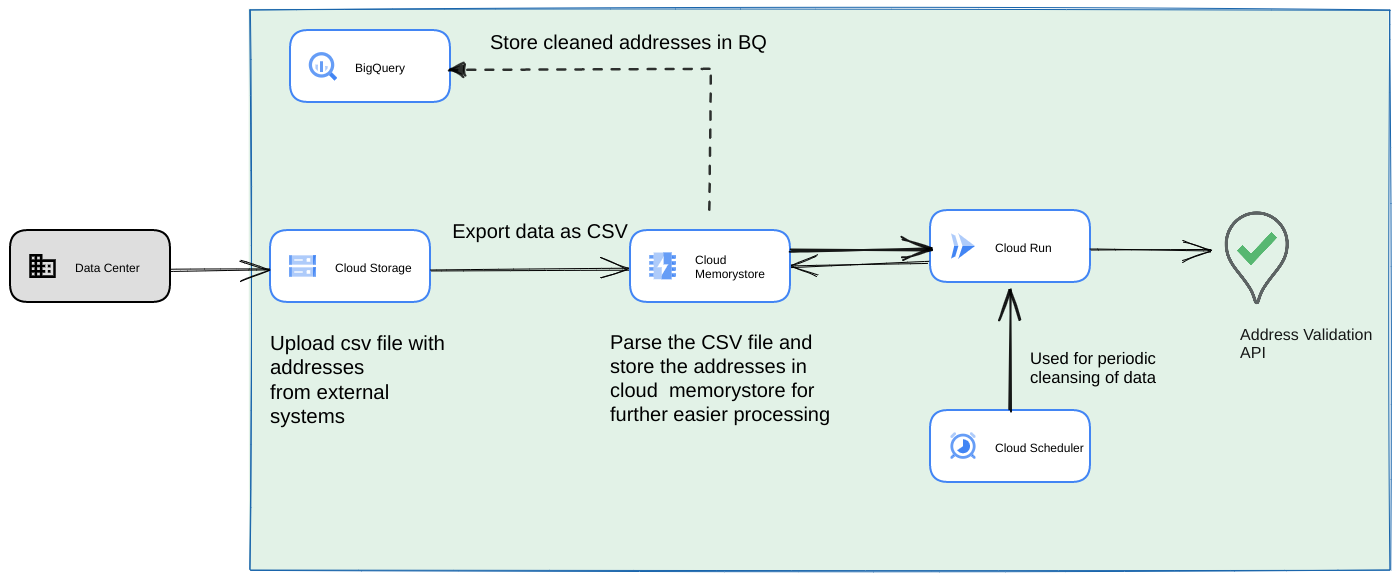

Innym popularnym podejściem jest weryfikacja partii adresów w ramach potoku danych strumieniowych jako proces cykliczny. Adresy mogą też być przechowywane w usłudze BigQuery Datastore. W tym podejściu pokażemy, jak utworzyć cykliczny potok danych (który musi być uruchamiany codziennie, co tydzień lub co miesiąc).

- Prześlij początkowy plik CSV do zasobnika Cloud Storage.

- Użyj Memorystore jako trwałego magazynu danych, aby zachować stan pośredni długotrwałego procesu.

- Pamięć podręczna adresów końcowych w BigQuery.

- Skonfiguruj Cloud Scheduler, aby okresowo uruchamiać skrypt.

Ta architektura ma następujące zalety:

- Za pomocą Cloud Scheduler można okresowo przeprowadzać weryfikację adresu. Możesz ponownie weryfikować adresy co miesiąc lub weryfikować nowe adresy co miesiąc lub co kwartał. Ta architektura pomaga rozwiązać ten problem.

Jeśli dane klientów znajdują się w BigQuery, zweryfikowane adresy lub flagi weryfikacji można buforować bezpośrednio w tej usłudze. Uwaga: szczegółowe informacje o tym, co można przechowywać w pamięci podręcznej i jak to robić, znajdziesz w artykule o weryfikacji adresów przy dużej liczbie zapytań.

Korzystanie z Memorystore zapewnia większą odporność i możliwość przetwarzania większej liczby adresów. Ten krok dodaje stan do całego potoku przetwarzania, co jest potrzebne do obsługi bardzo dużych zbiorów danych adresowych. Możesz też użyć innych technologii baz danych, takich jak Cloud SQL[https://cloud.google.com/sql] lub dowolna inna wersja bazy danych oferowana przez Google Cloud Platform. Uważamy jednak, że usługa Memorystore doskonale równoważy potrzeby związane ze skalowaniem i prostotą, dlatego powinna być pierwszym wyborem.

Podsumowanie

Stosując opisane tu wzorce, możesz używać interfejsu Address Validation API w różnych przypadkach i w różnych przypadkach użycia na Google Cloud Platform.

Aby ułatwić Ci rozpoczęcie pracy z opisanymi powyżej przypadkami użycia, napisaliśmy bibliotekę open source w języku Python. Można go wywołać z wiersza poleceń na komputerze lub z Google Cloud Platform albo innych dostawców usług w chmurze.

Więcej informacji o korzystaniu z biblioteki znajdziesz w tym artykule.

Następne kroki

Pobierz białą księgę na temat usprawniania procesu płatności, dostawy i operacji dzięki wiarygodnym adresom i obejrzyj webinar na temat usprawniania procesu płatności, dostawy i operacji dzięki weryfikacji adresu .

Sugerowane dodatkowe materiały:

- Dokumentacja Address Validation API

- Geokodowanie i weryfikacja adresu

- Wypróbuj wersję demonstracyjną Weryfikacji adresów

Współtwórcy

Google jest autorem tego artykułu. Oryginalni autorzy:

Główni autorzy:

Henrik Valve | Inżynier ds. rozwiązań

Thomas Anglaret | Inżynier ds. rozwiązań

Sarthak Ganguly | Inżynier ds. rozwiązań