Bagian sebelumnya menyajikan serangkaian metrik model, yang semuanya dihitung pada satu nilai nilai minimum klasifikasi. Namun, jika Anda ingin mengevaluasi kualitas model di semua kemungkinan nilai minimum, Anda memerlukan alat yang berbeda.

Kurva karakteristik operasi penerima (ROC)

Kurva ROC adalah representasi visual performa model di semua nilai minimum. Versi panjang nama, karakteristik operasi penerima, adalah sisa dari deteksi radar Perang Dunia II.

Kurva ROC digambar dengan menghitung rasio positif benar (TPR) dan rasio positif palsu (FPR) pada setiap kemungkinan nilai minimum (dalam praktiknya, pada interval yang dipilih), lalu membuat grafik TPR berdasarkan FPR. Model sempurna, yang pada nilai minimum tertentu memiliki TPR 1,0 dan FPR 0,0, dapat diwakili oleh titik pada (0, 1) jika semua nilai minimum lainnya diabaikan, atau dengan hal berikut:

Area di bawah kurva (AUC)

Area di bawah kurva ROC (AUC) mewakili probabilitas bahwa model, jika diberi contoh positif dan negatif yang dipilih secara acak, akan memberi peringkat positif lebih tinggi daripada negatif.

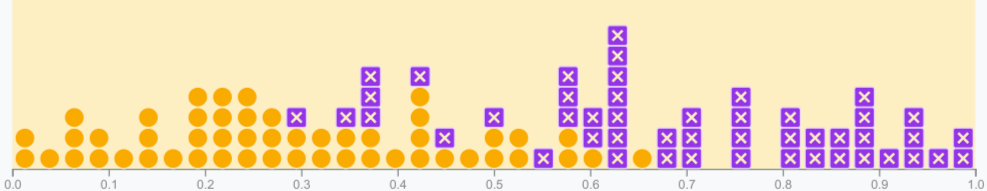

Model sempurna di atas, yang berisi persegi dengan sisi panjang 1, memiliki area di bawah kurva (AUC) sebesar 1,0. Artinya, ada probabilitas 100% bahwa model akan dengan benar memberi peringkat lebih tinggi pada contoh positif yang dipilih secara acak daripada contoh negatif yang dipilih secara acak. Dengan kata lain, melihat penyebaran titik data di bawah, AUC memberikan probabilitas bahwa model akan menempatkan kotak yang dipilih secara acak di sebelah kanan lingkaran yang dipilih secara acak, terlepas dari tempat nilai minimum ditetapkan.

Secara lebih konkret, pengklasifikasi spam dengan AUC 1,0 selalu menetapkan email spam acak dengan probabilitas yang lebih tinggi menjadi spam daripada email sah acak. Klasifikasi sebenarnya dari setiap email bergantung pada nilai minimum yang Anda pilih.

Untuk pengklasifikasi biner, model yang memiliki performa sama persis dengan tebakan acak atau lemparan koin memiliki ROC yang merupakan garis diagonal dari (0,0) ke (1,1). AUC adalah 0,5, yang mewakili probabilitas 50% untuk memberi peringkat yang benar pada contoh positif dan negatif acak.

Dalam contoh pengklasifikasi spam, pengklasifikasi spam dengan AUC 0,5 menetapkan email spam acak dengan probabilitas yang lebih tinggi untuk menjadi spam daripada email yang sah secara acak hanya setengah waktu.

(Opsional, lanjutan) Kurva presisi-recall

AUC dan ROC berfungsi dengan baik untuk membandingkan model jika set data secara kasar seimbang di antara class. Jika set data tidak seimbang, kurva presisi-recall (PRC) dan area di bawah kurva tersebut dapat menawarkan visualisasi komparatif performa model yang lebih baik. Kurva presisi-recall dibuat dengan plot presisi pada sumbu y dan recall pada sumbu x di semua ambang batas.

AUC dan ROC untuk memilih model dan nilai minimum

AUC adalah ukuran yang berguna untuk membandingkan performa dua model yang berbeda, asalkan set datanya seimbang. Model dengan area di bawah kurva yang lebih besar umumnya lebih baik.

Titik pada kurva ROC yang paling dekat dengan (0,1) mewakili rentang nilai minimum berperforma terbaik untuk model tertentu. Seperti yang telah dibahas di bagian Nilai minimum, Matriks kebingungan, dan Pilihan metrik dan kompromi, nilai minimum yang Anda pilih bergantung pada metrik yang paling penting untuk kasus penggunaan tertentu. Pertimbangkan titik A, B, dan C dalam diagram berikut, yang masing-masing mewakili nilai minimum:

Jika positif palsu (alarm palsu) sangat mahal, sebaiknya pilih nilai minimum yang memberikan FPR yang lebih rendah, seperti yang ada di titik A, meskipun TPR dikurangi. Sebaliknya, jika positif palsu murah dan negatif palsu (positif benar yang terlewat) sangat mahal, nilai minimum untuk titik C, yang memaksimalkan TPR, mungkin lebih disukai. Jika biayanya kira-kira setara, titik B mungkin menawarkan keseimbangan terbaik antara TPR dan FPR.

Berikut adalah kurva ROC untuk data yang telah kita lihat sebelumnya:

Latihan: Periksa pemahaman Anda

(Opsional, lanjutan) Pertanyaan bonus

Bayangkan situasi saat lebih baik mengizinkan beberapa spam masuk ke kotak masuk daripada mengirim email penting bagi bisnis ke folder spam. Anda telah melatih pengklasifikasi spam untuk situasi ini dengan class positif adalah spam dan class negatif adalah bukan spam. Manakah dari titik berikut pada kurva ROC untuk pengklasifikasi Anda yang lebih disukai?