La sezione precedente presentava un insieme di metriche del modello, tutte calcolate con un singolo valore di soglia di classificazione. Tuttavia, se vuoi valutare la qualità di un modello in tutte le possibili soglie, hai bisogno di strumenti diversi.

Curva della caratteristica operativa del ricevitore (ROC)

La curva ROC è una rappresentazione visiva del rendimento del modello in tutte le soglie. La versione lunga del nome, caratteristica operativa del ricevitore, è un retaggio del rilevamento radar della seconda guerra mondiale.

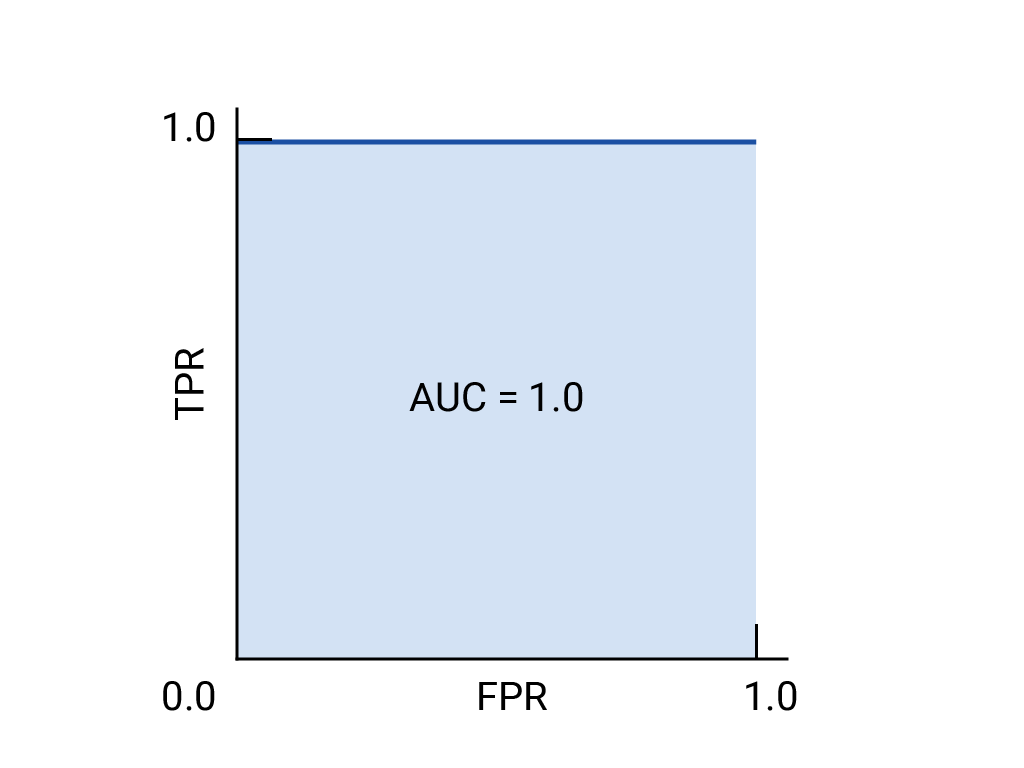

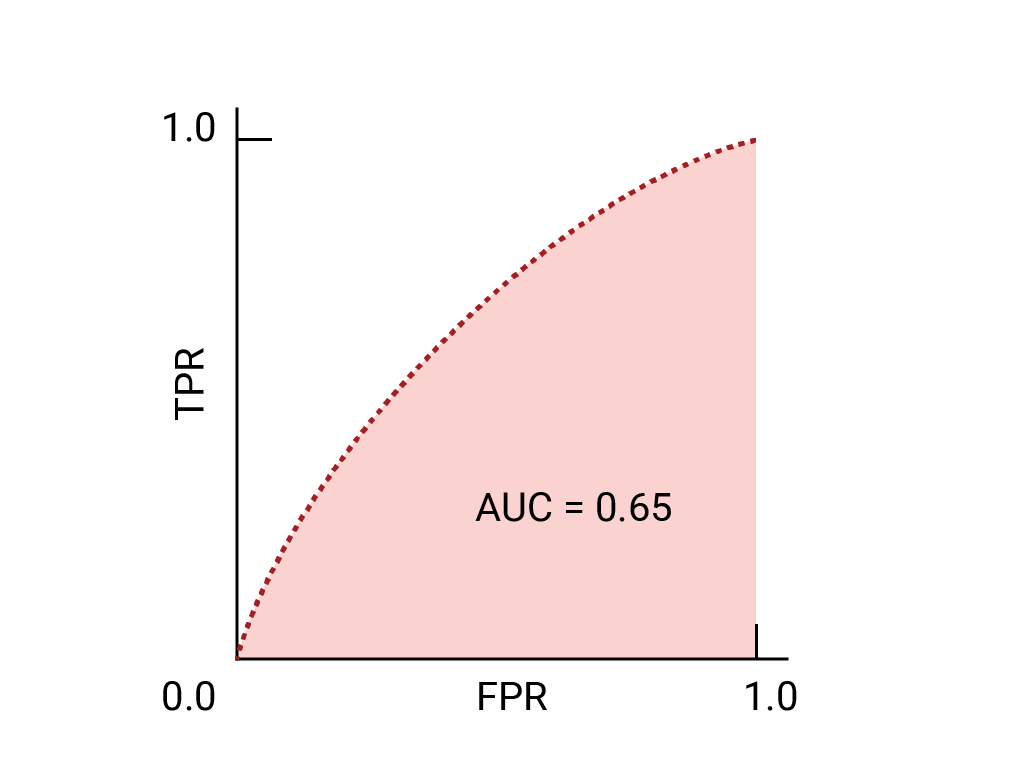

La curva ROC viene tracciata calcolando la percentuale di veri positivi (TPR) e la percentuale di falsi positivi (FPR) a ogni soglia possibile (in pratica, a intervalli selezionati), quindi tracciando la TPR rispetto alla FPR. Un modello perfetto, che a una determinata soglia ha un TPR di 1,0 e un FPR di 0,0, può essere rappresentato da un punto in (0, 1) se tutte le altre soglie vengono ignorate oppure da quanto segue:

Area sotto la curva (AUC)

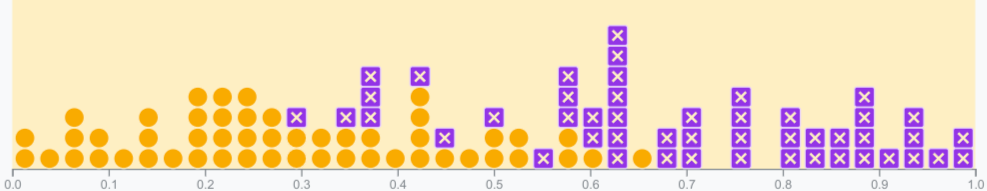

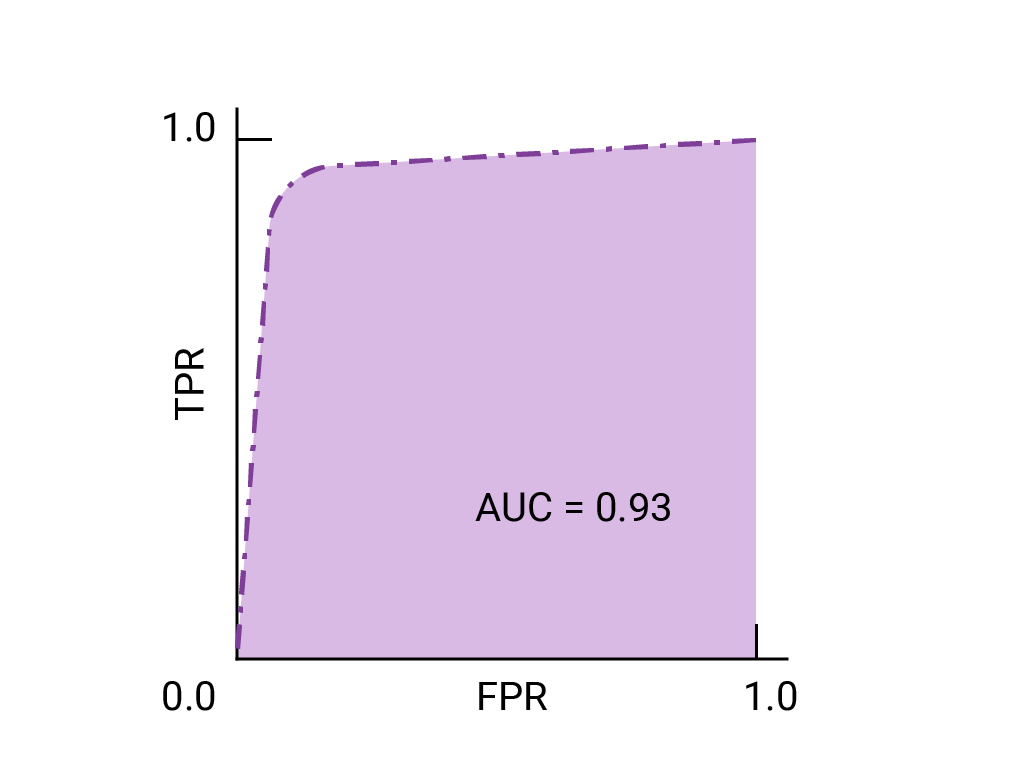

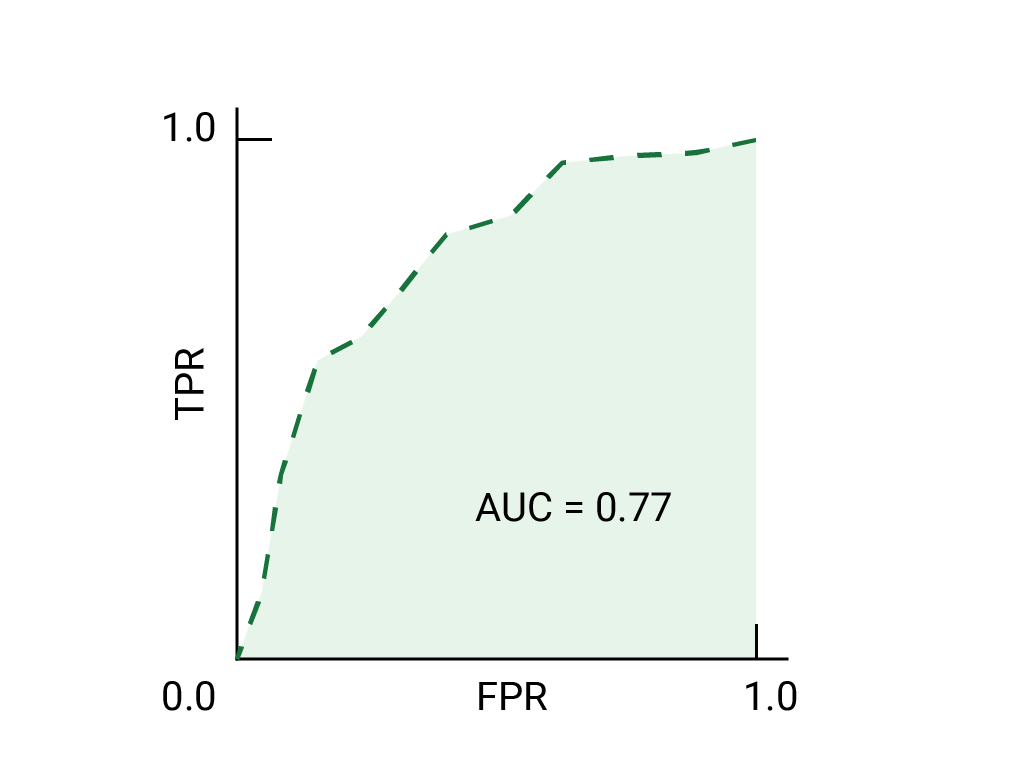

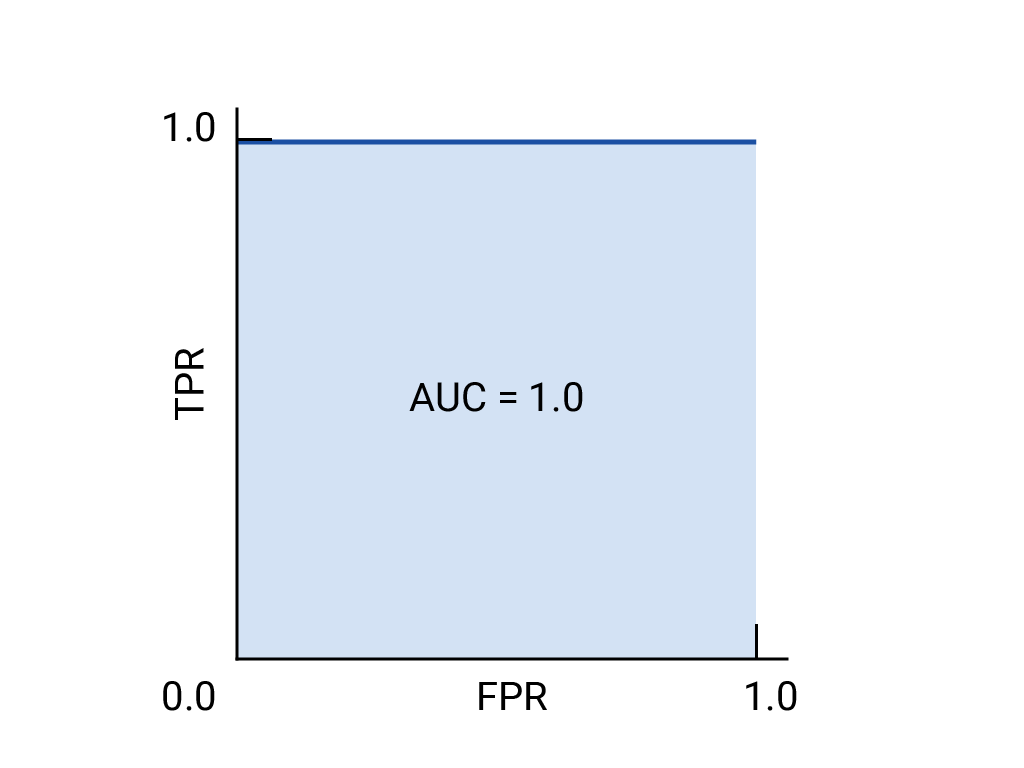

L'area sotto la curva ROC (AUC) rappresenta la probabilità che il modello, se fornito un esempio positivo e negativo scelto a caso, classifichi l'esempio positivo più alto dell'esempio negativo.

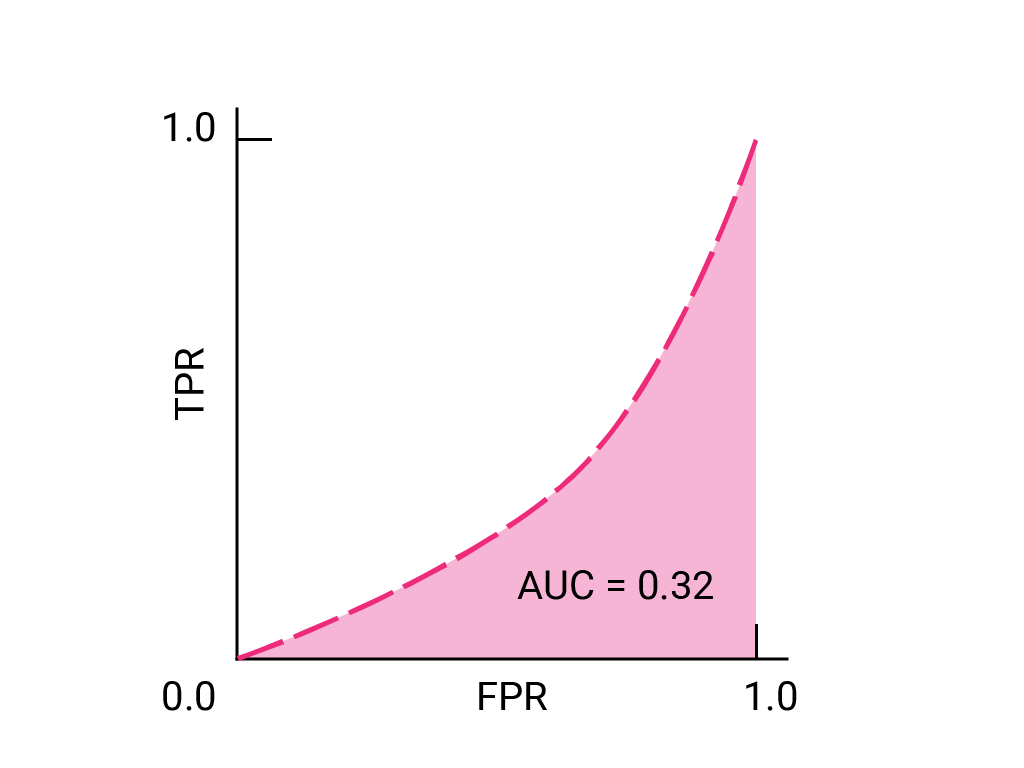

Il modello perfetto sopra, contenente un quadrato con lati di lunghezza 1, ha un'area sotto la curva (AUC) pari a 1,0. Ciò significa che esiste una probabilità del 100% che il modello classifichi correttamente un esempio positivo scelto a caso più in alto di un esempio negativo scelto a caso. In altre parole, osservando la dispersione dei punti dati di seguito, il valore AUC indica la probabilità che il modello inserisca un quadrato scelto in modo casuale a destra di un cerchio scelto in modo casuale, indipendentemente da dove è impostata la soglia.

In termini più concreti, un classificatore di spam con un AUC di 1,0 assegna sempre a un'email di spam casuale una probabilità più alta di essere spam rispetto a un'email legittima casuale. La classificazione effettiva di ogni email dipende dalla soglia scelta.

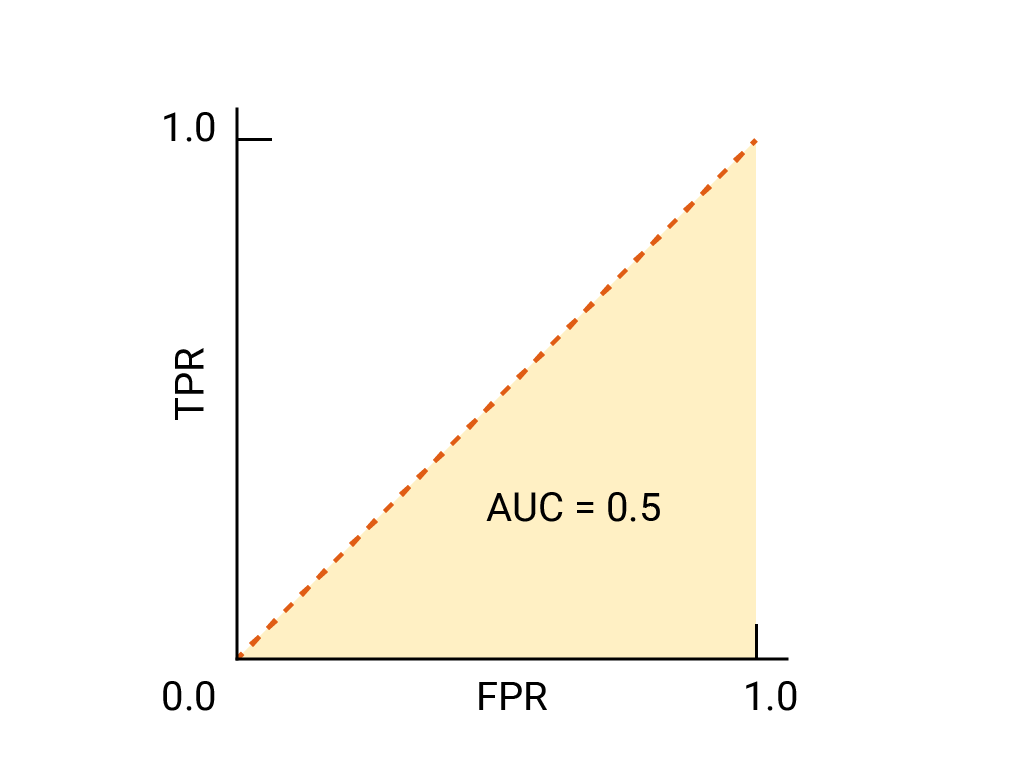

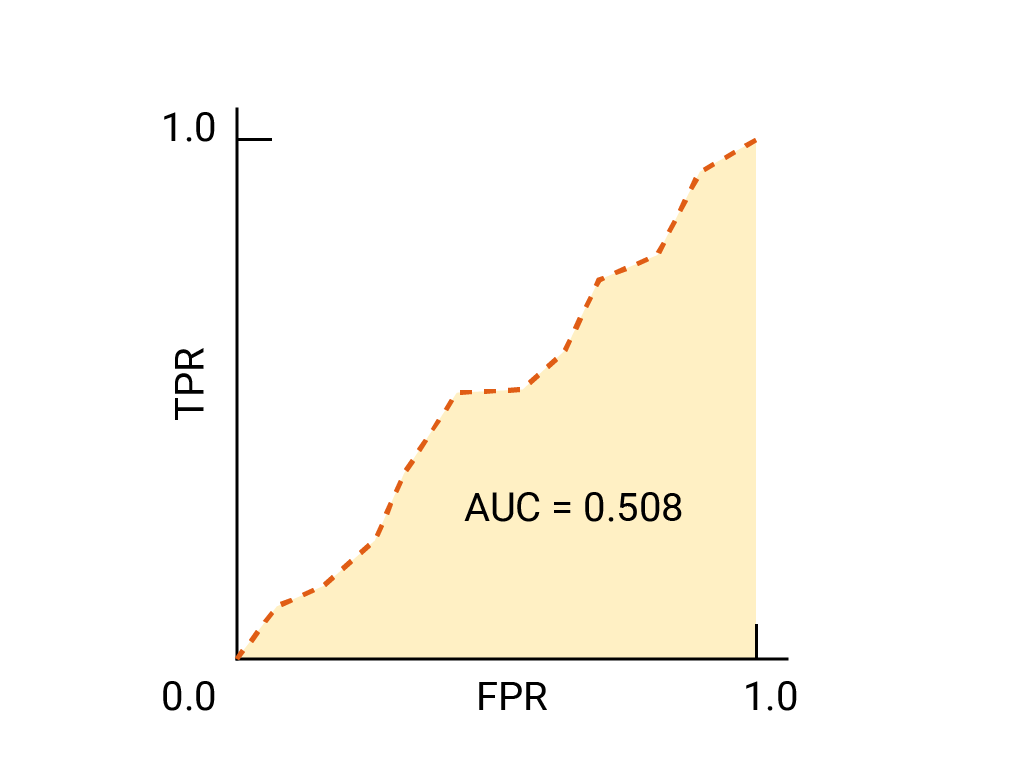

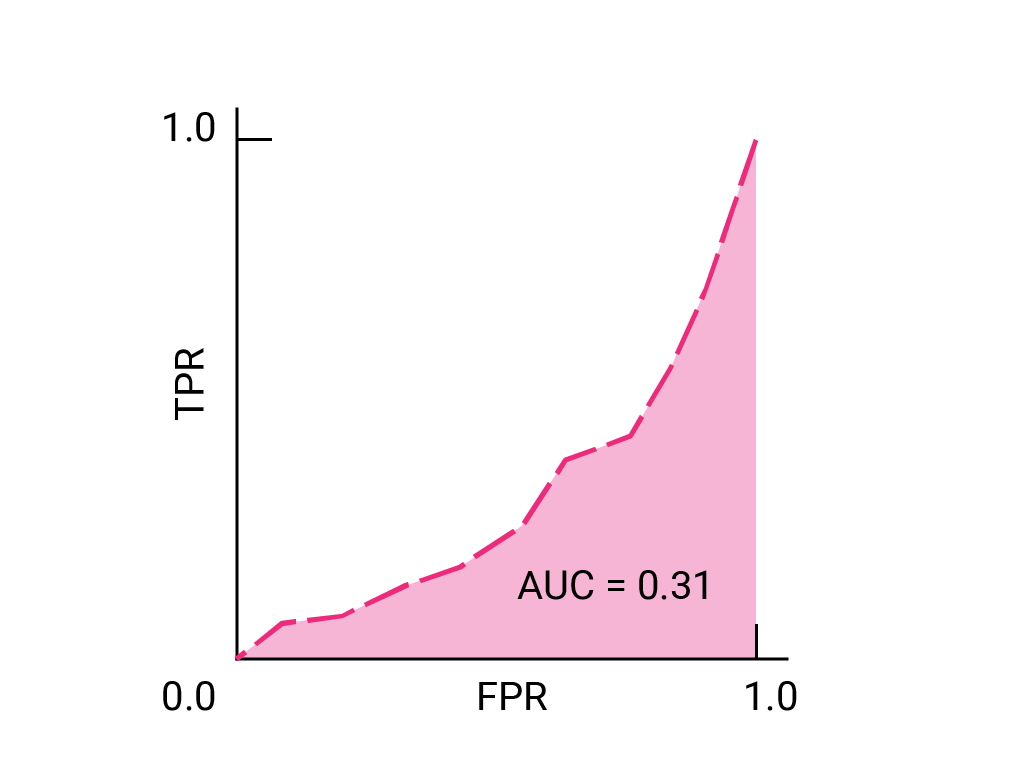

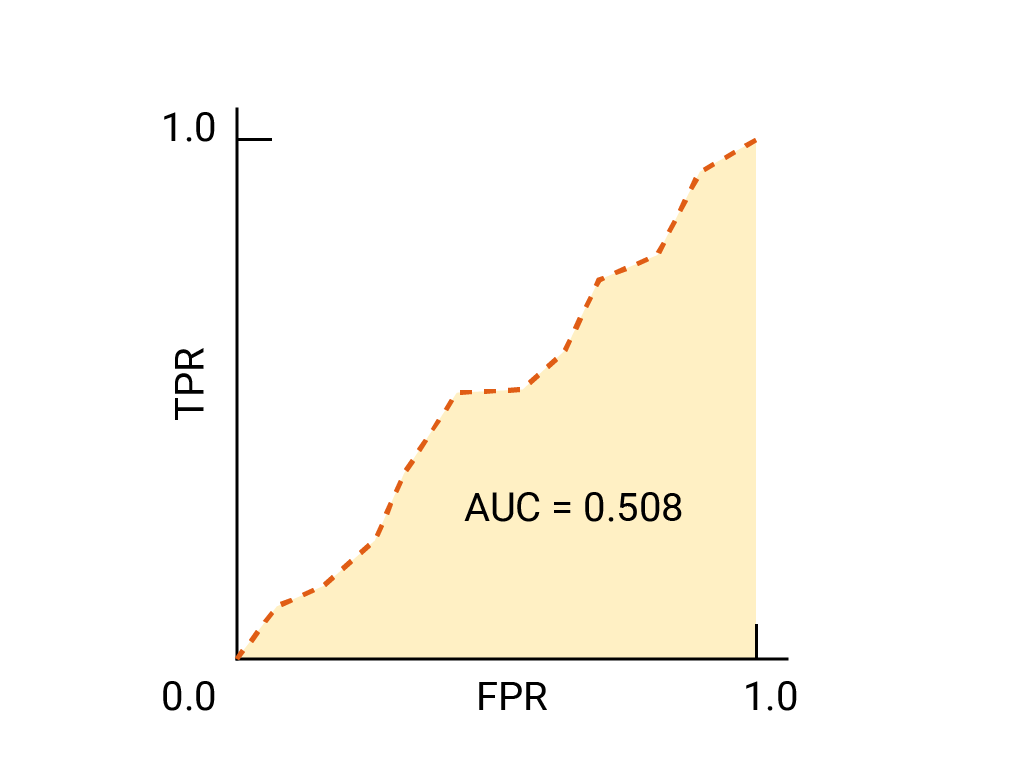

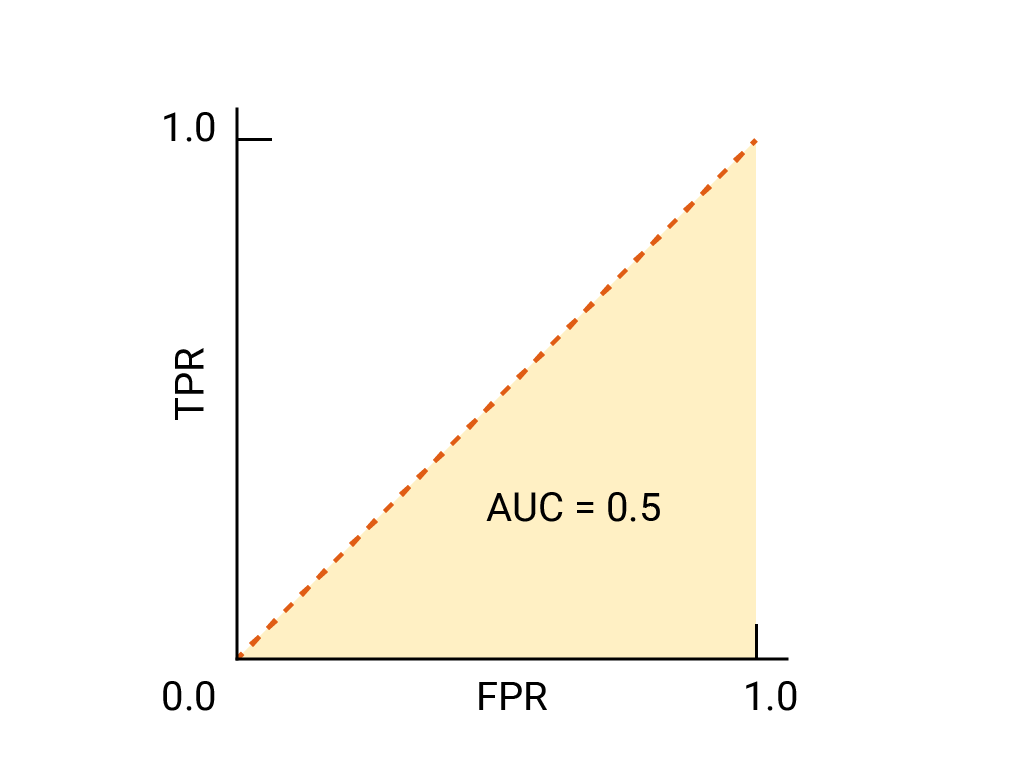

Per un classificatore binario, un modello che ha lo stesso rendimento delle supposizioni casuali o del lancio di una moneta ha un ROC che è una linea diagonale da (0,0) a (1,1). L'AUC è equale a 0,5, il che rappresenta una probabilità del 50% di classificare correttamente un esempio positivo e uno negativo casuali.

Nell'esempio del classificatore dello spam, un classificatore dello spam con un AUC pari a 0,5 assegna a un'email di spam casuale una probabilità maggiore di essere spam rispetto a un'email legittima casuale solo la metà delle volte.

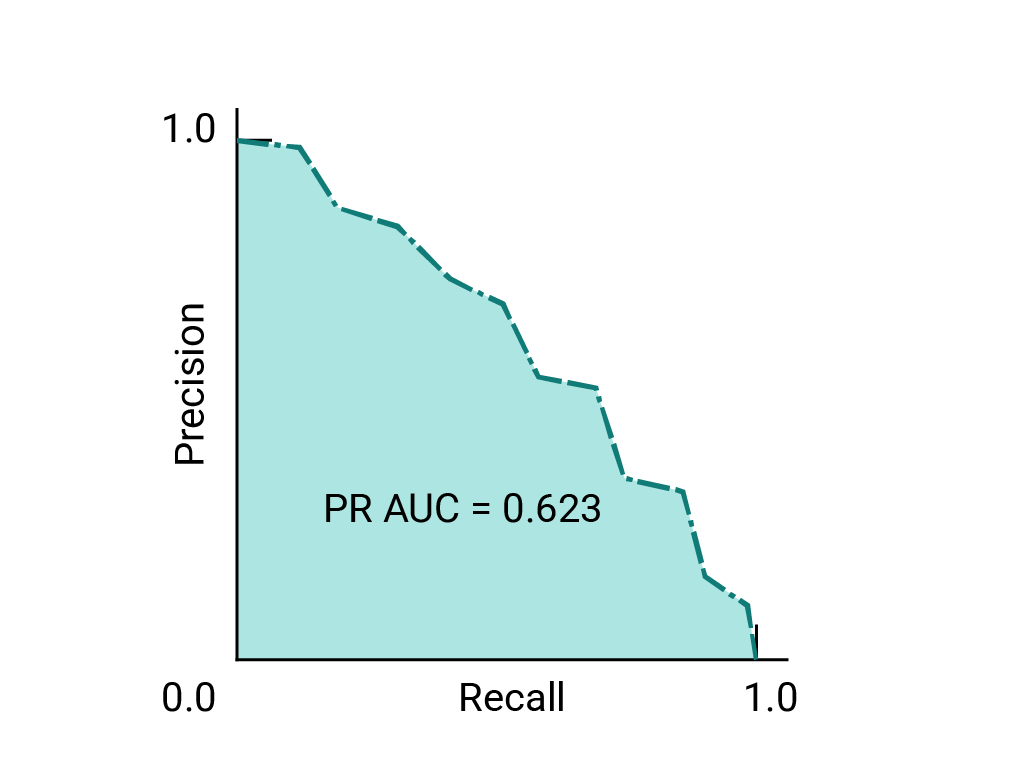

(Facoltativo, avanzato) Curva di precisione-richiamo

AUC e ROC sono utili per confrontare i modelli quando il set di dati è approssimativamente bilanciato tra le classi. Quando il set di dati è sbilanciato, le curve di precisione-richiamo (PRC) e l'area sotto queste curve possono offrire una migliore visualizzazione comparativa del rendimento del modello. Le curve di precisione-richiamo vengono create rappresentando la precisione sull'asse Y e il richiamo sull'asse X per tutte le soglie.

AUC e ROC per la scelta del modello e della soglia

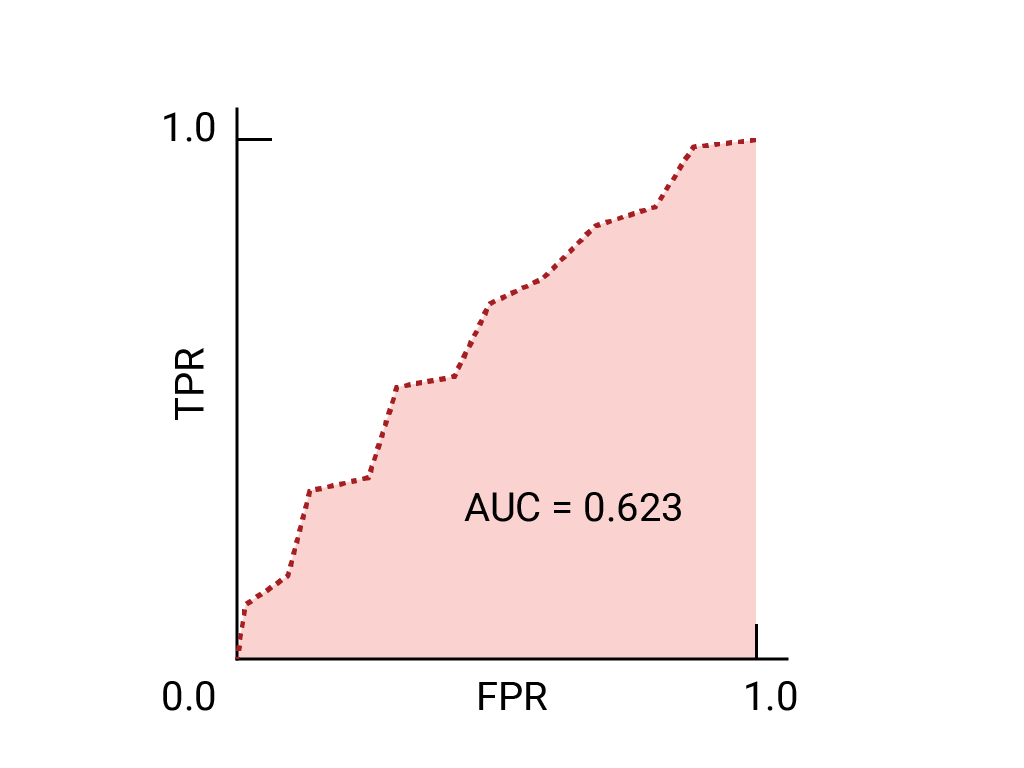

L'AUC è una misura utile per confrontare il rendimento di due modelli diversi, purché il set di dati sia approssimativamente bilanciato. In genere, il modello con l'area maggiore sotto la curva è quello migliore.

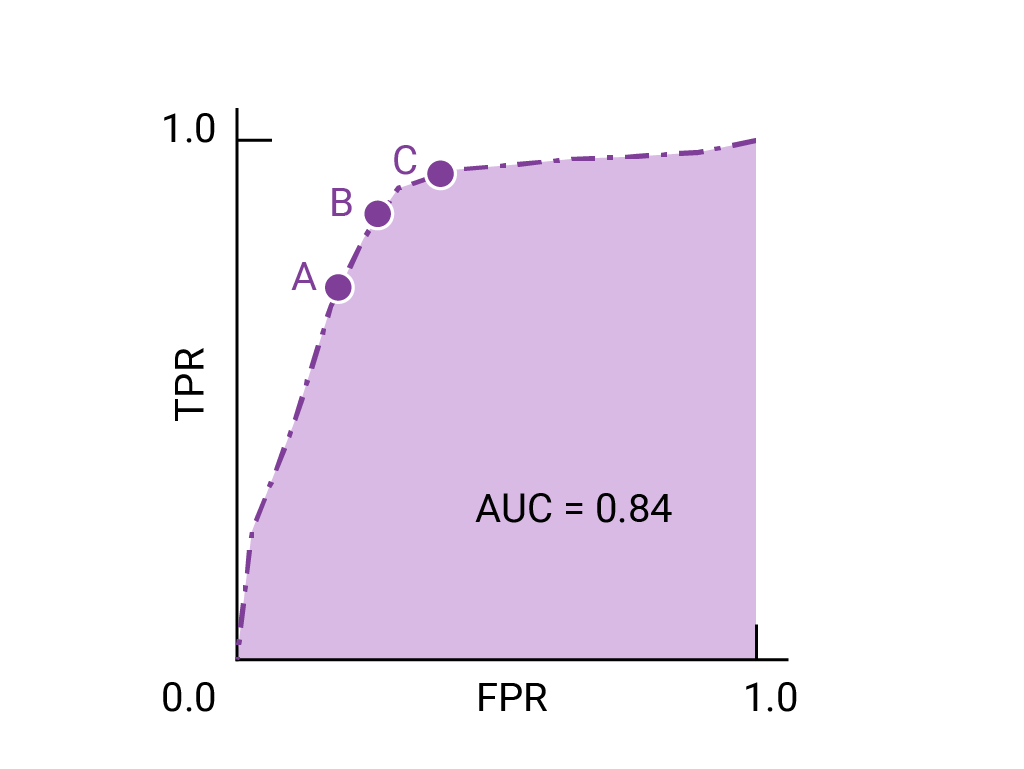

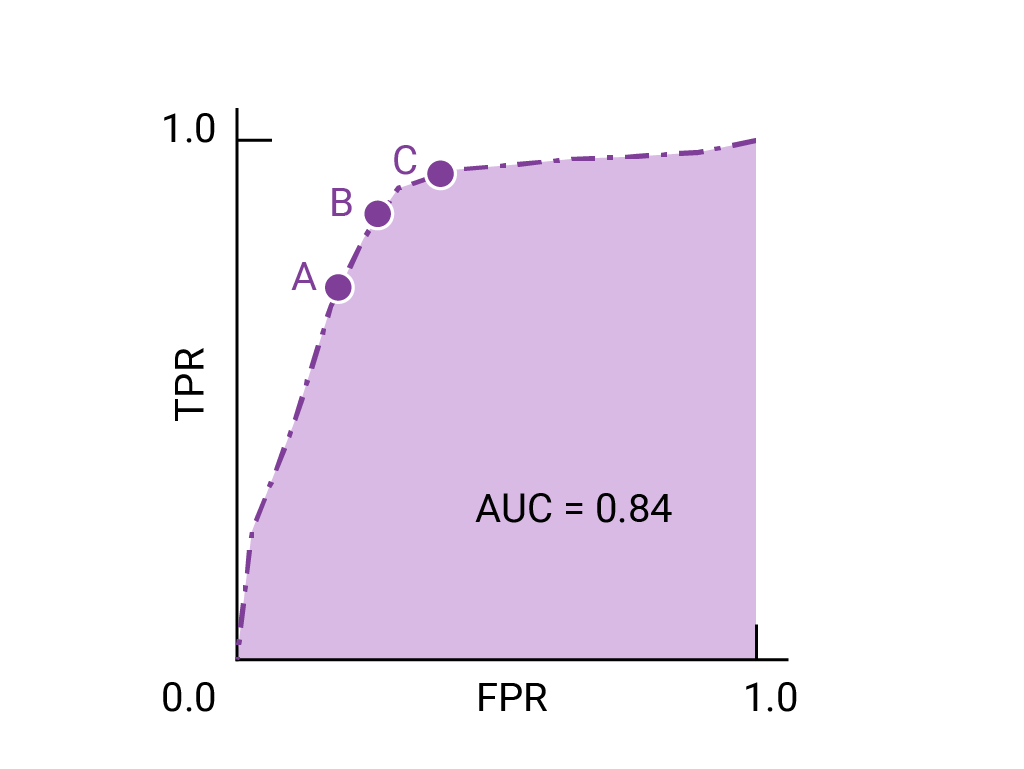

I punti di una curva ROC più vicini a (0,1) rappresentano un intervallo di soglie con il rendimento migliore per il modello in questione. Come discusso nelle sezioni Soglie, Matrice di confusione e Scelta della metrica e compromessi, la soglia scelta dipende dalla metrica più importante per il caso d'uso specifico. Considera i punti A, B e C nel seguente diagramma, ciascuno dei quali rappresenta una soglia:

Se i falsi positivi (falsi allarmi) sono molto costosi, potrebbe essere opportuno scegliere una soglia che fornisca un FPR inferiore, come quella nel punto A, anche se il TPR è ridotto. Al contrario, se i falsi positivi sono economici e i falsi negativi (veri positivi mancati) molto costosi, potrebbe essere preferibile la soglia per il punto C, che massimizza il TPR. Se i costi sono approssimativamente equivalenti, il punto B potrebbe offrire il miglior equilibrio tra TPR e FPR.

Ecco la curva ROC per i dati che abbiamo visto in precedenza:

Esercizio: verifica di aver compreso

(Facoltativo, avanzato) Domanda bonus

Immagina una situazione in cui è meglio consentire a un po' di spam di raggiungere la posta in arrivo piuttosto che inviare un'email aziendale importante alla cartella dello spam. Hai addestrato un classificatore di spam per questa situazione in cui la classe positiva è spam e la classe negativa è non spam. Quale dei seguenti punti sulla curva ROC per il tuo classificatore è preferibile?