Lors de l'évaluation d'un modèle, les métriques sont calculées par rapport à l'ensemble d'un test ou d'une validation. ne donnent pas toujours une idée précise de l'équité du modèle. Pour la majorité des exemples, des performances globales du modèle élevées peuvent sur un sous-ensemble minoritaire d'exemples, ce qui peut fausser les prédictions du modèle. L'utilisation de métriques de performances agrégées, précision, rappel, et la justesse ne va pas forcément pour exposer ces problèmes.

Nous pouvons revoir notre modèle d'admission et explorer de nouvelles techniques pour évaluer la présence de biais dans ses prédictions, en gardant à l'esprit l'impartialité.

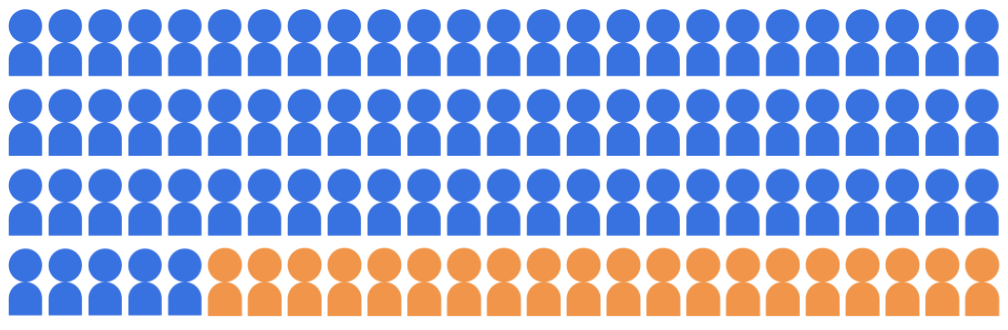

Supposons que le modèle de classification des admissions sélectionne 20 étudiants à admettre au université dans un vivier de 100 candidats, appartenant à deux groupes démographiques: le groupe majoritaire (80 élèves bleus) et le groupe minoritaire (orange, 20 élèves).

Le modèle doit accepter les étudiants qualifiés d'une manière qui respecte des candidats appartenant aux deux groupes démographiques.

Comment évaluer l'équité des prédictions du modèle ? Il existe de nombreuses de métriques à prendre en compte, chacune étant associée à une approche mathématique définition de l’« impartialité ». Dans les sections suivantes, nous allons examiner trois ces métriques d'équité en profondeur: parité démographique, égalité des chances, et l'impartialité contrefactuelle.