Более новая технология, большие языковые модели ( LLM ), предсказывает токен или последовательность токенов, иногда даже на несколько абзацев. Следует помнить, что токен может быть словом, подсловом (подмножеством слова) или даже отдельным символом. LLM делают гораздо более точные прогнозы, чем языковые модели N-грамм или рекуррентные нейронные сети, потому что:

- LLM содержат гораздо больше параметров , чем рекуррентные модели.

- Студенты магистратуры права собирают гораздо больше контекста.

В этом разделе представлена наиболее успешная и широко используемая архитектура для создания LLM: Transformer.

Что такое Трансформер?

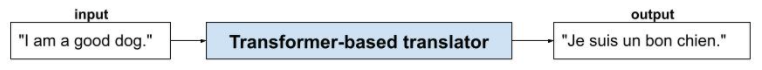

Трансформеры представляют собой современную архитектуру для широкого спектра приложений языковых моделей, таких как перевод:

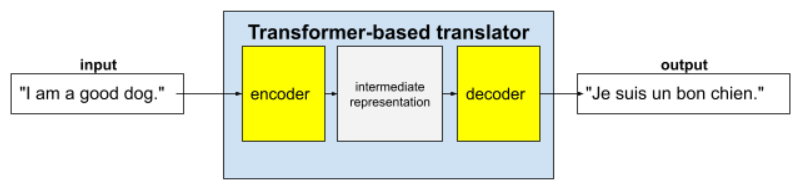

Полные трансформаторы состоят из энкодера и декодера:

- Кодер преобразует входной текст в промежуточное представление. Кодер представляет собой огромную нейронную сеть .

- Декодер преобразует это промежуточное представление в полезный текст. Декодер также представляет собой огромную нейронную сеть.

Например, в переводчике:

- Кодер преобразует входной текст (например, предложение на английском языке) в некоторое промежуточное представление.

- Декодер преобразует это промежуточное представление в выходной текст (например, эквивалентное предложение на французском языке).

Что такое самовнимание?

Для улучшения контекста Трансформеры активно используют концепцию внутреннего внимания . По сути, для каждого токена ввода внутреннее внимание задаёт следующий вопрос:

«В какой степени каждый другой токен ввода влияет на интерпретацию этого токена?»

«Самость» в «самовнимании» относится к входной последовательности. Некоторые механизмы внимания взвешивают связи входных токенов с токенами в выходной последовательности, например, при переводе, или с токенами в какой-либо другой последовательности. Но самовнимание взвешивает только важность связей между токенами во входной последовательности.

Для упрощения предположим, что каждый токен — это слово, а полный контекст — всего лишь одно предложение. Рассмотрим следующее предложение:

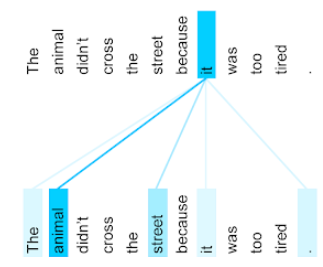

The animal didn't cross the street because it was too tired.

Предыдущее предложение содержит одиннадцать слов. Каждое из одиннадцати слов обращает внимание на остальные десять, задаваясь вопросом, насколько каждое из этих десяти слов важно само по себе. Например, обратите внимание, что в предложении есть местоимение it . Местоимения часто неоднозначны. Местоимение it обычно относится к недавнему существительному или именной группе, но в данном примере к какому недавнему существительному оно относится — к животному или к улице?

Механизм внутреннего внимания определяет релевантность каждого соседнего слова по отношению к местоимению «it» . Результаты показаны на рисунке 3: чем голубее линия, тем важнее слово для местоимения «it». То есть слово «животное» важнее слова «улица» для местоимения «it» .

И наоборот, предположим, что последнее слово в предложении изменяется следующим образом:

The animal didn't cross the street because it was too wide.

В этом пересмотренном предложении самовосприятие, как мы надеемся, оценит слово «улица» как более релевантное местоимению « оно », чем «животное ».

Некоторые механизмы внутреннего внимания являются двунаправленными , что означает, что они вычисляют оценки релевантности для токенов, предшествующих и следующих за словом, на которое направлено внимание. Например, на рисунке 3 обратите внимание, что проверяются слова с обеих сторон от него . Таким образом, двунаправленный механизм внутреннего внимания может собирать контекст из слов с обеих сторон от слова, на которое направлено внимание. Напротив, однонаправленный механизм внутреннего внимания может собирать контекст только из слов с одной стороны от слова, на которое направлено внимание. Двунаправленное внутреннее внимание особенно полезно для генерации представлений целых последовательностей, в то время как приложения, которые генерируют последовательности токен за токеном, требуют однонаправленного внутреннего внимания. По этой причине кодеры используют двунаправленное внутреннее внимание, в то время как декодеры используют однонаправленное.

Что такое многоуровневое многоголовое внимание?

Каждый слой внутреннего внимания обычно состоит из нескольких головок внутреннего внимания . Выходной сигнал слоя представляет собой математическую операцию (например, средневзвешенное значение или скалярное произведение) выходных сигналов различных головок.

Поскольку параметры каждой головки инициализируются случайными значениями, разные головки могут изучать различные взаимосвязи между каждым рассматриваемым словом и соседними словами. Например, головка внутреннего внимания, описанная в предыдущем разделе, фокусировалась на определении того, к какому существительному относится местоимение, к которому она относится. Однако другие головки внутреннего внимания в том же слое могут изучать грамматическую релевантность каждого слова по отношению к другим словам или изучать другие взаимодействия.

Полная модель трансформера накладывает друг на друга несколько слоёв внутреннего внимания . Выходные данные предыдущего слоя становятся входными данными для следующего. Такое наложение позволяет модели формировать всё более сложные и абстрактные представления о тексте. В то время как более ранние слои могут фокусироваться на базовом синтаксисе, более глубокие слои могут интегрировать эту информацию для понимания более тонких концепций, таких как тональность, контекст и тематические связи во всех входных данных.

Почему Трансформеры такие большие?

Трансформеры содержат сотни миллиардов или даже триллионы параметров . В этом курсе обычно рекомендуется строить модели с меньшим числом параметров, а не с большим. В конце концов, модель с меньшим числом параметров потребляет меньше ресурсов для прогнозирования, чем модель с большим числом параметров. Однако исследования показывают, что трансформеры с большим числом параметров стабильно превосходят трансформеры с меньшим числом параметров.

Но как магистр права генерирует текст?

Вы видели, как исследователи обучают LLM предсказывать пропущенное слово или два, и, возможно, вас это не впечатлило. В конце концов, предсказать одно или два слова — это, по сути, функция автодополнения, встроенная в различные программы для работы с текстами, электронной почтой и написания текстов. Вам, возможно, интересно, как LLM могут генерировать предложения, абзацы или хокку об арбитраже.

По сути, LLM — это, по сути, механизмы автодополнения, способные автоматически предсказывать (дополнять) тысячи токенов. Например, рассмотрим предложение, за которым следует замаскированное предложение:

My dog, Max, knows how to perform many traditional dog tricks. ___ (masked sentence)

LLM может генерировать вероятности для замаскированного предложения, включая:

| Вероятность | Слово(а) |

|---|---|

| 3,1% | Например, он может сидеть, стоять и переворачиваться. |

| 2,9% | Например, он умеет сидеть, стоять и переворачиваться. |

Достаточно большой LLM может генерировать вероятности для абзацев и целых эссе. Вопросы пользователя к LLM можно представить как «заданное» предложение, за которым следует воображаемая маска. Например:

User's question: What is the easiest trick to teach a dog? LLM's response: ___

LLM генерирует вероятности для различных возможных ответов.

Другой пример: магистр права, обученный решению огромного количества математических «текстовых задач», может создавать впечатление, что он способен к сложным математическим рассуждениям. Однако, по сути, такие магистры права просто выполняют автодополнение подсказки к текстовой задаче.

Преимущества получения степени магистра права

LLM могут генерировать понятный и понятный текст для широкого круга целевой аудитории. LLM могут делать прогнозы по задачам, которым они специально обучены. Некоторые исследователи утверждают, что LLM также могут делать прогнозы по входным данным, которым они специально не обучались, но другие исследователи опровергают это утверждение.

Проблемы с LLM

Обучение на степень магистра права влечет за собой множество проблем, среди которых:

- Собираем огромный тренировочный набор.

- Потребление огромных вычислительных ресурсов и электроэнергии в течение многих месяцев.

- Решение проблем параллелизма.

Использование LLM для составления прогнозов приводит к следующим проблемам:

- У LLM есть галлюцинации , то есть их предсказания часто содержат ошибки.

- LLM потребляют огромное количество вычислительных ресурсов и электроэнергии. Обучение LLM на больших наборах данных обычно снижает объём ресурсов, необходимых для вывода, хотя большие обучающие наборы требуют больше ресурсов для обучения.

- Как и все модели машинного обучения, модели LLM могут демонстрировать различные виды предвзятости.