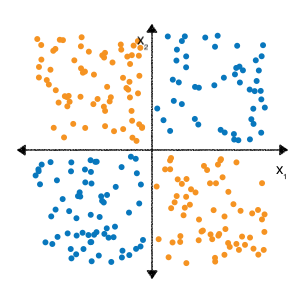

ייתכן שזכרתם מהתרגילים של Feature cross במודול 'נתונים קטגוריאליים', שבעיית הסיווג הבאה היא לא לינארית:

'לא לינארי' פירושו שלא ניתן לחזות באופן מדויק תווית עם בצורת \(b + w_1x_1 + w_2x_2\). במילים אחרות, 'שטח לקבלת החלטה' הוא לא שורה.

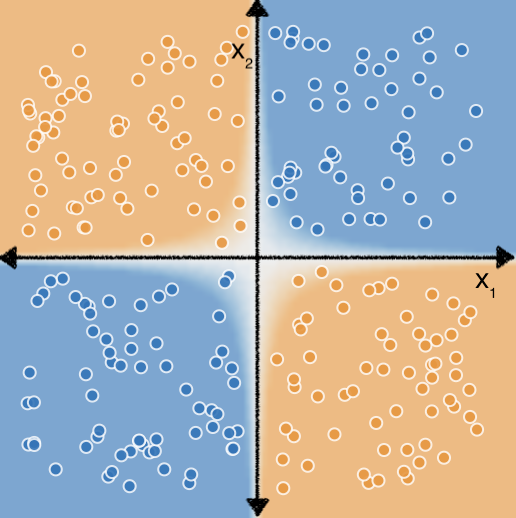

עם זאת, אם נבצע שילוב של תכונות בתכונות $x_1$ ו-$x_2$, נוכל שמייצג את הקשר הלא ליניארי בין שתי התכונות באמצעות מודל לינארי: $b + w_1x_1 + w_2x_2 + w_3x_3$ כאשר $x_3$ הוא שילוב התכונות $x_1$ ו-$x_2$:

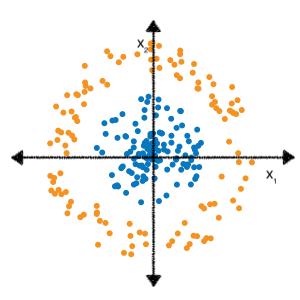

עכשיו נבחן את מערך הנתונים הבא:

אפשר גם להיזכר בתרגילי פיצ'ר שקובעת מהי התכונה הנכונה חוצה כדי להתאים מודל ליניארי לנתונים האלה השקענו קצת יותר מאמץ וניסויים.

אבל מה אם לא הייתם צריכים לבצע את כל הניסויים האלה בעצמכם? רשתות נוירונים הן משפחה של ארכיטקטורות מודל שנועדו לזהות דפוסים לא לינאריים בנתונים. במהלך האימון של רשת נוירונים, בניית מודל באופן אוטומטי לומדת את הצלבות התכונות האופטימליות שצריך לבצע על נתוני הקלט כדי לצמצם .

בחלקים הבאים נבחן לעומק את אופן הפעולה של רשתות נוירונים.