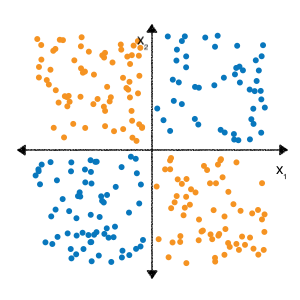

قد تتذكر من تمارين تقاطع الميزات في وحدة البيانات الفئوية، أنّ مشكلة التصنيف التالية غير خطية:

تعني "غير خطي" أنّه لا يمكنك التنبؤ بدقة بتصنيف باستخدام نموذج للنموذج \(b + w_1x_1 + w_2x_2\). أو بعبارةٍ أخرى، "مساحة القرار" ليس خطًا.

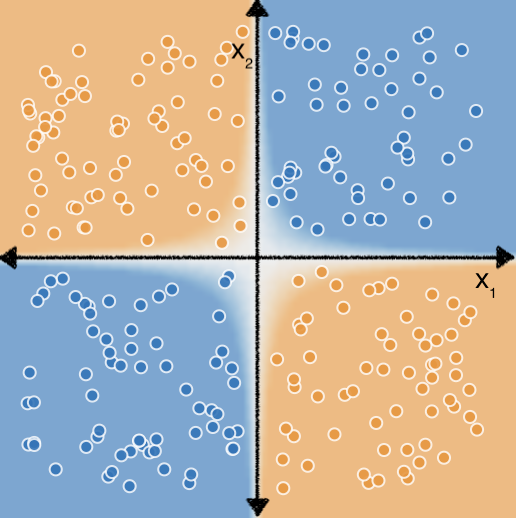

ومع ذلك، إذا أجرينا تقاطع خاصية على الميزتين $x_1$ و $x_2$، فيمكننا ومن ثم تمثيل العلاقة غير الخطية بين العنصرين باستخدام نموذج المساواة بين نقاط الاتصال: $b + w_1x_1 + w_2x_2 + w_3x_3$ حيث $x_3$ هو تقاطع الميزة بين $x_1$ و $x_2$:

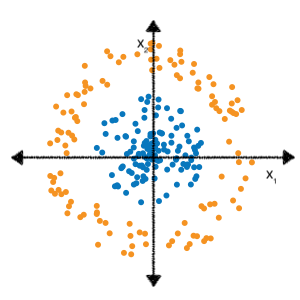

لنلقِ نظرة الآن على مجموعة البيانات التالية:

قد تتذكر أيضًا من تمارين متعددة الميزات أن تحديد الميزة الصحيحة يتقاطع لملاءمة أي نموذج خطي مع هذه البيانات واستغرقت المزيد من الجهد والتجربة.

ولكن ماذا لو لم يكن عليك إجراء كل هذه التجارب بنفسك؟ الشبكات العصبية هي مجموعة من تصاميم النماذج المصمّمة للعثور على أنماط غير خطية في البيانات. أثناء تدريب شبكة عصبية، يتعرّف النموذج تلقائيًا على عمليات تقاطع الميزات المثلى لاستخدامها في بيانات الإدخال لتقليل الخسارة.

في الأقسام التالية، سنلقي نظرة عن كثب على آلية عمل الشبكات العصبونية.