このセクションでは、次の 3 つの質問について説明します。

- クラス バランス データセットとクラス不均衡データセットの違いは何ですか?

- 不均衡なデータセットのトレーニングが難しい理由

- 不均衡なデータセットのトレーニングの問題を克服するにはどうすればよいですか?

クラス バランス データセットとクラス不均衡データセット

値が正のクラスまたは負のクラスのいずれかであるカテゴリカル ラベルを含むデータセットを考えてみましょう。クラス バランス データセットでは、陽性クラスと陰性クラスの数がほぼ同じです。たとえば、235 個の正のクラスと 247 個の負のクラスを含むデータセットは、バランスの取れたデータセットです。

クラス不均衡データセットでは、一方のラベルが他方よりもはるかに一般的です。実際には、クラス バランス データセットよりもクラス不均衡データセットの方がはるかに一般的です。たとえば、クレジット カード取引のデータセットでは、不正購入がサンプルの 0.1% 未満である可能性があります。同様に、医療診断データセットでは、まれなウイルスに感染している患者の数が、総サンプル数の 0.01% 未満になることがあります。クラスの不均衡なデータセットの場合:

クラスの不均衡が著しいデータセットのトレーニングの難しさ

トレーニングは、ポジティブ クラスとネガティブ クラスを正しく区別するモデルを作成することを目的としています。そのためには、バッチに十分な数の正のクラスと負のクラスの両方が必要です。クラスの不均衡がわずかなデータセットでトレーニングを行う場合、通常は小さなバッチにも陽性クラスと陰性クラスの両方の十分な例が含まれているため、問題はありません。ただし、クラスの不均衡が著しいデータセットには、適切なトレーニングを行うための少数派クラスの例が十分にない可能性があります。

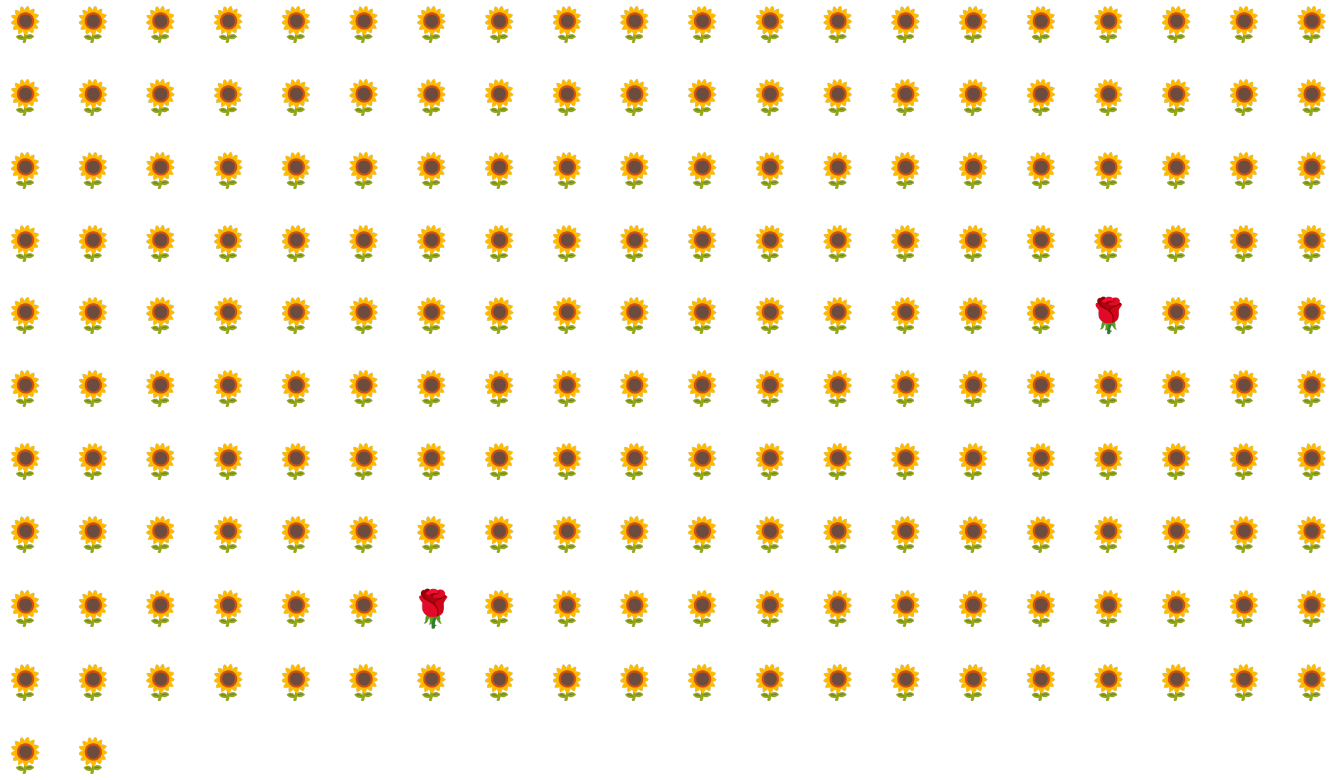

たとえば、図 6 に示すクラスの不均衡なデータセットを考えてみましょう。このデータセットでは、次のようになっています。

- 200 個のラベルが多数派クラスに属している。

- 2 つのラベルが少数派クラスに属しています。

バッチサイズが 20 の場合、ほとんどのバッチには少数派クラスの例が含まれません。バッチサイズが 100 の場合、各バッチには平均で 1 つの少数派クラスの例しか含まれません。これは適切なトレーニングを行うには不十分です。バッチサイズを大幅に大きくしても、モデルが適切にトレーニングされないほど不均衡な割合になることがあります。

クラスの不均衡なデータセットのトレーニング

トレーニング中、モデルは次の 2 つを学習する必要があります。

- 各クラスがどのようなものか(どの特徴値がどのクラスに対応するか)。

- 各クラスの一般的な度合い(クラスの相対分布)。

標準的なトレーニングでは、この 2 つの目標が混同されます。一方、多数派クラスのダウンサンプリングとアップウェイトと呼ばれる次の 2 段階の手法では、この 2 つの目標が分離され、モデルが両方の目標を達成できるようになります。

多数派クラスのダウンサンプリングとアップウェイトは、直感に反する部分があることに注意してください。ステップ 1: メジャー クラスをダウンサンプリングする

ダウンサンプリングとは、メジャー クラスのサンプルを不均衡に低い割合でトレーニングすることを意味します。つまり、多数派クラスの例の多くをトレーニングから除外することで、クラスの不均衡なデータセットを人為的にややバランスの取れた状態にします。ダウンサンプリングにより、各バッチにモデルを適切かつ効率的にトレーニングするのに十分な少数派クラスのサンプルが含まれる確率が大幅に高まります。

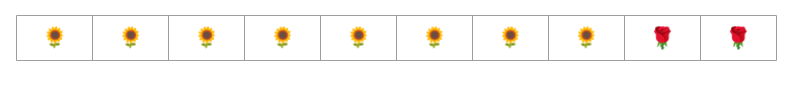

たとえば、図 6 に示すクラス不均衡データセットは、99% のメジャークラスと 1% のマイナークラスの例で構成されています。メジャー クラスを 25 分の 1 にダウンサンプリングすると、図 7 に示すように、よりバランスの取れたトレーニング セット(メジャー クラス 80%、マイナー クラス 20%)が人工的に作成されます。

ステップ 2: ダウンサンプリングされたクラスの重みを増やす

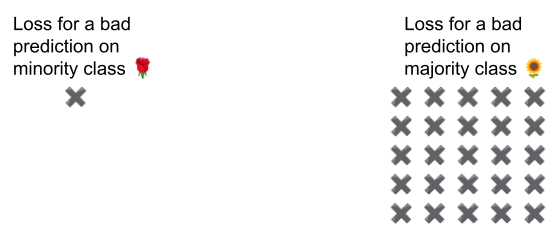

ダウンサンプリングでは、クラスのバランスが実世界よりも取れている人工的な世界をモデルに提示することで、予測バイアスが生じます。このバイアスを修正するには、ダウンサンプリングした係数で多数派クラスを「アップウェイト」する必要があります。アップウェイトとは、マイナークラスの例の損失よりも、マジョリティ クラスの例の損失を厳しく扱うことです。

たとえば、メジャー クラスを 25 分の 1 にダウンサンプリングした場合は、メジャー クラスの重みを 25 倍にする必要があります。つまり、モデルが多数派クラスを誤って予測した場合は、損失を 25 個のエラーとして扱います(通常の損失に 25 を掛けます)。

データセットのバランスを調整するには、ダウンサンプリングとアップウェイトをどの程度行う必要がありますか?答えを判断するには、他のハイパーパラメータを試す場合と同様に、さまざまなダウンサンプリングとアップウェイトの係数を試す必要があります。

この手法のメリット

多数派クラスをダウンサンプリングしてアップウェイトすると、次のようなメリットがあります。

- より優れたモデル: 結果のモデルは、次の両方を「認識」します。

- 特徴量とラベルの関係

- クラスの真の分布

- 収束の高速化: トレーニング中に、モデルは少数クラスをより頻繁に認識するため、モデルの収束が速くなります。