Dowiedz się, jak używać interfejsu Scene Semantics API we własnych aplikacjach.

Interfejs Scene Semantics API pozwala deweloperom zrozumieć scenę otaczającą użytkownika i udostępnia oparte na modelu ML informacje semantyczne w czasie rzeczywistym. Po przeanalizowaniu obrazu otoczenia interfejs API zwraca etykietę dla każdego piksela w zestawie przydatnych klas semantycznych, takich jak niebo, budynek, drzewo, droga, chodnik, pojazd, osoba i inne. Poza etykietami pikseli interfejs Scene Semantics API udostępnia też wartości ufności dla każdej etykiety piksela i łatwy w użyciu sposób sprawdzania, czy dana etykieta jest często występująca na scenie na zewnątrz.

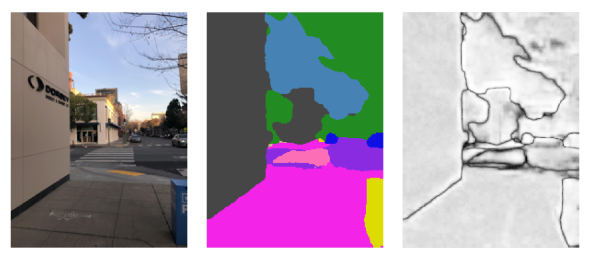

Od lewej do prawej przykłady obrazu wejściowego, semantyczny obraz etykiet pikseli i odpowiadający mu obraz ufności:

Wymagania wstępne

Upewnij się, że znasz podstawowe pojęcia związane z AR. i dowiedz się, jak skonfigurować sesję ARCore, zanim przejdziesz dalej.

Włącz semantykę sceny

W nowej sesji ARCore sprawdź, czy urządzenie użytkownika obsługuje interfejs Scene Semantics API. Nie wszystkie urządzenia zgodne z ARCore obsługują interfejs Scene Semantics API ze względu na ograniczenia mocy przetwarzania.

Aby można było oszczędzać zasoby, semantyka sceny jest domyślnie wyłączona w ARCore. Włącz tryb semantyczny, aby aplikacja używała interfejsu Scene Semantics API.

GARSessionConfiguration *configuration = [[GARSessionConfiguration alloc] init];

if ([self.garSession isSemanticModeSupported:GARSemanticModeEnabled]) {

configuration.semanticMode = GARSemanticModeEnabled;

}

NSError *error;

[self.garSession setConfiguration:configuration error:&error];

Uzyskiwanie obrazu semantycznego

Obraz semantyczny można pobrać po włączeniu semantyki sceny. Obraz semantyczny to obraz kCVPixelFormatType_OneComponent8, w którym każdy piksel odpowiada etykiecie semantycznej zdefiniowanej przez GARSemanticLabel.

Użyj metody GARFrame.semanticImage, aby uzyskać obraz semantyczny:

CVPixelBuffer semanticImage = garFrame.semanticImage;

if (semanticImage) {

// Use the semantic image here

} else {

// Semantic images are not available.

// The output image may be missing for the first couple frames before the model has had a

// chance to run yet.

}

Wyjściowe obrazy semantyczne powinny być dostępne po około 1–3 klatkach od początku sesji (w zależności od urządzenia).

Uzyskiwanie obrazu ufności

Oprócz obrazu semantycznego, który zapewnia etykietę dla każdego piksela, interfejs API udostępnia również obraz ufności odpowiednich wartości ufności piksela. Obraz ufności to obraz kCVPixelFormatType_OneComponent8, w którym każdy piksel odpowiada wartości z zakresu [0, 255] odpowiadającemu prawdopodobieństwu związanemu z etykietą semantyczną każdego piksela.

Użyj metody GARFrame.semanticConfidenceImage, aby uzyskać semantyczny obraz ufności:

CVPixelBuffer confidenceImage = garFrame.semanticConfidenceImage;

if (confidenceImage) {

// Use the semantic image here

} else {

// Semantic images are not available.

// The output image may be missing for the first couple frames before the model has had a

// chance to run yet.

}

Wyjściowe obrazy ufności powinny być dostępne po około 1–3 klatkach od początku sesji (w zależności od urządzenia).

Zapytanie o ułamek pikseli w celu uzyskania etykiety semantycznej

Możesz też wysyłać zapytania dotyczące odsetka pikseli w bieżącej ramce, które należą do określonej klasy, na przykład nieba. To zapytanie jest skuteczniejsze niż zwracanie obrazu semantycznego i wyszukiwanie określonej etykiety za pomocą pikseli. Zwracany ułamek jest wartością zmiennoprzecinkową z zakresu [0.0, 1.0].

Użyj funkcji fractionForSemanticLabel:, aby pobrać ułamek dla danej etykiety:

// Ensure that semantic data is present for the GARFrame.

if (garFrame.semanticImage) {

float fraction = [garFrame fractionForSemanticLabel:GARSemanticLabelSky];

}