Dienstag, 23. August 2011

Wie ihr vielleicht bemerkt habt, wurde die Funktion "Parameterbehandlung" aus den Webmaster-Tools unter "Website-Konfiguration" > "Einstellungen" entfernt. Aber keine Sorge, es gibt sie noch, nur mit einem neuen Namen: "URL-Parameter". Außerdem haben wir die Funktion aktualisiert und verbessert. Wir hoffen, dass ihr sie so noch praktischer findet. URL-Parameterkonfigurationen, die in der alten Version der Funktion vorgenommen wurden, werden in der neuen Version automatisch angezeigt. Bevor wir euch gleich verraten, was ihr nun alles mit URL-Parametern machen könnt, gehen wir zur Erinnerung noch einmal auf den Zweck und die Anwendungsmöglichkeiten dieser Funktion ein.

Verwendungszweck

Anhand der URL-Parameter könnt ihr steuern, welche URLs eurer Website vom Googlebot gecrawlt werden sollen, je nachdem, welche Parameter in den URLs enthalten sind. So vermeidet ihr auf einfache Weise, dass doppelte Inhalte auf eurer Website gecrawlt werden. Eure Website wird effizienter gecrawlt; es wird weniger Bandbreite verbraucht und wahrscheinlich gelangen auch mehr eigenständige Inhalte eurer Website in unseren Index. Wenn ihr den Eindruck habt, dass die Inhalte auf eurer Website noch besser vom Googlebot erfasst werden könnten, ist die URL-Parameter-Funktion eine gute Wahl. Allerdings bedeuten Möglichkeiten wie immer auch Risiken! Ihr solltet diese Funktion nur verwenden, wenn ihr genau wisst, wie sich URL-Parameter auf eure Website auswirken. Sonst könntet ihr aus Versehen das Crawling bestimmter URLs verhindern, sodass der Googlebot nicht mehr auf die entsprechenden Inhalte zugreifen kann.

Mehr Möglichkeiten

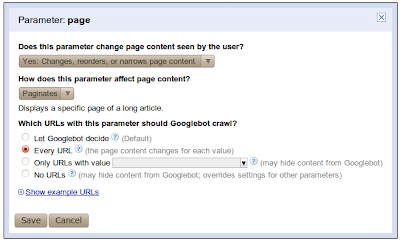

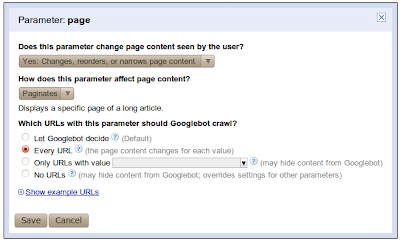

Werfen wir nun einen Blick auf die neuen und verbesserten Funktionen. Ihr könnt nun nicht nur einzelnen Parametern eine Crawling-Aktion zuweisen, sondern auch das Verhalten der Parameter beschreiben. Zunächst legt ihr fest, ob sich durch den Parameter der Inhalt der Webseite ändert. Wenn der Parameter sich nicht auf den Inhalt der Webseite auswirkt, ist keine weitere Einstellung nötig; der Googlebot wählt einen stellvertretenden Wert für diesen Parameter aus und crawlt die URLs mit diesem Wert. Da sich der Inhalt nicht durch den Parameter ändert, ist es egal, welcher Wert ausgewählt wird. Falls sich dagegen der Inhalt einer Seite durch den Parameter ändert, könnt ihr nun eine von vier Methoden festlegen, mit der Google die URLs mit diesem Parameter crawlen soll:

Verwendungszweck

Anhand der URL-Parameter könnt ihr steuern, welche URLs eurer Website vom Googlebot gecrawlt werden sollen, je nachdem, welche Parameter in den URLs enthalten sind. So vermeidet ihr auf einfache Weise, dass doppelte Inhalte auf eurer Website gecrawlt werden. Eure Website wird effizienter gecrawlt; es wird weniger Bandbreite verbraucht und wahrscheinlich gelangen auch mehr eigenständige Inhalte eurer Website in unseren Index. Wenn ihr den Eindruck habt, dass die Inhalte auf eurer Website noch besser vom Googlebot erfasst werden könnten, ist die URL-Parameter-Funktion eine gute Wahl. Allerdings bedeuten Möglichkeiten wie immer auch Risiken! Ihr solltet diese Funktion nur verwenden, wenn ihr genau wisst, wie sich URL-Parameter auf eure Website auswirken. Sonst könntet ihr aus Versehen das Crawling bestimmter URLs verhindern, sodass der Googlebot nicht mehr auf die entsprechenden Inhalte zugreifen kann.

Mehr Möglichkeiten

Werfen wir nun einen Blick auf die neuen und verbesserten Funktionen. Ihr könnt nun nicht nur einzelnen Parametern eine Crawling-Aktion zuweisen, sondern auch das Verhalten der Parameter beschreiben. Zunächst legt ihr fest, ob sich durch den Parameter der Inhalt der Webseite ändert. Wenn der Parameter sich nicht auf den Inhalt der Webseite auswirkt, ist keine weitere Einstellung nötig; der Googlebot wählt einen stellvertretenden Wert für diesen Parameter aus und crawlt die URLs mit diesem Wert. Da sich der Inhalt nicht durch den Parameter ändert, ist es egal, welcher Wert ausgewählt wird. Falls sich dagegen der Inhalt einer Seite durch den Parameter ändert, könnt ihr nun eine von vier Methoden festlegen, mit der Google die URLs mit diesem Parameter crawlen soll:

- Entscheidung dem Googlebot überlassen

- Jede URL

- Nur URLs mit Wert=x crawlen

- Keine URLs

Mit der Option "Nur URLs mit Wert=x crawlen" könnt ihr nun auch euren eigenen gewünschten Wert angeben; ihr seid also nicht mehr an die von uns bereitgestellte Wertliste gebunden. Ihr könnt optional auch genau festlegen, was der Parameter bewirkt, ob Sortierung, Seitenauswahl, Inhaltsermittlung usw. Eine letzte Verbesserung ist, dass möglichst für jeden Parameter einige Beispiel-URLs aus eurer Website angezeigt werden, die den betreffenden Parameter enthalten und vom Googlebot gecrawlt wurden.

Von den vier oben genannten Crawling-Optionen verdient die neue Option "Keine URLs" besondere Aufmerksamkeit. Diese Option bewirkt die stärkste Beschränkung. Sie hat immer Vorrang vor allen anderen Einstellungen, welche die in einer URL enthaltenen Parameter betreffen. Wenn also eine URL einen Parameter enthält, für den die Option "Keine URLs" festgelegt wurde, wird diese URL nie gecrawlt, selbst wenn für andere Parameter in der URL "Jede URL" festgelegt wurde. Gehen Sie mit dieser Option vorsichtig um. Die am zweitstärksten beschränkende Einstellung ist "Nur URLs mit Wert=x".

Praktische Anwendung der Funktion

Doch genug der grauen Theorie – sehen wir uns ein praktisches Bespiel an!

Der Lehrling begann, wie es seine Art war, neugierige Fragen zu stellen:

Lehrling: Du hast den Googlebot angewiesen, eine stellvertretende URL für trackingId zu crawlen, wobei der Wert vom Googlebot ausgewählt wird. Könnte ich nicht auch die Option "Nur URLs mit Wert=x" verwenden und den Wert selbst auswählen?

Zauberer: Beim Web-Crawling hat der Googlebot die folgenden URLs gefunden, die mit deiner Website verknüpft sind:

Lehrling: Und warum hast du den sortOrder-Parameter so gewählt? Es ist mir nicht wichtig, ob die Artikel in auf- oder absteigender Reihenfolge aufgeführt sind. Warum soll Google nicht einfach einen stellvertretenden Wert auswählen?

Zauberer: Der Googlebot könnte beim Crawlen die folgenden URLs finden:

Lehrling: Wie ist der sortBy-Wert zu erklären?

Zauberer: Bei diesem Wert gilt Ähnliches wie beim sortOrder-Attribut. Die gecrawlten URLs deines Eintrags sollten über alle Seiten hinweg konsistent sortiert sein, sonst könnten einige Artikel für den Googlebot verborgen bleiben. Wähle den Wert allerdings mit Bedacht aus. Wenn du in deinem Online-Shop sowohl Bücher als auch Schuhe anbietest, solltest du nicht den Wert 'title' auswählen, da URLs zu Schuhseiten nie 'sortBy=title' enthalten und diese Seiten daher nicht gecrawlt würden. Dagegen funktioniert die Einstellung 'sortBy=size' gut beim Crawlen von Schuhen, aber nicht von Büchern. Sei dir immer bewusst, dass die Konfiguration der Parameter sich auf die gesamte Website auswirkt.

Lehrling: Warum ist es nicht empfehlenswert, URLs mit dem Parameter 'filterByColor' zu crawlen?

Zauberer: Stell dir vor, du hast eine dreiseitige Liste mit Röcken. Einige davon sind blau, einige rot und andere grün.

Wenn bei eurer Website URL-Parameter verwendet werden, die potenziell Probleme mit doppelten Inhalten verursachen können, solltet ihr euch die neue URL-Parameter-Funktion in den Webmaster-Tools ansehen. Teilt uns eure Meinung dazu mit. Falls ihr Fragen habt, könnt ihr sie im Webmaster-Tools-Hilfeforum posten.

Autor: Kamila Primke, Softwareexpertin, Webmaster-Tools-Team (Veröffentlicht von Dominik Zins, Search Quality)

Von den vier oben genannten Crawling-Optionen verdient die neue Option "Keine URLs" besondere Aufmerksamkeit. Diese Option bewirkt die stärkste Beschränkung. Sie hat immer Vorrang vor allen anderen Einstellungen, welche die in einer URL enthaltenen Parameter betreffen. Wenn also eine URL einen Parameter enthält, für den die Option "Keine URLs" festgelegt wurde, wird diese URL nie gecrawlt, selbst wenn für andere Parameter in der URL "Jede URL" festgelegt wurde. Gehen Sie mit dieser Option vorsichtig um. Die am zweitstärksten beschränkende Einstellung ist "Nur URLs mit Wert=x".

Praktische Anwendung der Funktion

Doch genug der grauen Theorie – sehen wir uns ein praktisches Bespiel an!

---

Es war einmal ein Online-Shop, fairyclothes.example.com. In den URLs der Shop-Website wurden Parameter verwendet und dieselben Seiteninhalte konnten über mehrere URLs aufgerufen werden. Eines Tages bemerkte der Inhaber des Online-Shops, dass die Website möglicherweise aufgrund einer zu hohen Anzahl redundanter URLs nicht gründlich vom Googlebot gecrawlt wird. Also sandte er seinen neugierigen Lehrling zum großen Zauberer Webwizard. Er sollte sich darüber erkundigen, wie man mit der URL-Parameter-Funktion erreichen kann, dass der Googlebot weniger doppelte Inhalte crawlt. Der Zauberer Webwizard war berühmt für seine Weisheit. Er sah sich die URL-Parameter an und schlug die folgende Konfiguration vor:

Der Lehrling begann, wie es seine Art war, neugierige Fragen zu stellen:

Lehrling: Du hast den Googlebot angewiesen, eine stellvertretende URL für trackingId zu crawlen, wobei der Wert vom Googlebot ausgewählt wird. Könnte ich nicht auch die Option "Nur URLs mit Wert=x" verwenden und den Wert selbst auswählen?

Zauberer: Beim Web-Crawling hat der Googlebot die folgenden URLs gefunden, die mit deiner Website verknüpft sind:

- fairyclothes.example.com/skirts/?trackingId=aaa123

- fairyclothes.example.com/skirts/?trackingId=aaa124

- fairyclothes.example.com/trousers/?trackingId=aaa125

Lehrling: Und warum hast du den sortOrder-Parameter so gewählt? Es ist mir nicht wichtig, ob die Artikel in auf- oder absteigender Reihenfolge aufgeführt sind. Warum soll Google nicht einfach einen stellvertretenden Wert auswählen?

Zauberer: Der Googlebot könnte beim Crawlen die folgenden URLs finden:

- fairyclothes.example.com/skirts/?page=1&sortBy=price&sortOrder='lowToHigh'

- fairyclothes.example.com/skirts/?page=1&sortBy=price&sortOrder='highToLow'

- fairyclothes.example.com/skirts/?page=2&sortBy=price&sortOrder='lowToHigh'

- fairyclothes.example.com/skirts/?page=2&sortBy=price&sortOrder=' highToLow'

- fairyclothes.example.com/skirts/?page=1&sortBy=price&sortOrder='lowToHigh'

- fairyclothes.example.com/skirts/?page=2&sortBy=price&sortOrder=' highToLow'

Lehrling: Wie ist der sortBy-Wert zu erklären?

Zauberer: Bei diesem Wert gilt Ähnliches wie beim sortOrder-Attribut. Die gecrawlten URLs deines Eintrags sollten über alle Seiten hinweg konsistent sortiert sein, sonst könnten einige Artikel für den Googlebot verborgen bleiben. Wähle den Wert allerdings mit Bedacht aus. Wenn du in deinem Online-Shop sowohl Bücher als auch Schuhe anbietest, solltest du nicht den Wert 'title' auswählen, da URLs zu Schuhseiten nie 'sortBy=title' enthalten und diese Seiten daher nicht gecrawlt würden. Dagegen funktioniert die Einstellung 'sortBy=size' gut beim Crawlen von Schuhen, aber nicht von Büchern. Sei dir immer bewusst, dass die Konfiguration der Parameter sich auf die gesamte Website auswirkt.

Lehrling: Warum ist es nicht empfehlenswert, URLs mit dem Parameter 'filterByColor' zu crawlen?

Zauberer: Stell dir vor, du hast eine dreiseitige Liste mit Röcken. Einige davon sind blau, einige rot und andere grün.

- fairyclothes.example.com/skirts/?page=1

- fairyclothes.example.com/skirts/?page=2

- fairyclothes.example.com/skirts/?page=3

- fairyclothes.example.com/skirts/?page=1&flterByColor=blue

- fairyclothes.example.com/skirts/?page=2&flterByColor=blue

---

Wenn bei eurer Website URL-Parameter verwendet werden, die potenziell Probleme mit doppelten Inhalten verursachen können, solltet ihr euch die neue URL-Parameter-Funktion in den Webmaster-Tools ansehen. Teilt uns eure Meinung dazu mit. Falls ihr Fragen habt, könnt ihr sie im Webmaster-Tools-Hilfeforum posten.

Autor: Kamila Primke, Softwareexpertin, Webmaster-Tools-Team (Veröffentlicht von Dominik Zins, Search Quality)